Rumah >Peranti teknologi >AI >Anugerah kertas ICCV'23 'Fighting of Gods'! Meta Divide Everything dan ControlNet telah dipilih secara bersama, dan terdapat satu lagi artikel yang mengejutkan para hakim

Anugerah kertas ICCV'23 'Fighting of Gods'! Meta Divide Everything dan ControlNet telah dipilih secara bersama, dan terdapat satu lagi artikel yang mengejutkan para hakim

- 王林ke hadapan

- 2023-10-04 20:37:011591semak imbas

ICCV 2023, persidangan penglihatan komputer teratas yang diadakan di Paris, Perancis, baru sahaja berakhir!

Anugerah Kertas Terbaik tahun ini hanyalah "pergaduhan antara tuhan".

Sebagai contoh, dua kertas yang memenangi Anugerah Kertas Terbaik termasuk karya yang meruntuhkan bidang Vincentian AI - ControlNet.

Sejak sumber terbuka, ControlNet telah menerima 24k bintang di GitHub. Sama ada untuk model resapan atau keseluruhan bidang penglihatan komputer, anugerah kertas ini amat wajar

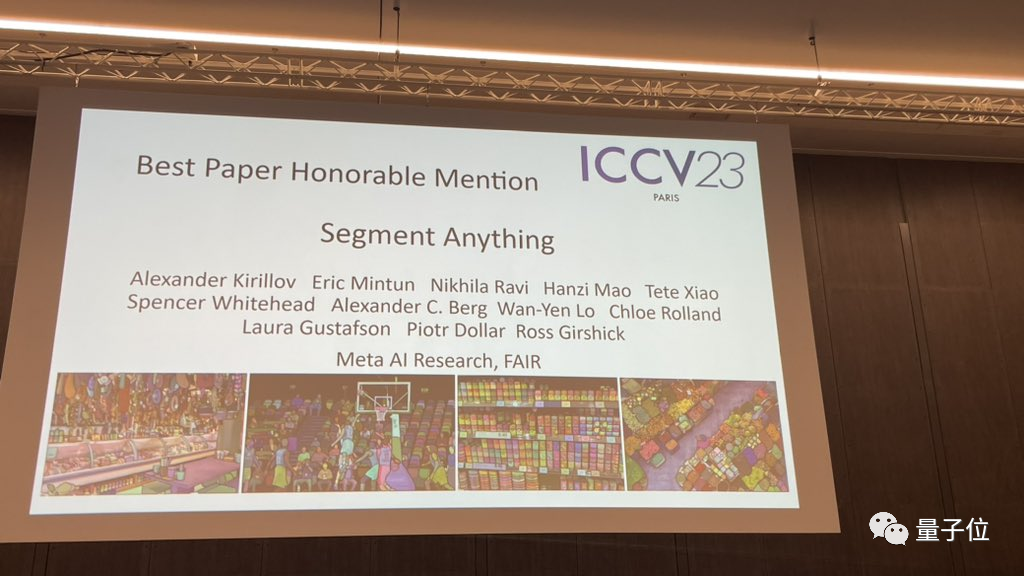

Penghargaan untuk Anugerah Kertas Terbaik telah dianugerahkan kepada satu lagi kertas kerja yang sama terkenal, Meta's “Split Everything” model SAM.

Sejak pelancarannya, "Segmen Semuanya" telah menjadi "penanda aras" untuk pelbagai model AI segmentasi imej, termasuk banyak FastSAM, LISA dan SegGPT yang datang dari belakang, yang semuanya menggunakannya sebagai penanda aras rujukan untuk ujian keberkesanan.

Pencalonan kertas semuanya sangat berat.

ICCV 2023 menyerahkan sejumlah 8068 kertas, tetapi hanya kira-kira satu perempat, iaitu, 2160 kertas diterima

Hampir 10% kertas kerja adalah dari China, selain universiti, terdapat juga banyak institusi perindustrian, seperti SenseTime 49 kertas daripada sains dan teknologi serta makmal bersama telah dipilih untuk ICCV 2023, dan 14 kertas daripada Megvii telah dipilih.

Mari kita lihat kertas mana yang memenangi anugerah ICCV 2023

ControlNet memenangi kertas terbaik dalam ICCV

Mari kita lihat dahulu dua kertas yang memenangi anugerah kertas terbaik (Marr Award) tahun ini

ICCV kertas terbaik Juga dikenali sebagai Marr Prize (Marr Prize), dipilih setiap dua tahun dan dikenali sebagai salah satu penghormatan tertinggi dalam bidang penglihatan komputer.

Anugerah ini dinamakan sempena David Marr, seorang perintis dalam bidang penglihatan komputer dan pengasas neurosains pengiraan

Pemenang Anugerah Kertas Terbaik pertama ialah "Menambah Kawalan Bersyarat untuk Model Resapan Teks-ke-Imej" daripada Stanford

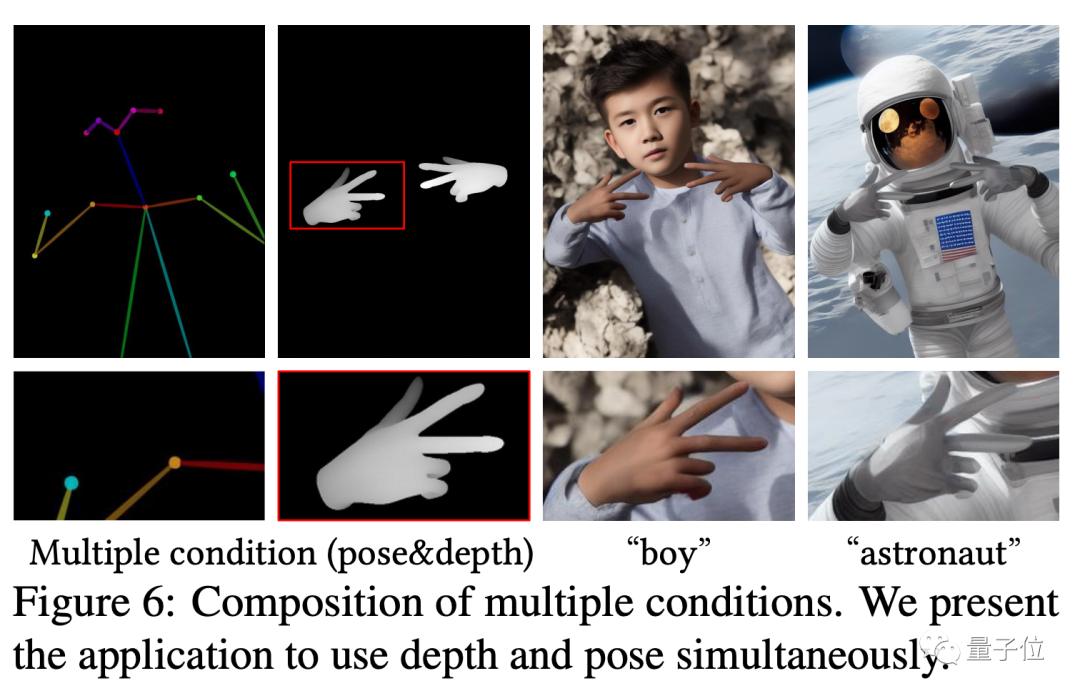

Kertas kerja ini mencadangkan model yang dipanggil ControlNet, yang boleh mengawal butiran penjanaannya dengan hanya menambah input tambahan pada model resapan yang telah dilatih.

Input di sini boleh terdiri daripada pelbagai jenis, termasuk lakaran, imej tepi, imej segmentasi semantik, ciri titik utama badan manusia, garis lurus pengesanan transformasi Hough, peta kedalaman, tulang manusia, dll. Apa yang dipanggil "AI boleh menarik tangan ", teras Teknologi datang daripada artikel ini.

Idea dan seni binanya adalah seperti berikut:

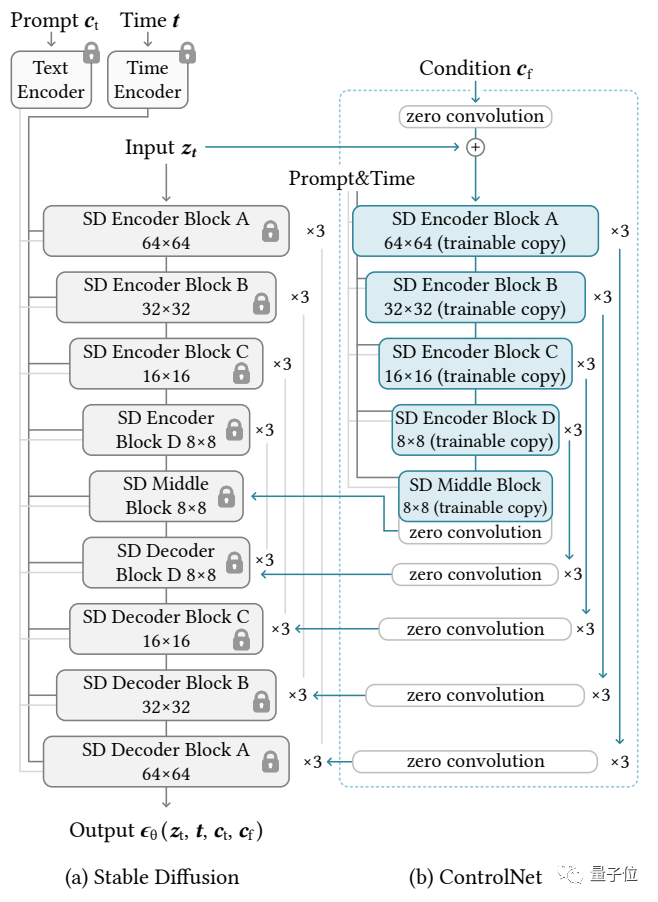

Rangkaian kawalan mula-mula menyalin berat model penyebaran untuk mendapatkan "salinan boleh dilatih"

Sebaliknya, model penyebaran asal telah dilatih terlebih dahulu pada berbilion-bilion images , jadi parameter "dikunci". Dan "salinan boleh dilatih" ini hanya perlu dilatih pada set data kecil tugas khusus untuk mempelajari kawalan bersyarat.

Walaupun jumlah data sangat kecil (tidak melebihi 50,000 imej), kawalan bersyarat yang dihasilkan oleh model selepas latihan adalah sangat baik.

Disambungkan melalui lapisan konvolusi 1×1, "model terkunci" dan "salinan boleh dilatih" membentuk struktur yang dipanggil "0 lapisan konvolusi". Berat dan berat sebelah lapisan konvolusi 0 ini dimulakan kepada 0, supaya kelajuan yang sangat pantas boleh diperolehi semasa proses latihan, hampir dengan kelajuan penalaan halus model resapan, malah boleh dilatih pada peranti peribadi

Sebagai contoh, jika anda menggunakan 200,000 data imej untuk melatih NVIDIA RTX 3090TI, ia hanya akan mengambil masa kurang daripada seminggu

Zhang Lvmin ialah pengarang pertama kertas ControlNet dan kini merupakan pelajar kedoktoran di Universiti Stanford. Selain ControlNet, beliau juga mencipta karya terkenal seperti Style2Paints dan Fooocus

Alamat kertas: https://arxiv.org/abs/2302.05543

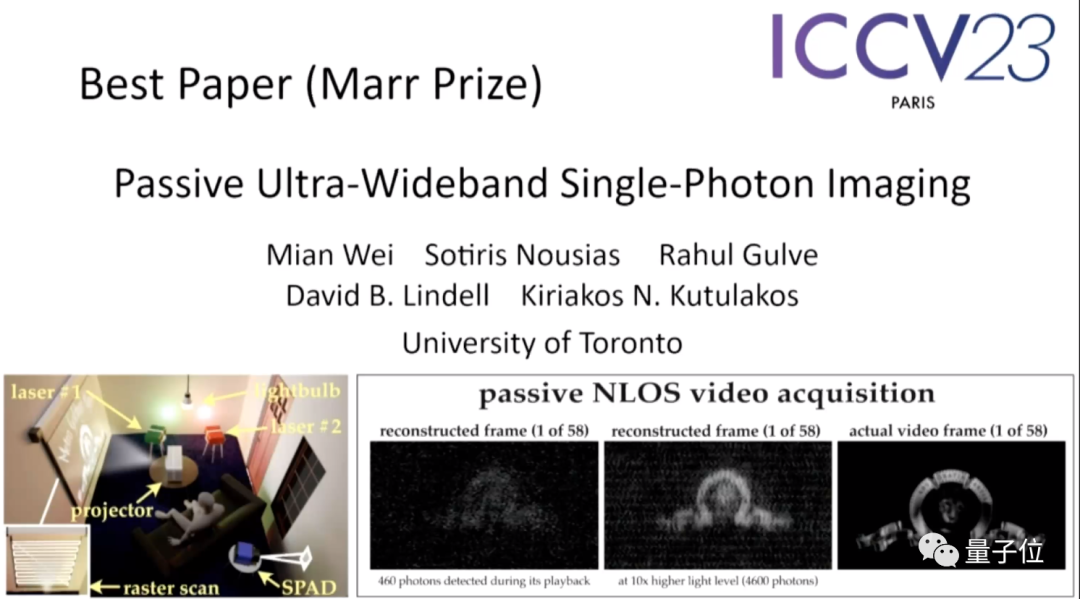

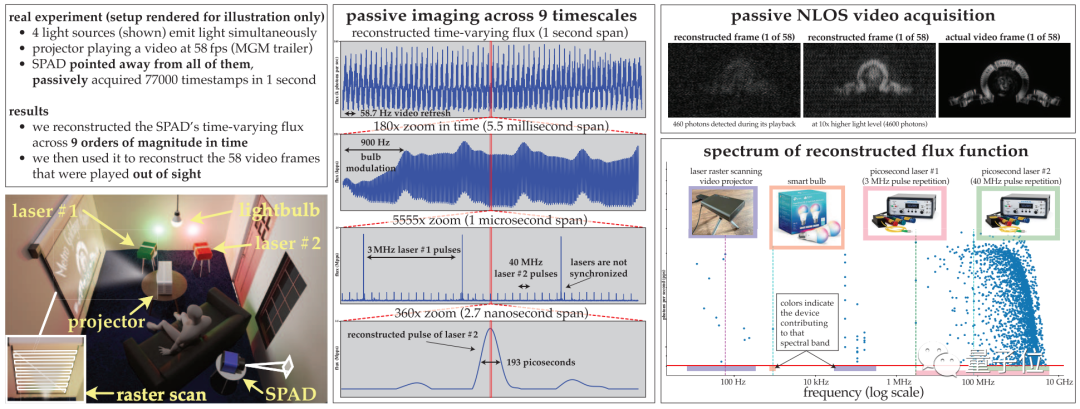

Kertas kedua "Passive Ultra-Wideband Single-Photon lmaging", daripada Universiti Toronto.

Kertas kerja ini dipanggil "kertas paling mengejutkan mengenai topik" oleh jawatankuasa pemilihan, sehinggakan salah seorang hakim berkata "hampir mustahil untuk dia berfikir untuk mencuba perkara sedemikian."

Abstrak kertas adalah seperti berikut:

Artikel ini membincangkan cara mengawal adegan dinamik Pengimejan secara serentak memerlukan pengimejan secara pasif (tanpa aktif menghantar sejumlah besar isyarat cahaya) dan dalam keadaan cahaya yang sangat jarang, dan tidak bergantung pada sebarang isyarat pemasaan daripada sumber cahaya.

Memandangkan teknik penganggaran aliran optik sedia ada untuk kamera foton tunggal gagal dalam julat ini, makalah ini membangunkan teori pengesanan aliran optik yang menggunakan idea kalkulus stokastik kepada aliran optik yang berubah-ubah masa yang dibina semula. piksel dalam aliran cap waktu pengesanan foton yang semakin monoton.

Berdasarkan teori ini, kertas kerja ini melakukan tiga perkara:

(1) Menunjukkan bahawa dalam keadaan aliran optik yang rendah, kamera pengesan panjang gelombang foton tunggal yang berjalan bebas pasif mempunyai lebar jalur Frekuensi yang boleh dicapai , merangkumi keseluruhan spektrum dari DC hingga 31 GHz;

(2) Terbitkan algoritma pembinaan semula aliran optik domain Fourier untuk mengimbas data cap masa untuk frekuensi dengan sokongan ketara secara statistik; model masih sah walaupun pada kiraan foton yang sangat rendah atau masa mati yang tidak boleh diabaikan.

(1) Sekiranya tiada penyegerakan (seperti mentol lampu, projektor, laser berbilang nadi ) , adegan pengimejan diterangi serentak oleh sumber cahaya yang berjalan pada kelajuan yang berbeza

(2) Koleksi video bukan garis pandang pasif # (3) Video jalur lebar ultra dirakam dan boleh dimainkan semula di 30 Hz untuk menunjukkan pergerakan setiap hari, tetapi juga boleh dimainkan semula pada satu bilion saat untuk menunjukkan cara cahaya bergerak.

Penulis pertama kertas kerja ialah Mian Wei, seorang pelajar kedoktoran di Universiti Toronto terletak pada peningkatan algoritma penglihatan komputer berdasarkan teknologi pengimejan pencahayaan aktif.

Penulis pertama kertas kerja ialah Mian Wei, seorang pelajar kedoktoran di Universiti Toronto terletak pada peningkatan algoritma penglihatan komputer berdasarkan teknologi pengimejan pencahayaan aktif.

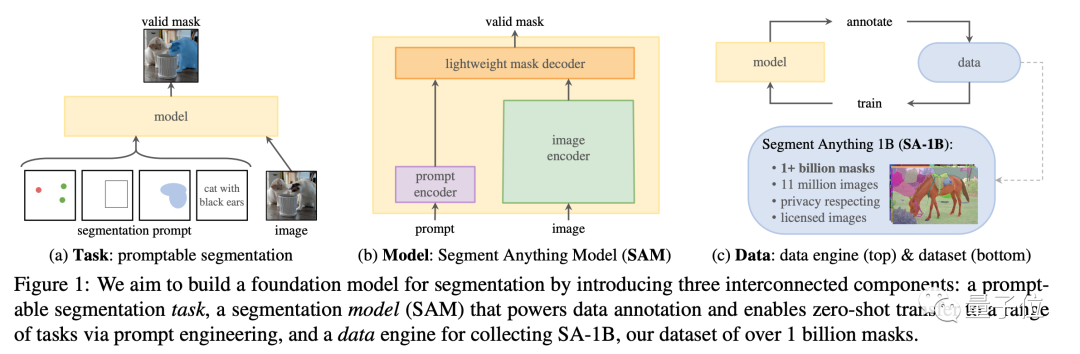

"Split Everything" menerima penghormatanPada persidangan ini, selain ControNet yang dinanti-nantikan, model Meta "Split Everything" turut memenangi penghormatan Kertas Terbaik Pencalonan Anugerah menjadi topik berprofil tinggi pada masa itu

Kertas ini bukan sahaja mencadangkan set data segmentasi imej terbesar pada masa ini, dengan 11J imej Terdapat lebih banyak daripada 1 bilion topeng, dan model SAM telah dilatih untuk tujuan ini, yang boleh membahagikan imej yang tidak kelihatan dengan cepat.

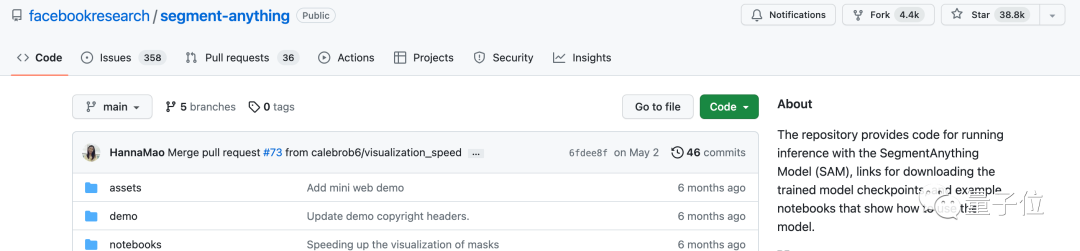

Model sumber terbuka ini pada masa ini telah menerima 38.8k bintang di GitHub, yang boleh dikatakan sebagai "penanda aras" dalam bidang segmentasi semantik

Model sumber terbuka ini pada masa ini telah menerima 38.8k bintang di GitHub, yang boleh dikatakan sebagai "penanda aras" dalam bidang segmentasi semantik

Dalam kerja pelajar, model Google "jejaki segala-galanya" menonjol

Sama seperti tajuk artikel, model ini boleh menjejak apa sahaja dalam imej di masa yang sama dari mana-mana sahaja# 🎜🎜#(Berbilang)Objek dijejaki pada tahap piksel.

Pengarang pertama projek itu ialah Qianqian Wang, Ph.D Cina dari Universiti Cornell, yang kini sedang menjalankan penyelidikan pasca doktoral di UCB.

#🎜🎜🎜##🎜🎜🎜 Laman utama projek: https://omnimotion.github.io/

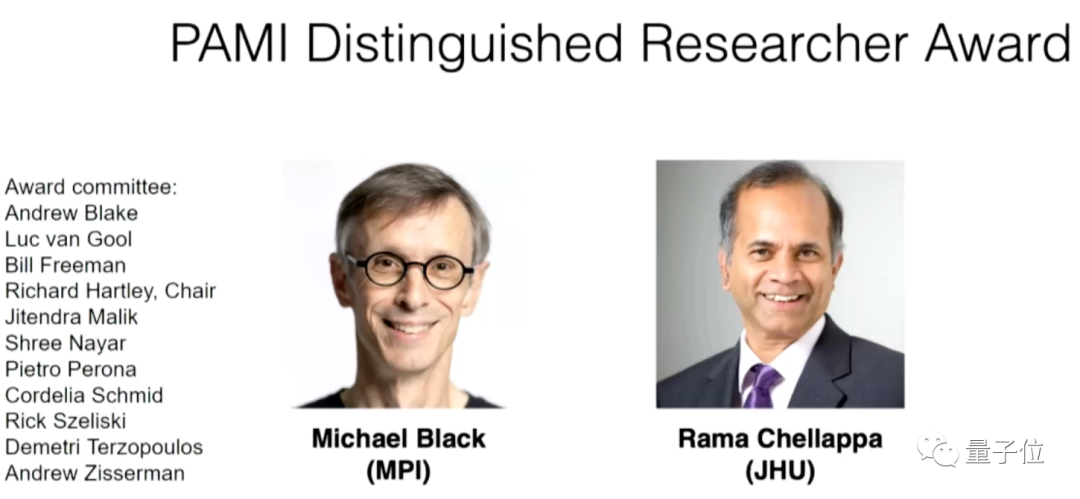

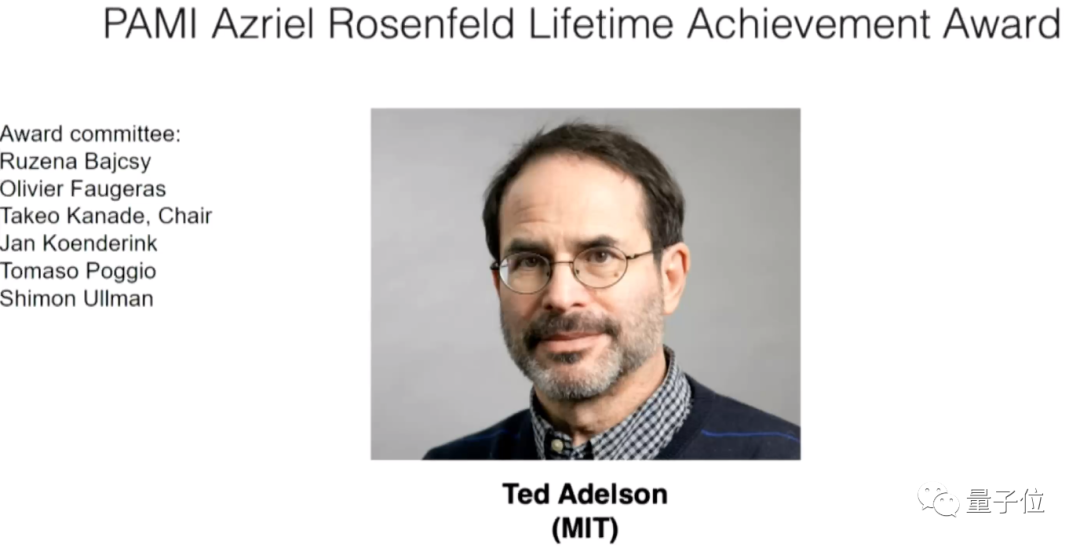

Pada majlis perasmian, anugerah khas yang disumbangkan oleh ahli jawatankuasa PAMIC turut diumumkan, yang turut menyumbangkan anugerah untuk dua persidangan lapangan visi komputer, CVPR dan WACV

Empat anugerah berikut disertakan:

- hai Mkhize Award: Kertas kerja ICCV yang memberi impak besar kepada penyelidikan penglihatan komputer sepuluh tahun yang lalu

- Anugerah Everingham: Kemajuan dalam bidang penglihatan komputer

- Penyelidik Cemerlang: Penyelidik yang telah memberikan sumbangan besar kepada kemajuan visi komputer

- Anugerah Pencapaian Sepanjang Hayat Rosenfeld: Penyelidik yang telah membuat sumbangan besar dalam bidang penglihatan komputer sepanjang kerjaya mereka yang panjang

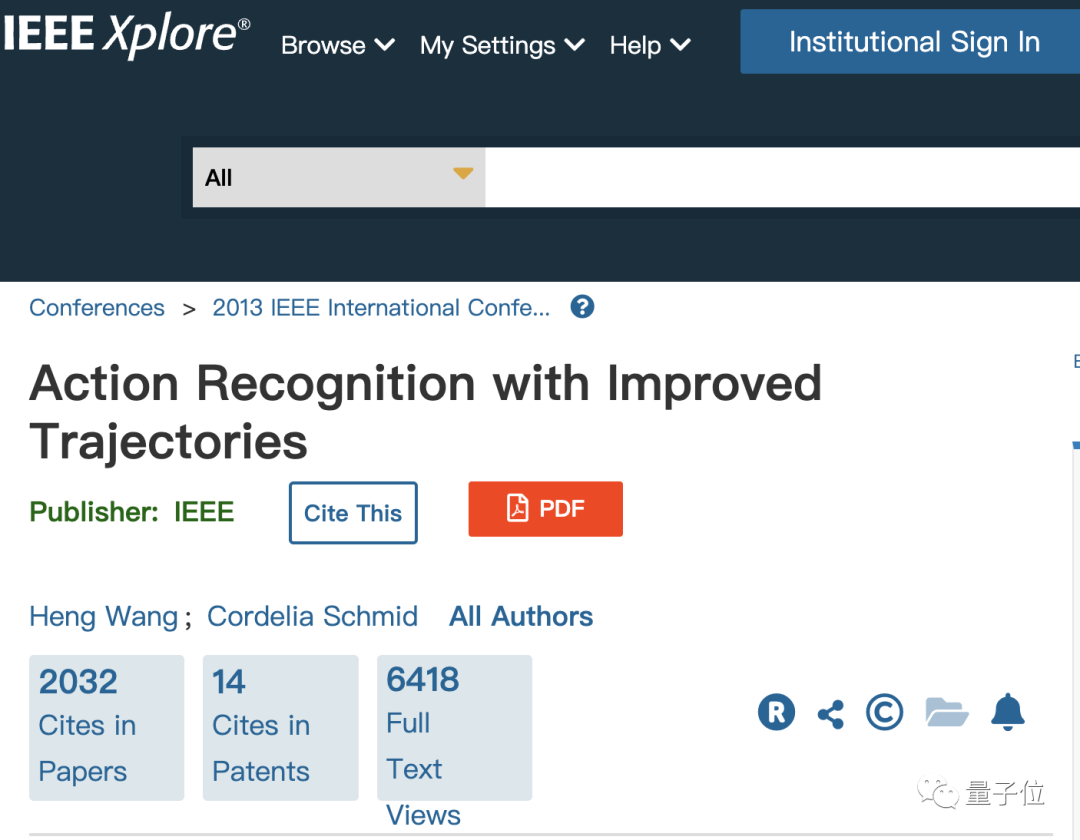

Para saintis yang memenangi Hadiah Helmholtz ialah saintis China Heng Wang dan Cordelia Schmid Google, yang merupakan ahli Meta AI

Mereka memenangi anugerah untuk kertas kerja yang mereka terbitkan pada 2013 mengenai pengiktirafan tindakan.

Pada masa itu, kedua-dua mereka bekerja di makmal Lear di bawah Institut Pengkomputeran dan Automasi Kebangsaan Perancis (singkatan bahasa Perancis: INRIA), dan Schmid adalah ketua makmal itu pada masa itu.

Sila klik pautan berikut untuk melihat kertas kerja: https://ieeexplore.ieee.org/document/6751553

Hadiah Everingham telah dianugerahkan kepada dua pasukan

Pemenang kumpulan pertama ialah Samer daripada Google Agarwal, Keir Mierle dan pasukan mereka

Kedua-dua pemenang masing-masing lulus dari Universiti Washington dan Universiti Toronto Pencapaian mereka adalah untuk membangunkan perpustakaan C++ sumber terbuka Ceres Solver

projek yang digunakan secara meluas. dalam bidang visi komputer Pautan halaman utama: http://ceres-solver.org/

Satu lagi keputusan yang memenangi anugerah ialah set data COCO, yang mengandungi sejumlah besar imej dan anotasi, mempunyai kandungan dan tugas yang kaya, dan merupakan data penting untuk menguji set model penglihatan komputer.

Set data ini dicadangkan oleh Microsoft. Pengarang pertama kertas yang berkaitan ialah saintis Cina Tsung-Yi Lin Dia lulus dari Universiti Cornell dengan Ph.D dan kini bekerja sebagai penyelidik di NVIDIA Labs.

Alamat kertas: https://arxiv.org/abs/1405.0312

Laman utama projek: https://cocodataset.org/

Penyelidikan yang cemerlang dan yang terbaik Profesor Max Planck Jerman Michael Black dari Institut dan Rama Chellappa dari Universiti Johns Hopkins.

Profesor Ted Adelson dari MIT memenangi Anugerah Pencapaian Sepanjang Hayat

Adakah kertas kerja anda telah diterima oleh ICCV 2023? Apakah pendapat anda tentang pemilihan anugerah tahun ini?

Atas ialah kandungan terperinci Anugerah kertas ICCV'23 'Fighting of Gods'! Meta Divide Everything dan ControlNet telah dipilih secara bersama, dan terdapat satu lagi artikel yang mengejutkan para hakim. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!