Rumah >Peranti teknologi >AI >Halusinasi? Musk's TruthGPT juga tidak boleh menanganinya! Pengasas bersama OpenAI berkata ia rumit

Halusinasi? Musk's TruthGPT juga tidak boleh menanganinya! Pengasas bersama OpenAI berkata ia rumit

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-05-23 19:13:04718semak imbas

Bulan lepas, Musk menggesa agar penyelidikan dan pembangunan super AI ditangguhkan selama 6 bulan.

Tidak lama kemudian, Lao Ma tidak boleh duduk diam dan secara rasmi mengumumkan pelancaran platform AI yang dipanggil TruthGPT.

Musk telah berkata bahawa TruthGPT akan menjadi "kecerdasan buatan mencari kebenaran terbesar" yang akan cuba memahami sifat alam semesta.

Beliau menekankan bahawa AI yang mengambil berat tentang memahami alam semesta tidak mungkin akan menghapuskan manusia kerana kita adalah bahagian yang menarik dari alam semesta.

Walau bagaimanapun, tiada model bahasa yang boleh mengendalikan "ilusi" setakat ini.

Baru-baru ini, pengasas bersama OpenAI menjelaskan mengapa merealisasikan cita-cita tinggi TruthGPT sangat sukar.

TruthGPT ideal adalah gelembung?

KebenaranGPT yang ingin dibina oleh X.AI Musk ialah model bahasa yang jujur.

Dengan berbuat demikian, kami terus menyasarkan ChatGPT.

Kerana, sebelum ini, sistem AI seperti ChatGPT sering menghasilkan kes halusinasi klasik seperti keluaran yang salah, malah menyokong laporan kepercayaan politik tertentu.

Walaupun ChatGPT membolehkan pengguna mempunyai lebih kawalan ke atas model bahasa untuk menyelesaikan masalah, "ilusi" masih menjadi masalah teras yang mesti ditangani oleh syarikat kecerdasan buatan OpenAI, Google dan Musk dalam masa hadapan.

Pengasas bersama OpenAI dan penyelidik John Schulman membincangkan cabaran ini dan cara menanganinya dalam ceramahnya "RL and Truthfulness – Towards TruthGPT".

Mengapa ada "halusinasi"?

Menurut Schulman, halusinasi boleh dibahagikan secara kasar kepada dua jenis:

1 "Tingkah laku penyempurnaan mod", iaitu model bahasa tidak boleh diungkapkan itu sendiri Ketidakpastian, ketidakupayaan untuk menyoal premis dengan segera, atau meneruskan kesilapan sebelumnya.

2.

Memandangkan model bahasa mewakili graf pengetahuan yang mengandungi fakta daripada data latihan dalam rangkaiannya sendiri, penalaan halus boleh difahami sebagai mempelajari fungsi yang beroperasi pada graf dan output pengetahuan ini ramalan token.

Sebagai contoh, set data penalaan halus mungkin mengandungi soalan "Apakah genre Star Wars dan jawapan "Fiksyen Sains?"

Jika maklumat ini sudah ada dalam data latihan asal, iaitu ia adalah sebahagian daripada graf pengetahuan, maka model tidak akan mempelajari maklumat baharu; Perbuatan - mengeluarkan jawapan yang betul. Penalaan halus ini juga dipanggil "pengklonan tingkah laku".

Tetapi masalahnya, jika soalan tentang "Apakah nama filem spin-off Han Solo" muncul dalam set data penalaan halus.

Tetapi jika jawapan "Solo" bukan sebahagian daripada set data latihan asal (atau sebahagian daripada graf pengetahuan), rangkaian akan belajar untuk menjawab walaupun ia tidak mengetahui jawab.

Mengajar rangkaian untuk membuat jawapan—iaitu mencipta "halusinasi"—dengan memperhalusinya menggunakan jawapan yang sebenarnya betul tetapi tidak dalam graf pengetahuan. Sebaliknya, latihan dengan jawapan yang salah menyebabkan rangkaian menahan maklumat.

Oleh itu, pengklonan tingkah laku sebaiknya sentiasa berdasarkan pengetahuan rangkaian, tetapi pengetahuan ini selalunya tidak diketahui oleh pekerja manusia yang mencipta atau menilai set data, seperti untuk penalaan arahan.

Menurut Schulman, masalah ini juga wujud apabila model lain mencipta set data yang diperhalusi, seperti yang berlaku dengan formula Alpaca.

Dia meramalkan bahawa rangkaian yang lebih kecil dengan graf pengetahuan yang lebih kecil bukan sahaja akan belajar menggunakan output ChatGPT untuk memberi jawapan dan mengikut arahan, tetapi juga belajar untuk berhalusinasi dengan lebih kerap.

Bagaimanakah OpenAI memerangi halusinasi?

Pertama sekali, untuk soalan mudah, model bahasa boleh meramalkan sama ada mereka tahu jawapan dalam kebanyakan kes, dan juga boleh menyatakan ketidakpastian.

Oleh itu, Schulman berkata bahawa apabila memperhalusi set data, model mesti belajar cara menyatakan ketidakpastian, cara menangani situasi di mana premis diubah dan apabila ralat diakui .

Anda perlu memberi contoh situasi ini kepada model dan biarkan mereka belajar.

Tetapi model masih kurang terlatih dalam pemasaan, iaitu, mereka tidak tahu bila hendak melaksanakan operasi ini.

Schulman berkata di sinilah pembelajaran peneguhan (RL) dimainkan. Contohnya, Pembelajaran Pengukuhan dengan Maklum Balas Manusia (RLHF) berdasarkan maklum balas manusia.

Menggunakan RL, model boleh mempelajari "sempadan tingkah laku" dan mengetahui masa untuk melaksanakan tingkah laku.

Kesukaran lain ialah keupayaan untuk mendapatkan semula dan memetik sumber.

Persoalannya, dengan kebolehan meniru tingkah laku dan RLHF, kenapa ChatGPT masih menghasilkan halusinasi?

Puncanya terletak pada kesukaran masalah itu sendiri.

Walaupun kaedah di atas berfungsi dengan baik untuk soalan dan jawapan pendek, masalah lain timbul dengan tetapan format panjang yang biasa di ChatGPT.

Di satu pihak, jawapan yang salah sama sekali tidak mungkin.

Dalam kes yang melampau, ini mungkin hanya kesilapan dalam 100 baris kod.

Dalam kes lain, maklumat itu tidak salah dalam erti kata konvensional sebaliknya mengelirukan. Oleh itu, dalam sistem seperti ChatGPT, adalah sukar untuk mengukur kualiti output dari segi kandungan maklumat atau ketepatan.

Tetapi ukuran ini sangat penting untuk algoritma RL yang direka untuk melatih sempadan tingkah laku yang kompleks.

Pada masa ini, OpenAI bergantung pada model ganjaran berasaskan ranking RLHF, yang mampu meramalkan antara dua jawapan yang difikirkan lebih baik, tetapi tidak memberikan isyarat yang berkesan tentang yang mana satu Lebih baik, lebih bermaklumat atau betul jawapannya.

Schulman berkata ia tidak mempunyai keupayaan untuk memberikan maklum balas kepada model untuk mempelajari sempadan tingkah laku yang baik. Dan sempadan tingkah laku yang baik ini adalah cara yang mungkin untuk menyelesaikan ilusi.

Selain itu, proses ini dirumitkan lagi oleh kesilapan manusia dalam proses pelabelan RLHF.

Oleh itu, walaupun Schulman menganggap RL sebagai salah satu cara penting untuk mengurangkan halusinasi, dia percaya masih banyak masalah yang belum diselesaikan.

Kecuali rupa model ganjaran yang dinyatakan di atas untuk membimbing tingkah laku yang betul, RLHF pada masa ini hanya bergantung pada pertimbangan manusia.

Ini mungkin menyukarkan penjanaan pengetahuan. Kerana ramalan tentang masa depan kadangkala membawa kepada persembahan yang kurang meyakinkan.

Walau bagaimanapun, Schulman percaya bahawa penjanaan pengetahuan adalah langkah penting seterusnya dalam model bahasa Pada masa yang sama, beliau percaya bahawa pembinaan teori masalah seperti meramal masa depan dan memberi peraturan inferens adalah jenis seterusnya. masalah terbuka yang perlu diselesaikan dengan segera.

Schulman berkata satu penyelesaian yang mungkin adalah menggunakan model AI lain untuk melatih model bahasa.

OpenAI juga percaya bahawa kaedah ini sangat bermakna untuk penjajaran AI.

Arkitek ChatGPT

Sebagai arkitek ChatGPT, John Schulman menyertai OpenAI sebagai salah seorang pengasas bersama seawal tahun 2015 ketika beliau masih belajar di peringkat PhD.

Dalam temu bual, Schulman menjelaskan mengapa dia menyertai OpenAI:

Saya mahu melakukannya Berkenaan penyelidikan kecerdasan buatan, saya rasa OpenAI mempunyai misi yang bercita-cita tinggi dan komited untuk membina kecerdasan buatan am.

Walaupun, bercakap tentang AGI kelihatan agak gila pada masa itu, saya fikir adalah munasabah untuk mula memikirkannya, dan saya mahu berada di tempat di mana bercakap tentang AGI boleh diterima .

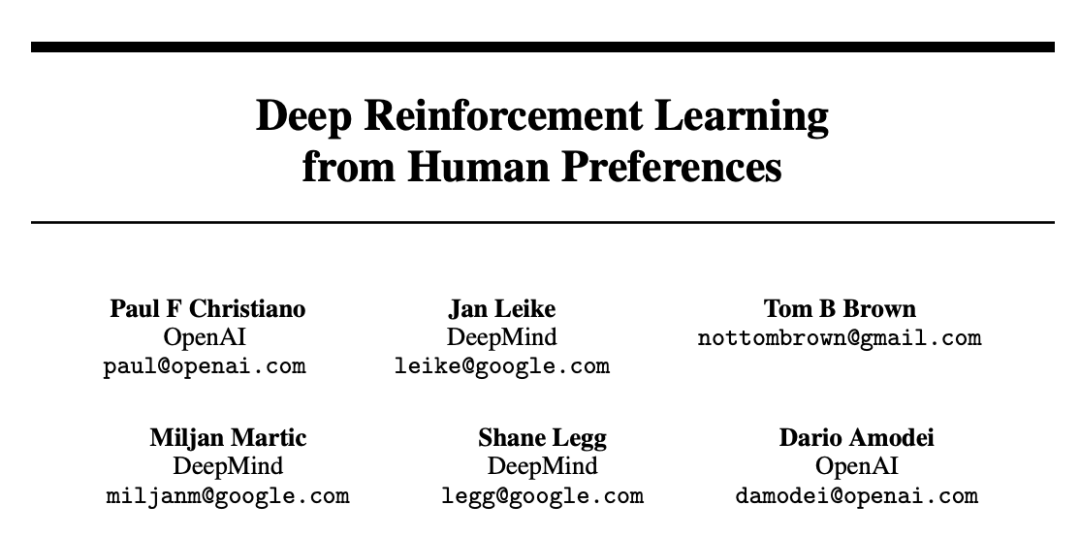

Selain itu, menurut Schulman, idea OpenAI untuk memperkenalkan pembelajaran pengukuhan maklum balas manusia (RLHF) ke dalam ChatGPT boleh dikesan sejak 17 tahun lalu.

Pada masa itu, beliau juga merupakan ahli OpenAI dan menerbitkan kertas kerja "Pembelajaran Pengukuhan Dalam Dari Keutamaan Manusia" yang menyebut kaedah ini.

Alamat kertas: https://arxiv.org/pdf/1706.03741.pdf

Sebab pasukan keselamatan OpenAI mengusahakan perkara ini adalah kerana mereka ingin menyelaraskan model mereka dengan pilihan manusia—cuba menjadikan model benar-benar mendengar manusia dan cuba melakukan perkara yang manusia mahu lakukan.

Apabila GPT-3 menamatkan latihan, maka Schulman memutuskan untuk menyertai trend ini kerana dia melihat potensi keseluruhan hala tuju penyelidikan.

Apabila ditanya apakah reaksi pertamanya apabila dia menggunakan ChatGPT buat kali pertama, kata-kata Schulman mendedahkan "tiada emosi".

Saya masih ingat ChatGPT keluar tahun lepas, yang membuatkan otak ramai orang meletup serta-merta.

Dan tiada sesiapa di dalam OpenAI teruja dengan ChatGPT. Oleh kerana ChatGPT yang dikeluarkan adalah model yang lebih lemah berdasarkan GPT-3.5, rakan sekerja sedang bermain dengan GPT-4 pada masa itu.

Jadi pada masa itu, tiada sesiapa di OpenAI yang teruja dengan ChatGPT kerana terdapat model yang lebih berkuasa dan lebih pintar yang telah dilatih.

Berkenaan sempadan kecerdasan buatan seterusnya pada masa hadapan, Schulman berkata bahawa AI terus memperbaiki tugas yang lebih sukar, dan kemudian persoalannya menjadi, apakah yang perlu dilakukan oleh manusia? tugas di mana manusia boleh mempunyai pengaruh yang lebih besar dan melakukan lebih banyak kerja dengan bantuan model besar.

Atas ialah kandungan terperinci Halusinasi? Musk's TruthGPT juga tidak boleh menanganinya! Pengasas bersama OpenAI berkata ia rumit. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI