Rumah >Peranti teknologi >AI >UCSD, MIT dan pasukan China yang lain mengajar anjing robot untuk melihat dunia 3D! Dengan cip M1, anda boleh menaiki tangga dan merentas halangan.

UCSD, MIT dan pasukan China yang lain mengajar anjing robot untuk melihat dunia 3D! Dengan cip M1, anda boleh menaiki tangga dan merentas halangan.

- 王林ke hadapan

- 2023-05-22 22:22:141455semak imbas

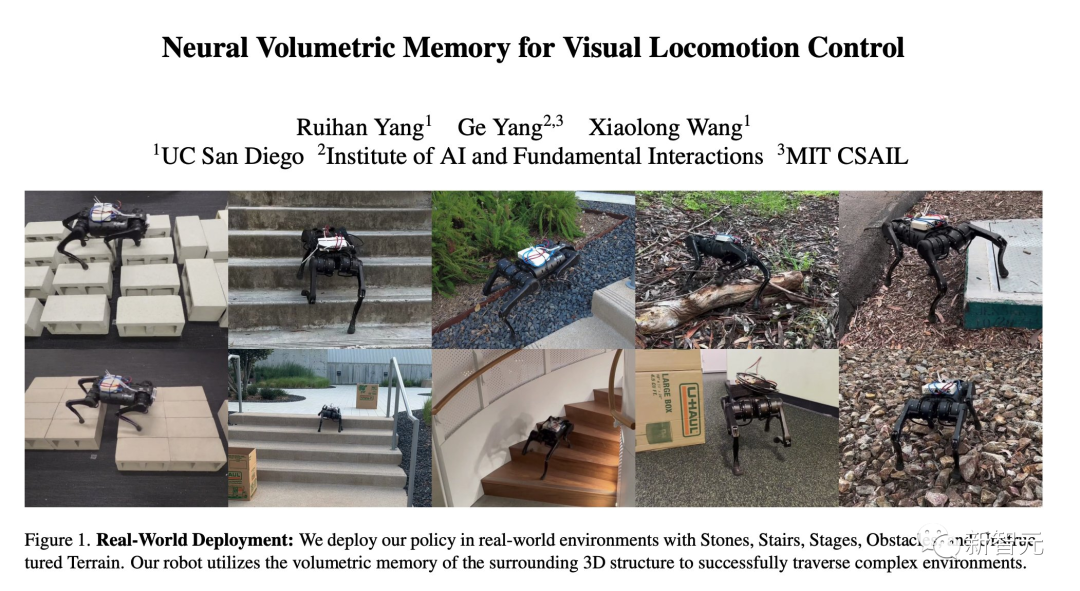

Baru-baru ini, penyelidik dari institusi UCSD, IAIFI dan MIT menggunakan seni bina ingatan volumetrik neural (NVM) baharu untuk mengajar anjing robot untuk melihat dunia tiga dimensi.

Menggunakan teknologi ini, anjing robot boleh memanjat tangga, merentasi celah, memanjat halangan, dsb. melalui rangkaian saraf tunggal - sepenuhnya secara autonomi, tanpa memerlukan alat kawalan jauh.

Saya tertanya-tanya adakah anda perasan kotak putih di belakang anjing itu?

Ia dilengkapi dengan cip M1 Apple, yang bertanggungjawab untuk menjalankan tugas pemprosesan visual anjing robot itu. Selain itu, pasukan itu mengeluarkannya daripada Mac.

Tidak sukar untuk melihat bahawa anjing robot dari MIT ini boleh dengan mudah memanjat bahagian dahan di hadapannya tanpa sebarang usaha (pada dasarnya).

Macbook dengan 4 kaki?

Seperti yang kita sedia maklum, amat sukar bagi anjing robot dan robot lain yang berkaki untuk melintas jalan yang tidak rata.

Semakin kompleks keadaan jalan raya, semakin banyak halangan yang tidak dapat dilihat.

Untuk menyelesaikan masalah "persekitaran separa boleh diperhatikan", teknologi gerakan visual SOTA semasa menghubungkan saluran imej melalui penyusunan bingkai.

Walau bagaimanapun, kaedah pemprosesan mudah ini jauh ketinggalan berbanding teknologi penglihatan komputer semasa, yang boleh memodelkan aliran optik dan geometri 3D tertentu secara eksplisit.

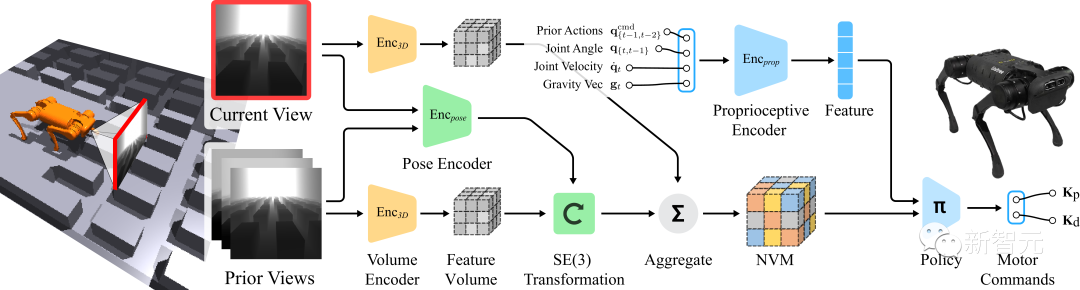

Diilhamkan oleh ini, pasukan mencadangkan seni bina ingatan volum neural (NVM) yang boleh mengambil kira kesetaraan SE(3) dunia tiga dimensi sepenuhnya.

Alamat projek: https://rchalyang.github.io/NVM/

Tidak seperti kaedah sebelumnya, NVM ialah format volumetrik. Ia mengagregatkan volum ciri daripada berbilang paparan kamera ke dalam bingkai egosentrik robot, membolehkan robot memahami persekitarannya dengan lebih baik.

Keputusan ujian menunjukkan bahawa selepas menggunakan memori volumetrik neural (NVM) untuk melatih pergerakan kaki, prestasi robot di kawasan kompleks adalah jauh lebih baik daripada teknologi sebelumnya.

Tambahan pula, hasil daripada eksperimen ablasi menunjukkan bahawa kandungan yang disimpan dalam memori volumetrik neural menangkap maklumat geometri yang mencukupi untuk membina semula pemandangan 3D.

Eksperimen dunia sebenar

Untuk mengesahkan dalam senario dunia sebenar yang berbeza di luar simulasi, pasukan menjalankan eksperimen dalam senario dalaman dan luaran Semua eksperimen dijalankan.

Apabila anjing robot mendapati halangan tiba-tiba muncul di hadapannya, ia akan memilih untuk mengelaknya secara langsung.

Nampaknya tiada masalah berjalan di atas tanah berbatu, walaupun ia masih lebih berat daripada di tanah rata. Beberapa.

Halangan yang agak besar berbanding diri sendiri masih boleh diatasi dengan usaha yang gigih.

Menggunakan teknologi kawalan pengecaman sebelum ini, kaki belakang anak anjing itu jelas membuat kesilapan dalam menilai jarak ia melangkah ke dalam parit dan terbalik, yang gagal.

Selepas menerima pakai NVM yang dicadangkan oleh MIT, anak anjing itu menyeberangi parit, kebahagiaan yang stabil, kejayaan!

Menggunakan teknologi kawalan pengecaman sebelumnya, anak anjing itu terlepas sasaran dengan tendangan pertamanya, dan kepala anjing itu mencengkam tanah dan gagal.

Selepas menerima pakai NVM yang dicadangkan oleh MIT, anak anjing itu berjalan lancar melalui matriks. > Menggunakan perspektif kamera yang egosentrik pada asasnya adalah masalah menangani "persekitaran yang boleh diperhatikan separa" (Diperhatikan Separa).

Untuk menjadikan masalah kawalan itu konkrit, robot perlu mengumpulkan maklumat daripada bingkai sebelumnya dan membuat kesimpulan yang betul tentang rupa bumi yang tersumbat.

Semasa pergerakan, kamera yang dipasang terus pada casis robot mengalami perubahan kedudukan yang drastik dan mendadak. Dengan cara ini, dalam proses mencirikan satu siri gambar, menjadi sangat penting untuk satu bingkai boleh diletakkan pada kedudukan yang betul.

Untuk tujuan ini, konsep memori volum neural (NVM) yang dicadangkan oleh pasukan boleh menukar satu siri maklumat visual input kepada ciri pemandangan untuk gambaran 3D dan kemudian output.

Belajar NVM melalui penyeliaan diri

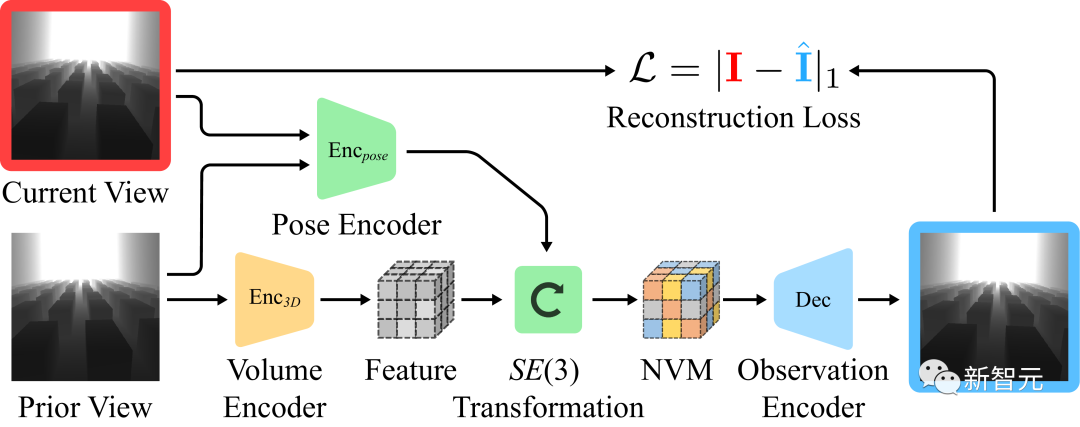

Walaupun "sasaran pengklonan tingkah laku " Memadai untuk menjana dasar yang baik, tetapi menyasarkan kesetaraan terjemahan dan putaran, secara automatik menyediakan objektif pembelajaran bebas yang diselia sendiri untuk memori volumetrik neural.

Pembelajaran penyeliaan kendiri: Pasukan penyelidik melatih penyahkod bebas. Biarkan ia meramalkan pemerhatian visual dalam bingkai yang berbeza dengan mengambil pemerhatian visual dan menganggarkan peralihan antara dua bingkai.

Seperti yang ditunjukkan dalam imej di atas, boleh diandaikan bahawa pemandangan 3D di sekeliling kekal tidak berubah antara bingkai. Memandangkan kamera melihat ke hadapan, kami boleh menormalkan volum ciri daripada bingkai sebelumnya dan menggunakannya untuk meramalkan imej seterusnya.

Pembinaan semula visual penyahkod

Imej pertama menunjukkan robot bergerak dalam persekitaran, dan imej kedua ialah pemerhatian visual input, Gambar ketiga ialah kesan pemerhatian visual menggunakan volum ciri 3D dan anggaran sintesis gambar. Untuk pemerhatian visual input, pasukan penyelidik menggunakan sejumlah besar peningkatan data pada imej untuk meningkatkan keteguhan model.

Pengenalan Pengarang

Ruihan Yan

Ruihan Yan ialah pelajar kedoktoran tahun kedua di University of California, San Diego. Sebelum itu, beliau memperoleh ijazah sarjana muda dalam bidang kejuruteraan perisian dari Universiti Nankai pada 2019

Minat penyelidikannya ialah pembelajaran pengukuhan, pembelajaran mesin, robotik, dsb. Secara khusus, beliau mahu membina ejen pintar yang menggunakan maklumat daripada sumber yang berbeza untuk membuat keputusan.

Ge Yang

Ge Yang Undergraduate Beliau lulus dari Universiti Yale dengan jurusan fizik dan matematik dan menerima PhD dalam fizik dari Universiti Chicago. Pada masa ini, beliau adalah penyelidik pasca doktoral di Institut Kecerdasan Buatan dan Interaksi Fundamental (IAIFI) Yayasan Sains Kebangsaan.

Penyelidikan Ge Yang melibatkan dua set isu berkaitan. Kumpulan pertama adalah untuk meningkatkan pembelajaran dengan menyemak semula cara kami mewakili pengetahuan dalam rangkaian saraf dan cara pengetahuan dipindahkan merentas pengedaran. Kumpulan kedua melihat pembelajaran pengukuhan melalui kanta alat teori seperti kernel tangen saraf, geometri bukan Euclidean, dan dinamik Hamiltonian.

Xiaolong Wang

Xiaolong Wang ialah Penolong Profesor di Jabatan ECE di UC San Diego. Beliau adalah ahli pasukan robotik di Institut Yayasan Sains Kebangsaan TILOS untuk Kepintaran Buatan.

Beliau menerima PhD dalam bidang robotik dari Carnegie Mellon University dan melakukan penyelidikan pasca doktoral di University of California, Berkeley.

Atas ialah kandungan terperinci UCSD, MIT dan pasukan China yang lain mengajar anjing robot untuk melihat dunia 3D! Dengan cip M1, anda boleh menaiki tangga dan merentas halangan.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI