Rumah >Peranti teknologi >AI >Menjana video adalah sangat mudah, cuma berikan petunjuk dan anda juga boleh mencubanya dalam talian

Menjana video adalah sangat mudah, cuma berikan petunjuk dan anda juga boleh mencubanya dalam talian

- 王林ke hadapan

- 2023-05-20 17:16:191680semak imbas

Anda memasukkan teks dan membiarkan AI menjana video. Idea ini hanya muncul dalam imaginasi orang sebelum ini, dengan perkembangan teknologi, fungsi ini telah direalisasikan.

Dalam beberapa tahun kebelakangan ini, kecerdasan buatan generatif telah menarik perhatian besar dalam bidang penglihatan komputer. Dengan kemunculan model penyebaran, menghasilkan imej berkualiti tinggi daripada gesaan teks, iaitu sintesis teks ke imej, telah menjadi sangat popular dan berjaya.

Percubaan penyelidikan terkini untuk berjaya memanjangkan model resapan teks-ke-imej kepada tugas penjanaan dan pengeditan teks-ke-video dengan menggunakannya semula dalam domain video. Walaupun kaedah sedemikian telah mencapai hasil yang menjanjikan, kebanyakannya memerlukan latihan yang meluas menggunakan sejumlah besar data berlabel, yang mungkin terlalu mahal untuk kebanyakan pengguna.

Untuk menjadikan penjanaan video lebih murah, Tune-A-Video yang dicadangkan oleh Jay Zhangjie Wu et al tahun lepas memperkenalkan mekanisme untuk menggunakan model Stable Diffusion (SD) pada video padang . Hanya satu video yang perlu dilaraskan, sangat mengurangkan beban kerja latihan. Walaupun ini jauh lebih cekap daripada kaedah sebelumnya, ia masih memerlukan pengoptimuman. Tambahan pula, keupayaan penjanaan Tune-A-Video adalah terhad kepada aplikasi penyuntingan video berpandukan teks, dan penggubahan video dari awal kekal di luar kemampuannya.

Dalam artikel ini, penyelidik dari Picsart AI Resarch (PAIR), University of Texas di Austin dan institusi lain telah menggunakan zero-shot dan tiada latihan untuk mencapai kaedah text-to baharu -sintesis video Satu langkah ke hadapan dalam arah masalah menjana video berdasarkan gesaan teks tanpa sebarang pengoptimuman atau penalaan halus.

- Alamat kertas: https://arxiv.org/ pdf/2303.13439.pdf

- Alamat projek: https://github.com/Picsart-AI-Research/Text2Video-Zero

- Alamat percubaan: https://huggingface.co/spaces/PAIR/Text2Video-Zero

Mari kita lihat cara ia berfungsi. Contohnya, seekor panda sedang melayari; seekor beruang sedang menari di Times Square:

Penyelidikan ini juga boleh menjana tindakan berdasarkan pada sasaran :

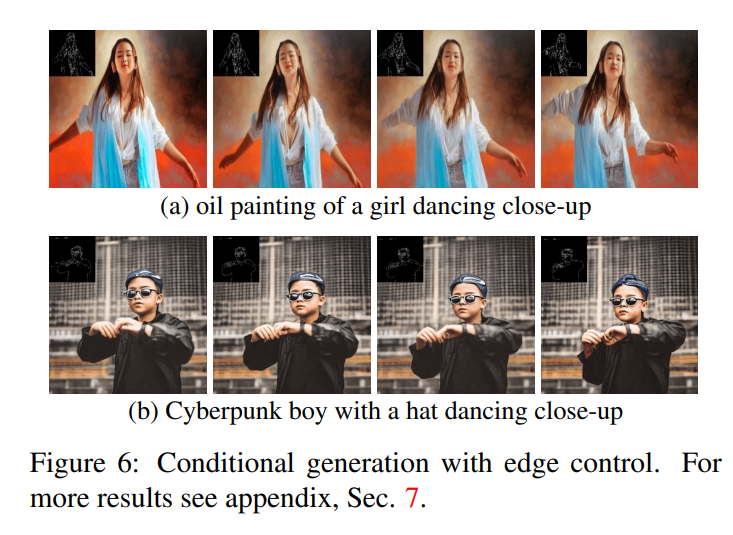

Selain itu, pengesanan tepi boleh dilakukan:

Konsep utama pendekatan yang dicadangkan dalam kertas kerja ini ialah mengubah suai model teks-ke-imej yang telah terlatih (cth. Resapan Stabil) untuk memperkayakannya mengikut masa -generasi yang konsisten. Dengan membina model teks-ke-imej yang sudah terlatih, pendekatan kami memanfaatkan kualiti penjanaan imej yang sangat baik, meningkatkan kebolehgunaannya pada domain video tanpa memerlukan latihan tambahan.

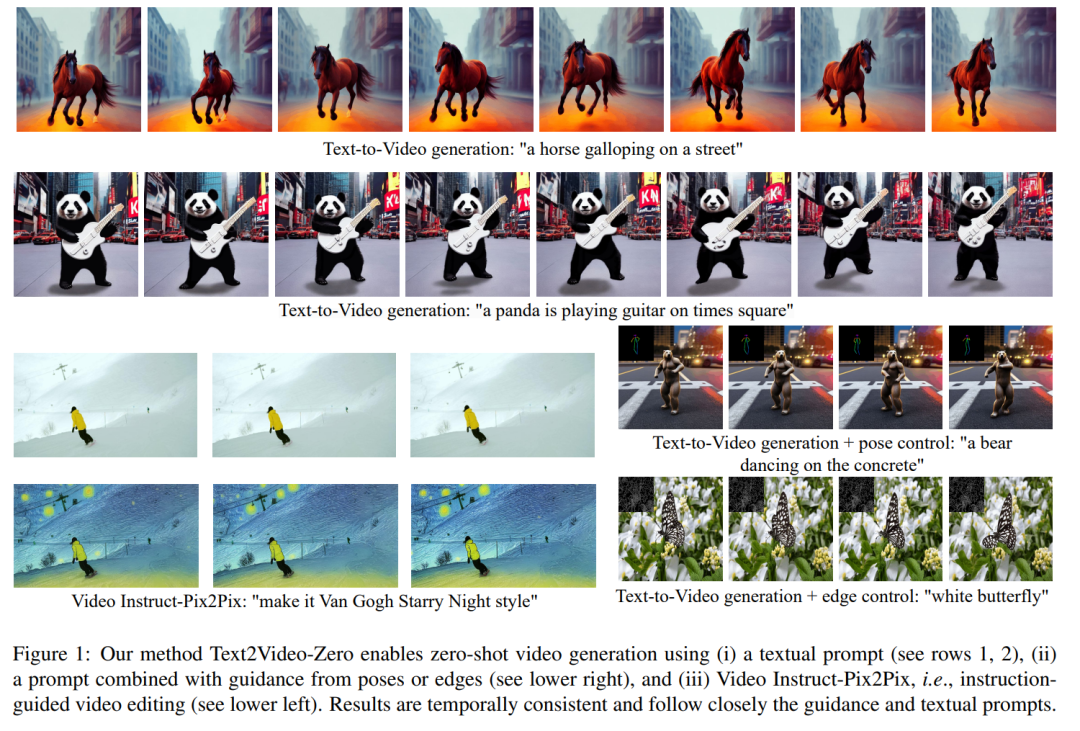

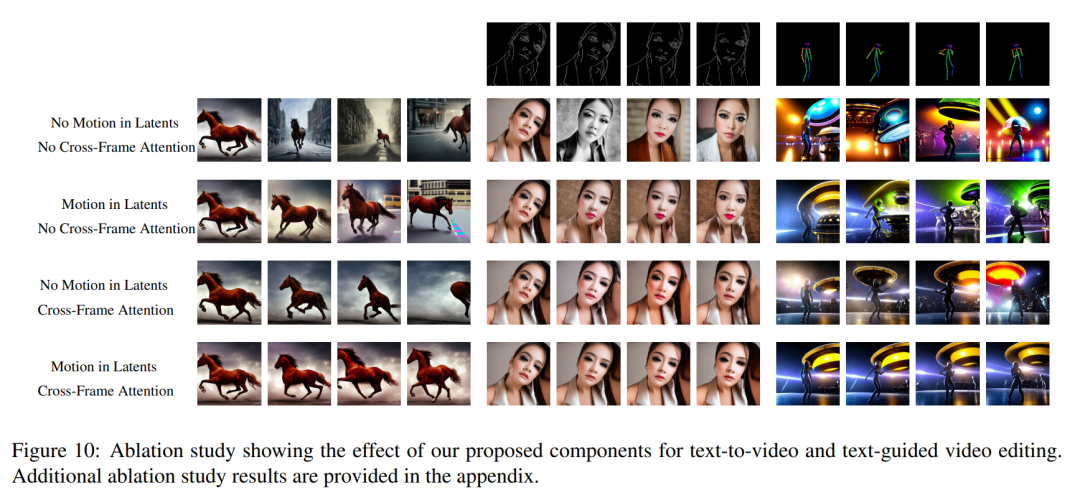

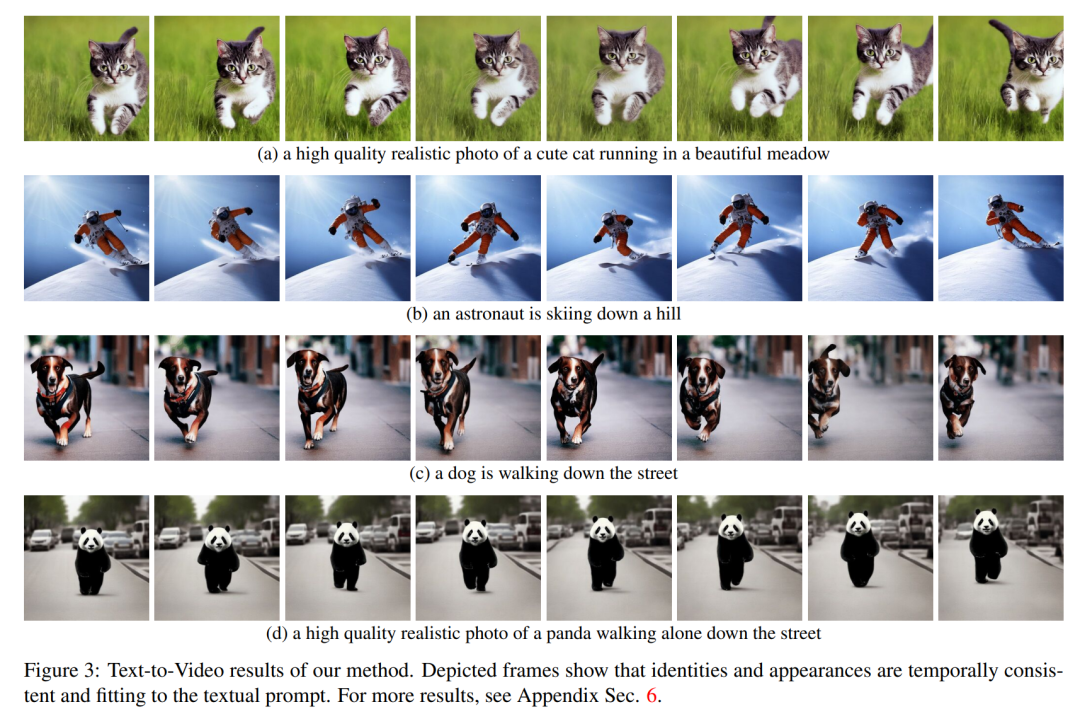

Untuk meningkatkan ketekalan temporal, kertas kerja ini mencadangkan dua pengubahsuaian inovatif: (1) mula-mula memperkayakan pengekodan terpendam bagi bingkai yang dijana dengan maklumat gerakan untuk memastikan pemandangan dan latar belakang global konsisten secara sementara; (2) ) kemudian menggunakan mekanisme perhatian bingkai silang untuk mengekalkan konteks, rupa dan identiti objek latar depan sepanjang jujukan. Eksperimen menunjukkan bahawa pengubahsuaian mudah ini boleh menghasilkan video yang berkualiti tinggi dan konsisten dari segi masa (ditunjukkan dalam Rajah 1).

Sementara kerja orang lain dilatih pada data video berskala besar, kaedah kami mencapai prestasi yang serupa dan kadangkala lebih baik (seperti yang ditunjukkan dalam Rajah 8, 9).

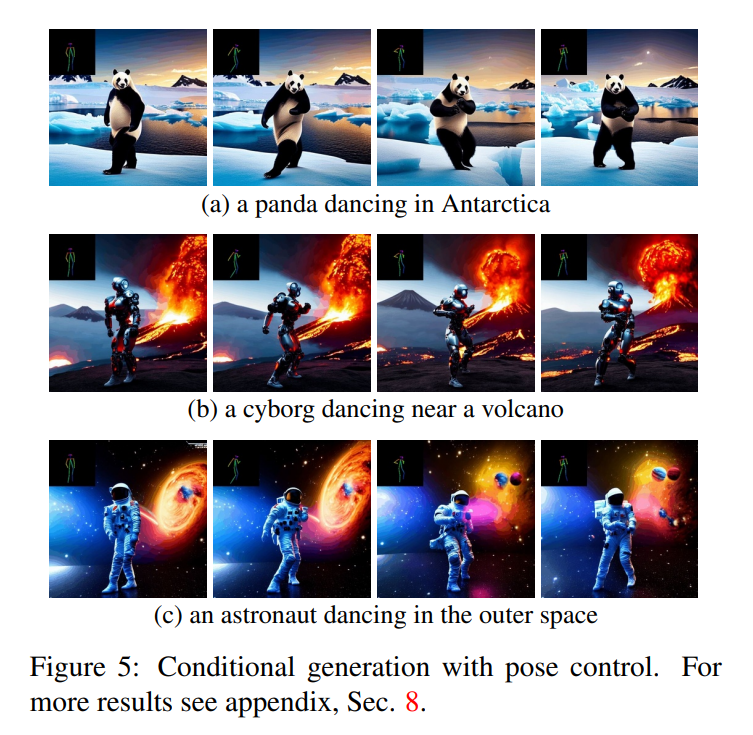

Kaedah dalam artikel ini tidak terhad kepada sintesis teks-ke-video, tetapi juga sesuai untuk bersyarat (lihat Rajah 6, 5) dan penjanaan video khusus (lihat Rajah 7), serta video berpandukan arahan penyuntingan, yang boleh dipanggil Ia ialah Video Instruct-Pix2Pix yang dipacu oleh Instruct-Pix2Pix (lihat Rajah 9).

Dalam kertas ini, kertas kerja ini menggunakan keupayaan sintesis teks-ke-imej Stable Diffusion (SD) untuk mengendalikan tugasan teks-ke-video dalam situasi sifar tangkapan. Untuk keperluan penjanaan video dan bukannya penjanaan imej, SD harus menumpukan pada operasi jujukan kod asas. Pendekatan naif adalah untuk mencuba secara bebas kod potensi m daripada taburan Gaussian standard, iaitu

N (0, I) , dan gunakan Sampel DDIM untuk mendapatkan tensor yang sepadan

, dengan k = 1,…,m, kemudian nyahkod ke Dapatkan urutan video yang dijana

Untuk menyelesaikan masalah ini, artikel ini mengesyorkan dua kaedah berikut: (i) Dalam pengekodan terpendam  untuk mengekalkan ketekalan temporal adegan global; (ii) mekanisme perhatian bingkai silang digunakan untuk mengekalkan rupa dan identiti objek latar depan. Setiap komponen kaedah yang digunakan dalam kertas ini diterangkan secara terperinci di bawah, dan gambaran keseluruhan kaedah boleh didapati dalam Rajah 2.

untuk mengekalkan ketekalan temporal adegan global; (ii) mekanisme perhatian bingkai silang digunakan untuk mengekalkan rupa dan identiti objek latar depan. Setiap komponen kaedah yang digunakan dalam kertas ini diterangkan secara terperinci di bawah, dan gambaran keseluruhan kaedah boleh didapati dalam Rajah 2.

Ambil perhatian bahawa untuk memudahkan tatatanda, artikel ini mewakili keseluruhan jujukan kod berpotensi sebagai:

Hasil kualitatif

Semua aplikasi Text2Video-Zero menunjukkan bahawa ia berjaya menjana video dengan ketekalan temporal adegan dan latar belakang global, latar depan Konteks , rupa dan identiti objek dikekalkan sepanjang jujukan.

Dalam kes teks-ke-video, dapat diperhatikan bahawa ia menghasilkan video berkualiti tinggi yang sejajar dengan gesaan teks (lihat Rajah 3). Sebagai contoh, seekor panda ditarik untuk berjalan secara semula jadi di jalan. Begitu juga, menggunakan panduan tepi atau pose tambahan (lihat Rajah 5, 6, dan 7), gesaan dan panduan pemadanan video berkualiti tinggi telah dihasilkan, menunjukkan ketekalan temporal yang baik dan pemeliharaan identiti.

Dalam kes Video Instruct-Pix2Pix (lihat Rajah 1), video yang dihasilkan Kesetiaan tinggi berbanding dengan video input sambil mengikuti arahan dengan tegas.

Perbandingan dengan Baseline

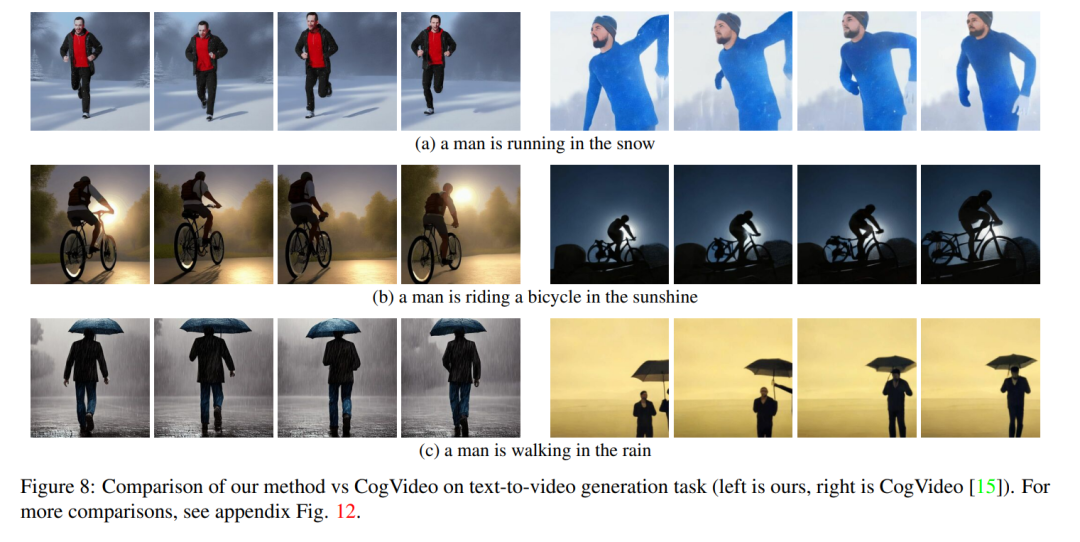

Kerja ini membandingkan kaedahnya dengan dua garis dasar yang tersedia secara umum: CogVideo dan Tune -A- Video. Memandangkan CogVideo ialah kaedah teks ke video, artikel ini membandingkannya dengannya dalam senario sintesis video berpandukan teks biasa menggunakan Video Instruct-Pix2Pix untuk perbandingan dengan Tune-A-Video.

Untuk perbandingan kuantitatif, artikel ini menggunakan skor CLIP untuk menilai model, yang mewakili tahap penjajaran teks video. Dengan mendapatkan 25 video yang dijana oleh CogVideo secara rawak, dan mensintesis video yang sepadan menggunakan petua yang sama mengikut kaedah dalam artikel ini. Skor CLIP kaedah kami dan CogVideo masing-masing ialah 31.19 dan 29.63. Oleh itu, kaedah kami lebih baik sedikit daripada CogVideo, walaupun yang terakhir mempunyai 9.4 bilion parameter dan memerlukan latihan berskala besar pada video.

Rajah 8 menunjukkan beberapa keputusan kaedah yang dicadangkan dalam kertas ini dan menyediakan perbandingan kualitatif dengan CogVideo. Kedua-dua kaedah menunjukkan ketekalan temporal yang baik sepanjang jujukan, mengekalkan identiti objek serta konteksnya. Kaedah kami menunjukkan keupayaan penjajaran teks-video yang lebih baik. Sebagai contoh, kaedah kami menjana video seseorang yang menunggang basikal di bawah matahari dengan betul dalam Rajah 8 (b), manakala CogVideo menetapkan latar belakang kepada cahaya bulan. Juga dalam Rajah 8 (a), kaedah kami menunjukkan dengan betul seseorang berlari di dalam salji, manakala salji dan orang yang berlari tidak dapat dilihat dengan jelas dalam video yang dijana oleh CogVideo.

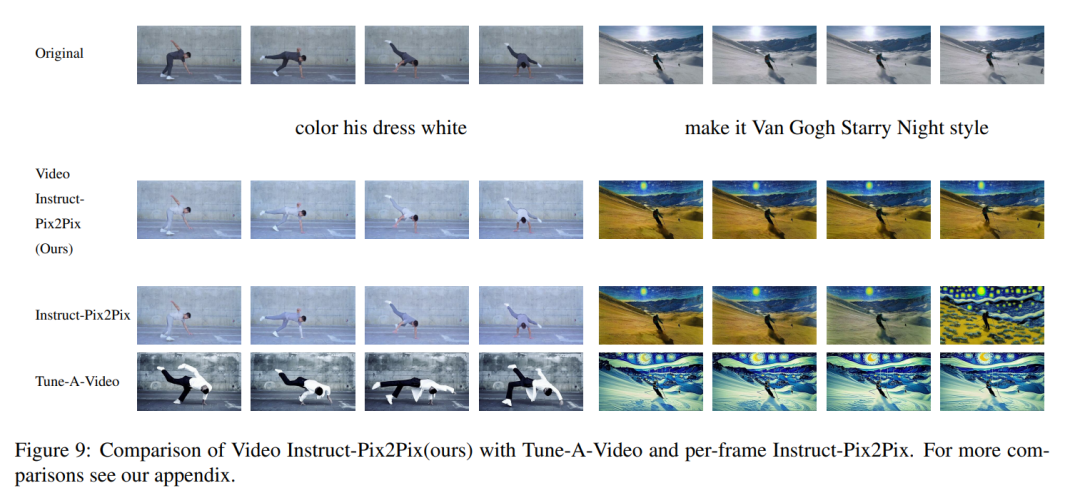

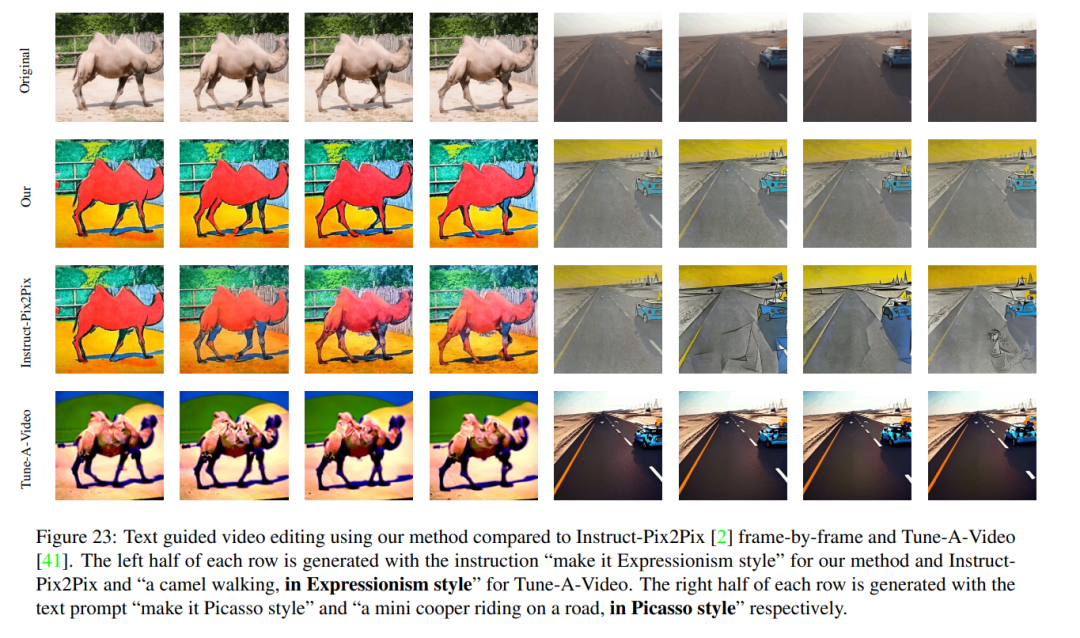

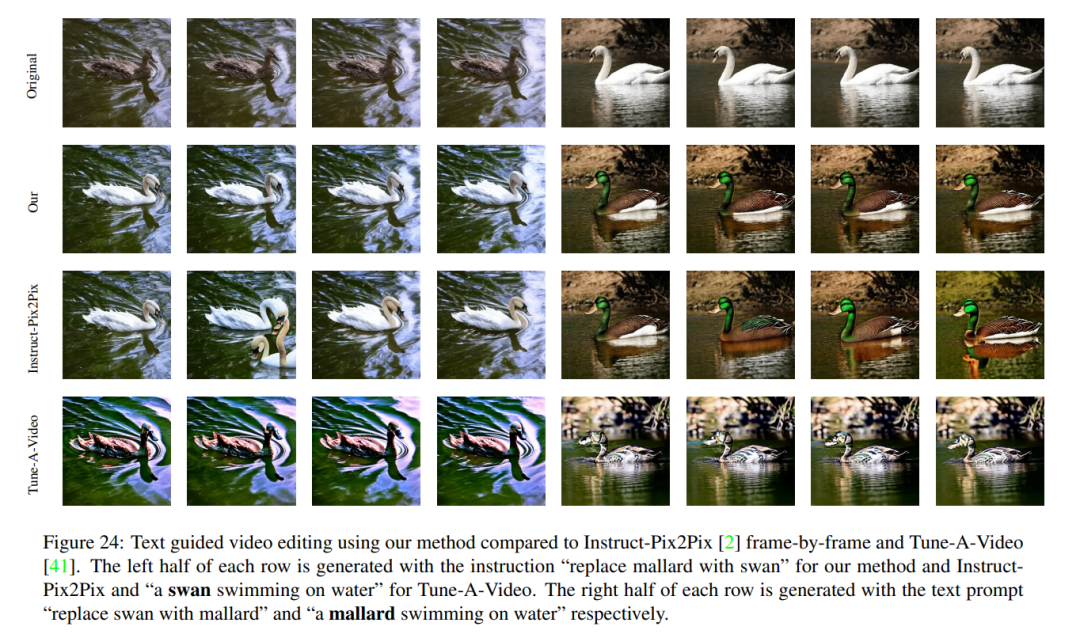

Keputusan kualitatif Video Instruct-Pix2Pix dan perbandingan visual dengan setiap bingkai Instruct-Pix2Pix dan Tune-AVideo ditunjukkan dalam Rajah 9. Walaupun Instruct-Pix2Pix menunjukkan prestasi penyuntingan yang baik bagi setiap bingkai, ia tidak mempunyai konsistensi temporal. Ini amat ketara dalam video yang menggambarkan pemain ski, di mana salji dan langit dilukis menggunakan gaya dan warna yang berbeza. Isu ini telah diselesaikan menggunakan kaedah Video Instruct-Pix2Pix, menghasilkan pengeditan video yang konsisten secara sementara sepanjang jujukan.

Walaupun Tune-A-Video mencipta penjanaan video yang konsisten masa, berbanding dengan kaedah artikel ini, ia kurang konsisten dengan panduan arahan, sukar untuk membuat suntingan tempatan dan Butiran input urutan hilang. Ini menjadi jelas apabila melihat suntingan video penari yang digambarkan dalam Rajah 9, kiri. Berbanding dengan Tune-A-Video, kaedah kami melukis keseluruhan pakaian dengan lebih cerah sambil mengekalkan latar belakang dengan lebih baik, seperti dinding di belakang penari kekal hampir tidak berubah. Tune-A-Video mengecat dinding yang sangat cacat. Selain itu, kaedah kami lebih sesuai dengan butiran input Contohnya, berbanding dengan Tune-A-Video, Video Instruction-Pix2Pix menarik penari menggunakan pose yang disediakan (Rajah 9 kiri) dan memaparkan semua pemain ski yang muncul dalam video input. Seperti yang ditunjukkan dalam bingkai terakhir di sebelah kanan Rajah 9). Semua kelemahan Tune-A-Video yang disebutkan di atas juga boleh diperhatikan dalam Rajah 23, 24.

Atas ialah kandungan terperinci Menjana video adalah sangat mudah, cuma berikan petunjuk dan anda juga boleh mencubanya dalam talian. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI