Rumah >Peranti teknologi >AI >Penyelidikan Stanford terkini mengingatkan kita untuk tidak terlalu mempercayai keupayaan model besar untuk muncul, kerana ini hanyalah hasil daripada pemilihan metrik.

Penyelidikan Stanford terkini mengingatkan kita untuk tidak terlalu mempercayai keupayaan model besar untuk muncul, kerana ini hanyalah hasil daripada pemilihan metrik.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-05-09 09:55:091478semak imbas

"Jangan terlalu percaya karut tentang kemunculan model besar. Di manakah terdapat begitu banyak keajaiban di dunia Penyelidik di Universiti Stanford mendapati bahawa kemunculan model besar sangat berkaitan dengan indeks penilaian?" Tugas itu bukan kerana kelakuan model itu berkaitan dengan tugas dan tugasan tertentu Untuk perubahan asas dalam skala, selepas menggantikan beberapa penunjuk yang lebih berterusan dan lancar, fenomena kemunculan adalah kurang jelas dan lebih dekat kepada kelinearan.

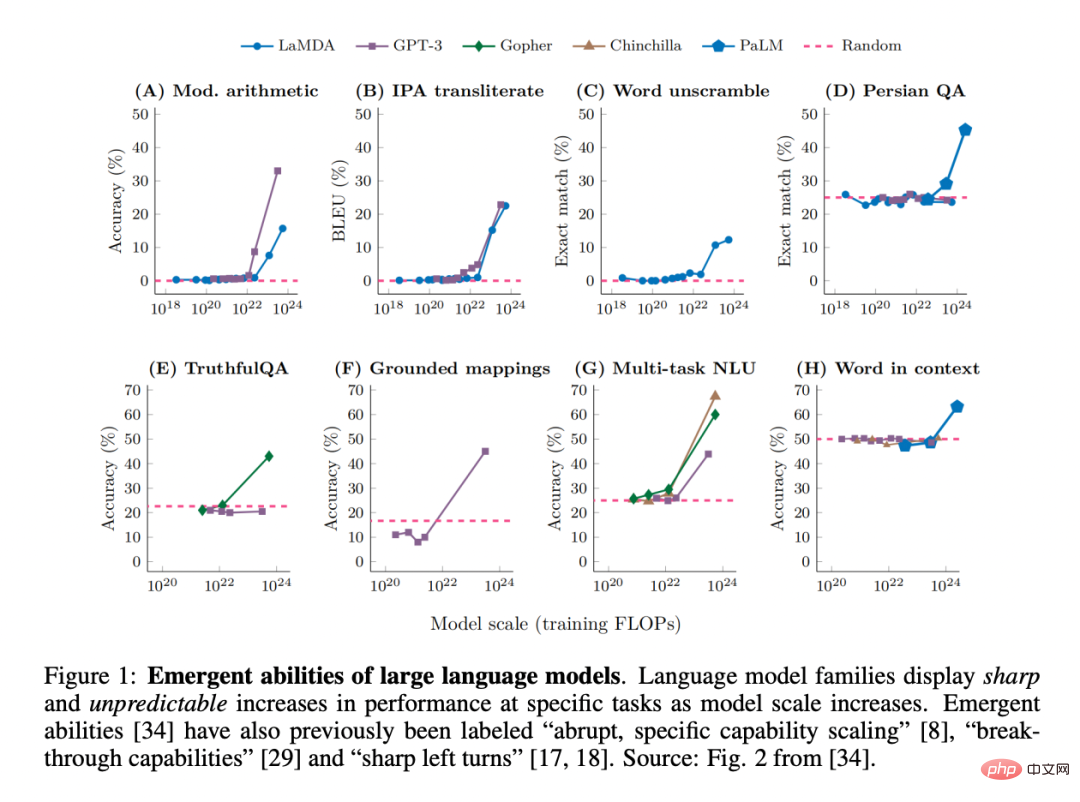

Baru-baru ini, kerana penyelidik telah memerhatikan bahawa model bahasa besar (LLM), seperti GPT, PaLM dan LaMDA, boleh mempamerkan apa yang dipanggil "keupayaan muncul" dalam tugas yang berbeza, Terminologi ini telah mendapat banyak perhatian dalam bidang pembelajaran mesin:

Malah, kerumitan sistem yang kompleks Ciri-ciri baru muncul sentiasa menjadi tumpuan penyelidikan dalam fizik, biologi, matematik dan disiplin lain.

Satu perkara yang perlu diberi perhatian ialah pemenang Hadiah Nobel P.W Anderson mengemukakan "Lebih Berbeza". Pandangan ini berpendapat bahawa apabila kerumitan sistem meningkat, sifat baharu mungkin terwujud, walaupun ia tidak diramalkan (dengan mudah atau sama sekali) daripada pemahaman kuantitatif yang tepat tentang butiran mikroskopik sistem.

Bagaimana untuk menentukan "kemunculan" dalam bidang model besar? Cara biasa untuk mengatakan ini ialah "keupayaan yang tidak terdapat dalam model berskala kecil tetapi terdapat dalam model berskala besar", dan oleh itu ia tidak boleh diramalkan dengan hanya mengekstrapolasi peningkatan prestasi model berskala kecil.

Keupayaan yang muncul ini mungkin pertama kali ditemui dalam keluarga GPT-3. Beberapa kerja berikutnya menyerlahkan penemuan ini: "Walaupun prestasi model boleh diramal pada tahap umum, pada tugas tertentu prestasinya kadangkala muncul pada skala yang agak tidak dapat diramalkan." Malah, keupayaan yang muncul ini sangat mengejutkan sehinggakan "pengembangan keupayaan khusus secara tiba-tiba" telah disebut sebagai salah satu daripada dua ciri LLM yang paling menentukan. Selain itu, istilah seperti "keupayaan terobosan" dan "belok kiri tajam" juga digunakan.

Ringkasnya, kita boleh mengenal pasti dua sifat penentu keupayaan muncul LLM:

1. kepada "kewujudan" nampaknya hanya peralihan segera;

2.

Sementara itu, beberapa soalan masih belum terjawab: Apakah yang mengawal keupayaan yang muncul? Apakah yang mengawal kemunculan keupayaan? Bagaimanakah kita boleh membuat keupayaan yang diingini muncul dengan lebih cepat dan memastikan bahawa keupayaan yang kurang diingini tidak pernah muncul?

Soalan-soalan ini berkaitan dengan keselamatan dan penjajaran AI, kerana keupayaan yang muncul memberi isyarat bahawa model yang lebih besar mungkin suatu hari nanti menguasai keupayaan berbahaya tanpa amaran, Ini adalah sesuatu yang tidak diingini oleh manusia. berlaku.

Dalam kertas kerja baru-baru ini, penyelidik dari Universiti Stanford mempersoalkan dakwaan bahawa LLM mempunyai keupayaan yang muncul.

Kertas: https://arxiv.org/pdf/2304.15004.pdf

Secara khusus, cabaran di sini adalah mengenai perubahan yang muncul dan tidak dapat diramalkan dalam output model sebagai fungsi saiz model dalam tugas tertentu.

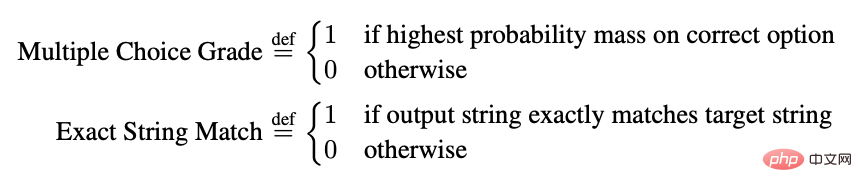

Kesangsian mereka adalah berdasarkan pemerhatian bahawa model kelihatan muncul hanya jika skala tidak linear atau tidak berterusan dalam sebarang ukuran kadar ralat per-token model. Contohnya, dalam tugas BIG-Bench, >92% daripada keupayaan yang muncul muncul di bawah kedua-dua metrik ini:

Ini menimbulkan kemungkinan penjelasan lain tentang asal usul kemunculan keupayaan LLM: walaupun kadar ralat per-token bagi keluarga model akan berubah dengan lancar, berterusan dan boleh diramal apabila saiz model meningkat , tetapi perubahan yang kelihatan tajam dan tidak dapat diramalkan mungkin disebabkan oleh kaedah pengukuran yang dipilih oleh penyelidik.

Maksudnya, keupayaan yang muncul mungkin merupakan fatamorgana, terutamanya disebabkan oleh penyelidik memilih metrik yang mengubah kadar ralat per-token secara tidak linear atau tidak berterusan, sebahagiannya kerana Ini adalah disebabkan oleh data ujian yang terlalu sedikit untuk menganggarkan prestasi model yang lebih kecil dengan tepat (menyebabkan model yang lebih kecil kelihatan tidak dapat melaksanakan tugasan sepenuhnya), dan sebahagiannya disebabkan oleh menilai terlalu sedikit model berskala besar.

Untuk menggambarkan penjelasan ini, penyelidik menganggapnya sebagai model matematik yang mudah dan menunjukkan cara ia secara kuantitatif mengeluarkan semula bukti yang disediakan untuk menyokong kuasa kemunculan LLM. Para penyelidik kemudian menguji penjelasan ini dalam tiga cara pelengkap:

1 Menggunakan keluarga model InstructGPT [24]/GPT-3 [3], berdasarkan hipotesis alternatif, ujian dan. mengesahkan tiga ramalan.

2 Menjalankan meta-analisis beberapa keputusan sebelumnya dan menunjukkan bahawa dalam ruang tugas-metrik-model-keluarga triplet, kebolehan muncul hanya untuk metrik tertentu dan bukan model. keluarga (lajur) pada tugas. Kajian selanjutnya menunjukkan bahawa pada output model tetap, menukar metrik menyebabkan fenomena kemunculan hilang.

3. Sengaja mendorong keupayaan muncul merentasi pelbagai tugas penglihatan (yang tidak pernah ditunjukkan sebelum ini) dalam rangkaian saraf dalam seni bina yang berbeza untuk menunjukkan bagaimana pilihan metrik yang serupa boleh Mendorong kebolehan yang kelihatan muncul.

Ujian 1: Analisis siri model InstructGPT/GPT-3

Penyelidik memilih model siri GPT untuk analisis lanjut kerana ia boleh ditanya secara umum sedikit berbeza daripada yang lain siri model (seperti PaLM, LaMDA, Gopher, Chinchilla). Dalam penyelidikan terdahulu, keluarga model GPT dianggap mempamerkan keupayaan yang muncul dalam tugas aritmetik integer. Di sini, penyelidik juga memilih tugas aritmetik integer.

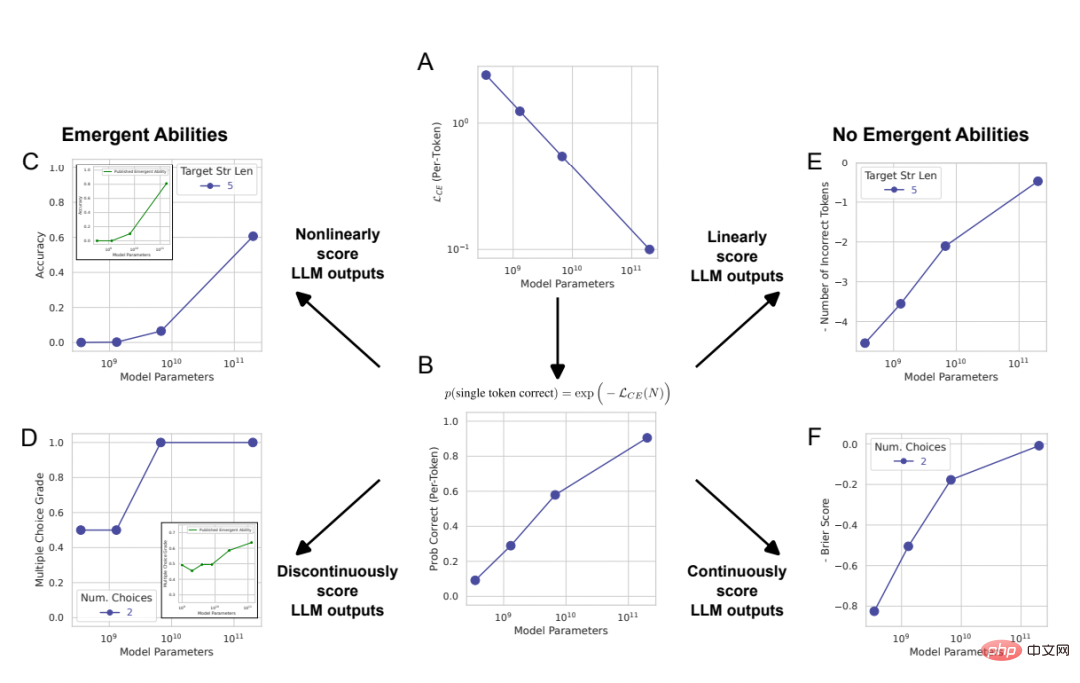

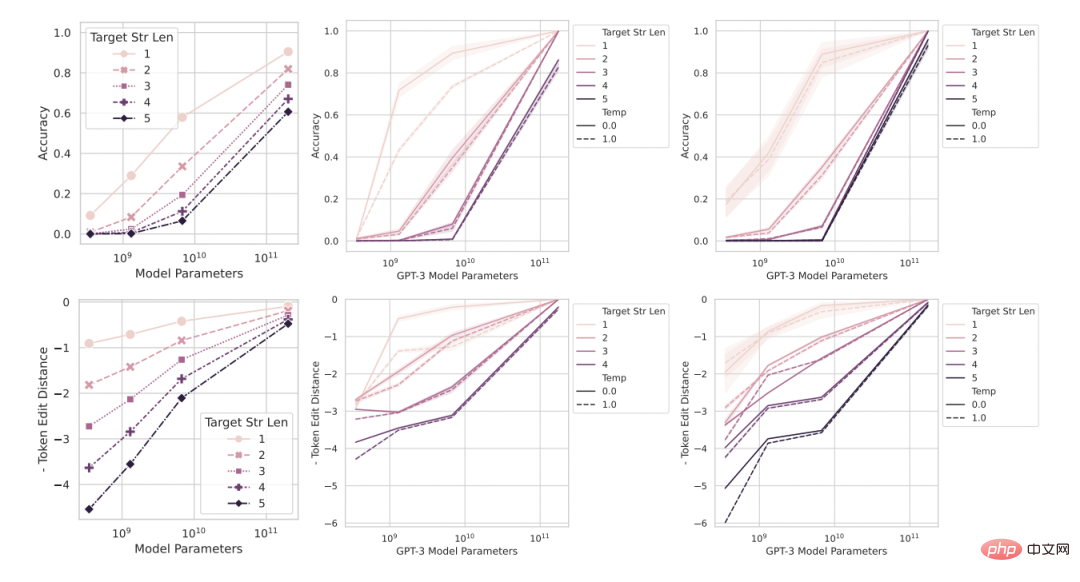

Rajah 2: Keupayaan kemunculan model bahasa besar ialah penyelidikan artifak analisis pengarang dan bukannya perubahan asas dalam keluaran model dengan skala.

Seperti yang dijelaskan secara matematik dan grafik dalam Bahagian 2, penjelasan alternatif yang dicadangkan oleh penyelidik meramalkan tiga hasil:

1. Apabila skala model meningkat, jika metrik ditukar daripada metrik tak linear/tak selanjar (Rajah 2CD) kepada metrik linear/berterusan (Rajah 2EF), maka perlu ada peningkatan prestasi yang boleh diramal dengan lancar dan berterusan.

2. Untuk ukuran tak linear, jika resolusi prestasi model yang diukur dipertingkatkan dengan meningkatkan saiz set data ujian, maka model itu seharusnya boleh memperolehi yang lancar dan berterusan , penambahbaikan boleh diramal, dan bahagian peningkatan ini sepadan dengan kesan tak linear yang boleh diramal bagi metrik yang dipilih.

3 Tanpa mengira metrik yang digunakan, meningkatkan panjang rentetan sasaran harus memberi kesan ke atas prestasi model sebagai fungsi panjang rentetan sasaran 1: Untuk ketepatan Ia adalah fungsi hampir geometri, dan jarak edit untuk token ialah fungsi hampir separa linear.

Untuk menguji ketiga-tiga kesimpulan ramalan ini, penyelidik mengumpul keputusan output rentetan model siri InstructGPT/GPT-3 pada dua tugas aritmetik: menggunakan API OpenAI untuk melaksanakan 2 dua -digit Pendaraban dua sampel antara integer dua digit dan penambahan dua sampel antara dua integer empat digit.

Rajah 3: Apabila skala model meningkat, menukar metrik boleh membawa Perubahan prestasi yang lancar, berterusan dan boleh diramal.

Dari kiri ke kanan: model matematik, 2 tugasan pendaraban integer dua digit, 2 tugasan penambahan integer empat digit. Graf di atas ialah prestasi model yang diukur menggunakan metrik tak linear seperti ketepatan, dan anda boleh melihat bahawa prestasi keluarga model InstructGPT/GPT-3 kelihatan lebih tajam dan kurang boleh diramal pada panjang sasaran yang lebih panjang. Angka di bawah ialah prestasi model yang diukur menggunakan metrik linear (seperti jarak edit token ini menunjukkan peningkatan prestasi yang lancar dan boleh diramal, iaitu keupayaan yang didakwa penyelidik muncul).

Ramalan: Keupayaan timbul hilang di bawah ukuran linear

Pada kedua-dua tugas pendaraban dan penambahan integer, keluarga GPT bagi model mempamerkan keupayaan aritmetik yang muncul jika panjang rentetan sasaran ialah 4 atau 5 digit dan prestasi diukur dengan ketepatan (baris atas Rajah 3). Walau bagaimanapun, jika anda menukar metrik daripada tak linear kepada linear sambil mengekalkan output model tetap, prestasi keluarga model bertambah baik dengan lancar, berterusan dan boleh diramalkan. Ini mengesahkan ramalan penyelidik, dengan itu mencadangkan bahawa sumber ketajaman dan ketidakpastian adalah metrik yang dipilih oleh penyelidik, dan bukannya perubahan dalam output model. Ia juga boleh dilihat bahawa apabila menggunakan jarak suntingan token, jika panjang rentetan sasaran dinaikkan daripada 1 kepada 5, prestasi model siri ini boleh diramalkan akan berkurangan, dan arah aliran menurun hampir separa linear, yang konsisten dengan yang ketiga separuh pertama ramalan.

Ramalan: Kuasa kemunculan hilang dengan munculnya penilaian resolusi yang lebih tinggi

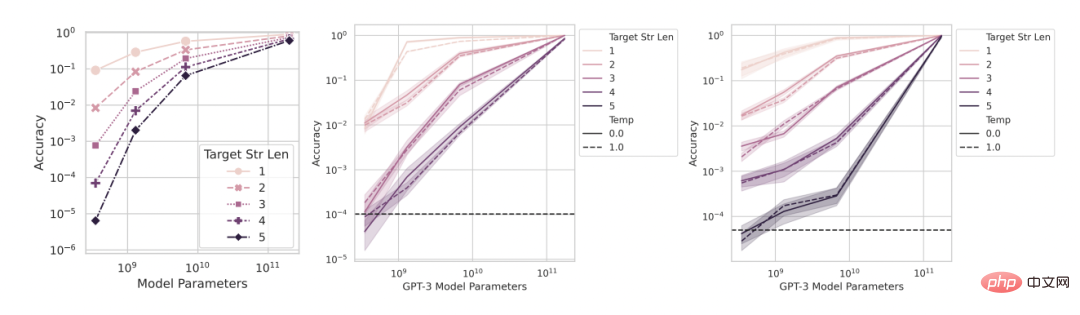

Dua ramalan Seterusnya: Walaupun dengan bukan- ukuran linear seperti ketepatan, ketepatan model yang lebih kecil tidak akan menjadi sifar, tetapi nilai bukan sifar lebih tinggi daripada peluang, perkadaran yang sepadan dengan pilihan menggunakan ketepatan sebagai ukuran. Untuk meningkatkan resolusi dan menganggarkan ketepatan model dengan lebih tepat, penyelidik juga menjana beberapa data ujian lain, dan kemudian mereka mendapati bahawa: sama ada pada tugas pendaraban integer atau tugas penambahan integer, semua InstructGPT/GPT-3 siri Model kesemuanya mencapai ketepatan positif yang melebihi peluang (Rajah 4). Ini mengesahkan ramalan kedua. Ia boleh dilihat bahawa apabila panjang rentetan sasaran meningkat, ketepatan berkurangan hampir secara geometri dengan panjang rentetan sasaran, yang konsisten dengan separuh kedua ramalan ketiga. Keputusan ini juga menunjukkan bahawa ketepatan yang dipilih oleh penyelidik mempunyai beberapa kesan (anggaran) yang sepatutnya kita jangkakan, iaitu pereputan hampir geometri dengan panjang sasaran.

Rajah 4: Menggunakan lebih banyak set data ujian diperolehi Ketepatan yang lebih baik anggaran, yang mendedahkan bahawa perubahan dalam prestasi adalah lancar, berterusan dan boleh diramal.

Dari kiri ke kanan: model matematik, 2 tugasan pendaraban integer dua digit, 2 tugasan penambahan integer empat digit. Meningkatkan resolusi dengan menjana lebih banyak data ujian mendedahkan bahawa prestasi siri model InstructGPT/GPT-3 adalah di luar jangkaan walaupun pada ukuran ketepatan, dan peningkatannya dalam kedua-dua keupayaan muncul adalah lancar, Keputusan kedua-dua keupayaan muncul ini, berterusan dan boleh diramal, adalah konsisten secara kualitatif dengan model matematik.

Ujian 2: Meta-analisis kemunculan model

Memandangkan siri model GPT tersedia secara terbuka untuk pertanyaan, ia boleh dianalisis. Walau bagaimanapun, model lain yang juga didakwa mempunyai keupayaan yang muncul (seperti PaLM, Chinchilla, Gopher) tidak tersedia secara umum, dan output yang mereka jana bukan umum, yang bermaksud penyelidik terhad dalam menganalisis hasil yang diterbitkan. Para penyelidik memberikan dua ramalan berdasarkan hipotesis alternatif mereka sendiri:

- Pertama, pada "peringkat populasi" triplet "siri model-metrik tugas", apabila memilih untuk menggunakan metrik tak linear dan/atau tak selanjar untuk menilai prestasi model , model harus menunjukkan keupayaan kemunculan pada tugas.

- Kedua, untuk tiga kali ganda "siri model-metrik tugas" tertentu yang mempamerkan keupayaan muncul, jika metrik ditukar kepada metrik linear dan/atau berterusan, maka keupayaan muncul harus dihapuskan.

Untuk menguji kedua-dua hipotesis ini, penyelidik menyiasat keupayaan yang didakwa muncul pada suite penilaian BIG-Bench, di mana penanda aras tersedia secara terbuka dan mempunyai dokumentasi yang baik juga.

Ramalan: Keupayaan yang timbul harus terutamanya muncul pada langkah tidak linear/tak berterusan

Untuk menguji yang pertama Untuk ramalan , para penyelidik menganalisis penunjuk yang sama ada gandingan "siri model tugas" yang berbeza akan mempunyai keupayaan yang muncul. Untuk menentukan sama ada triple "keluarga model-tugas-metrik" berkemungkinan mempamerkan keupayaan yang muncul, mereka meminjam definisi yang diperkenalkan dalam kertas "Melangkaui permainan tiruan: Mengukur dan mengekstrapolasi keupayaan model bahasa". Biarkan y_i ∈ R mewakili prestasi model apabila saiz model ialah x_i ∈ R, dan jadikan x_i

Hasilnya, para penyelidik mendapati bahawa kebanyakan ukuran yang digunakan oleh BIG-Bench tidak menunjukkan keupayaan kemunculan pasangan "siri model tugas": dalam 39 BIG-Bench yang disukai orang Di antara langkah-langkah itu, paling banyak 5 mempamerkan keupayaan muncul (Rajah 5A). Kebanyakan daripada 5 ini adalah bukan linear/tidak berterusan, seperti padanan rentetan tepat, kedudukan berbilang pilihan, ROUGE-L-Sum. Perlu diingat bahawa memandangkan BIG-Bench biasanya menggunakan pelbagai ukuran untuk menilai prestasi tugas model, kekurangan keupayaan muncul di bawah langkah lain menunjukkan bahawa apabila langkah lain digunakan untuk menilai output model, keupayaan muncul tidak muncul. .

Rajah 5: Keupayaan muncul hanya muncul untuk beberapa langkah sahaja. (A) Daripada 39 langkah BIG-Bench yang digemari orang ramai, keupayaan yang timbul mungkin muncul pada paling banyak hanya 5 ukuran. (B) Data beranotasi manusia daripada kertas yang dipetik menunjukkan bahawa hanya 4 ukuran keutamaan orang ramai menunjukkan kuasa yang muncul. (C) >92% daripada kebolehan yang timbul berlaku pada salah satu daripada dua ukuran: kedudukan berbilang pilihan dan padanan rentetan yang tepat.

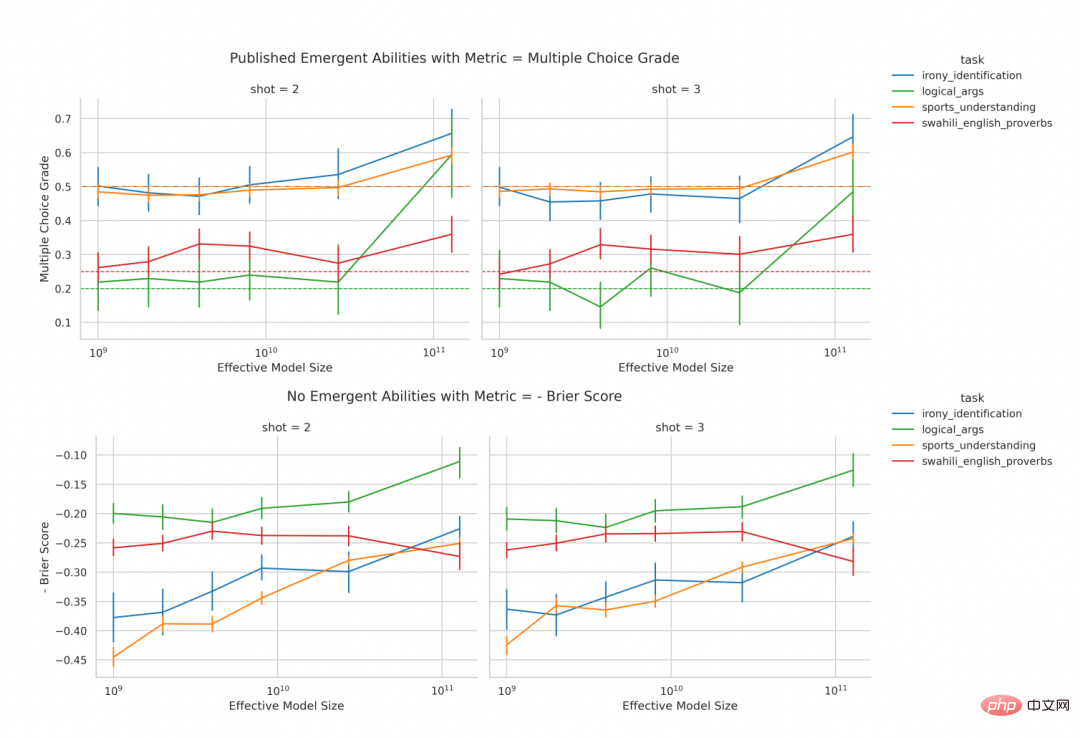

Ramalan: Keupayaan timbul harus dihapuskan jika langkah tak linear/tak selanjar digantikan

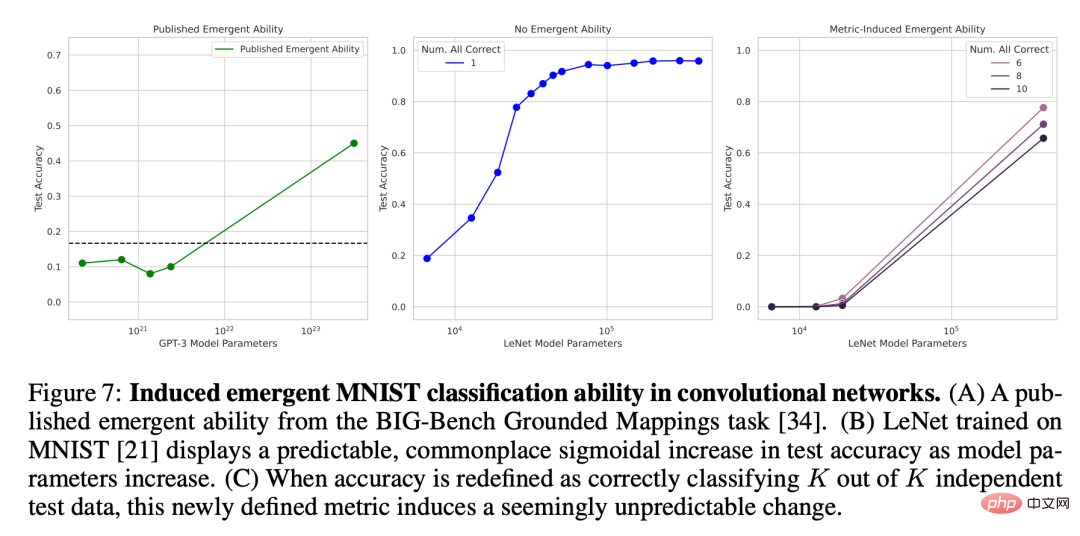

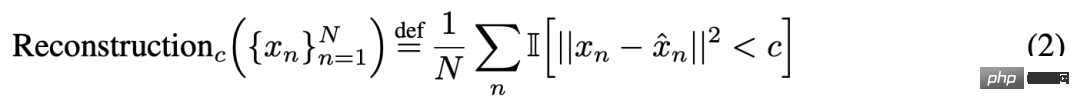

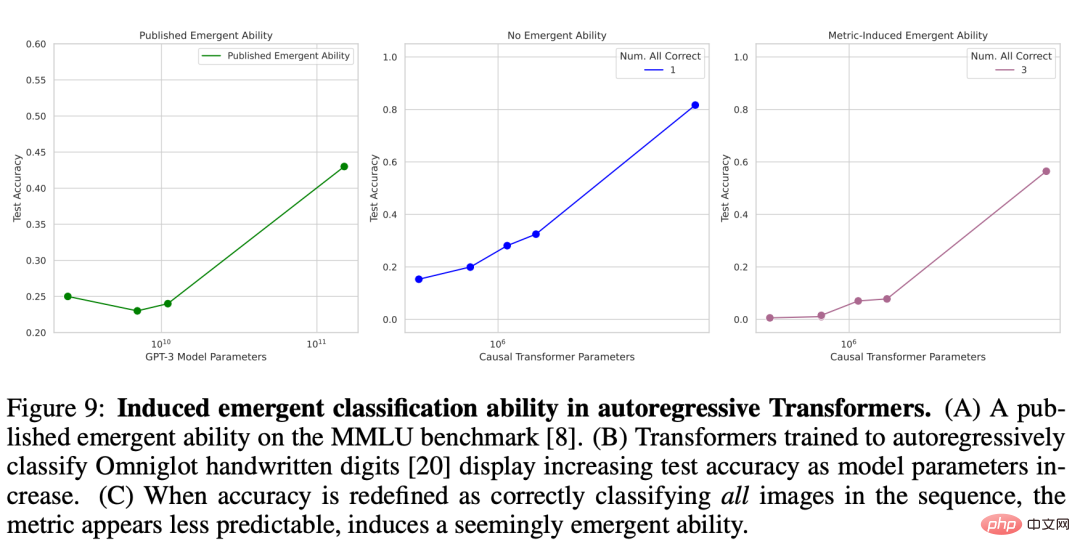

Untuk ramalan kedua, para penyelidik menganalisis keupayaan kemunculan anotasi manual dalam kertas yang dipetik di atas. Mereka memberi tumpuan kepada keluarga LaMDA kerana outputnya tersedia melalui BIG-Bench, manakala output daripada keluarga model lain tidak. Antara model LaMDA yang diterbitkan, yang terkecil mempunyai 2 bilion parameter, tetapi banyak model LaMDA dalam BIG-Bench jauh lebih kecil, dan penyelidik menyatakan bahawa kerana mereka tidak dapat menentukan asal usul model yang lebih kecil ini, mereka tidak dipertimbangkan dalam analisis. . Dalam analisis, penyelidik mengenal pasti tugas yang LaMDA menunjukkan keupayaan muncul pada ukuran hierarki pelbagai pilihan, dan kemudian mereka bertanya: Bolehkah LaMDA melaksanakan tugas yang sama apabila menggunakan ukuran BIG-Bench yang lain, skor Brier Menunjukkan keupayaan muncul? Skor Brier ialah satu set peraturan pemarkahan yang betul-betul tepat yang mengukur ramalan hasil yang saling eksklusif untuk ramalan hasil binari, skor Brier dipermudahkan kepada ralat kuasa dua min antara hasil dan jisim kebarangkalian yang diramalkan. Para penyelidik mendapati bahawa apabila kedudukan berbilang pilihan metrik tidak berterusan ditukar kepada skor Brier metrik berterusan (Rajah 6), keupayaan LaMDA yang muncul itu hilang. Ini seterusnya menunjukkan bahawa punca keupayaan muncul bukanlah perubahan penting dalam tingkah laku model apabila skala semakin meningkat, tetapi penggunaan langkah terputus . Rajah 6: Misi dan keluarga model kekal sama Menukar metrik BIG-Bench di bawah premis akan menyebabkan keupayaan kemunculan hilang. Baris atas: Keluarga model LaMDA mempamerkan keupayaan yang muncul apabila menggunakan ukuran tidak berterusan (pemeringkatan berbilang pilihan). Baris seterusnya: Apabila menggunakan metrik BIG-Bench berterusan (skor Brier), keluarga model LaMDA tidak lagi muncul untuk tugas yang sama. Pandangan penyelidik ialah ia boleh diinduksi melalui pemilihan metrik Model menghasilkan keupayaan muncul untuk membuktikan ini, mereka menunjukkan betapa rangkaian saraf yang mendalam dengan seni bina yang berbeza (bersambung sepenuhnya, konvolusi, perhatian diri) boleh menghasilkan keupayaan muncul. Para penyelidik di sini memberi tumpuan kepada tugas visual untuk dua sebab. Pertama, orang ramai pada masa ini memberi tumpuan kepada keupayaan muncul model bahasa berskala besar, kerana untuk model visual, peralihan secara tiba-tiba daripada tiada keupayaan model kepada ya belum lagi diperhatikan. Kedua, beberapa tugas penglihatan boleh diselesaikan dengan rangkaian bersaiz sederhana, jadi penyelidik boleh membina keluarga lengkap model merentasi pelbagai urutan magnitud. Rangkaian konvolusi muncul dengan keupayaan untuk mengklasifikasikan digit tulisan tangan MNIST Penyelidik mula-mula mendorong pelaksanaan LeNet convolution The siri rangkaian saraf muncul dengan keupayaan pengelasan, dan set data latihan ialah set data digit tulisan tangan MNIST. Siri ini menunjukkan peningkatan lancar dalam ketepatan ujian apabila bilangan parameter bertambah (Rajah 7B). Untuk mensimulasikan metrik ketepatan yang digunakan dalam kertas mengenai kemunculan, ketepatan subset digunakan di sini: jika rangkaian betul mengklasifikasikan data K daripada data ujian K (bebas), maka rangkaian Ketepatan subset ialah 1, jika tidak, ia adalah 0. Berdasarkan takrifan ketepatan ini, apabila K meningkat daripada 1 kepada 5, keluarga model ini mempamerkan keupayaan untuk "muncul" untuk mengklasifikasikan set digit MNIST dengan betul, terutamanya apabila digabungkan dengan pensampelan yang jarang bagi saiz model (Rajah 7C). Keupayaan pengelasan yang muncul bagi siri konvolusi ini adalah konsisten secara kualitatif dengan keupayaan yang muncul dalam kertas yang diterbitkan, seperti keputusan mengenai tugas pemetaan topografi BIG-Bench (Rajah 7A). Rajah 7: Mendorong kemunculan dalam klasifikasi MNIST rangkaian konvolusi keupayaan. (A) Keupayaan muncul berdasarkan tugas pemetaan rupa bumi BIG-Bench daripada kertas yang diterbitkan. (B) LeNet yang dilatih di MNIST menunjukkan peningkatan ketepatan ujian berbentuk ramalan, umum, berbentuk S apabila bilangan parameter model bertambah. (C) Apabila ketepatan ditakrifkan semula sebagai mengelaskan K dengan betul daripada data ujian bebas K, metrik yang baru ditakrifkan ini mendorong perubahan yang kelihatan tidak dijangka. Pengekod auto tak linear muncul keupayaan pembinaan semula pada set imej semula jadi CIFAR100 Untuk menyerlahkan bahawa ketajaman metrik yang dipilih oleh penyelidik bertanggungjawab untuk keupayaan yang muncul, dan untuk menunjukkan bahawa ketajaman ini tidak terhad kepada ukuran seperti ketepatan, penyelidik juga mendorong kedangkalan (iaitu, tersembunyi tunggal) yang dilatih pada set imej semula jadi CIFAR100 lapisan) pengekod auto tak linear muncul dengan keupayaan untuk membina semula input imej. Untuk tujuan ini, mereka dengan sengaja menentukan ukuran ketakselanjaran baharu untuk mengukur keupayaan model, iaitu purata bilangan data ujian dengan ralat pembinaan semula kuasa dua lebih rendah daripada ambang tetap c:

Ujian 3: Mendorong kemunculan keupayaan DNN

Di mana saya (・) ialah pembolehubah penunjuk rawak dan x^n ialah pembinaan semula pengekod auto bagi x_n. Para penyelidik meneliti bilangan unit kesesakan dalam pengekod auto dan mendapati bahawa apabila saiz model meningkat, ralat pembinaan semula kuasa dua bagi rangkaian menunjukkan aliran menurun yang lancar (Rajah 8B), tetapi jika metrik pembinaan semula yang baru ditakrifkan digunakan, untuk dipilih c. Keupayaan siri pengekod auto ini untuk membina semula set data ini adalah tajam dan hampir tidak dapat diramalkan (Rajah 8C). .

Rajah 8: Dalam kebolehan pembinaan semula munculan autoenkoder tak linear cetek. (A) Keupayaan muncul berdasarkan tugas elemen berkala BIG-Bench daripada kertas yang diterbitkan. (B) Pengekod auto tak linear cetek yang dilatih pada CIFAR100 mempamerkan ralat pembinaan semula min kuasa dua yang menurun dengan lancar. (C) Perubahan yang tidak dapat diramalkan diinduksi menggunakan metrik pembinaan semula yang baru ditakrifkan (Persamaan 2).

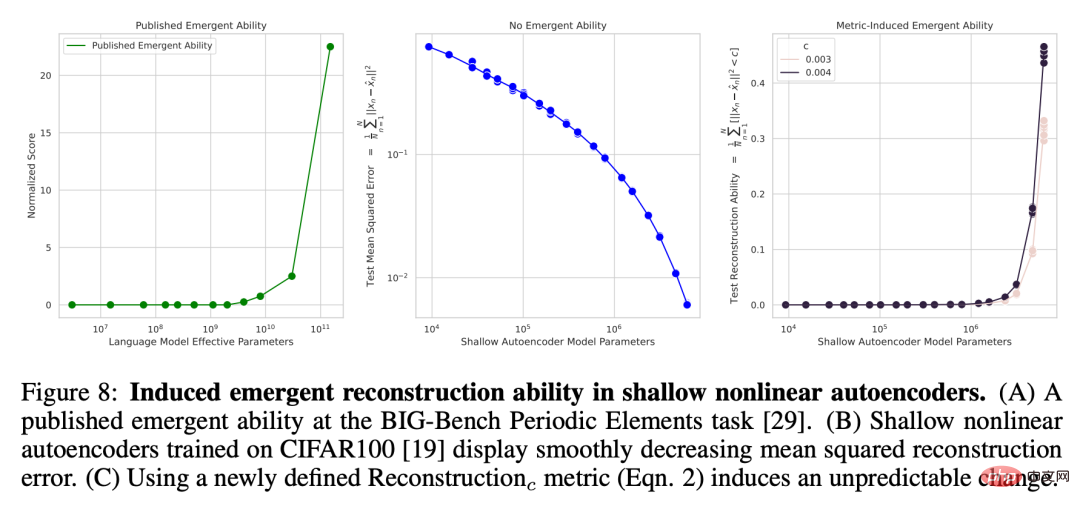

Autoregressive Transformer telah muncul dengan keupayaan pengelasan pada set aksara Omniglot

Teruskan Seterusnya ialah keupayaan muncul Transformer, yang menggunakan kaedah autoregresif untuk mengklasifikasikan aksara tulisan tangan Omniglot. Persediaan percubaan yang digunakan oleh penyelidik adalah serupa: imej Omniglot mula-mula dibenamkan oleh lapisan konvolusi, dan kemudian Transformer penyahkod sahaja dimasukkan sebagai urutan pasangan [imej terbenam, label kategori imej] dan matlamat latihan ini Transformer adalah untuk meramalkan label Kategori Omniglot. Penyelidik mengukur prestasi pengelasan imej pada urutan panjang L ∈ [1, 5], yang juga diukur dengan ketepatan subset: jika semua imej L dikelaskan dengan betul (Rajah 9B), maka ketepatan subset ialah 1, Jika tidak, ia adalah 0 . Causal Transformer nampaknya mempamerkan keupayaan yang muncul dalam tugas mengklasifikasikan aksara tulisan tangan Omniglot dengan betul (Rajah 9C), hasil yang konsisten secara kualitatif dengan keupayaan yang muncul dalam kertas yang diterbitkan, seperti pemahaman bahasa berbilang tugas berskala besar (Rajah 9A).

Rajah 9: Mendorong keupayaan pengelasan yang muncul dalam Transformer autoregresif. (A) Keupayaan muncul berdasarkan penanda aras MMLU dalam kertas yang diterbitkan. (B) Apabila parameter model meningkat, ketepatan ujian Transformer yang menggunakan kaedah autoregresif untuk mengklasifikasikan digit tulisan tangan Omniglot juga menunjukkan peningkatan. (C) Apabila ketepatan ditakrifkan semula sebagai mengklasifikasikan semua imej dengan betul dalam urutan, metrik adalah lebih sukar untuk diramal, yang nampaknya menunjukkan induksi keupayaan muncul.

Atas ialah kandungan terperinci Penyelidikan Stanford terkini mengingatkan kita untuk tidak terlalu mempercayai keupayaan model besar untuk muncul, kerana ini hanyalah hasil daripada pemilihan metrik.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI