Rumah >Peranti teknologi >AI >Senarai penyelidikan AI paling popular bulan Julai dikeluarkan, dengan 'Model Standard' terbaru Ma Yi menduduki tempat kesembilan

Senarai penyelidikan AI paling popular bulan Julai dikeluarkan, dengan 'Model Standard' terbaru Ma Yi menduduki tempat kesembilan

- 王林ke hadapan

- 2023-05-02 15:25:061295semak imbas

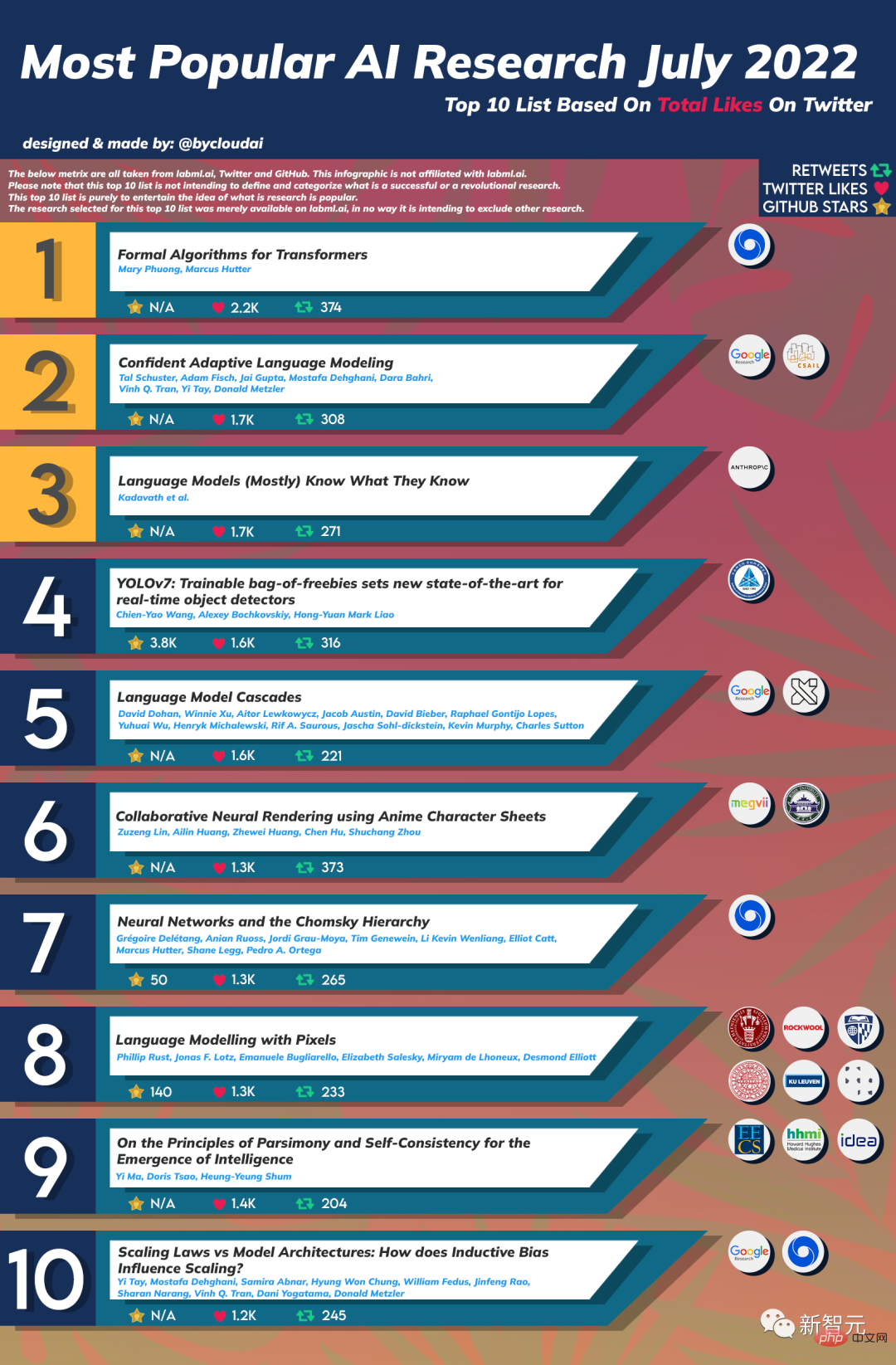

Senarai penyelidikan AI paling popular pada bulan Julai telah keluar!

Senarai yang disusun oleh pengguna Reddit @bycloudai ini disenaraikan antara sepuluh penyelidikan AI teratas pada Julai 2022 berdasarkan sukaan Twitter, tweet semula dan bintang Github, termasuk DeepMind, Google, Institusi terkenal seperti MIT CSAIL.

Mari kita lihat siapa yang tersenarai~

TOP1: Algoritma Formal untuk Transformers

Pengarang: Mary Phuong, Marcus Hutter

Institusi: DeepMind

Abstrak: Artikel ini bertujuan untuk menjadi gambaran keseluruhan yang serba lengkap dan tepat secara matematik bagi seni bina dan algoritma Transformer. Ia merangkumi apa itu Transformers, cara mereka dilatih, kegunaannya, komponen seni bina utamanya dan pratonton model yang paling menonjol.

Top2: Pemodelan Bahasa Adaptif Yakin

Pengarang: Tal Schuster, Adam Fisch, Jai Gupta, Mostafa Dehghani, Dara Bahri, Vinh Q Tran, Yi Tay, Donald Metzler

Institusi: Google, MIT CSAIL

Abstrak: Kemajuan terkini dalam model bahasa besar (LLM) berasaskan Transformer telah mendorong peningkatan prestasi yang ketara pada banyak tugas. Walau bagaimanapun, sementara prestasi bertambah baik, saiz model juga meningkat secara mendadak, yang boleh membawa kepada proses inferens yang kompleks dan peningkatan kos. Walau bagaimanapun, dalam amalan, model bahasa besar menghasilkan satu siri lelaran yang terdiri daripada pelbagai peringkat kesukaran.

Dalam kerja ini, kami memperkenalkan Confident Adaptive Language Model-ing (CALM), rangka kerja yang memperuntukkan jumlah input komputer dan tempoh penjanaan yang berbeza-beza secara dinamik.

Penyahkodan keluar awal melibatkan beberapa isu yang kami tangani di sini, seperti: (1) apakah ukuran keyakinan untuk digunakan; (2) menghubungkan kekangan peringkat jujukan untuk keluar dari keputusan untuk token tempatan; disebabkan keluar awal token sebelumnya. Melalui analisis teori dan eksperimen pada tiga tugas penjanaan teks yang berbeza, kami menunjukkan keberkesanan rangka kerja kami dalam mengurangkan pengiraan - berpotensi mempercepatkan sehingga 3x sambil mengekalkan prestasi tinggi.

Top3: Model Bahasa (Kebanyakannya) Tahu Apa Yang Mereka Tahu

Pengarang: Saurav Kadavath, Tom Conerly, Amanda Askell, Tom Henighan, dll.

Organisasi: Anthropic

Abstrak: Kertas kerja ini menyiasat sama ada model bahasa boleh menilai kesahihan dakwaan mereka sendiri dan meramalkan soalan yang mereka akan dapat jawab dengan betul. Kami mula-mula menunjukkan bahawa apabila model yang lebih besar disediakan dalam format yang betul, mereka menentukur dengan baik kepada pelbagai pilihan berbilang dan masalah benar/salah. Oleh itu, kita boleh menilai sendiri tugas pensampelan terbuka dengan meminta model mencadangkan jawapan dahulu dan kemudian menilai kebarangkalian P(Benar) bahawa jawapannya adalah betul.

Kami mendapati P(True) menarik dalam prestasi, penentukuran dan penskalaannya merentas pelbagai tugas. Prestasi penilaian kendiri bertambah baik lagi apabila kami membenarkan model mempertimbangkan banyak sampelnya sendiri sebelum meramalkan kesahihan kemungkinan tertentu. Seterusnya, kami menyiasat sama ada kami boleh melatih model untuk meramalkan P(IK), kebarangkalian "Saya tahu jawapan kepada soalan", tanpa merujuk kepada sebarang jawapan yang dicadangkan khusus.

Top4: YOLOv7: Beg percuma yang boleh dilatih menetapkan teknologi terkini untuk pengesan objek masa nyata

Pengarang: Chien-Yao Wang, Alexey Bochkovskiy, Hong-Yuan Mark Liao

Institusi: Institut Sains Maklumat, Academia Sinica

Top5: Lata Model Bahasa

Pengarang: David Dohan, Win Xunie, Aitor Lewkowycz et al

Institusi: Google

Top6: Rendering Neural Kolaboratif menggunakan Helaian Karakter Anime

Pengarang: Zuzeng Lin, Ailin Huang, Zhewei Huang et al.

Institusi: Universiti Wuhan, Teknologi Megvii

Top7: Rangkaian Neural dan Hierarki Chomsky

Pengarang: Grégoire Delétang, Anian Ruoss, Jordi Grau-Moya, Tim Genewein dan banyak lagi

Institusi: DeepMind

Top8: Pemodelan bahasa dengan Piksel

Top8: Pemodelan bahasa dengan Piksel

Pengarang: Phillip Rust, Jonas F. Lotz, Emanuele Bugliarello, dsb.

Institusi: Universiti Copenhagen, Universiti Johns Hopkins, Universiti Uppsala

Atas9: Mengenai Prinsip Parsimony dan Konsistensi Diri untuk Kemunculan Intelligence

Pengarang: Ma Yi, Cao Ying, Shen Xiangyang

Institusi: University of California, Berkeley, Guangdong-Hong Kong-Macao Greater Bay Area Institut Penyelidikan Ekonomi Digital

| pembangunan AI dalam tempoh 70 tahun yang lalu.

Selepas membaca kertas kerja 10 pakar Teratas, mari bercakap tentang beberapa butiran menarik senarai ini.

Selain itu, "Model Generasi Visual Infinite NUWA-Infinity" yang sangat diminta sebelum ini hanya menduduki tempat ke-12 dari segi bilangan suka di Twitter, tetapi bilangan bintang Github mempunyai melebihi 2.4k.

Sejak NUWA Infinity mengeluarkan versi pertamanya seawal November 2021, senarai ini hanya mengira bilangan suka untuk versi kedua selepas itu.

Atas ialah kandungan terperinci Senarai penyelidikan AI paling popular bulan Julai dikeluarkan, dengan 'Model Standard' terbaru Ma Yi menduduki tempat kesembilan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI

Top8: Pemodelan bahasa dengan Piksel

Top8: Pemodelan bahasa dengan Piksel