Rumah >Peranti teknologi >AI >6 Rangka Kerja Python yang Disyorkan untuk Membina Sistem Kepintaran Buatan (XAI) yang Boleh Diterangkan

6 Rangka Kerja Python yang Disyorkan untuk Membina Sistem Kepintaran Buatan (XAI) yang Boleh Diterangkan

- WBOYke hadapan

- 2023-04-26 10:49:081984semak imbas

AI adalah seperti kotak hitam yang boleh membuat keputusan sendiri, tetapi orang ramai tidak tahu mengapa. Bina model AI, masukkan data, dan kemudian keluarkan hasilnya, tetapi satu masalah ialah kami tidak dapat menjelaskan mengapa AI mencapai kesimpulan sedemikian. Terdapat keperluan untuk memahami alasan di sebalik cara AI mencapai kesimpulan tertentu, bukannya hanya menerima hasil yang dikeluarkan tanpa konteks atau penjelasan.

Kebolehtafsiran direka untuk membantu orang ramai memahami:

- Bagaimanakah ia dipelajari?

- Apa yang dipelajari?

- Mengapa input tertentu Membuat keputusan sedemikian?

- Adakah keputusan itu boleh dipercayai?

Dalam artikel ini, saya akan memperkenalkan 6 rangka kerja Python untuk kebolehtafsiran.

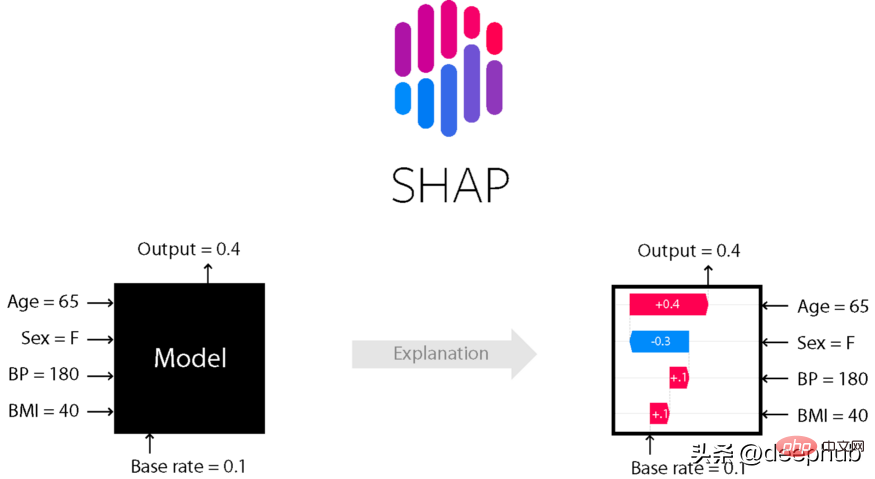

SHAP

Penjelasan Tambahan SHApley (Penjelasan Tambahan SHApley) ialah kaedah teori permainan untuk menerangkan output mana-mana model pembelajaran mesin. Ia menggunakan nilai Shapley klasik daripada teori permainan dan sambungan berkaitannya untuk mengaitkan peruntukan kredit yang optimum dengan tafsiran tempatan (lihat kertas untuk butiran dan petikan).

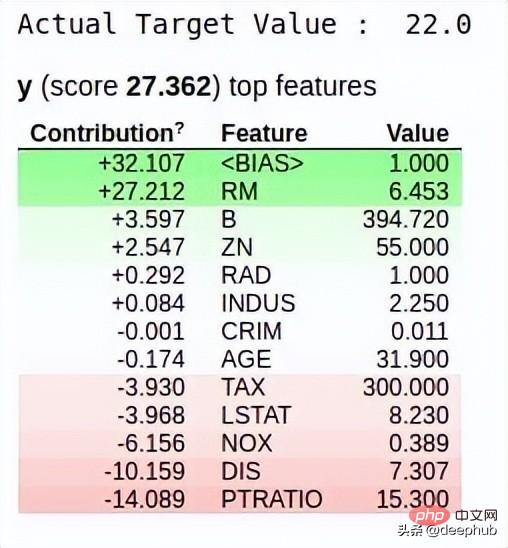

Sumbangan setiap ciri dalam set data kepada ramalan model dijelaskan oleh nilai Shapley. Algoritma SHAP Lundberg dan Lee pada asalnya diterbitkan pada 2017, dan algoritma itu telah diterima pakai secara meluas oleh komuniti dalam pelbagai bidang.

Gunakan pip atau conda untuk memasang perpustakaan shap.

# install with pippip install shap# install with condaconda install -c conda-forge shap

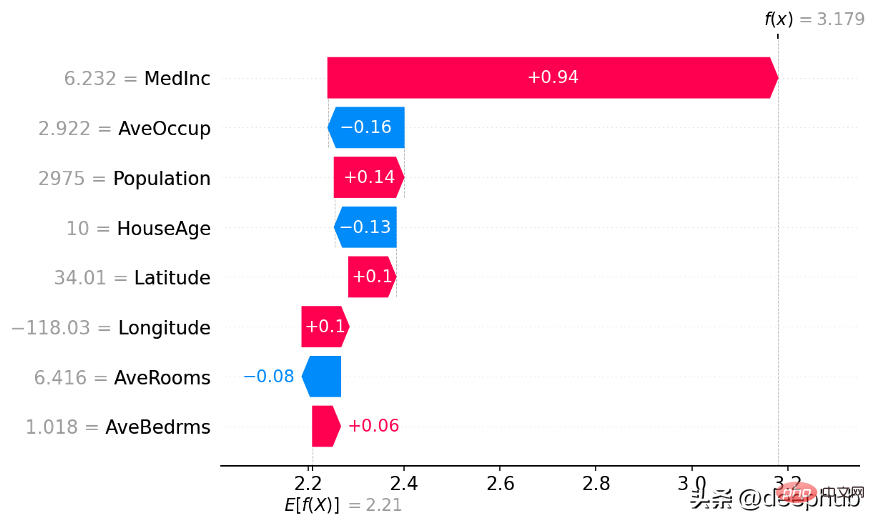

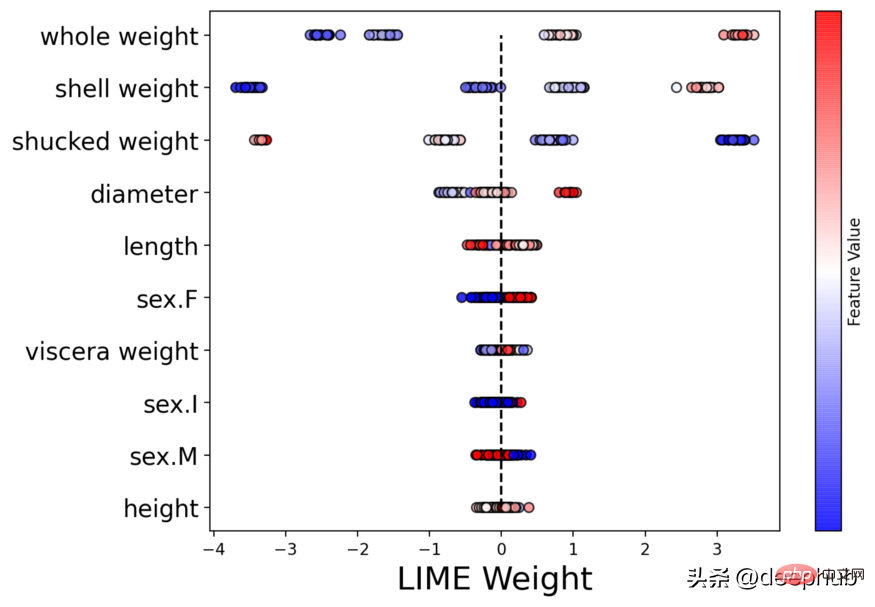

Gunakan perpustakaan Shap untuk membina carta air terjun

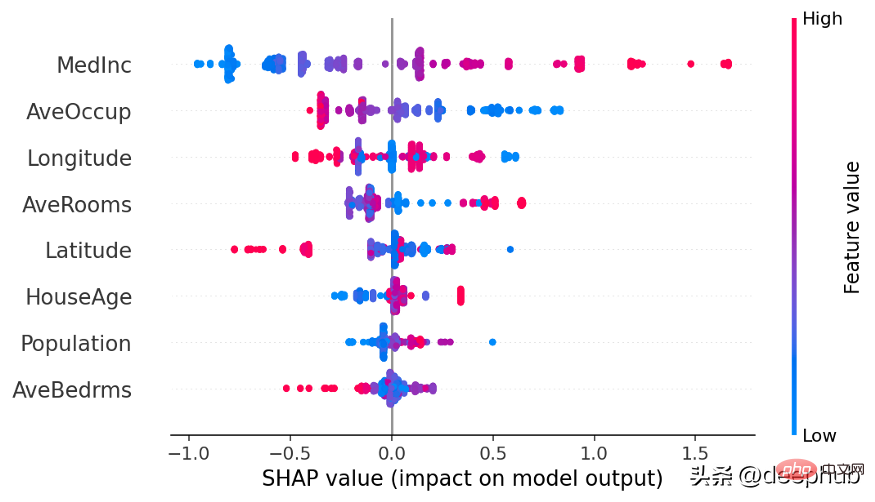

Gunakan perpustakaan Shap untuk membina carta Beeswarm

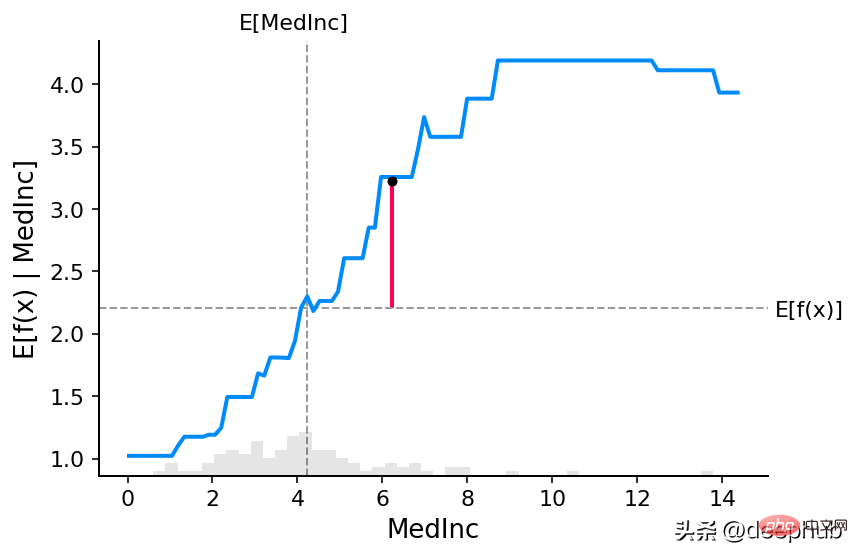

Gunakan perpustakaan Shap untuk membina graf pergantungan separa

LIME

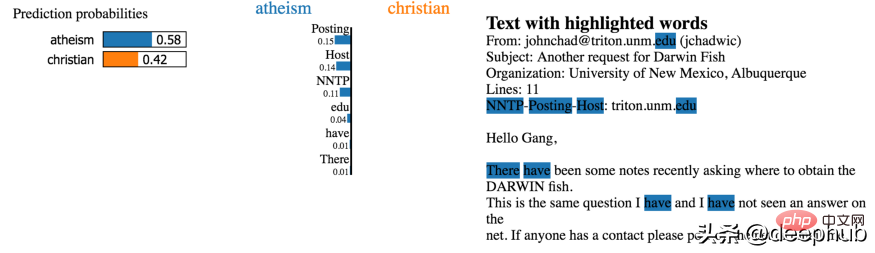

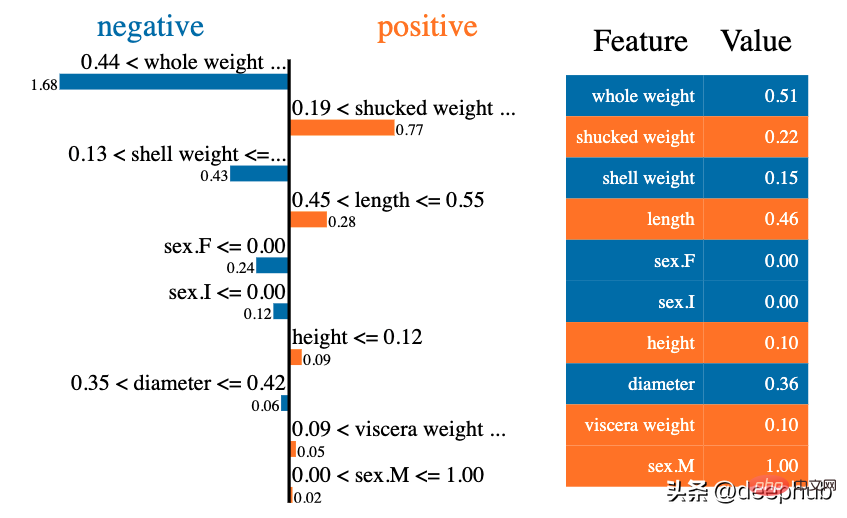

Dalam bidang kebolehtafsiran, salah satu kaedah terkenal pertama ialah LIME. Ia boleh membantu menjelaskan model pembelajaran mesin yang sedang dipelajari dan sebab model tersebut meramalkan cara tertentu. Lime kini menyokong tafsiran data jadual, pengelas teks dan pengelas imej.

Mengetahui sebab model meramalkan cara ia melakukannya adalah penting untuk menala algoritma. Dengan penjelasan LIME, anda boleh memahami sebab model berkelakuan sedemikian. Jika model tidak berjalan seperti yang dirancang, kemungkinan berlaku kesilapan semasa fasa penyediaan data.

Gunakan pip untuk memasang

pip install lime

Rajah penjelasan separa yang dibina oleh LIME

Graf hangat yang dibina oleh LIME

Shapash

“ Shapash ialah perpustakaan Python yang menjadikan pembelajaran mesin boleh ditafsir dan difahami untuk semua orang Shapash menyediakan beberapa jenis Visualisasi yang menunjukkan dengan jelas label yang boleh difahami oleh semua orang memudahkan saintis data memahami model mereka dan berkongsi hasil pengguna boleh menggunakan ringkasan paling standard untuk memahami cara model membuat pertimbangannya ”

Untuk menyatakan penemuan yang mengandungi cerita. cerapan, dan model dalam data anda, interaktiviti dan carta yang cantik adalah penting. Cara terbaik untuk saintis/penganalisis perniagaan dan data membentangkan dan berinteraksi dengan hasil AI/ML adalah dengan memvisualisasikannya dan meletakkannya di web. Pustaka Shapash boleh menjana papan pemuka interaktif dan mempunyai koleksi banyak carta visualisasi. Berkaitan dengan kebolehtafsiran bentuk/kapur. Ia boleh menggunakan SHAP/Lime sebagai bahagian belakang, yang bermaksud ia hanya menyediakan carta yang kelihatan lebih baik.

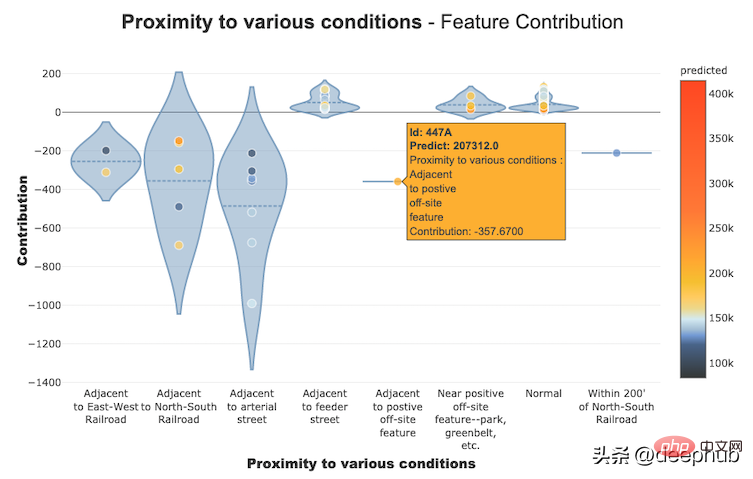

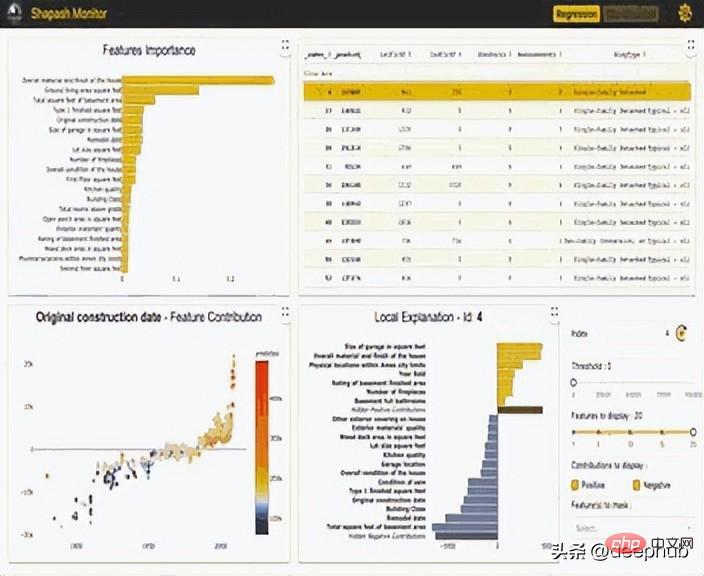

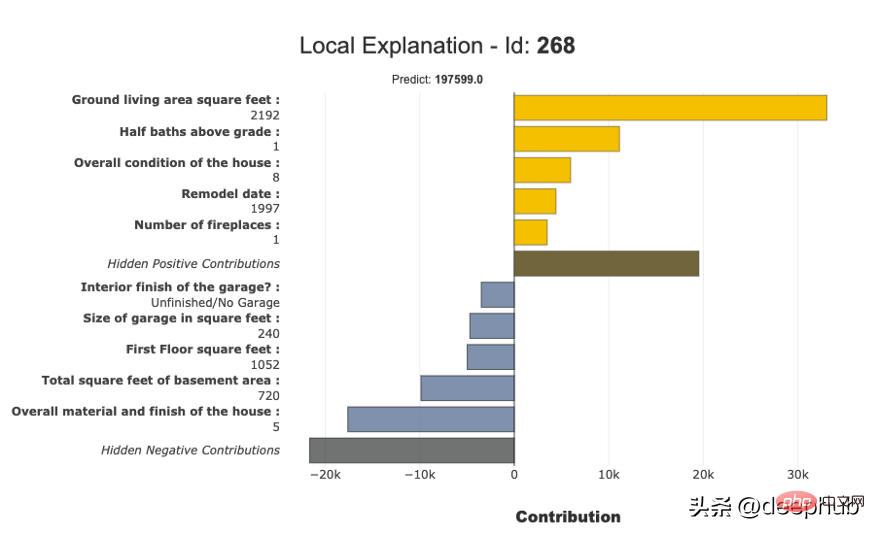

Membina graf sumbangan ciri menggunakan Shapash

Papan pemuka interaktif dibuat menggunakan perpustakaan Shapash

Graf penjelasan separa dibina menggunakan Shapash

InterpretML

InterpretML ialah pakej Python sumber terbuka yang menyediakan algoritma kebolehtafsiran pembelajaran mesin kepada penyelidik. InterpretML menyokong model latihan boleh tafsir (kotak kaca), serta mentafsir saluran paip ML sedia ada (kotak hitam).

InterpretML menunjukkan dua jenis kebolehtafsiran: model kotak kaca - model pembelajaran mesin yang direka untuk kebolehtafsiran (cth. model linear, senarai peraturan, model tambahan umum) dan teknik kebolehtafsiran kotak hitam - menggunakan Digunakan untuk menerangkan sistem sedia ada (cth. kebergantungan separa, LIME ). Menggunakan API bersatu dan merangkum pelbagai kaedah, dengan platform visualisasi yang boleh diperluaskan terbina dalam, pakej ini membolehkan penyelidik membandingkan algoritma kebolehtafsiran dengan mudah. InterpretML juga menyertakan pelaksanaan pertama Penjelasan Boosting Machine, model kotak kaca yang berkuasa, boleh ditafsir, yang boleh setepat banyak model kotak hitam.

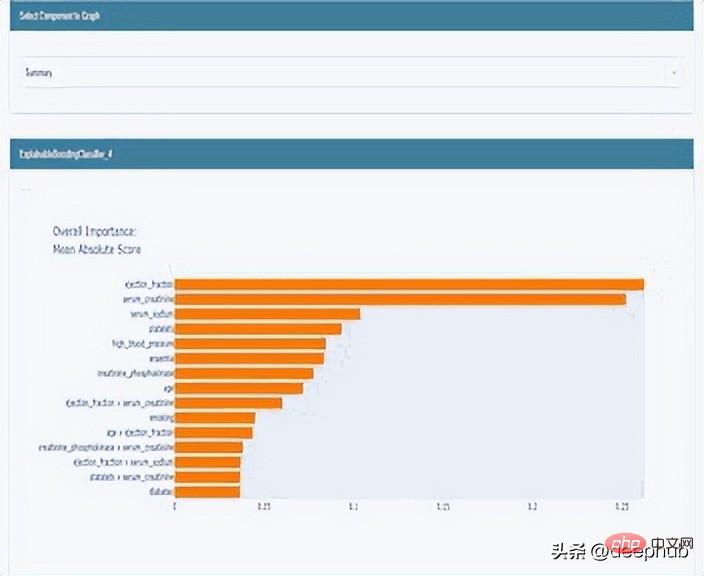

Graf interaktif penjelasan tempatan dibina menggunakan InterpretML

Graf penjelasan global yang dibina menggunakan InterpretML

ELI5

ELI5 ialah perpustakaan Python yang boleh membantu nyahpepijat pengelas pembelajaran mesin dan mentafsir ramalan mereka. Pada masa ini rangka kerja pembelajaran mesin berikut disokong:

- scikit-learn

- XGBoost, LightGBM CatBoost

- Keras

ELI5 mempunyai dua Cara utama untuk menerangkan model klasifikasi atau regresi:

- Periksa parameter model dan terangkan cara model berfungsi secara global

- Periksa ramalan individu model dan terangkan perkara yang akan dibuat oleh model tersebut. .

Gunakan perpustakaan ELI5 untuk menjana pemberat global

Gunakan perpustakaan ELI5 untuk menjana pemberat tempatan

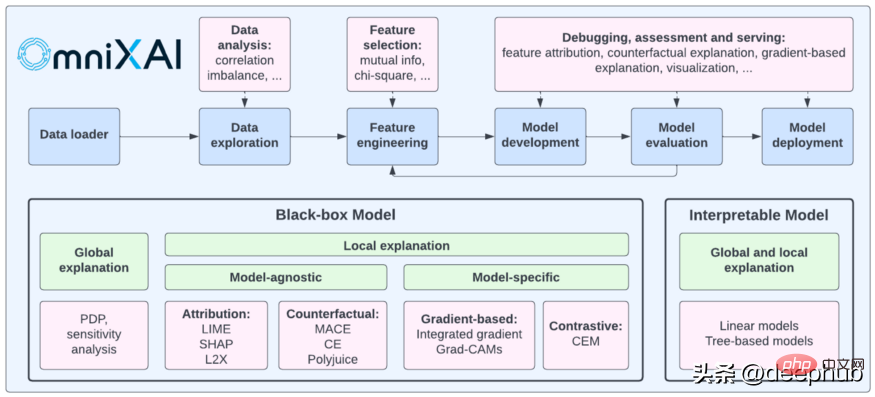

OmniXAI

OmniXAI (singkatan untuk Omni explain AI) ialah perpustakaan Python yang dibangunkan baru-baru ini dan sumber terbuka oleh Salesforce. Ia menyediakan rangkaian penuh kecerdasan buatan yang boleh dijelaskan dan keupayaan pembelajaran mesin yang boleh dijelaskan untuk menyelesaikan beberapa masalah yang memerlukan pertimbangan dalam penjanaan model pembelajaran mesin dalam amalan. Bagi saintis data, penyelidik ML yang perlu mentafsir pelbagai jenis data, model dan teknik penjelasan pada pelbagai peringkat proses ML, OmniXAI berharap dapat menyediakan perpustakaan komprehensif sehenti yang menjadikan AI boleh dijelaskan dengan mudah.

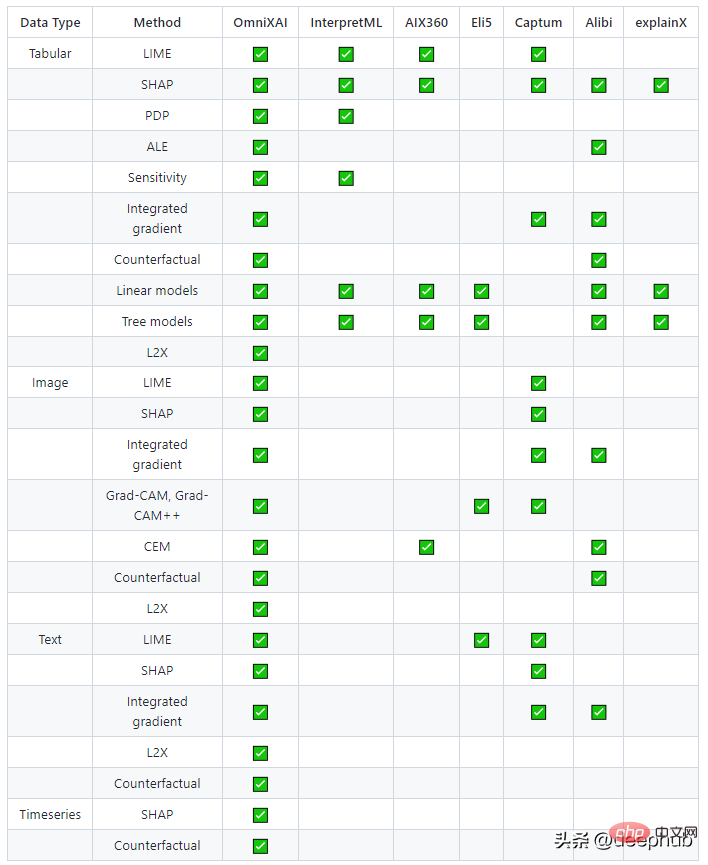

Berikut ialah perbandingan antara apa yang OmniXAI sediakan dan perpustakaan lain yang serupa

Atas ialah kandungan terperinci 6 Rangka Kerja Python yang Disyorkan untuk Membina Sistem Kepintaran Buatan (XAI) yang Boleh Diterangkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI