Rumah >Peranti teknologi >AI >Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!

Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!

- 王林ke hadapan

- 2023-04-14 16:10:031241semak imbas

Kebanyakan kejayaan dalam bidang kecerdasan buatan sejak beberapa tahun kebelakangan ini telah didorong oleh pembelajaran penyeliaan kendiri, seperti MLM (Model Bahasa Bertopeng) yang dicadangkan dalam BERT, yang meramalkan semula beberapa perkataan dalam teks dengan menutupnya , membenarkan data teks besar yang tidak berlabel digunakan untuk melatih model, dan sejak itu telah membuka era baharu model pra-latihan berskala besar. Walau bagaimanapun, algoritma pembelajaran yang diselia sendiri juga mempunyai had yang jelas Ia biasanya hanya sesuai untuk data dalam satu modaliti (seperti imej, teks, pertuturan, dll.), dan memerlukan banyak kuasa pengkomputeran untuk belajar daripada data besar-besaran. Sebaliknya, manusia belajar dengan ketara lebih cekap daripada model AI semasa dan boleh belajar daripada pelbagai jenis data.

Pada Januari 2022, Meta AI mengeluarkan data2vec rangka kerja pembelajaran penyeliaan kendiri , menyepadukan tiga data modal (suara, visual dan teks) melalui rangka kerja, terdapat trend menyatukan pelbagai mod. Baru-baru ini Meta AI dikeluarkan data2cec versi 2.0 , terutamanya meningkatkan generasi sebelumnya dari segi prestasi: dengan ketepatan yang sama, kelajuan latihan adalah sehingga 16 kali lebih tinggi daripada algoritma lain!

Pautan kertas:https://ai.facebook.com/research/publications/epembelajaran-pengawasan-sendiri-cekap-dengan-perwakilan-sasaran-kontekstual-untuk-penglihatan-pertuturan-dan-bahasa

Pautan kod:https://github.com/faceboo kresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0

Pada masa ini Secara umumnya, kebanyakan model pembelajaran mesin masih berdasarkan model pembelajaran yang diselia, yang memerlukan anotasi khusus untuk melabelkan data sasaran Walau bagaimanapun, untuk beberapa tugas (seperti beribu-ribu bahasa manusia di bumi), adalah perlu untuk mengumpul anotasi . Data tidak tersedia.

Sebaliknya, pembelajaran penyeliaan kendiri tidak perlu memberitahu model apa yang betul dan salah, tetapi membenarkan mesin belajar imej dengan memerhati dunia, struktur pertuturan dan teks. Hasil penyelidikan berkaitan telah menggalakkan pertuturan (cth., wave2vec 2.0), penglihatan komputer (cth., autoenkoder bertopeng), dan pemprosesan bahasa semula jadi (cth., BERT) dan bidang lain.

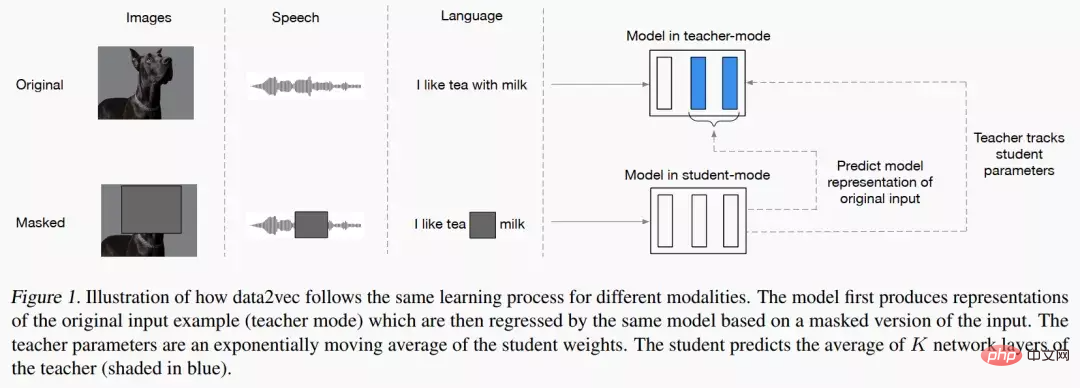

Idea utama data2vec adalah untuk membina rangkaian guru dahulu dan mula-mula mengira perwakilan sasaran daripada imej, teks atau ucapan . Data kemudiannya ditutup untuk mengaburkan bahagian input, dan proses diulang dengan rangkaian pelajar untuk meramalkan perwakilan yang diperoleh oleh model guru.

Dengan kata lain, model pelajar hanya boleh meramalkan perwakilan "data input lengkap" sambil menerima "maklumat input tidak lengkap". Untuk memastikan ketekalan kedua-dua model, parameter kedua-dua model dikongsi, tetapi parameter model Guru akan dikemas kini dengan lebih cepat pada peringkat awal latihan. Dari segi keputusan percubaan, data2vec telah meningkatkan prestasi dengan ketara berbanding model garis dasar dalam pertuturan, penglihatan, teks dan tugasan lain.

data2vec 2.0

data2vec mencadangkan umum rangka kerja pembelajaran penyeliaan kendiri menyatukan pembelajaran tiga data modal: pertuturan, penglihatan dan bahasa Perkara utama yang diselesaikan oleh data2vec2.0 ialah membina model penyeliaan sendiri memerlukan sejumlah besar kuasa pengkomputeran GPU untuk melengkapkan latihan. Sama seperti algoritma data2vec asal, data2vec 2.0 meramalkan perwakilan kontekstual bagi data atau lapisan rangkaian saraf, dan bukannya meramalkan piksel dalam imej, perkataan dalam segmen teks atau pertuturan.

Tidak seperti algoritma biasa yang lain, apa yang dipanggil perwakilan sasaran ini adalah kontekstual, yang bermaksud bahawa algoritma perlu Keseluruhan contoh latihan diambil kira.

Sebagai contoh, model mempelajari perwakilan perkataan bank berdasarkan keseluruhan ayat yang mengandungi bank, menjadikannya lebih mudah untuk menyimpulkan maksud perkataan yang betul, seperti membezakan sama ada ia secara khusus merujuk kepada "institusi kewangan" atau "tanah di tepi sungai." Para penyelidik percaya bahawa matlamat kontekstual akan memudahkan tugas pembelajaran yang lebih kaya dan membolehkan data2vec 2.0 belajar lebih cepat daripada algoritma lain.

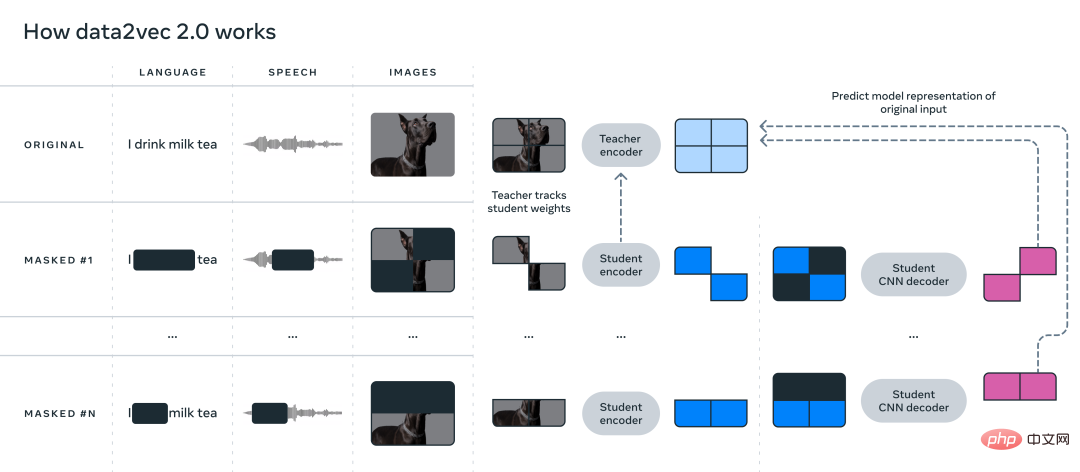

data2vec 2.0 meningkatkan kecekapan algoritma data2vec asal dalam tiga cara berikut:

1 Bina perwakilan sasaran untuk contoh latihan tertentu dan gunakan semula perwakilan pada versi bertopeng. Dalam versi bertopeng, bahagian contoh latihan yang berlainan disembunyikan secara rawak. Perwakilan yang dipelajari oleh kedua-dua versi kemudiannya dimasukkan ke dalam model pelajar, yang meramalkan perwakilan sasaran kontekstual yang sama untuk versi topeng yang berbeza, dengan berkesan melunaskan usaha pengiraan yang diperlukan untuk mencipta perwakilan sasaran.

2 Sama seperti pengekod auto bertopeng (MAE), rangkaian pengekod dalam model pelajar tidak berfungsi Bahagian kosong bagi contoh latihan (dikosongkan). Dalam eksperimen imej, kira-kira 80% bahagian kosong, menghasilkan penjimatan kitaran pengiraan yang ketara.

3 Model penyahkod yang lebih berkesan digunakan, yang tidak lagi bergantung pada rangkaian Transformer, tetapi bergantung pada berbilang lapisan. Rangkaian konvolusi.

Bahagian Eksperimen

Untuk memahami dengan lebih intuitif betapa lebih cekap data2vec 2.0 berbanding data2vec dan algoritma lain yang serupa, penyelidik dalam Computer Vision Eksperimen yang meluas dijalankan pada penanda aras yang berkaitan dengan , pertuturan dan tugasan teks. Dalam percubaan, ketepatan akhir dan masa yang diperlukan untuk pra-latihan model telah dipertimbangkan terutamanya Persekitaran eksperimen semuanya pada perkakasan yang sama (model GPU, kuantiti, dll.) untuk mengukur kelajuan berjalan algoritma.

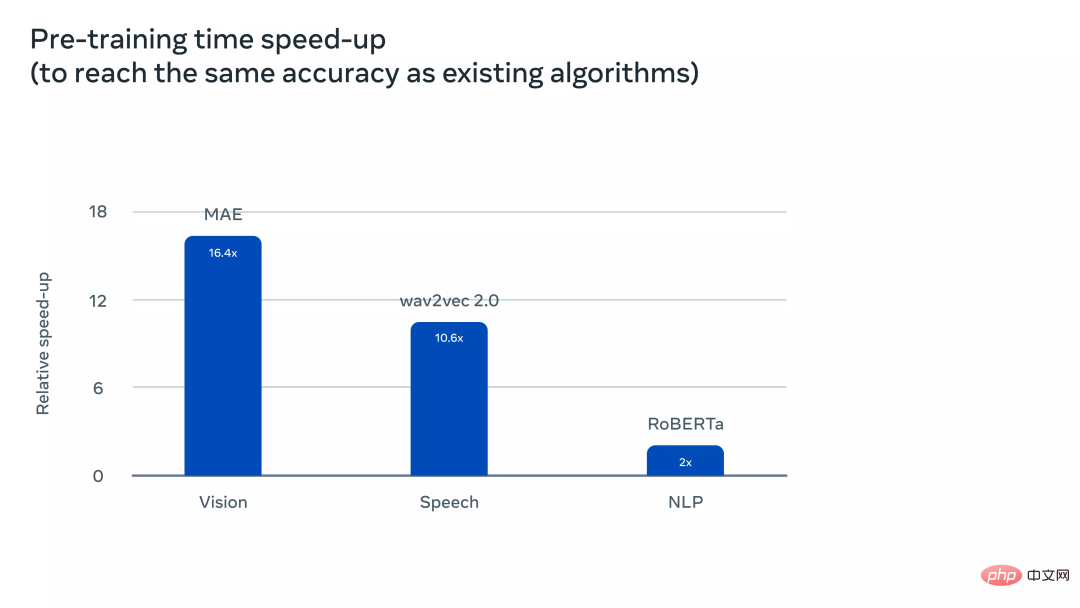

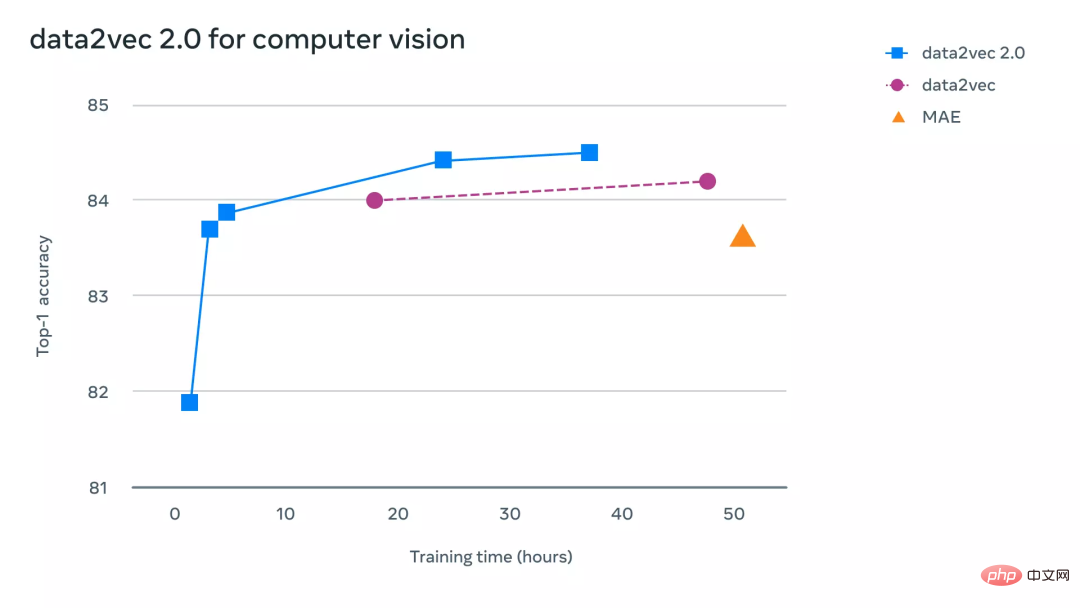

Mengenai tugas penglihatan komputer, para penyelidik menilai data2vec 2.0 pada tanda aras klasifikasi imej ImageNet-1K standard, set data dari mana model boleh mempelajari Imej perwakilan. Keputusan eksperimen menunjukkan bahawa data2vec 2.0 boleh menyamai ketepatan pengekod auto bertopeng (MAE), tetapi 16 kali lebih pantas.

Jika anda terus memberikan algoritma data2vec 2.0 lebih masa berjalan, ia boleh mencapai ketepatan yang lebih tinggi dan masih lebih pantas daripada MAE.

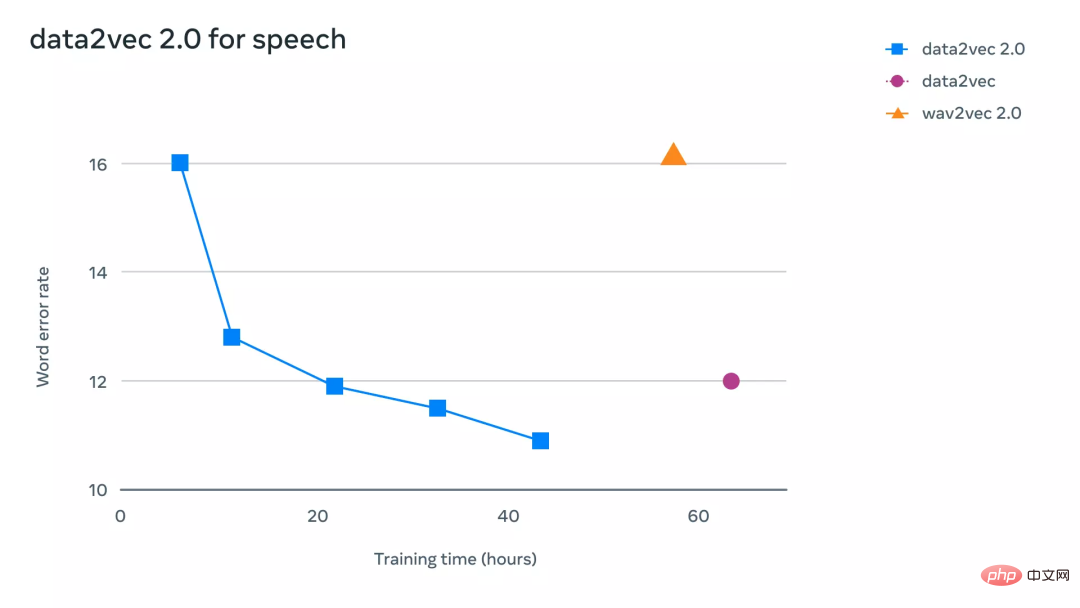

Mengenai tugas pertuturan, penyelidik mengujinya pada penanda aras pengecaman pertuturan LibriLanguage, dan ia lebih daripada 11 kali lebih tepat daripada wave2vec 2.0.

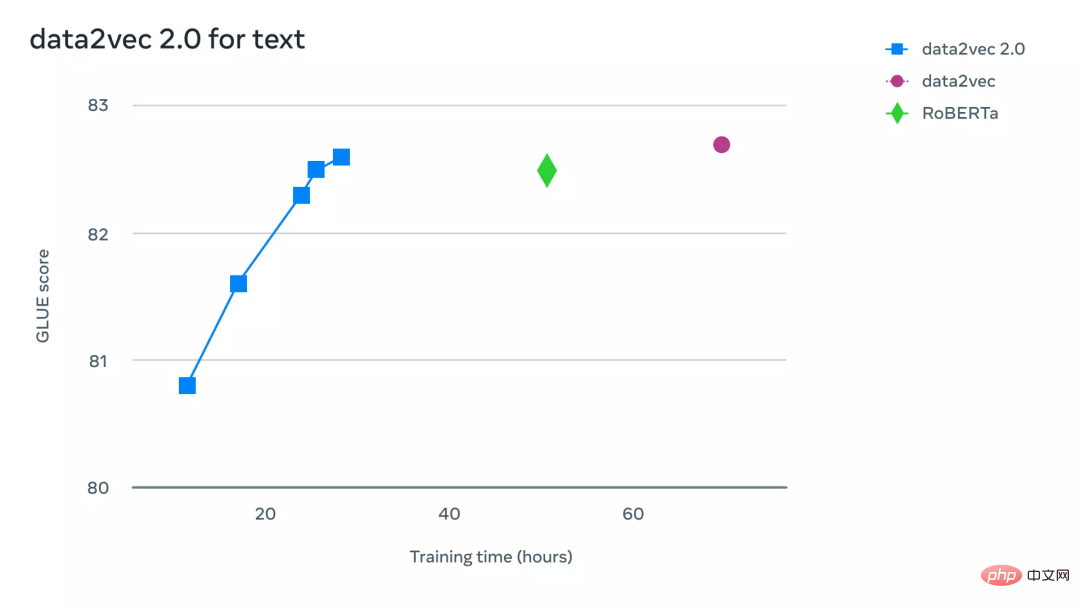

Untuk tugasan pemprosesan bahasa semula jadi, penyelidik menilai data2vec 2.0 pada penanda aras General Language Understanding Evaluation (GLUE), yang memerlukan hanya separuh masa latihan. boleh mencapai ketepatan yang sama seperti RoBERTa, pelaksanaan semula BERT.

Atas ialah kandungan terperinci Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI