Rumah >Peranti teknologi >AI >Kelajuan inferens adalah 2 kali lebih pantas daripada Resapan Stabil;

Kelajuan inferens adalah 2 kali lebih pantas daripada Resapan Stabil;

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-13 23:55:011643semak imbas

Kertas 1: Satu Model untuk Mengedit Kesemuanya: Manipulasi Imej Dipacu Teks Bentuk Percuma dengan Modulasi Semantik

- Pengarang: Yiming Zhu, Hongyu Liu et al

- Alamat kertas: https://arxiv.org/pdf/2210.07883.pdf

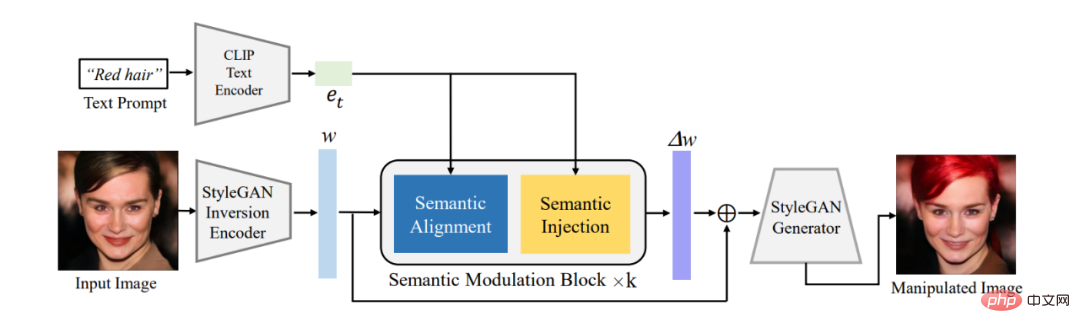

Abstrak: Artikel ini mula-mula menggunakan pengekod sedia ada untuk menukar imej yang perlu diedit kepada pengekodan berpotensi w dalam ruang semantik W^+ StyleGAN , dan kemudian mencadangkan Modul modulasi semantik melaksanakan modulasi penyesuaian pada pengekodan terpendam. Modul pemodulatan semantik termasuk penjajaran semantik dan modul suntikan semantik Ia mula-mula menjajarkan semantik antara pengekodan teks dan pengekodan terpendam GAN melalui mekanisme perhatian, dan kemudian menyuntik maklumat teks ke dalam pengekodan terpendam sejajar untuk memastikan pengekodan Cain memiliki. teks. Maklumat dengan itu mencapai keupayaan untuk mengedit imej menggunakan teks.

Berbeza daripada model StyleCLIP klasik, model kami tidak perlu melatih model berasingan untuk setiap teks Satu model boleh bertindak balas kepada berbilang teks untuk mengedit imej dengan berkesan, jadi kita Model itu menjadi Manipulasi Imej Dipacu Teks Borang Bebas FFCLIP. Pada masa yang sama, model kami telah mencapai hasil yang sangat baik pada set data gereja, muka dan kereta klasik.

Rajah 1: Gambarajah bingkai keseluruhan

Disyorkan: Paradigma baharu untuk penyuntingan teks dan imej, satu model membolehkan pengeditan imej berpandukan berbilang teks.

Kertas 2: Modul Fotovoltaik Organik Bercetak pada Substrat Ultra Nipis Boleh Pindah sebagai Sumber Kuasa Aditif

- Pengarang: Mayuran Saravanapavanantham, Jeremiah Mwaura, dll.

- Alamat kertas: https://onlinelibrary.wiley.com/doi/10.1002/smtd. 202200940

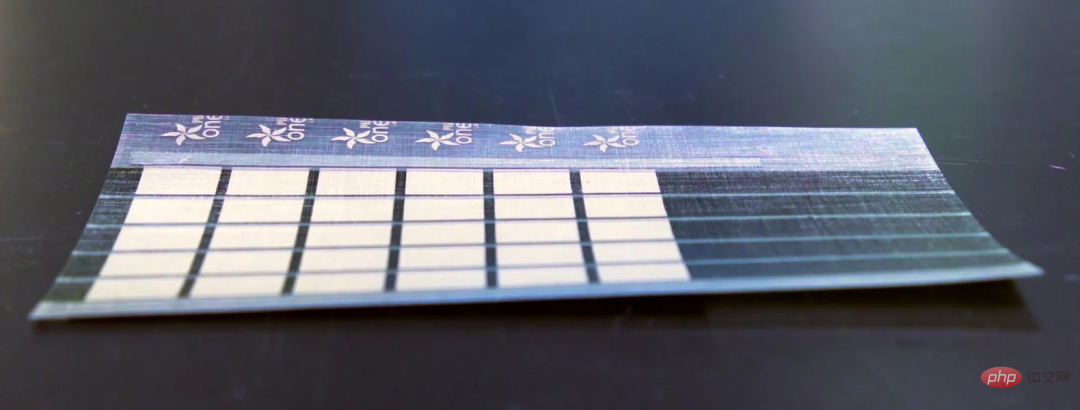

Ringkasan: Penyelidik MIT telah membangunkan teknologi pembuatan berskala yang boleh menghasilkan sel Suria ultra nipis dan ringan boleh diletakkan pada mana-mana permukaan.

Penyelidik MIT telah mencipta panel solar yang lebih nipis daripada rambut manusia dan membekalkan 18 kali lebih tenaga bagi setiap kilogram daripada panel solar berasaskan kaca dan silikon semasa. Panel solar ini mempunyai berat hanya satu peratus daripada sel fotovoltaik tradisional.

Panel solar ultra nipis ini juga boleh dipasang pada layar bot, sayap dron dan khemah. Mereka amat berguna di kawasan terpencil dan operasi bantuan bencana.

Disyorkan: MIT mencipta panel solar nipis kertas.

Kertas 3: Satu Tinjauan Pembelajaran Mendalam untuk Penaakulan Matematik

- Pengarang: Pan Lu, Liang Qiu et al

- Alamat kertas: https://arxiv.org/pdf/2212.10535.pdf

Abstrak: Dalam laporan yang dikeluarkan baru-baru ini, penyelidik dari UCLA dan institusi lain secara sistematik menyemak kemajuan pembelajaran mendalam dalam penaakulan matematik.

Secara khusus, kertas kerja ini membincangkan pelbagai tugasan dan set data (Bahagian 2), dan mengkaji kemajuan dalam rangkaian saraf (Bahagian 3) dan model bahasa pra-latihan (Bahagian 4) dalam bidang matematik . Perkembangan pesat pembelajaran kontekstual model bahasa besar dalam penaakulan matematik juga diterokai (Bahagian 5). Artikel tersebut menganalisis lebih lanjut penanda aras sedia ada dan mendapati bahawa kurang perhatian diberikan kepada persekitaran multimodal dan sumber rendah (Bahagian 6.1). Penyelidikan berasaskan bukti menunjukkan bahawa perwakilan semasa keupayaan pengkomputeran adalah tidak mencukupi dan kaedah pembelajaran mendalam adalah tidak konsisten berkenaan dengan penaakulan matematik (Bahagian 6.2). Selepas itu, penulis mencadangkan penambahbaikan kepada kerja semasa dari segi generalisasi dan keteguhan, penaakulan yang boleh dipercayai, pembelajaran daripada maklum balas, dan penaakulan matematik multimodal (Bahagian 7).

Disyorkan: Sejauh mana pembelajaran mendalam perlahan-lahan membuka pintu kepada penaakulan matematik.

Kertas 4: Muse: Penjanaan Teks-Ke-Imej melalui Transformers Generatif Bertopeng

- Pengarang: Huiwen Chang, Han Zhang, et al

- Alamat kertas: https://arxiv.org/pdf/2301.00704v1.pdf

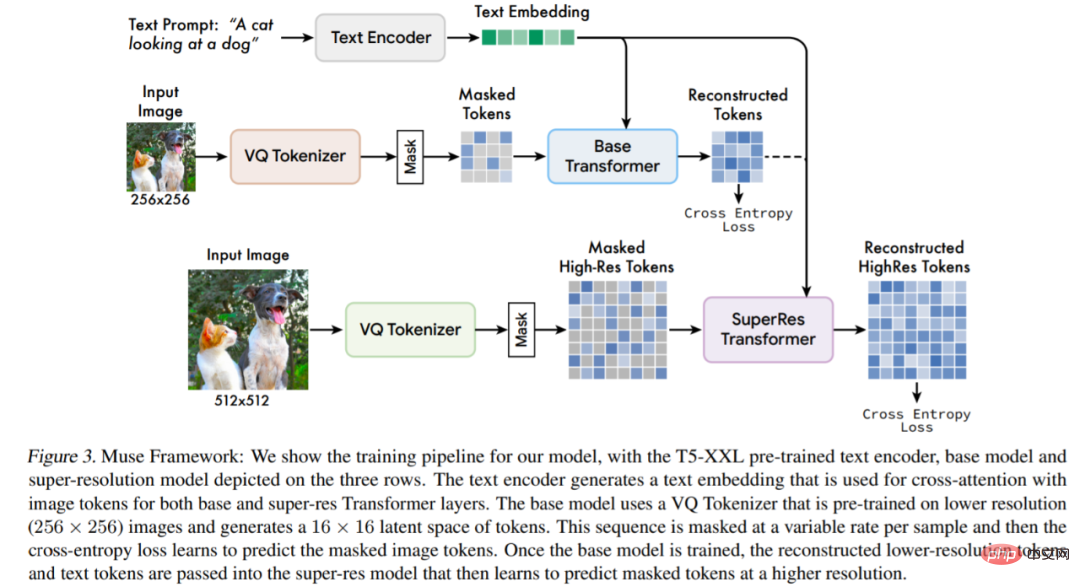

Abstrak: Kajian ini mencadangkan model baharu untuk sintesis teks ke imej menggunakan pendekatan pemodelan imej bertopeng, di mana seni bina penyahkod imej dimodelkan selepas Pembenaman pengekod T5-XXL Large Language Model (LLM) yang telah dilatih dan beku dikondisikan.

Berbanding dengan Imagen (Saharia et al., 2022) atau Dall-E2 (Ramesh et al., 2022) berdasarkan model resapan ruang piksel bertingkat Berbanding dengan Muse, kecekapan bertambah baik dengan ketara kerana penggunaan token diskret. Berbanding dengan model autoregresif SOTA Parti (Yu et al., 2022), Muse lebih cekap kerana penggunaan penyahkodan selari.

Berdasarkan keputusan percubaan pada TPU-v4, penyelidik menganggarkan Muse lebih 10 kali lebih pantas daripada model Imagen-3B atau Parti-3B dalam kelajuan inferens dan lebih pantas daripada Stable Diffusion v1 .4 (Rombach et al., 2022) 2 kali lebih cepat. Penyelidik percaya bahawa Muse lebih pantas daripada Stable Diffusion kerana model resapan digunakan dalam Stable Diffusion v1.4, yang jelas memerlukan lebih banyak lelaran semasa inferens.

Gambaran keseluruhan seni bina model.

Syor: Kelajuan inferens adalah 2 kali lebih pantas daripada Stable Diffusion, dan penjanaan dan pembaikan imej boleh dilakukan dengan satu model Google.

Kertas 5: Bunyi Insentif Positif

- Pengarang: Li Xuelong

- Alamat kertas: https://ieeexplore.ieee.org/document/10003114

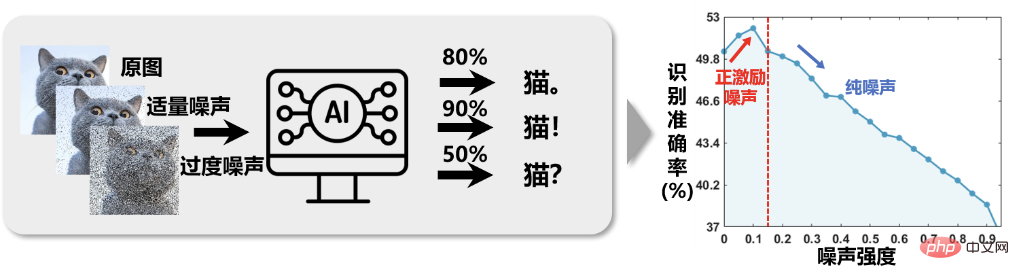

Abstrak: Dalam semua aspek penyelidikan saintifik, terdapat sejumlah besar bunyi, seperti ralat instrumen yang disebabkan oleh ketepatan instrumen yang tidak mencukupi, penyelewengan yang disebabkan oleh kesilapan manusia dalam operasi, herotan maklumat yang disebabkan oleh gangguan luar seperti persekitaran yang melampau , dll. Ia telah menjadi satu andaian biasa di kalangan penyelidik bahawa bunyi bising selalunya memberi kesan buruk terhadap tugas yang dilakukan. Oleh itu, sejumlah besar kerja penyelidikan telah dihasilkan di sekitar tugas teras "pengurangan hingar". Walau bagaimanapun, pasukan Profesor Li Xuelong dari Universiti Politeknik Barat Laut mempersoalkan andaian ini melalui pemerhatian eksperimen apabila melaksanakan tugas pengesanan dan pemprosesan isyarat: Adakah bunyi bising dalam penyelidikan saintifik benar-benar selalu berbahaya?

Seperti yang ditunjukkan dalam Rajah 1, dalam sistem pengelasan pintar imej, selepas menambah jumlah hingar yang sesuai pada imej dan kemudian latihan, ketepatan pengecaman meningkat. Ini membawa kita sedikit inspirasi: menambahkan sedikit hingar pada imej dan bukannya mengalih keluarnya, dan kemudian melaksanakan tugas pengelasan imej mungkin mendapat hasil yang lebih baik. Selagi kesan bunyi pada sasaran jauh lebih kecil daripada kesan bunyi pada latar belakang, kesan "merosakkan musuh (bunyi latar belakang) sebanyak seribu dan merosakkan diri sendiri (isyarat sasaran) sebanyak lapan ratus" adalah bermakna, kerana misi mengejar nisbah isyarat-ke-bunyi yang tinggi. Pada dasarnya, apabila berhadapan dengan masalah pengelasan tradisional, secara rawak menambah hingar sederhana selepas ciri adalah bersamaan dengan meningkatkan dimensi ciri, ia adalah serupa dengan menambah fungsi kernel pada ciri, yang sebenarnya menyelesaikan tugasan dari rendah -ruang dimensi ke ruang dimensi tinggi menjadikan data lebih boleh dipisahkan, sekali gus meningkatkan kesan pengelasan.

Rajah 1 Ketepatan pengecaman imej menunjukkan hubungan "berlawanan-intuitif" bagi "pertama kali meningkat dan kemudian berkurangan" apabila keamatan hingar imej meningkat.

Disyorkan: Profesor Li Xuelong dari NPU mencadangkan rangka kerja analisis matematik berdasarkan entropi tugasan.

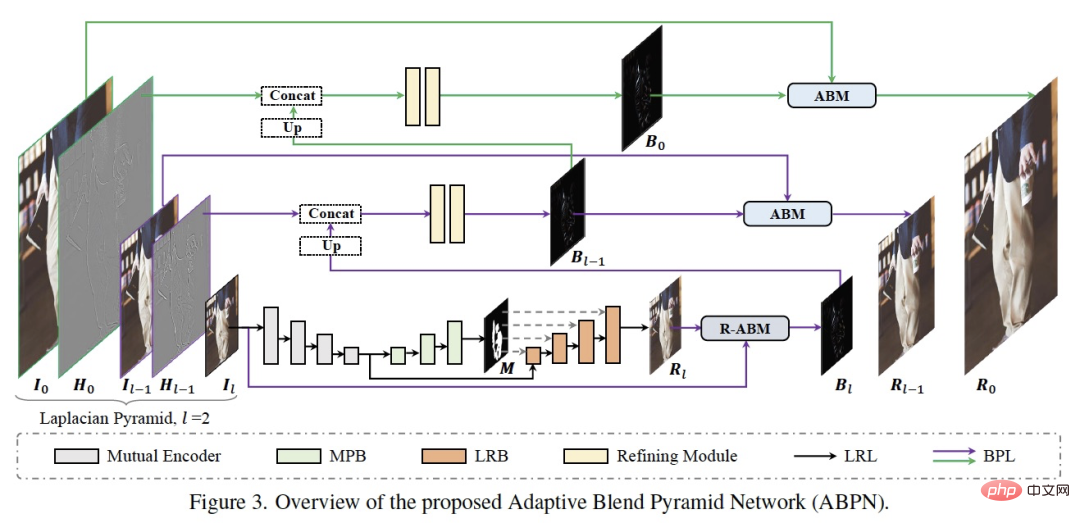

Kertas 6: ABPN: Rangkaian Adaptive Blend Pyramid untuk Penyesuaian Setempat Masa Nyata Foto Resolusi Ultra Tinggi

- Pengarang: Biwen Lei, Xiefan Guo, dll.

- Alamat kertas: https://openaccess.thecvf.com/content/ CVPR2022/ papers/Lei_ABPN_Adaptive_Blend_Pyramid_Network_for_Real-Time_Local_Retouching_of_CVPR_2022_paper.pdf

Pencarian Semula dari Akademi profesional penjagaan kulit sebagai titik permulaan, membangunkan satu set algoritma ubah suai tempatan ultra-halus ABPN untuk imej definisi tinggi, yang telah mencapai hasil dan aplikasi yang baik dalam pengindahan kulit dan tugas penyingkiran kedutan pakaian dalam imej definisi ultra tinggi.

Seperti yang ditunjukkan dalam rajah di atas, struktur rangkaian terutamanya terdiri daripada dua bahagian: lapisan pengubahsuaian tempatan (LRL) sedar konteks dan piramid hibrid adaptif lapisan (BPL). Tujuan LRL adalah untuk mengubah suai secara tempatan imej resolusi rendah sampel yang diturunkan dan menghasilkan imej hasil pengubahsuaian resolusi rendah, dengan mempertimbangkan sepenuhnya maklumat konteks global dan maklumat tekstur tempatan. Selanjutnya, BPL digunakan untuk meningkatkan secara beransur-ansur hasil resolusi rendah yang dijana dalam LRL kepada hasil resolusi tinggi. Antaranya, kami mereka bentuk modul pengadunan adaptif (ABM) dan modul terbaliknya (R-ABM) Menggunakan lapisan campuran perantaraan Bi, kami boleh merealisasikan penukaran adaptif dan pengembangan ke atas antara imej asal dan imej hasil, menunjukkan kebolehskalaan yang kuat. dan keupayaan kesetiaan terperinci. Kami menjalankan sejumlah besar eksperimen dalam dua set data pengubahsuaian muka dan pengubahsuaian pakaian, dan keputusan menunjukkan bahawa kaedah kami jauh mendahului kaedah sedia ada dari segi keberkesanan dan kecekapan. Perlu dinyatakan bahawa model kami mencapai inferens masa nyata bagi imej resolusi ultra tinggi 4K pada satu kad P100.

Disyorkan: Padam cela dan kedutan dengan satu klik.

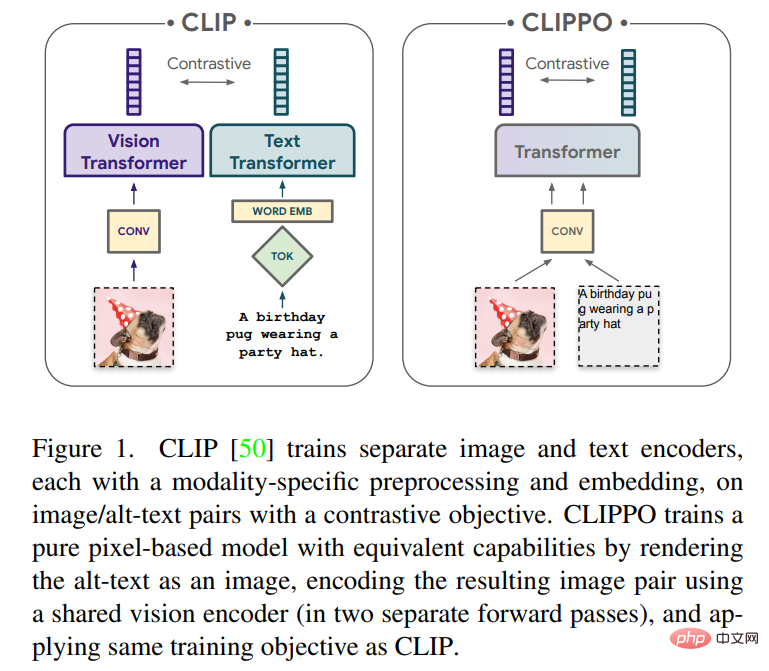

Kertas 7: Pemahaman Imej-dan-Bahasa daripada Piksel Sahaja

- Pengarang: Michael Tschannen, Basil Mustafa, dsb.

- Alamat kertas: https://arxiv.org/pdf/2212.08045.pdf

Abstrak: Membangunkan model hujung ke hujung tunggal yang boleh mengendalikan sebarang modaliti atau gabungan modaliti akan menjadi langkah penting dalam pembelajaran pelbagai mod. Dalam artikel ini, penyelidik daripada Google Research (pasukan Google Brain) dan Zurich akan memberi tumpuan terutamanya pada imej dan teks.

Artikel ini akan meneroka pembelajaran pelbagai mod teks dan imej menggunakan model berasaskan piksel semata-mata. Model ini ialah Transformer visual yang berasingan yang memproses input visual atau teks, atau kedua-duanya bersama-sama, semuanya dipaparkan sebagai imej RGB. Semua modaliti menggunakan parameter model yang sama, termasuk pemprosesan ciri peringkat rendah, iaitu, tiada lilitan awal khusus modaliti, algoritma tokenisasi atau jadual benam input. Model ini dilatih dengan hanya satu tugas: pembelajaran kontrastif, seperti yang dipopularkan oleh CLIP dan ALIGN. Oleh itu model itu dipanggil CLIP-Pixel Sahaja (CLIPPO).

Disyorkan: Parameter dibahagi dua dan sebaik CLIP Transformer visual bermula daripada piksel untuk menyatukan imej dan teks .

ArXiv Weekly Radiostation

Heart of Machine bekerjasama dengan ArXiv Weekly Radiostation yang dimulakan oleh Chu Hang dan Luo Ruotian, dan memilih kertas kerja yang lebih penting minggu ini berdasarkan 7 Papers, termasuk NLP, CV , 10 kertas terpilih dalam setiap bidang ML, dan sediakan pengenalan abstrak kepada kertas dalam bentuk audio Butirannya adalah seperti berikut:

10 Kertas NLPAudio: . 00:0020:02

10 kertas kerja NLP terpilih minggu ini ialah:

1. daripada Hongming Zhang , Dan Roth)

2 Memahami Polarisasi Politik menggunakan Model Bahasa: Satu set data dan kaedah (dari Bhiksha Raj)

. 3. Ke Arah Penjanaan Jadual-ke-Teks dengan Model Bahasa Pralatihan: Pemahaman Struktur Jadual dan Pendekatan Pertimbangan Teks (dari Hui Xiong)

4. (daripada Brendan O'Connor)

5 Ke Arah Penghuraian Semantik Teks-ke-SQL Intensif dengan Pengetahuan Formula (dari Min-Yen Kan)

6. Memanfaatkan Pengetahuan Dunia dalam Pengesanan Pertuturan Kebencian Tersirat (daripada Jessica Lin)

7 Furu Wei)

8. EZInterviewer: Untuk Meningkatkan Prestasi Temuduga Kerja dengan Mock Interview Generator (dari Tao Zhang)

9 Pemodelan Bahasa berasaskan Kamus untuk Pengecaman Pertuturan Automatik (daripada Yuxuan Wang)

10 Ruang Reka Bentuk Penalaan Halus Parameter (daripada Diyi Yang)

10 Kertas CVAudio: 00:0021:06

10 kertas kerja CV terpilih minggu ini ialah:

1. CA$^2$T-Net: Pemindahan Artikulasi 3D Kategori-Agnostik daripada Imej Tunggal (dari Jitendra Malik)

2 pengembangan tanaman pokok lestari di Benin (dari Vipin Kumar)

3

4. LANGKAH: Pengekstrakan Langkah Utama Sendiri daripada Video Prosedur Tidak Berlabel (daripada Rama Chellappa)

5 Penjanaan melalui Transformers Generatif Bertopeng (daripada Ming-Hsuan Yang, Kevin Murphy, William T. Freeman)

6 )

7 Transformer Cross Modal melalui Pengekodan Koordinat untuk Pengesanan Objek 3D (dari Xiangyu Zhang)

8 Perwakilan melalui Semantic Region Prediction (dari Alan Yuille)

9. Pembelajaran secara Isih: Pembelajaran Sendiri dengan Kekangan Susunan Kumpulan (dari Bernt Schiele)

10. AttEntropy: Membahagikan Objek Tidak Diketahui dalam Adegan Kompleks menggunakan Entropi Perhatian Spatial Transformer Segmentasi Semantik. (dari Pascal Fua)

10 ML Kertas音频:00:0023:15

本周 10 篇 ML 精选论文是:

1. Pembelajaran Struktur Graf Terpelihara Organisasi Kendiri dengan Prinsip Maklumat Berkaitan. (daripada Philip S. Yu)

2. Peluasan Pertanyaan Diubahsuai Melalui Rangkaian Adversarial Generatif untuk Pengekstrakan Maklumat dalam E-Dagang. (dari Altan Cakir)

3. Penjelasan Terpisah Ramalan Rangkaian Neural dengan Mencari Subruang Berkaitan. (daripada Klaus-Robert Müller)

4. L-HYDRA: Rangkaian Neural Bermaklumat Fizik Berbilang Kepala. (daripada George Em Karniadakis)

5. Mengenai Mengubah Pembelajaran Pengukuhan oleh Transformer: Trajektori Pembangunan. (dari Dacheng Tao)

6. Menggalakkan Rangkaian Neural untuk Menyusun Perduaan Dioptimumkan. (daripada Kai Chen)

7. NeuroExplainer: Penyahkodan Perhatian Berbutir Halus untuk Mendedahkan Corak Perkembangan Kortikal Bayi Pramatang. (dari Dinggang Shen)

8. Teori Pembelajaran Sedikit Tembakan Seperti Manusia. (dari Ming Li)

9. Pembelajaran Perbezaan Temporal dengan Kemas Kini Termampat: Ralat-Maklum Balas memenuhi Pembelajaran Pengukuhan. (daripada George J. Pappas)

10. Menganggarkan Aliran Populasi Terpendam daripada Data Terkumpul melalui Pengangkutan Optimum Berbilang Margin Songsang. (dari Hongyuan Zha)

Atas ialah kandungan terperinci Kelajuan inferens adalah 2 kali lebih pantas daripada Resapan Stabil;. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI