Rumah >Peranti teknologi >AI >Google menggunakan semula algoritma klasik dari 30 tahun yang lalu, dan CV memperkenalkan pembelajaran pengukuhan: Adakah RLHF visual akan datang?

Google menggunakan semula algoritma klasik dari 30 tahun yang lalu, dan CV memperkenalkan pembelajaran pengukuhan: Adakah RLHF visual akan datang?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-13 23:43:011177semak imbas

Kepopularan ChatGPT jelas kepada semua, dan teknologi di sebalik kejayaannya diselia penalaan halus arahan dan pembelajaran pengukuhan berdasarkan maklum balas manusia. Teknik ini juga berkembang secara beransur-ansur ke dalam bidang AI lain, termasuk penglihatan komputer (CV).

Kita tahu bahawa apabila menangani output yang kompleks dalam penglihatan komputer, kriteria utama untuk kejayaan bukanlah seberapa baik model mengoptimumkan sasaran latihan, tetapi seberapa baik keupayaan ramalan sepadan dengan tugas . Iaitu, prestasi model untuk kegunaan yang dimaksudkan.

Untuk meneruskan konsistensi ini, sesetengah penyelidik telah membuat beberapa penambahbaikan dalam seni bina model, data, pengoptimuman, pensampelan, pasca pemprosesan, dsb. Sebagai contoh, dalam tugas pengesanan objek, penyelidik menggunakan NMS (penindasan bukan maksimum), kehilangan global berasaskan set dan menukar data input untuk mendapatkan model dengan tingkah laku yang lebih baik pada masa ujian. Walaupun kaedah ini membawa faedah yang ketara, ia selalunya hanya berguna untuk tugasan tertentu dan hanya secara tidak langsung mengoptimumkan risiko misi.

Bukan sahaja CV, malah pemprosesan bahasa semula jadi (NLP), pembelajaran pengukuhan (RL) dan bidang lain turut mengkaji fenomena ini secara meluas. Dalam domain ini, sangat sukar untuk merumuskan matlamat pengoptimuman untuk tugasan yang kurang jelas, seperti terjemahan atau penjanaan ringkasan. Apabila menangani masalah jenis ini, pendekatan yang popular ialah belajar meniru output contoh dan kemudian melakukan pembelajaran tetulang untuk menyelaraskan model dengan fungsi ganjaran . Bidang NLP telah menghasilkan hasil yang menarik menggunakan pendekatan ini, yang menggunakan model bahasa pra-terlatih yang besar dan ganjaran yang ditakrifkan oleh maklum balas manusia untuk menangani tugasan yang sukar ditentukan.

Tambahan pula, kaedah yang sama digunakan secara meluas dalam tugasan kapsyen imej, di mana CIDEr (yang dicadangkan oleh Vedantam et al. 2015) digunakan sebagai ganjaran. Namun begitu, sepanjang pengetahuan kami, pengoptimuman ganjaran belum pernah diterokai dalam tugas penglihatan komputer (bukan tekstual).

Baru-baru ini, penyelidik dari pasukan Google Brain telah membuktikan dalam kertas kerja "Menala model penglihatan komputer dengan ganjaran tugas" bahawa menggunakan algoritma REINFORCE (yang dicadangkan oleh Williams pada tahun 1992 ) Penalaan model pra-latihan dengan fungsi ganjaran boleh digunakan di luar kotak untuk pelbagai tugas penglihatan komputer .

Malah, banyak kajian tentang tugasan pembelajaran pengukuhan akan menyebut algoritma REINFORCE Williams, yang menunjukkan kepentingan algoritma ini. Boleh dikatakan bahawa algoritma REINFORCE ialah wakil tipikal bagi kecerunan dasar dan juga pembelajaran pengukuhan.

Alamat kertas: https://arxiv.org/pdf/2302.08242v1.pdf

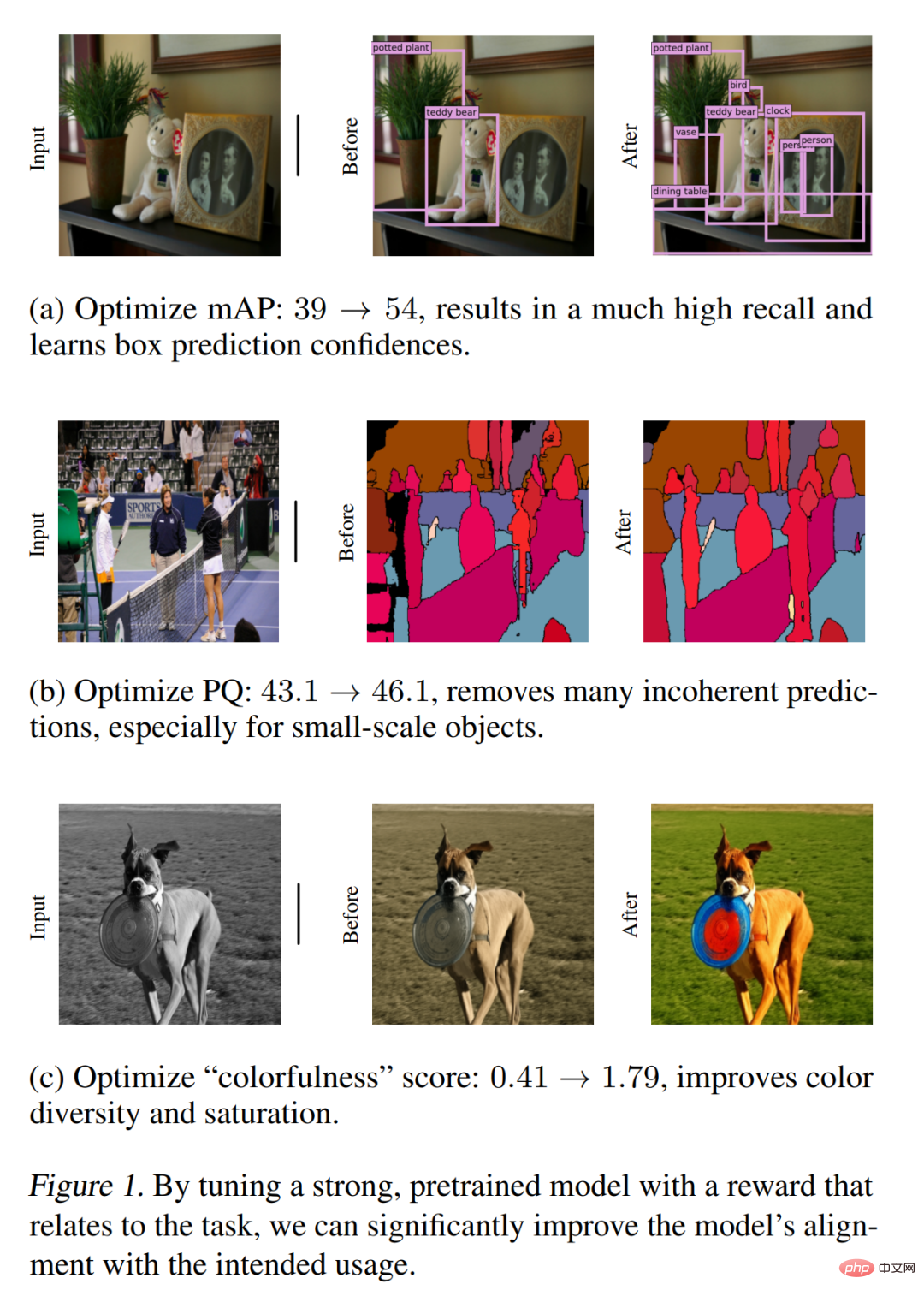

Rajah 1 Beberapa hasil utama dibentangkan, terutamanya termasuk penambahbaikan kuantitatif dan kualitatif yang dibawa oleh pengoptimuman ganjaran dalam pengesanan objek, pembahagian panorama dan pewarnaan imej. Kaedah yang dicadangkan dalam kajian ini adalah mudah dan berkesan dalam mengendalikan pelbagai tugas CV, menunjukkan kepelbagaian dan kebolehsuaiannya. Walaupun kertas kerja ini terutamanya menggunakan ganjaran dalam bentuk metrik penilaian, keputusan awal ini menunjukkan bahawa kaedah ini juga boleh menjadi cara yang berkesan untuk mengoptimumkan model penglihatan komputer yang mempunyai ganjaran yang lebih kompleks dan sukar untuk ditentukan, seperti maklum balas manusia atau prestasi keseluruhan .

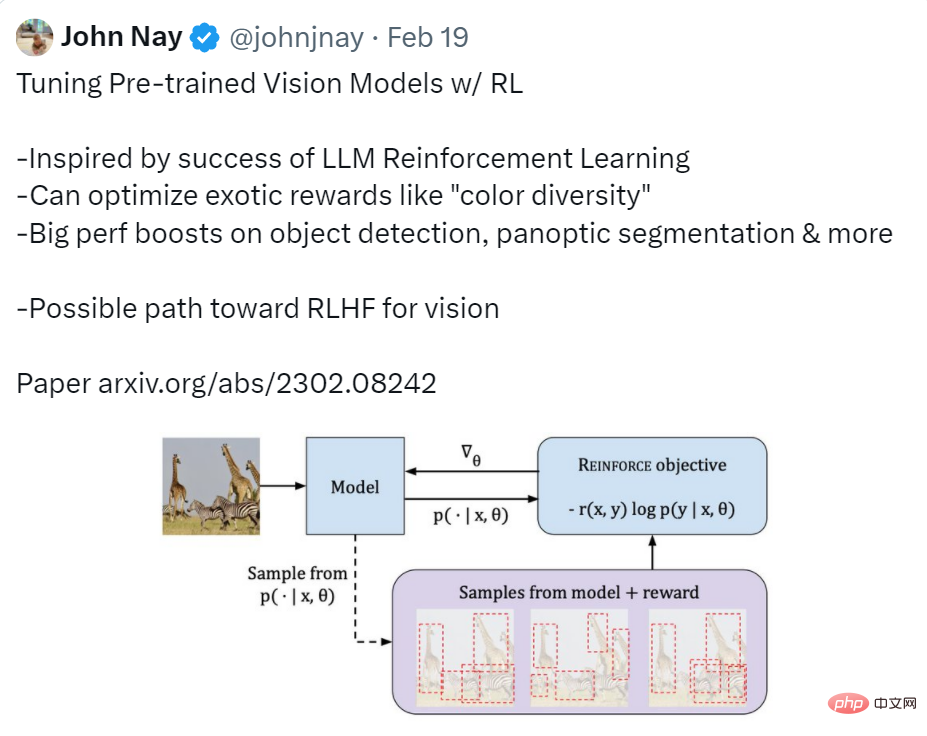

Pengguna Twitter memberikan ringkasan yang agak menyeluruh tentang artikel ini, iaitu fungsi yang dilaksanakan dalam artikel ini ialah menggunakan RL untuk melaraskan pra- model visual terlatih. Motivasi untuk penyelidikan telah diilhamkan oleh kejayaan pembelajaran pengukuhan LLM kesannya adalah peningkatan yang ketara dalam prestasi dalam pengesanan sasaran, segmentasi panorama, dsb. Beliau juga menyatakan bahawa penyelidikan ini mungkin cara yang berkesan untuk mencapai RLHF visual (Pembelajaran Pengukuhan daripada Maklum Balas Manusia).

Sumber imej: https://twitter.com/johnjnay/status /1627009121378598912

Ganjaran

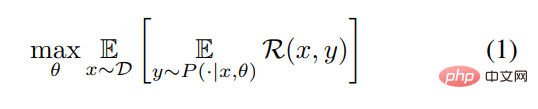

Tanpa kehilangan generalisasi, kajian menggambarkan tugas CV sebagai proses pembelajaran fungsi yang memetakan input x (iaitu imej) kepada output y = [y_1, y_1,. .., y_n] (jujukan token teks, jujukan kotak sempadan, dsb.). Penyelidikan ini bertujuan untuk mempelajari taburan bersyarat P (y|x, θ) dengan θ sebagai parameter untuk memaksimumkan fungsi ganjaran R. Untuk menggunakan formula abstrak untuk menerangkannya, artikel ini akan menyelesaikan masalah pengoptimuman berikut.

Masalahnya ada, dan langkah seterusnya ialah cara menyelesaikannya. Artikel ini dibahagikan kepada dua langkah: pertama, gunakan anggaran kemungkinan maksimum Pra-latih model, kemudian gunakan algoritma REINFORCE untuk menala model. Mari kita lihat proses khusus dua langkah ini:

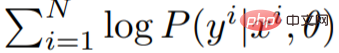

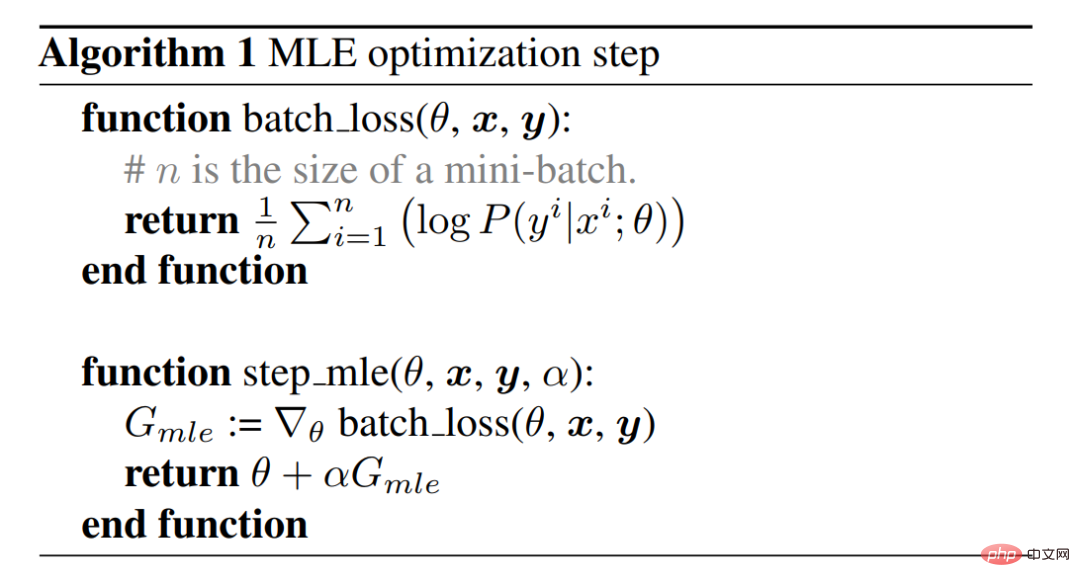

Pralatihan kemungkinan maksimum

Parameter θ mula-mula dianggarkan menggunakan prinsip kemungkinan maksimum dan pengedaran data latihan ditangkap. Ini dicapai menggunakan algoritma penurunan kecerunan, yang berfungsi dengan memaksimumkan kemungkinan log data latihan. Algoritma 1 dan Rajah 2 menerangkan langkah pengoptimuman MLE (anggaran kemungkinan maksimum), yang merupakan kaedah yang paling biasa untuk model latihan. Melengkapkan langkah ini akan menghasilkan model MLE.

Algoritma REINFORC memaksimumkan ganjaran

Algoritma REINFORC memaksimumkan ganjaran

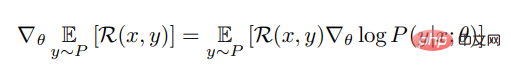

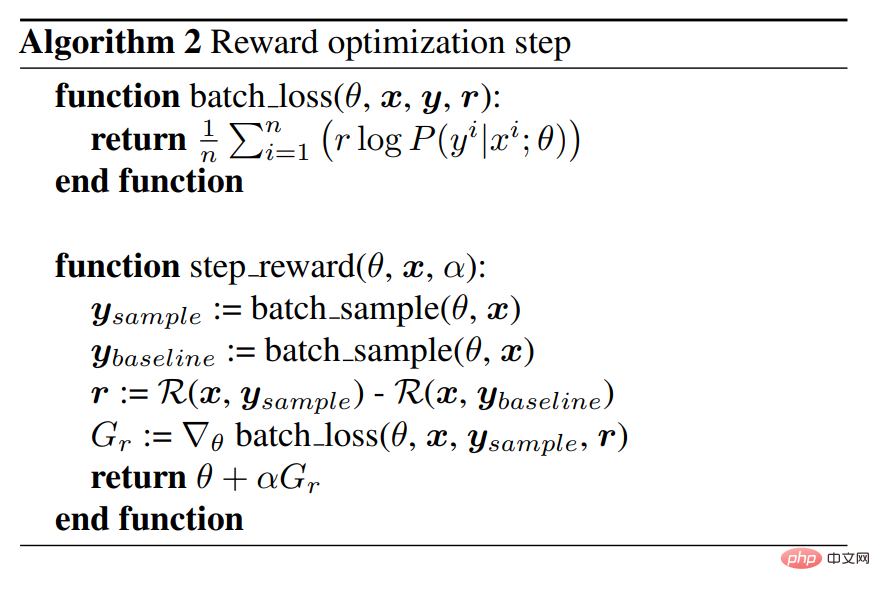

Untuk mengoptimumkan model MLE dengan lebih baik untuk menyesuaikan diri dengan risiko tugas, ia juga perlu untuk memaksimumkan fungsi ganjaran. Untuk input x yang diberikan, kajian ini menggunakan algoritma REINFORCE untuk menganggarkan kecerunan ganjaran yang dijangkakan untuk x yang diberikan Formulanya adalah seperti berikut:

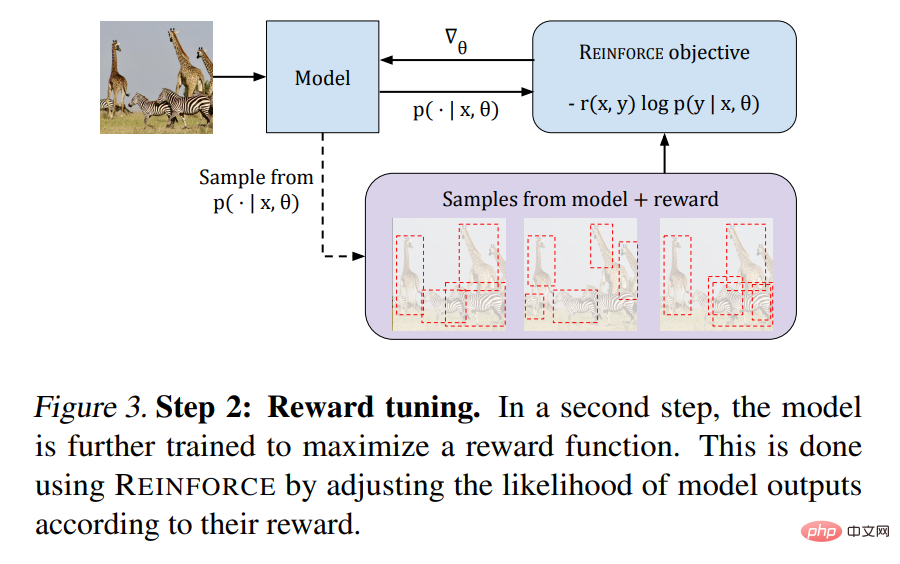

<.>Pseudokod Algoritma 2 disediakan dan Rajah 3 menggambarkan proses:

Seterusnya, mari kita lihat prestasi kaedah yang dicadangkan dalam artikel ini mengenai tugas visual.

Seterusnya, mari kita lihat prestasi kaedah yang dicadangkan dalam artikel ini mengenai tugas visual.

Segmentasi Panorama

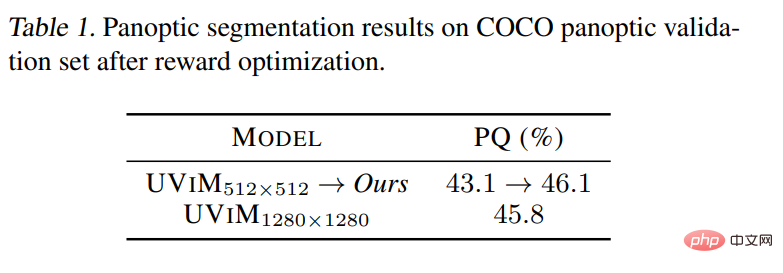

Seperti yang ditunjukkan dalam Jadual 1 di bawah, proses Penalaan meningkatkan model MLE dengan ketara. Keputusan selepas pemeriksaan visual menunjukkan bahawa model selepas Penalaan lebih baik untuk mengelakkan ramalan yang tidak koheren, terutamanya untuk objek berskala kecil, lihat Rajah 1.

Pengesanan sasaran

Pengesanan sasaran

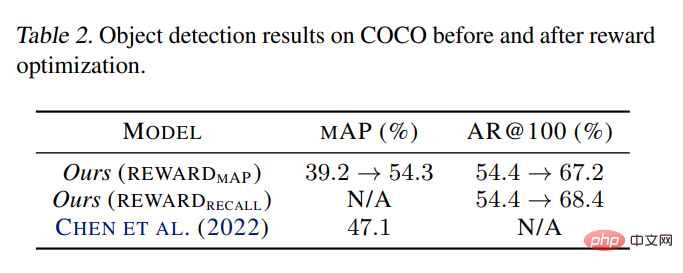

Jadual 2 menunjukkan bahawa melalui pengoptimuman, kajian ini telah meningkatkan dengan ketara skor mAP model MLE asal daripada 39.2% kepada 54.3%. Dalam Pix2seq, model ViT-B bersaiz sama dengan resolusi 1333×1333 lebih besar sedikit dan banyak heuristik mencapai 47.1%. Apabila menggunakan tulang belakang ViT-L yang lebih besar, Pix2seq melaporkan hasil pengesanan sasaran terbaik sebanyak 50.0%.

Mewarna

Hasil kualitatif yang dibentangkan dalam Rajah 4 jelas menunjukkan bahawa model baharu secara konsisten menghasilkan imej yang lebih berwarna.

Penerangan Imej

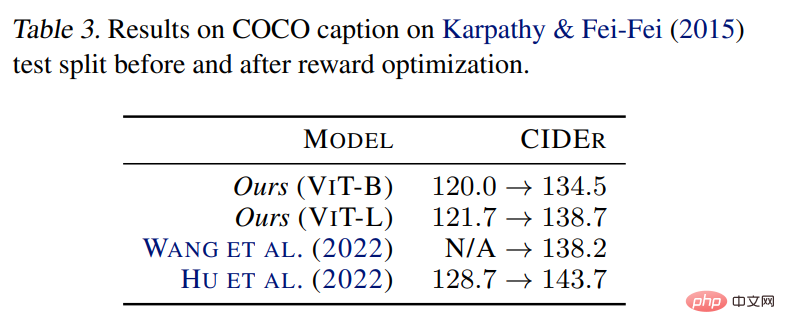

Keputusan Jadual 3 menunjukkan bahawa menggunakan kaedah yang dicadangkan boleh menambah baik model MLE, yang konsisten dengan pemerhatian sebelumnya dalam literatur, menunjukkan keberkesanan kaedah ini untuk menyesuaikan risiko tugas tertentu.

Atas ialah kandungan terperinci Google menggunakan semula algoritma klasik dari 30 tahun yang lalu, dan CV memperkenalkan pembelajaran pengukuhan: Adakah RLHF visual akan datang?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI