Rumah >Peranti teknologi >AI >Cabaran satu kad setiap hari: RTX2080Ti mengendalikan latihan model yang besar, menjimatkan 136 kali kuasa pengkomputeran, dan komuniti akademik bersorak

Cabaran satu kad setiap hari: RTX2080Ti mengendalikan latihan model yang besar, menjimatkan 136 kali kuasa pengkomputeran, dan komuniti akademik bersorak

- PHPzke hadapan

- 2023-04-13 18:58:011591semak imbas

Apakah jenis model BERT yang boleh diperolehi dengan melatih GPU gred pengguna dalam masa sehari sahaja?

Baru-baru ini, model bahasa telah sekali lagi membakar bidang AI. Atribut latihan tanpa pengawasan bagi model bahasa pra-latihan membolehkannya dilatih berdasarkan sampel besar-besaran dan memperoleh sejumlah besar pengetahuan semantik dan tatabahasa Sama ada klasifikasi atau soal jawab, nampaknya tidak ada masalah dengan AI tidak dapat menyelesaikan.

Walau bagaimanapun, model besar bukan sahaja membawa kejayaan teknologi, tetapi juga meletakkan permintaan yang tidak berkesudahan pada kuasa pengkomputeran.

Baru-baru ini, Jonas Geiping dan Tom Goldstein dari University of Maryland membincangkan semua penyelidikan mengenai penskalaan pengiraan dan menyelidiki arah penambahbaikan dalam mengecilkan pengiraan. Penyelidikan mereka telah menarik perhatian komuniti pembelajaran mesin.

Dalam penyelidikan baharu, penulis membincangkan jenis model bahasa yang boleh dilatih oleh GPU gred pengguna tunggal (RTX 2080Ti) dan memperoleh hasil yang menarik. Mari lihat bagaimana ia dilaksanakan:

Peluasan skala model

Dalam bidang pemprosesan bahasa semula jadi (NLP), model pra-latihan berdasarkan seni bina Transformer telah menjadi arus perdana dan telah membawa banyak Kemajuan terobosan. Sebahagian besarnya, sebab prestasi hebat model ini adalah skala besarnya. Apabila jumlah parameter model dan data meningkat, prestasi model akan terus bertambah baik. Oleh itu, terdapat perlumbaan dalam bidang NLP untuk meningkatkan saiz model.

Walau bagaimanapun, beberapa penyelidik atau pengamal percaya mereka mempunyai keupayaan untuk melatih model bahasa besar (LLM), dan biasanya hanya gergasi teknologi dalam industri yang mempunyai sumber untuk melatih LLM.

Untuk membalikkan arah aliran ini, penyelidik dari Universiti Maryland menjalankan beberapa penerokaan.

Kertas "Cramming: Melatih Model Bahasa pada GPU Tunggal dalam Satu Hari":

Pautan kertas: https://arxiv.org/abs /2212.14034

Isu ini sangat penting kepada kebanyakan penyelidik dan pengamal, kerana ia akan menjadi rujukan untuk kos latihan model dan dijangka dapat memecahkan kesesakan kos latihan LLM yang sangat tinggi. Kertas penyelidikan itu dengan cepat mencetuskan perhatian dan perbincangan di Twitter.

Pakar penyelidikan NLP IBM, Leshem Choshen mengulas di Twitter: "Kertas kerja ini meringkaskan semua helah latihan model besar yang boleh anda fikirkan."

Penyelidik di University of Maryland percaya bahawa jika pra-latihan model yang diperkecilkan ialah simulasi pra-latihan berskala besar yang boleh dilaksanakan, maka ini akan membuka satu siri penyelidikan akademik lanjut mengenai model berskala besar yang sukar dicapai pada masa ini.

- Model bahasa berasaskan pengubah dalam sebarang saiz, dilatih sepenuhnya dari awal menggunakan pemodelan bahasa bertopeng

- Saluran paip tidak boleh mengandungi model pra-latihan sedia ada ;

- Sebarang mentah; teks (tidak termasuk data hiliran) boleh dimasukkan dalam latihan, yang bermaksud percepatan boleh dicapai dengan bijak memilih cara dan bila untuk mengambil sampel data, dengan syarat mekanisme pensampelan tidak memerlukan pra- Model latihan; prapemprosesan data mentah tidak termasuk dalam jumlah belanjawan di sini termasuk pembinaan tokenizer berasaskan CPU, tetapi tidak termasuk pembelajaran perwakilan

- Latihan Hanya dijalankan pada satu GPU selama 24 jam; 🎜>

Prestasi hiliran dinilai pada gam. digunakan, dan penalaan halus hiliran tidak dikira dalam jumlah belanjawan. -

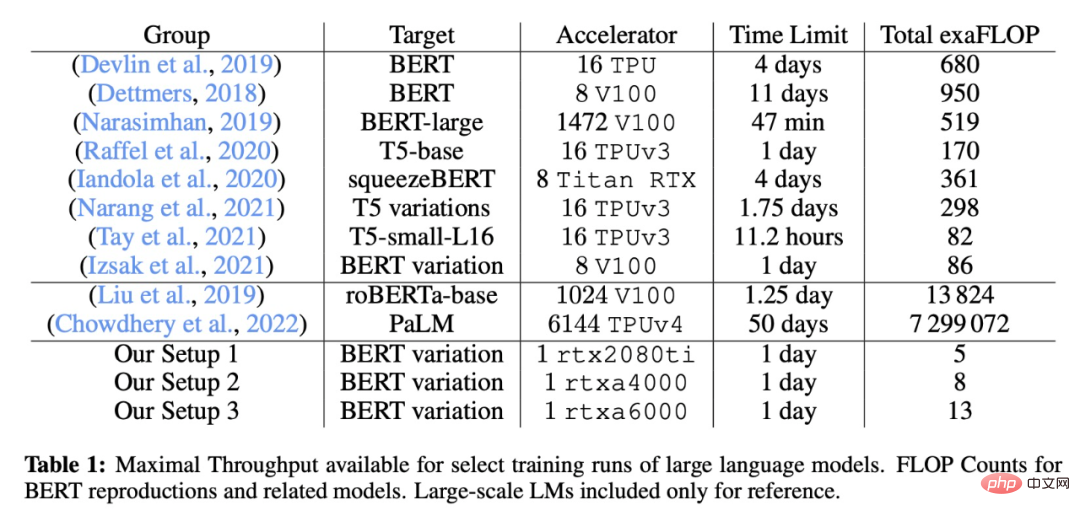

- Tetapan latihan khusus kajian ini berbanding dengan beberapa model besar klasik ditunjukkan dalam jadual berikut:

Kaedah penambahbaikan

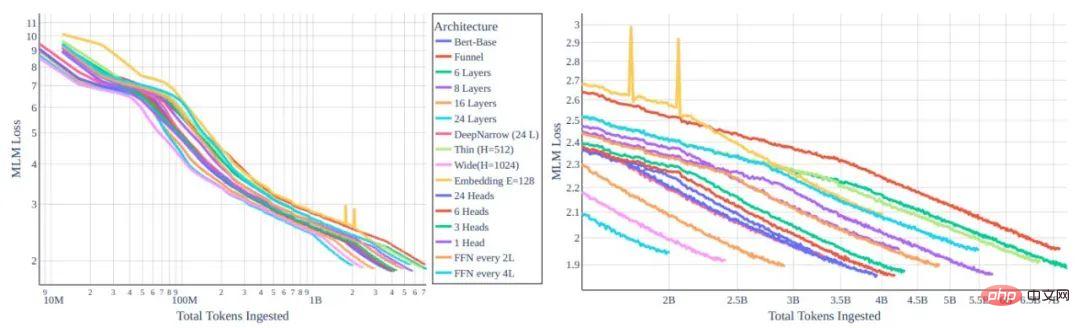

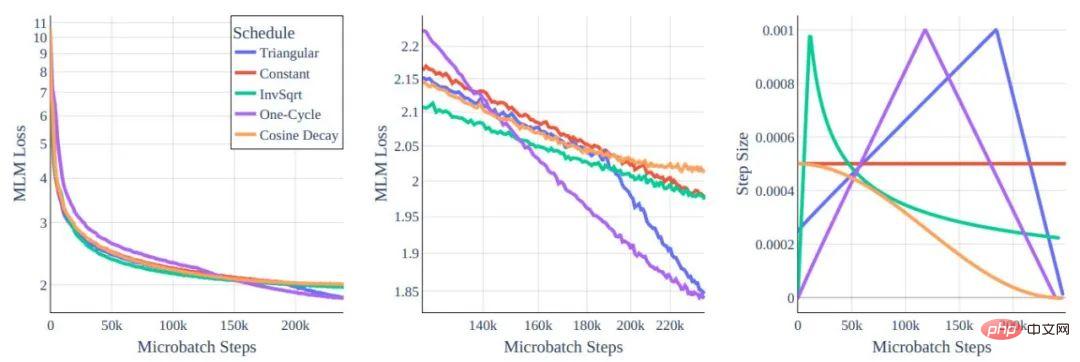

Rajah 1: Perbandingan fungsi kehilangan MLM dan token bagi varian seni bina transformer yang berbeza

Rajah 2: Jadual Kadar Pembelajaran

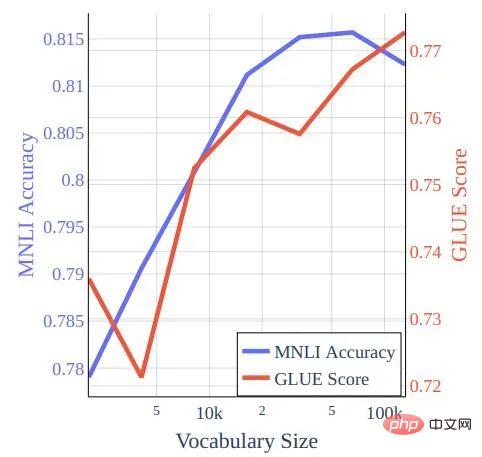

Rajah 3: Saiz perbendaharaan kata berbanding skor GLUE dan ketepatan MNLI untuk model yang dilatih tentang latihan gaya Cramming pada data bookcorpus-wikipedia.

Prestasi pada GLUE

Para penyelidik menilai secara sistematik prestasi penanda aras GLUE dan WNLI, dengan menyatakan bahawa dalam bahagian sebelumnya hanya MNLI (m) digunakan dan bukan berdasarkan skor GLUE penuh Laraskan hiperparameter. Dalam kajian baharu, pengarang memperhalusi semua set data untuk 5 zaman untuk asas BERT, dengan saiz kelompok 32 dan kadar pembelajaran 2 × 10-5. Ini adalah suboptimum untuk model terlatih Cramming, yang boleh mendapat peningkatan kecil daripada saiz kelompok 16 dan kadar pembelajaran 4 × 10−5 dengan pereputan kosinus (tetapan ini tidak menambah baik titik semak BERT pra-latihan).

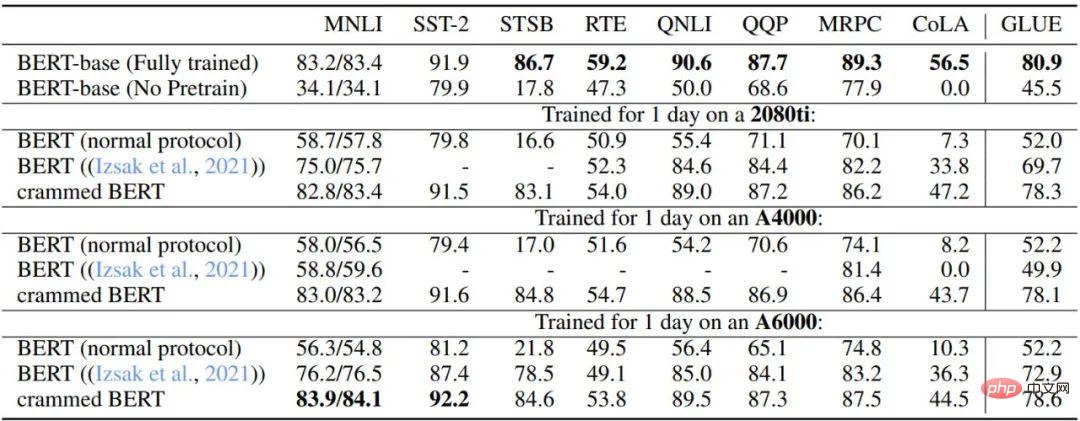

Jadual 3 dan Jadual 4 menerangkan prestasi persediaan ini pada tugas hiliran GLUE. Penulis membandingkan titik semak asas BERT asal, tetapan pra-latihan BERT yang berhenti selepas mencapai had kuasa pengkomputeran, tetapan yang diterangkan dalam kajian 2021 oleh Izsak et al., dan tetapan diubah suai yang dilatih selama satu hari bagi setiap GPU tetapan. Secara keseluruhannya, prestasi sangat baik, terutamanya untuk set data yang lebih besar seperti MNLI, QQP, QNLI dan SST-2, dan penalaan halus hiliran boleh melancarkan baki perbezaan antara model BERT penuh dan varian tetapan Cramming.

Selain itu, penulis mendapati bahawa kaedah baharu itu bertambah baik dengan ketara berbanding latihan BERT biasa dengan kuasa pengkomputeran yang terhad dan kaedah yang diterangkan oleh Izsak et al. Untuk kajian oleh Izsak et al., kaedah yang diterangkan pada asalnya direka untuk pelayan bilah 8-GPU penuh, dan dalam senario baharu, memampatkan model BERT-besar ke GPU yang lebih kecil bertanggungjawab untuk kebanyakan sebab prestasi untuk merosot.

Jadual 3: Perbandingan prestasi GLUE-dev bagi model versi BERT dan Cramming garis dasar

Hiperparameter semua tugasan ditetapkan dan had zaman ialah 5 , nilai yang hilang ialah NaN. Ia direka untuk pelayan bilah 8-GPU, dan di sini, semua pengkomputeran dijejalkan ke dalam satu GPU.

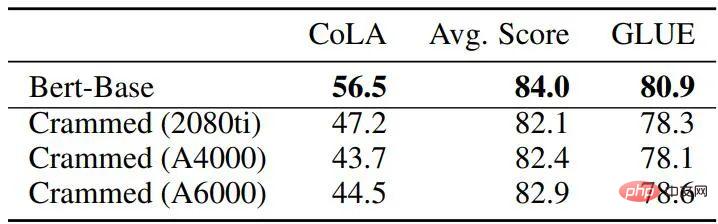

Jadual 4: Perbandingan prestasi GLUE-dev antara baseline BERT dan model padding

Secara keseluruhan, menggunakan kaedah dalam kertas kerja, hasil latihan adalah sangat hampir BERT asal, tetapi sedar bahawa yang terakhir menggunakan 45-136 kali lebih jumlah FLOPS daripada kaedah baharu (ia mengambil masa empat hari pada 16 TPU). Dan apabila masa latihan dilanjutkan sebanyak 16 kali (dua hari latihan pada 8 GPU), prestasi kaedah baharu sebenarnya bertambah baik daripada BERT asal, mencapai tahap RoBERTa.

Ringkasan

Dalam kerja ini, telah dibincangkan berapa banyak prestasi model bahasa berasaskan transformer boleh dicapai dalam persekitaran yang sangat terhad dari segi pengiraan Mujurlah, beberapa arah pengubahsuaian boleh membolehkan Kami mendapat yang baik di hiliran prestasi pada GLUE. Para penyelidik berharap bahawa kerja ini dapat menyediakan garis dasar untuk penambahbaikan selanjutnya dan seterusnya memberikan sokongan teoritis untuk banyak penambahbaikan dan teknik yang dicadangkan untuk seni bina transformer dalam beberapa tahun kebelakangan ini.

Atas ialah kandungan terperinci Cabaran satu kad setiap hari: RTX2080Ti mengendalikan latihan model yang besar, menjimatkan 136 kali kuasa pengkomputeran, dan komuniti akademik bersorak. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI