Rumah >Peranti teknologi >AI >Versi Meta 'Divide Everything' yang sangat berkembang telah ada di sini! IDEA mengetuai pasukan domestik teratas untuk mencipta: mengesan, membahagikan dan menjana segala-galanya serta meraih 2k bintang

Versi Meta 'Divide Everything' yang sangat berkembang telah ada di sini! IDEA mengetuai pasukan domestik teratas untuk mencipta: mengesan, membahagikan dan menjana segala-galanya serta meraih 2k bintang

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-13 14:40:031912semak imbas

Selepas model "bahagi segala-galanya" Meta keluar, orang dalam industri telah pun menyatakan bahawa CV tidak wujud.

Hanya satu hari selepas SAM dikeluarkan, pasukan domestik telah menghasilkan versi berevolusi "Grounded-SAM" berdasarkannya.

Nota: Logo projek telah dibuat oleh pasukan menggunakan Midjourney selama sejam

Grounded-SAM mengintegrasikan SAM dengan BLIP dan Stable Diffusion, menyepadukan tiga keupayaan "segmentasi", "pengesanan" dan "generasi" imej menjadi satu, menjadi aplikasi visual Zero-Shot yang paling berkuasa.

Netizen menyatakan ia terlalu kerinting! "Ini terlalu pantas," kata Wenhu Chen, seorang saintis penyelidikan di Google Brain dan penolong profesor sains komputer di Universiti Waterloo.

Bos AI Shen Xiangyang juga mengesyorkan projek terbaharu ini kepada semua orang:

Grounded- Segmen-Anything : Mengesan, membahagikan dan menjana apa-apa sahaja secara automatik dengan input imej dan teks. Pembahagian tepi boleh dipertingkatkan lagi.

Grounded- Segmen-Anything : Mengesan, membahagikan dan menjana apa-apa sahaja secara automatik dengan input imej dan teks. Pembahagian tepi boleh dipertingkatkan lagi.

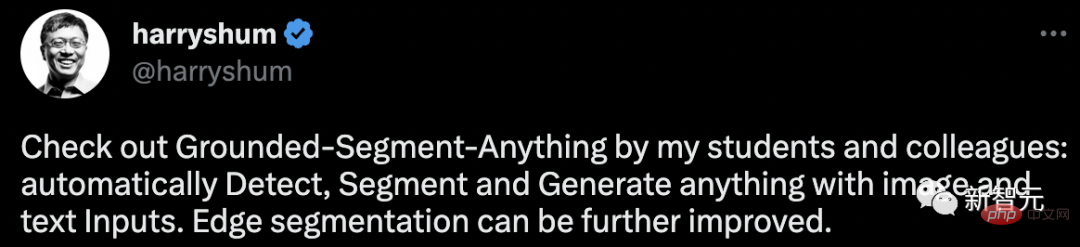

Setakat ini, projek ini telah memperoleh 2k bintang di GitHub.

Kesan segala-galanya, belah segala-galanya, jana segala-galanya

Minggu lalu, pengeluaran SAM mengalu-alukan CV Inilah detik GPT-3. Malah, Meta AI mendakwa bahawa ini adalah model pembahagian imej asas pertama dalam sejarah.

Model ini boleh menentukan titik, kotak sempadan dan ayat dalam pengekod gesaan rangka kerja bersatu untuk membahagikan terus sebarang objek dengan satu klik.

SAM mempunyai fleksibiliti yang luas, iaitu, ia mempunyai keupayaan migrasi sifar sampel, yang cukup untuk menampung pelbagai kes penggunaan Dengan latihan tambahan, ia boleh digunakan di luar kotak dalam domain pengimejan baharu, sama ada foto bawah air atau mikroskop sel.

Dapat dilihat bahawa SAM sangat kuat.

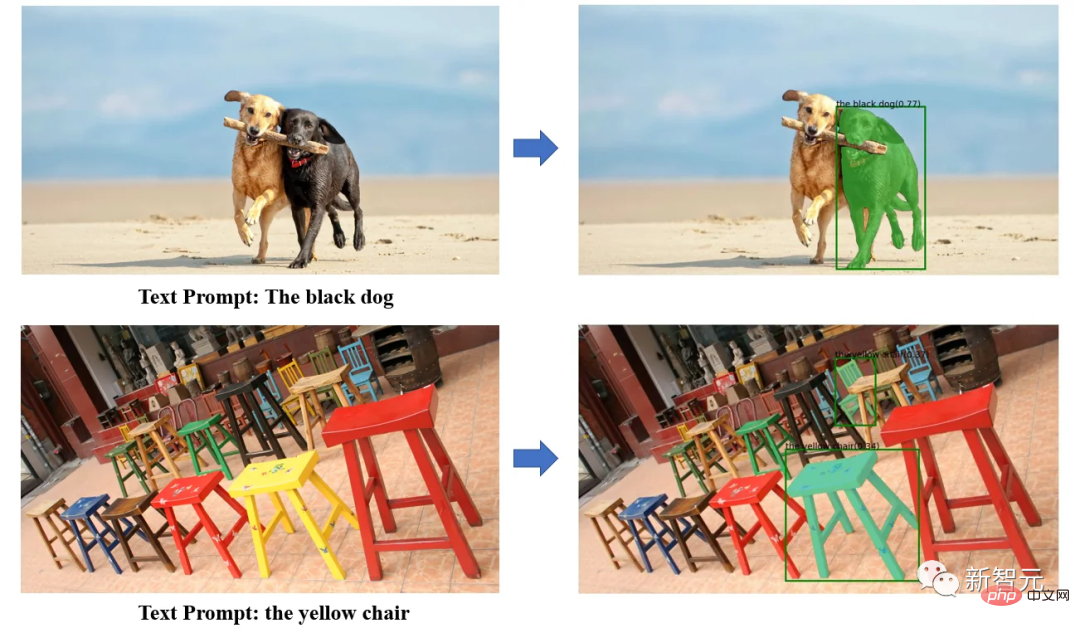

Kini, penyelidik domestik telah menghasilkan idea baharu berdasarkan model ini dengan menggabungkan pengesan sasaran sampel sifar yang berkuasa dengan DINO, ia boleh mengesan dan membahagikan melalui input teks .

Kini, penyelidik domestik telah menghasilkan idea baharu berdasarkan model ini dengan menggabungkan pengesan sasaran sampel sifar yang berkuasa dengan DINO, ia boleh mengesan dan membahagikan melalui input teks .

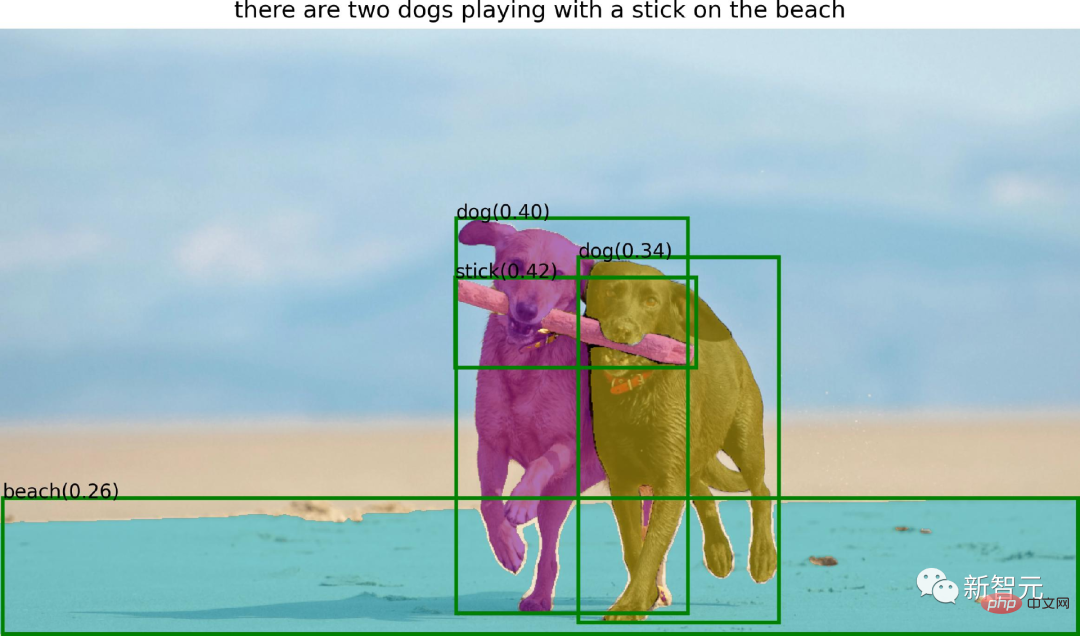

Dengan keupayaan pengesanan sampel sifar yang berkuasa DINO Grounding, SAM Grounded boleh mencari sebarang objek dalam gambar melalui penerangan teks, dan kemudian menggunakan keupayaan segmentasi berkuasa SAM untuk membahagikan objek dalam cara yang halus mas.

Akhir sekali, Resapan Stabil juga boleh digunakan untuk menjana teks dan imej yang boleh dikawal dalam kawasan yang dibahagikan.

Dalam amalan khusus Grounded-SAM, para penyelidik menggabungkan Segmen-Anything dengan tiga model sifar pukulan yang berkuasa untuk membina proses sistem pelabelan automatik dan menunjukkan hasil yang sangat, sangat mengagumkan!

Projek ini menggabungkan model berikut:

· BLIP: Model Anotasi Imej Berkuasa

· DINO pembumian: Pengesan tembakan sifar terkini

· Segmen-Apa-apa sahaja: Sifar berkuasa- Model segmentasi pukulan

· Stabil-Resapan: Model generatif yang sangat baik

Semua model boleh digabungkan Gunakan atau boleh digunakan secara bebas. Bina model aliran kerja visual yang berkuasa. Keseluruhan aliran kerja mempunyai keupayaan untuk mengesan segala-galanya, membahagikan segala-galanya dan menjana segala-galanya.

Ciri-ciri sistem termasuk:

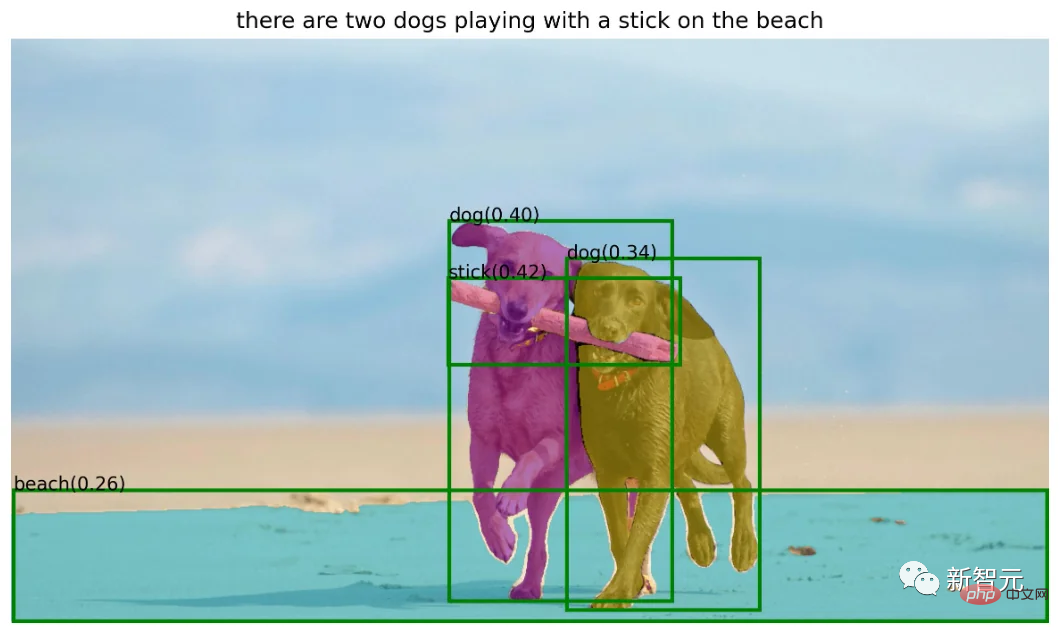

BLIP+Grounded-SAM=Pelabel Automatik

Gunakan model BLIP untuk menjana tajuk, mengekstrak label dan menggunakan Ground-SAM untuk menjana kotak dan topeng:

· Sistem anotasi separa automatik: Mengesan teks input dan menyediakan anotasi kotak dan anotasi topeng yang tepat.

· Sistem pelabelan automatik sepenuhnya:

Mula-mula gunakan BLIP model Hasilkan anotasi yang boleh dipercayai untuk imej input, kemudian biarkan Grounding DINO mengesan entiti dalam anotasi, diikuti dengan SAM contohnya pembahagian pada isyarat kotak mereka.

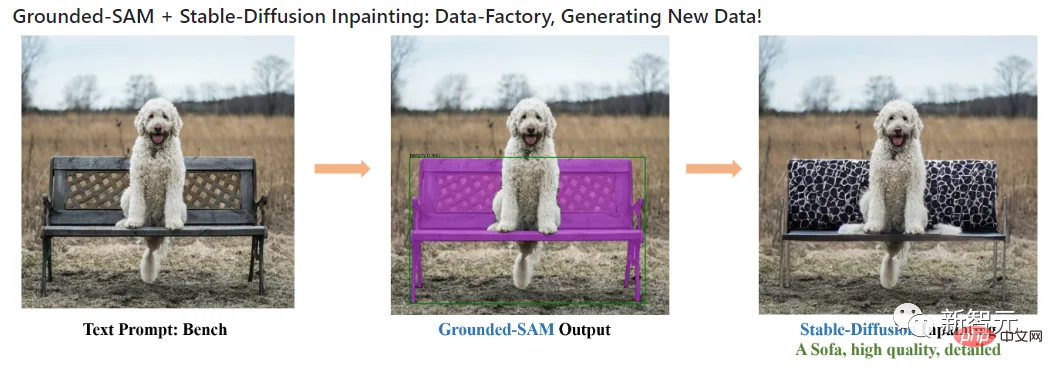

Stable Diffusion+Grounded-SAM=Kilang Data

· Gunakan sebagai kilang data untuk menjana data baharu: Model pembaikan resapan boleh digunakan untuk menjana data baharu berdasarkan topeng.

Segmen Apa sahaja+Pengeditan Manusia

Di cawangan ini, penulis Gunakan Segmen Anything untuk mengedit rambut/muka orang.

· Penyuntingan Rambut SAM+

· Fesyen SAM+ Editor

Pengarang mencadangkan beberapa kemungkinan arah penyelidikan masa hadapan untuk model Grounded-SAM:

Menjana imej secara automatik untuk membina set data baharu; model asas yang lebih berkuasa yang dipralatih untuk kerjasama dengan model (Chat-)GPT; ) dan menjana imej baharu.

Pengenalan kepada pengarang

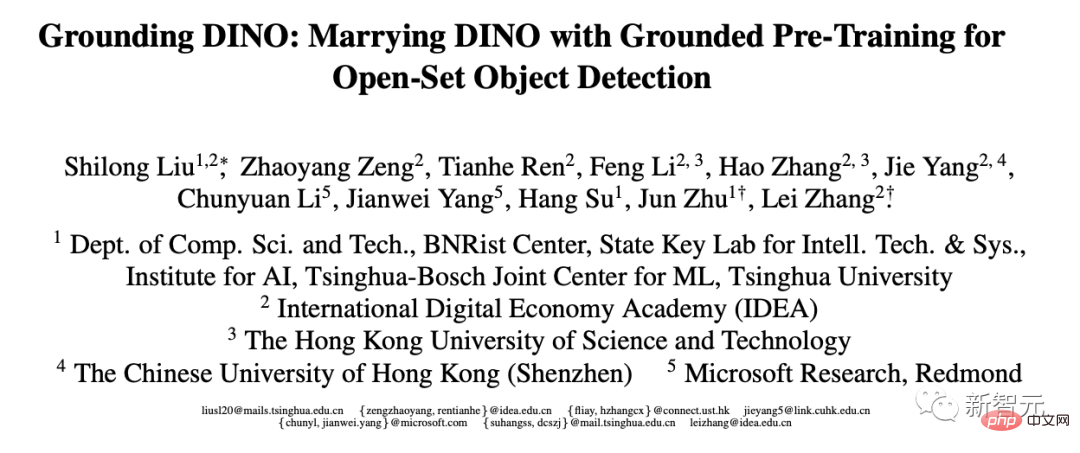

Salah seorang penyelidik projek Grounded-SAM ialah Liu Shilong, pelajar kedoktoran tahun ketiga di Jabatan Sains Komputer di Tsinghua Universiti.

Dia baru-baru ini memperkenalkan projek terbaharu yang dia dan pasukannya telah buat di GitHub, dan berkata ia masih dipertingkatkan.

Kini, Liu Shilong adalah pelatih di Pusat Penyelidikan Visi Komputer dan Robotik di Guangdong-Hong Kong-Macao Greater Bay Area Institut Penyelidikan Ekonomi Digital (Institut Penyelidikan IDEA) , dibimbing oleh Profesor Zhang Lei Arah penyelidikannya termasuk pengesanan sasaran dan pembelajaran pelbagai mod.

Sebelum ini, beliau menerima ijazah sarjana muda dalam Kejuruteraan Industri dari Universiti Tsinghua pada 2020 dan telah menjalani latihan di Megvii untuk tempoh masa pada 2019.

Laman utama peribadi: http://www.lsl.zone/

By the way, Liu Shilong Ia juga merupakan karya model pengesanan sasaran Grounding DINO yang dikeluarkan pada Mac tahun ini.

Selain itu, 4 kertas kerja beliau telah diterima oleh CVPR 2023, 2 kertas telah diterima oleh ICLR 2023, dan 1 kertas telah diterima oleh AAI 2023.

Alamat kertas: https://arxiv.org/pdf/2303.05499.pdf

Bos besar Liu Shilong menyebut, Ren Tianhe, kini bekerja sebagai jurutera algoritma penglihatan komputer di Institut Penyelidikan IDEA. Beliau juga dibimbing oleh Profesor Zhang Lei.

Selain itu, rakan usaha sama projek itu termasuk Li Kunchang, pelajar kedoktoran tahun ketiga di Universiti Akademi Sains China, yang hala tuju penyelidikan utamanya adalah pemahaman video dan pembelajaran pelbagai mod ;

Ren Tianhe, Liu Shilong

Pasang dan jalankan

Projek ini memerlukan pemasangan python 3.8 dan ke atas, pytorch 1.7 dan ke atas dan torchvision 0.8 ke atas. Di samping itu, penulis amat mengesyorkan memasang PyTorch dan TorchVision yang menyokong CUDA.

Pasang Segmen Apa-apa sahaja:

python -m pip install -e segment_anything

Pasang GroundingDINO:

python -m pip install -e GroundingDINO

Pasang peresap:

pip install --upgrade diffusers[torch]

Pasang kebergantungan pilihan yang diperlukan untuk pemprosesan pasca topeng, menyimpan topeng dalam format COCO, contoh buku nota dan mengeksport model dalam format ONNX. Pada masa yang sama, projek itu juga memerlukan jupyter untuk menjalankan buku nota contoh.

pip install opencv-python pycocotools matplotlib onnxruntime onnx ipykernel

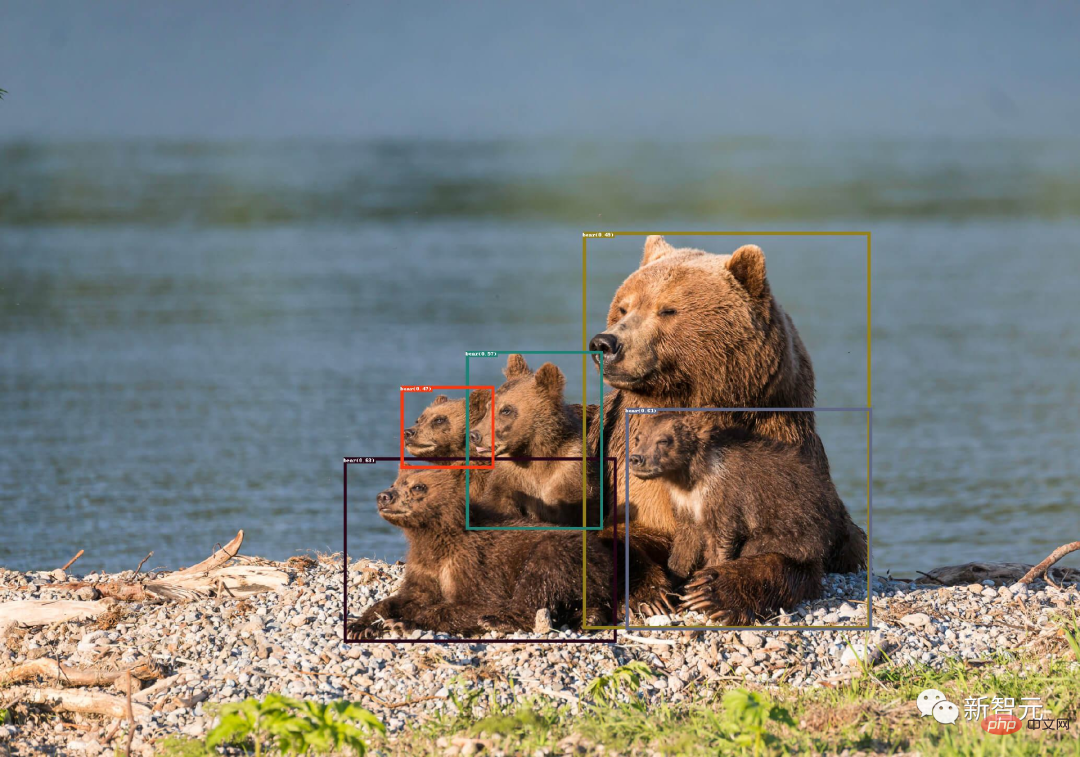

Grounding DINO Demo

Muat turun groundingdino checkpoint:

cd Grounded-Segment-Anything wget https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth

Run demo:

export CUDA_VISIBLE_DEVICES=0 python grounding_dino_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --input_image assets/demo1.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --text_prompt "bear" --device "cuda"

Visualisasi ramalan model akan disimpan dalam output_dir seperti berikut:

Ground-Segment-Anything+BLIP Demonstrasi

Menjana pseudo-label secara automatik adalah mudah:

1 ) untuk menghasilkan label.

2. Ekstrak tag daripada anotasi dan gunakan ChatGPT untuk memproses ayat yang mungkin kompleks.

3. Gunakan Grounded-Segment-Anything untuk menjana kotak dan topeng.

export CUDA_VISIBLE_DEVICES=0 python automatic_label_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/demo3.jpg --output_dir "outputs" --openai_key your_openai_key --box_threshold 0.25 --text_threshold 0.2 --iou_threshold 0.5 --device "cuda"

伪标签和模型预测可视化将保存在output_dir中,如下所示:

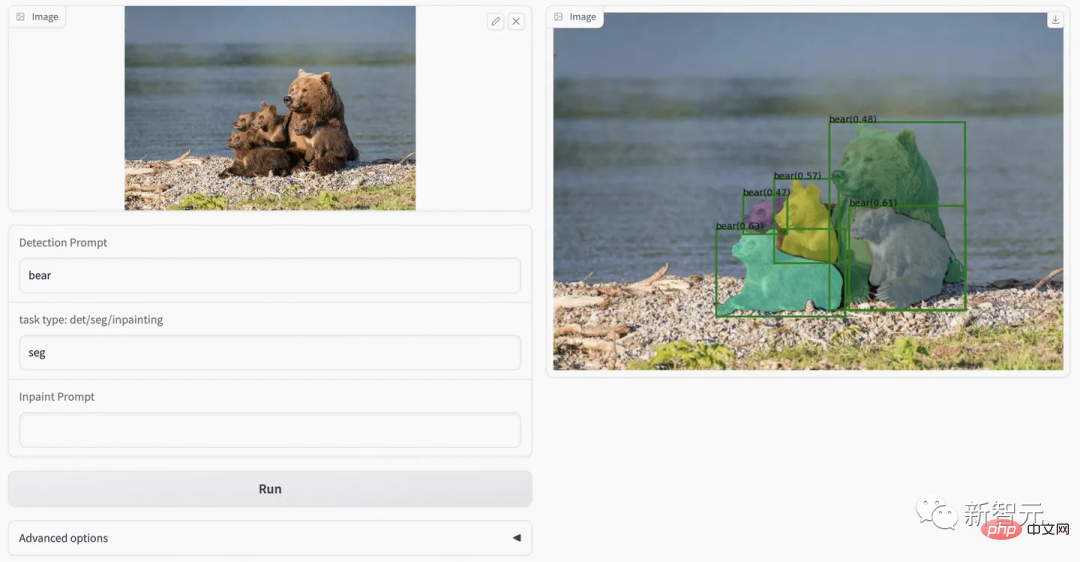

Grounded-Segment-Anything+Inpainting演示

CUDA_VISIBLE_DEVICES=0 python grounded_sam_inpainting_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/inpaint_demo.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --det_prompt "bench" --inpaint_prompt "A sofa, high quality, detailed" --device "cuda"

Grounded-Segment-Anything+Inpainting Gradio APP

python gradio_app.py

作者在此提供了可视化网页,可以更方便的尝试各种例子。

网友评论

对于这个项目logo,还有个深层的含义:

一只坐在地上的马赛克风格的熊。坐在地面上是因为ground有地面的含义,然后分割后的Versi Meta Divide Everything yang sangat berkembang telah ada di sini! IDEA mengetuai pasukan domestik teratas untuk mencipta: mengesan, membahagikan dan menjana segala-galanya serta meraih 2k bintang可以认为是一种马赛克风格,而且马塞克谐音mask,之所以用熊作为logo主体,是因为作者主要示例的Versi Meta Divide Everything yang sangat berkembang telah ada di sini! IDEA mengetuai pasukan domestik teratas untuk mencipta: mengesan, membahagikan dan menjana segala-galanya serta meraih 2k bintang是熊。

看到Grounded-SAM后,网友表示,知道要来,但没想到来的这么快。

项目作者任天和称,「我们用的Zero-Shot检测器是目前来说最好的。」

未来,还会有web demo上线。

最后,作者表示,这个项目未来还可以基于生成模型做更多的拓展应用,例如多领域精细化编辑、高质量可信的数据工厂的构建等等。欢迎各个领域的人多多参与。

Atas ialah kandungan terperinci Versi Meta 'Divide Everything' yang sangat berkembang telah ada di sini! IDEA mengetuai pasukan domestik teratas untuk mencipta: mengesan, membahagikan dan menjana segala-galanya serta meraih 2k bintang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI