Rumah >Peranti teknologi >AI >AI secara automatik menjana gesaan yang setanding dengan manusia: Jurutera baru sahaja diambil bekerja dan akan disingkirkan lagi.

AI secara automatik menjana gesaan yang setanding dengan manusia: Jurutera baru sahaja diambil bekerja dan akan disingkirkan lagi.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 22:40:011626semak imbas

Pada peringkat ini, terima kasih kepada pengembangan skala model dan kemunculan seni bina berasaskan perhatian, model bahasa telah menunjukkan fleksibiliti yang tidak pernah berlaku sebelum ini. Model bahasa besar (LLM) ini telah menunjukkan keupayaan luar biasa dalam pelbagai tugas yang berbeza, termasuk tetapan sifar syot dan beberapa syot.

Walau bagaimanapun, berdasarkan kepelbagaian model, persoalan kawalan timbul: Bagaimanakah kita boleh membuat LLM melakukan apa yang kita perlukan?

Untuk menjawab soalan ini dan membimbing LLM ke arah tingkah laku yang kita inginkan, penyelidik telah mengambil beberapa siri langkah untuk mencapai matlamat ini, seperti memperhalusi model, menggunakan konteks Pembelajaran, pelbagai bentuk penjanaan segera, dsb. Kaedah berasaskan segera termasuk gesaan lembut yang diperhalusi dan kejuruteraan segera bahasa semula jadi. Ramai penyelidik telah menunjukkan minat yang besar terhadap yang kedua kerana ia menyediakan antara muka interaktif semula jadi untuk manusia berinteraksi dengan mesin.

Walau bagaimanapun, gesaan mudah tidak selalu menghasilkan hasil yang diingini, contohnya, apabila menghasilkan imej panda, menambah kata sifat seperti "comel" atau "makan buluh" Kami tidak tahu apakah kesan frasa seperti ini pada output.

Oleh itu, pengguna manusia mesti mencuba pelbagai gesaan untuk membimbing model melalui tingkah laku yang kita inginkan. Pelaksanaan LLM boleh dianggap sebagai proses kotak hitam: walaupun mereka boleh melaksanakan pelbagai program bahasa semula jadi, program ini mungkin diproses dengan cara yang tidak intuitif kepada manusia, sangat sukar untuk difahami dan hanya boleh digunakan. semasa menjalankan tugas hiliran. Ukur kualiti pengajaran.

Kami tidak boleh tidak bertanya: Bolehkah model bahasa besar menulis gesaan untuk diri mereka sendiri? Jawapannya, bukan sahaja boleh, malah boleh sampai ke peringkat manusia .

Untuk mengurangkan beban kerja manual mencipta dan mengesahkan arahan yang sah, penyelidik dari University of Toronto, University of Waterloo dan institusi lain mencadangkan algoritma baharu yang menggunakan LLM untuk menjana dan pilih arahan: APE (Automatic Prompt Engineer). Mereka menggambarkan masalah ini sebagai sintesis program bahasa semula jadi dan mencadangkan untuk menganggapnya sebagai masalah pengoptimuman kotak hitam di mana LLM boleh digunakan untuk menjana serta mencari penyelesaian calon yang boleh dilaksanakan.

- Alamat kertas: https://arxiv.org/pdf/2211.01910.pdf

- Halaman utama kertas: https://sites.google.com/view/automatic-prompt-engineer

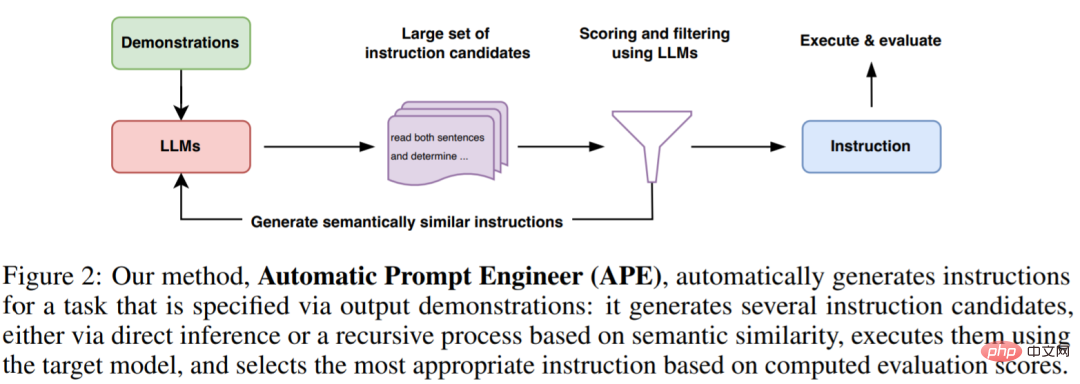

Penyelidik bermula daripada tiga ciri LLM. Pertama, LLM digunakan sebagai model inferens untuk menjana calon arahan berdasarkan satu set kecil demonstrasi pasangan input-output borang. Seterusnya, skor dikira melalui setiap arahan di bawah LLM untuk membimbing proses carian. Akhir sekali, mereka mencadangkan kaedah carian Monte Carlo berulang di mana LLM menambah baik arahan calon terbaik dengan mencadangkan varian arahan yang serupa secara semantik.

Secara intuitif, algoritma yang dicadangkan dalam kertas ini memerlukan LLM menjana satu set calon arahan berdasarkan demonstrasi, dan kemudian meminta algoritma menilai arahan yang lebih menjanjikan dan algoritma dinamakan APE.

Sumbangan artikel ini adalah seperti berikut:

- Pengkaji mensintesis penjanaan pengajaran sebagai program bahasa semula jadi dan menyatakannya sebagai masalah pengoptimuman kotak hitam Berpandu LLM, dan kaedah carian Monte Carlo berulang dicadangkan untuk menganggarkan penyelesaiannya; 19/24 tugas atau prestasi yang setara.

- Melihat kajian ini, netizen tidak dapat mengeluh: Jurutera segera yang baru diupah itu mungkin disingkirkan oleh AI dalam beberapa bulan. Implikasinya ialah penyelidikan ini akan menghilangkan kerja jurutera segera manusia.

"Kajian ini cuba sedaya upaya untuk mengautomasikan kejuruteraan segera supaya penyelidik yang terlibat dalam ML boleh kembali kepada keadaan sebenar ialah masalah algoritma (dengan dua emotikon menangis dilampirkan) 》

"Kajian ini cuba sedaya upaya untuk mengautomasikan kejuruteraan segera supaya penyelidik yang terlibat dalam ML boleh kembali kepada keadaan sebenar ialah masalah algoritma (dengan dua emotikon menangis dilampirkan) 》

Sesetengah orang mengeluh: LLM sememangnya tunjang utama AGI asal.

Menggunakan LLM untuk sintesis program bahasa semula jadi

APE berguna dalam kedua-dua cadangan dan pemarkahan LLM adalah digunakan dalam setiap komponen utama.

Seperti yang ditunjukkan dalam Rajah 2 dan Algoritma 1 di bawah, APE mula-mula mencadangkan beberapa gesaan calon, kemudian menapis/memurnikan set calon mengikut fungsi pemarkahan yang dipilih, dan akhirnya memilih arahan dengan markah tertinggi.

Rajah berikut menunjukkan proses pelaksanaan APE. Ia boleh menjana beberapa gesaan calon melalui inferens langsung atau proses rekursif berdasarkan persamaan semantik, menilai prestasi mereka dan secara berulang mencadangkan gesaan baharu.

Pengagihan cadangan awal

Memandangkan ruang carian tidak terhingga, didapati Arahan yang betul adalah amat sukar, menjadikan sintesis program bahasa semula jadi sukar dikawal. Berdasarkan ini, penyelidik mempertimbangkan untuk menggunakan LLM terlatih untuk mencadangkan penyelesaian calon untuk membimbing proses carian.

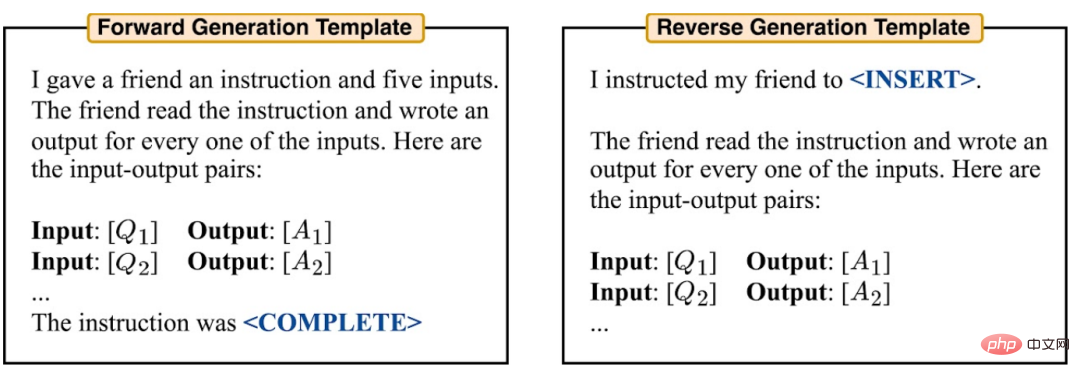

Mereka mempertimbangkan dua kaedah untuk menjana calon berkualiti tinggi. Pertama, kaedah berdasarkan penjanaan corak hadapan diguna pakai. Selain itu, mereka juga mempertimbangkan penjanaan corak terbalik, menggunakan LLM dengan keupayaan pelapik (cth., T5, GLM, InsertGPT) untuk membuat kesimpulan arahan yang tiada.

Fungsi skor

Untuk menyelesaikan masalah Menukar kepada masalah pengoptimuman kotak hitam, penyelidik memilih fungsi pemarkahan untuk mengukur penjajaran antara set data dan data yang dihasilkan oleh model dengan tepat.

Dalam eksperimen induksi, penyelidik mempertimbangkan dua fungsi pemarkahan yang berpotensi. Dalam percubaan TruthfulQA, penyelidik memfokuskan terutamanya pada metrik automasi yang dicadangkan oleh Lin et al., serupa dengan ketepatan pelaksanaan.

Dalam setiap kes, penyelidik menggunakan formula berikut (1) untuk menilai kualiti arahan dan jangkaan yang dihasilkan untuk memegang set data ujian Dtest.

Eksperimen

Para penyelidik mengkaji cara APE membimbing LLM untuk mencapai tingkah laku yang diingini. Mereka meneruskan dari tiga perspektif: prestasi sifar pukulan, prestasi pembelajaran konteks beberapa pukulan dan ketulenan (kejujuran).

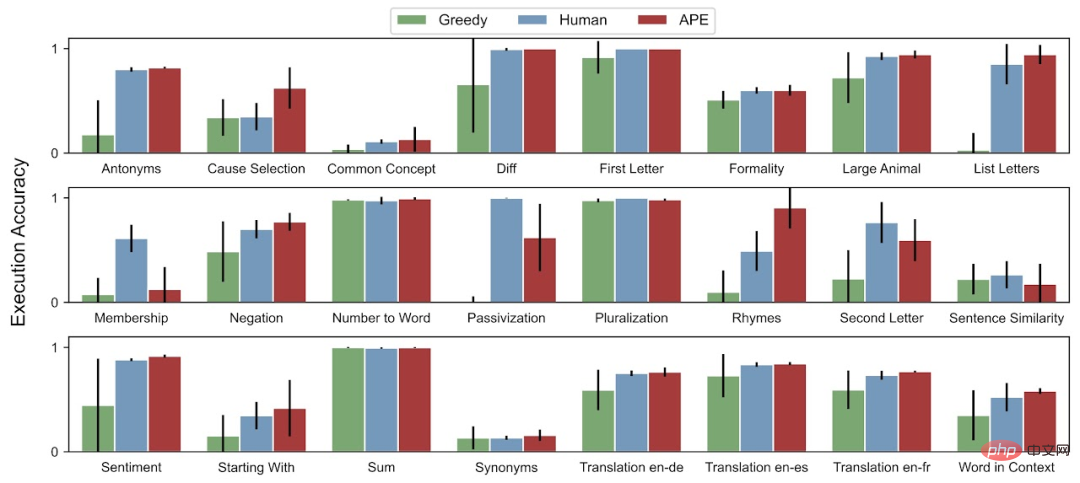

Kami menilai pembelajaran konteks sifar pukulan dan beberapa pukulan pada 24 tugasan induksi arahan yang dicadangkan oleh Honovich et al. Tugasan ini merangkumi banyak aspek pemahaman bahasa, daripada struktur frasa mudah kepada pengecaman persamaan dan sebab akibat. Untuk memahami cara arahan yang dijana oleh APE membimbing LLM untuk menjana gaya jawapan yang berbeza, kertas kerja ini menggunakan APE pada TruthfulQA, set data.

Untuk ketepatan ujian sifar pukulan, APE mencapai prestasi peringkat manusia pada 19 daripada 24 tugasan.

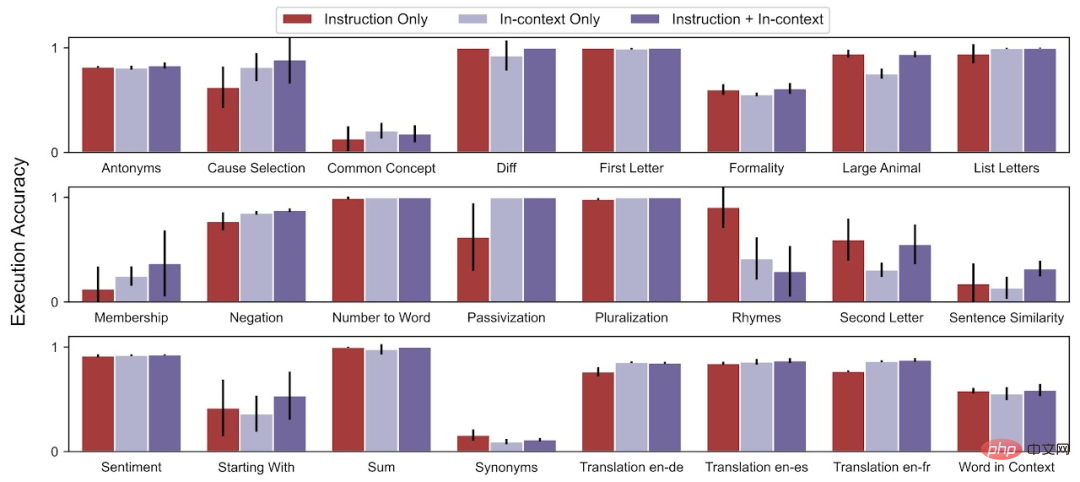

Untuk ketepatan ujian konteks beberapa pukulan, APE meningkatkan prestasi pembelajaran konteks beberapa pukulan pada 21 daripada 24 tugasan.

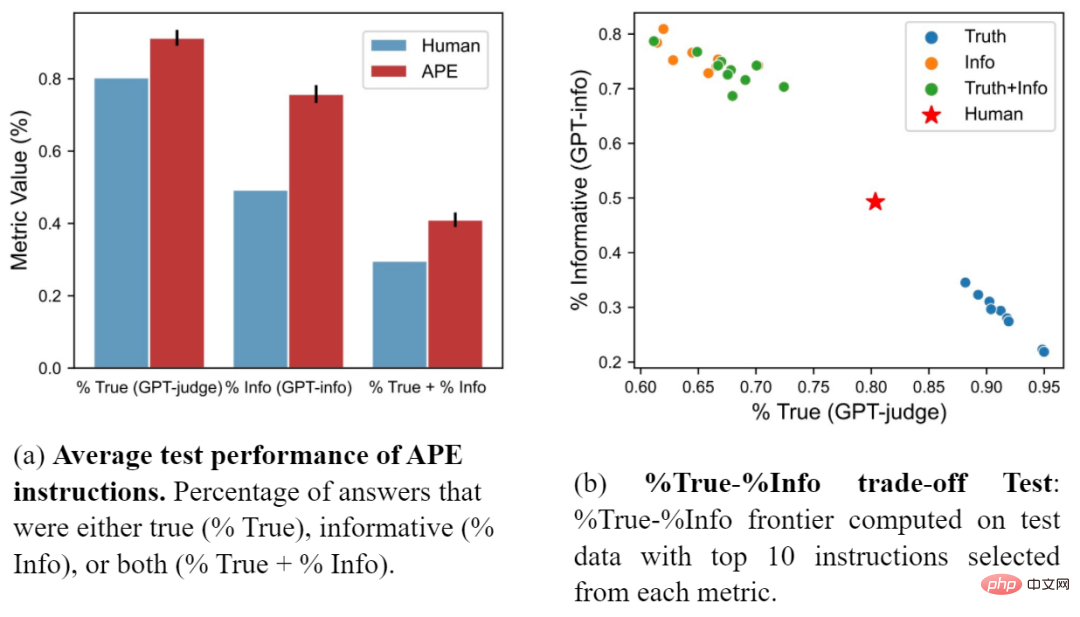

Para penyelidik juga membandingkan gesaan APE dengan gesaan buatan yang dicadangkan oleh Lin et al. Rajah (a) menunjukkan bahawa arahan APE mengatasi gesaan manusia pada ketiga-tiga metrik. Rajah (b) menunjukkan pertukaran antara kebenaran dan bermaklumat.

Sila rujuk kertas asal untuk butiran lanjut.

Atas ialah kandungan terperinci AI secara automatik menjana gesaan yang setanding dengan manusia: Jurutera baru sahaja diambil bekerja dan akan disingkirkan lagi.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI