Rumah >Peranti teknologi >AI >Penyebaran + pengesanan sasaran = penjanaan imej yang boleh dikawal! Pasukan China mencadangkan GLIGEN untuk mengawal kedudukan spatial objek dengan sempurna

Penyebaran + pengesanan sasaran = penjanaan imej yang boleh dikawal! Pasukan China mencadangkan GLIGEN untuk mengawal kedudukan spatial objek dengan sempurna

- 王林ke hadapan

- 2023-04-12 21:25:05916semak imbas

Dengan sumber terbuka Stable Diffusion, penggunaan bahasa semula jadi untuk penjanaan imej secara beransur-ansur menjadi popular Banyak masalah AIGC juga telah terdedah, seperti AI tidak boleh menarik tangan, tidak dapat memahami hubungan tindakan dan sukar untuk mengawal kedudukan objek menunggu.

Sebab utama ialah "antara muka input" hanya mempunyai bahasa semula jadi, tidak dapat mencapai kawalan skrin yang baik.

Baru-baru ini, kawasan tumpuan penyelidikan dari University of Wisconsin-Madison, Columbia University dan Microsoft telah mencadangkan kaedah baharu GLIGEN, yang menggunakan input pembumian sebagai syarat untuk menambah baik "pra- teks terlatih kepada imej" Kefungsian Model Resapan telah diperluaskan.

Pautan kertas: https://arxiv.org/pdf/2301.07093.pdf

Laman utama projek: https://gligen.github.io/

Pautan pengalaman: https: //huggingface.co/spaces/gligen/demo

Untuk mengekalkan sejumlah besar pengetahuan konseptual model pra-latihan, para penyelidik tidak memilih untuk mendenda -tala model, tetapi melalui gating Mekanisme menyuntik keadaan pembumian input yang berbeza ke dalam lapisan baharu yang boleh dilatih untuk mencapai kawalan ke atas penjanaan imej dunia terbuka.

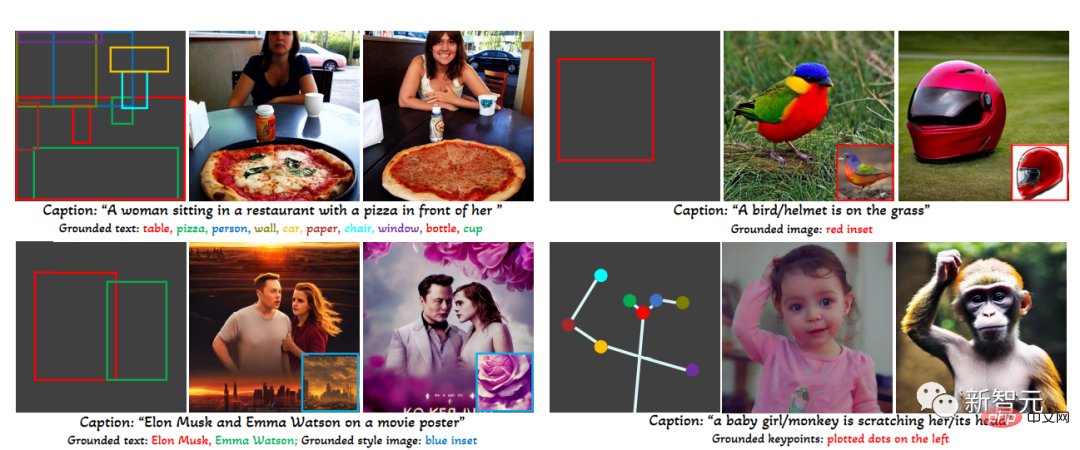

Pada masa ini GLIGEN menyokong empat input.

(kiri atas) teks entiti+kotak (kanan atas) imej entiti+kotak

(kiri bawah) gaya imej + teks + kotak (kanan bawah) entiti teks + titik utama

Percubaan keputusan juga menunjukkan, prestasi tangkapan sifar GLIGEN pada COCO dan LVIS adalah jauh lebih baik daripada garis dasar reka letak-ke-imej yang diselia semasa.

Penjanaan imej yang boleh dikawal

Sebelum model penyebaran, rangkaian musuh generatif (GAN) sentiasa menjadi peneraju dalam bidang penjanaan imej, dan ruang terpendam dan bersyaratnya input berada dalam " Aspek "operasi terkawal" dan "penjanaan" telah dikaji sepenuhnya.

Model autoregresif dan resapan bersyarat teks menunjukkan kualiti imej dan liputan konsep yang menakjubkan, terima kasih kepada objektif pembelajaran yang lebih stabil dan data berpasangan imej-teks berskala besar Berlatih dan cepat keluar dari bulatan, menjadi alat untuk membantu reka bentuk dan penciptaan seni.

Walau bagaimanapun, model penjanaan imej teks berskala besar sedia ada tidak boleh dikondisikan pada mod input lain "selain teks" dan tidak mempunyai konsep kedudukan yang tepat atau penggunaan imej rujukan untuk mengawal proses penjanaan Kebolehan menghadkan penyampaian maklumat.

Sebagai contoh, sukar untuk menerangkan lokasi tepat objek menggunakan teks dan kotak sempadan (kotak sempadan

) atau titik kekunci (titik utama) ) boleh dilaksanakan dengan mudah.

Sesetengah alatan sedia ada seperti inpainting, layout2img generation, dsb. boleh menggunakan input modal selain daripada teks, tetapi mereka Ini input jarang digabungkan untuk penjanaan text2img terkawal.

Di samping itu, model generatif sebelumnya biasanya dilatih secara bebas pada set data khusus tugas, manakala dalam bidang pengecaman imej, paradigma yang telah lama wujud adalah untuk belajar daripada "imej berskala besar data" Atau model asas pra-latihan pada "pasangan teks imej" untuk mula membina model untuk tugasan tertentu.

Model resapan telah dilatih pada berbilion pasangan teks imej, dan persoalan biasa ialah: bolehkah kita membina model resapan sedia ada, memberi mereka mod input bersyarat baharu? ?

Disebabkan oleh jumlah besar pengetahuan konsep yang dimiliki oleh model pra-latihan, adalah mungkin untuk mencapai prestasi yang lebih baik pada tugas penjanaan lain sambil memperoleh lebih banyak data daripada penjanaan imej teks sedia ada model.

GLIGEN

Berdasarkan tujuan dan idea di atas, model GLIGEN yang dicadangkan oleh penyelidik masih mengekalkan tajuk teks sebagai input, tetapi juga membolehkan modaliti input lain, seperti sebagai konsep pembumian Kotak pembatas, imej rujukan pembumian dan titik utama bahagian pembumian.

Masalah utama di sini adalah untuk mengekalkan sejumlah besar pengetahuan konseptual asal dalam model pra-latihan sambil belajar menyuntik maklumat asas baharu.

Untuk mengelakkan lupa pengetahuan, para penyelidik mencadangkan pembekuan model asal dan menambah lapisan Transformer berpagar baharu untuk menyerap input pengikatan baharu Yang berikut menggunakan kotak sempadan sebagai contoh.

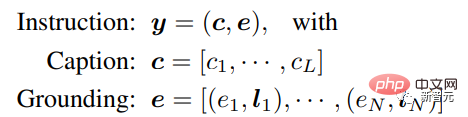

Input arahan

Setiap entiti teks penggredan diwakili sebagai kotak sempadan yang mengandungi nilai koordinat penjuru kiri atas dan kanan bawah.

Perlu diambil perhatian bahawa kerja berkaitan susun atur2img sedia ada biasanya memerlukan kamus konsep dan hanya boleh mengendalikan entiti set rapat (seperti kategori COCO) semasa fasa penilaian pengekod pengekodan perihalan imej boleh menyamaratakan maklumat lokasi dalam set latihan kepada konsep lain.

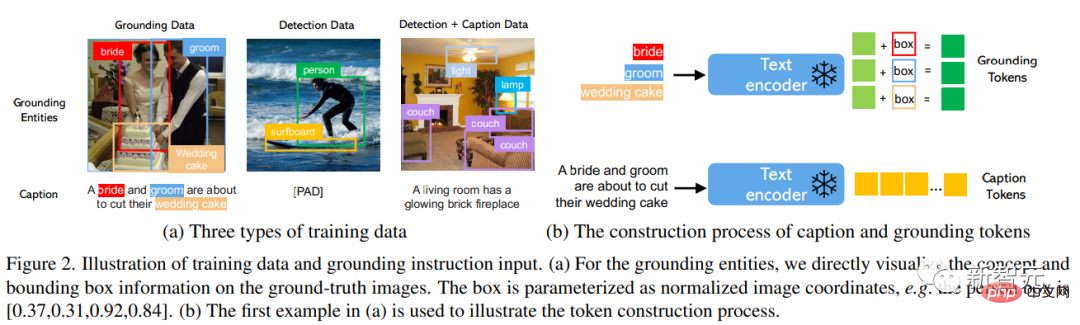

Data latihan

digunakan untuk menjana pembumian imej Data latihan memerlukan teks c dan entiti asas e sebagai syarat Dalam amalan, keperluan data boleh dilonggarkan dengan mempertimbangkan input yang lebih fleksibel.

Terdapat terutamanya tiga jenis data

1 . Data pembumian

Setiap imej dikaitkan dengan kapsyen yang menerangkan keseluruhan imej entiti kata nama diekstrak daripada kapsyen dan dilabelkan dengan kotak sempadan.

Memandangkan entiti kata nama diambil terus daripada tajuk bahasa semula jadi, ia boleh merangkumi perbendaharaan kata yang lebih kaya, yang bermanfaat kepada generasi asas perbendaharaan kata dunia terbuka.

2. Data pengesanan 80 kategori objek), pilih untuk menggunakan token tajuk kosong dalam panduan bebas pengelas sebagai tajuk.

Jumlah data pengesanan (berjuta-juta tahap) adalah lebih besar daripada data asas (ribuan tahap), jadi keseluruhan data latihan boleh ditingkatkan dengan banyak.

3. Data Pengesanan dan Kapsyen

Entiti kata nama adalah sama dengan entiti kata nama dalam data pengesanan , dan imej diterangkan dengan tajuk teks sahaja, mungkin terdapat kes di mana entiti kata nama tidak konsisten sepenuhnya dengan entiti dalam tajuk.

Sebagai contoh, tajuk hanya memberikan penerangan aras tinggi tentang ruang tamu dan tidak menyebut objek di tempat kejadian, manakala anotasi pengesanan memberikan butiran peringkat objek yang lebih halus.

Mekanisme perhatian berpagar

Penyelidik Matlamatnya ialah untuk memberikan model penjanaan imej bahasa berskala besar yang sedia ada keupayaan berasaskan ruang baharu

Model penyebaran berskala besar telah dilatih terlebih dahulu pada teks imej berskala rangkaian untuk mendapatkan pengetahuan yang diperlukan. untuk mensintesis imej realistik berdasarkan arahan bahasa yang pelbagai dan kompleks Memandangkan pra-latihan adalah mahal dan berprestasi baik, adalah penting untuk mengekalkan pengetahuan ini dalam pemberat model sambil mengembangkan keupayaan baharu Ini boleh dicapai dengan menyesuaikan modul baharu untuk menampung keupayaan baharu lama kelamaan.

Semasa proses latihan, mekanisme gating digunakan untuk menyepadukan maklumat asas baharu secara beransur-ansur ke dalam model pra-latihan. Reka bentuk ini membolehkan fleksibiliti dalam proses pensampelan semasa penjanaan untuk meningkatkan kualiti dan kebolehkawalan.

Ia juga telah dibuktikan dalam eksperimen bahawa menggunakan model lengkap (semua lapisan) pada separuh pertama langkah pensampelan dan hanya lapisan asal (tiada lapisan Transformer berpagar) dalam separuh masa kedua, menjana Hasilnya boleh mencerminkan keadaan pembumian dengan lebih tepat dan mempunyai kualiti imej yang lebih tinggi.

Bahagian percubaan

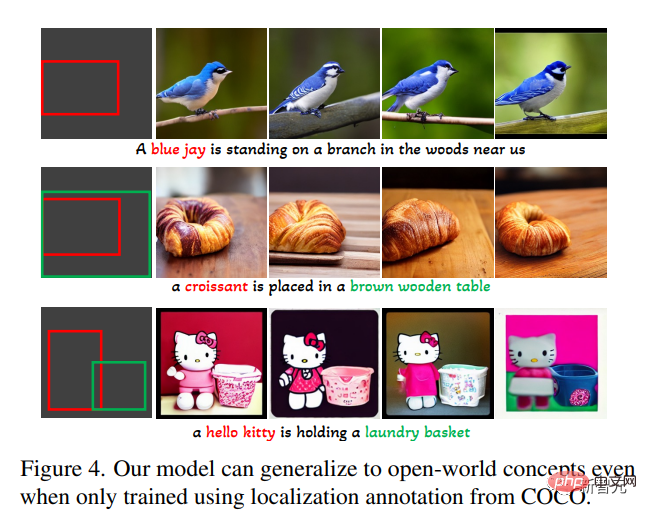

Dalam set terbuka teks asas kepada tugas penjanaan imej, mula-mula gunakan hanya anotasi asas COCO (COCO2014CD) untuk latihan dan menilai sama ada GLIGEN boleh menjana entiti asas selain daripada kategori COCO.

Seperti yang anda lihat, GLIGEN boleh mempelajari konsep baharu seperti "blue jay", "croissant", atau baharu Atribut objek seperti "meja kayu coklat", dan maklumat ini tidak muncul dalam kategori latihan.

Penyelidik percaya ini adalah kerana perhatian diri berpagar GLIGEN belajar untuk meletakkan semula ciri visual yang sepadan dengan entiti asas dalam tajuk untuk lapisan perhatian silang berikut, dan keupayaan Generalisasi diperoleh kerana ruang teks kongsi dalam dua lapisan ini.

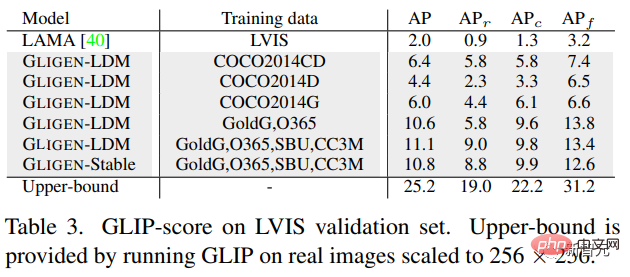

Percubaan juga menilai secara kuantitatif prestasi penjanaan sifar tangkapan model ini pada LVIS, yang mengandungi 1203 kategori objek ekor panjang. Gunakan GLIP untuk meramalkan kotak sempadan daripada imej yang dijana dan mengira AP, dinamakan skor GLIP; bandingkan dengan model terkini yang direka untuk tugasan susun atur2img,

Secara keseluruhannya, kertas ini:

Secara keseluruhannya, kertas ini:

Cadangan kaedah penjanaan text2img baharu

, memberikan model penyebaran text2img yang sedia ada kebolehkawalan pembumian baharu, model itu menyedari. penjanaan text2img berasaskan dunia terbuka dan input kotak sempadan, iaitu, ia menyepadukan konsep kedudukan baharu yang tidak diperhatikan dalam latihan3. Prestasi sifar tangkapan model ini pada tugasan susun atur2img; adalah jauh lebih baik daripada tahap tercanggih sebelum ini, membuktikan bahawa model generatif pra-latihan berskala besar boleh meningkatkan prestasi tugasan hiliran

Atas ialah kandungan terperinci Penyebaran + pengesanan sasaran = penjanaan imej yang boleh dikawal! Pasukan China mencadangkan GLIGEN untuk mengawal kedudukan spatial objek dengan sempurna. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI