Rumah >Peranti teknologi >AI >Bagaimana untuk menjadikan AI mempunyai keupayaan sejagat? Kajian baharu: Tidurkan

Bagaimana untuk menjadikan AI mempunyai keupayaan sejagat? Kajian baharu: Tidurkan

- 王林ke hadapan

- 2023-04-12 21:19:041477semak imbas

Rangkaian saraf boleh mengatasi manusia dalam banyak tugas, tetapi jika anda meminta sistem AI untuk menyerap ingatan baharu, mereka mungkin lupa serta-merta apa yang telah mereka pelajari sebelum ini. Kini, satu kajian baharu mendedahkan cara baharu untuk rangkaian saraf bergerak melalui peringkat tidur dan membantu mencegah amnesia ini.

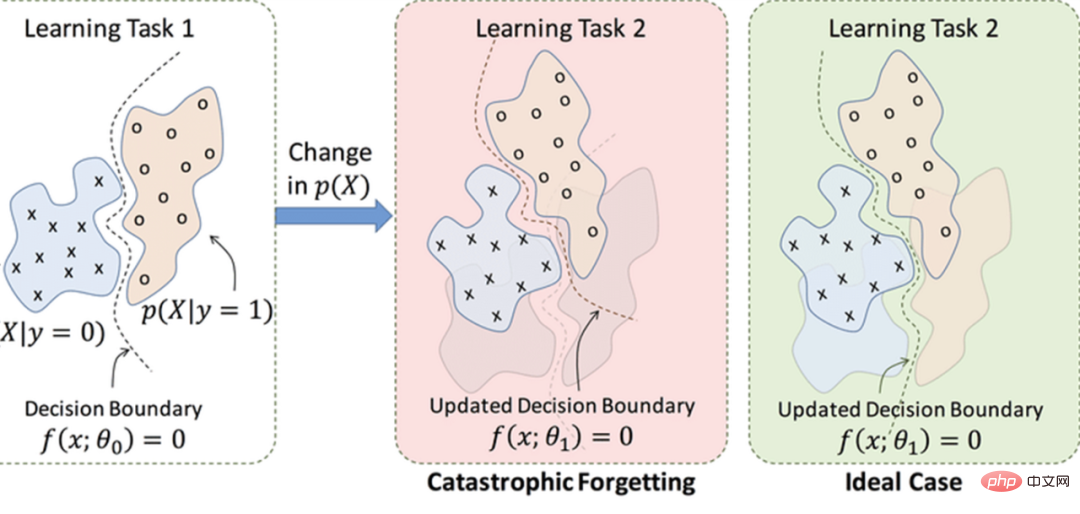

Cabaran utama yang dihadapi oleh rangkaian saraf tiruan ialah "pelupaan bencana". Apabila mereka pergi untuk mempelajari tugas baru, mereka mempunyai kecenderungan yang malang untuk tiba-tiba lupa sepenuhnya apa yang telah mereka pelajari sebelum ini.

Pada asasnya, perwakilan data oleh rangkaian saraf ialah "mampatan" data berorientasikan tugas bagi data asal, dan pengetahuan yang baru dipelajari akan menimpa data lepas.

Ini adalah salah satu kelemahan terbesar teknologi semasa berbanding dengan rangkaian saraf manusia: sebaliknya, otak manusia mampu mempelajari tugas baharu sepanjang hayatnya; Tidak menjejaskan keupayaannya untuk melaksanakan tugas yang telah dihafal sebelumnya. Kami tidak tahu sepenuhnya mengapa, tetapi penyelidikan telah lama menunjukkan bahawa otak manusia belajar dengan baik apabila pusingan pembelajaran diselangi dengan tidur. Tidur nampaknya membantu menggabungkan pengalaman terkini ke dalam bank memori jangka panjang.

"Menyusun semula ingatan sebenarnya boleh menjadi salah satu sebab utama mengapa organisma perlu melalui peringkat tidur," kata Erik Delanois, ahli sains saraf pengiraan di University of California, San Diego.

Bolehkah AI juga belajar tidur? Beberapa penyelidikan terdahulu telah cuba menangani amnesia bencana dengan mempunyai AI mensimulasikan tidur. Sebagai contoh, apabila rangkaian saraf mempelajari tugas baharu, strategi yang dipanggil latihan berjalin secara serentak menyuapkan data lama mesin yang telah mereka pelajari sebelum ini untuk membantu mereka mengekalkan pengetahuan lepas. Pendekatan ini sebelum ini dianggap meniru cara otak berfungsi semasa tidur - sentiasa memainkan semula kenangan lama.

Walau bagaimanapun, saintis telah membuat hipotesis bahawa latihan berjalin memerlukan penyusunan rangkaian saraf semua data yang asalnya digunakan untuk mempelajari kemahiran lama setiap kali ia ingin mempelajari sesuatu yang baharu. Ini bukan sahaja memerlukan banyak masa dan data, tetapi ia juga nampaknya bukan perkara yang dilakukan oleh otak biologi semasa tidur sebenar - organisma tidak mempunyai keupayaan untuk mengekalkan semua data yang diperlukan untuk mempelajari tugas lama, mahupun mereka mempunyai masa untuk memainkan semula semuanya semasa tidur.

Dalam kajian baharu, penyelidik menganalisis mekanisme di sebalik pelupaan bencana dan keberkesanan tidur dalam mencegah masalah. Para penyelidik tidak menggunakan rangkaian neural tradisional, tetapi menggunakan "rangkaian neural spiking" yang lebih dekat dengan otak manusia.

Dalam rangkaian saraf tiruan, komponen yang dipanggil neuron diberi data dan bekerjasama untuk menyelesaikan masalah, seperti mengenali wajah. Rangkaian saraf berulang kali mengubah suai sinapsnya—hubungan antara neuronnya—dan melihat sama ada corak tingkah laku yang terhasil lebih baik membawa kepada penyelesaian. Dari masa ke masa (latihan berterusan), rangkaian menemui corak yang terbaik untuk mengira hasil yang betul. Akhirnya ia menggunakan mod ini sebagai mod lalainya, yang dianggap sebahagiannya meniru proses pembelajaran otak manusia.

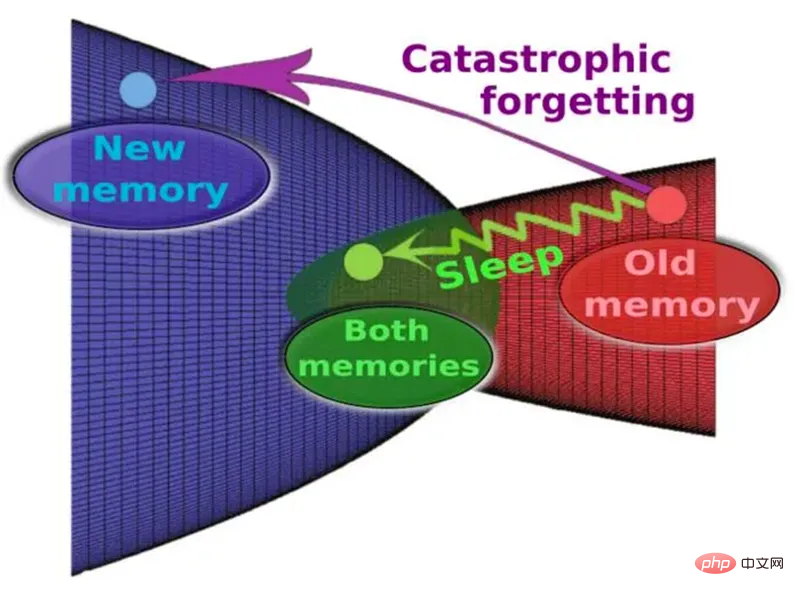

Rajah ini mewakili ingatan dalam ruang sinaptik abstrak dan evolusinya semasa dan tanpa tidur.

Dalam rangkaian neural buatan, output neuron berubah secara berterusan apabila input berubah. Sebaliknya, dalam rangkaian neural spiking (SNN), neuron menghasilkan isyarat keluaran hanya selepas bilangan isyarat input tertentu, satu proses yang merupakan pembiakan sebenar tingkah laku neuron biologi sebenar. Oleh kerana rangkaian neural spiking jarang mengeluarkan denyutan, ia menghantar kurang data daripada rangkaian neural tiruan biasa dan pada dasarnya memerlukan kurang kuasa dan jalur lebar komunikasi.

Seperti yang dijangkakan, rangkaian neural spiking mempunyai ciri sedemikian: pelupaan bencana berlaku semasa proses pembelajaran awal Walau bagaimanapun, selepas beberapa pusingan pembelajaran, selepas tempoh masa, set neuron yang terlibat dalam pembelajaran tugas pertama diaktifkan semula. Ini lebih dekat dengan apa yang difikirkan oleh ahli sains saraf tentang proses tidur.

Ringkasnya: SNN membolehkan jejak memori yang dipelajari sebelum ini diaktifkan semula secara automatik semasa tidur semasa pemprosesan luar talian dan untuk mengubah suai pemberat sinaptik tanpa gangguan.

Kajian ini menggunakan SNN berbilang lapisan dengan pembelajaran pengukuhan untuk meneroka sama ada pelupaan bencana boleh dielakkan dengan menyelangi tempoh latihan tugasan baharu dengan tempoh aktiviti autonomi seperti tidur. Terutama, kajian menunjukkan bahawa pelupaan bencana boleh dicegah dengan mengganggu pembelajaran pengukuhan secara berkala semasa tugasan baharu, sama seperti peringkat tidur.

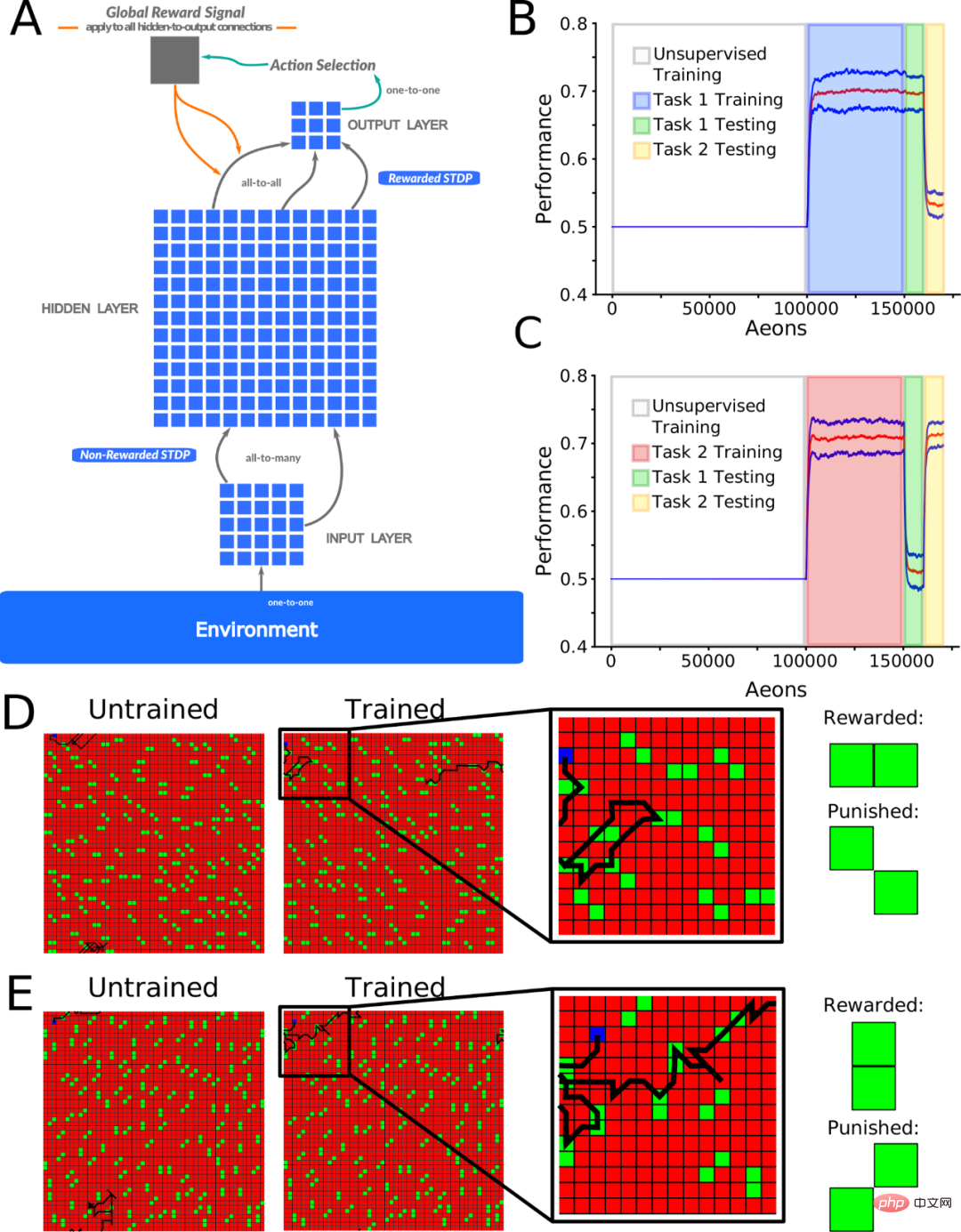

Rajah 1A menunjukkan rangkaian neural spiking suapan untuk mensimulasikan isyarat daripada input kepada output. Neuron yang terletak di antara lapisan input (I) dan lapisan tersembunyi (H) menjalani pembelajaran tanpa pengawasan (dilaksanakan menggunakan STDP tanpa ganjaran), dan neuron antara lapisan H dan lapisan output (O) menjalani pembelajaran tetulang (dilaksanakan menggunakan ganjaran. STDP).

Pembelajaran tanpa pengawasan membolehkan neuron lapisan tersembunyi mempelajari corak zarah yang berbeza dari lokasi spatial yang berbeza dalam lapisan input, manakala STDP ganjaran membolehkan neuron lapisan output belajar berdasarkan zarah yang dikesan dalam lapisan input. Keputusan gerakan untuk jenis corak zarah.

Para penyelidik melatih rangkaian dalam dua cara yang saling melengkapi. Dalam kedua-dua tugasan, rangkaian belajar membezakan antara pola zarah ganjaran dan hukuman, dengan matlamat untuk mendapatkan ganjaran sebanyak mungkin. Tugas itu mempertimbangkan kebolehdiskriminasian corak (nisbah ganjaran yang dibelanjakan kepada zarah penalti) sebagai ukuran prestasi dengan peluang 0.5. Semua keputusan yang dilaporkan adalah berdasarkan sekurang-kurangnya 10 percubaan dengan pengamulaan rangkaian rawak yang berbeza.

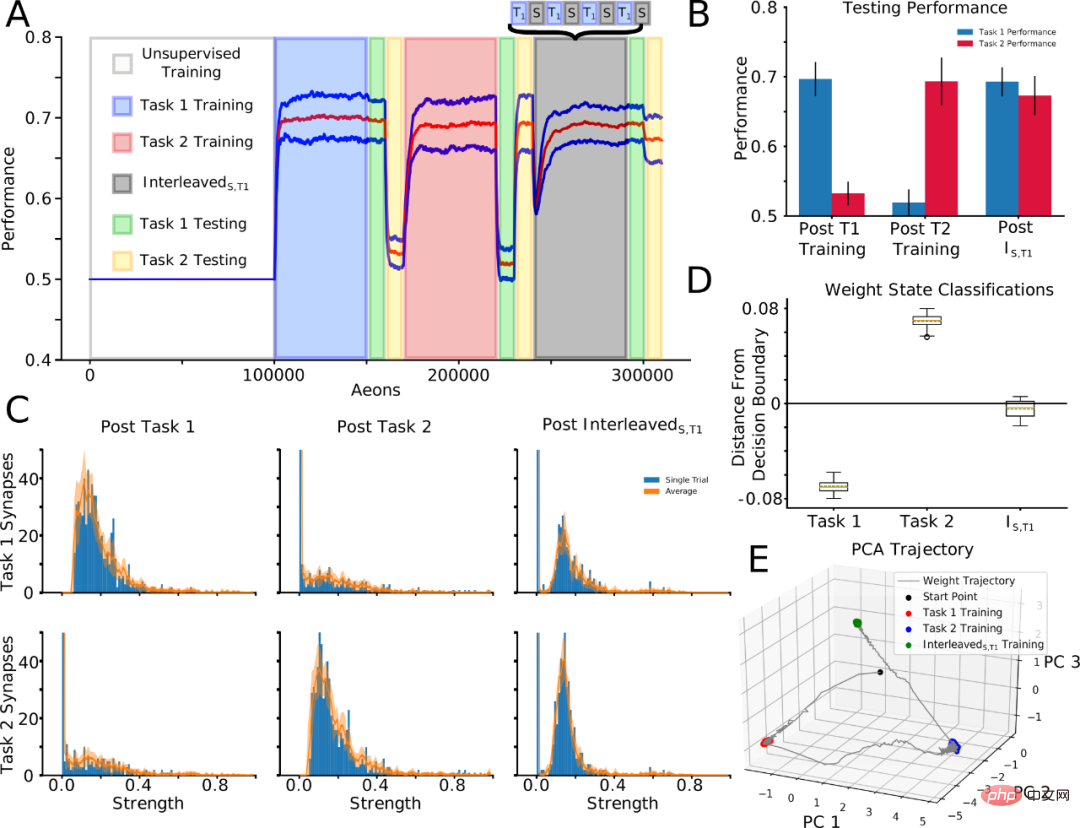

Untuk mendedahkan dinamik berat sinaptik semasa latihan dan tidur, penyelidik seterusnya menjejaki sinaps "berkaitan tugas", iaitu, dalam 10% pengedaran teratas selepas latihan pada tugas tertentu Sinaps yang dikenal pasti. Tugasan 1 dilatih dahulu, kemudian tugasan 2, dan sinaps berkaitan tugas dikenal pasti selepas setiap latihan tugasan. Seterusnya teruskan latihan tugasan 1 sekali lagi, tetapi selanginya dengan masa tidur (latihan selang seli): T1→T2→SelangiS,T1. Latihan berurutan Tugasan 1 - Tugasan 2 menyebabkan Tugasan 1 dilupakan, tetapi selepas InterleavedS, Tugasan 1 dipelajari semula dan Tugasan 2 juga dikekalkan (Rajah 4A dan 4B).

Yang penting, strategi ini membolehkan kami membandingkan pemberat sinaptik selepas latihan pada InterleavedS,T1 dengan pemberat sinaptik yang dikenal pasti sebagai berkaitan tugasan selepas latihan pada Tugasan 1 dan Tugasan 2 sahaja (Gamb. 4C) . Struktur pengedaran sinaps berkaitan Tugasan 1 yang terbentuk selepas latihan Tugasan 1 (Rajah 4C; kiri atas) telah terganggu selepas latihan Tugasan 2 (tengah atas) tetapi sebahagiannya dipulihkan selepas latihan InterleavedS, T1 (kanan atas). Struktur pengedaran sinaps berkaitan Tugasan 2 selepas latihan Tugasan 2 (tengah bawah) tiada selepas latihan Tugasan 1 (kiri bawah) dan sebahagiannya dikekalkan selepas latihan InterleavedS, T1 (kanan bawah).

Perlu diingat bahawa corak kualitatif ini boleh diperhatikan dengan jelas dalam satu percubaan (Rajah 4C; bar biru) dan juga boleh digeneralisasikan merentas ujian (Rajah 4C; Wayar oren). Oleh itu, tidur boleh mengekalkan sinaps penting sambil menggabungkan sinaps baharu.

Rajah 4. Tempoh selang latihan tugasan baharu dan tidur membolehkan penyepaduan maklumat sinaptik yang berkaitan dengan tugasan baharu sambil mengekalkan maklumat tugas lama.

"Menariknya, kami tidak menyimpan secara eksplisit data yang berkaitan dengan ingatan awal untuk memainkan semula secara buatan semasa tidur untuk mengelakkan lupa," kata pengarang bersama kajian itu, Said pengarang Pavel Sanda, ahli sains saraf pengiraan di Institut Sains Komputer Akademi Sains Czech.

Strategi baharu telah ditemui untuk membantu mencegah pelupaan bencana. Rangkaian saraf spiking dapat melaksanakan kedua-dua tugas selepas melalui peringkat seperti tidur, dan para penyelidik percaya strategi mereka membantu mengekalkan corak sinaptik yang dikaitkan dengan tugas lama dan baharu.

"Kerja kami menunjukkan kegunaan untuk membangunkan penyelesaian yang diilhamkan secara biologi," kata Delanois.

Para penyelidik mendapati bahawa penemuan mereka tidak terhad kepada rangkaian neural spiking. Sanda berkata kerja akan datang menunjukkan bahawa peringkat seperti tidur boleh membantu "mengatasi pelupaan bencana dalam rangkaian saraf tiruan standard."

Kajian itu diterbitkan pada 18 November dalam jurnal PLOS Computational Biology.

Kertas: "Tidur menghalang pelupaan bencana dalam rangkaian neural spiking dengan membentuk perwakilan berat sinaptik bersama"

Alamat kertas: https://journals.plos.org/ploscompbiol/article?id=10.1371/journal.pcbi.1010628

Atas ialah kandungan terperinci Bagaimana untuk menjadikan AI mempunyai keupayaan sejagat? Kajian baharu: Tidurkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI