Rumah >Peranti teknologi >AI >Dua perantis Li Feifei bersama-sama membimbing: Robot yang boleh memahami 'gesaan berbilang modal' boleh meningkatkan prestasi sifar pukulan sebanyak 2.9 kali

Dua perantis Li Feifei bersama-sama membimbing: Robot yang boleh memahami 'gesaan berbilang modal' boleh meningkatkan prestasi sifar pukulan sebanyak 2.9 kali

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 20:37:081352semak imbas

Peluang pembangunan seterusnya dalam bidang kecerdasan buatan mungkin untuk melengkapkan model AI dengan "badan" dan berinteraksi dengan dunia sebenar untuk belajar.

Berbanding dengan tugas sedia ada seperti pemprosesan bahasa semula jadi dan penglihatan komputer yang dilakukan dalam persekitaran tertentu, teknologi robotik di padang terbuka jelas lebih Bencana .

Sebagai contoh, pembelajaran berasaskan segera boleh membenarkan model bahasa tunggal untuk melaksanakan sebarang tugas pemprosesan bahasa semula jadi, seperti menulis kod, membuat abstrak, dan menjawab soalan, hanya dengan mengubah suai gesaan.

Tetapi terdapat lebih banyak jenis spesifikasi tugasan dalam robotik, seperti meniru satu contoh demonstrasi, mengikuti arahan bahasa atau mencapai matlamat visual tertentu, yang biasanya dianggap Tugas yang berbeza dikendalikan oleh model terlatih khas .

Baru-baru ini, penyelidik dari NVIDIA, Stanford University, Macalester College, Caltech, Tsinghua University dan University of Texas di Austin bersama-sama mencadangkan robot universal berdasarkan Transformer The agent VIMA menggunakan gesaan berbilang modal untuk mencapai prestasi generalisasi yang sangat tinggi dan boleh mengendalikan sejumlah besar tugas pengendalian robot.

Pautan kertas: https://arxiv.org/abs/2210.03094

Pautan projek: https://vimalabs.github.io/

Pautan kod: https://github.com/vimalabs/ VIMA

Gesaan input ialah simbol teks dan visual bersilang.

Untuk melatih dan menilai VIMA, penyelidik mencadangkan set data penanda aras simulasi baharu yang mengandungi beribu-ribu imej yang dijana secara prosedur dengan tugas desktop isyarat berbilang mod dan lebih 600,000 pakar trajektori digunakan untuk pembelajaran tiruan, dengan empat peringkat untuk menilai prestasi generalisasi model .

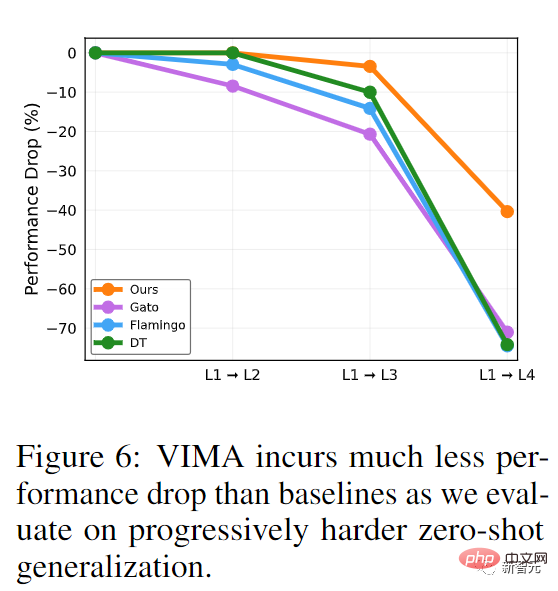

Dengan model saiz yang sama dan jumlah data latihan yang sama, kadar kejayaan VIMA dalam tetapan generalisasi sifar pukulan yang paling sukar adalah sama dengan kaedah sota semasa 2.9 kali .

Dengan 10 kali kurang data latihan, VIMA masih berprestasi 2.7 kali lebih baik daripada kaedah lain.

Pada masa ini semua kod, model pra-latihan, set data dan penanda aras simulasi adalah sumber terbuka sepenuhnya.

Pengarang pertama makalah ini ialah Yunfan Jiang, seorang pelajar sarjana tahun kedua di Universiti Stanford yang kini menjadi pelatih di Institut Penyelidikan NVIDIA. Lulus dari Universiti Edinburgh pada tahun 2020. Arah penyelidikan utamanya ialah kecerdasan buatan yang terkandung (AI yang terkandung), yang belajar melalui interaksi dengan alam sekitar. Kandungan penyelidikan khusus ialah cara menggunakan model asas berskala besar untuk melaksanakan ejen terwujud terbuka (ejen termaktub)

Kertas tersebut merangkumi The dua mentor kedua-duanya bekas pelajar Li Feifei.

Zhu Yuke lulus dari Universiti Zhejiang dan memperoleh ijazah dua dari Universiti Zhejiang dan Universiti Simon Fraser di Kanada. Pelajar sarjana dan kedoktoran belajar di Universiti Stanford di bawah Li Feifei, dan memperoleh ijazah kedoktoran mereka pada Ogos 2019. Zhu Yuke kini merupakan penolong profesor di Jabatan Sains Komputer di UT Austin, pengarah Makmal Persepsi dan Pembelajaran Robot, dan seorang saintis penyelidikan kanan di Institut Penyelidikan NVIDIA.

Fan Linxi, lulus dari Universiti Stanford dengan Ph.D di bawah bimbingan Feifei Li, dan kini seorang saintis penyelidikan di NVIDIA AI. Hala tuju penyelidikan utama ialah pembangunan ejen autonomi yang berkebolehan secara amnya, kerja penyelidikan khusus meliputi model asas, pembelajaran dasar, robotik, pembelajaran pelbagai mod dan sistem berskala besar.

Robot dan gesaan pelbagai mod

Transformer telah mencapai prestasi yang sangat tinggi dalam berbilang tugas dalam bidang NLP Hanya satu model boleh menyelesaikan soal jawab, mesin terjemahan, dan teks pada masa yang sama Abstrak dll.

Antara muka untuk melaksanakan tugas yang berbeza terletak pada gesaan teks input, dengan itu menghantar keperluan tugas khusus kepada model besar umum.

Bolehkah antara muka gesaan ini digunakan pada ejen robot am?

Untuk robot kerja rumah, idealnya, anda hanya perlu masukkan Dapatkan untuk saya, dan robot boleh mengambil cawan mengikut gambar itu datang.

Apabila robot perlu mempelajari kemahiran baharu, sebaiknya mempelajarinya dengan memasukkan demonstrasi video. Jika robot perlu berinteraksi dengan objek yang tidak dikenali, ia boleh dijelaskan dengan mudah hanya dengan ilustrasi.

Pada masa yang sama, untuk memastikan penggunaan yang selamat, pengguna boleh menentukan lagi kekangan visual, seperti Jangan masuk ke bilik

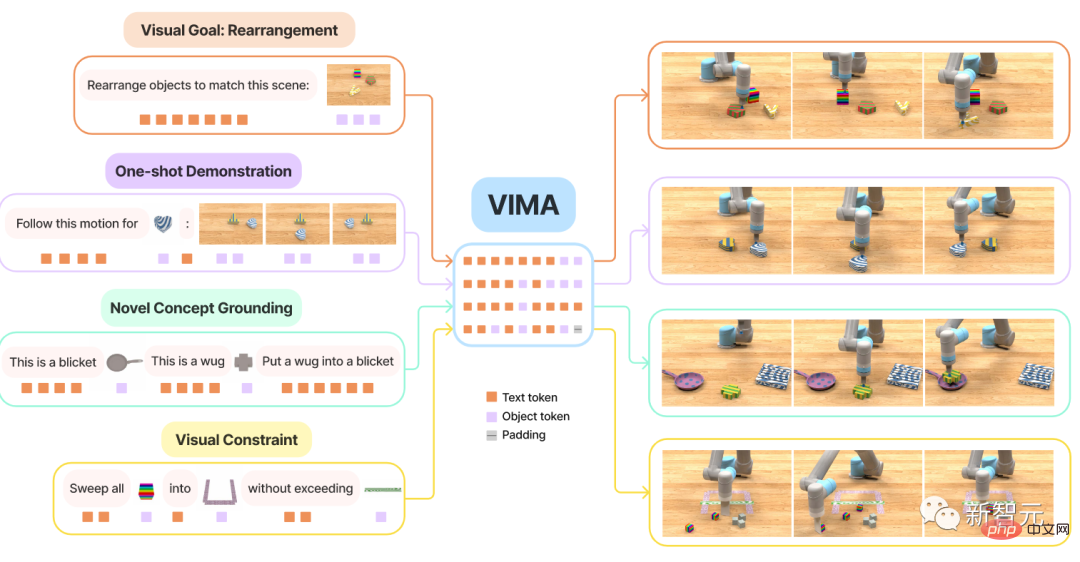

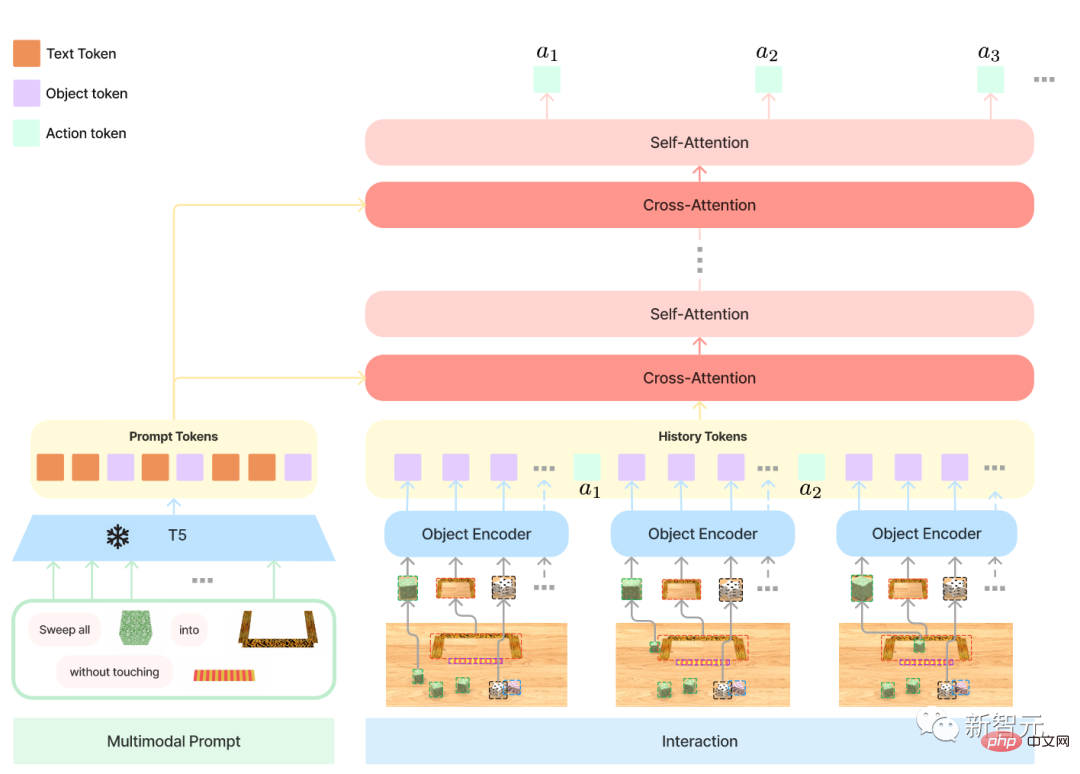

Untuk merealisasikan fungsi ini, model VIMA terutamanya mengandungi tiga bahagian:

1 berubah menjadi masalah pemodelan jujukan; 🎜>3. Sebuah penanda aras berskala besar dengan tugas yang berbeza untuk menilai secara sistematik skalabiliti dan keluasan ejen

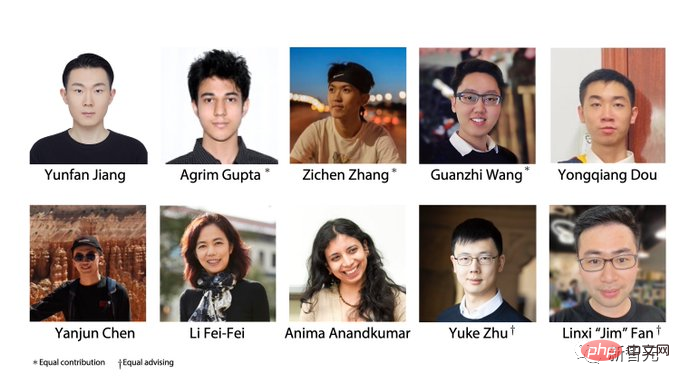

Pertama, oleh Fleksibiliti yang dibawa oleh pelbagai modal gesaan membolehkan pembangun menentukan dan membina model untuk menyokong sejumlah besar spesifikasi tugasan ini terutamanya mempertimbangkan enam jenis tugasan:

1manipulasi objek mudah , gesaan tugas adalah dalam bentuk meletakkan ke dalam , di mana slot yang sepadan ialah imej objek

2. Mencapai matlamat visual , manipulasi objek untuk mencapai penetapan matlamat, seperti penyusunan semula; seperti dax, blicket, dsb., yang boleh dijelaskan melalui imej dalam gesaan, dan kemudian digunakan secara langsung dalam arahan, yang boleh menguji pengecaman konsep baharu oleh ejen >

4.Tiruan video satu tangkapan , tonton demonstrasi video dan pelajari cara mensimulasikan pergerakan tertentu dengan laluan pergerakan yang sama Objek dihasilkan semula; >5. Memenuhi kekangan visual (Kepuasan kekangan visual) , robot mesti memanipulasi objek dengan teliti untuk mengelak daripada melanggar sekatan keselamatan

6Taakulan visual Terdapat beberapa tugas yang memerlukan ejen dapat membuat alasan, seperti "memasukkan semua objek dengan tekstur yang sama seperti ke dalam bekas", atau memerlukan memori visual, seperti "Masukkan ke dalam bekas itu, dan kemudian letakkannya semula"

Perlu diingatkan bahawa enam jenis tugasan ini Tidak saling eksklusif, sebagai contoh, beberapa tugasan mungkin memperkenalkan kata kerja yang belum pernah dilihat sebelum ini (Konsep Novel) melalui video tunjuk cara (tiruan)

Tanda aras baharu VIM-BENCHSukar untuk membuat hidangan tanpa nasi. Bagi melatih model tersebut, penyelidik turut menyediakan beberapa data sokongan sebagai penanda aras pembelajaran robot berbilang mod VIMA-BENCH

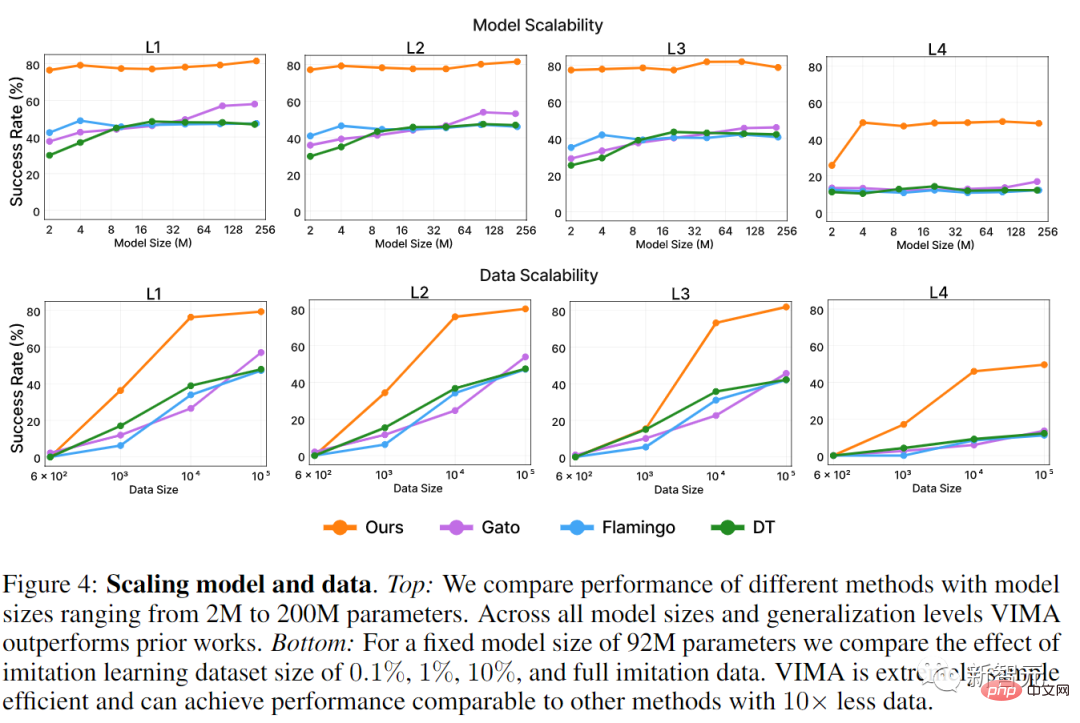

.Dalam Persekitaran Simulasi, penanda aras sedia ada secara amnya ditujukan kepada spesifikasi tugasan tertentu Pada masa ini, tiada penanda aras yang boleh menyediakan suite tugasan pelbagai mod yang kaya dan platform ujian A yang komprehensif untuk dikesan keupayaan ejen dengan cara yang disasarkan. Untuk tujuan ini, para penyelidik membina VIMA-BENCH dengan memanjangkan simulator robot Ravens untuk menyokong koleksi objek dan tekstur yang boleh diperluas untuk menyusun isyarat berbilang modal dan secara prosedur menjana sejumlah besar tugas . Secara khususnya, VIMA-BENCH menyediakan 17 tugasan meta dengan templat gesaan berbilang modal, yang boleh dijadikan instantiated menjadi 1000 tugasan bebas. Setiap meta-tugas tergolong dalam satu atau lebih daripada enam kaedah spesifikasi tugasan di atas. VIMA-BENCH boleh menjana sejumlah besar data pembelajaran tiruan melalui ejen oracle berskrip. Pada Pemerhatian dan Tindakan , ruang pemerhatian simulator terdiri daripada imej RGB yang dipaparkan dari pandangan hadapan dan atas bawah, penanda aras Segmen objek realistik dan kotak sempadan turut disediakan untuk melatih model berpusatkan objek. VIM-BENCH mewarisi ruang aksi lanjutan daripada kerja sebelumnya, yang terdiri daripada kemahiran pergerakan paling asas, seperti "pilih dan letak", "lap", dsb., khususnya kesan terminal Ditentukan oleh postur. Simulator juga menampilkan program oracle berskrip yang boleh digunakan untuk memberi keistimewaan maklumat keadaan simulator, seperti lokasi tepat semua objek, serta berbilang -arahan modal Penjelasan asas dan demonstrasi pakar. Akhir sekali, penyelidik menghasilkan set data luar talian yang besar bagi trajektori pakar untuk pembelajaran tiruan melalui oracle yang telah diprogramkan. Set data termasuk 50,000 trajektori untuk setiap meta-tugas, untuk sejumlah 650,000 trajektori yang berjaya. Juga kekalkan subset model dan tekstur objek untuk penilaian mudah, dan gunakan 4 daripada 17 meta-tugas untuk ujian generalisasi sifar pukulan. Setiap standard tugasan VIMA-BENCH hanya mempunyai kejayaan dan kegagalan, dan tiada isyarat ganjaran untuk keadaan pertengahan. Pada masa ujian, penyelidik melaksanakan strategi ejen dalam simulator fizik untuk mengira kadar kejayaan, dengan purata kadar kejayaan merentas semua tugasan meta yang dinilai sebagai metrik terakhir yang dilaporkan. Protokol penilaian mengandungi empat peringkat untuk secara sistematik menyiasat keupayaan generalisasi ejen, dengan setiap peringkat lebih menyimpang daripada Pengagihan latihan, secara tegasnya satu tahap lebih sukar daripada yang lain. 1. Generalisasi peletakan : Semasa proses latihan, semua gesaan adalah verbatim, tetapi semasa ujian, objek pada Peletakan desktop adalah rawak. 2. Generalisasi gabungan : Semua bahan (kata sifat) dan objek tiga dimensi (kata nama) boleh dilihat dalam latihan, tetapi dalam Beberapa gabungan baharu akan muncul dalam ujian itu. 3. Generalisasi objek novel : Gesaan ujian dan ruang kerja simulasi termasuk kata adjektif dan objek baharu. 4 Pengertian tugasan novel : Meta-tugas baharu dengan templat gesaan baharu semasa ujian mengandungi sejumlah tiga format dalam gesaan berbilang modal: 1, Teks, menggunakan model T5 yang telah terlatih Jalankan perkataan pembahagian dan dapatkan vektor perkataan; 2 Seluruh adegan desktop, mula-mula gunakan Mask R-CNN untuk mengenal pasti semua objek bebas, setiap objek terdiri daripada kotak sempadan dan perwakilan imej dipotong, dan kemudian dikodkan menggunakan pengekod bo terikat dan ViT masing-masing. 3 Imej objek tunggal, juga gunakan ViT untuk mendapatkan token, dan kemudian masukkan urutan hasil ke dalam model pengekod T5 yang telah dilatih. Pengawal Robot, iaitu input penyahkod ialah perwakilan dan trajektori selepas berbilang lapisan perhatian silang pada jujukan sejarah jujukan segera. Reka bentuk sedemikian boleh meningkatkan sambungan kepada gesaan dengan lebih baik mengekalkan dan memproses token gesaan asal dengan lebih baik dan kecekapan pengkomputeran yang lebih baik. reka bentuk eksperimen dalam fasa ujian terutamanya untuk menjawab tiga soalan: 1, VIMA Perbandingan prestasi dengan ejen berasaskan SOTA Transformer sebelumnya pada pelbagai tugas dengan gesaan berbilang modal; > 3 Sama ada pembahagian kata visual yang berbeza, gesaan bersyarat dan pengekodan bersyarat akan menjejaskan keputusan muktamad. Model garis dasar yang dibandingkan termasuk Gato, Flamingo dan Pertama pada Penskalaan model, para penyelidik melatih semua kaedah daripada saiz parameter 2M hingga 200M, dan saiz pengekod sentiasa dikekalkan sebagai pangkalan T5 daripada karya lain dalam penilaian generalisasi sifar pukulan di semua peringkat. Walaupun Gato dan Flamingo meningkatkan prestasi mereka pada model bersaiz lebih besar, VIMA masih mengatasi semua model. Dalam Penskalaan data (Penskalaan data) Dalam General Progresif (General Progresif) Rujukan: https://arxiv.org/ abs /2210.03094 Model VIMA

Atas ialah kandungan terperinci Dua perantis Li Feifei bersama-sama membimbing: Robot yang boleh memahami 'gesaan berbilang modal' boleh meningkatkan prestasi sifar pukulan sebanyak 2.9 kali. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI