Rumah >Peranti teknologi >AI >Meta melancarkan model dunia MoDem: menyelesaikan tiga cabaran utama dalam bidang visual, dikemukakan oleh LeCun

Meta melancarkan model dunia MoDem: menyelesaikan tiga cabaran utama dalam bidang visual, dikemukakan oleh LeCun

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 20:22:011606semak imbas

Pada 27 Disember, MetaAI bertanggungjawab untuk A dalam bidang penglihatan dan pembelajaran pengukuhan

Sehingga petang hari 27hb, tweet ini Jumlah bacaan telah mencecah 73.9k.

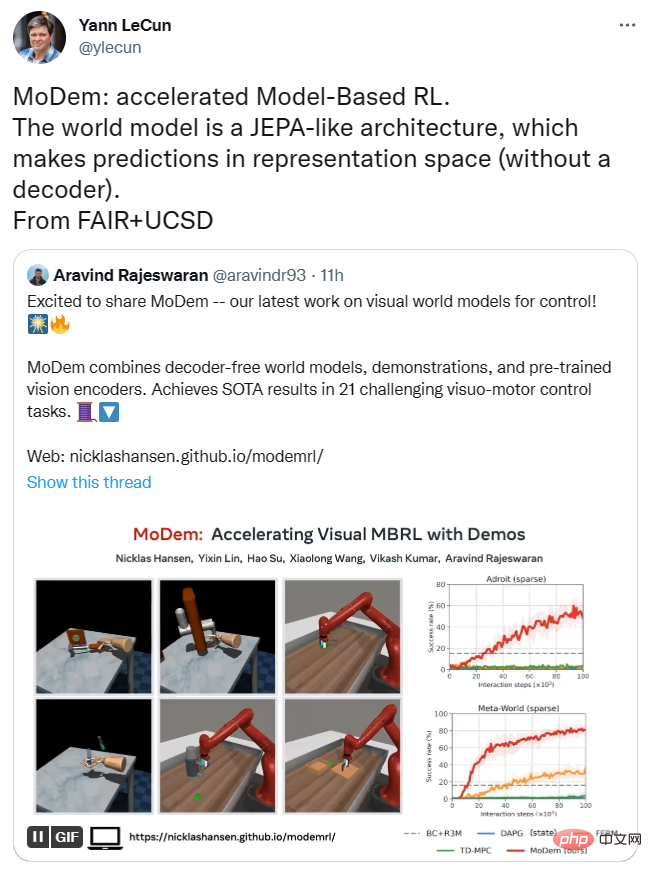

Beliau berkata dengan hanya 5 demo, MoDem dapat menyelesaikan masalah dengan ganjaran yang jarang dan ruang tindakan berdimensi tinggi dalam 100K langkah interaksi dengan ketara mengatasi kaedah terkini yang sedia ada pada tugas kawalan gerakan visual yang mencabar.

Seberapa hebatnya?

Mereka mendapati bahawa MoDem mempunyai kadar kejayaan yang lebih tinggi dalam menyelesaikan tugas ganjaran yang jarang daripada kaedah sebelumnya dalam rejim data rendah 150%-250% .

Lecun juga memajukan penyelidikan ini, mengatakan bahawa seni bina model MoDem adalah serupa dengan JEPA dan boleh membuat ramalan dalam ruang perwakilan tanpa memerlukan penyahkod. .

Editor dah letak link kat bawah ni Kawan-kawan yang berminat boleh tengok ~

Pautan kertas: https://arxiv.org/abs/2212.05698

Pautan Github: https: / /github.com/facebookresearch/modem

Inovasi Penyelidikan dan Seni Bina Model

Kecekapan sampel yang rendah ialah aplikasi praktikal untuk melaksanakan pembelajaran tetulang mendalam (RL) algoritma. Cabaran utama, terutamanya kawalan visuomotor.

RL berasaskan model berpotensi untuk mencapai kecekapan sampel yang tinggi dengan mempelajari model dunia secara serentak dan menggunakan penggunaan sintetik untuk perancangan dan penambahbaikan dasar.

Walau bagaimanapun, dalam praktiknya, pembelajaran sampel yang cekap dalam RL berasaskan model dihalang oleh cabaran penerokaan ini dengan tepat menyelesaikan cabaran utama ini.

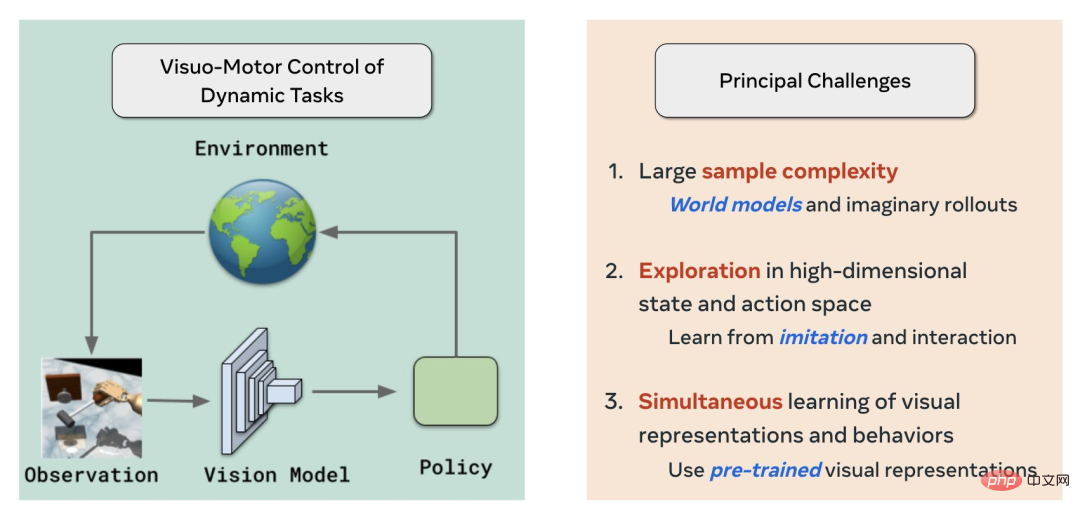

Pertama sekali, MoDem menyelesaikan tiga cabaran utama dalam bidang pembelajaran/kawalan peneguhan visual dengan menggunakan model dunia, tiruan + RL dan latihan pra-latihan visual penyeliaan sendiri masing-masing:

- Kerumitan sampel yang besar

- Penerokaan dalam keadaan berdimensi tinggi dan ruang tindakan

- Serentak pembelajaran perwakilan visual dan tingkah laku

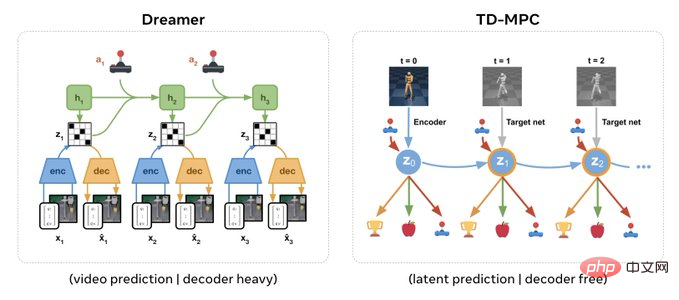

Kali ini seni bina model serupa dengan JEPA Yann LeCun dan tidak memerlukan penyahkod.

Aravind Rajeswaran, pengarang, berkata berbanding Dreamer, yang memerlukan penyahkod untuk ramalan tahap piksel dan mempunyai seni bina yang berat, seni bina tanpa dekoder boleh menyokong pemasukan langsung visual perwakilan dilatih terlebih dahulu menggunakan SSL.

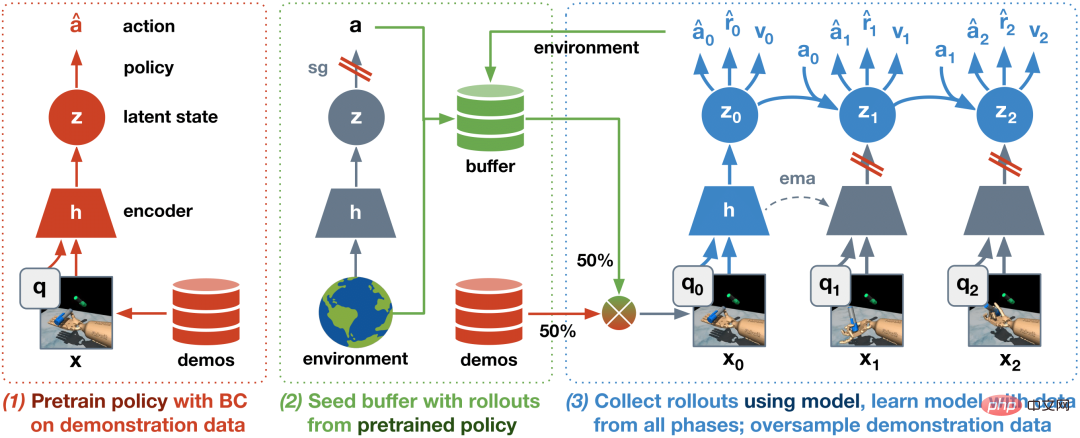

Selain itu, berdasarkan IL+RL, mereka mencadangkan algoritma tiga peringkat:

- Strategi pra-latihan SM

- Pralatih model dunia menggunakan set data benih yang mengandungi demonstrasi dan penerokaan, peringkat ini penting untuk kestabilan dan kecekapan keseluruhan

- Memperhalusi model dunia melalui interaksi dalam talian

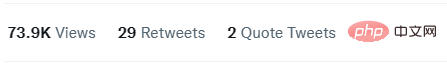

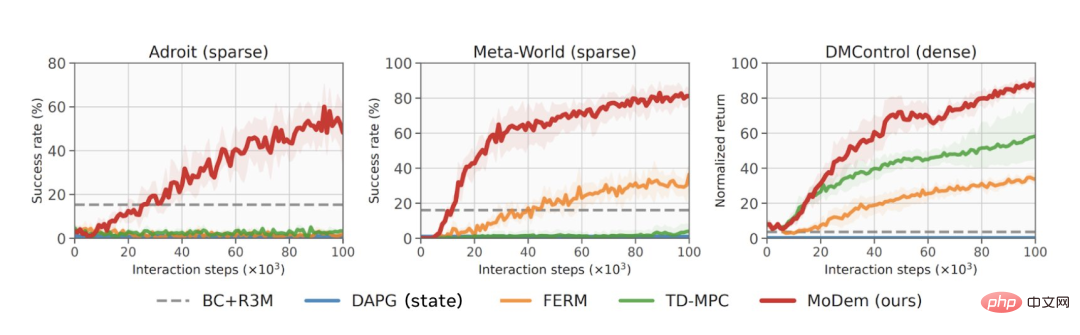

Hasilnya menunjukkan bahawa algoritma yang dijana adalah dalam 21 keputusan SOTA yang Dicapai (Keputusan State-Of-The-Art) dalam tugas kawalan gerakan visual keras, termasuk operasi tangkas Adroit, suite kawalan MetaWorld dan DeepMind.

Dari sudut pandangan data, MoDem berprestasi jauh lebih baik daripada model lain dalam pelbagai tugas, dan hasilnya adalah 150% hingga 250% lebih tinggi daripada kaedah SOTA sebelumnya.

Garis merah menunjukkan prestasi MoDem dalam pelbagai tugas

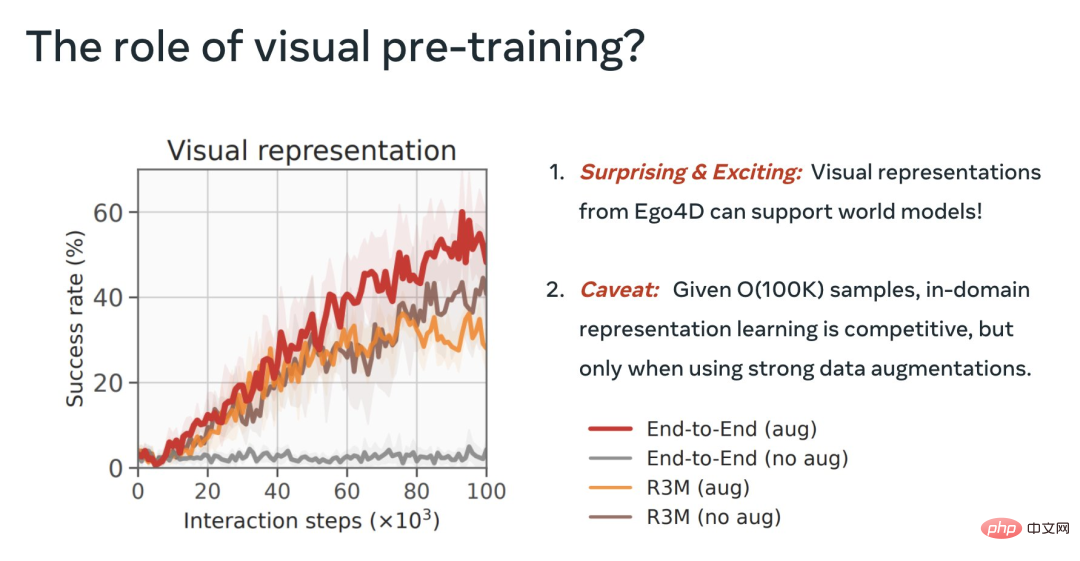

Dalam proses itu, mereka juga memberi penerangan tentang kepentingan peringkat yang berbeza dalam MoDem, kepentingan penambahan data untuk MBRL visual, dan kegunaan perwakilan visual yang telah terlatih.

Akhir sekali, menggunakan fungsi R3M beku adalah jauh lebih baik daripada pendekatan langsung E2E. Ini menarik dan menunjukkan bahawa pra-latihan visual daripada video boleh menyokong model dunia.

Tetapi E2E dengan data kukuh pada bulan Ogos bersaing dengan R3M beku, kami boleh melakukan lebih baik melalui pra-latihan.

Atas ialah kandungan terperinci Meta melancarkan model dunia MoDem: menyelesaikan tiga cabaran utama dalam bidang visual, dikemukakan oleh LeCun. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI