Rumah >Peranti teknologi >AI >Satu lagi revolusi dalam pembelajaran pengukuhan! DeepMind mencadangkan 'penyulingan algoritma': Transformer pembelajaran tetulang pra-latihan yang boleh diterokai

Satu lagi revolusi dalam pembelajaran pengukuhan! DeepMind mencadangkan 'penyulingan algoritma': Transformer pembelajaran tetulang pra-latihan yang boleh diterokai

- 王林ke hadapan

- 2023-04-12 18:58:152021semak imbas

Dalam tugas pemodelan jujukan semasa, Transformer boleh dikatakan sebagai seni bina rangkaian saraf yang paling berkuasa, dan model Transformer yang telah terlatih boleh menggunakan gesaan sebagai syarat atau pembelajaran dalam konteks untuk menyesuaikan diri dengan situasi yang berbeza .

Keupayaan generalisasi model Transformer pra-latihan berskala besar telah disahkan dalam pelbagai bidang, seperti pelengkapan teks, pemahaman bahasa, penjanaan imej, dsb.

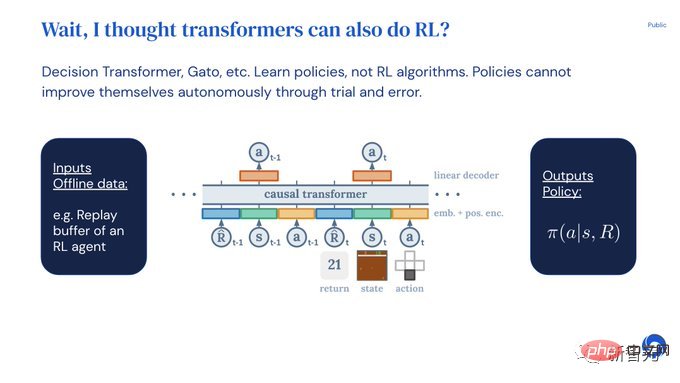

Sejak tahun lepas, terdapat kerja yang relevan membuktikan bahawa dengan menganggap pembelajaran peneguhan luar talian (luar talian RL) sebagai masalah ramalan jujukan, maka model Dasar boleh dipelajari daripada data luar talian.

Tetapi kaedah semasa sama ada mempelajari dasar daripada data yang tidak mengandungi pembelajaran (seperti dasar pakar yang ditetapkan melalui penyulingan), atau daripada data yang mengandungi pembelajaran (seperti mengangkat berat ejen). penampan), tetapi konteksnya terlalu kecil untuk menangkap penambahbaikan dasar.

Penyelidik DeepMind menemui melalui pemerhatian bahawa pada dasarnya sifat pembelajaran yang berurutan dalam latihan algoritma pembelajaran pengukuhan boleh mengubah peneguhan menjadi Pembelajaran proses itu sendiri dimodelkan sebagai "masalah ramalan jujukan sebab" .

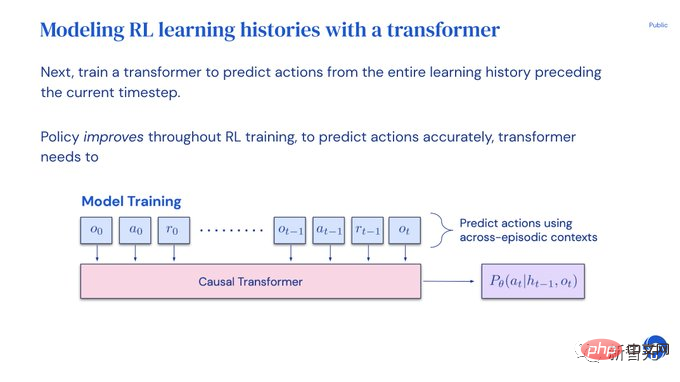

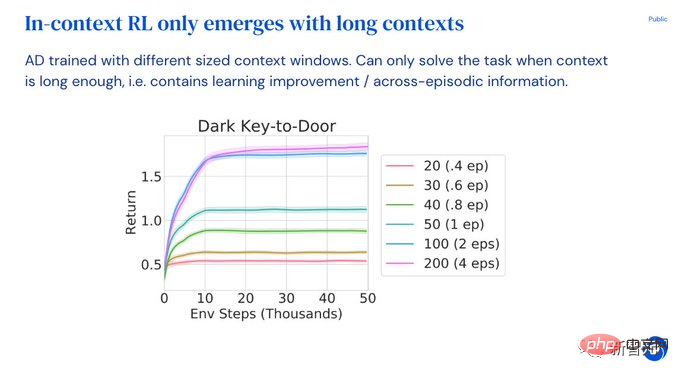

Khususnya, jika konteks Transformer cukup panjang untuk memasukkan penambahbaikan dasar disebabkan oleh kemas kini pembelajaran, ia bukan sahaja boleh mewakili dasar tetap, tetapi juga boleh keadaan, tindakan dan ganjaran episod sebelumnya diwakili sebagai pengendali penambahbaikan dasar.

Ini juga menyediakan kemungkinan teknikal bahawa mana-mana algoritma RL boleh disuling menjadi model jujukan yang cukup berkuasa melalui pembelajaran tiruan dan diubah menjadi algoritma RL dalam konteks.

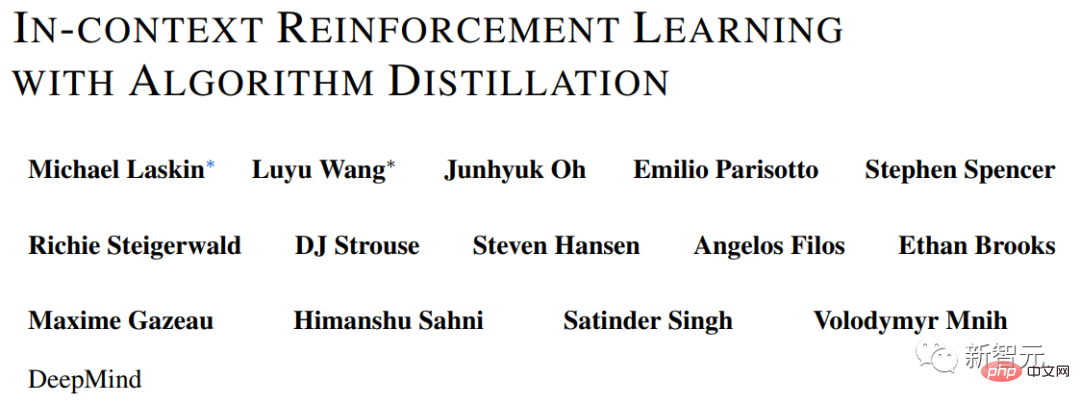

Berdasarkan perkara ini, DeepMind mencadangkan Penyulingan Algoritma (AD), yang mengekstrak algoritma pembelajaran tetulang ke dalam rangkaian saraf dengan mewujudkan model jujukan sebab.

Pautan kertas: https://arxiv.org/pdf/2210.14215.pdf

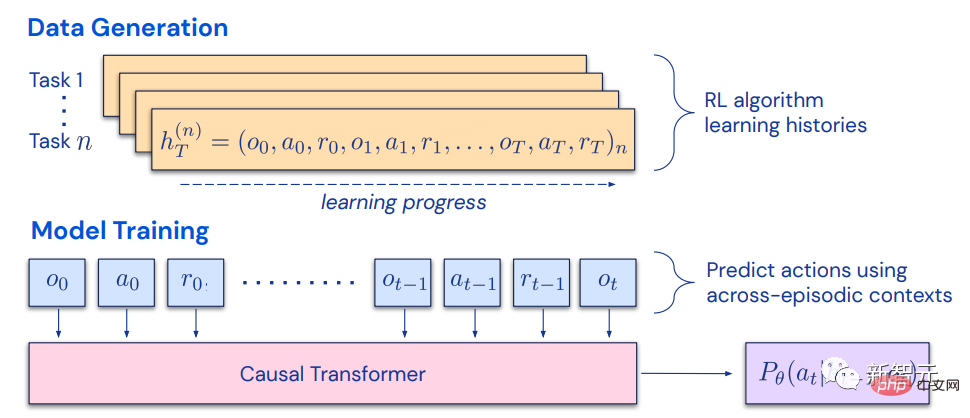

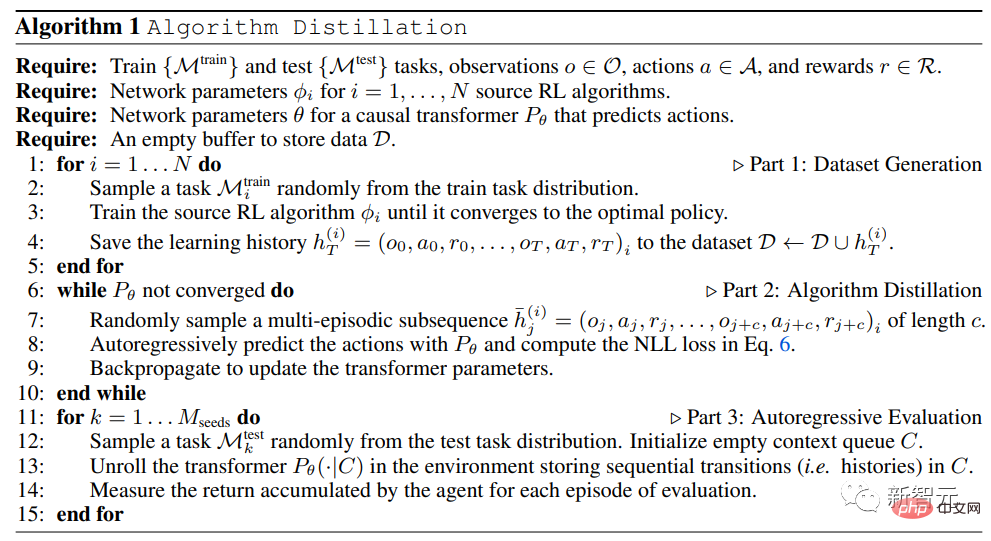

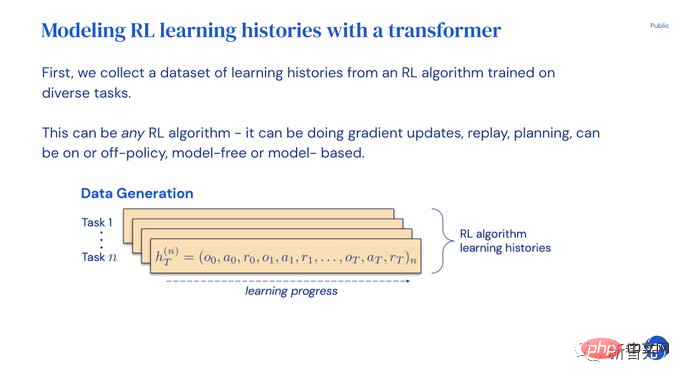

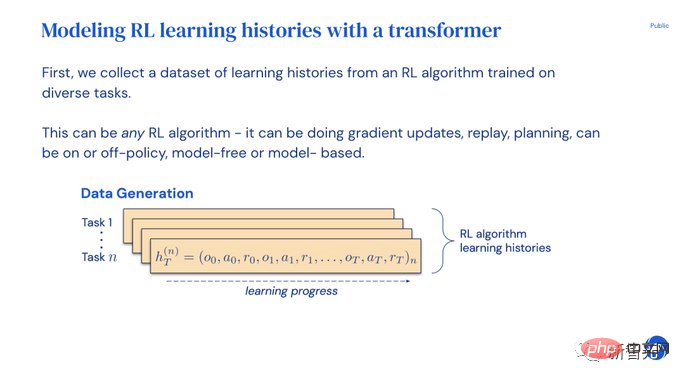

Penyulingan algoritma menganggap pembelajaran pengukuhan pembelajaran sebagai masalah ramalan jujukan episod merentas, menjana set data sejarah pembelajaran melalui algoritma RL sumber, dan kemudian menggunakan sejarah pembelajaran sebagai konteks untuk melatih Transformer penyebab melalui autoregresif tingkah laku ramalan.

Tidak seperti struktur ramalan dasar pasca pembelajaran atau jujukan jujukan pakar, AD dapat memperbaik dasarnya sepenuhnya dalam konteks tanpa mengemas kini parameter rangkaiannya.

- Transfomer mengumpul datanya sendiri dan memaksimumkan ganjaran untuk tugasan baharu;

- Dengan pemberat dibekukan, Transformer boleh meneroka, mengeksploitasi dan memaksimumkan pemulangan konteks! Kaedah Penyulingan Pakar seperti Gato tidak dapat meneroka dan tidak dapat memaksimumkan pulangan.

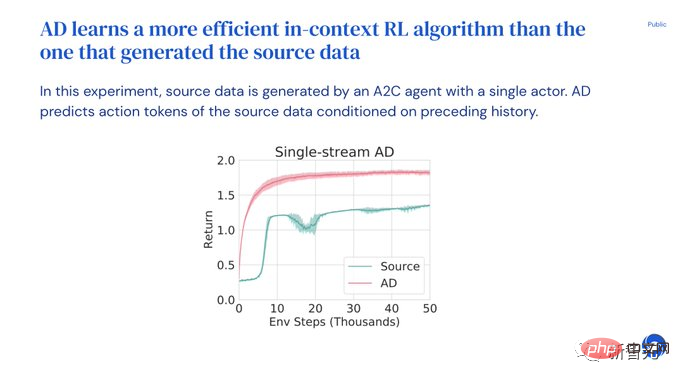

- Hasil eksperimen membuktikan bahawa AD boleh melaksanakan pembelajaran pengukuhan dalam pelbagai persekitaran dengan ganjaran yang jarang, struktur tugas gabungan dan pemerhatian berasaskan piksel, dan kecekapan data pembelajaran AD ( cekap data) daripada algoritma RL yang menjana data sumber.

AD juga merupakan pertama yang menunjukkan pembelajaran peneguhan dalam konteks melalui pemodelan jujukan data luar talian dengan kehilangan tiruan.

Penyulingan AlgoritmaPada tahun 2021, beberapa penyelidik mula-mula mendapati bahawa Transformer boleh mempelajari dasar satu tugasan daripada data RL luar talian melalui pembelajaran tiruan, dan kemudiannya diperluaskan untuk menjadi mampu Mengekstrak strategi berbilang tugas dalam tetapan domain yang sama dan merentas domain.

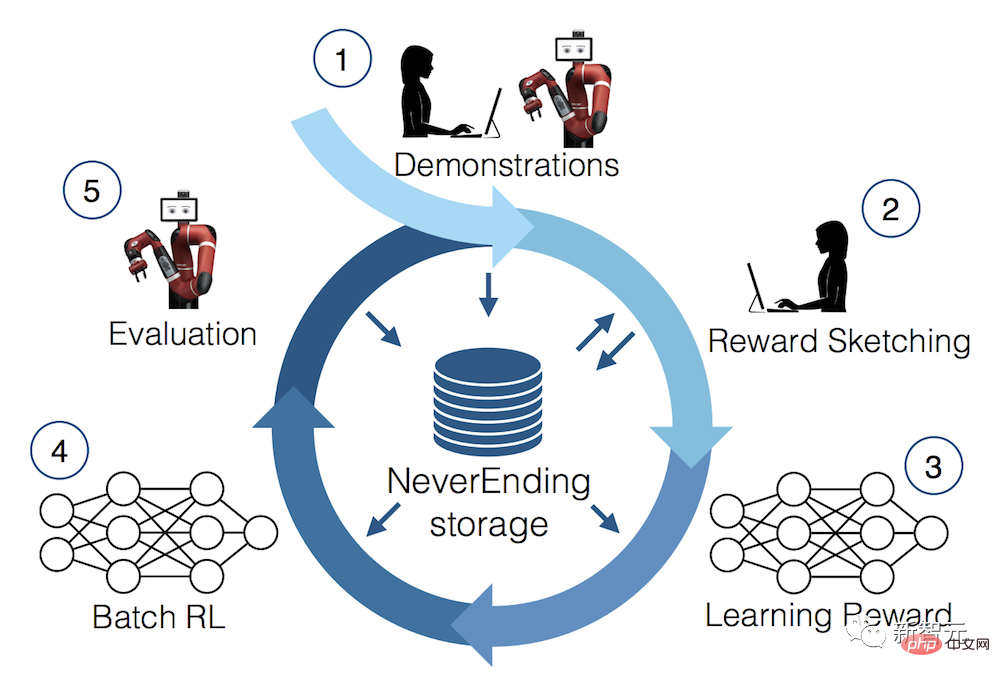

Kerja-kerja ini mencadangkan paradigma yang menjanjikan untuk mengekstrak strategi berbilang tugas umum: mula-mula kumpulkan sejumlah besar set data interaksi persekitaran yang berbeza, dan kemudian ekstrak satu daripada data melalui Strategi pemodelan jujukan.Kaedah pembelajaran dasar daripada data RL luar talian melalui pembelajaran tiruan juga dipanggil penyulingan dasar luar talian, atau ringkasnya Penyulingan Dasar (PD) . Walaupun idea PD adalah sangat mudah dan sangat mudah untuk diperluaskan, PD mempunyai kelemahan utama: strategi yang dihasilkan tidak bertambah baik daripada interaksi tambahan dengan persekitaran. Sebagai contoh, MultiGame Decision Transformer (MGDT) mempelajari dasar bersyarat pulangan yang boleh memainkan sejumlah besar permainan Atari, manakala Gato mempelajari dasar bersyarat dalam Strategi untuk menyelesaikan tugasan dalam persekitaran yang berbeza, tetapi kedua-dua pendekatan tidak boleh memperbaiki strateginya melalui percubaan dan kesilapan. MGDT menyesuaikan pengubah kepada tugas baharu dengan memperhalusi berat model, manakala Gato memerlukan petua demonstrasi pakar untuk menyesuaikan diri dengan tugas baharu. Ringkasnya, kaedah Penyulingan Dasar mempelajari dasar dan bukannya algoritma pembelajaran pengukuhan. Para penyelidik membuat hipotesis bahawa sebab Penyulingan Polisi tidak boleh bertambah baik melalui percubaan dan kesilapan adalah kerana ia dilatih pada data yang tidak menunjukkan kemajuan pembelajaran. Penyulingan Algoritma (AD) ialah kaedah pembelajaran pengendali penambahbaikan dasar intrinsik dengan mengoptimumkan kehilangan ramalan jujukan sebab dalam sejarah pembelajaran algoritma RL. IKLAN termasuk dua komponen: 1 Dengan menyimpan Latihan sejarah algoritma RL pada banyak tugasan berasingan menjana set data berbilang tugas yang besar; Oleh kerana dasar itu terus bertambah baik sepanjang proses latihan algoritma RL sumber, AD mesti belajar cara menambah baik pengendali untuk mensimulasikan tindakan dengan tepat pada mana-mana titik tertentu dalam latihan sejarah. Paling penting, saiz konteks Transformer mestilah cukup besar (iaitu merentas zaman) untuk menangkap peningkatan dalam data latihan.

Dalam bahagian percubaan, untuk meneroka kelebihan AD dalam keupayaan RL dalam konteks, penyelidik menumpukan pada ketidakupayaan untuk melepasi sifar selepas pra-latihan -shot membuat generalisasi untuk menyelesaikan persekitaran di mana setiap persekitaran diperlukan untuk menyokong pelbagai tugas dan model tidak boleh membuat kesimpulan dengan mudah penyelesaian kepada tugasan daripada pemerhatian. Pada masa yang sama, episod perlu cukup pendek supaya Transformers bersebab merentas episod boleh dilatih.

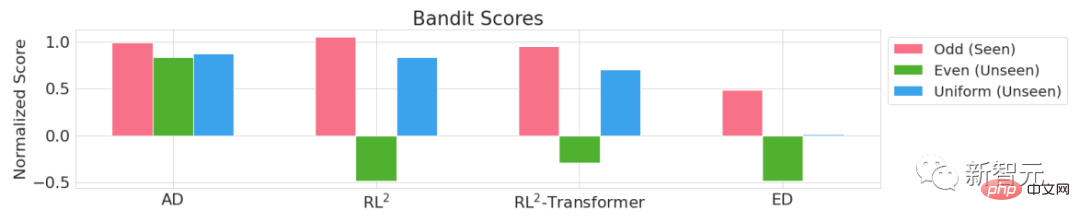

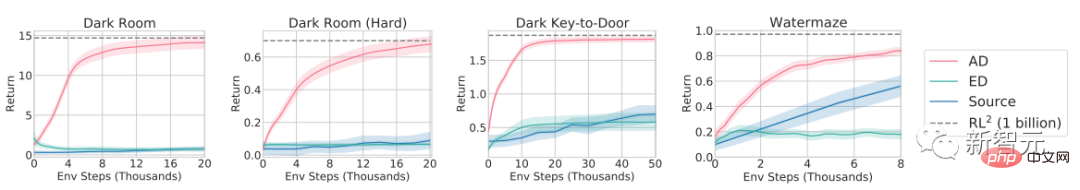

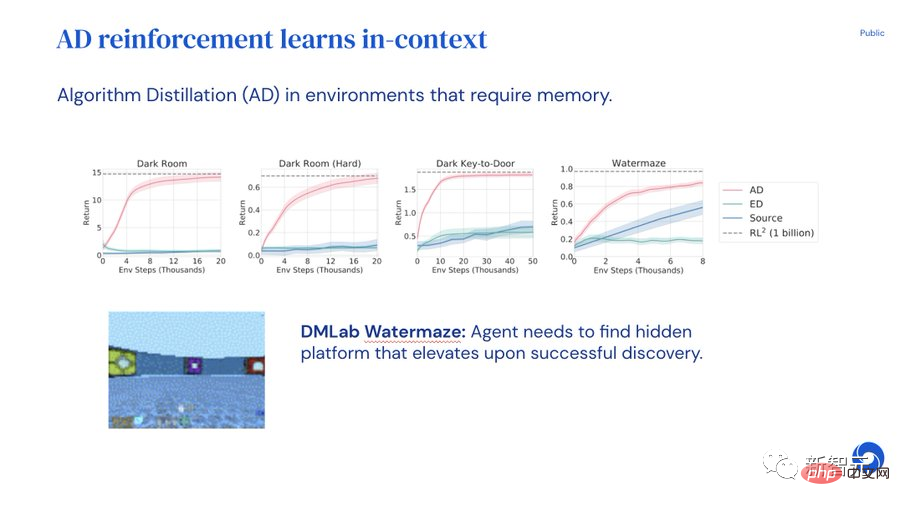

Seperti yang dapat dilihat dalam keputusan eksperimen bagi empat persekitaran Adversarial Bandit, Bilik Gelap, Kunci-ke-Pintu Gelap dan Watermaze DMLab, melalui algoritma RL berasaskan Gradien tiruan, menggunakan Transformer sebab dengan konteks yang cukup besar, AD boleh mengukuhkan pembelajaran tugasan baharu sepenuhnya dalam konteks.

AD boleh melakukan penerokaan dalam konteks, peruntukan kredit temporal dan generalisasi Algoritma pembelajaran AD adalah lebih baik daripada sumber latihan Transformer algoritma adalah lebih cekap data. Penjelasan PPT

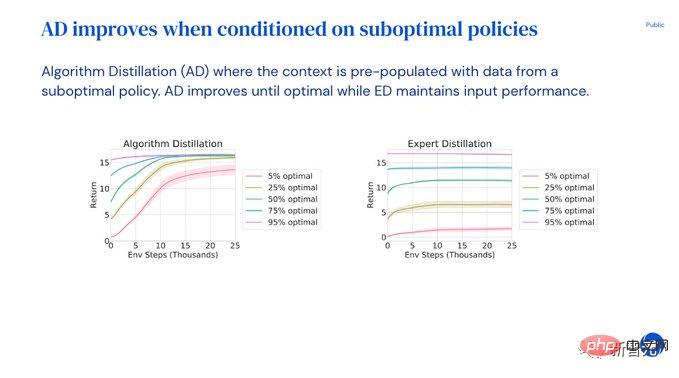

Eksperimen pada penyulingan algoritma menunjukkan bahawa Transformer boleh menambah baik model secara autonomi melalui percubaan dan ralat tanpa mengemas kini pemberat, gesaan atau penalaan halus. Satu Transformer boleh mengumpul datanya sendiri dan memaksimumkan ganjaran untuk tugasan baharu. Walaupun terdapat banyak model yang berjaya menunjukkan cara Transformer belajar dalam konteks, Transformer masih belum terbukti dapat mengukuhkan pembelajaran dalam konteks. Untuk menyesuaikan diri dengan tugasan baharu, pembangun sama ada perlu menentukan pembayang atau melaraskan model secara manual. Bukankah bagus jika Transformer dapat menyesuaikan diri dengan pembelajaran pengukuhan dan digunakan di luar kotak? Tetapi Decision Transformers atau Gato hanya boleh mempelajari strategi daripada data luar talian dan tidak boleh menambah baik secara automatik melalui percubaan berulang. Transformer yang dijana menggunakan kaedah pra-latihan penyulingan algoritmik (AD) boleh melaksanakan pembelajaran pengukuhan dalam konteks. Mula-mula latih berbilang salinan algoritma pembelajaran pengukuhan untuk menyelesaikan tugasan yang berbeza dan menyimpan sejarah pembelajaran. Setelah set data sejarah pembelajaran dikumpul, Transformer boleh dilatih untuk meramalkan tindakan sejarah pembelajaran sebelumnya. Memandangkan dasar telah bertambah baik dari segi sejarah, meramalkan tindakan dengan tepat akan memaksa Transformer untuk memodelkan penambahbaikan dasar. Keseluruhan prosesnya begitu mudah sahaja dengan meniru tindakan Tiada nilai Q seperti yang digunakan dalam model pembelajaran pengukuhan biasa. dan tidak ada yang panjang Urutan operasi-tindakan-ganjaran juga tidak mempunyai syarat pulangan seperti DT. Dalam konteks, pembelajaran pengukuhan tidak mempunyai overhed tambahan, dan model tersebut kemudiannya dinilai dengan memerhati sama ada AD boleh memaksimumkan ganjaran untuk tugasan baharu. Semasa Transformer meneroka, mengeksploitasi dan memaksimumkan pulangan dalam konteks, pemberatnya dibekukan! Penyulingan Pakar (paling serupa dengan Gato), sebaliknya, tidak boleh meneroka atau memaksimumkan ganjaran. AD boleh mengekstrak mana-mana algoritma RL Para penyelidik mencuba UCB dan DQNA2C Satu penemuan yang menarik ialah dalam pembelajaran algoritma RL kontekstual, AD Lebih cekap data . Pengguna juga boleh memasukkan gesaan dan demo suboptimum, dan model akan menambah baik strategi secara automatik sehingga penyelesaian optimum diperoleh! Walau bagaimanapun, Expert Distillation ED hanya boleh mengekalkan prestasi demo yang tidak optimum. Konteks RL hanya akan muncul apabila konteks Transformer cukup panjang untuk menjangkau berbilang episod. AD memerlukan sejarah yang cukup panjang untuk melaksanakan penambahbaikan model dan tugas pengenalpastian yang berkesan. Melalui eksperimen, penyelidik membuat kesimpulan berikut:

Atas ialah kandungan terperinci Satu lagi revolusi dalam pembelajaran pengukuhan! DeepMind mencadangkan 'penyulingan algoritma': Transformer pembelajaran tetulang pra-latihan yang boleh diterokai. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI