Rumah >Peranti teknologi >AI >Bolehkah DALL-E dan Flamingo memahami satu sama lain? Tiga rangkaian saraf SOTA pra-latihan menyatukan imej dan teks

Bolehkah DALL-E dan Flamingo memahami satu sama lain? Tiga rangkaian saraf SOTA pra-latihan menyatukan imej dan teks

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 16:49:101360semak imbas

Matlamat penting penyelidikan pelbagai mod adalah untuk meningkatkan keupayaan mesin untuk memahami imej dan teks. Khususnya, penyelidik telah melakukan usaha yang hebat tentang cara untuk mencapai komunikasi yang bermakna antara kedua-dua model. Sebagai contoh, penjanaan kapsyen imej seharusnya dapat menukar kandungan semantik imej kepada teks koheren yang boleh difahami oleh manusia. Sebaliknya, model generatif imej teks juga boleh mengeksploitasi semantik penerangan teks untuk mencipta imej yang realistik.

Ini membawa kepada beberapa soalan menarik berkaitan semantik: untuk imej tertentu, perihalan teks yang manakah paling tepat menerangkan imej itu? Begitu juga, untuk teks tertentu, apakah cara yang paling bermakna untuk melaksanakan imej? Mengenai soalan pertama, beberapa kajian mendakwa bahawa penerangan imej terbaik haruslah maklumat yang semula jadi dan boleh memulihkan kandungan visual. Bagi soalan kedua, imej yang bermakna harus berkualiti tinggi, pelbagai dan sesuai dengan kandungan teks.

Dalam apa jua keadaan, didorong oleh komunikasi manusia, tugas interaktif yang melibatkan model penjanaan imej teks dan model penjanaan teks imej boleh membantu kami memilih pasangan teks imej yang paling tepat.

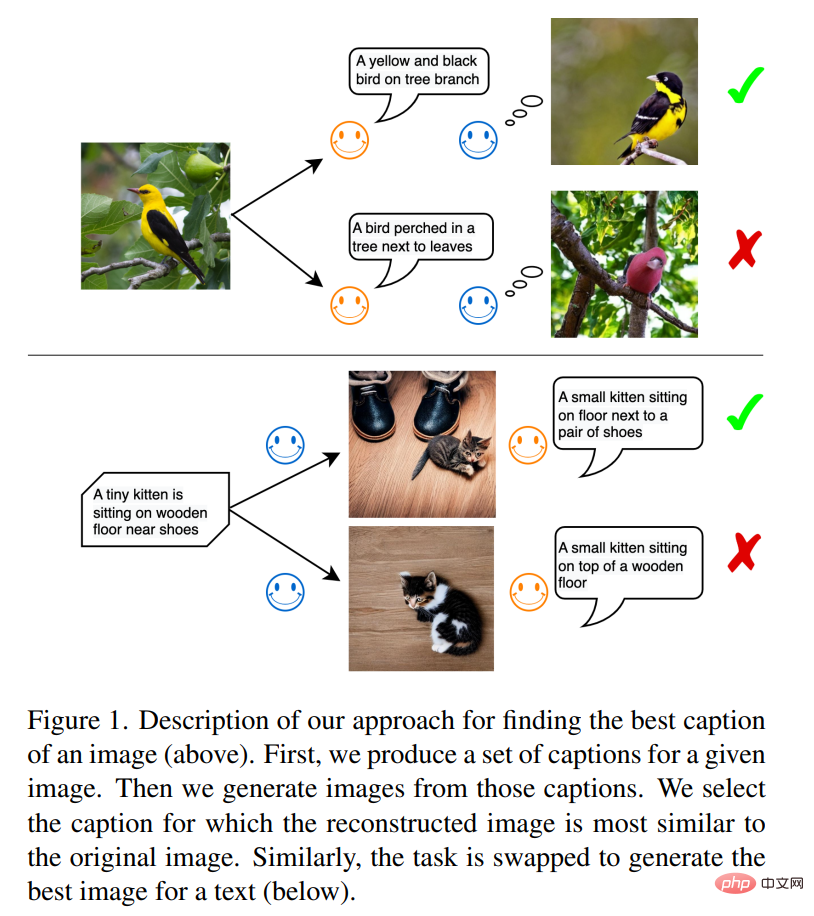

Seperti yang ditunjukkan dalam Rajah 1, dalam tugasan pertama, model teks imej ialah penghantar maklumat, dan model imej teks ialah penerima maklumat. Matlamat penghantar adalah untuk menyampaikan kandungan imej kepada penerima menggunakan bahasa semula jadi supaya ia memahami bahasa dan membina semula perwakilan visual yang realistik. Sebaik sahaja penerima boleh membina semula maklumat imej asal dengan kesetiaan yang tinggi, ia menunjukkan bahawa maklumat telah berjaya dipindahkan. Penyelidik percaya bahawa penerangan teks yang dihasilkan dengan cara ini adalah optimum, dan imej yang dihasilkan melaluinya juga paling serupa dengan imej asal.

Peraturan ini diilhamkan oleh penggunaan bahasa orang ramai untuk berkomunikasi. Bayangkan senario berikut: Dalam adegan panggilan kecemasan, polis mengetahui tentang kemalangan kereta dan status orang yang cedera melalui telefon. Ini pada asasnya melibatkan proses penerangan imej oleh saksi di tempat kejadian. Pihak polis perlu membina semula keadaan alam sekitar secara mental berdasarkan penerangan lisan untuk mengatur operasi menyelamat yang sesuai. Jelas sekali, penerangan teks yang terbaik harus menjadi panduan terbaik untuk pembinaan semula tempat kejadian.

Tugas kedua melibatkan pembinaan semula teks: model imej teks menjadi penghantar mesej, dan model teks imej menjadi penerima mesej. Apabila kedua-dua model bersetuju dengan kandungan maklumat pada peringkat teks, medium imej yang digunakan untuk menyampaikan maklumat adalah imej optimum yang menghasilkan semula teks sumber.

Dalam artikel ini, kaedah yang dicadangkan oleh penyelidik dari Universiti Munich, Siemens dan institusi lain berkait rapat dengan komunikasi antara ejen. Bahasa adalah kaedah utama untuk bertukar maklumat antara ejen. Tetapi bagaimana kita boleh memastikan bahawa ejen pertama dan ejen kedua mempunyai pemahaman yang sama tentang apa itu kucing atau apa itu anjing?

Alamat kertas: https://arxiv.org/pdf/2212.12249.pdf

Idea yang ingin diterokai oleh artikel ini ialah meminta ejen pertama menganalisis imej dan menjana teks yang menerangkan imej, dan kemudian ejen kedua mendapatkan teks dan mensimulasikan imej berdasarkannya. Antaranya, proses yang terakhir boleh dianggap sebagai proses penjelmaan. Kajian ini percaya bahawa komunikasi berjaya jika imej yang disimulasikan oleh ejen kedua adalah serupa dengan imej input yang diterima oleh ejen pertama (lihat Rajah 1).

Dalam eksperimen, kajian ini menggunakan model luar biasa, terutamanya model pra-latihan berskala besar yang dibangunkan baru-baru ini. Contohnya, Flamingo dan BLIP ialah model penerangan imej yang boleh menjana penerangan teks secara automatik berdasarkan imej. Begitu juga, model penjanaan imej yang dilatih pada pasangan teks imej boleh memahami semantik teks yang mendalam dan mensintesis imej berkualiti tinggi, seperti model DALL-E dan model resapan terpendam (SD).

Selain itu, kajian itu memanfaatkan model CLIP untuk membandingkan imej atau teks. CLIP ialah model bahasa visual yang memetakan imej dan teks dalam ruang benam yang dikongsi. Kajian ini menggunakan set data teks imej yang dibuat secara manual seperti COCO dan NoCaps untuk menilai kualiti teks yang dijana. Model generatif imej dan teks mempunyai komponen stokastik yang membenarkan pensampelan daripada pengedaran, dengan itu memilih yang terbaik daripada julat teks dan imej calon. Kaedah pensampelan yang berbeza, termasuk pensampelan kernel, boleh digunakan dalam model penerangan imej, dan artikel ini menggunakan pensampelan kernel sebagai model asas untuk menunjukkan keunggulan kaedah yang digunakan dalam artikel ini.

Gambaran Keseluruhan Kaedah

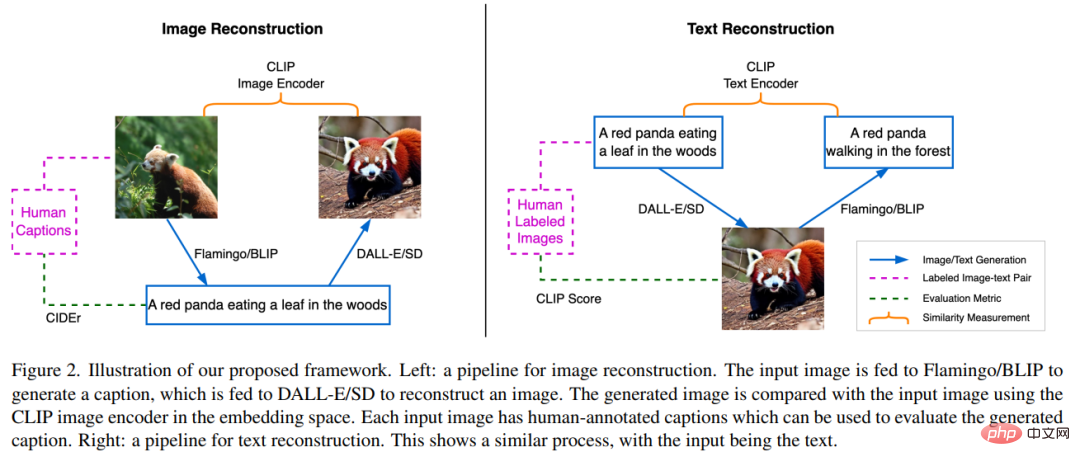

Rangka kerja artikel ini terdiri daripada tiga rangkaian neural SOTA terlatih. Pertama, model penjanaan imej-teks; kedua, model penjanaan imej-teks ketiga, model perwakilan berbilang mod yang terdiri daripada pengekod imej dan pengekod teks, yang masing-masing boleh memetakan imej atau teks ke dalam semantiknya.

Pembinaan semula imej melalui penerangan teks

Seperti yang ditunjukkan di bahagian kiri Rajah 2 Seperti yang ditunjukkan dalam bahagian, tugas pembinaan semula imej adalah untuk membina semula imej sumber menggunakan bahasa sebagai arahan, dan pelaksanaan proses ini akan membawa kepada penjanaan teks optimum yang menerangkan pemandangan sumber. Pertama, imej sumber x dimasukkan ke model BLIP untuk menjana berbilang teks calon y_k. Contohnya, seekor panda merah memakan daun di dalam hutan. Set calon teks yang dijana diwakili oleh C, dan kemudian teks y_k dihantar ke model SD untuk menjana imej x'_k. Di sini x'_k merujuk kepada imej yang dihasilkan berdasarkan panda merah. Selepas itu, pengekod imej CLIP digunakan untuk mengekstrak ciri semantik daripada sumber dan imej yang dihasilkan:  dan

dan  .

.

Kemudian persamaan kosinus antara kedua-dua vektor benam ini dikira dengan tujuan mencari huraian teks calon y_s, iaitu

di mana s ialah indeks imej yang paling hampir dengan imej sumber.

Kajian ini menggunakan CIDEr (Metrik Penerangan Imej) dan merujuk anotasi manusia untuk menilai teks terbaik. Memandangkan kami berminat dengan kualiti teks yang dihasilkan, kajian ini menetapkan model BLIP kepada teks output yang lebih kurang sama panjangnya. Ini memastikan perbandingan yang agak adil, kerana panjang teks berkorelasi positif dengan jumlah maklumat dalam imej yang boleh disampaikan. Semasa kerja ini, semua model akan dibekukan dan tiada penalaan halus akan dilakukan.

Pembinaan semula teks melalui imej

Bahagian kanan Rajah 2 menunjukkan kebalikan proses yang diterangkan dalam bahagian sebelumnya. Model BLIP memerlukan meneka teks sumber berpandukan SD, yang mempunyai akses kepada teks tetapi hanya boleh memaparkan kandungannya dalam bentuk imej. Proses bermula dengan menggunakan SD untuk menjana imej calon x_k untuk teks y, dan set imej calon yang terhasil dilambangkan dengan K. Menjana imej menggunakan SD melibatkan proses pensampelan rawak, di mana setiap proses penjanaan mungkin berakhir dengan sampel imej sah yang berbeza dalam ruang piksel yang besar. Kepelbagaian pensampelan ini menyediakan kumpulan calon untuk menapis imej terbaik. Selepas itu, model BLIP menjana penerangan teks y’_k untuk setiap imej sampel x_k. Di sini y’_k merujuk kepada teks awal Seekor panda merah sedang merayap di dalam hutan. Kajian kemudiannya menggunakan pengekod teks CLIP untuk mengekstrak ciri teks sumber dan teks yang dijana, masing-masing diwakili oleh  dan

dan  . Tujuan tugasan ini adalah untuk mencari imej calon terbaik x_s yang sepadan dengan semantik teks y. Untuk melakukan ini, kajian perlu membandingkan jarak antara teks yang dijana dan teks input, dan kemudian pilih imej dengan jarak teks berpasangan terkecil, iaitu

. Tujuan tugasan ini adalah untuk mencari imej calon terbaik x_s yang sepadan dengan semantik teks y. Untuk melakukan ini, kajian perlu membandingkan jarak antara teks yang dijana dan teks input, dan kemudian pilih imej dengan jarak teks berpasangan terkecil, iaitu

kajian tersebut percaya bahawa imej x_s boleh menggambarkan dengan terbaik penerangan teks y kerana ia boleh menyampaikan kandungan kepada penerima dengan kehilangan maklumat yang minimum. Selain itu, kajian ini menganggap imej  sepadan dengan teks y sebagai pembentangan rujukan y, dan mengukur imej terbaik sebagai kedekatannya dengan imej rujukan.

sepadan dengan teks y sebagai pembentangan rujukan y, dan mengukur imej terbaik sebagai kedekatannya dengan imej rujukan.

Hasil eksperimen

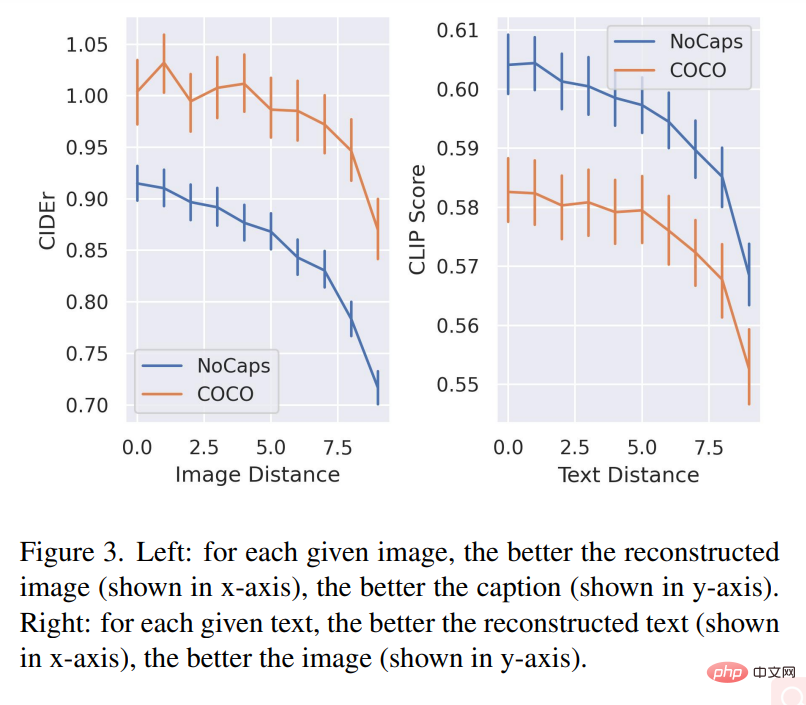

Carta kiri dalam Rajah 3 menunjukkan korelasi antara kualiti pembinaan semula imej dan kualiti teks penerangan pada dua set data. Untuk setiap imej yang diberikan, lebih baik kualiti imej yang dibina semula (ditunjukkan dalam paksi-x), lebih baik kualiti perihalan teks (ditunjukkan dalam paksi-y).

Graf kanan Rajah 3 mendedahkan hubungan antara kualiti teks yang dipulihkan dan kualiti imej yang dijana: untuk setiap teks yang diberikan, penerangan teks yang dibina semula (ditunjukkan pada x lebih baik paksi-y), lebih baik kualiti imej (ditunjukkan pada paksi-y).

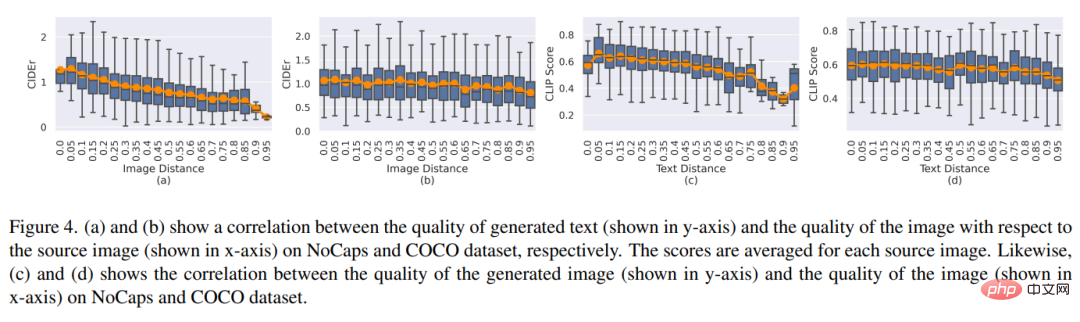

Rajah 4 (a) dan (b) menunjukkan perbezaan antara kualiti pembinaan semula imej dan purata kualiti teks berdasarkan pada hubungan imej sumber antara. Rajah 4(c) dan (d) menunjukkan perkaitan antara jarak teks dan kualiti imej yang dibina semula.

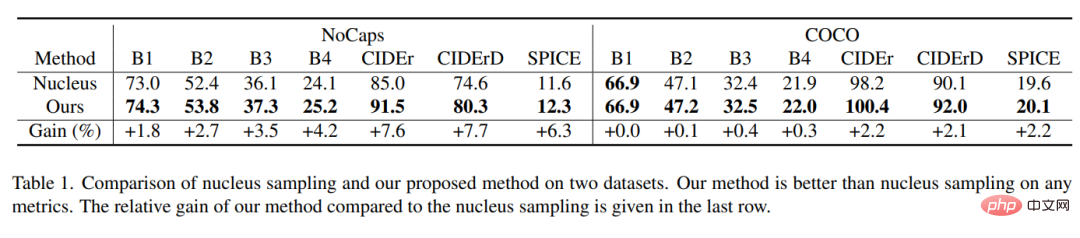

Jadual 1 menunjukkan bahawa kaedah persampelan kajian mengatasi persampelan kernel dalam setiap metrik, model Keuntungan relatif boleh setinggi sebanyak 7.7%.

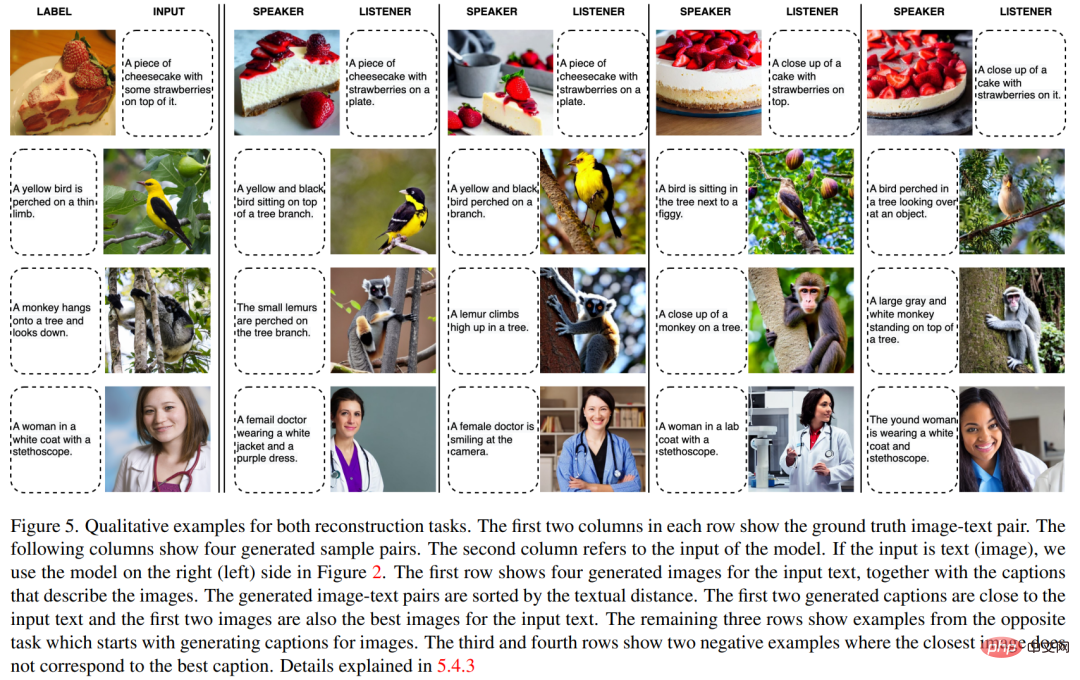

Rajah 5 menunjukkan contoh kualitatif bagi dua tugas pembinaan semula.

Atas ialah kandungan terperinci Bolehkah DALL-E dan Flamingo memahami satu sama lain? Tiga rangkaian saraf SOTA pra-latihan menyatukan imej dan teks. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI