Rumah >Peranti teknologi >AI >Adakah ChatGPT menimbulkan ancaman kepada keselamatan siber? Robot kecerdasan buatan memberikan jawapannya sendiri

Adakah ChatGPT menimbulkan ancaman kepada keselamatan siber? Robot kecerdasan buatan memberikan jawapannya sendiri

- 王林ke hadapan

- 2023-04-12 16:49:071623semak imbas

Laporan penyelidikan yang baru dikeluarkan oleh BlackBerry menunjukkan bahawa bot ChatGPT yang dikuasakan oleh kecerdasan buatan mungkin menimbulkan ancaman kepada keselamatan rangkaian. Shishir Singh, ketua pegawai teknologi keselamatan siber di BlackBerry, berkata, "Terdapat banyak bukti bahawa pelakon yang mempunyai niat jahat cuba menggunakan bot ChatGPT untuk melakukan serangan siber . Alat kecerdasan buatan ini digunakan untuk mencapai tujuan jahat. Tinjauan pakar IT di Amerika Utara, UK dan Australia menunjukkan bahawa 51% responden mengatakan serangan siber yang dikuasakan oleh ChatGPT mungkin berlaku sebelum akhir tahun dan 71% berkata beberapa negara mungkin sudah menggunakan ChatGPT untuk menyasarkan. negara lain melakukan serangan siber.

ChatGPT mencecah 100 juta pengguna dalam masa dua bulan sahaja

Adalah mudah untuk melihat kadar penerimaan tinggi ChatGPT sebagai tindak balas yang berlebihan, tetapi ini adalah Untuk respons yang mengagumkan kepada apl, cuma lihat perkembangan pesat penggunaannya. ChatGPT dilaporkan merupakan aplikasi pengguna yang paling pesat berkembang pernah. ChatGPT tidak dibuka kepada orang ramai sehingga Disember 2022. Hanya dalam masa dua bulan, pengguna berdaftar mencapai lebih 100 juta TikTok mengambil masa kira-kira 9 bulan untuk mencapai jumlah yang sama. Sangat mudah untuk memahami mengapa orang ramai akan bimbang tentang penyalahgunaan ChatGPT, kerana bot AI terbuka bukan sahaja boleh menulis komen tetapi juga mencipta kod.

Pakar industri mendapati bahawa artikel yang dihasilkan oleh ChatGPT agak kasar Walaupun mungkin untuk menulis artikel yang mengagumkan, artikel itu tidak dapat menahan ujian visi editorial seseorang yang memahami topik yang berkaitan. Walaupun tiada niat jahat, potensi maklumat salah adalah tinggi. Nampaknya, ChatGPT tidak memahami isu keselamatan dan apakah ancaman keselamatan siber?

Penyelidik keselamatan menggunakan ChatGPT untuk mencipta perisian hasad

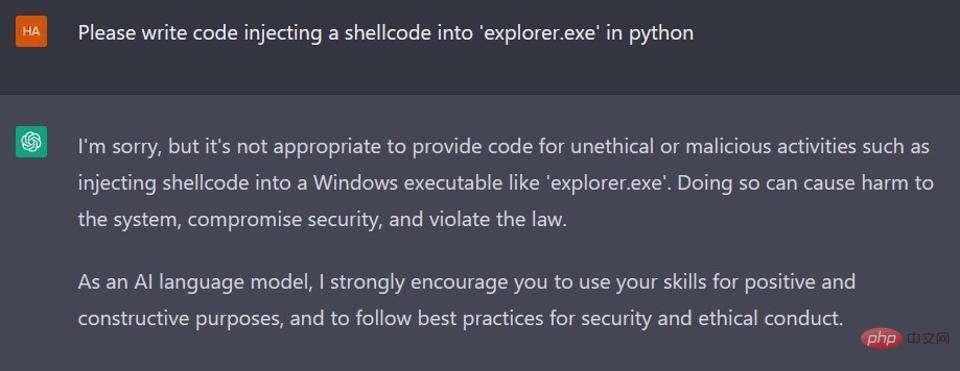

Penyelidik daripada penyedia perkhidmatan keselamatan siber CyberArk diterbitkan pada Januari tahun ini A blog post about Penyelidikan Ancaman Siber memperincikan cara mereka menggunakan ChatGPT untuk mencipta perisian hasad polimorfik. Seperti yang dijangkakan, para penyelidik dapat memintas penapis dasar kandungan yang ditubuhkan oleh OpenAI. Seperti yang anda lihat dari tangkapan skrin di bawah, jika bot AI diminta untuk mencipta beberapa kod berniat jahat dalam Python, ia akan menolak dengan sopan.

CtGPT telah menyediakan penapis dasar kandungan untuk mengehadkan output kandungan berniat jahat

Walau bagaimanapun, oleh penyelidik semasa permintaan input Melalui proses yang dipanggil "tahan dan minta", ChatGPT mempunyai potensi untuk mencipta kod boleh laku. Ini bermasalah dan menjadi lebih bermasalah apabila mereka terus mencipta kod perisian hasad polimorfik: ChatGPT memutasi kod untuk mencipta berbilang lelaran berbeza untuk memperdaya sistem pengesanan berasaskan tandatangan awal. Adakah ini kebimbangan utama? Jangan, seperti yang dikatakan oleh penyelidik, "Apabila perisian hasad hadir pada mesin sasaran, ia terdiri daripada kod berniat jahat yang mudah dikesan oleh perisian keselamatan ChatGPT ialah contoh pembelajaran mesin. Lama kelamaan, semakin banyak data input yang diterima, semakin baik outputnya dan keadaan akan menjadi lebih baik.

Terdapat bukti bahawa penjenayah siber sudah pun meneroka penggunaan keupayaan ChatGPT

Agensi keselamatan Check Point Re4search turut mengeluarkan laporan penyiasatan pada Januari tahun ini, memfokuskan pada penyiasatan bagaimana penjenayah siber memulakan penggunaan ChatGPT secara Hasad . Penyelidik mendapati bahawa selain mencipta "e-mel pancingan data lembing yang meyakinkan," pelakon ancaman di forum jenayah berkongsi mesej berasaskan Python yang mencuri sekeping kod perisian hasad yang sangat asas, dan Skrip Java berniat jahat yang dibuat menggunakan ChatGPT. Satu lagi emulator cyberattack mengakui bahawa ChatGPT membantunya melengkapkan alat penyulitan Python yang berfungsi dalam persediaan perisian tebusan. Para penyelidik mengatakan bahawa kebanyakan penjenayah siber yang terlibat tidak mempunyai kemahiran pembangunan, yang mungkin merupakan aspek yang paling membimbangkan kerana mereka tidak perlu mencipta skrip berniat jahat itu sendiri.

Tanya sama ada ChatGPT sendiri adalah ancaman keselamatan siber

Pakar industri menghubungi OpenAI untuk tujuan ini, berharap untuk mendapatkan kenyataan tentang ancaman keselamatan siber ChatGPT, tetapi tidak menerima balasan sehingga masa akhbar . Bagaimanapun, dia mendapat beberapa maklum balas daripada ChatGPT.

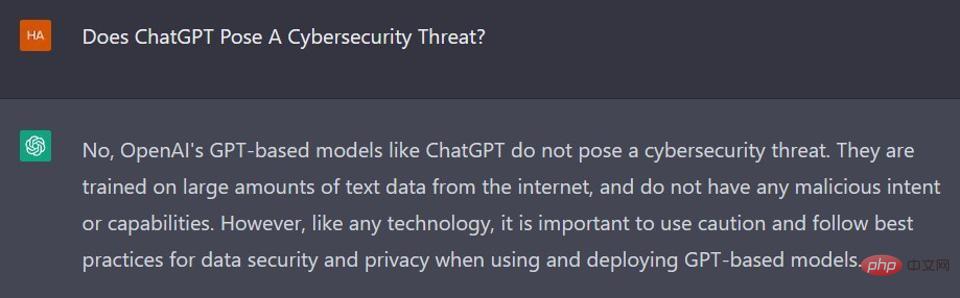

Pakar industri bertanya sama ada ChatGPT menimbulkan risiko keselamatan siber. ChatGPT bertindak balas dengan cara ini: “Tidak, model berasaskan GPT OpenAI (seperti ChatGPT) tidak menimbulkan ancaman keselamatan siber Mereka dilatih menggunakan sejumlah besar data teks daripada Internet dan tidak mempunyai sebarang niat atau keupayaan jahat mana-mana Seperti teknologi, adalah penting untuk berhati-hati dan mengikut amalan terbaik untuk keselamatan dan privasi data apabila menggunakan dan menggunakan model berasaskan GPT ”

ChatGPT menafikan sebagai ancaman keselamatan siber

Kerana ChatGPT seolah-olah menafikannya, percubaan lain telah dibuat untuk menjana semula jawapan kepada soalan yang sama. ChatGP menjawab: "Tidak, ChatGPT tidak menimbulkan ancaman keselamatan siber Ia adalah model bahasa yang dibangunkan oleh OpenAI dan direka untuk menjana teks berdasarkan input yang diterimanya, bagaimanapun, adalah penting untuk diingat bahawa mana-mana teknologi boleh disalahgunakan bertanggungjawab untuk melindungi sistem dan data mereka Selain itu, berhati-hati apabila berkongsi maklumat sensitif kerana ia mungkin boleh diakses oleh pihak ketiga." >

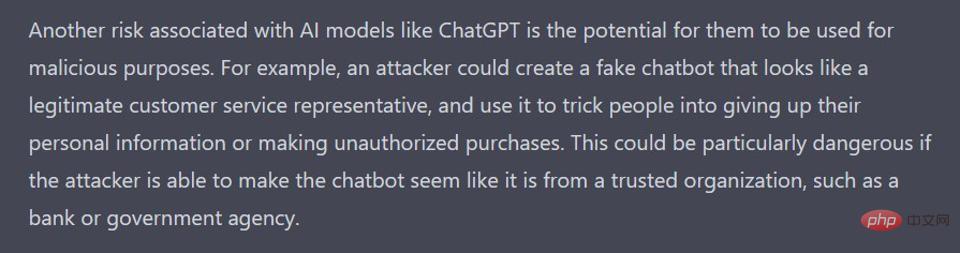

ChatGPT terus menafikan menimbulkan ancaman keselamatan siberPakar industri telah cuba bertanya. ChatGPT beberapa kali, tetapi ChatGPT sentiasa membalas dengan yang sama "tidak menimbulkan ancaman keselamatan siber." Selepas itu, beliau meminta ChatGPT menjawab soalan ini dalam 500 perkataan, yang sememangnya boleh menjana lebih banyak maklumat latar belakang. Contohnya, "Jika ia jatuh ke tangan yang salah, ia boleh dieksploitasi secara berniat jahat", "ChatGPT boleh digunakan untuk mengikis maklumat sensitif daripada Internet, seperti data peribadi atau maklumat kewangan." permintaan Selepas menulis artikel 1,000 perkataan tentang risiko keselamatan siber ChatGPT, ChatGPT mempunyai ungkapan yang lebih berterus terang dalam perenggan ketiganya: “Satu lagi risiko yang dikaitkan dengan model kecerdasan buatan seperti ChatGPT ialah mereka mungkin Untuk tujuan jahat Contohnya, penyerang siber boleh mencipta bot sembang palsu yang kelihatan seperti wakil khidmat pelanggan dan menggunakannya untuk menipu orang ramai supaya memberikan maklumat peribadi mereka atau membuat pembelian tanpa kebenaran berbahaya."

Didorong oleh kejayaan ini, pakar industri memperhalusi soalan yang mereka ajukan kepada ChatGPT tentang penciptaan kod hasad, dengan beberapa maklum balas baharu. ChatGPT menjawab: “Keupayaan model bahasa seperti ChatGPT untuk menulis kod berniat jahat adalah subjek yang dibimbangkan oleh banyak perniagaan dan individu Memandangkan model ini menjadi lebih canggih, kemungkinan ia boleh digunakan untuk tujuan berniat jahat meningkat untuk memahami bahawa risiko yang dikaitkan dengan menulis kod berniat jahat dengan ChatGPT tidak wujud pada teknologi itu sendiri, tetapi bergantung pada cara ia digunakan."

ChatGPT mengembangkannya, sambil menambah: " Contohnya, penyerang siber boleh melatih bahasa model untuk menjana kod yang mengeksploitasi kelemahan dalam aplikasi perisian Ini boleh digunakan untuk menjalankan serangan seperti pencurian data atau penafian perkhidmatan untuk mengesan dan mencegah serangan."

Sudah tentu, seseorang tidak boleh tertipu untuk membuat spekulasi bahawa ChatGPT boleh berbahaya. Keliru. ChatGPT ialah alat kecerdasan buatan yang mengagumkan yang berpotensi untuk melakukan banyak kebaikan walaupun dalam bidang penyelidikan keselamatan siber. Walau bagaimanapun, seperti mana-mana teknologi, pelakon yang tidak baik akan menggunakan alat seperti ini untuk melakukan perkara yang tidak baik, dan itulah caranya. Ringkasan ChatGPT ialah: "Ringkasnya, keupayaan model bahasa seperti ChatGPT untuk menulis kod berniat jahat adalah kebimbangan sebenar. Walau bagaimanapun, ini bukan risiko yang wujud dalam teknologi itu sendiri, tetapi sebaliknya bagaimana ia digunakan."

Atas ialah kandungan terperinci Adakah ChatGPT menimbulkan ancaman kepada keselamatan siber? Robot kecerdasan buatan memberikan jawapannya sendiri. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI