Rumah >Peranti teknologi >AI >Dua penyelidik Google China mengeluarkan model 'pemahaman UI mudah alih' visual yang pertama, empat tugas utama untuk menyegarkan SOTA

Dua penyelidik Google China mengeluarkan model 'pemahaman UI mudah alih' visual yang pertama, empat tugas utama untuk menyegarkan SOTA

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 16:40:031439semak imbas

Untuk AI, "bermain dengan telefon mudah alih" bukanlah tugas yang mudah Hanya mengenal pasti pelbagai antara muka pengguna (UI) adalah masalah besar: bukan sahaja jenis setiap komponen mesti dikenal pasti, tetapi juga mengikut penggunaan simbolnya. dan kedudukan untuk menentukan fungsi komponen.

Pemahaman tentang UI peranti mudah alih boleh membantu merealisasikan pelbagai tugas interaksi manusia-komputer, seperti automasi UI.

UI mudah alih pemodelan kerja sebelum ini biasanya bergantung pada maklumat hierarki paparan skrin, menggunakan secara langsung data struktur UI, dan dengan itu memintas masalah mengenal pasti komponen bermula daripada piksel skrin.

Walau bagaimanapun, hierarki paparan tidak tersedia dalam semua senario Kaedah ini biasanya menghasilkan hasil yang salah disebabkan huraian objek yang hilang atau maklumat struktur yang salah letak, jadi walaupun menggunakan hierarki paparan boleh meningkatkan prestasi jangka pendek, tetapi akhirnya boleh menghalang. kebolehgunaan dan prestasi generalisasi model.

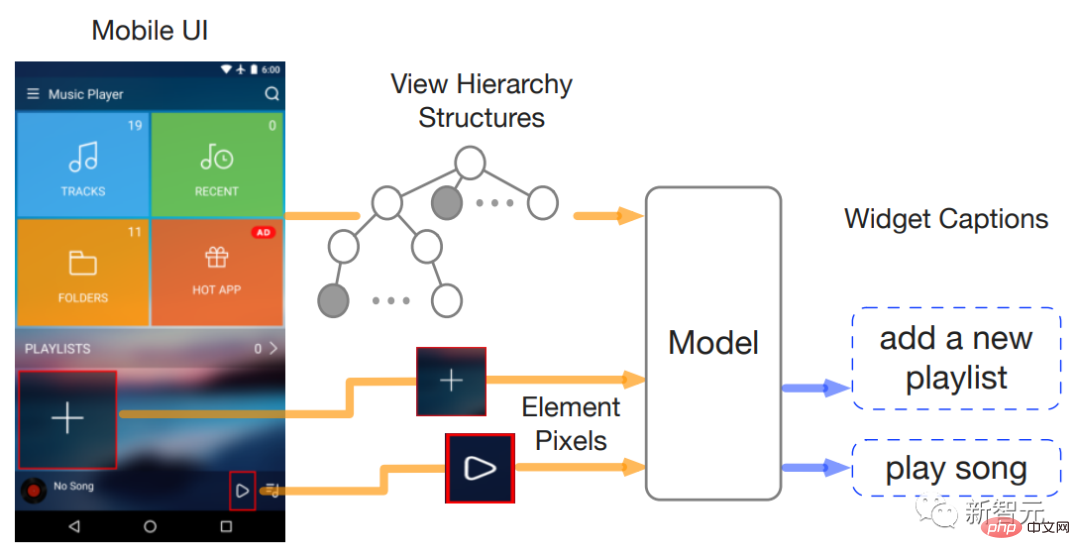

Baru-baru ini, dua penyelidik dari Google Research mencadangkan Spotlight, kaedah visual semata-mata yang boleh digunakan untuk pemahaman UI mudah alih, berdasarkan model bahasa visual, ia hanya perlu menggabungkan tangkapan skrin antara muka pengguna dan rasa aktif kawasan yang diminati (fokus) boleh digunakan sebagai input.

Pautan kertas: https://arxiv.org/pdf/2209.14927.pdf

Seni bina umum Spotlight sangat Mudah diperluaskan dan mampu melaksanakan pelbagai tugas pemodelan antara muka pengguna.

Hasil percubaan dalam artikel ini menunjukkan bahawa model Spotlight telah mencapai prestasi sota pada beberapa tugasan antara muka pengguna yang mewakili, berjaya mengatasi kaedah sebelumnya yang menggunakan tangkapan skrin dan melihat hierarki sebagai input.

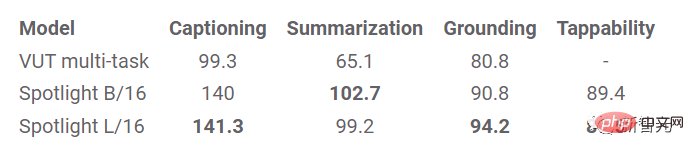

Selain itu, artikel itu juga meneroka pembelajaran berbilang tugas dan keupayaan segera beberapa pukulan model Spotlight, dan juga menunjukkan hasil percubaan yang menjanjikan ke arah pembelajaran berbilang tugas.

Pengarang kertas kerja, Yang Li, ialah penyelidik kanan di Pusat Penyelidikan Google dan ahli fakulti gabungan CSE di Universiti Washington Beliau menerima PhD dalam sains komputer dari Akademi Sains China dan menjalankan penyelidikan pasca doktoral di EECS di University of California, Berkeley. Beliau mengetuai pembangunan Next Android App Prediction, merupakan perintis dalam pembelajaran mesin interaktif pada peranti pada Android, membangunkan carian gerak isyarat dan banyak lagi.

Spotlight: Memahami Antara Muka Mudah Alih

Pemahaman pengiraan antara muka pengguna ialah langkah kritikal dalam mendayakan gelagat UI pintar.

Sebelum ini, pasukan telah mengkaji pelbagai tugas pemodelan UI, termasuk tajuk tetingkap (widget), ringkasan skrin (ringkasan skrin) dan pembumian perintah ini menyelesaikan automasi dan kebolehpercayaan senario interaksi yang berbeza .

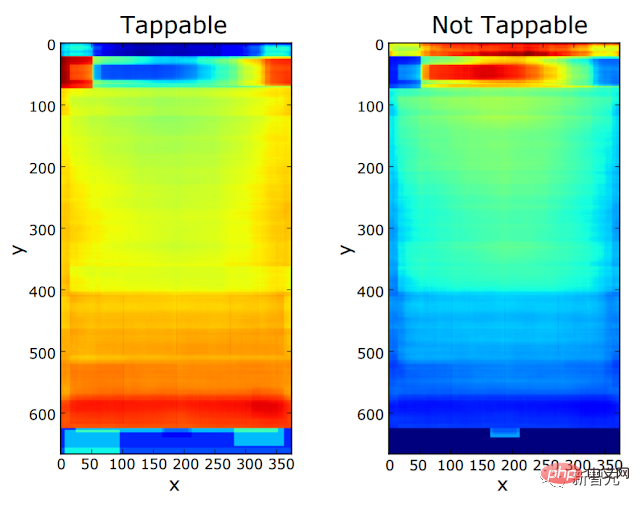

Tindakan susulan juga menggunakan ciri ini untuk menunjukkan cara pembelajaran mesin boleh membantu "pengamal pengalaman pengguna" meningkatkan kualiti UI dengan mendiagnosis kekeliruan kebolehklikan dan memberikan idea untuk menambah baik reka bentuk UI, yang semuanya konsisten dengan kerja dalam bidang lain bersama-sama menunjukkan bagaimana rangkaian saraf dalam berpotensi mengubah pengalaman pengguna akhir dan amalan reka bentuk interaksi.

Walaupun tahap kejayaan tertentu telah dicapai dalam mengendalikan "tugas UI tunggal", soalan seterusnya ialah: sama ada ia boleh dilakukan dari " khusus Tingkatkan keupayaan pemprosesan "UI umum" dalam tugas "Pengecaman UI".

Model Spotlight juga merupakan percubaan pertama untuk menyelesaikan masalah ini Para penyelidik membangunkan model berbilang tugas untuk mengendalikan satu siri tugasan UI secara serentak Walaupun beberapa kemajuan telah dicapai dalam kerja masih ada masalah.

Model UI sebelumnya sangat bergantung pada hierarki paparan UI, iaitu struktur atau metadata skrin UI mudah alih, seperti Model Objek Dokumen pada halaman web skrin. Butiran termasuk jenis, kandungan teks, lokasi, dsb.

Metadata ini memberikan model terdahulu kelebihan berbanding model visual semata-mata, tetapi kebolehcapaian data hierarki paparan merupakan cabaran utama, dengan masalah seperti kehilangan penerangan objek atau penjajaran maklumat struktur yang tidak betul sering berlaku.

Jadi, walaupun terdapat faedah jangka pendek untuk menggunakan hierarki paparan, ini mungkin akhirnya menghalang prestasi dan kebolehgunaan model anda. Selain itu, model terdahulu perlu mengendalikan maklumat heterogen merentas set data dan tugasan UI, selalunya menghasilkan seni bina model yang lebih kompleks yang akhirnya sukar untuk skala atau umum merentas tugas.

Model Spotlight

Pendekatan Spotlight visual semata-mata bertujuan untuk mencapai keupayaan pemahaman antara muka pengguna universal sepenuhnya daripada piksel mentah.

Penyelidik memperkenalkan pendekatan bersatu untuk mewakili tugas UI yang berbeza, di mana maklumat boleh diwakili secara universal ke dalam dua mod teras: visual dan lisan, di mana mod visual menangkap perkara yang pengguna lihat daripada skrin UI Kandungan dan corak bahasa boleh menjadi bahasa semula jadi atau sebarang urutan token yang berkaitan dengan tugas.

Input kepada model Spotlight ialah triplet: tangkapan skrin, kawasan yang diminati pada skrin dan penerangan teks tugasan ialah penerangan teks atau respons tentang kawasan yang diminati.

Perwakilan input dan output model yang ringkas ini adalah lebih umum, boleh digunakan pada pelbagai tugas UI dan boleh diperluaskan kepada pelbagai seni bina model.

Reka bentuk model boleh menjalankan satu siri strategi dan tetapan pembelajaran, daripada menyempurnakan tugasan khusus kepada pembelajaran berbilang tugas dan sedikit- pembelajaran pukulan.

Model lampu sorotan boleh memanfaatkan blok binaan seni bina sedia ada, seperti ViT dan T5, yang telah dilatih dalam bidang bahasa visual am sumber tinggi dan boleh dibina terus di atas model domain umum ini.

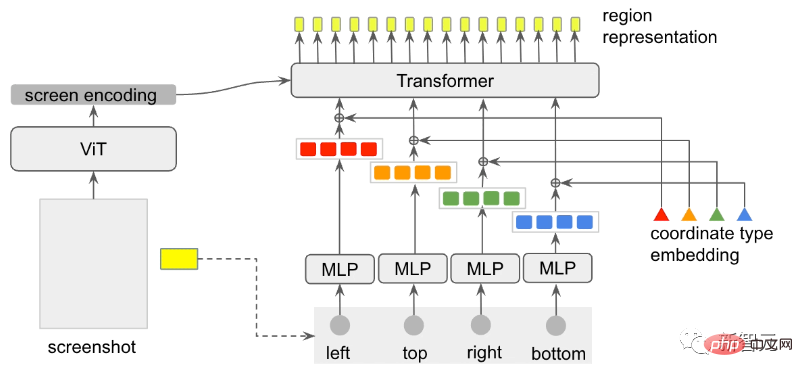

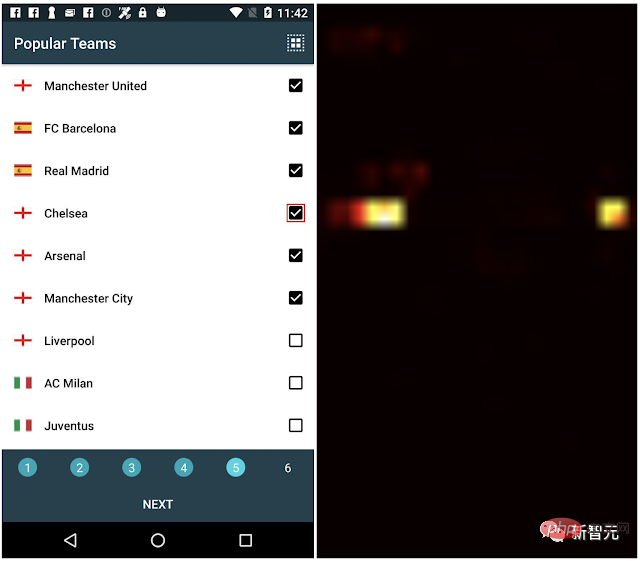

Oleh kerana tugasan UI biasanya berkaitan dengan objek atau kawasan tertentu pada skrin, model perlu dapat memfokus pada objek atau kawasan yang diminati Para penyelidik memperkenalkan pengekstrak kawasan fokus (Focus Region Extractor ) ke dalam model bahasa visual , membolehkan model memfokus pada kawasan tersebut berdasarkan konteks skrin.

Penyelidik juga mereka bentuk Rumusan Wilayah untuk mendapatkan perwakilan terpendam bagi kawasan skrin berdasarkan pengekodan ViT dengan menggunakan pertanyaan perhatian yang dijana oleh kotak sempadan rantau.

Khususnya, kotak sempadan untuk setiap koordinat (nilai skalar, termasuk kiri, atas, kanan atau bawah), diwakili sebagai kotak kuning dalam tangkapan skrin.

Mula-mula tukar input kepada satu set vektor padat melalui perceptron berbilang lapisan (MLP), dan kemudian suapkannya semula kepada model Transformer untuk mendapatkan vektor benam (benam jenis koordinat) mengikut koordinat jenis. Vektor padat dan benam jenis koordinat yang sepadan adalah berkod warna untuk menunjukkan hubungannya dengan setiap nilai koordinat.

Kemudian menyelaraskan pertanyaan mengambil bahagian dalam pengekodan skrin output ViT melalui "cross-attention", dan akhirnya output perhatian Transformer digunakan sebagai Regional perwakilan penyahkodan hiliran T5.

Hasil eksperimen

Para penyelidik menggunakan dua set data tidak berlabel untuk melatih model Spotlight, yang merupakan set data dalaman berdasarkan korpus C4 dan set data mudah alih dalaman , yang mengandungi a sejumlah 2.5 juta skrin UI mudah alih dan 80 juta halaman web.

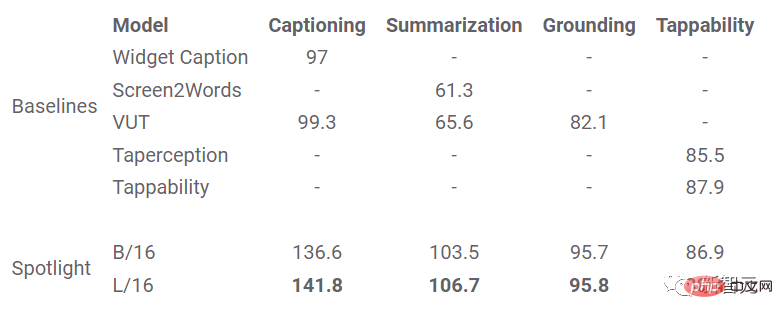

Kemudian model pra-latihan diperhalusi untuk empat tugasan hiliran: tajuk, ringkasan, grouding dan kebolehklikan.

Untuk tugasan kapsyen tetingkap dan ringkasan skrin, gunakan metrik CIDEr untuk mengukur keserupaan perihalan teks model dengan set rujukan yang dibuat oleh penilai untuk tugas pembumian perintah, metrik ketepatan adalah milik model respons kepada pengguna Peratusan perintah yang berjaya mengesan objek sasaran untuk ramalan kebolehklikan, gunakan skor F1 untuk mengukur keupayaan model untuk membezakan objek boleh klik daripada objek tidak boleh klik.

Dalam percubaan, Spotlight dibandingkan dengan beberapa model penanda aras: WidgetCaption menggunakan hierarki paparan dan imej setiap objek UI untuk menjana penerangan teks untuk objek; Screen2Words menggunakan hierarki paparan dan tangkapan skrin serta fungsi kebolehaksesan (seperti Program aplikasi Penerangan) untuk menjana ringkasan untuk skrin; VUT menggabungkan tangkapan skrin dan hierarki paparan untuk melaksanakan pelbagai tugas; dalam empat tugas pemodelan UI.

Rujukan:

https://www.php.cn/link/64517d8435994992e682b3e4aa0a0661Atas ialah kandungan terperinci Dua penyelidik Google China mengeluarkan model 'pemahaman UI mudah alih' visual yang pertama, empat tugas utama untuk menyegarkan SOTA. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI