Rumah >Peranti teknologi >AI >Ketua Saintis NVIDIA: Perkakasan pembelajaran mendalam masa lalu, masa kini dan masa depan

Ketua Saintis NVIDIA: Perkakasan pembelajaran mendalam masa lalu, masa kini dan masa depan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 15:07:072027semak imbas

Sepuluh tahun yang lalu telah menjadi "dekad emas" pembelajaran mendalam Ia telah mengubah sepenuhnya cara manusia bekerja dan berhibur, dan telah digunakan secara meluas dalam pelbagai industri seperti penjagaan perubatan, pendidikan dan reka bentuk produk. . Kemajuan dalam perkakasan pengkomputeran, terutamanya inovasi dalam GPU.

Kejayaan pelaksanaan teknologi pembelajaran mendalam bergantung pada tiga elemen utama: Yang pertama ialah algoritma. Kebanyakan algoritma pembelajaran mendalam seperti rangkaian saraf dalam, rangkaian saraf konvolusi, algoritma perambatan belakang, dan keturunan kecerunan stokastik telah dicadangkan pada tahun 1980-an atau lebih awal lagi.

Yang kedua ialah set data. Set data yang digunakan untuk melatih rangkaian saraf mestilah cukup besar untuk rangkaian saraf mengatasi teknik lain. Hanya pada awal abad ke-21 set data besar seperti Pascal dan ImageNet tersedia. Yang ketiga ialah perkakasan. Hanya dengan pembangunan perkakasan matang masa yang diperlukan untuk melatih rangkaian saraf yang besar dengan set data yang besar boleh dikawal dalam julat yang munasabah. Industri umumnya percaya bahawa masa latihan yang lebih "munasabah" adalah kira-kira dua minggu.

Pada ketika ini, api padang rumput telah menyala dalam bidang pembelajaran mendalam. Jika algoritma dan set data dianggap sebagai bahan api campuran pembelajaran mendalam, maka GPU adalah percikan yang menyalakannya Apabila GPU berkuasa boleh digunakan untuk melatih rangkaian, teknologi pembelajaran mendalam menjadi praktikal.

Sejak itu, pembelajaran mendalam telah menggantikan algoritma lain dan telah digunakan secara meluas dalam bidang seperti klasifikasi imej, pengesanan imej, pengecaman pertuturan, pemprosesan bahasa semula jadi, analisis siri masa, dan juga dalam Pergi dan catur Anda juga boleh melihatnya. Memandangkan pembelajaran mendalam meresap ke dalam semua aspek kehidupan manusia, latihan model dan inferens telah semakin menuntut perkakasan.

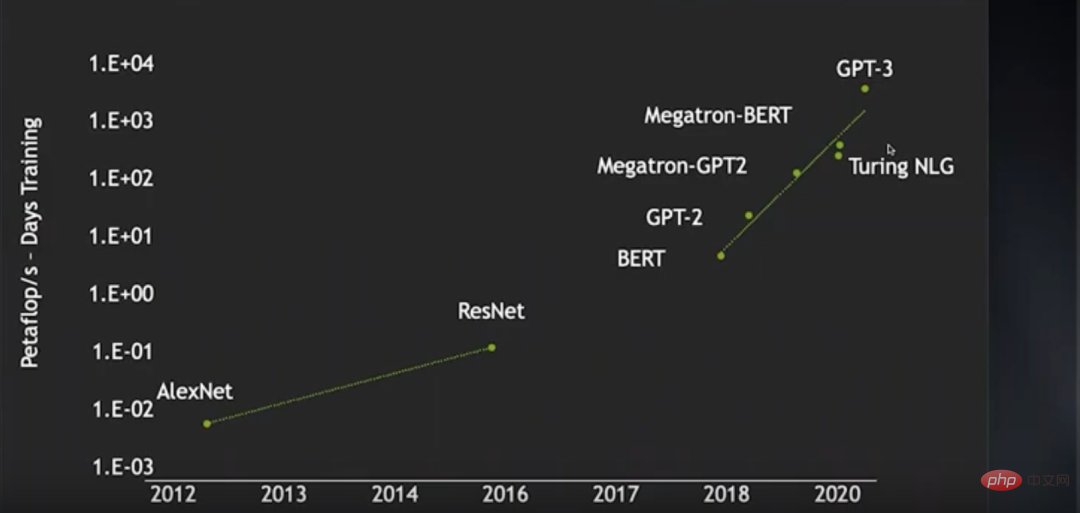

Dari kemunculan AlexNet pada 2012 hingga kemunculan ResNet pada 2016, latihan algoritma rangkaian neural imej Penggunaan kuasa (dalam petaflop/s-hari) telah meningkat hampir 2 susunan magnitud, manakala daripada BERT pada 2018 kepada GPT-3 dalam beberapa tahun kebelakangan ini, penggunaan kuasa pengkomputeran latihan telah meningkat hampir 4 susunan magnitud. Dalam tempoh ini, berkat kemajuan teknologi tertentu, kecekapan latihan rangkaian saraf telah dipertingkatkan dengan ketara, sekali gus menjimatkan banyak kuasa pengkomputeran, jika tidak, peningkatan dalam penggunaan kuasa pengkomputeran akan menjadi lebih keterlaluan.

Para penyelidik ingin melatih model bahasa yang lebih besar dengan set data bahasa tanpa pengawasan yang lebih besar Walau bagaimanapun, walaupun mereka sudah mempunyai gugusan GPU 4000-nod, sukar untuk dilatih dalam lingkungan yang munasabah masa latihan. Operasi yang boleh diproses masih sangat terhad. Ini bermakna betapa pantas teknologi pembelajaran mendalam berkembang bergantung pada kelajuan perkakasan berkembang.

Kini, model pembelajaran mendalam bukan sahaja menjadi semakin kompleks, tetapi juga mempunyai rangkaian aplikasi yang semakin luas. Oleh itu, terdapat keperluan untuk terus meningkatkan prestasi pembelajaran mendalam. Jadi, bagaimanakah perkakasan pembelajaran mendalam boleh terus bertambah baik? Ketua Saintis NVIDIA, Bill Dally sudah pasti berkuasa untuk menjawab soalan ini Sebelum keluaran H100 GPU, beliau menyemak status semasa perkakasan pembelajaran mendalam dalam ucapan dan membincangkan peningkatan berterusan prestasi apabila Undang-undang Moore gagal. . Beberapa arah pengembangan. Komuniti OneFlow menyusun ini.

1 Sejarah evolusi seni bina GPU

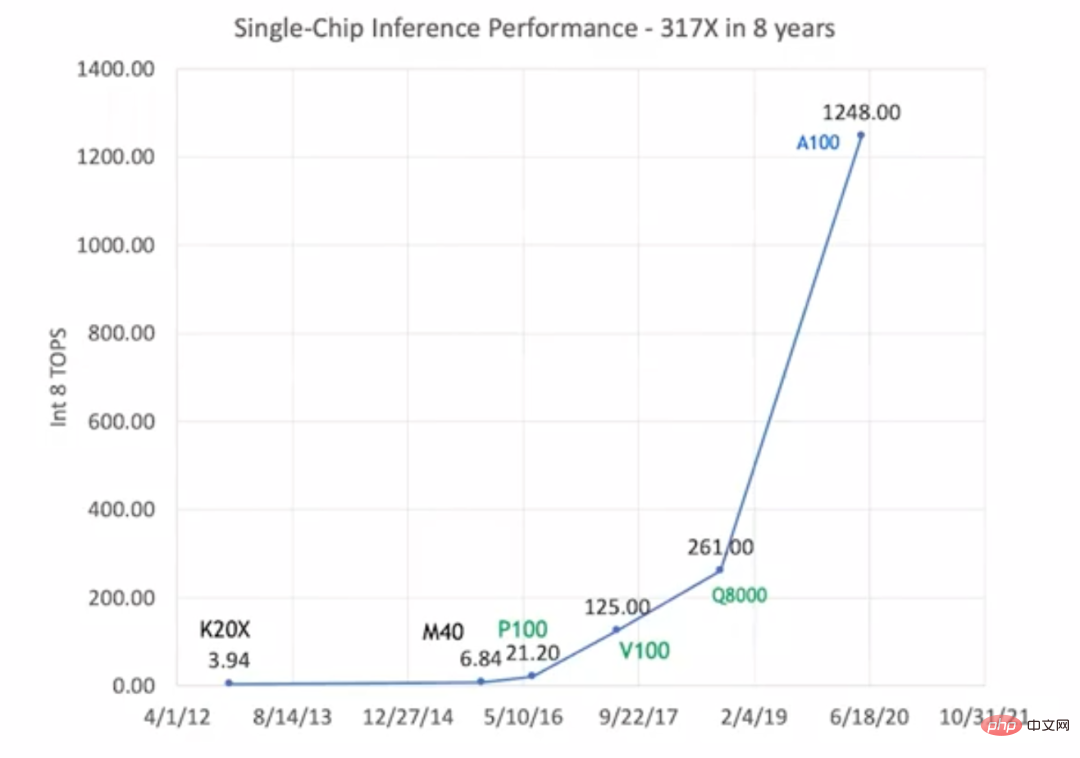

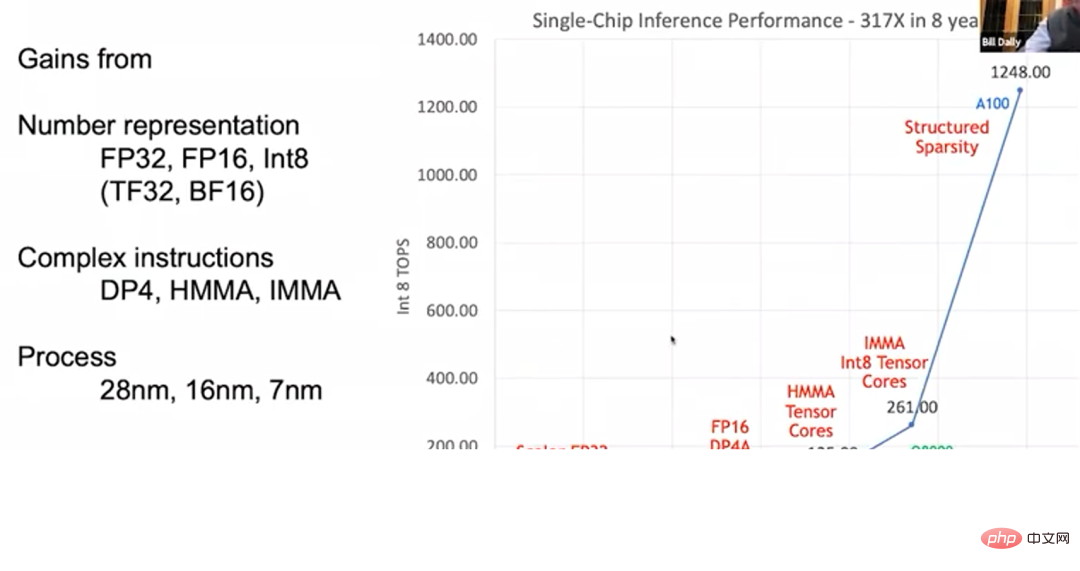

Daripada K20X pada 2012 kepada A100 pada 2020, prestasi inferens GPU Meningkat kepada 317 kali ganda nilai asal. Inilah yang kita panggil "Huang's Law", dan kadar pembangunan ini jauh lebih cepat daripada "Moore's Law".

Prestasi inferens GPU dipertingkatkan Tetapi tidak seperti "Moore's Law", dalam "Huang's Law", peningkatan prestasi GPU ialah tidak bergantung sepenuhnya kepada kemajuan dalam teknologi proses. Gambar di atas menandakan jenis GPU ini dalam warna hitam, hijau dan biru, yang mewakili bahawa mereka menggunakan tiga teknologi proses yang berbeza. K20X dan M40 awal menggunakan proses 28nm; P100, V100 dan Q8000 menggunakan proses 16nm; Kemajuan dalam teknologi proses hanya boleh meningkatkan prestasi GPU kepada 1.5 atau 2 kali ganda tahap asalnya. Peningkatan prestasi keseluruhan 317 kali ganda kebanyakannya dikaitkan dengan peningkatan seni bina GPU dan reka bentuk litar.

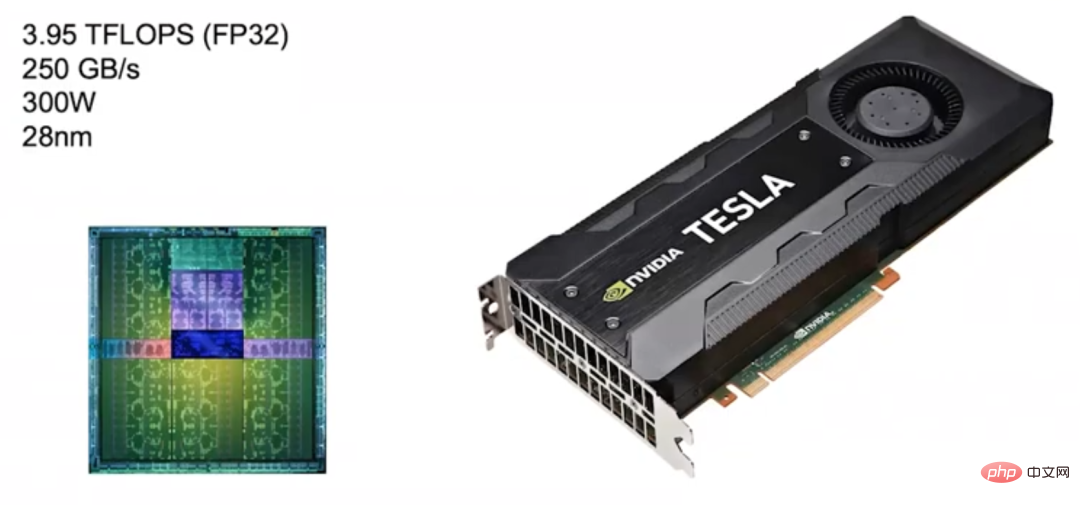

Pada tahun 2012, Nvidia melancarkan GPU seni bina Kepler, tetapi ia tidak direka khusus untuk pembelajaran mendalam. Nvidia hanya mula terlibat dengan pembelajaran mendalam pada tahun 2010, dan pada masa itu ia masih belum mempertimbangkan untuk menyesuaikan produk GPU untuk pembelajaran mendalam.

Kepler (2012) Kepler Senario penggunaan sasaran ialah pemprosesan imej dan pengkomputeran berprestasi tinggi, tetapi ia digunakan terutamanya untuk pemprosesan imej. Oleh itu, ia dicirikan oleh kuasa pengkomputeran titik terapung yang tinggi, dengan kelajuan pengiraan FP32 (pengiraan titik terapung ketepatan tunggal) mencecah hampir 4 TFLOPS dan lebar jalur memori mencapai 250 GB/s. Berdasarkan prestasi cemerlang Kepler, NVIDIA juga menganggapnya sebagai garis dasar untuk produknya sendiri.

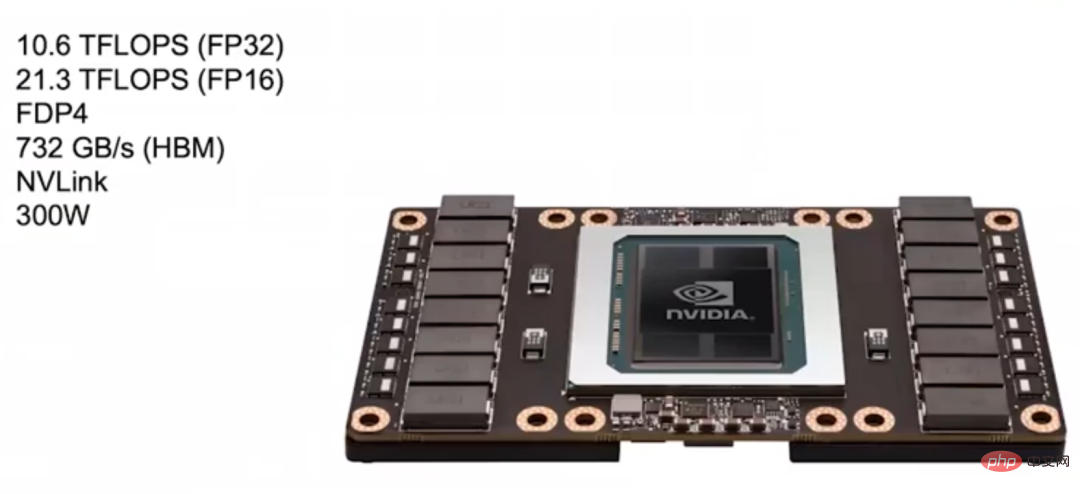

Pascal (2016) Kemudian, Nvidia melancarkannya pada 2016 Dengan seni bina Pascal, reka bentuknya lebih sesuai untuk pembelajaran mendalam. Selepas beberapa penyelidikan, NVIDIA mendapati bahawa banyak rangkaian saraf boleh dilatih dengan FP16 (pengiraan titik terapung separuh ketepatan), jadi kebanyakan model seni bina Pascal menyokong pengiraan FP16.

Kelajuan pengiraan FP32 GPU Pascal ini dalam gambar di bawah boleh mencapai 10.6 TFLOPS, yang jauh lebih tinggi daripada GPU Kepler sebelumnya, dan pengiraan FP16nya lebih pantas, dengan kelajuan FP32 dua kali.

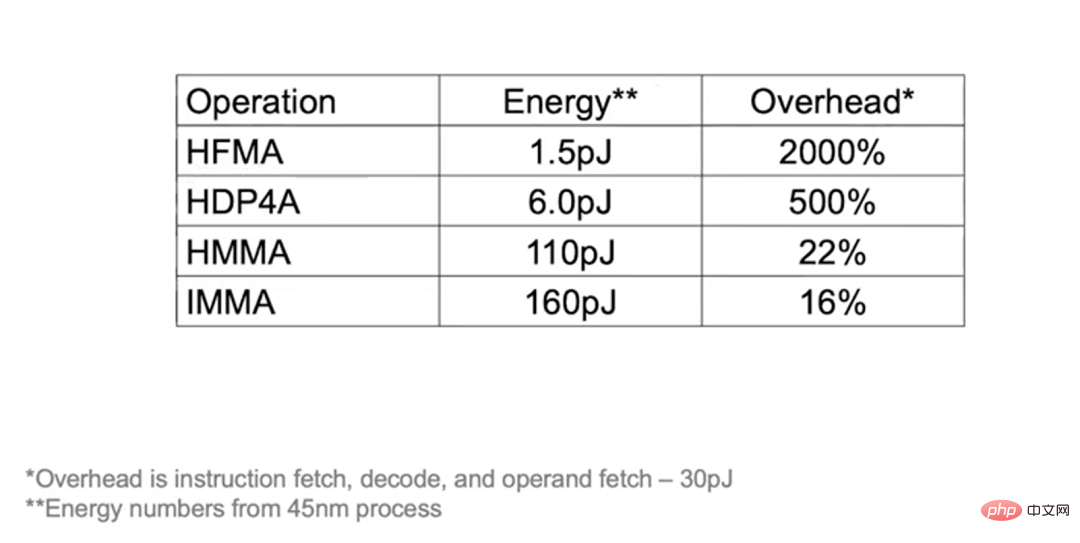

Seni bina Pascal juga menyokong arahan yang lebih kompleks, seperti FDP4, supaya overhed arahan pengambilan, penyahkodan dan operan pengambilan boleh dilunaskan kepada 8 operasi aritmetik. Berbanding dengan arahan gandakan-tambah (Fuse Multiply-Add) sebelumnya yang hanya boleh memperuntukkan overhed kepada dua operasi aritmetik, seni bina Pascal boleh mengurangkan penggunaan tenaga yang disebabkan oleh overhed tambahan dan sebaliknya menggunakannya untuk operasi matematik.

Seni bina Pascal juga menggunakan memori video HBM, dengan lebar jalur 732 GB/s, iaitu 3 kali ganda daripada Kepler. Alasan untuk meningkatkan lebar jalur ialah jalur lebar memori merupakan hambatan utama dalam meningkatkan prestasi pembelajaran mendalam. Selain itu, Pascal menggunakan NVLink untuk menyambungkan lebih banyak mesin dan kluster GPU untuk melengkapkan latihan berskala besar dengan lebih baik.

Sistem DGX-1 yang dilancarkan oleh NVIDIA untuk pembelajaran mendalam menggunakan 8 GPU berdasarkan seni bina Pascal.

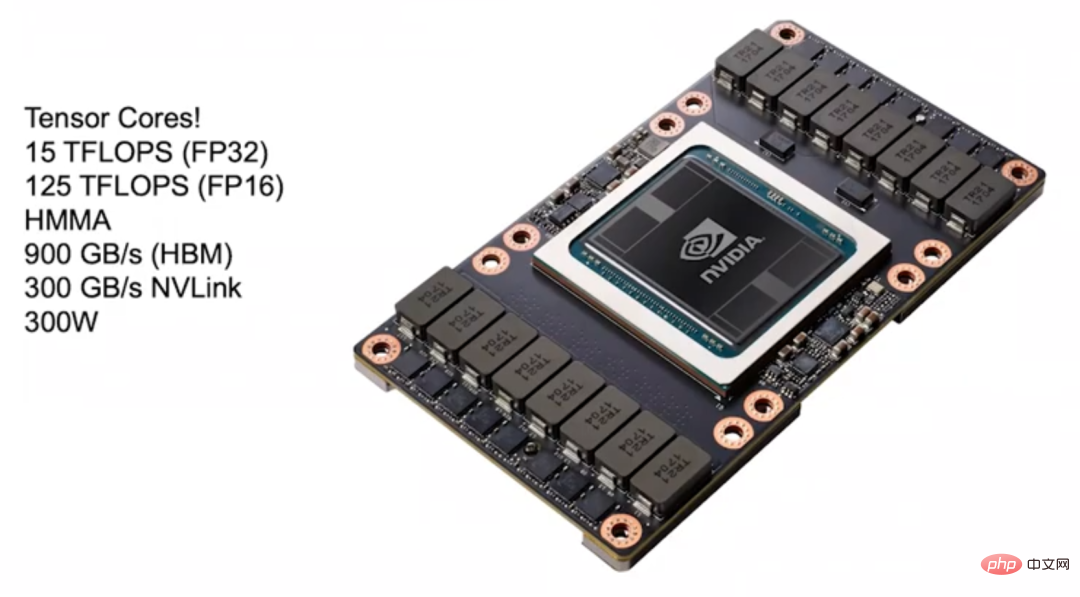

Volta (2017) 2017 Pada 2017, NVIDIA melancarkan seni bina Volta yang sesuai untuk pembelajaran mendalam Salah satu fokus reka bentuknya adalah untuk melunaskan overhed arahan dengan lebih baik. Teras Tensor diperkenalkan dalam seni bina Volta untuk pecutan pembelajaran mendalam. Teras Tensor boleh disambungkan kepada GPU dalam bentuk arahan Arahan utama ialah HMMA (Half Precision Matrix Multiply Accumulate), yang mendarab dua matriks 4×4 FP16 dan kemudian menambah hasilnya kepada satu Dalam matriks FP32, operasi jenis ini. adalah sangat biasa dalam pembelajaran mendalam. Melalui arahan HMMA, overhed arahan pengambilan dan penyahkodan boleh dikurangkan kepada 10% hingga 20% asal melalui pelunasan.

Selebihnya adalah soal beban. Jika anda ingin mengatasi prestasi Tensor Core, anda harus bekerja keras pada beban. Dalam seni bina Volta, sejumlah besar penggunaan tenaga dan ruang digunakan untuk pecutan pembelajaran mendalam, jadi walaupun kebolehprograman dikorbankan, ia tidak boleh membawa banyak peningkatan prestasi.

Volta turut menaik taraf memori video HBM, dengan lebar jalur memori 900 GB/s, dan turut menggunakan versi baharu NVLink, yang boleh menggandakan lebar jalur apabila membina kluster. Selain itu, seni bina Volta juga memperkenalkan NVSwitch, yang boleh menyambungkan berbilang GPU Secara teori, NVSwitch boleh menyambung sehingga 1024 GPU untuk membina mesin memori kongsi yang besar.

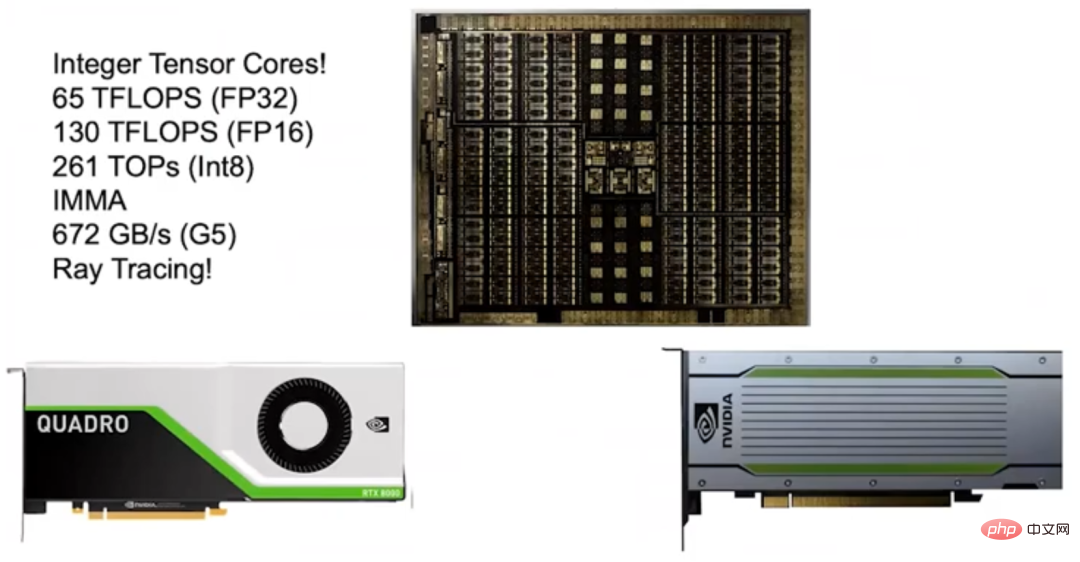

Turing (2018) 2018 Pada 2016, NVIDIA melancarkan seni bina Turing. Disebabkan kejayaan besar Teras Tensor sebelum ini, NVIDIA melancarkan Teras Tensor Integer. Oleh kerana kebanyakan rangkaian saraf boleh dilatih dengan FP16, dan inferens tidak memerlukan ketepatan yang terlalu tinggi dan julat dinamik yang besar, hanya gunakan Int8. Oleh itu, NVIDIA memperkenalkan Teras Tensor Integer dalam seni bina Turing, yang menggandakan prestasi.

Seni bina Turing juga menggunakan memori GDDR untuk menyokong model NLP dan sistem pengesyoran yang mempunyai keperluan lebar jalur yang tinggi. Pada masa itu, sesetengah orang mempersoalkan bahawa kecekapan tenaga seni bina Turing tidak sebaik pemecut lain di pasaran. Tetapi jika anda mengira dengan teliti, anda akan mendapati bahawa seni bina Turing sebenarnya lebih cekap tenaga, kerana Turing menggunakan memori video G5, manakala pemecut lain menggunakan memori LPDDR. Pada pendapat saya, memilih memori G5 adalah keputusan yang tepat kerana ia boleh menyokong model dengan keperluan lebar jalur tinggi yang tidak dapat disokong oleh produk serupa.

Apa yang saya amat berbangga dengan seni bina Turing ialah ia juga dilengkapi dengan Teras RT yang menyokong Ray Tracing. Nvidia hanya mula menyelidik RT Core pada 2013, dan secara rasmi melancarkan RT Core hanya lima tahun kemudian.

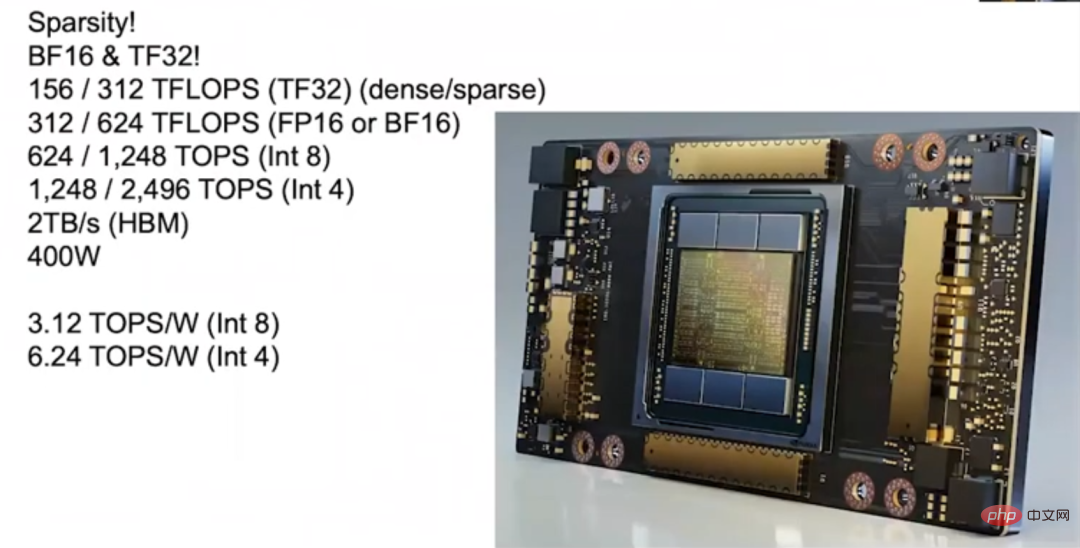

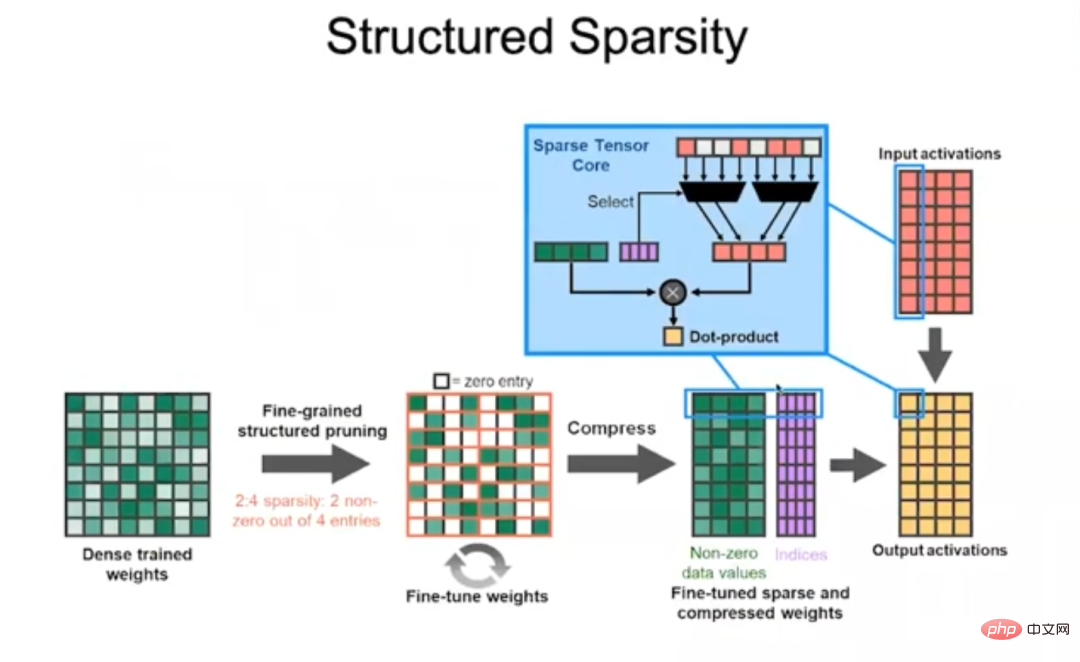

Ampere (2020) Pada tahun 2020, NVIDIA mengeluarkan Ampere The seni bina membolehkan A100 yang dikeluarkan pada tahun itu mencapai lonjakan prestasi, dengan kelajuan inferens lebih daripada 1,200 Teraflops. Salah satu kelebihan besar seni bina Ampere ialah ia menyokong sparsity. Kami mendapati bahawa kebanyakan rangkaian saraf boleh dikecilkan, iaitu rangkaian saraf boleh "dipangkas" dan sejumlah besar pemberat boleh ditetapkan kepada 0 tanpa menjejaskan ketepatannya. Tetapi rangkaian saraf yang berbeza boleh dikurangkan kepada tahap yang berbeza, yang agak rumit. Sebagai contoh, tanpa kehilangan ketepatan, ketumpatan rangkaian saraf konvolusi boleh dikurangkan kepada 30% hingga 40%, manakala rangkaian saraf yang bersambung sepenuhnya boleh dikurangkan kepada 10% hingga 20%.

Pandangan tradisional ialah disebabkan oleh kos yang tinggi untuk mengendalikan pakej matriks jarang, jika ketumpatan tidak dapat dikurangkan di bawah 10%, trade-off tidak sebaik mengendalikan matriks padat. pakej. Kami mula-mula bekerjasama dengan Universiti Stanford untuk mengkaji sparsity, dan kemudian membina mesin yang sangat baik yang boleh berjalan dengan cekap apabila ketumpatan matriks mencapai 50%, tetapi kami mahu menjadikan matriks jarang lebih cekap daripada matriks padat dari segi power gating masih sukar untuk menjadikan matriks lebih baik, dan di sinilah kami sentiasa mahu menerobos.

Akhirnya, kami berjaya mengatasi masalah tersebut dan membangunkan Ampere, dan rahsianya ialah sparsity berstruktur.

Jarang berstruktur Seni bina Ampere menentukan setiap 4 matriks Dalam nilai berangka, tidak boleh lebih daripada 2 nilai bukan sifar, iaitu pemberat dimampatkan dengan mengeluarkan nilai bukan sifar. Tentukan pemberat mana yang harus dikekalkan dengan memasukkan perkataan kod (perkataan kod), dan gunakan perkataan kod untuk menentukan pengaktifan input pemberat bukan sifar ini harus didarabkan, dan kemudian menambahnya untuk melengkapkan operasi pendaraban titik. Pendekatan ini sangat cekap, membolehkan seni bina Ampere menggandakan prestasi kebanyakan rangkaian saraf.

Selain itu, seni bina Ampere mempunyai banyak inovasi Sebagai contoh, Ampere mempunyai format TF32 (TensorFloat-32) terbina dalam, yang menggabungkan bit eksponen 8-bit FP32 dan FP32. Bit eksponen 10-bit digit mantissa. Ampere juga menyokong format BFLOAT Bit eksponen BFLOAT adalah sama dengan FP32, dan bit mantissa adalah kurang daripada FP32, jadi ia boleh dianggap sebagai versi terkecil FP32. Semua format data di atas menyokong jarang berstruktur, jadi sama ada anda menggunakan FP16 dan TF32 untuk latihan, atau menggunakan Int8 dan Int4 untuk inferens, anda boleh mendapatkan prestasi tinggi yang dibawa oleh jarang berstruktur.

Memandangkan Ampere menjadi lebih baik dan lebih baik dalam pengkuantitian, ia boleh digunakan pada banyak rangkaian saraf dan memastikan prestasi tinggi. Ampere mempunyai 6 tindanan HBM, dan lebar jalur memori HBM juga telah ditingkatkan, mencapai 2TB/s. Semasa inferens hujung ke hujung, keupayaan pengkomputeran Ampere boleh mencapai 3.12 TOPS/W (Int8) dan 6.24 TOPS/W (Int4).

2 Tiga faktor utama untuk meningkatkan prestasi inferens GPU

Tiga faktor utama untuk meningkatkan prestasi inferens GPU Merumuskan perkembangan pembelajaran mendalam yang lalu, peningkatan 317 kali ganda dalam prestasi inferens GPU dalam tempoh 8 tahun terutamanya disebabkan oleh tiga faktor Faktor besar:

Pertama dan paling penting ialah pembangunan perwakilan nombor.

Ketepatan FP32 terlalu tinggi, mengakibatkan kos operasi aritmetik menjadi terlalu tinggi. Kemudian, seni bina Turing dan Ampere menyokong Int8, yang telah meningkatkan prestasi setiap watt GPU. Apabila Google menerbitkan kertas yang mengumumkan TPU1, ia menyatakan bahawa kelebihan TPU1 ialah ia disesuaikan secara khusus untuk pembelajaran mesin. Malah, Google sepatutnya membandingkan TPU1nya sendiri dengan Kepler NVIDIA (seperti yang dinyatakan sebelum ini, Kepler tidak direka khusus untuk pembelajaran mendalam), jadi kelebihan TPU1 boleh dikatakan kelebihan Int8 berbanding FP32.

Kedua, GPU menyokong arahan yang kompleks.

Seni bina Pascal telah menambah arahan pendaraban titik, dan kemudian seni bina Volta, Turing dan Ampere telah menambah arahan produk matriks untuk melunaskan overhed. Menyimpan enjin boleh atur cara dalam GPU boleh membawa banyak faedah. Ia boleh menjadi secekap pemecut kerana setiap arahan menyelesaikan begitu banyak tugas sehingga pelunasan overhed setiap arahan hampir boleh diabaikan.

Akhir sekali, kemajuan teknologi proses.

Proses pembuatan cip telah berkembang daripada 28 nanometer kepada 7 nanometer hari ini, yang telah memberikan sumbangan tertentu kepada peningkatan prestasi GPU. Contoh berikut boleh membantu anda memahami dengan lebih baik kesan perkongsian kos: jika anda melakukan operasi HFMA, operasi "darab" dan "tambah" berjumlah hanya 1.5pJ (Picojoules, Picojoules), semasa mengambil arahan, penyahkodan dan mendapatkan operan Ia memerlukan overhed 30pJ, dan kosnya akan setinggi 2000% apabila dilunaskan.

Dan jika operasi HDP4A dilakukan, overhed boleh diperuntukkan kepada 8 operasi, mengurangkan overhed kepada 500%. Untuk operasi HMMA, kerana kebanyakan penggunaan tenaga digunakan untuk beban, overhed hanya 22%, dan IMMA adalah lebih rendah, 16%. Oleh itu, semasa mengejar kebolehprograman menambah sejumlah kecil overhed, peningkatan prestasi yang boleh dicapai dengan menggunakan reka bentuk yang berbeza adalah lebih penting.

3 Daripada prestasi kad tunggal kepada sambungan kluster GPU

Perkataan di atas mengenai prestasi GPU tunggal, tetapi melatih model bahasa yang besar jelas memerlukan berbilang GPU, jadi sambungan antara GPU juga mesti dipertingkatkan. Kami memperkenalkan NVLink dalam seni bina Pascal, dan kemudian seni bina Volta menerima pakai NVLink 2, dan seni bina Ampere menerima pakai NVLink 3. Lebar jalur setiap generasi seni bina meningkat dua kali ganda. Di samping itu, kami melancarkan generasi pertama NVSwitch pada seni bina Volta dan generasi kedua pada seni bina Ampere. Melalui NVLink dan NVSwitch, kluster GPU yang sangat besar boleh dibina. Selain itu, kami juga melancarkan kotak DGX.

Kotak DGX

Pada tahun 2020, NVIDIA memperoleh Mellanox, jadi ia kini boleh menyediakan set lengkap penyelesaian pusat data termasuk Suis dan Saling Sambung untuk membina kluster GPU yang besar. Di samping itu, kami dilengkapi dengan DGX SuperPOD, yang berada di kedudukan 20 teratas dalam senarai Rekod Prestasi AI 500. Pada masa lalu, pengguna perlu menyesuaikan mesin, tetapi kini mereka hanya perlu membeli mesin prakonfigurasi yang boleh menggunakan DGX SuperPOD untuk mendapatkan prestasi tinggi yang dibawa oleh DGX SuperPOD. Selain itu, mesin ini sangat sesuai untuk pengkomputeran saintifik.

Pada masa lalu, ia mengambil masa beberapa bulan untuk melatih satu model bahasa besar dengan satu mesin, tetapi kecekapan latihan boleh dipertingkatkan dengan banyaknya dengan membina kluster GPU Oleh itu, mengoptimumkan sambungan kluster GPU dan menambah baik prestasi satu Prestasi GPU adalah sama penting.

4 Pemecut Pembelajaran Mendalam: Tempat ujian untuk teknologi baharu

Mari kita bincangkan tentang kerja penyelidikan dan pembangunan pemecut NVIDIA. Nvidia menganggap pemecut sebagai pembawa untuk menguji teknologi baharu, dan teknologi yang berjaya akhirnya akan digunakan pada GPU arus perdana. Pemecut boleh difahami dengan cara ini: ia mempunyai input unit pendaraban matriks mengikut hierarki memori Perkara seterusnya yang perlu dilakukan ialah membiarkan kebanyakan penggunaan tenaga digunakan untuk pengiraan pendaraban matriks dan bukannya pengendalian data.

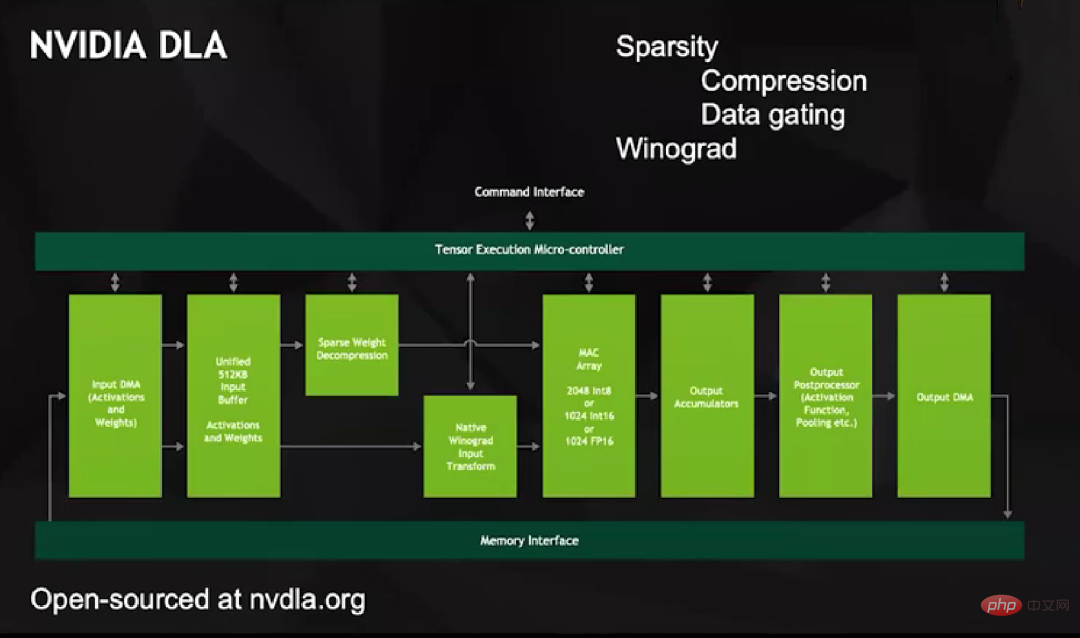

Untuk mencapai matlamat ini, kami melancarkan projek NVIDIA DLA sekitar tahun 2013. Ia adalah produk sumber terbuka dengan kemudahan sokongan yang sangat lengkap, tidak berbeza dengan pemecut pembelajaran mendalam yang lain. Tetapi DLA mempunyai tatasusunan MAC yang besar yang menyokong operasi 2048 Int8, 1024 Int16 atau 1024 FP16.

DLA mempunyai dua ciri unik: Pertama, ia menyokong sparsifikasi. Kami bermula dari buah yang tergantung rendah Semua pemindahan data, termasuk dari DMA ke Penimbal Bersepadu dan dari Penimbal Bersepadu ke tatasusunan MAC, hanya melibatkan nilai bukan sifar Kami memutuskan elemen yang ditinggalkan melalui pengekodan, dan kemudian menyelesaikan elemen ini dan kemudian masukkan ke dalam tatasusunan MAC untuk pengiraan.

Cara DLA nyahmampat adalah bijak, ia tidak memasukkan nilai sifar ke dalam tatasusunan MAC, kerana ini akan menjadikan satu siri data menjadi sifar. Sebaliknya, ia menyediakan baris yang berasingan untuk mewakili nilai sifar, dan apabila pengganda menerima baris itu pada salah satu input, ia melekat pada data dalam pengganda dan kemudian menghantar output, yang tidak meningkat dengan sebarang nilai angka Gating sangat menjimatkan tenaga.

Yang kedua ialah menyokong transformasi Winograd di peringkat perkakasan. Anda tahu, jika anda ingin melakukan konvolusi, contohnya, kernel konvolusi m×n, anda memerlukan n 2 pengganda dan penambah dalam domain spatial, tetapi jika anda melakukannya dalam domain frekuensi, anda hanya memerlukan titik demi titik. pendaraban. Oleh itu, operasi kernel lilitan besar adalah lebih cekap dalam domain frekuensi berbanding dalam domain spatial. Bergantung pada saiz kernel lilitan, transformasi Winograd boleh membawa peningkatan prestasi 4x ganda kepada beberapa rangkaian imej.

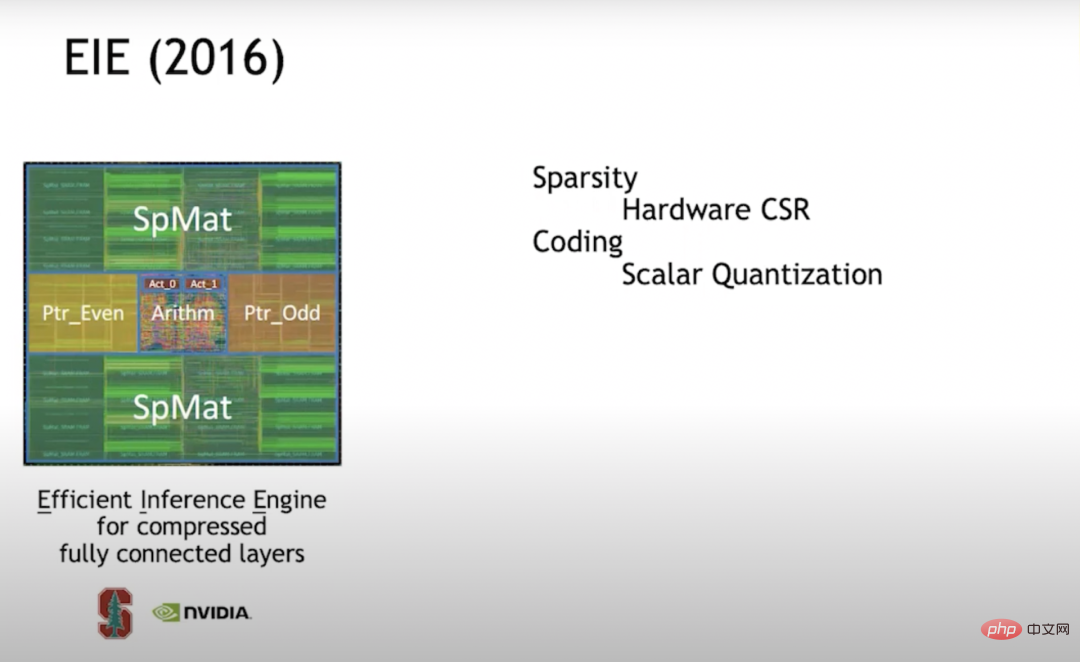

EIE (2016) Pada 2016, saya berada di Stanford dan Pelajar saya ketika itu Han Song (penolong profesor MIT EECS dan bekas pengasas bersama Teknologi Shenjian) mempelajari EIE (Enjin Inferens Cekap) bersama-sama. Ini adalah salah satu penerokaan pertama ke dalam sparsifikasi. Kami menyokong perwakilan matriks CSR (Compressed Sparse Row) pada peringkat perkakasan Pendekatan ini sangat cekap Apabila ketumpatan adalah 50%, ia lebih menjimatkan tenaga daripada pengkomputeran ketumpatan penuh.

Kemudian didapati bahawa jika anda ingin menjadikan pemecut lebih cekap, anda harus membina tatasusunan unit vektor supaya setiap enjin bukan sahaja melakukan satu pengumpulan gandaan, tetapi setiap PE (Elemen Pemprosesan) melakukan 16×16=256 pendaraban dan penambahan. Tetapi apabila kami mula membina tatasusunan sel vektor, kami mendapati sukar untuk mencapai sparsity dengan cekap, jadi kami beralih kepada sparsity berstruktur.

Apabila EIE memproses unit skalar, ia menyimpan struktur penunjuk dalam memori yang berasingan, dan kemudian memproses struktur penunjuk melalui peringkat saluran paip untuk menentukan data yang boleh didarabkan, dan kemudian melakukan pendaraban. Hasil operasi diletakkan di lokasi yang sesuai. Keseluruhan proses ini berjalan dengan sangat cekap. Kami juga mendapati bahawa sebagai tambahan kepada "pemangkasan" untuk mencapai sparsity, kaedah untuk meningkatkan kecekapan pengkomputeran rangkaian saraf juga melibatkan kuantifikasi. Oleh itu, kami memutuskan untuk menggunakan kuantisasi buku kod. Pengkuantitian buku kod ialah cara terbaik untuk meningkatkan kecekapan apabila melibatkan data yang dinyatakan dalam bit. Jadi kami berlatih pada buku kod.

Ternyata jika anda boleh menggunakan rambatan belakang untuk menangkap keturunan kecerunan, anda boleh menggunakan rambatan balik pada apa-apa sahaja. Jadi kami menggunakan perambatan belakang dalam buku kod untuk melatih set kata kod yang optimum untuk ketepatan tertentu. Dengan mengandaikan bahawa buku kod mempunyai 7 bit, maka anda akan mendapat 128 kata kod Kami akan mencari 128 kata kod yang optimum dalam rangkaian saraf untuk latihan.

Kuantasi buku kod menghadapi masalah: overhed operasi matematik adalah tinggi. Kerana tidak kira betapa besar buku kod itu, berapa nilai sebenar, anda perlu mencarinya dalam RAM (memori akses rawak). Nilai sebenar mesti diwakili dengan ketepatan tinggi dan anda tidak boleh mewakili kata kod ini dengan tepat. Jadi kami meletakkan banyak usaha ke dalam matematik ketepatan tinggi. Dari sudut pemampatan, ini berfungsi dengan baik, tetapi dari sudut tenaga matematik, ia tidak begitu kos efektif, jadi kami meninggalkan teknologi ini dalam kerja berikutnya.

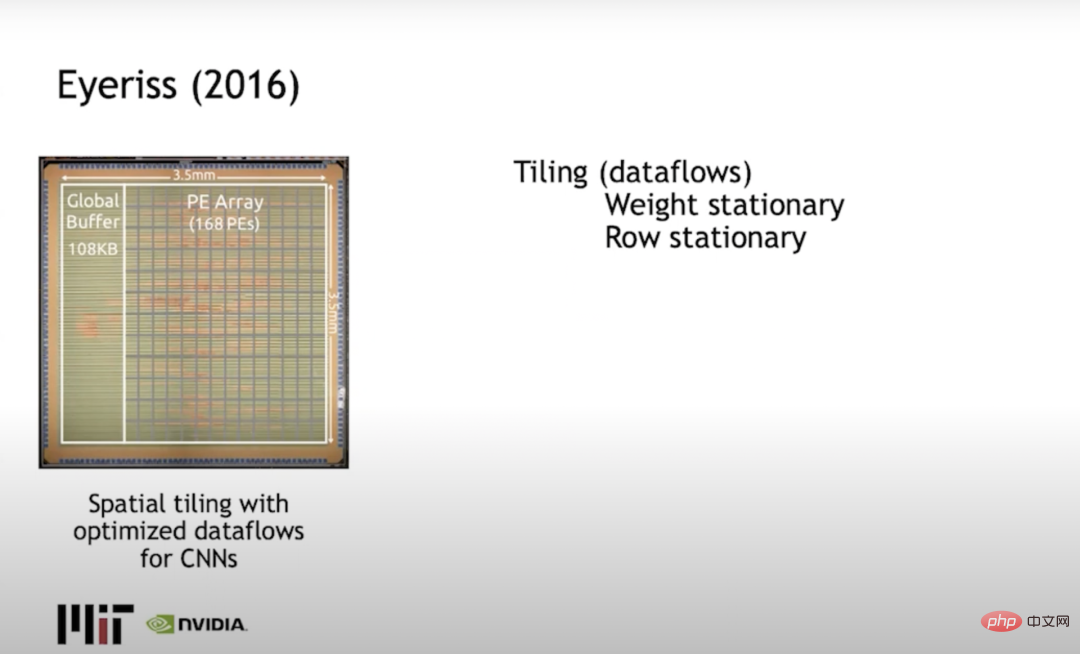

Eyeriss (2016) Joel Emer (yang bekerja di kedua-dua NVIDIA dan MIT) dan Vivienne Sze dari MIT membina Eyeriss, yang terutamanya menyelesaikan masalah jubin, atau cara mengehadkan pengiraan untuk meminimumkan perubahan data. Pendekatan biasa ialah menggunakan pegun baris, menyebarkan pemberat dalam baris dan pengaktifan output dalam lajur, dan meminimumkan tenaga yang digunakan oleh pergerakan data.

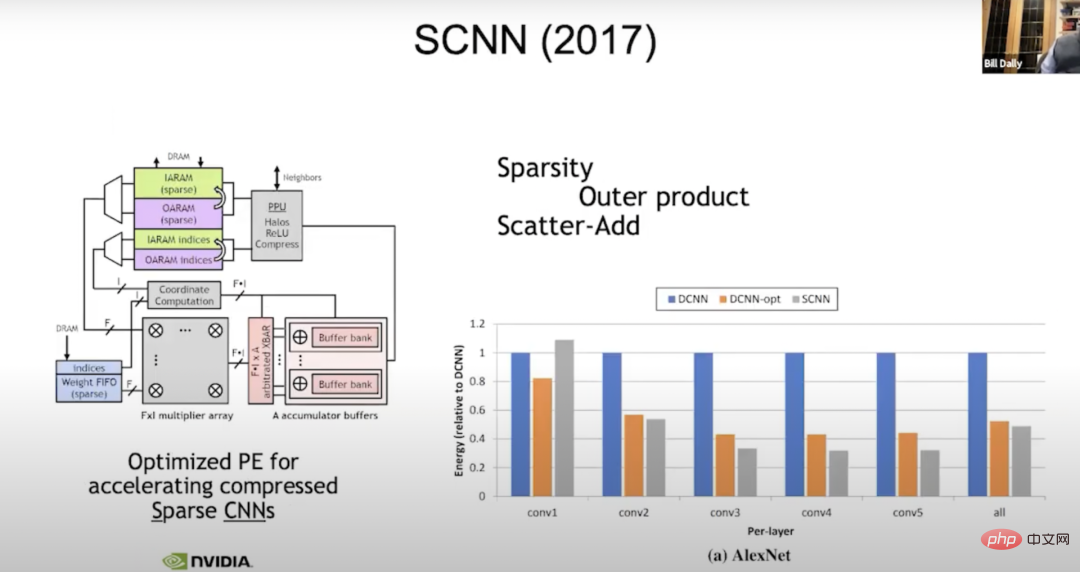

SCNN (2017) Kami masih mengusahakan sparsity sekarang Penyelidikan. Pada tahun 2017, kami membina mesin yang dipanggil SCNN (Sparse CNNs) untuk kompilasi jarang (evolusi rangkaian saraf Apa yang kami lakukan ialah: kami memindahkan semua masalah kompleks yang berkaitan dengan menangani sparsity kepada output). Baca semua pengaktifan input dan tentukan ke mana mereka perlu pergi, jadi "vektor lebar-f" di sini ialah pengaktifan input vektor biasa.

Kami akan membaca empat pengaktifan input pada satu masa, empat pemberat dan setiap pemberat perlu didarab dengan setiap pengaktifan input. Ia hanya persoalan di mana untuk meletakkan keputusan, jadi kita darabkan f dengan f.

Dalam pengiraan koordinat, kami mengambil eksponen pengaktifan input dan berat, dan mengira kedudukan di mana hasil penjumlahan perlu berada dalam pengaktifan output. Kemudian pengiraan serakan data (scatter_add) dilakukan pada penimbal penumpuk ini. Sebelum itu, semuanya berfungsi dengan sempurna. Tetapi ternyata memindahkan penyelewengan kepada output bukanlah idea yang baik, kerana dalam output, ketepatan sebenarnya adalah yang paling luas. Apabila anda cenderung untuk mengumpul, anda melakukan lapan bit pemberat, lapan bit pengaktifan, dan anda menambah sehingga 24 bit. Di sini kami menggunakan akumulator lebar untuk melakukan banyak pergerakan data, yang lebih baik daripada melakukan pergerakan data yang lebih intensif. Walau bagaimanapun, peningkatan tidak seperti yang dibayangkan, mungkin 50% daripada tenaga unit ketumpatan.

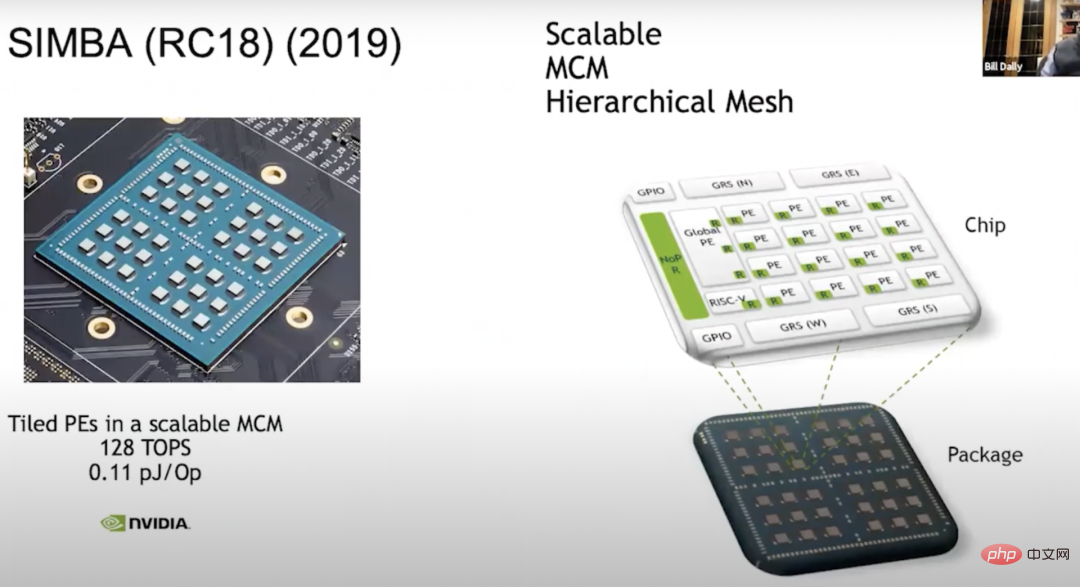

SIMBA (RC18) (2019) Satu lagi perkara yang perlu kita lakukan ialah: gunakan pemecut sedia ada untuk membina modul berbilang cip - SIMBA (RC18 Idea untuk melakukan penyelidikan ini muncul pada tahun 2018. Pada masa yang sama, cip ini juga). menunjukkan banyak teknologi yang bijak. Ia mempunyai seni bina PE yang baik, dan cip menyediakan teknologi isyarat yang sangat berkesan di tengah. Kini seni bina berskala kepada 36 cip penuh, setiap satunya mempunyai matriks PE 4x4, dan dalam unit ini, setiap PE mempunyai 8 unit vektor lebar, jadi kita boleh mendapat 128 TOPS kuasa pengkomputeran, setiap Setiap Op mempunyai 0.1 pJ, yang mana adalah lebih kurang bersamaan dengan 10 TOPS/W.

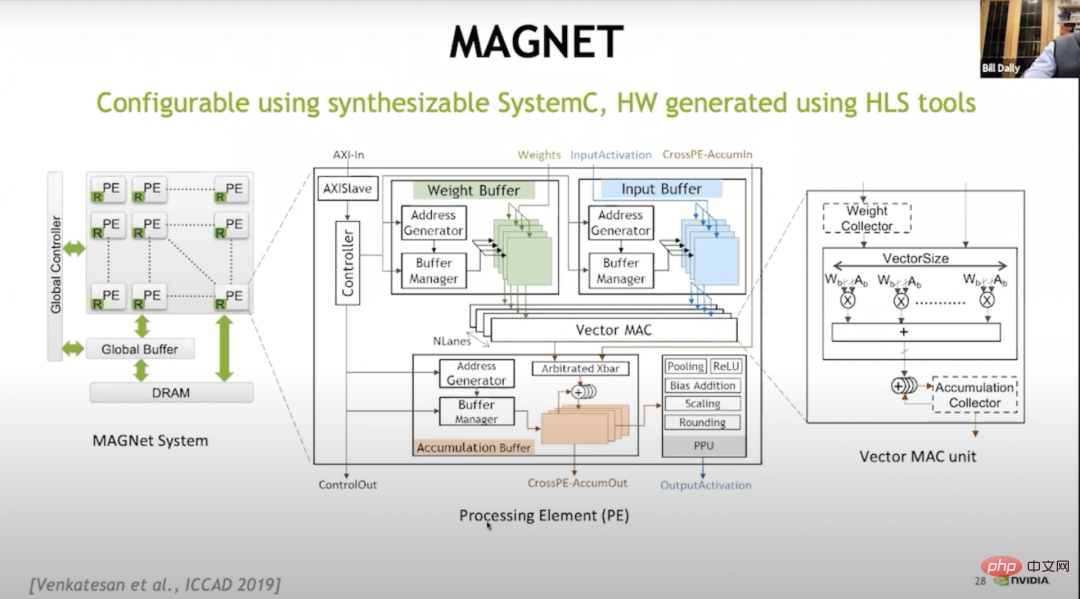

Kami belajar banyak tentang pertukaran. Kami menyedari bahawa membina tatasusunan PE ini adalah seperti membina ruang reka bentuk yang sangat besar, tentang cara membina hierarki memori, cara menjadualkan data, dll., jadi kami membina sistem yang dipanggil MAGNET.

MAGNET Gambar di atas merupakan reka bentuk sistem penerokaan angkasa lepas yang diterbitkan di ICCAD (International Conference on Computer-Aided Design) pada tahun 2019. Ia terutamanya Digunakan untuk menghitung ruang reka bentuknya, seperti: berapa lebar setiap unit vektor sepatutnya, berapa banyak unit vektor yang ada pada setiap PE, berapa besar penampan berat, berapa besar penampan akumulator, berapa besar penimbal pengaktifan, dsb. Kemudian didapati bahawa kami perlu melakukan satu lagi tahap caching, jadi kami menambah pengumpul berat dan pengumpul penumpuk.

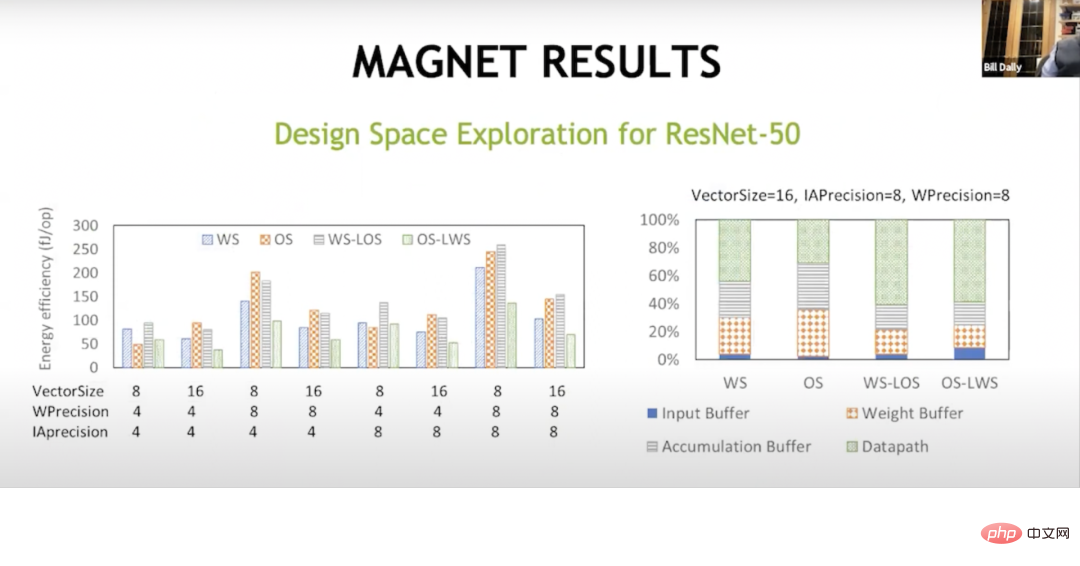

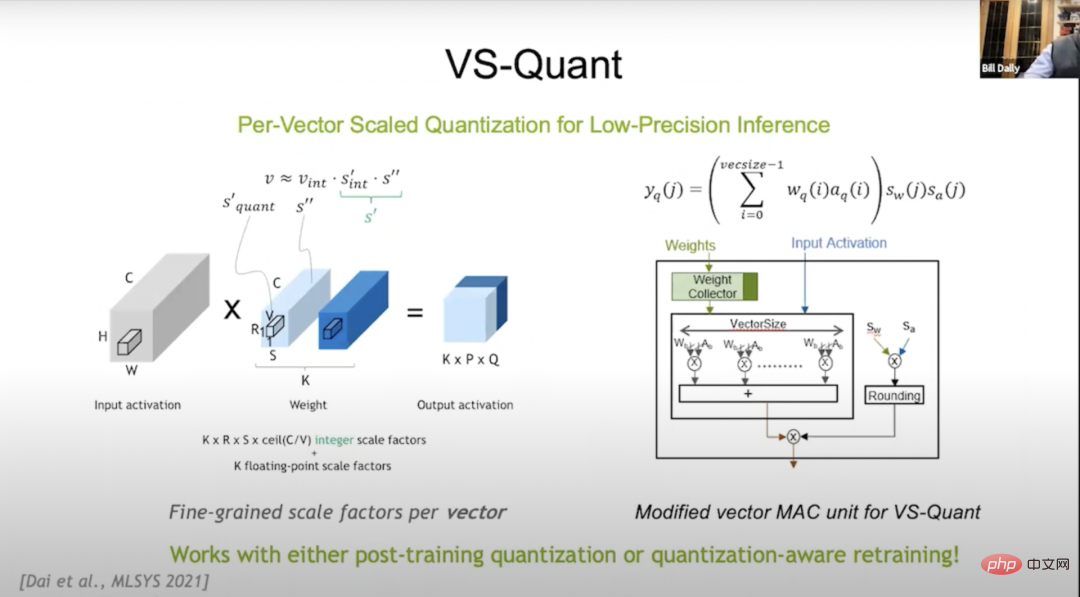

HASIL MAGNET Dengan tahap caching tambahan ini, kami Akhirnya ia adalah satu kejayaan. Ini menunjukkan bahawa aliran data di sini adalah berbeza, dan aliran data tetap berat pada asalnya dilakukan oleh Sze dan Joel. Anda meletakkan sebahagian besar tenaga anda ke dalam perkara di luar laluan data, seperti ke dalam penimbal pengumpulan, penimbal berat dan penimbal input. Tetapi dengan aliran data hibrid ini, pemberat ditetapkan, output tempatan ditetapkan, output ditetapkan, pemberat tempatan ditetapkan, anda boleh mendapatkan hampir dua pertiga daripada tenaga dalam operasi matematik dan anda boleh mengurangkan tenaga yang dibelanjakan dalam tatasusunan memori ini. , dengan itu dalam pemprosesan ingatan pada tahap hierarki yang lain. Ini menjadikan prestasi per watt kepada kira-kira 20 TOPS sekarang. 2021 , pada persidangan MLSYS (The Conference on Machine Learning and Systems, Machine Learning and Systems Conference), kami memperkenalkan VS-Quant untuk meneroka cara untuk memampatkan bilangan bit (kesan pengkuantitian buku kod sangat baik dalam hal ini) dan Kaedah kuantitatif yang sangat menjimatkan kos dari segi overhed matematik. Kami menggunakan perwakilan integer tetapi ingin menskalakannya supaya julat dinamik integer boleh diwakili.

Tetapi ternyata jika anda menggunakan ini pada keseluruhan rangkaian saraf sekarang, ia tidak akan berfungsi dengan baik kerana terdapat banyak julat dinamik yang berbeza pada rangkaian saraf, jadi VS-Quant's Kuncinya ialah: kita mengenakan faktor skala tunggal pada vektor yang agak kecil, kira-kira dengan melakukan operasi di atas pada 32 pemberat, julat dinamik akan menjadi lebih kecil. Kami boleh meletakkan integer ini di atas, dan kami juga boleh melaraskan dan mengoptimumkannya.

Mungkin kami tidak mewakili outlier dengan tepat, tetapi kami mewakili nombor yang lain dengan lebih baik. Dengan cara ini, kita boleh menukar berat dan pengaktifan ketepatan yang agak rendah untuk ketepatan yang lebih tinggi. Jadi kita kini mempunyai pelbagai faktor skala: satu ialah faktor berat dan satu ialah faktor pengaktifan.

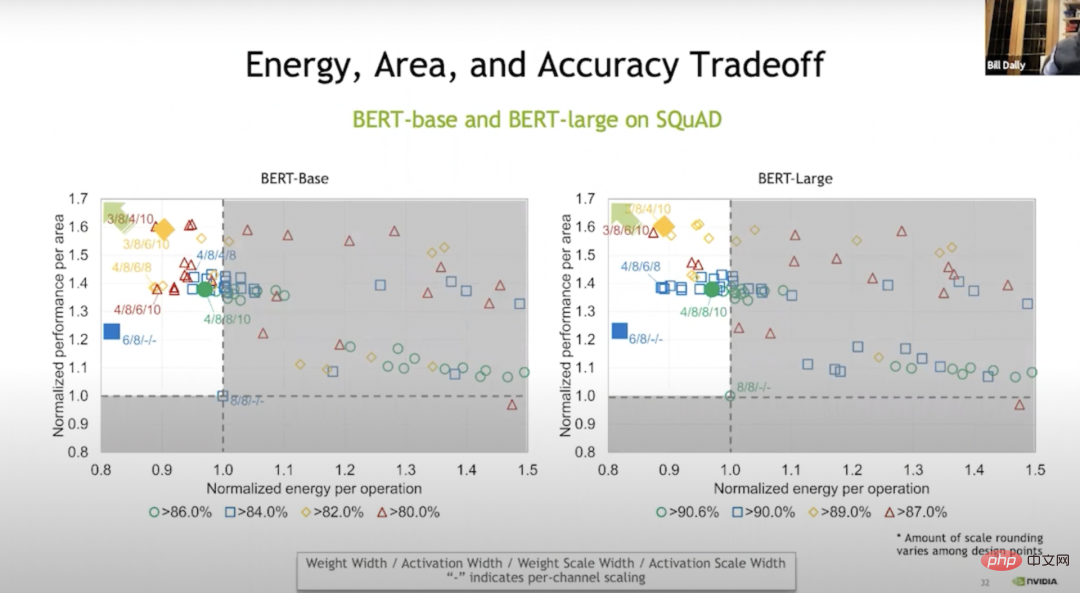

Pertukaran Tenaga, Kawasan dan Ketepatan

Kami pada asasnya melaksanakan operasi ini pada tahap vektor, dan hasilnya ditunjukkan dalam Bert-base. Berbanding dengan latihan tanpa pemberat, kita boleh menjimatkan 20% tenaga dan 70% ruang dalam beberapa kes dengan latihan Warna hijau dalam rajah di atas menunjukkan bahawa pada dasarnya tiada kehilangan ketepatan, biru, oren dan merah menunjukkan ketepatannya Tinggi atau rendah. Tetapi walaupun pada tahap biru, ketepatannya agak tinggi.

Dengan VS-Quant dan beberapa tweak lain, kami menjalankan percubaan pada model bahasa ini. Berjalan pada model bahasa adalah lebih sukar daripada berjalan pada model imej iaitu sekitar 120 TOPS/W.

Pemecut

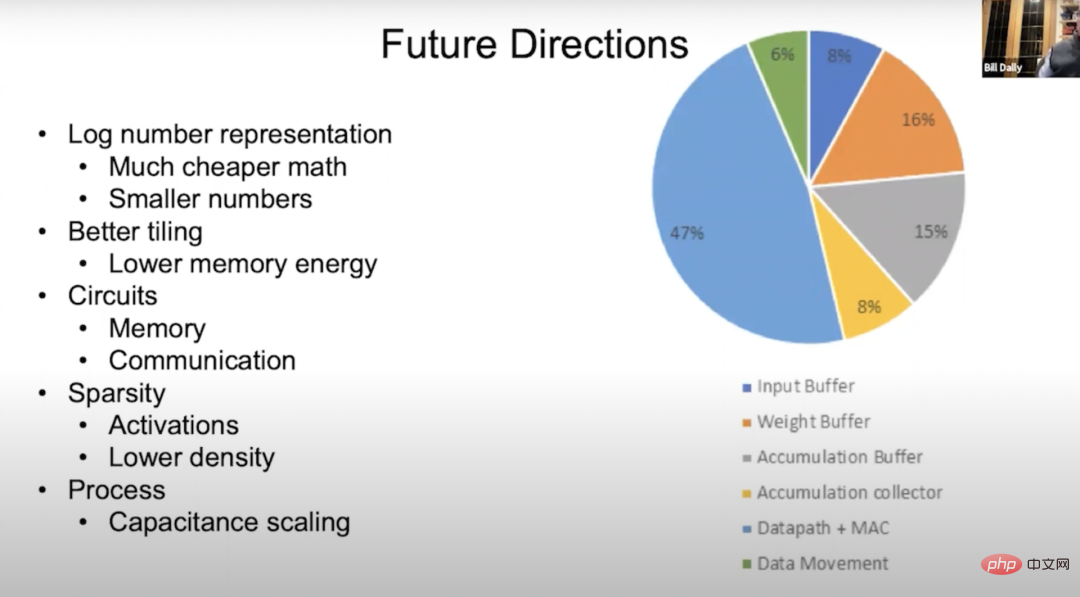

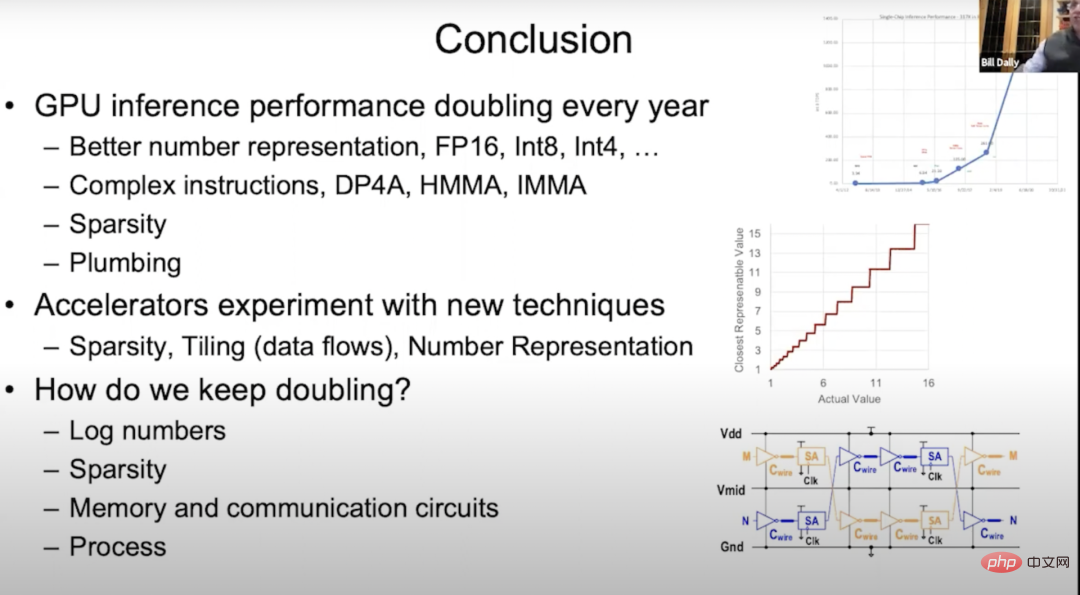

Jadi untuk pemecut, anda perlu melakukan peranti pertama pendaraban matriks. Kita perlu menghasilkan kaedah jubin, kaedah pengiraan tujuh gelung bersarang menggunakan rangkaian saraf. Pada asasnya menyalin beberapa gelung ini ke pelbagai lapisan sistem memori untuk memaksimumkan penggunaan semula hierarki memori setiap lapisan dan meminimumkan pengendalian data.Kami juga mengkaji sparsity, yang cukup bagus dalam pemampatan. Ia pada asasnya meningkatkan lebar jalur memori dan jalur komunikasi serta mengurangkan tenaga memori dan komunikasi. Tahap pembangunan sparsity seterusnya ialah: apabila anda mempunyai nilai sifar, hanya hantar baris berasingan yang mewakili nilai sifar tanpa perlu bertukar kepada 8 atau 16 bit setiap gelung. Seni bina Ampere boleh menggunakan semula pengganda dengan menggunakan sparsity berstruktur, yang merupakan kaedah yang sangat cekap dan hanya memerlukan overhed beberapa pemultipleks (yang pada asasnya boleh diabaikan Tidak dikira). Kita juga boleh menggunakan semula pengganda apabila melakukan operasi penunjuk, yang daripadanya kita boleh mendapat 2x prestasi. Perwakilan nombor adalah sangat penting. Kami bermula dengan EIE (Nota Penterjemah: Enjin Inferens Cekap, makalah Dr. Han Song di ISCA 2016. Merealisasikan pecutan perkakasan rangkaian neural jarang termampat. ESE dengan kaedah anggarannya memenangi kertas terbaik FPGA2017.), cuba melakukan buku kod, tetapi ini menjadikan penskalaan mahal secara matematik. Akhir sekali, teknologi yang berjaya diuji dalam pemecut akhirnya akan digunakan pada GPU. Ini adalah cara yang baik untuk menguji. Kami percaya bahawa GPU ialah platform untuk perkakasan khusus domainnya sangat baik dan rangkaiannya lancar, membolehkan aplikasi pembelajaran mendalam berjalan dengan sangat pantas. Hala Tuju Masa Depan Mari kita bercakap tentang masa depan perkakasan pembelajaran mendalam. Gambar di atas ialah carta pai aliran tenaga Anda dapat melihat bahawa kebanyakannya mengalir ke laluan data ingatan dan pergerakan data. Yang hijau ialah pemindahan data, dan selebihnya ialah penimbal input, penimbal berat, penimbal pengumpulan dan pengumpul pengumpulan, dengan perkadaran yang berbeza. Kami sedang mengkaji untuk mengurangkan penggunaan tenaga bagi operasi matematik, dan salah satu cara terbaik ialah memindahkannya ke sistem logaritma. Kerana dalam sistem logaritma, pendaraban menjadi penambahan, dan penambahan biasanya kurang intensif tenaga. Cara lain ialah menukar kepada nilai yang lebih kecil, yang boleh dicapai melalui VS-Quant. Dengan mengukur dengan lebih tepat, kita boleh mendapatkan ketepatan yang setara daripada rangkaian saraf dengan nombor ketepatan yang lebih rendah. Kami berharap dapat melakukan lebih baik dengan jubin, seperti mungkin menambah lebih banyak lapisan dalam hierarki memori dalam beberapa kes, yang boleh mengurangkan tenaga memori, juga Ia boleh membuat litar memori dan litar komunikasi lebih berkesan. Pada seni bina Ampere, kerja yang telah kami lakukan pada sparsity berstruktur adalah permulaan yang baik, tetapi saya fikir kami boleh melakukan yang lebih baik dengan menurunkan ketumpatan atau memilih berbilang ketumpatan untuk melaraskan pengaktifan dan pemberat. Dengan penyelidikan yang mendalam, teknologi proses juga akan membawa beberapa kemajuan dalam penskalaan kapasitans. Dikeluarkan pada 2012 Sejak seni bina Kepler, prestasi inferens GPU meningkat dua kali ganda setiap tahun. Perkembangan ini sebahagian besarnya disebabkan oleh perwakilan digital yang lebih baik. Kali ini kami bercakap tentang banyak kandungan, seperti dari FP32 ke FP16 ke Int8 dan kemudian ke Int4 seni bina Kepler kami bercakap tentang menggunakan produk titik yang lebih kompleks dengan memperuntukkan overhead arahan kami bercakap tentang seni bina Pascal dan separa; matriks ketepatan mendarab dan terkumpul dalam seni bina Volta , pendaraban dan pengumpulan matriks integer dalam seni bina Turing, dan seni bina Ampere dan sparsity struktur. Saya telah bercakap sedikit tentang Paip, tetapi Paip adalah sangat penting. Paip digunakan untuk menyusun sistem memori dan rangkaian pada cip, supaya Teras Tensor yang berkuasa boleh digunakan sepenuhnya. Untuk Tensor Cores melaksanakan gigabit operasi sesaat dalam seni bina Turing dan menyuapkan data ke dalam melaksanakan penanda aras biasa, mengatur memori cawangan, memori pada cip dan saling sambungan antara mereka dan operasi Normal adalah sangat penting. Melihat masa depan, kami bersedia untuk mencuba menerapkan pelbagai teknologi baharu pada pemecut. Seperti yang dinyatakan sebelum ini, kami telah menjalankan banyak eksperimen tentang teknik sparsity dan jubin, dan bereksperimen dengan teknik jubin yang berbeza, perwakilan berangka, dsb. dalam projek MAGNet. Tetapi kami masih berasa tertekan, kerana kemajuan pembelajaran mendalam sebenarnya bergantung pada peningkatan berterusan prestasi perkakasan Menggandakan prestasi inferens GPU setiap tahun adalah satu cabaran yang besar. Malah, kad di tangan kita hampir dimainkan, yang bermakna kita mesti mula membangunkan teknologi baharu berikut adalah empat arah yang saya rasa patut diberi perhatian: Pertama, kaji perwakilan nombor baharu, seperti logaritma (nombor Log), dan skema pengkuantitian yang lebih bijak daripada EasyQuant; > Kedua, teruskan mengkaji sparsity secara mendalam; 🎜> 7 Jawab soalan penonton Dejan Milojicic: Berapa besar konvolusi matriks diperlukan untuk menukar Algoritma Winograd Tukar kepada pelaksanaan lilitan yang lebih cekap?

Saya rasa konvolusi matriks 3×3 adalah Sangat cekap . Sudah tentu, lebih besar lilitan, lebih tinggi kecekapan. Dejan Milojicic: Bagaimanakah lebar jalur memori bagi Memori Lebar Jalur Tinggi (HBM) dikira? Adakah memori diakses melalui semua teras GPU pada masa yang sama? Bill Dally: Setiap tindanan HBM mempunyai Kawasan framebuffer yang berasingan, seperti Ampere seni bina mempunyai enam susunan. Jalur lebar memori kami dikira dengan setiap pengawal memori berjalan pada lebar jalur penuh. Terdapat lapisan cache di antara setiap teras GPU, dan lebar jalur rangkaian pada cip kami adalah beberapa kali lebar jalur HBM, jadi pada asasnya kami hanya perlu menjalankan sebahagian kecil daripada multipemproses penstriman untuk memenuhi HBM. Dejan Milojicic: Bagaimanakah pengkomputeran teragih dengan NVLink berfungsi? Siapa yang memutuskan pengiraan mana yang perlu dilakukan? Di mana dan apakah overhed yang ditanggung apabila melakukan scatter-gather pada berbilang GPU? Bill Dally: Pengaturcara akan memutuskan tempat untuk meletakkan data dan utas lokasi, dan anda hanya memulakan urutan dan data pada GPU dan menentukan di mana ia dijalankan. Kelebihan utama sistem yang disambungkan menggunakan NVLink ialah ia adalah ruang alamat yang dikongsi, dan overhed penghantaran data yang agak kecil juga agak kecil, jadi kami menggunakan komunikasi kelompok dalam rangkaian. Biasanya, jika anda melakukan keselarian data dalam pembelajaran mendalam, maka setiap GPU akan menjalankan rangkaian yang sama, tetapi memproses bahagian yang berbeza dari set data yang sama, dan masing-masing akan Mengumpul kecerunan berat, kemudian anda berkongsi kecerunan merentas GPU dan mengumpul semua kecerunan dan kemudian menambahkannya pada pemberat. Komunikasi kluster sangat baik dalam mengendalikan kerja seperti ini. Dejan Milojicic: Sekiranya kita mencipta pemecut pembelajaran mendalam sejagat untuk semua aplikasi, atau patutkah kita mencipta pemecut khusus yang berasingan, seperti pemecut penglihatan atau pemecut pemprosesan bahasa semula jadi ? Bill Dally: Tanpa menjejaskan kecekapan, saya rasa pemecut Sudah tentu, lebih umum lebih baik, dan GPU Nvidia adalah setanding dengan pemecut khusus dalam mempercepatkan kecekapan pembelajaran mendalam. Apa yang benar-benar penting ialah bidang pembelajaran mesin bergerak ke hadapan pada kadar yang luar biasa. Beberapa tahun yang lalu, semua orang masih menggunakan rangkaian saraf berulang untuk memproses bahasa, dan kemudian Transformer muncul dan menggantikan RNN pada sekelip mata, semua orang mula menggunakan Transformer . Begitu juga, hanya beberapa tahun yang lalu, semua orang menggunakan CNN untuk memproses imej Walaupun ramai orang masih menggunakan rangkaian saraf konvolusi, semakin ramai orang mula menggunakan Transformers untuk memproses imej. Oleh itu, saya tidak menyokong pengkhususan berlebihan produk atau penciptaan pemecut khusus untuk rangkaian tertentu, kerana kitaran reka bentuk produk biasanya mengambil masa beberapa tahun, dan pada masa ini, orang mungkin berhenti menggunakannya. Kita mesti mempunyai pandangan yang tajam untuk mengesan perubahan dalam industri tepat pada masanya, kerana ia berkembang pada kadar yang membimbangkan sepanjang masa. Dejan Milojicic: Apakah kesan Undang-undang Moore terhadap prestasi GPU dan penggunaan memori? Bill Dally: Hukum Moore menyatakan bahawa kos transistor akan berkurangan tahun mengikut tahun. Hari ini, bilangan transistor yang boleh ditampung pada litar bersepadu sememangnya semakin meningkat, dan proses pembuatan cip juga telah membuat lonjakan daripada 16 nanometer kepada 7 nanometer Ketumpatan transistor pada litar bersepadu semakin besar, tetapi harganya daripada satu transistor tidak berkurangan. Jadi saya rasa Undang-undang Moore agak ketinggalan zaman. Namun, adalah satu perkara yang baik untuk mempunyai lebih banyak transistor pada litar bersepadu supaya kami boleh membina GPU yang lebih besar. GPU yang besar juga menggunakan lebih banyak kuasa dan lebih mahal, tetapi itu sentiasa perkara yang baik kerana kita boleh membina perkara yang tidak dapat kita bina sebelum ini. Dejan Milojicic: Jika pembangun memberi lebih perhatian kepada rangka kerja seperti PyTorch, maka apakah yang perlu mereka pelajari daripada kemajuan perkakasan untuk menjadikan model pembelajaran mendalam mereka berjalan dengan lebih baik? cekap? Bill Dally: Soalan ini sukar dijawab. Rangka kerja berfungsi dengan baik untuk mengabstraksikan perkakasan, tetapi masih terdapat beberapa faktor yang mempengaruhi kepantasan model anda berjalan yang patut disiasat. Apa yang boleh kita cuba lakukan ialah, apabila menghasilkan teknik yang lebih baik, seperti perwakilan berangka yang lebih baik, kita boleh cuba menggabungkan pelbagai teknik yang berbeza dengan rangka kerja dan melihat yang mana lebih berkesan, yang merupakan bahagian yang amat diperlukan dalam kerja R&D. Dejan Milojicic: Adakah Nvidia sedang bereksperimen dengan kaedah pembungkusan baharu? Bill Dally: Kami telah melakukan pelbagai kerja pada pelbagai teknologi pembungkusan Eksperimen dan ketahui perkara yang boleh dan tidak boleh mereka lakukan supaya anda boleh menggunakan teknologi tersebut ke dalam pengeluaran apabila tiba masanya. Sebagai contoh, beberapa projek ini sedang mengkaji modul berbilang cip, menggunakan bonggol pateri dan ikatan hibrid untuk menyusun cip Malah, terdapat banyak teknologi pembungkusan mudah. Dejan Milojicic: Berbanding dengan Teras Tensor Nvidia dan TPU Google, siapa yang lebih baik? Bill Dally: Kami tidak tahu banyak tentang TPU terbaharu Google, tetapi TPU yang mereka lancarkan sebelum ini semuanya adalah enjin khusus, pada asasnya terbina dalam tatasusunan pengganda-akumulator besar. Unit bebas TPU untuk mengendalikan perkara seperti fungsi bukan linear dan normalisasi kelompok (norma kelompok), tetapi pendekatan kami adalah untuk membina pemproses berbilang penstriman (SM) unit pengkomputeran yang sangat umum, hanya arahan yang sangat umum boleh digunakan untuk membuatnya melakukan apa sahaja, dan kemudian Tensor Cores digunakan untuk mempercepatkan bahagian pendaraban matriks. Jadi kedua-dua Teras Tensor dan TPU Google mempunyai tatasusunan pengganda-akumulator yang serupa, cuma tatasusunan yang kami gunakan adalah lebih kecil. Dejan Milojicic: Siapa saingan terbesar Nvidia? Bill Dally: NVIDIA tidak pernah membandingkan dengan syarikat lain. Lawan terbesar kami ialah diri kami sendiri, dan kami sentiasa mencabar diri kami sendiri. Jika kita membuta tuli menganggap orang lain sebagai pesaing, ia akan melambatkan kemajuan kita. Daripada terlalu fokus pada apa yang orang lain lakukan, kita harus benar-benar fokus pada apa yang mungkin. Apa yang kami lakukan adalah seperti mengejar kelajuan cahaya Kami memberi perhatian lebih kepada cara melakukan yang terbaik dan sejauh mana kami berada dari kelajuan cahaya. Dejan Milojicic: Apakah pendapat anda tentang pengkomputeran kuantum? Adakah simulasi kuantum lanjutan semula jadi daripada cabaran pembelajaran mendalam? Bill Dally: Pada Mac 2021, kami mengeluarkan kit pembangunan perisian yang dipanggil "cuQuantum". Google juga sebelum ini telah membangunkan komputer dengan 53 qubit dan mendakwa bahawa ia telah mencapai "keunggulan kuantum." Beberapa pengiraan yang tidak dapat diselesaikan oleh komputer tradisional boleh diselesaikan dalam masa lima minit menggunakan cuQuantum. Oleh itu, jika anda ingin mencapai algoritma kuantum yang benar-benar tepat, dan bukannya pengiraan Kuantum Skala Perantaraan Bising (NIST) hari ini, GPU harus menjadi pilihan terbaik. Komputer GPU tradisional Nvidia ialah salah satu komputer kuantum terpantas pada masa ini, dan Alibaba juga telah mencapai keputusan yang baik dalam pengiraan klasik yang serupa, yang hanya mengesahkan kesimpulan kami. Pandangan kami tentang pengkomputeran kuantum: Nvidia tidak akan terkejut dengan sebarang perkembangan dalam bidang teknologi ini. Malah, kami juga telah menubuhkan kumpulan penyelidikan untuk menjejaki perkembangan termaju dalam bidang pengkomputeran kuantum Sebagai contoh, IBM mengumumkan pembangunan cip dengan 127 qubit. Kami juga telah menjejaki kemajuan dalam aspek seperti bilangan qubit dan masa koheren. Memandangkan bilangan qubit yang diperlukan, ketepatan qubit, gangguan bunyi pada kuantum, dan overhed yang diperlukan untuk pembetulan ralat kuantum, saya fikir dalam tempoh lima hingga sepuluh tahun, kuantum akan Pengiraan tidak boleh dikomersialkan. Pandangan saya yang paling optimis ialah dalam masa kira-kira lima tahun, orang akan mula melakukan simulasi kimia kuantum, yang sepatutnya menjadi perkara yang paling mungkin dilakukan. Tetapi sebelum itu berlaku, masih terdapat banyak teka-teki fizikal untuk diselesaikan. Apa yang ramai orang tidak sedar ialah komputer kuantum adalah komputer analog, dan komputer analog perlu sangat tepat dan mudah diasingkan, jika tidak, sebarang gandingan kepada persekitaran akan membawa kepada keputusan yang tidak konsisten. Dejan Milojicic: Pada pendapat anda, bilakah mesin akan mencapai tahap kecerdasan am buatan (AGI)? Bill Dally: Saya mempunyai pandangan negatif tentang isu ini. Lihat beberapa kes penggunaan kecerdasan buatan yang lebih berjaya, seperti rangkaian saraf, yang pada asasnya adalah pelengkap fungsi universal. Rangkaian saraf boleh mempelajari fungsi melalui pemerhatian, jadi nilainya masih tercermin dalam persepsi buatan dan bukannya kecerdasan buatan. Walaupun kami telah mencapai keputusan yang baik setakat ini, kami boleh terus mengkaji cara menggunakan kecerdasan buatan dan pembelajaran mendalam untuk meningkatkan produktiviti, dengan itu meningkatkan penjagaan dan pendidikan perubatan, dan membawa perkara yang lebih baik kepada kehidupan orang. Sebenarnya, kita tidak memerlukan AGI untuk melakukan ini, tetapi harus memberi tumpuan kepada cara memaksimumkan penggunaan teknologi sedia ada. Masih jauh lagi perjalanan sebelum AGI, dan kita juga mesti faham apa itu AGI. 5 Masa depan perkakasan pembelajaran mendalam

6 Ringkasan

Bill Dally:

Atas ialah kandungan terperinci Ketua Saintis NVIDIA: Perkakasan pembelajaran mendalam masa lalu, masa kini dan masa depan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI