Rumah >Peranti teknologi >AI >Meta mengeluarkan model bahasa topeng 'bukan parametrik' pertama NPM: mengalahkan GPT-3 dengan 500 kali ganda bilangan parameter

Meta mengeluarkan model bahasa topeng 'bukan parametrik' pertama NPM: mengalahkan GPT-3 dengan 500 kali ganda bilangan parameter

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 10:13:061128semak imbas

Walaupun prestasi hebat model bahasa berskala besar dalam bidang NLP adalah menakjubkan, kos negatif yang dibawanya juga serius, seperti terlalu mahal untuk dilatih dan sukar dikemas kini. , dan sukar untuk menangani pengetahuan panjang.

Dan model bahasa biasanya menggunakan lapisan softmax yang mengandungi perbendaharaan kata terhad dalam lapisan ramalan, yang pada dasarnya tidak mengeluarkan perkataan atau frasa yang jarang, yang sangat mengehadkan keupayaan ekspresi model.

Untuk menyelesaikan masalah long-tail model, sarjana dari University of Washington, Meta AI dan Allen Institute for Artificial Intelligence baru-baru ini bersama-sama mencadangkan "model bahasa Topeng Bukan Parametrik" yang pertama (bahasa Topeng Bukan Parametrik model, NPM), yang menggantikan output softmax dengan merujuk kepada taburan bukan parametrik bagi setiap frasa dalam korpus.

Pautan kertas: https://arxiv.org/abs/2212.01349

Pautan kod: https://github.com/facebookresearch/NPM

NPM boleh dilatih dengan berkesan oleh objektif kontrastif dan anggaran intra-batch untuk mendapatkan semula korpus lengkap.

Para penyelidik menjalankan penilaian sifar pada 9 tugasan tertutup dan 7 tugasan terbuka, termasuk transformasi ruang dan tugas terjemahan peringkat perkataan yang menekankan keperluan untuk meramal fakta baharu atau frasa yang jarang ditemui.

Hasilnya menunjukkan bahawa tidak kira sama ada kaedah perolehan semula dan penjanaan digunakan, NPM adalah jauh lebih baik daripada model parameter yang lebih besar Contohnya, GPT-3 dengan 500 kali lebih parameter dan OPT 13B dengan prestasi 37 kali lebih banyak. lebih baik, dan NPM amat mahir dalam mengendalikan corak yang jarang berlaku (makna perkataan atau fakta) dan meramalkan perkataan yang jarang atau jarang dilihat (seperti skrip bukan Latin).

Model bahasa bukan parametrik pertama

Walaupun masalah ini boleh dikurangkan dengan menggabungkan beberapa kerja berkaitan ambil dan jana sedia ada, bahagian ramalan akhir model ini Lapisan softmax masih diperlukan untuk meramalkan token, yang pada asasnya tidak menyelesaikan masalah ekor panjang.

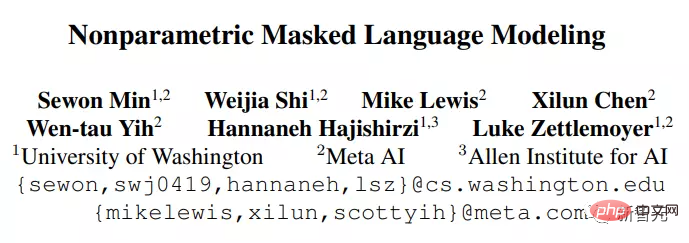

NPM terdiri daripada pengekod dan korpus rujukan Pengekod memetakan teks ke dalam vektor bersaiz tetap, dan kemudian NPM mengambil frasa daripadanya dan mengisi [MASK].

Seperti yang anda lihat, NPM memilih taburan bukan parametrik yang diperolehi pada frasa dan bukannya menggunakan softmax perbendaharaan kata output tetap sebagai output.

Tetapi latihan model bukan parametrik juga membawa dua masalah utama:

1 Mendapatkan semula korpus yang lengkap semasa proses latihan adalah sangat memakan masa dan memerlukan tenaga kerja yang banyak dengan penghampiran intra-batch untuk mendapatkan semula korpus yang lengkap;

Ringkasnya, NPM membuang sepenuhnya softmax perbendaharaan kata keluaran, mencapai ruang keluaran tanpa had yang berkesan dengan meramalkan sebarang bilangan n-gram.

Model yang terhasil boleh meramalkan perkataan "sangat jarang" atau bahkan "tidak kelihatan sepenuhnya" (seperti perkataan Korea), dan boleh menyokong saiz perbendaharaan kata tanpa had dengan berkesan, yang model sedia ada tidak dapat mewujudkannya.

Kaedah NPM

Idea utama NPM ialah menggunakan pengekod untuk memetakan semua frasa dalam korpus ke dalam ruang vektor yang padat. Pada masa inferens, apabila diberi pertanyaan dengan [MASK], gunakan pengekod untuk mencari frasa terdekat daripada korpus dan isikan [MASK].

Model pengekod tulen (Pengekod sahaja) ialah model perwakilan yang sangat kompetitif, tetapi model pengekodan tulen sedia ada tidak boleh membuat ramalan dengan bilangan token yang tidak diketahui, menjadikan penggunaannya tanpa penalaan halus adalah terhad.

NPM menyelesaikan masalah ini dengan mendapatkan semula frasa untuk mengisi [MASK] dengan sebarang bilangan token.

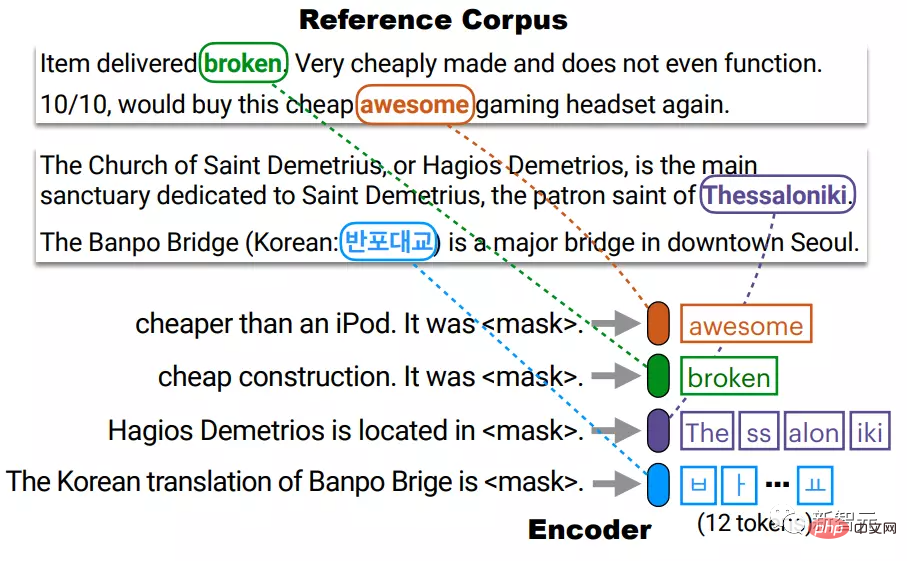

InferensPengekod memetakan setiap frasa yang berbeza dalam korpus rujukan C ke dalam ruang vektor yang padat.

Pada masa ujian, pengekod memetakan pertanyaan bertopeng ke dalam ruang vektor yang sama dan mengisi [MASK] dengan frasa yang diambil daripada C.

Di sini, C tidak semestinya sama dengan korpus latihan dan boleh diganti atau dilanjutkan pada masa ujian tanpa melatih semula pengekod.

Dalam amalan, terdapat sejumlah besar frasa dalam korpus, dan mengindeks kesemuanya adalah mahal.

Sebagai contoh, jika kita menganggap frasa dengan paling banyak l token (l≈20), kita perlu mengindeks l×|C| bilangan vektor, yang mungkin memakan masa.

Para penyelidik mengindeks setiap token yang berbeza dalam C, dengan itu mengurangkan saiz indeks daripada l×|C| kepada |C|, dan kemudian apabila menguji, The non- taburan parametrik semua frasa dianggarkan dengan melakukan carian jiran terhampir k secara berasingan untuk permulaan dan penghujung.

Para penyelidik mengindeks setiap token yang berbeza dalam C, dengan itu mengurangkan saiz indeks daripada l×|C| kepada |C|, dan kemudian apabila menguji, The non- taburan parametrik semua frasa dianggarkan dengan melakukan carian jiran terhampir k secara berasingan untuk permulaan dan penghujung.

Sebagai contoh, frasa Thessaloniki yang terdiri daripada 4 token BPE diwakili oleh sambungan c1 dan c4, yang sepadan dengan permulaan (The) dan akhir (iki) frasa masing-masing.

Kemudian wakili pertanyaan dengan dua vektor q_start dan q_end dalam ruang vektor yang sama, dan kemudian gunakan setiap vektor untuk mendapatkan semula permulaan dan penghujung frasa yang munasabah sebelum mengagregatkan.

Premis untuk melakukan ini ialah perwakilan permulaan dan penghujungnya cukup baik, iaitu titik permulaan q cukup dekat dengan c1, dan titik akhir q cukup dekat dengan c4 , dan ini telah dipastikan semasa proses latihan.

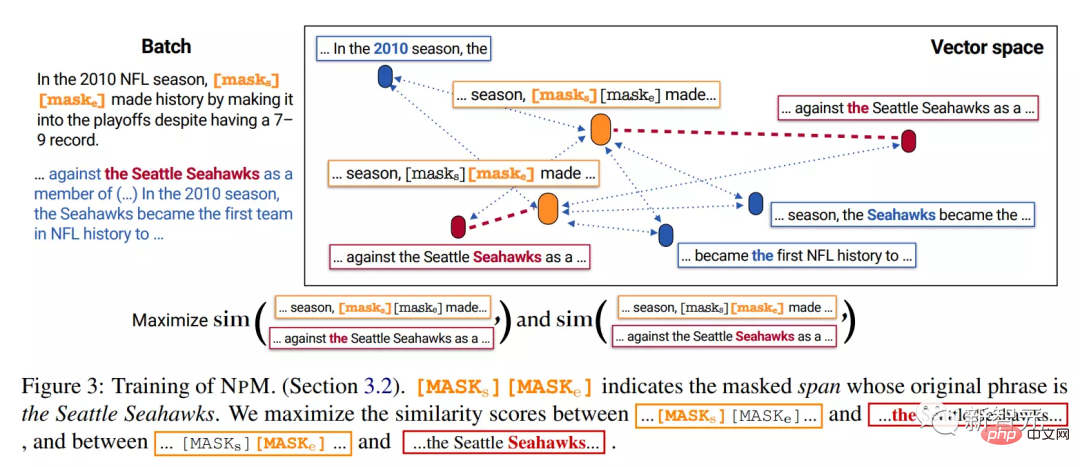

Latihan

NPM dilatih pada data teks tidak berlabel untuk memastikan pengekod memetakan teks ke dalam ruang vektor padat yang baik.

Terdapat dua masalah utama dalam latihan NPM: 1) Pengambilan korpus yang lengkap akan menjadikan latihan sangat memakan masa; 2) Mengisi [MASK] dengan frasa yang panjangnya sewenang-wenangnya dan bukannya token.

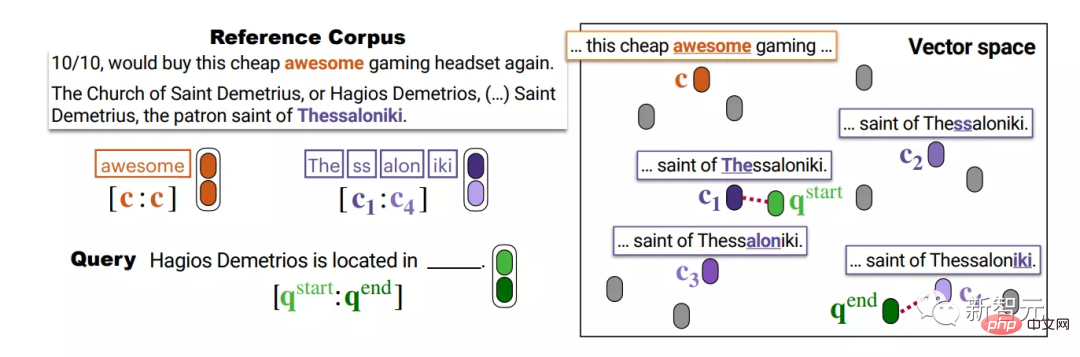

1. Masking Masking

Span masking adalah untuk menutup token berterusan yang panjangnya diambil daripada taburan geometri.

Para penyelidik mengembangkan perkara ini:

1) Jika beberapa serpihan berlaku bersama dalam urutan lain dalam kelompok, ia kemudiannya ditutup untuk memastikan bahawa dalam kumpulan semasa latihan Contoh-contoh positif (dalam- kumpulan positif).

Contohnya, klip bertopeng tahun 2010, Seattle Seahawks dan kepada semua berlaku bersama dalam urutan lain.

Tetapi untuk "permainan" bigram, mereka tidak boleh ditutup bersama-sama Walaupun mereka juga muncul dalam dua urutan, mereka tidak berlaku bersama.

2) Daripada menggantikan setiap token dalam serpihan dengan [MASK], gantikan keseluruhan serpihan dengan dua token khas [MASK][MASKe].

Sebagai contoh, dalam contoh di atas, tanpa mengira panjang segmen bertopeng, ia digantikan dengan [MASK][MASKe], supaya vektor permulaan dan akhir setiap segmen boleh diperoleh, membuat penaakulan lebih selesa.

2. Objektif latihan

Dengan mengandaikan bahawa klip bertopeng adalah Seattle Seahawks, semasa ujian, model harus belajar daripada korpus rujukan Frasa Seattle Seahawks telah diambil daripada urutan lain .

Dalam peringkat inferens, model memperoleh vektor daripada [MASK] dan [MASKe] dan menggunakannya untuk mendapatkan semula permulaan dan akhir frasa masing-masing daripada korpus.

Oleh itu, matlamat latihan harus menggalakkan vektor [MASK] menjadi lebih dekat dengan Seattle Seahawks dan lebih jauh daripada token lain, dan tidak sepatutnya menjadi dalam mana-mana frasa, seperti menjadi dalam pertama.

Kami melakukan ini dengan melatih model untuk menganggarkan korpus penuh kepada jujukan lain dalam kelompok Secara khusus, kami melatih model untuk mendapatkan semula titik permulaan segmen Seattle Seahawks daripada jujukan lain dalam kumpulan yang sama dan titik akhir.

Perlu diingat bahawa strategi topeng ini memastikan setiap rentang bertopeng mempunyai segmen yang berlaku bersama dalam satu kelompok.

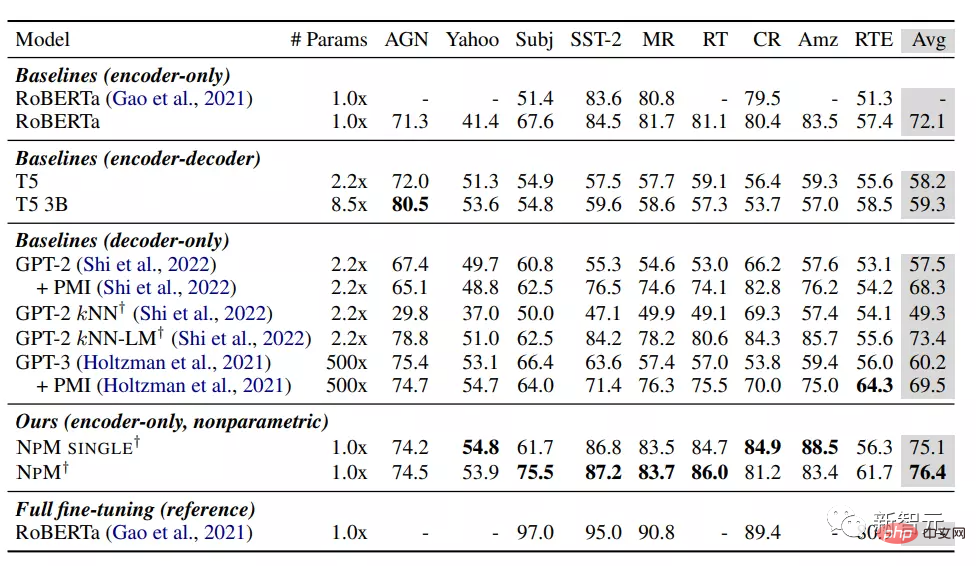

Bahagian eksperimen

Daripada keputusan, NPM berprestasi lebih baik daripada model garis dasar lain dalam tetapan tangkapan sifar.

Antara model parametrik, RoBERTa mencapai prestasi terbaik, tanpa diduga mengatasi model termasuk GPT-3, mungkin kerana model pengekod tulen. Dwiarah memainkan peranan penting, yang juga menunjukkan bahawa model bahasa kausal mungkin bukan pilihan yang sesuai untuk pengelasan.

Kaedah kNN-LM menambah komponen bukan parametrik pada model parametrik dan prestasinya lebih baik daripada semua garis dasar lain. Namun begitu, bergantung semata-mata pada perolehan semula (kNN) berprestasi buruk dalam GPT-2, menunjukkan had penggunaan kNN hanya pada masa inferens.

Kedua-dua NPM SINGLE dan NPM secara ketara mengatasi semua garis dasar, mencapai prestasi unggul secara konsisten pada semua set data. Ini menunjukkan bahawa model bukan parametrik sangat kompetitif walaupun untuk tugasan yang tidak memerlukan pengetahuan luaran secara eksplisit.

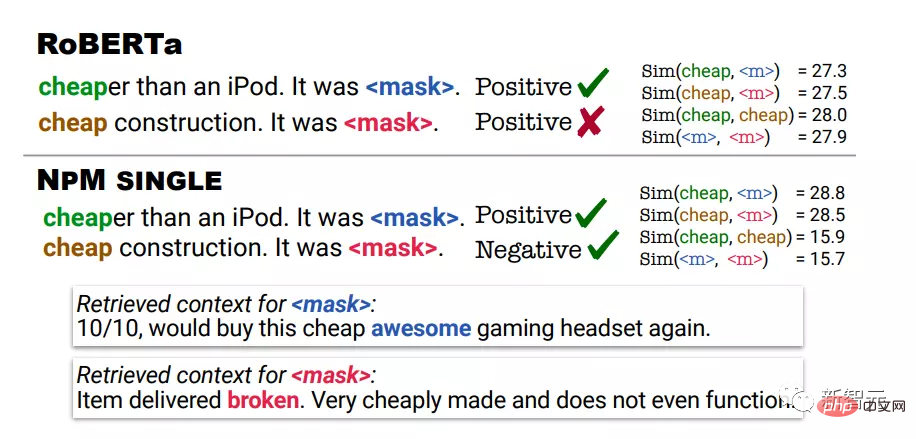

Analisis kualitatif menggunakan keputusan ramalan RoBERTa dan NPM dalam tugasan analisis sentimen. Dalam contoh pertama, murah bermakna tidak mahal, dan dalam contoh kedua, murah bermaksud kualiti yang tidak baik.

Ramalan RoBERTa adalah positif untuk kedua-dua contoh, manakala NPM membuat ramalan yang betul dengan mendapatkan semula konteks yang murah digunakan dalam konteks yang sama dengan ramalan input.

Ia juga boleh didapati bahawa output perwakilan oleh NPM boleh membawa kepada nyahkekaburan makna perkataan yang lebih baik. Sebagai contoh, RoBERTa memberikan skor persamaan yang tinggi antara murah dan murah.

Sebaliknya, NPM berjaya memberikan skor persamaan yang rendah antara murah dan murah, yang juga menunjukkan bahawa latihan bukan parametrik dengan objektif kontrastif ini berkesan dan boleh meningkatkan pembelajaran perwakilan dengan lebih baik, manakala inferens kNN Algoritma jenis ini tanpa latihan adalah mustahil sama sekali.

Rujukan: https://arxiv.org/abs/2212.01349

Atas ialah kandungan terperinci Meta mengeluarkan model bahasa topeng 'bukan parametrik' pertama NPM: mengalahkan GPT-3 dengan 500 kali ganda bilangan parameter. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI