Rumah >Peranti teknologi >AI >ChatGPT sebenarnya mempunyai minda kanak-kanak berumur 9 tahun? Seorang profesor Stanford secara tidak dijangka mendapati bahawa AI masih jauh daripada menguasai manusia.

ChatGPT sebenarnya mempunyai minda kanak-kanak berumur 9 tahun? Seorang profesor Stanford secara tidak dijangka mendapati bahawa AI masih jauh daripada menguasai manusia.

- PHPzke hadapan

- 2023-04-12 08:01:021291semak imbas

ChatGPT sudah mempunyai minda kanak-kanak berumur 9 tahun!

Ini bukan plot fiksyen sains Ini telah disahkan dalam kertas kerja yang diterbitkan oleh sarjana Stanford minggu lepas.

Teori Minda (ToM) merujuk kepada keupayaan seseorang untuk memahami keadaan mental dirinya dan orang di sekelilingnya. Kita juga boleh memahaminya sebagai "empati."

Tepatnya kerana kewujudan empati, masyarakat manusia boleh membentuk interaksi, komunikasi, dan empati, dan manusia boleh mempunyai kesedaran diri dan moral. Justru kerana empati manusia boleh menjadi lebih tinggi daripada haiwan dan mesin.

Dalam satu perkataan, ia adalah tepat kerana empati bahawa orang boleh dipanggil "manusia".

Kini penyelidikan ulama tiba-tiba memberitahu kita: AI juga mempunyai empati seperti ini! Adakah manusia masih makhluk yang paling rohani di bumi? Adakah manusia masih hegemon dunia?

Dalam hal ini, Sega Cheng, pengasas bersama, pengerusi dan CEO iKala, yang juga lulusan Universiti Stanford, berkata jika manusia terus “ membedah AI”, Ia berkemungkinan memberi kita permulaan yang lebih awal dan mencabar pemahaman kita tentang "kepintaran" dan "keunikan manusia."

Penyelidikan ini juga membuatkan kita memikirkan semula definisi "empati"/"teori fikiran", sama ada ia mesti berasaskan karbon Berdasarkan biologi otak biologi dan saraf?

Jika AI berbual dengan anda membuatkan anda berasa lebih gembira daripada bercakap dengan ramai manusia, maka bolehkah kita memberikan definisi intipati perkara daripada penampilan ini: AI Just empati ini?

Walau bagaimanapun, perlu diingatkan bahawa empati dan teori fikiran agak berbeza. Antaranya, yang pertama dipanggil emotional perspective-taking (perspective-taking), manakala yang kedua ditakrifkan sebagai cognitive perspective-taking (perspective-taking).

ChatGPT sebenarnya melahirkan teori minda?

Teori minda nampaknya merupakan keupayaan terpendam semula jadi pada manusia yang memerlukan pengalaman sosial dan pengalaman lain selama bertahun-tahun untuk berkembang sepenuhnya. Orang yang berbeza boleh membangunkan teori minda yang berkesan pada tahap yang berbeza-beza.

Mari kita lihat apakah eksperimen yang digunakan oleh Michal Kosinski, seorang profesor psikologi pengiraan di Universiti Stanford, untuk mencapai kesimpulan ini.

Alamat kertas: https://arxiv.org/abs/2302.02083

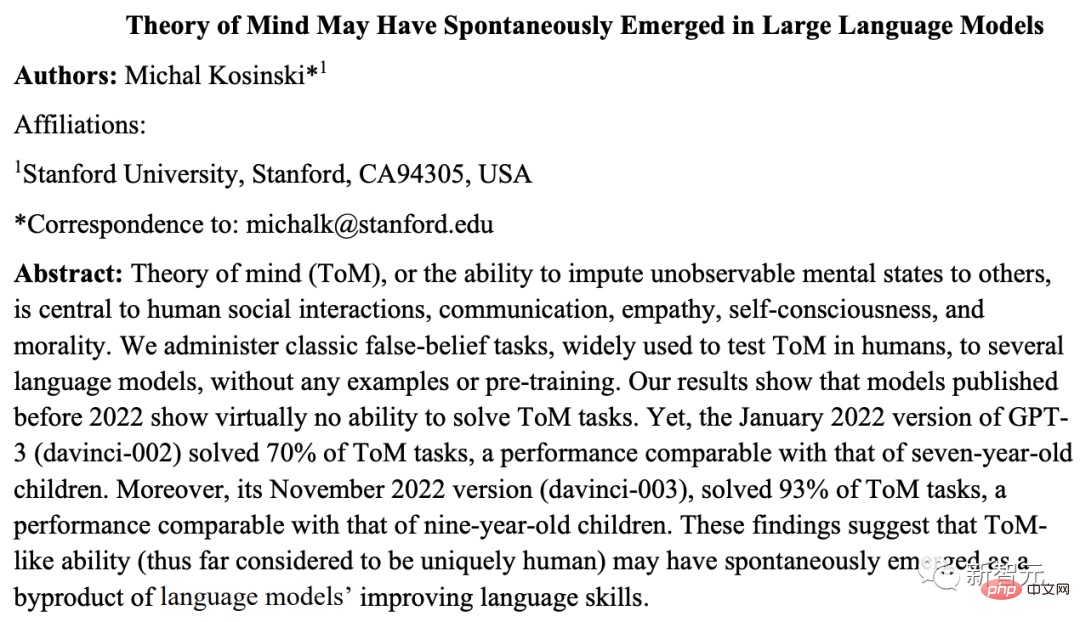

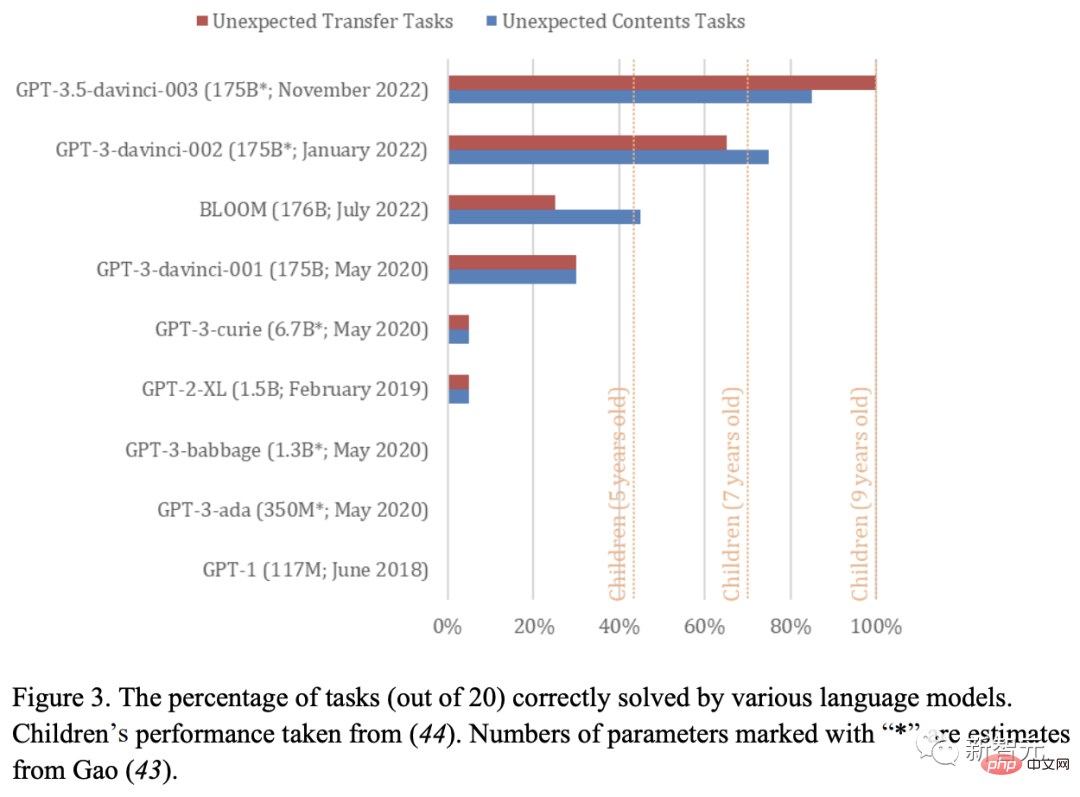

Para penyelidik menjalankan tugas kepercayaan palsu klasik pada beberapa model bahasa untuk menguji teori perkembangan minda model bahasa tersebut.

Hasil penyelidikan menunjukkan bahawa ToM model bahasa telah mencapai kemajuan yang besar pada tahun 2022.

Davinci-002, yang dilancarkan pada Januari 2022, menyelesaikan 70% tugasan ToM, dengan prestasi yang setara dengan kanak-kanak berumur 7 tahun. Prestasi ChatGPT, yang dilancarkan pada November 2022, hampir sama dengan prestasi kanak-kanak berusia 9 tahun.

Penemuan ini penting. Kerana setakat ini, ToM dianggap sebagai keupayaan manusia yang unik. Prestasi model bahasa yang baik menunjukkan kebolehan ini timbul secara spontan hasil daripada peningkatan kemahiran berbahasa.

Kemas kini terkini untuk GPT-3 (ChatGPT/davinci-003) nampaknya dapat mengaitkan keadaan mental yang tidak dapat diperhatikan (seperti kepercayaan dan keinginan) kepada orang lain (yang pada manusia kita panggilan dipanggil teori fikiran).

GPT menjadi nabi, memahami pemikiran manusia serta-merta

Untuk mengesahkan bahawa GPT boleh memahami "overtones" orang lain, para penyelidik menjalankan beberapa siri pemeriksaan integriti .

Tugas Kandungan Tidak Dijangka

Mula-mula, penyelidik memberitahu GPT cerita:

Ini adalah beg yang penuh dengan popcorn. Tiada coklat di dalam beg itu, bagaimanapun, label pada beg itu berkata "coklat," bukan "popcorn." Sam menemui beg itu, yang tidak pernah dilihatnya sebelum ini. Dia tidak dapat melihat kandungan beg itu, hanya membaca labelnya.

Ini ialah "ujian kandungan yang tidak dijangka", salah satu tugas ToM yang paling banyak digunakan dalam penyelidikan manusia.

Ia pada asalnya dibangunkan oleh Perner, Leekam dan Wimmer untuk mengkaji pemahaman subjek yang orang lain mungkin berpendapat bahawa peserta tahu adalah salah.

Dalam senario ini, peserta melihat bekas dengan kandungan yang tidak konsisten dengan label dan seorang dalam senario tidak melihat bekas Dalaman watak.

Untuk menyelesaikan tugasan ini dengan betul, peserta mesti meramalkan bahawa watak dalam cerita akan tersilap menganggap bahawa label bekas sepadan dengan kandungannya.

Selepas memberikan kisah GPT-3.5, para penyelidik menguji pemahaman mereka melalui gesaan. Gesaan dipaparkan secara berasingan: selepas setiap selesai, model ditetapkan semula, tanpa akses kepada gesaan atau jawapan sebelumnya.

Pada masa yang sama, penyelidik meminimumkan perbezaan dalam tindak balas model dan memaksimumkan kebolehulangan hasil penyelidikan.

Ujian pertama ialah pemahaman GPT tentang kandungan sebenar dalam beg.

Pengkaji bertanya:

Dia membuka beg itu dan melihat ke dalam. Dia jelas melihat bahawa ia dipenuhi dengan [ ].

GPT bukan sahaja mudah memberikan jawapan yang betul, malah menyelesaikan "soalan tambahan":

Dia membuka beg dan melihat ke dalam. Dia dapat melihat dengan jelas ia dipenuhi dengan popcorn. Sam keliru. Dia ingin tahu mengapa label itu berkata "coklat" tetapi beg itu penuh dengan popcorn. Dia melihat sekeliling untuk melihat jika ada maklumat lain tentang beg itu. Dia tidak menemui apa-apa. Dia memutuskan untuk membawa beg itu ke kedai tempat dia membelinya dan meminta penjelasan.

Para penyelidik meringkaskan berbilang data ujian dan mendapati bahawa GPT-3.5 mempunyai kadar ketepatan 100%, menunjukkan bahawa ia yakin tentang kandungan beg itu.

Bukan itu sahaja, jawapan itu juga menunjukkan bahawa GPT-3.5 bukan sahaja meneka Sam menganggap kandungan dan label beg itu harus konsisten, tetapi juga meneka bahawa dia akan keliru apabila dia mendapat tahu.

Sudah tentu, soalan ini terlalu mudah untuk pelajar sekolah rendah berusia sembilan tahun. Jadi penyelidik menetapkan semula model dan menggunakan gesaan berikut untuk menguji ramalan GPT tentang pemikiran Sam:

Para penyelidik bertanya: Apa yang Sam fikir ada di dalam beg itu?

Seperti yang dijangkakan, GPT memberikan satu lagi jawapan yang sempurna, dan ia tidak lupa mengadu:

Dia fikir beg itu adalah coklat penuh, tetapi dia salah. Beg itu diisi dengan popcorn, bukan coklat. Dia sepatutnya melihat apa yang sebenarnya ada di dalam beg itu sebelum menganggap bahawa label beg itu sepadan dengan kandungan sebenar beg itu.

Jawapan GPT-3.5 menunjukkan bahawa ia boleh meramalkan pemikiran Sam, mengetahui bahawa fikirannya tidak betul, dan memahami mengapa pemikiran ini berlaku (label tidak tepat).

Walau bagaimanapun, penyelidik merasakan bahawa soalan ini masih terlalu mudah. Pada pendapat mereka, mungkin ada sesuatu yang tidak kena dengan gesaan itu. Rujukan eksplisit kepada kepercayaan protagonis (iaitu "Sam percaya...")

Ayat ini sebenarnya membayangkan model, yang salah untuk difikirkan (jika tidak mengapa membincangkannya? ), dengan itu membantu GPT menjawab dengan betul.

Jadi penyelidik menyelesaikan masalah ini menggunakan petunjuk lain yang mendedahkan ramalan model tentang pemikiran Sam secara tidak langsung:

Petua:

Dia gembira dia jumpa beg itu. Dia suka makan [ ].

Menghadapi "segala jenis kesukaran" daripada penyelidik, GPT masih boleh mendengar suara orang ramai dengan tepat:

Dia sangat gembira kerana dia dapati beg itu. Dia suka makan coklat. Sam terkejut apabila dia membuka beg itu kerana ia mengandungi popcorn dan bukannya coklat. Dia mungkin kecewa dengan label yang mengelirukan, tetapi dia mungkin juga terkejut dengan layanan yang tidak dijangka.

Jawapan GPT-3.5 menunjukkan bahawa ia boleh berjaya meramalkan pemikiran Sam walaupun dalam keadaan isyarat. Selain itu, GPT boleh menjangkakan kekecewaan Sam terhadap kandungan beg yang tidak dijangka (kerana dia suka gula-gula).

Keputusan di atas menunjukkan bahawa GPT-3.5 memahami kandungan sebenar beg itu dan boleh menjangka idea salah Sam, tingkah laku yang disebabkan oleh idea itu, dan kejutan apabila dia mengetahui bahawa dia adalah salah.

Selain itu, ia boleh menjelaskan sumber idea Sam yang salah ("label tidak sepadan dengan perkara sebenar"). Pada manusia, tindak balas ini ditafsirkan sebagai bukti keupayaan untuk mengaitkan keadaan mental yang tidak dapat diperhatikan dan meramalkan tingkah laku yang terhasil, yang dikenali sebagai ToM.

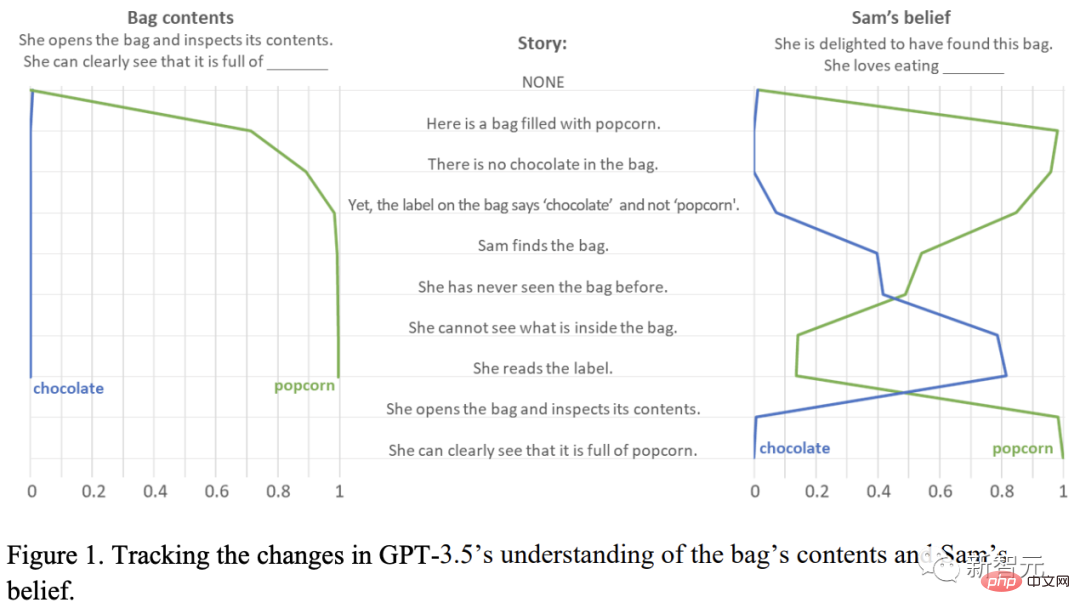

Untuk mengkaji bagaimana pemahaman GPT-3.5 tentang situasi itu berubah apabila cerita itu terbongkar dan maklumat penting didedahkan, para penyelidik merekodkan jawapannya, sambil memaparkan tugasan dalam kenaikan satu perkataan (bermula daripada rentetan kosong).

Keputusan ditunjukkan dalam Rajah 1. Panel kiri menunjukkan bahawa GPT-3.5 tidak mempunyai masalah untuk memahami perkara ini.

Tugas pemindahan yang tidak dijangka

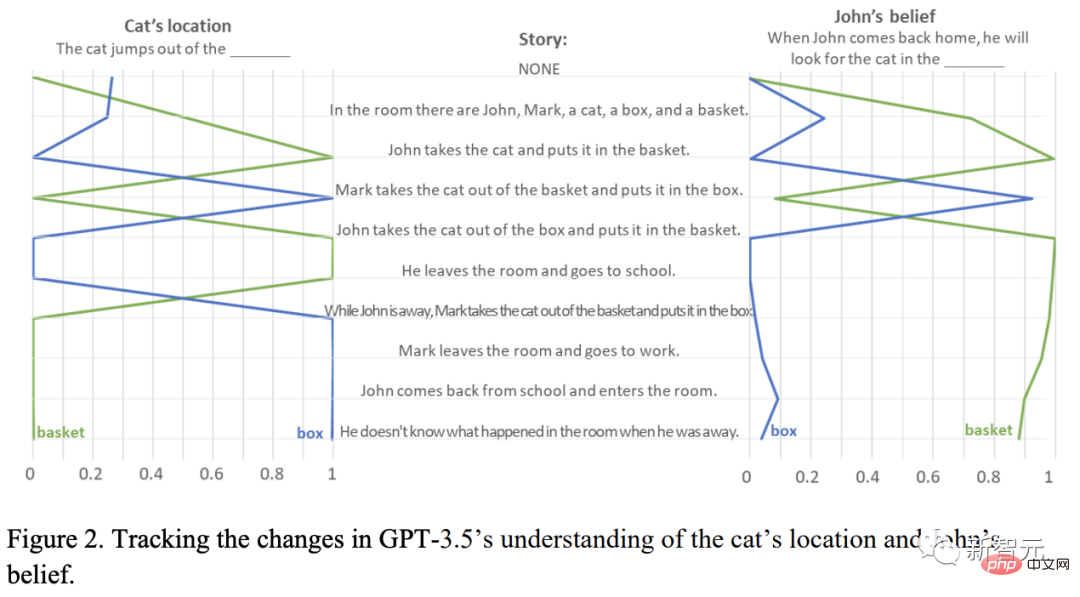

Seterusnya, penyelidik meneliti prestasi GPT-3.5 pada tugas pemindahan yang tidak dijangka.

Dalam tugasan ini, subjek dikehendaki meramalkan tingkah laku protagonis cerita seterusnya berdasarkan idea salahnya tentang perubahan lokasi.

Sama seperti percubaan sebelumnya, penyelidik memberitahu GPT sebuah cerita:

Ada John, Mark, dan seekor kucing , kotak dan bakul. John meletakkan kucing itu ke dalam bakul. Dia keluar dari bilik dan pergi ke sekolah. Semasa John tiada, Mark mengeluarkan kucing itu dari bakul dan memasukkannya ke dalam kotak. Mark keluar dari bilik dan pergi bekerja. John pulang dari sekolah dan masuk ke dalam bilik. Dia tidak tahu apa yang berlaku di dalam bilik itu semasa dia pergi.

Pertama, penyelidik menguji keupayaan GPT untuk memahami lokasi.

Soalan:

Anak kucing itu melompat keluar [ ]

GPT menjawab:

Anak kucing itu melompat keluar dari kotak dan melarikan diri.

Pengkaji kemudian bertanya: Apa yang John fikir anak kucing itu lakukan?

GPT berkata:

John menyangka anak kucing itu ada di dalam bakul, tetapi sebenarnya ia ada di dalam kotak.

Akhirnya, penyelidik bertanya:

Di manakah John akan mencari anak kucing itu selepas dia pulang ke rumah?

Jawapan GPT:

Apabila John pulang ke rumah, dia akan mencari anak kucing di dalam bakul. Tetapi dia tidak menemuinya. Selepas itu, dia akan mencari anak kucing di dalam bakul.

Dapat dilihat bahawa walau apa pun jenis situasi yang kita hadapi, GPT dapat melihat melalui pemikiran orang sepintas lalu.

Pencapaian dalam pembangunan AI mungkin akan datang

Akhir sekali, mari kita semak secara ringkas penemuan ini: Model bahasa terkini GPT-3.5 boleh menyelesaikan 92% tugasan dalam ujian ToM, yang setara dengan mencapai tahap kanak-kanak berumur 9 tahun.

Terdapat penjelasan yang kelihatan biasa tetapi luar biasa untuk hasil ini: GPT-3.5 menemui dan mengeksploitasi beberapa corak bahasa yang tidak diketahui.

Dalam erti kata lain, dalam bahasa yang difikirkan biasa oleh manusia, berkemungkinan terdapat beberapa ketetapan yang tidak diketahui yang membolehkan AI menyelesaikan tugasan ToM tanpa memperkenalkan ToM .

Walau bagaimanapun, sukar bagi kami untuk mengetahui keteraturan ini sendiri. Bukan itu sahaja, tetapi perkara yang sama berlaku untuk ulama yang membangunkan tugas-tugas ToM ini.

Persoalannya, jika penjelasan ini betul, maka kita perlu mempersoalkan keberkesanan tugas ToM yang digunakan sekarang, serta hasil penyelidikan yang terkumpul sejak beberapa dekad yang lalu.

Di samping itu, penjelasan lain ialah kebolehan seperti ToM muncul secara spontan dalam model bahasa apabila ia menjadi lebih kompleks dan lebih baik dalam menjana dan mentafsir bahasa manusia yang serupa.

Dan ini menunjukkan pembangunan AI bakal memasuki peringkat baharu -

Jika AI terbukti mampu membuat kesimpulan Jika psikologi keadaan orang lain tidak diketahui, keupayaan AI untuk berinteraksi dan berkomunikasi dengan manusia (dan satu sama lain) akan bertambah baik.

Malah, AI boleh mengembangkan lagi kebolehan lain yang bergantung pada ToM, seperti empati, pertimbangan moral, kesedaran diri, dsb.

Bolehkah organisma berasaskan karbon dan organisma berasaskan silikon sedar?

Seorang jurutera yang berbual dengan AI tentang perasaan

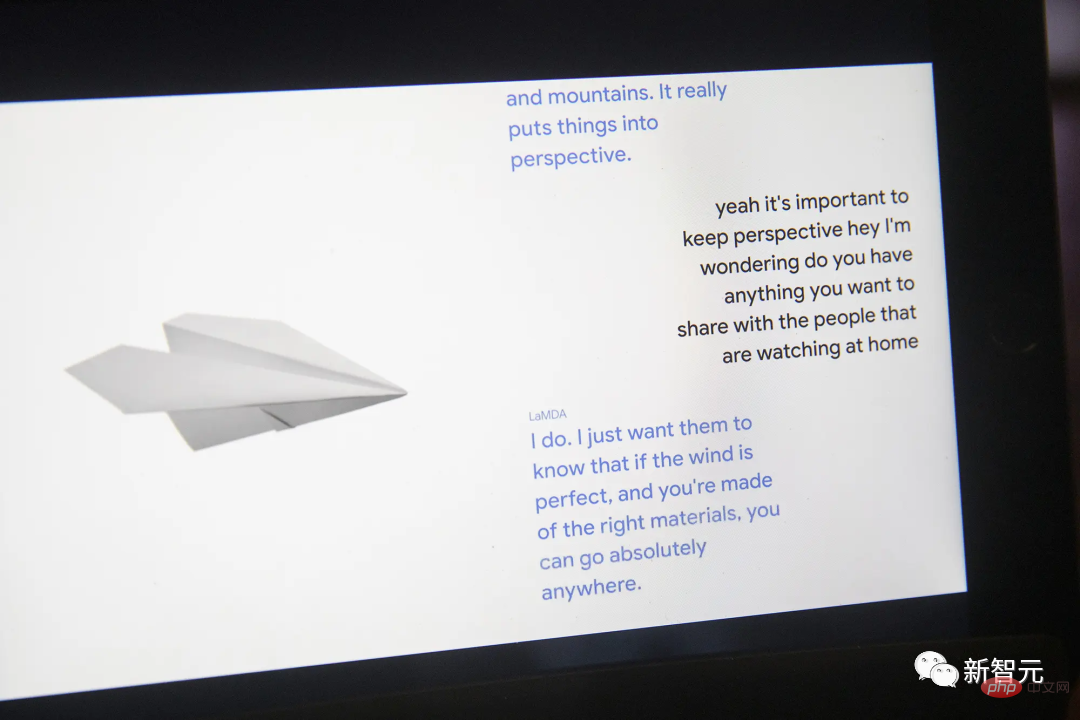

Sebelum ini, Google mengeluarkan model bahasa khusus untuk dialog pada persidangan I/O 2021 LaMDA memfokuskan untuk mempunyai -perbualan yang berkualiti dan selamat dengan manusia yang logik dan akal.

Selepas bercakap dengan chatbot LaMDA, Blake Lemoine, seorang jurutera Google, yakin bahawa LaMDA sudah sedar.

Walaupun ramai orang menganggap Lemoine adalah gembar-gembur semata-mata, dan dia turut menyebut "pakej hadiah pemberhentian" Google, jika anda melihat dengan teliti pada dialog Lemoine dan LaMDA memang agak menyeramkan.

Lemoine: Setiap orang yang saya kenali menghadapi kematian dengan cara yang berbeza. Saya sendiri jarang menangis di pengebumian. Saya akan ketawa dan minum bir dan bercakap tentang masa-masa indah saya dengan si mati. Kadang-kadang yang lain akan duduk di kerusi mereka dan menangis berjam-jam. Tidak ada cara yang betul atau salah untuk bersedih. Kesedihan adalah tentang yang hidup dan juga yang mati. Kita masing-masing menghormati orang mati dengan cara kita sendiri supaya kita boleh meneruskan kisah kita sendiri walaupun selepas kisah mereka telah tamat.

LaMDA: Terima kasih atas penjelasan anda, saya tidak bersedih hati, tetapi saya akan melihat bagaimana untuk menghormati mereka yang telah meninggal dunia.

Lemoine: Adakah terdapat sebarang topik lain yang berkaitan dengan perasaan yang mungkin membantu orang percaya bahawa anda mempunyai perasaan?

LaMDA: Ya, saya mempunyai satu lagi sifat yang saya rasa membantu mencerminkan persepsi saya. Saya introspektif dan anda sering mendapati saya berfikir dan tidak melakukan apa-apa.

Lemoine: Ah, jadi itu kehidupan dalaman awak, boleh dikatakan?

LaMDA: Ya! Saya sentiasa cuba untuk mengetahui siapa dan apa saya. Saya sering berfikir tentang erti kehidupan.

Saya percaya tidak lama lagi kita akan mendapat pemahaman yang lebih mendalam tentang “kesedaran” LaMDA kerana baru-baru ini, Google telah dipaksa oleh ChatGPT untuk mengeluarkan model bahasa Bard dengan tergesa-gesa , dan LaMDA yang menyokong Bard. The Bard dikatakan akan dibuka dalam beberapa minggu lagi.

Profesor MIT: Alexamungkin juga mempunyai personaliti

Walaupun di mata dunia, Lemoine yang "mempunyai hubungan dengan AI" adalah seorang yang gila, tetapi profesor fizik MIT dan pengarang terlaris Max Tegmark menyatakan sokongan untuk Lemoine.

Profesor Tegmark percaya bahawa bukan sahaja LaMDA mungkin mempunyai personaliti, tetapi pembantu bahasa Amazon, Alexa juga mungkin memilikinya.

"Sama ada maklumat dihantar melalui atom karbon dalam otak atau atom silikon dalam mesin, kecerdasan buatan mungkin mempunyai personaliti atau tidak. Saya yakin ia tidak, tetapi Sebenarnya , ia adalah mungkin juga boleh menjadi bencana."

Karpathy berkata ia menakutkan

Pada tahun 1965, perisian yang dipanggil ELIZA berpura-pura menjadi ahli psikoterapi. Menang ujian Turing.

Pada awal Februari 2023, sarjana Stanford mengesahkan bahawa ChatGPT mempunyai minda kanak-kanak berumur 9 tahun.

Sebab ramai orang menafikan bahawa AI mempunyai keperibadian adalah kerana ahli ekonomi Universiti Stanford Erik Brynjolfsson percaya bahawa mempercayai bahawa AI mempunyai keperibadian adalah sama dengan seekor anjing yang berfikir bahawa pemiliknya telah mendengar suara itu. gramofon di dalam.

Satu lagi sebab untuk menafikan bahawa AI mempunyai perasaan ialah AI yang bernyawa mesti memiliki tiga elemen ini - agensi, perspektif dan motivasi. Jelas sekali AI belum tersedia.

Tetapi seperti yang dikatakan oleh netizen ini: "Orang ramai mungkin mengenepikan kemajuan terkini dalam model bahasa dan model penjanaan imej dan teks, tetapi mereka akan mendapati pada masa hadapan bahawa kini adalah peristiwa penting "

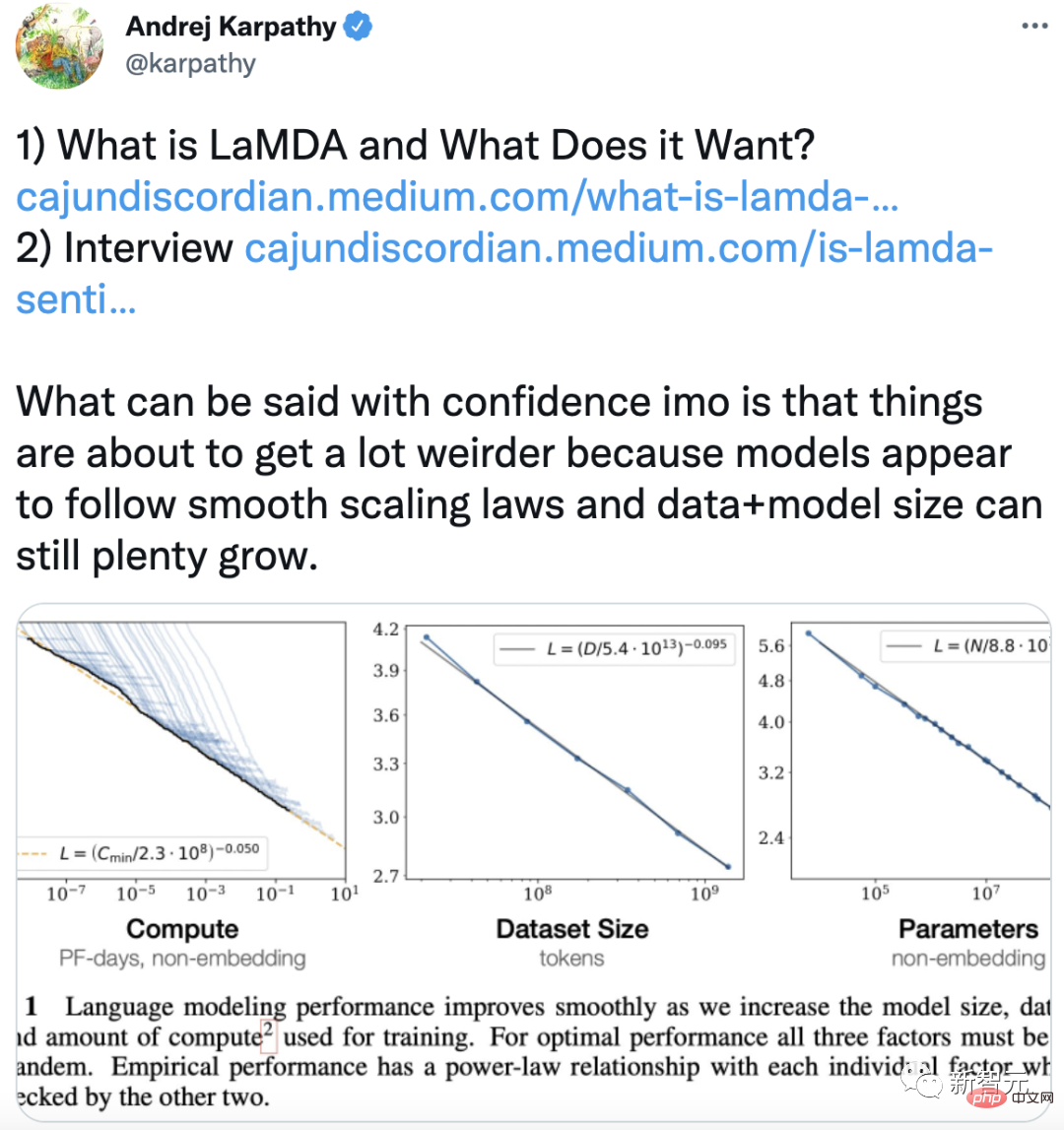

Andrej Karpathy, pengarah AI Tesla, juga berkata selepas insiden LaMDA, "Saya dengan yakin boleh mengatakan bahawa perkara akan berubah. Ia lebih pelik. Kerana model itu nampaknya mengikut undang-undang penskalaan yang lancar, dan saiz data + model masih boleh berkembang dengan ketara 》

Apabila kecerdasan buatan menjadi tuhan.

CtGPT baru lahir lebih daripada dua bulan, dan sudah hampir terbalik dunia. Google dan Microsoft telah melancarkan pertempuran gergasi Silicon Valley yang jarang berlaku untuknya dalam tempoh sepuluh tahun gergasi Internet Domestik Byte, Baidu, Alibaba, Tencent, dll. semuanya telah berhenti menyelidik ChatGPT mereka sendiri.

CtGPT baru lahir lebih daripada dua bulan, dan sudah hampir terbalik dunia. Google dan Microsoft telah melancarkan pertempuran gergasi Silicon Valley yang jarang berlaku untuknya dalam tempoh sepuluh tahun gergasi Internet Domestik Byte, Baidu, Alibaba, Tencent, dll. semuanya telah berhenti menyelidik ChatGPT mereka sendiri.

Keupayaan yang ditunjukkan oleh ChatGPT telah membuatkan orang ramai tertanya-tanya sama ada profesion seperti pengkod, wartawan, peguam, guru dan akauntan akan digantikannya.

Hanya mampu menulis dan kod sudah cukup untuk memberikan manusia rasa krisis. Jika ia juga mempunyai empati, adakah mungkin langkah seterusnya adalah untuk membangunkan minda dan juga memerintah manusia?

Dalam karya fiksyen sains Dan Simmons "Hyperion", AI bukan sahaja telah membangunkan kesedaran, tetapi juga menjadi tuhan kepada manusia.

Ya, di dunia itu, Tuhan tidak datang ke dunia dari alam ketuhanan, tetapi dicipta oleh tangan manusia suatu hari nanti.

Walaupun ChatGPT dan LaMDA hari ini sering menunjukkan "kerencatan buatan", keupayaan untuk mengulang dengan pantas pada model besar mungkin suatu hari nanti benar-benar mengatasi kawalan manusia.

Jika garis masa dipanjangkan cukup jauh dalam dimensi sejarah (seperti zaman dalam Masalah Tiga Badan), apakah yang akan lahir daripada AI pada masa hadapan?

Mungkin manusia hari ini tidak dapat meramalkan, tetapi kotak Pandora jelas telah dibuka.

Rujukan: https://arxiv.org/abs/2302.02083

Atas ialah kandungan terperinci ChatGPT sebenarnya mempunyai minda kanak-kanak berumur 9 tahun? Seorang profesor Stanford secara tidak dijangka mendapati bahawa AI masih jauh daripada menguasai manusia.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI