Rumah >Peranti teknologi >AI >Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang

Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 23:58:011189semak imbas

ChatGPT telah mencetuskan api model bahasa, dan pengamal NLP merenung dan meringkaskan hala tuju penyelidikan masa hadapan.

Baru-baru ini, pemenang Anugerah Turing Yann LeCun telah mengambil bahagian dalam menulis ulasan tentang "model bahasa yang dipertingkatkan", mengkaji The work combines model bahasa dengan kemahiran menaakul dan kebolehan menggunakan alatan, dan menyimpulkan bahawa hala tuju penyelidikan baharu ini berpotensi untuk menangani batasan model bahasa tradisional, seperti isu kebolehtafsiran, ketekalan dan skalabiliti.

Pautan kertas: https://arxiv.org/abs/2302.07842

Dalam model bahasa yang dipertingkatkan, penaakulan bermaksud menguraikan tugasan kompleks kepada subtugasan yang lebih mudah Alat termasuk memanggil modul luaran (seperti jurubahasa kod, kalkulator, dll.), dan LM boleh menggunakan Kaedah heuristik mengeksploitasi peningkatan ini. secara individu atau gabungan, atau melalui pembelajaran tunjuk cara.

Sambil mengikut matlamat ramalan token tiada standard, LM yang dipertingkatkan boleh menggunakan pelbagai modul luaran yang mungkin bukan parametrik untuk melanjutkan keupayaan pemprosesan konteks dan tidak terhad kepada pemodelan bahasa tulen Paradigma boleh dipanggil model bahasa tambahan (ALMs, Augmented Language Models).

Sasaran ramalan untuk token yang hilang membolehkan ALM belajar untuk menaakul, menggunakan alatan, dan juga bertindak (bertindak), sambil masih mampu melaksanakan tugas bahasa semula jadi standard dan bahkan mengatasi prestasi pada beberapa set data penanda aras Lebih daripada kebanyakan LM biasa.

Model Bahasa Dipertingkat

Model bahasa berskala besar (LLM) telah memacu kemajuan yang luar biasa dalam pemprosesan bahasa semula jadi dan secara beransur-ansur menjadi teras teknikal produk yang digunakan oleh berjuta-juta pengguna termasuk pembantu pengekodan Copilot, enjin carian Google dan ChatGPT yang dikeluarkan baru-baru ini.

Penghafalan digabungkan dengan keupayaan Kekomposisian membolehkan LLM melaksanakan pelbagai tugas seperti pemahaman bahasa atau penjanaan teks bersyarat dan tidak bersyarat pada tahap prestasi yang belum pernah berlaku sebelum ini, dengan itu memberi perkhidmatan kepada lebih ramai orang yang mempunyai interaksi komputer membuka jalan praktikal.

Walau bagaimanapun, perkembangan semasa LLM masih tertakluk kepada banyak sekatan, menghalang penggunaannya kepada rangkaian senario aplikasi yang lebih luas.

Sebagai contoh, LLM sering memberikan ramalan yang tidak berdasarkan fakta tetapi kelihatan munasabah, juga dikenali sebagai halusinasi Banyak ralat sebenarnya boleh dielakkan sepenuhnya, termasuk masalah aritmetik dan rantaian penaakulan Ralat kecil berlaku.

Tambahan pula, banyak keupayaan terobosan LLM nampaknya datang dengan skala, seperti yang diukur dengan bilangan parameter yang boleh dilatih, kerana penyelidik terdahulu telah menunjukkan bahawa sebaik sahaja model itu mencapai tahap tertentu. skala, LLM boleh menyelesaikan beberapa tugas BIG-bench melalui gesaan beberapa pukulan.

Walaupun terdapat usaha baru-baru ini untuk melatih beberapa LM yang lebih kecil sambil mengekalkan beberapa keupayaan model besar, skala semasa LLM dan permintaan untuk data menjadikan latihan dan penyelenggaraan sukar tidak praktikal: pembelajaran berterusan model besar kekal sebagai masalah penyelidikan terbuka.

Penyelidik meta percaya bahawa masalah ini berpunca daripada kecacatan asas LLM: proses latihan diberi model parameter dan konteks terhad (biasanya n perkataan sebelum dan seterusnya), dan kemudian melaksanakan statistik pemodelan bahasa.

Walaupun saiz konteks n telah berkembang sejak beberapa tahun kebelakangan ini disebabkan oleh pembangunan perisian dan perkakasan, kebanyakan model masih menggunakan saiz konteks yang agak kecil, jadi saiz besar model disimpan Tidak hadir ialah syarat yang diperlukan untuk pengetahuan kontekstual, yang juga penting untuk melaksanakan tugas hiliran.

Oleh itu, trend penyelidikan yang semakin meningkat adalah untuk menyelesaikan masalah ini dengan cara yang sedikit menyimpang daripada paradigma pemodelan bahasa statistik semata-mata yang disebutkan di atas.

Sebagai contoh, terdapat kerja untuk memintas masalah saiz konteks terhad LLM dengan menambah pengiraan perkaitan daripada "maklumat yang diekstrak daripada fail luaran yang berkaitan". Dengan melengkapkan LM dengan modul dapatkan semula untuk mendapatkan semula dokumen sedemikian dalam konteks tertentu daripada pangkalan data, kami boleh memadankan beberapa keupayaan LM berskala lebih besar sambil mempunyai parameter yang lebih sedikit.

Adalah penting untuk ambil perhatian bahawa model yang terhasil kini bukan parametrik, kerana ia boleh menanyakan sumber data luaran. Secara umumnya, LM juga boleh menambah baik konteksnya melalui strategi inferens untuk menjana konteks yang lebih relevan sebelum menjana jawapan, meningkatkan prestasi melalui lebih banyak pengiraan.

Strategi lain ialah membenarkan LM memanfaatkan alatan luaran untuk meningkatkan konteks semasa dengan maklumat penting yang hilang yang tidak terkandung dalam pemberat LM. Walaupun kebanyakan kerja ini bertujuan untuk mengurangkan kelemahan LM yang disebutkan di atas, adalah mudah untuk membayangkan bahawa meningkatkan LM dengan lebih sistematik dengan penaakulan dan alatan boleh membawa kepada agen yang lebih berkuasa.

Penyelidik secara kolektif merujuk model ini sebagai Model Bahasa Ditambah (ALM) .

Apabila aliran ini semakin pantas, menjadi sukar untuk menjejaki dan memahami pelbagai model, yang memerlukan pengelasan kerja ALM dan istilah teknikal yang kadangkala digunakan untuk tujuan yang berbeza Tentukan.

Penaakulan

Dalam konteks ALM, penaakulan ialah penguraian tugas yang mungkin kompleks kepada Subtugasan yang lebih mudah yang LM boleh menyelesaikan dengan lebih mudah sendiri atau menggunakan alatan.

Pada masa ini terdapat pelbagai cara untuk menguraikan subtugasan, seperti pengulangan atau lelaran Dalam erti kata lain, alasannya adalah serupa dengan Pelan "Menuju Perisikan Mesin Autonomi" LeCun yang ditakrifkan dalam "Laluan. ".

Pautan kertas: https://openreview.net/pdf?id=BZ5a1r-kVsf

Dalam tinjauan ini, penaakulan merujuk kepada pelbagai strategi untuk meningkatkan keupayaan penaakulan dalam LM, seperti menggunakan sebilangan kecil contoh untuk penaakulan langkah demi langkah. Walaupun masih belum difahami sepenuhnya sama ada LM sebenarnya membuat alasan, atau hanya menjana konteks yang lebih besar yang meningkatkan kemungkinan meramalkan token yang hilang dengan betul.

Memandangkan keadaan teknologi semasa, penaakulan mungkin merupakan istilah yang terlalu digunakan, tetapi istilah itu sudah digunakan secara meluas dalam komuniti. Dalam konteks ALM, definisi inferens yang lebih pragmatik adalah untuk memberikan model lebih langkah pengiraan sebelum tiba pada jawapan kepada gesaan.

Alat Alat

Untuk ALM, alat tersebut ialah modul luaran, biasanya Dipanggil menggunakan peraturan atau token khas, outputnya disertakan dalam konteks ALM.

Alat boleh digunakan untuk mengumpul maklumat luaran, atau memberi kesan pada dunia maya atau fizikal (biasanya dirasai oleh ALM): contohnya, pengambilan fail boleh digunakan sebagai alat untuk mendapatkan maklumat luaran, Atau gunakan lengan robot untuk mengesan pengaruh luaran.

Alat boleh dipanggil pada masa latihan atau pada masa inferens Secara umumnya, model perlu belajar untuk berinteraksi dengan alat tersebut, termasuk belajar memanggil APInya

.Bertindak

Untuk ALM, memanggil alat yang memberi kesan kepada dunia maya atau fizikal dan memerhatikannya keputusan, Biasanya ia dibawa ke dalam konteks semasa ALM.

Sesetengah kerja yang diperkenalkan dalam tinjauan ini membincangkan carian di web atau memanipulasi senjata robot melalui LM. Dalam sedikit penyalahgunaan istilah, penggunaan alat ALM kadangkala diwakili sebagai tindakan, walaupun ia tidak memberi kesan kepada dunia luar.

Mengapa membincangkan penaakulan dan alatan pada masa yang sama?

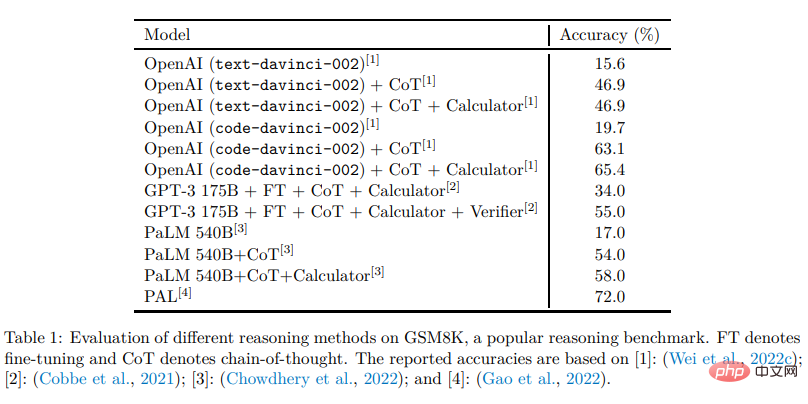

Gabungan penaakulan dan alatan dalam LM harus membolehkan menyelesaikan pelbagai tugas yang kompleks tanpa heuristik, iaitu dengan keupayaan generalisasi yang lebih baik.

Lazimnya, penaakulan memudahkan LM untuk memecahkan masalah yang diberikan kepada subtugasan yang berpotensi lebih mudah, manakala alatan membantu untuk menyelesaikan setiap langkah dengan betul, cth. dari Dapatkan hasil daripada operasi matematik.

Dalam erti kata lain, penaakulan ialah satu cara untuk LM menggabungkan alatan yang berbeza untuk menyelesaikan tugasan yang kompleks, manakala alatan ialah cara untuk mengelakkan kegagalan penaakulan dan terurai dengan berkesan.

Kedua-duanya harus mendapat manfaat daripada yang lain, dan inferens serta alatan boleh diletakkan dalam modul yang sama, kerana kedua-duanya meningkatkan ramalan token yang hilang dengan meningkatkan konteks LM, Walaupun dalam cara yang berbeza .

Mengapa membincangkan alatan dan tindakan pada masa yang sama?

Alat untuk mengumpul maklumat tambahan dan memberi kesan kepada dunia maya atau fizikal boleh digunakan oleh LM dengan cara yang sama. Sebagai contoh, nampaknya terdapat sedikit perbezaan antara LM yang mengeluarkan kod python untuk menyelesaikan operasi matematik dan LM yang mengeluarkan kod python untuk memanipulasi lengan robot. Beberapa karya yang dibincangkan dalam ulasan ini sudah menggunakan LM yang mempunyai kesan ke atas dunia maya atau fizikal Dalam pandangan ini, kita boleh mengatakan bahawa LM mempunyai potensi untuk bertindak dan mengharapkan kemajuan penting ke arah LM sebagai ejen autonomi. Kaedah pengelasan

Para penyelidik menguraikan kerja yang diperkenalkan dalam semakan ke dalam tiga dimensi di atas dan memperkenalkannya secara berasingan, dan akhirnya membincangkan kerja berkaitan dalam dimensi lain. Bagi pembaca, perlu diingat bahawa banyak teknik ini pada asalnya diperkenalkan dalam konteks selain LM, dan jika perlu, lihat pengenalan kertas yang disebutkan dan kerja berkaitan jika boleh. Akhir sekali, walaupun semakan memfokuskan kepada LLM, tidak semua kerja berkaitan menggunakan model besar, tetapi bertujuan untuk ketepatan LM.

Atas ialah kandungan terperinci Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI