Rumah >Peranti teknologi >AI >Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC

Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC

- 王林ke hadapan

- 2023-04-11 21:31:041198semak imbas

Pautan kertas: https://arxiv.org/pdf/2105.10375.pdf

Aplikasi & Kod:

- https://www.php.cn/link/c42af2fa7356818e0389593714f

- https://www.php.cn/link/60a6c4002cc7b29142def8871531281a>Latar Belakang

Klasifikasi imej ialah salah satu teknologi aplikasi praktikal AI yang paling berjaya pada masa ini dan telah disepadukan ke dalam kehidupan harian manusia. Ia digunakan secara meluas dalam kebanyakan tugas penglihatan komputer, seperti klasifikasi imej, carian imej, OCR, semakan kandungan, pengesahan pengecaman dan bidang lain. Terdapat konsensus umum: "Apabila set data lebih besar dan terdapat lebih banyak ID, selagi ia dilatih dengan betul, kesan tugas pengelasan yang sepadan akan menjadi lebih baik." Walau bagaimanapun, apabila berhadapan dengan berpuluh-puluh juta ID atau malah ratusan juta ID, adalah sukar bagi rangka kerja DL yang popular pada masa ini untuk secara langsung menjalankan latihan pengelasan berskala ultra-besar dengan kos yang rendah.

Cara paling intuitif untuk menyelesaikan masalah ini adalah dengan menggunakan lebih banyak sumber kad grafik melalui pengelompokan, tetapi walaupun begitu, masalah pengelasan di bawah ID besar masih akan mengalami masalah berikut:

1) Isu kos: Dalam kes rangka kerja latihan teragih + data besar, overhed memori, komunikasi berbilang mesin, penyimpanan data dan pemuatan akan menggunakan lebih banyak sumber.

2) Masalah ekor panjang: Dalam senario sebenar, apabila set data mencapai ratusan juta ID, bilangan sampel imej dalam kebanyakan ID selalunya sangat kecil, dan data akan diedarkan dalam ekor panjang Sangat jelas bahawa latihan langsung sukar untuk mencapai hasil yang lebih baik.

Bab-bab yang selebihnya dalam artikel ini akan menumpukan pada penyelesaian sedia ada untuk rangka kerja pengelasan berskala sangat besar, serta prinsip dan helah yang sepadan bagi rangka kerja pengelasan kos rendah FFC.

Kaedah

Sebelum memperkenalkan kaedah, artikel ini terlebih dahulu mengkaji cabaran utama klasifikasi berskala sangat besar semasa:

Mata cabaran 1: Kos kekal tinggi

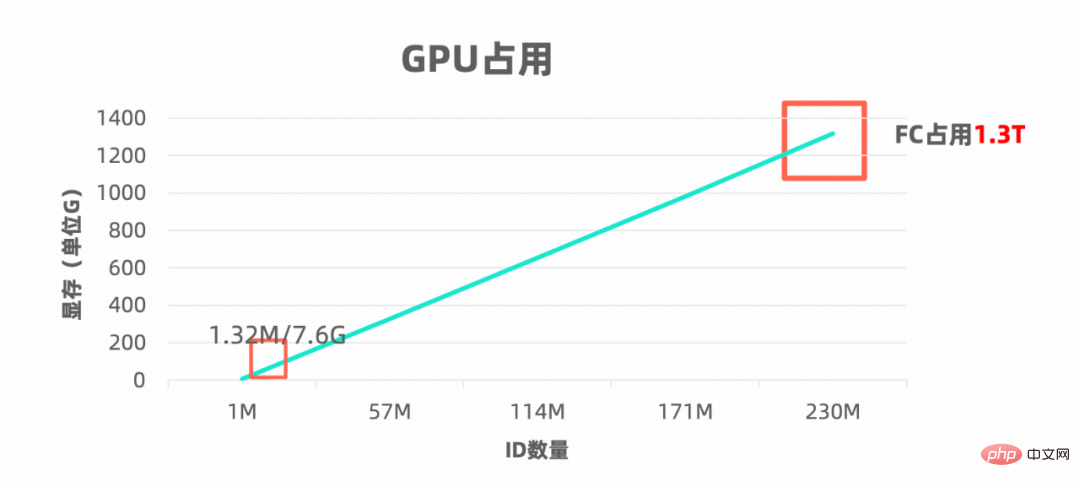

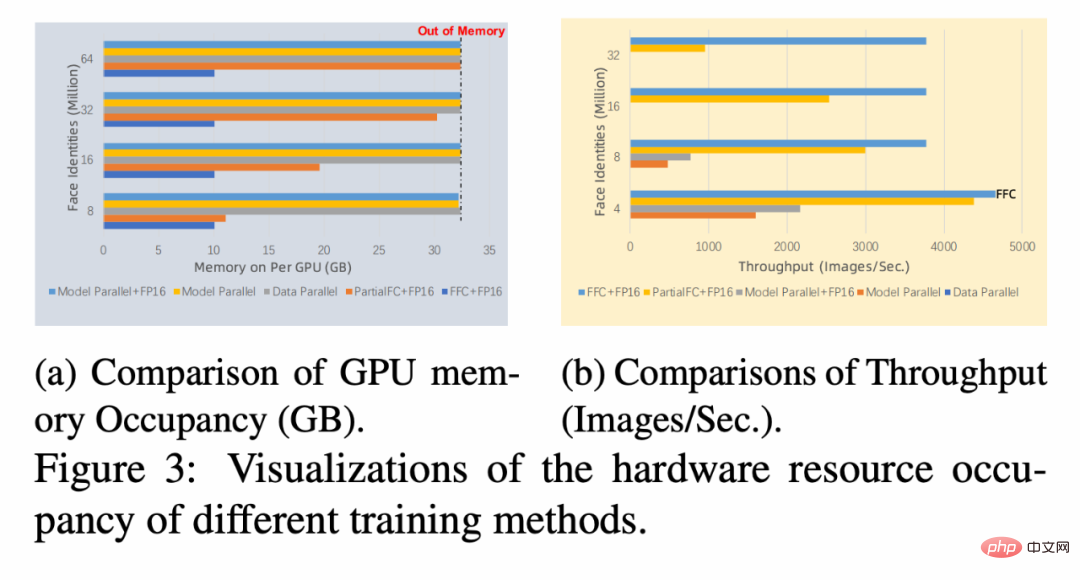

Semakin besar bilangan ID, semakin besar keperluan memori pengelas, seperti yang ditunjukkan dalam rajah berikut :

Semakin besar memori video, semakin banyak kad mesin diperlukan dan semakin tinggi kos infrastruktur perkakasan yang sepadan untuk kerjasama berbilang mesin juga lebih tinggi. Pada masa yang sama, apabila bilangan ID pengelasan mencapai skala yang sangat besar, jumlah pengiraan utama akan dibazirkan pada lapisan pengelas terakhir, dan masa yang digunakan oleh rangkaian rangka boleh diabaikan.

Semakin besar memori video, semakin banyak kad mesin diperlukan dan semakin tinggi kos infrastruktur perkakasan yang sepadan untuk kerjasama berbilang mesin juga lebih tinggi. Pada masa yang sama, apabila bilangan ID pengelasan mencapai skala yang sangat besar, jumlah pengiraan utama akan dibazirkan pada lapisan pengelas terakhir, dan masa yang digunakan oleh rangkaian rangka boleh diabaikan.

Mata cabaran 2: Kesukaran dalam pembelajaran long-tail

Dalam senario sebenar, bilangan mutlak antara ratusan daripada berjuta-juta ID Bilangan sampel imej dalam kebanyakan ID akan menjadi sangat kecil, dan pengedaran data ekor panjang sangat jelas, menjadikan latihan langsung sukar untuk disatukan. Jika dilatih dengan berat yang sama, sampel ekor panjang akan terharu dan tidak cukup dipelajari. Pada masa ini, sampel tidak seimbang secara amnya digunakan Mengenai topik penyelidikan ini, terdapat banyak kaedah yang boleh digunakan untuk rujukan Apakah kaedah yang lebih sesuai untuk diintegrasikan ke dalam rangka kerja pengelasan berskala ultra-besar?

Dengan dua cabaran di atas, mari kita lihat dahulu penyelesaian yang boleh dilaksanakan sedia ada dan sama ada ia boleh menyelesaikan dua cabaran di atas dengan baik.

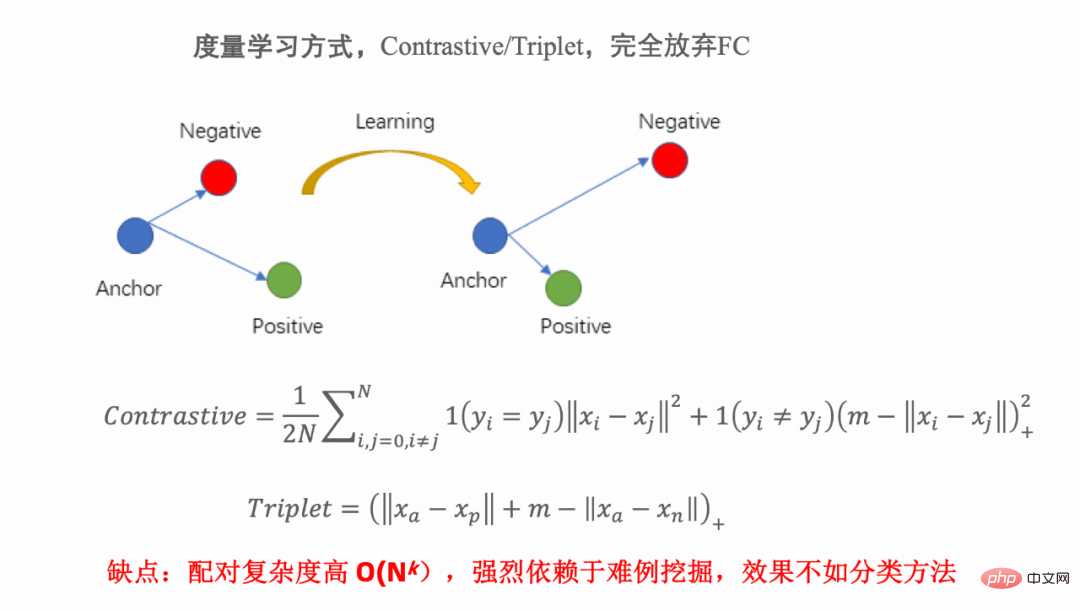

Kaedah yang boleh dilaksanakan 1: Pembelajaran metrik

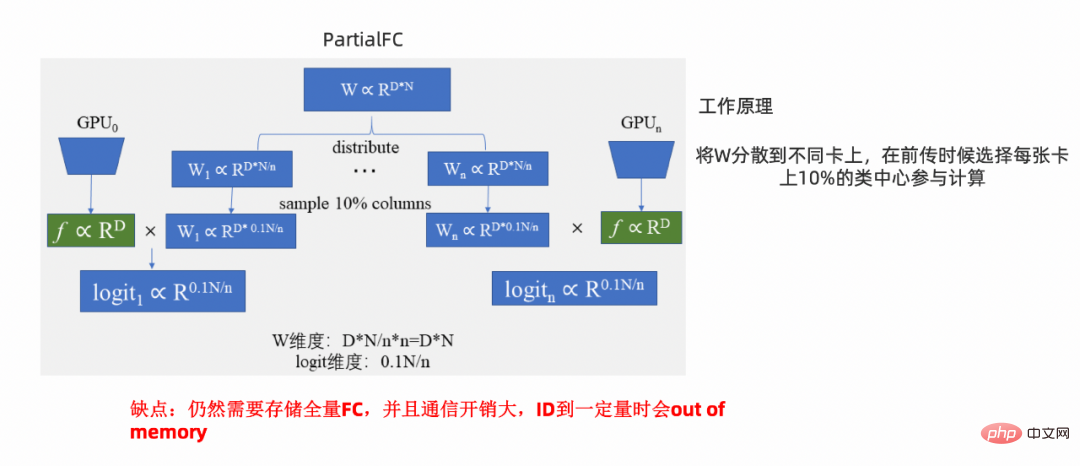

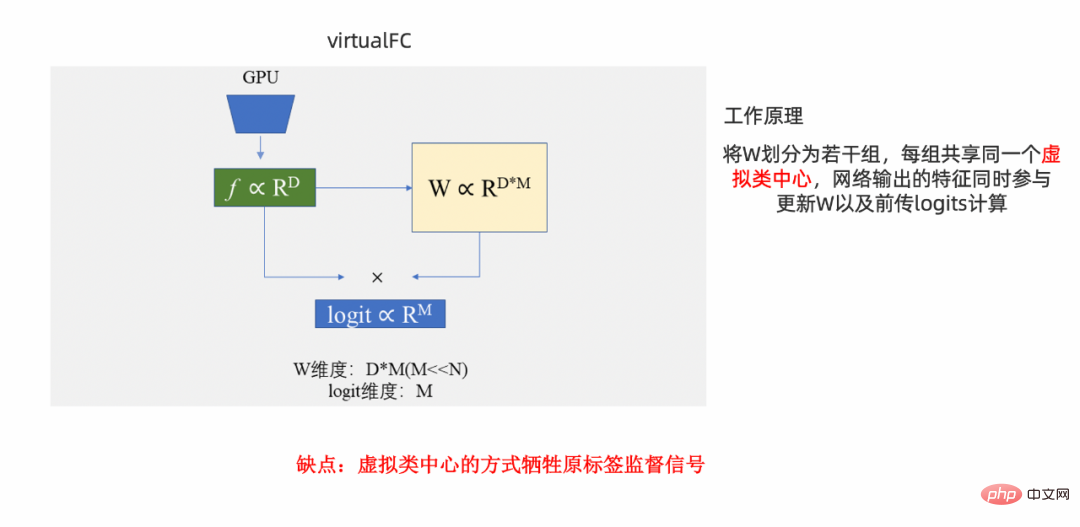

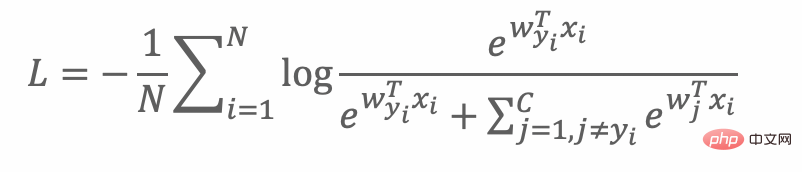

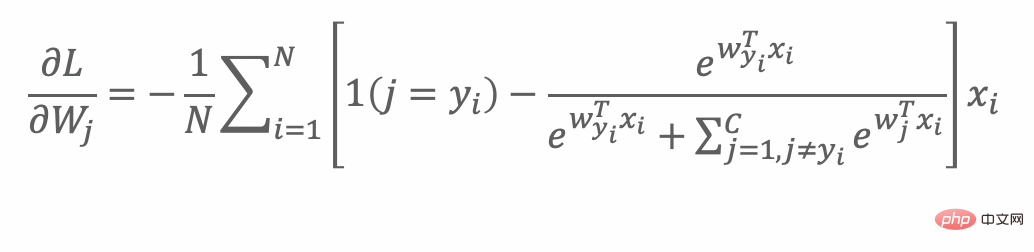

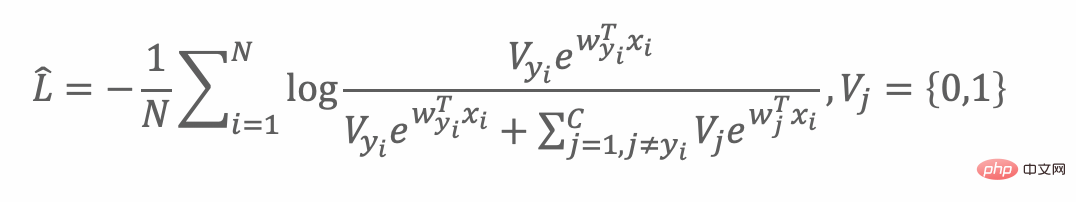

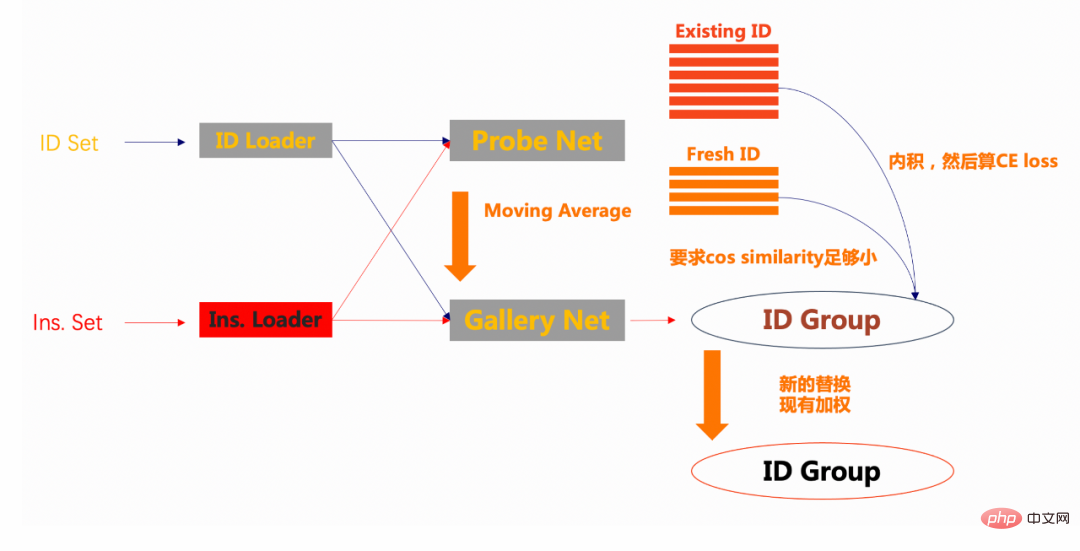

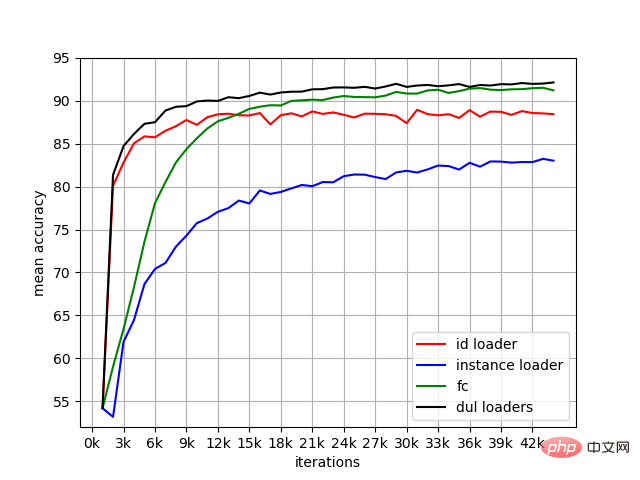

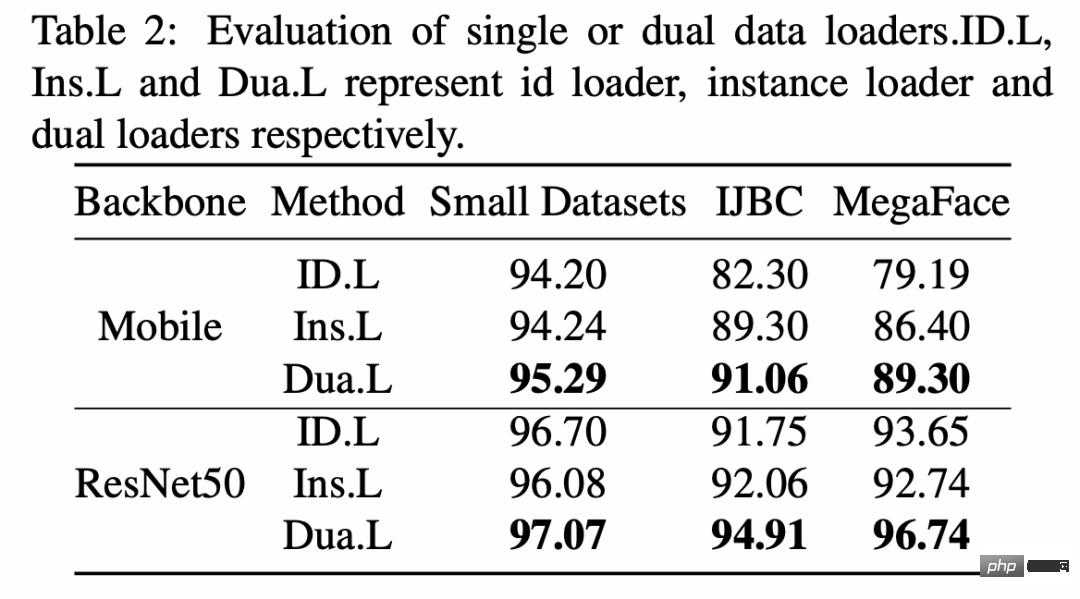

Kemungkinan kaedah 3: Rangka kerja VFC Kaedah kertas ini: Rangka kerja FFC Apabila klasifikasi berskala besar dilatih menggunakan FC, fungsi kehilangan adalah seperti berikut: Semasa setiap proses backpropagation, semua pusat kelas akan dikemas kini: Tetapi FC terlalu besar Idea intuitif adalah untuk memilih bahagian tertentu pusat kelas secara munasabah, iaitu, Vj berikut ialah 1 bahagian: Berdasarkan motivasi di atas , yang membawa kepada pelan awal berikut: Pertama sekali, untuk menyelesaikan kesan ekor panjang, artikel ini memperkenalkan dua pemuat, satu berdasarkan id Terdapat dua pemuat, id_loader persampelan dan pemuat instance berdasarkan persampelan sampel. Dalam setiap zaman, kelas dengan banyak sampel dan kelas dengan sedikit sampel (sedikit pukulan) boleh berpeluang untuk dilatih. Kedua, sebelum latihan bermula, hantar sebahagian daripada sampel kepada kumpulan id Di sini, diandaikan bahawa 10% daripada sampel id dimasukkan ke dalam kumpulan. Pada masa ini, galeri menggunakan parameter rawak. Kemudian, apabila latihan bermula, sampel batch memasuki jaring siasatan satu demi satu. Kemudian terdapat dua situasi untuk sampel dalam setiap kelompok: 1.) Terdapat ciri dengan ID yang sama bagi sampel ini dalam kumpulan, 2.) Tiada ciri sampel yang serupa dalam kumpulan. Untuk kedua-dua kes ini, panggil mereka id sedia ada dan id baharu masing-masing. Untuk sampel sedia ada, gunakan ciri dan ciri dalam kumpulan untuk melakukan produk dalam, kira fungsi kehilangan entropi silang dengan label, dan kemudian kembalikannya. Untuk sampel segar, kurangkan persamaan kosinus dengan sampel dalam kumpulan. Akhir sekali, ciri dalam kumpulan dikemas kini dan digantikan dengan pusat kelas baharu, berdasarkan prinsip pemberat pusat kelas sedia ada. Untuk jaring galeri, strategi purata bergerak digunakan untuk mengemas kini parameter dalam probe secara beransur-ansur. Kaedah kertas ini: pengenalan helah 1.) Saiz Kumpulan ID yang diperkenalkan boleh laras Parameter, biasanya lalai kepada 30,000. 2.) Untuk mencapai latihan yang stabil, rujuk kaedah kelas moco dan perkenalkan purata bergerak Syarat penumpuan yang sepadan ialah: 1. Eksperimen ablasi Pemuat Berganda 2. Perbandingan kesan kaedah SOTA 3. Perbandingan memori video dan throughput sampel

Hasil percubaan

Hasil percubaan

Atas ialah kandungan terperinci Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI