Rumah >Peranti teknologi >AI >Xiaozha menghabiskan banyak wang! Meta telah membangunkan model AI khusus untuk Metaverse

Xiaozha menghabiskan banyak wang! Meta telah membangunkan model AI khusus untuk Metaverse

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 19:58:22890semak imbas

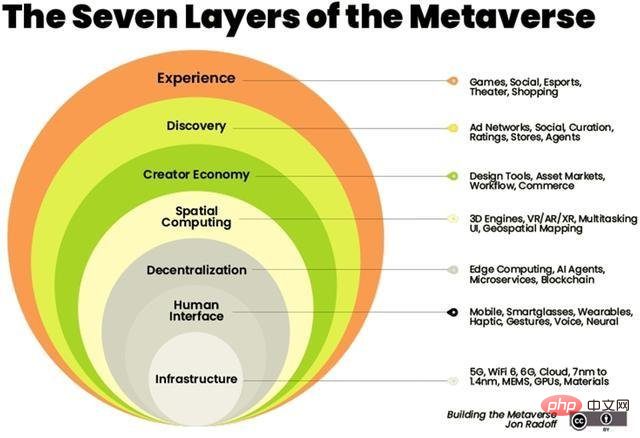

Kecerdasan buatan akan menjadi tulang belakang dunia maya.

Kecerdasan buatan boleh digabungkan dengan pelbagai teknologi berkaitan dalam metaverse, seperti penglihatan komputer, pemprosesan bahasa semula jadi, rantaian blok dan kembar digital.

Pada bulan Februari, Zuckerberg mempamerkan rupa Metaverse di Inside The Lab, acara maya pertama syarikat itu. Beliau berkata syarikat itu sedang membangunkan siri model AI generatif baharu yang akan membolehkan pengguna menjana avatar realiti maya mereka sendiri hanya dengan menerangkannya.

Zuckerberg mengumumkan satu siri projek akan datang, seperti Project CAIRaoke, model saraf hujung ke hujung sepenuhnya untuk membina pembantu suara pada peranti yang membantu pengguna berkomunikasi dengan pembantu suara mereka dengan lebih semula jadi . Sementara itu, Meta sedang berusaha keras untuk membina penterjemah pertuturan universal yang menyediakan terjemahan pertuturan ke pertuturan terus untuk semua bahasa.

Beberapa bulan kemudian, Meta menunaikan janji mereka. Walau bagaimanapun, Meta bukan satu-satunya syarikat teknologi yang mempunyai kulit dalam permainan. Syarikat seperti Nvidia juga telah mengeluarkan model AI yang dibangunkan sendiri untuk memberikan pengalaman Metaverse yang lebih kaya.

Transformer pra-latihan sumber terbuka (OPT-175 bilion parameter)

GAN ayat 3D

GANverse 3D dibangunkan oleh NVIDIA AI Research and is Model yang menggunakan pembelajaran mendalam untuk memproses imej 2D ke dalam versi animasi 3D, alat yang diterangkan dalam kertas penyelidikan yang diterbitkan di ICLR dan CVPR tahun lepas, boleh menghasilkan simulasi dengan lebih pantas dan pada kos yang lebih rendah.

Model ini menggunakan StyleGAN untuk menjana berbilang paparan secara automatik daripada satu imej. Aplikasi ini boleh diimport sebagai lanjutan kepada NVIDIA Omniverse untuk memaparkan objek 3D dengan tepat dalam dunia maya. Omniverse yang dilancarkan oleh NVIDIA membantu pengguna membuat simulasi idea akhir mereka dalam persekitaran maya.

Penghasilan model 3D telah menjadi faktor utama dalam membina Metaverse. Peruncit seperti Nike dan Forever21 telah menyediakan kedai maya mereka di Metaverse untuk memacu jualan e-dagang.

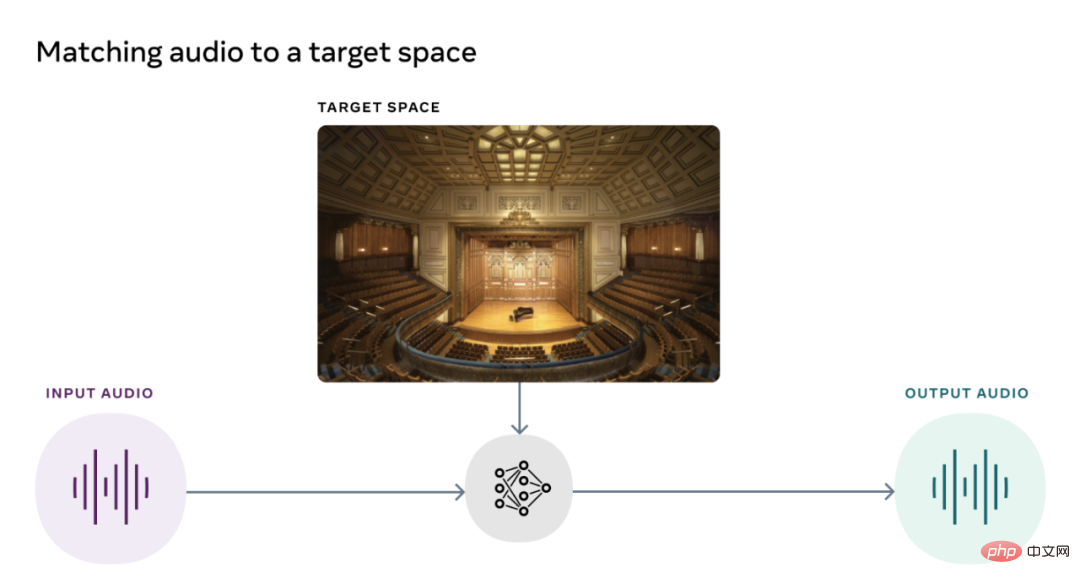

Model Padanan Akustik Visual (AViTAR)

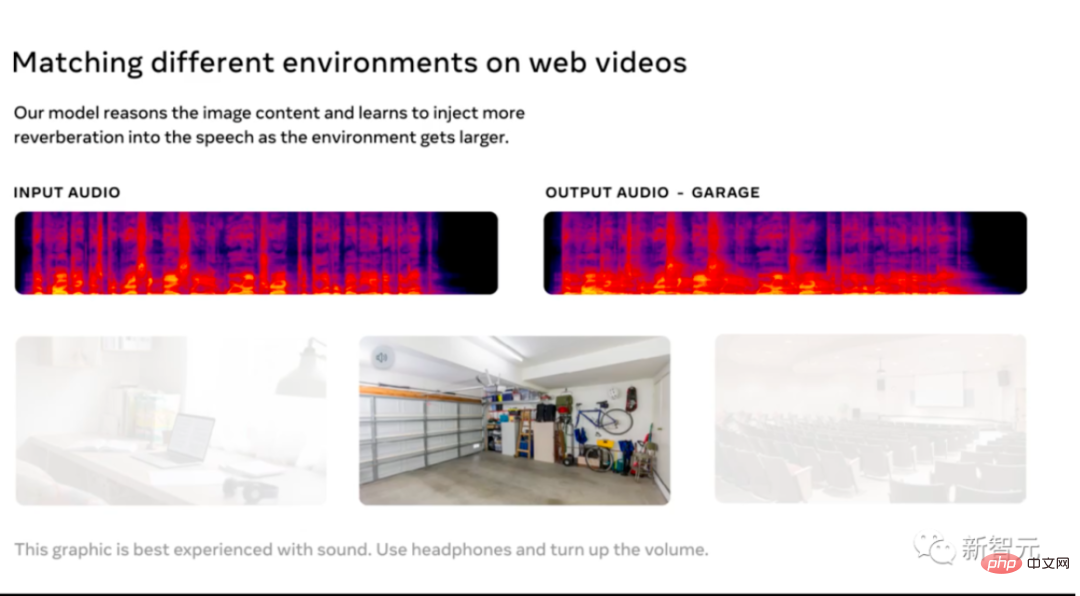

Pasukan Makmal Realiti Meta bekerjasama dengan Universiti Texas untuk membina model kecerdasan buatan yang meningkatkan bunyi kualiti metaspace. Model ini membantu memadankan audio dan video dalam adegan. Ia mengubah klip audio untuk menjadikannya berbunyi seperti dirakam dalam persekitaran tertentu. Model ini menggunakan pembelajaran penyeliaan kendiri selepas mengekstrak data daripada video dalam talian rawak. Sebaik-baiknya, pengguna harus dapat melihat kenangan kegemaran mereka pada cermin mata AR mereka dan mendengar bunyi tepat yang dihasilkan oleh pengalaman sebenar.

Meta AI telah mengeluarkan AViTAR sebagai sumber terbuka, bersama-sama dengan dua model akustik lain, yang sangat jarang memandangkan bunyi adalah bahagian yang sering diabaikan dalam pengalaman metaverse.

Pengurangan Getaran Terkena Visual (VIDA)

Model akustik kedua yang dikeluarkan oleh Meta AI digunakan untuk menghilangkan gema dalam akustik.

Model ini dilatih pada set data berskala besar dengan pelbagai pemaparan audio realistik daripada model 3D rumah. Reverb bukan sahaja mengurangkan kualiti audio, menjadikannya sukar untuk difahami, tetapi ia juga meningkatkan ketepatan pengecaman pertuturan automatik.

VIDA adalah unik kerana ia menggunakan audio serta isyarat visual untuk pemerhatian. Menambah baik pada kaedah audio sahaja biasa, VIDA meningkatkan pertuturan dan mengenal pasti suara dan pembesar suara.

Suara Visual (VisualVoice)

VisualVoice, model akustik ketiga yang dikeluarkan oleh Meta AI, boleh mengekstrak pertuturan daripada video. Seperti VIDA, VisualVoice dilatih tentang isyarat audio-visual daripada video tidak berlabel. Model telah memisahkan pertuturan secara automatik.

Model ini mempunyai senario aplikasi yang penting, seperti membuat teknologi untuk orang cacat pendengaran, mempertingkatkan bunyi peranti AR boleh pakai, menyalin pertuturan daripada video dalam talian dalam persekitaran yang bising, dsb.

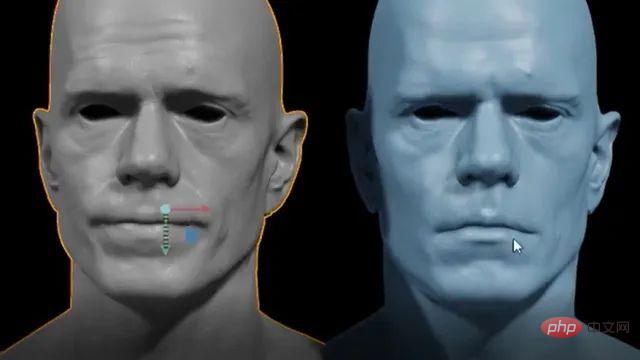

Audio2Face

Tahun lepas, Nvidia mengeluarkan versi beta terbuka Omniverse Audio2Face untuk menjana animasi muka dipacu AI untuk memadankan sebarang alih suara. Alat ini memudahkan proses animasi permainan dan kesan visual yang panjang dan membosankan. Aplikasi ini juga membenarkan pengguna mengeluarkan arahan dalam berbilang bahasa.

Awal tahun ini, Nvidia mengeluarkan kemas kini pada alat itu, menambah ciri seperti BlendShape Generation untuk membantu pengguna mencipta set blendhapes daripada avatar neutral. Selain itu, kefungsian pemain audio penstriman telah ditambah, membenarkan penstriman data audio menggunakan aplikasi teks ke pertuturan. Audio2Face menyediakan model aksara 3D yang boleh dianimasikan dengan trek audio. Audio kemudiannya dimasukkan ke dalam rangkaian saraf yang mendalam. Pengguna juga boleh mengedit aksara dalam pasca pemprosesan untuk mengubah prestasi mereka.

Atas ialah kandungan terperinci Xiaozha menghabiskan banyak wang! Meta telah membangunkan model AI khusus untuk Metaverse. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI