Rumah >Peranti teknologi >AI >Paradigma baharu untuk pembelajaran pengukuhan luar talian! JD.com & Universiti Tsinghua mencadangkan algoritma pembelajaran yang dipisahkan

Paradigma baharu untuk pembelajaran pengukuhan luar talian! JD.com & Universiti Tsinghua mencadangkan algoritma pembelajaran yang dipisahkan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 16:22:031107semak imbas

Algoritma pembelajaran pengukuhan luar talian (RL Luar Talian) ialah salah satu sub-arah pembelajaran pengukuhan yang paling popular. Pembelajaran pengukuhan luar talian tidak berinteraksi dengan persekitaran dan bertujuan untuk mempelajari dasar sasaran daripada data yang direkodkan sebelum ini. Pembelajaran pengukuhan luar talian amat menarik berbanding pembelajaran pengukuhan dalam talian (RL Dalam Talian) di kawasan yang pengumpulan data mahal atau berbahaya, tetapi mungkin terdapat sejumlah besar data (mis., robotik, kawalan industri, pemanduan autonomi).

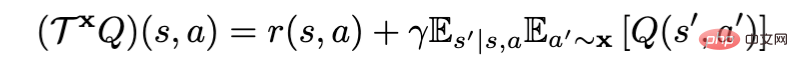

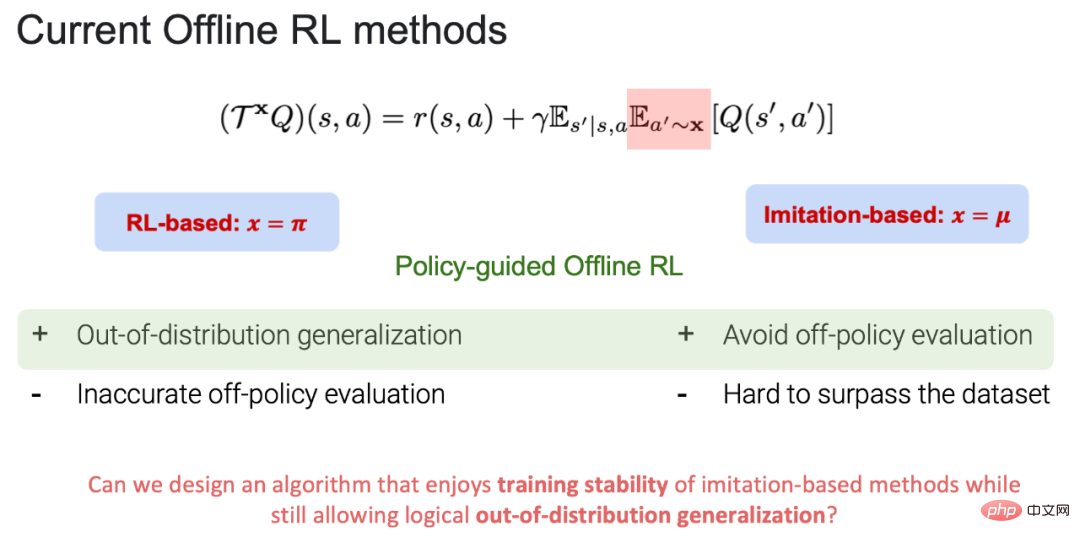

Apabila menggunakan operator penilaian dasar Bellman untuk penilaian dasar, algoritma pembelajaran tetulang luar talian semasa boleh dibahagikan kepada berasaskan RL (x=π) dan berasaskan Tiruan (x=μ), di mana π ialah strategi sasaran dan μ ialah strategi tingkah laku (Nota: strategi sasaran: strategi untuk pembelajaran dan pengemaskinian; strategi tingkah laku: strategi dalam data luar talian). Pada masa ini, kedua-dua berasaskan RL dan berasaskan Tiruan mempunyai kelebihan dan kekurangan mereka sendiri:

1 Kelebihan berasaskan RL: Ia boleh membuat generalisasi di luar data, dan akhirnya mencapai strategi Matlamat pembelajaran di luar strategi tingkah laku. Kelemahan: Terdapat pertukaran antara anggaran nilai yang tepat dalam penilaian dasar (lebih teratur tingkah laku) dan penambahbaikan dasar (kurang teratur tingkah laku). Semasa proses penilaian dasar, jika tindakan di luar pengedaran data dipilih, fungsi nilai tindakan (nilai keadaan tindakan) tidak boleh dianggarkan dengan tepat, yang akhirnya membawa kepada kegagalan pembelajaran dasar sasaran.

2.Kelebihan berasaskan tiruan: Kerana dalam proses penilaian strategi, semua tindakan berada dalam pengedaran data, ia bukan sahaja dapat membawa kestabilan kepada latihan, tetapi juga mengelakkan kesilapan di luar pengedaran data penilaian strategi boleh mempelajari strategi yang hampir dengan yang terbaik dalam perpustakaan strategi tingkah laku. Kelemahan: Oleh kerana semua tindakan diambil dalam pengagihan data, adalah sukar untuk mengatasi strategi tingkah laku yang sedia ada dalam data asal.

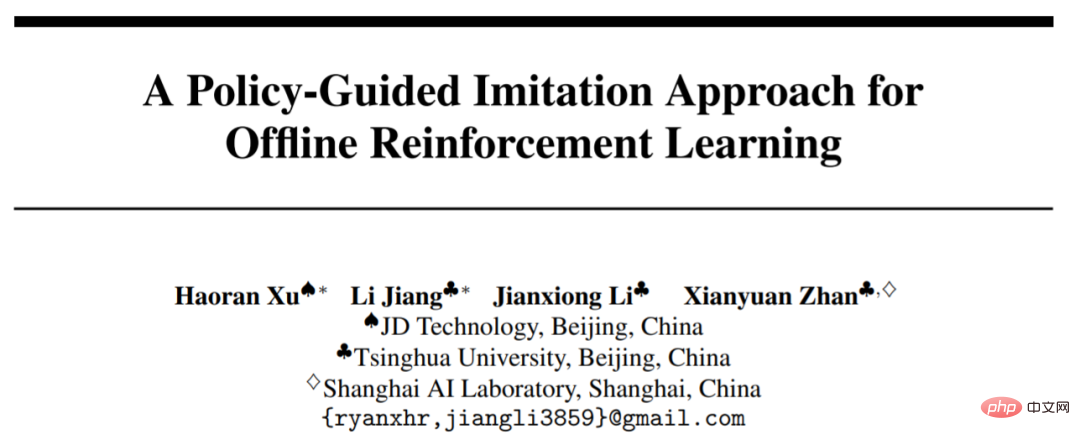

POR Berdasarkan ini, ia bukan sahaja dapat mengelakkan pertukaran dalam proses penilaian strategi, tetapi juga mempunyai keupayaan untuk membuat generalisasi di luar data . Kerja ini telah diterima oleh NeurIPS 2022 dan dijemput untuk pembentangan lisan. Kertas dan kod tersebut adalah sumber terbuka.

- Kertas: https://arxiv.org/abs/2210.08323

- Kod: https://github.com/ryanxhr/POR

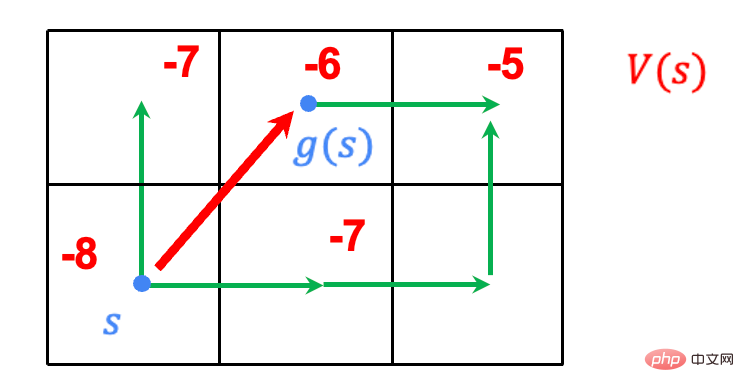

jahitan keadaan lwn. jahitan aksi

- Tugas: Berjalan di grid, dengan titik akhir di sudut kanan atas dan titik permulaan di sudut kanan bawah. Cari laluan terpendek dari titik mula ke titik akhir.

- Peraturan: Ejen boleh memilih lapan grid di sekelilingnya dalam mana-mana grid dan akan diberi ganjaran 1 apabila ia sampai ke penghujungnya dan semua ganjaran tingkah laku lain ialah 0.

- Data: Laluan pejalan kaki hijau ialah data laluan sedia ada.

Algoritma berasaskan tiruan sebelum ini semuanya menggunakan jahitan tindakan: mencantumkan trajektori yang tersedia dalam data untuk mencapai pembelajaran dasar sasaran. Sebagai contoh, trajektori biru dalam video ialah trajektori terbaik yang boleh dipelajari di bawah jahitan tindakan, tetapi ia tidak boleh digeneralisasikan secara berkesan di luar data, untuk mempelajari strategi sasaran di luar strategi tingkah laku dalam data. Walau bagaimanapun, POR boleh menyamaratakan strategi sasaran dengan berkesan melalui paradigma pembelajaran yang dipisahkan, dengan itu mengatasi prestasi strategi tingkah laku.

Bagaimana untuk melaksanakan state-stitching?

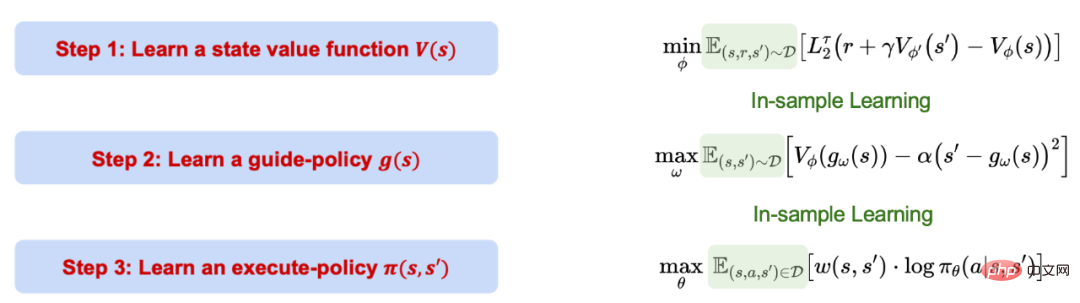

Proses pembelajaran RL Luar Talian (POR) berpandukan Dasar dibahagikan kepada tiga langkah ini dipisahkan secara berasingan dan berinteraksi antara satu sama lain. Perlu diingat bahawa keseluruhan proses POR adalah berdasarkan pembelajaran berasaskan peniruan, iaitu pembelajaran dalam sampel, dan tidak menilai nilai tindakan di luar pengedaran data.

1 Gunakan regresi kuantil untuk mempelajari batas atas keyakinan bagi fungsi nilai.

2. Gunakan fungsi nilai yang dipelajari untuk mempelajari strategi bimbingan, yang boleh menjana kedudukan keadaan optimum seterusnya dalam sampel berdasarkan keadaan semasa. Item terakhir berfungsi sebagai kekangan untuk memastikan keadaan yang dijana memenuhi syarat MDP.

3 Gunakan semua sampel dalam data untuk mempelajari strategi pelaksanaan yang boleh mengambil langkah berdasarkan keadaan semasa dan keadaan seterusnya (s'). bergerak dari keadaan semasa (s) ke keadaan seterusnya (s').

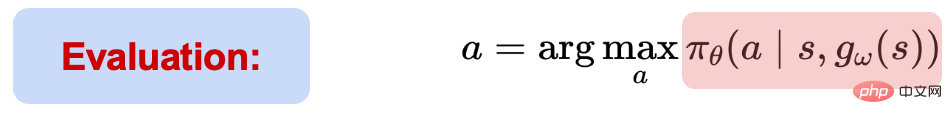

Semasa proses ujian, berdasarkan maklumat status semasa (s), status optimum seterusnya (s') mula-mula diberikan melalui bimbingan strategi.

Memandangkan (s, s'), strategi pelaksanaan boleh memilih dan melaksanakan tindakan. Walaupun keseluruhan proses pembelajaran POR adalah pembelajaran dalam sampel, prestasi generalisasi rangkaian saraf boleh digunakan untuk melaksanakan pembelajaran generalisasi di luar data, dan akhirnya mencapai jahitan keadaan.

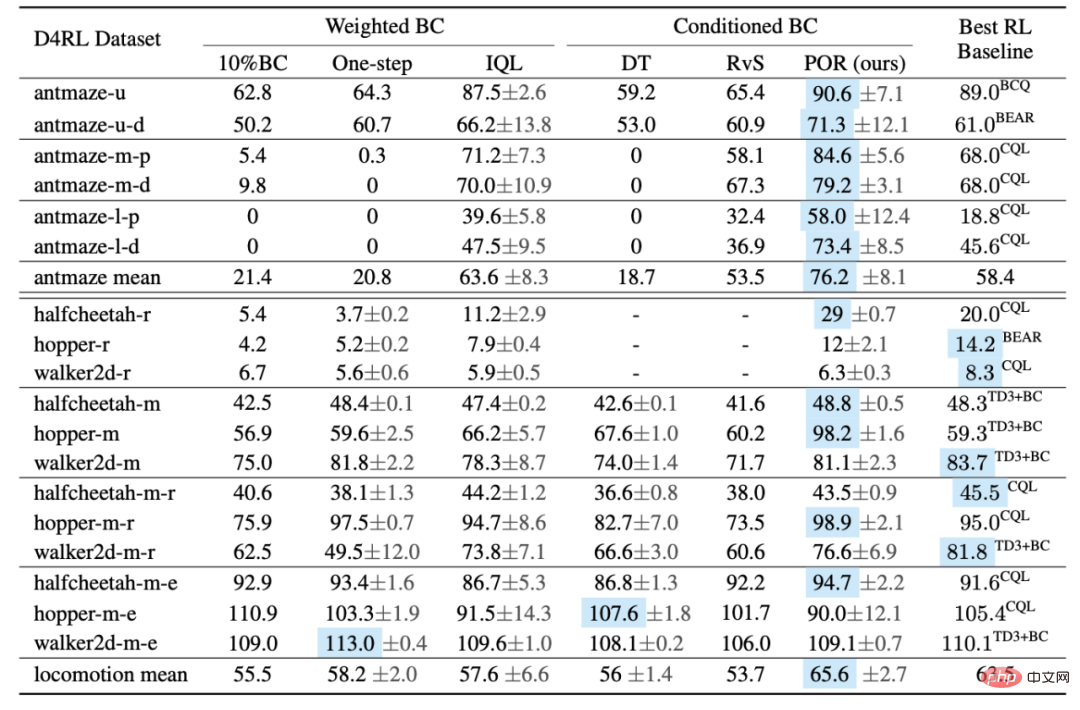

Eksperimen

Pengarang membandingkan prestasi POR dan algoritma lain pada Penanda Aras D4RL. Berdasarkan jadual, POR berprestasi sangat baik pada data suboptimum, dan mencapai prestasi algoritma optimum pada tugas Antmaze yang lebih sukar.

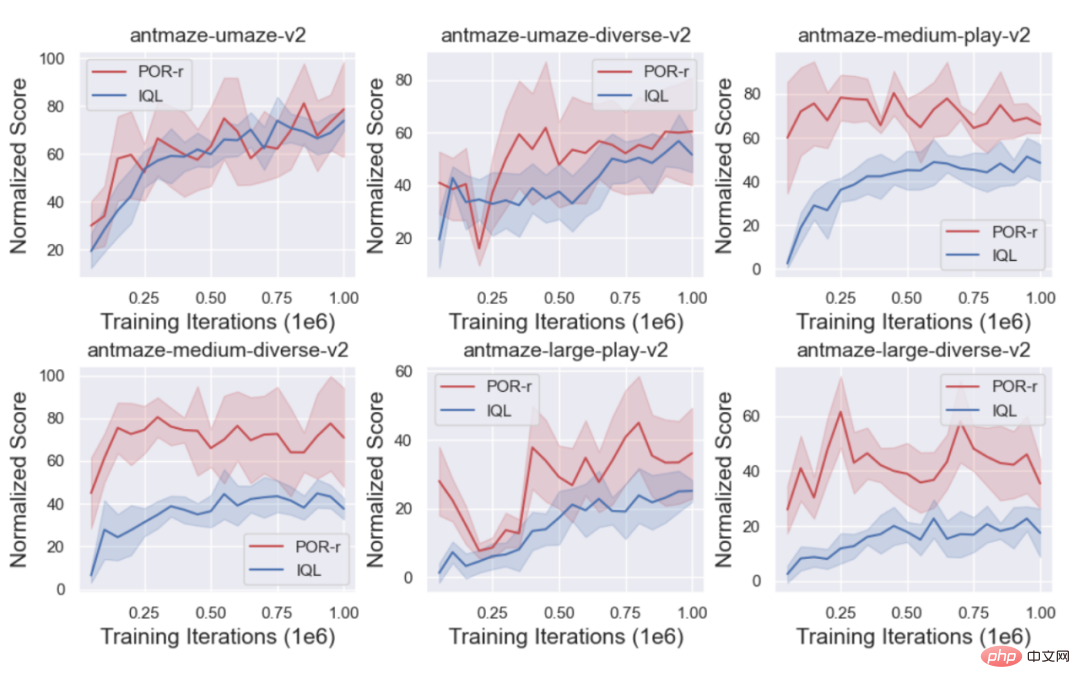

Pada masa yang sama, penulis membandingkan keluk latihan POR (state-stitching) dan IQL (action-stitching) untuk menunjukkan kelebihan. daripada jahitan negeri .

Apakah faedah tambahan penyahgandingan

1. Pelajari semula strategi panduan untuk mencapai prestasi algoritma yang lebih baik.

Selalunya terdapat sejumlah besar set data suboptimum atau rawak (D_o) dalam dunia nyata Jika ia diperkenalkan secara langsung kepada set data asal (D_e) yang sedang dipelajari, ia mungkin membawa kepada Strategi yang lemah dipelajari, tetapi untuk algoritma pembelajaran yang dipisahkan, komponen yang berbeza disasarkan dan set data yang berbeza dipelajari untuk meningkatkan prestasi. Apabila mempelajari fungsi nilai, lebih banyak set data lebih baik, kerana fungsi nilai boleh dipelajari dengan lebih tepat sebaliknya, pembelajaran strategi tidak mahu memperkenalkan (D_o).

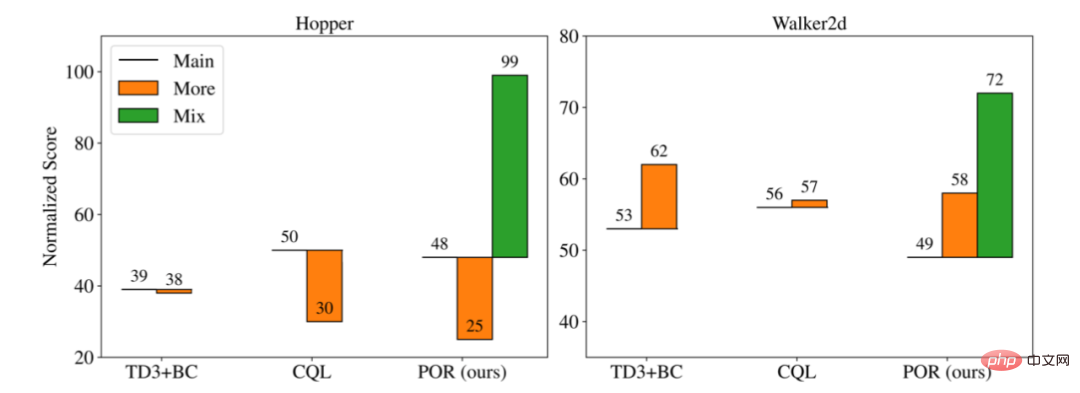

Pengarang membandingkan prestasi tiga algoritma berbeza dalam senario latihan yang berbeza:

Utama: pada set data asal ( D_e) Belajar tanpa memperkenalkan set data suboptimum tambahan.

2 Lagi: Campurkan set data asal (D_e) dan set data baharu (D_o) untuk belajar sebagai set data baharu.

3 Campuran: Untuk algoritma yang dipisahkan, set data yang berbeza boleh digunakan untuk pembelajaran bagi bahagian pembelajaran yang berbeza, jadi hanya POR boleh mempunyai paradigma pembelajaran Campuran.

Seperti yang anda lihat daripada rajah di atas, apabila data sub-optimum baharu ditambah dan dilatih bersama (Lagi), ia boleh mengakibatkan prestasi yang lebih baik daripada yang asal Prestasi set data asal (Utama) adalah lebih baik atau lebih teruk, tetapi untuk borang latihan yang dipisahkan untuk mempelajari semula strategi bimbingan (D_o+D_e), eksperimen pengarang menunjukkan bahawa lebih banyak data boleh meningkatkan selektiviti strategi bimbingan dan keupayaan generalisasi sambil mengekalkan strategi tingkah laku tidak berubah, dengan itu mencapai peningkatan strategi pelaksanaan.

4. Apabila menghadapi tugasan baharu, kerana strategi pelaksanaan tidak relevan dengan tugasan, anda hanya perlu mempelajari semula strategi bimbingan.

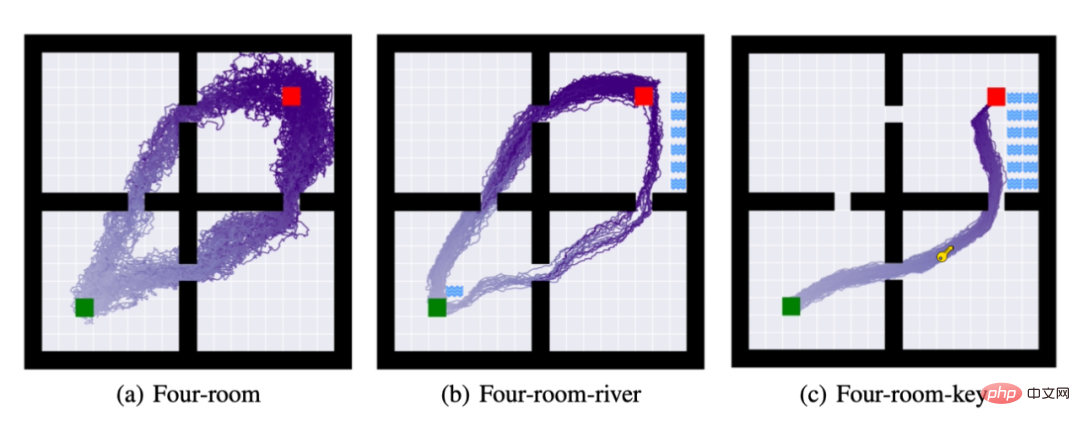

Untuk tujuan ini, penulis mencadangkan tiga tugas: (a): empat bilik: memerlukan ejen berpindah dari petak hijau ke petak merah. (b) Di samping menyelesaikan tugas (a), ejen dikehendaki tidak menyentuh sungai. (c) Di samping menyelesaikan tugasan (a) dan (b), ejen mesti mendapatkan kunci untuk menyelesaikan tugas tersebut.

Gambar di atas adalah trajektori untuk melancarkan polisi 50 kali selepas menyelesaikan pembelajaran dasar, dalam tugasan (b) dan (c) penulis mengikuti strategi pelaksanaan tugas (a) dan hanya mempelajari semula strategi bimbingan. Seperti yang dapat dilihat daripada rajah di atas, kaedah pembelajaran yang dipisahkan boleh menyelesaikan pemindahan tugasan menggunakan sumber pengkomputeran sesedikit mungkin.

Atas ialah kandungan terperinci Paradigma baharu untuk pembelajaran pengukuhan luar talian! JD.com & Universiti Tsinghua mencadangkan algoritma pembelajaran yang dipisahkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI