Rumah >Peranti teknologi >AI >Meta dan CMU bekerjasama untuk melancarkan peningkatan VR epik! Model HyperReel terkini merealisasikan pemaparan video kebebasan 6 darjah kesetiaan tinggi

Meta dan CMU bekerjasama untuk melancarkan peningkatan VR epik! Model HyperReel terkini merealisasikan pemaparan video kebebasan 6 darjah kesetiaan tinggi

- PHPzke hadapan

- 2023-04-11 13:10:031452semak imbas

Baru-baru ini, HyperReel, model perwakilan video 6-DoF yang dicadangkan oleh Meta dan Universiti Carnegie Mellon, mungkin mengumumkan kelahiran aplikasi "pembunuh" VR baharu!

Apa yang dipanggil "video enam darjah kebebasan" (6-DoF) hanyalah main balik pengalaman 4D definisi ultra tinggi.

Antaranya, pengguna boleh "melibatkan diri" sepenuhnya dalam adegan dinamik dan bergerak dengan bebas. Dan apabila mereka menukar kedudukan kepala mereka (3 DoF) dan arah (3 DoF) sewenang-wenangnya, pandangan yang sepadan juga akan dijana dengan sewajarnya.

Alamat kertas: https://arxiv.org/abs/2301.02238

Berbanding dengan kerja sebelumnya, kelebihan terbesar HyperReel terletak pada kecekapan ingatan dan pengkomputeran, yang kedua-duanya penting untuk set kepala VR mudah alih.

Dan menggunakan PyTorch vanila, HyperReel boleh mencapai pemaparan resolusi megapiksel pada 18 bingkai sesaat pada satu NVIDIA RTX 3090.

Versi terlalu panjang:

1 rangkaian ramalan pensampelan keadaan ringan yang boleh mencapai ketepatan tinggi, pemaparan kadar bingkai tinggi pada resolusi tinggi, serta perwakilan volum dinamik yang padat dan cekap ingatan; >2. Kaedah perwakilan video 6-DoF HyperReel menggabungkan dua bahagian teras di atas untuk mencapai keseimbangan ideal antara kelajuan, kualiti dan memori sambil memberikan resolusi megapiksel dalam masa nyata;

3. HyperReel lebih unggul daripada kaedah lain dalam banyak aspek seperti keperluan memori dan kelajuan rendering.

Pengenalan kertasPerwakilan adegan volumetrik boleh memberikan sintesis pandangan yang realistik untuk adegan statik dan membentuk Asas 6-DoF teknologi video yang sedia ada.

Walau bagaimanapun, program pemaparan volum yang mendorong perwakilan ini memerlukan pertukaran yang teliti dari segi kualiti, kelajuan pemaparan dan kecekapan memori.

Kaedah sedia ada mempunyai kelemahan - mereka tidak boleh mencapai prestasi masa nyata secara serentak, jejak memori yang kecil dan pemaparan berkualiti tinggi, yang amat sukar dalam mencabar senario dunia sebenar.

Untuk menyelesaikan masalah ini, penyelidik mencadangkan HyperReel, kaedah pencirian video 6-DoF berdasarkan teknologi NeRF (Neural Radiation Field).

Antaranya, dua bahagian teras HyperReel ialah:

1 Rangkaian ramalan pensampelan dalam keadaan cahaya, berkeupayaan tinggi dengan resolusi tinggi -kesetiaan, pemaparan kadar bingkai tinggi;

2.

Berbanding dengan kaedah lain, saluran paip video 6-DoF HyperReel bukan sahaja berprestasi sangat baik dari segi kualiti visual, tetapi juga memerlukan memori yang sangat sedikit.

Pada masa yang sama, HyperReel boleh mencapai kelajuan pemaparan 18 bingkai/saat pada resolusi megapiksel tanpa sebarang kod CUDA tersuai.

Khususnya, HypeReel mencapai kualiti pemaparan tinggi, kelajuan dan ingatan dengan menggabungkan rangkaian ramalan sampel dan perwakilan volumetrik berasaskan kerangka utama antara kecekapan.

Rangkaian ramalan sampel boleh mempercepatkan pemaparan volum dan meningkatkan kualiti pemaparan, terutamanya untuk adegan dengan kebergantungan paparan yang mencabar.

Dari segi perwakilan volum berasaskan kerangka utama, penyelidik menggunakan sambungan TensoRF.

Kaedah ini boleh mewakili jujukan video lengkap dengan tepat sambil menggunakan memori yang hampir sama dengan bingkai statik tunggal TensoRF.

Demonstrasi Masa Nyata

Seterusnya, kami akan menunjukkan dalam masa nyata bagaimana HypeReel melaksanakan adegan dinamik dan statik pada resolusi 512x512 piksel.

Perlu diambil perhatian bahawa penyelidik menggunakan model yang lebih kecil dalam adegan Technicolor dan Berkilat, jadi kadar bingkai pemaparan lebih besar daripada 40 FPS. Untuk set data yang tinggal, model penuh digunakan, tetapi HypeReel masih dapat memberikan inferens masa nyata.

Technicolor

Technicolor

Berkilat

Berkilat

Stanford

Stanford

Mengasyikkan

Mengasyikkan

DoNeRF

Kaedah pelaksanaan

Untuk melaksanakan HeperReel, isu pertama yang perlu dipertimbangkan ialah mengoptimumkan pandangan statik sintesis Pencirian isipadu.

Perwakilan volum seperti NeRF memodelkan ketumpatan dan penampilan setiap titik pemandangan statik dalam ruang 3D.

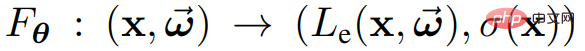

Lebih khusus, peta kedudukan x dan arah  sepanjang ⼀ sinar ke warna melalui fungsi

sepanjang ⼀ sinar ke warna melalui fungsi

dan ketumpatan σ(x).

dan ketumpatan σ(x).

Parameter yang boleh dilatih θ di sini boleh menjadi berat rangkaian saraf, entri tatasusunan N-dimensi atau gabungan kedua-duanya.

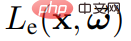

Anda kemudiannya boleh memaparkan paparan baharu bagi pemandangan statik

di mana  mewakili hantaran dari o ke

mewakili hantaran dari o ke  .

.

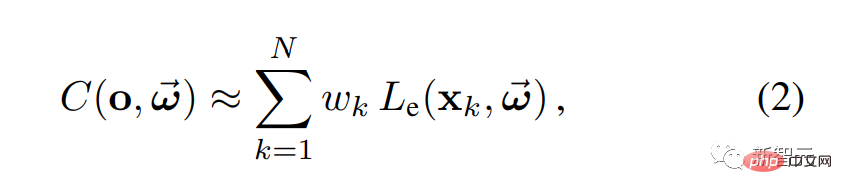

Dalam amalan, Persamaan 1 boleh dikira dengan mengambil beberapa titik sampel di sepanjang sinar yang diberikan dan kemudian menggunakan kuadratur berangka:

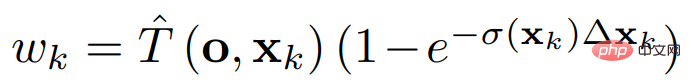

di mana berat  menentukan sumbangan warna setiap titik sampel kepada output.

menentukan sumbangan warna setiap titik sampel kepada output.

Contoh jejaring untuk pemaparan volum

Dalam HyperReel untuk pemandangan statik, diberikan set imej dan kamera berpose, dan matlamat latihan adalah untuk membina semula warna yang diukur yang dikaitkan dengan setiap sinar.

Kebanyakan adegan terdiri daripada objek pepejal yang permukaannya terletak pada manifold 2D dalam kelantangan pemandangan 3D. Dalam kes ini, hanya sebilangan kecil titik sampel mempengaruhi warna yang diberikan bagi setiap sinar.

Oleh itu, untuk mempercepatkan pemaparan volum, penyelidik berharap untuk hanya menanyakan warna dan kelegapan untuk mata bukan sifar  .

.

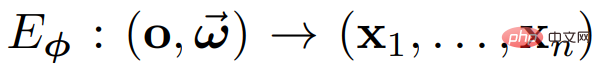

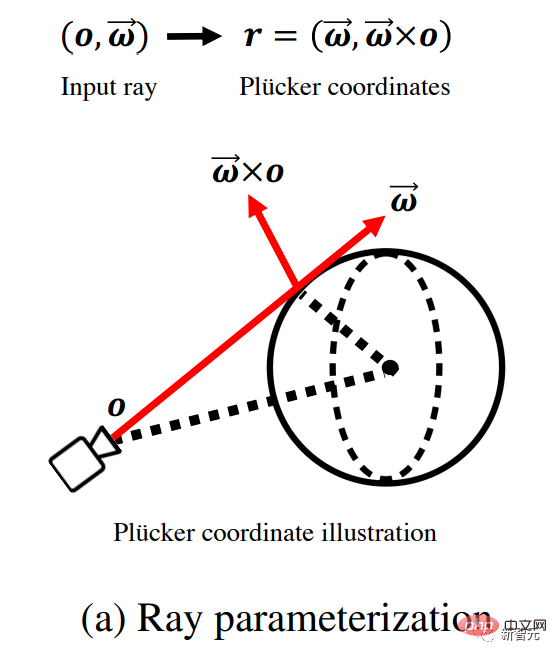

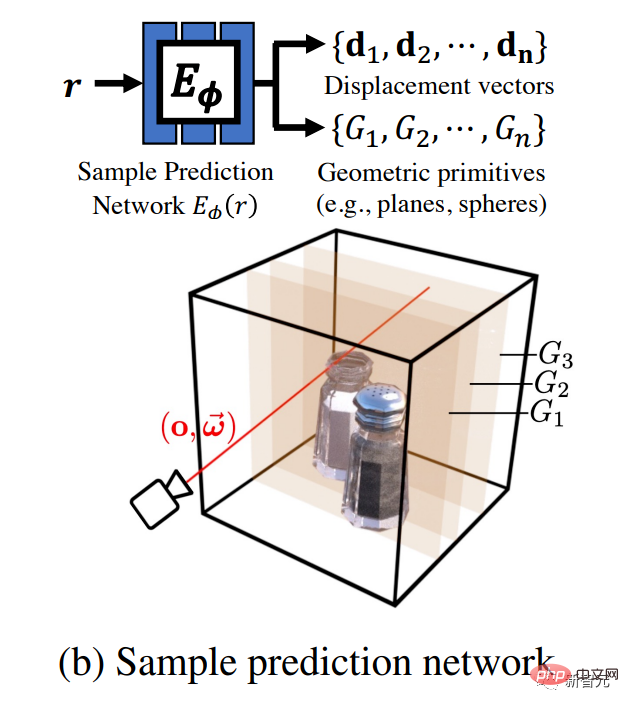

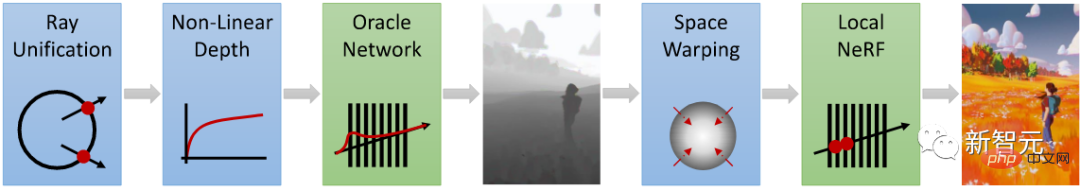

Seperti yang ditunjukkan dalam rajah di bawah, penyelidik menggunakan rangkaian suapan ke hadapan untuk meramalkan set lokasi sampel  . Khususnya, rangkaian ramalan sampel

. Khususnya, rangkaian ramalan sampel  digunakan dan memetakan sinar

digunakan dan memetakan sinar  ke titik sampel

ke titik sampel  untuk mendapatkan persamaan volum 2 Memaparkan dalam.

untuk mendapatkan persamaan volum 2 Memaparkan dalam.

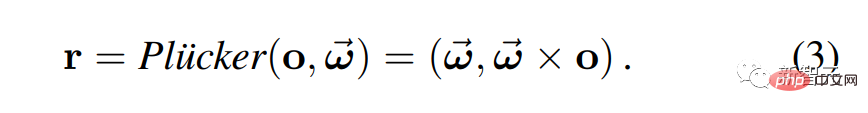

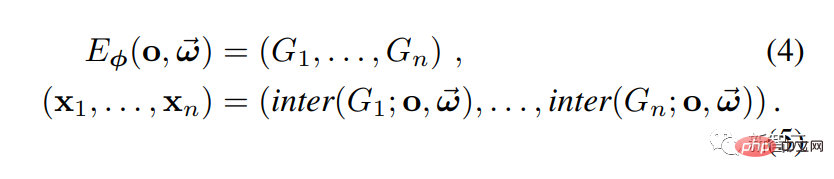

Di sini, penyelidik menggunakan parameterisasi Plucker untuk mencirikan cahaya.

Tetapi terdapat masalah: memberikan rangkaian terlalu banyak kelonggaran mungkin mempunyai kesan negatif terhadap kualiti sintesis paparan. Contohnya, jika (x1, . . . , xn) adalah titik arbitrari sepenuhnya, maka pemaparan mungkin tidak kelihatan konsisten merentas berbilang paparan.

Untuk menyelesaikan masalah ini, penyelidik memilih untuk menggunakan rangkaian ramalan sampel untuk meramalkan parameter set primitif geometri G1, ..., Gn, di mana parameter bagi primitif boleh ditentukan mengikut sinar masukan berbeza-beza bergantung kepada. Untuk mendapatkan titik sampel, sinar bersilang dengan setiap primitif.

Seperti yang ditunjukkan dalam Rajah a, memandangkan sinar input yang berasal dari asal kamera o dan merambat sepanjang arah ω, para penyelidik mula-mula menggunakan koordinat Plucker , parameterkan semula cahaya.

Seperti yang ditunjukkan dalam Rajah b, rangkaian mengambil sinar ini sebagai input dan mengeluarkan set daripada Parameter untuk primitif geometri {} (seperti satah dan sfera sejajar paksi) dan vektor sesaran {}.

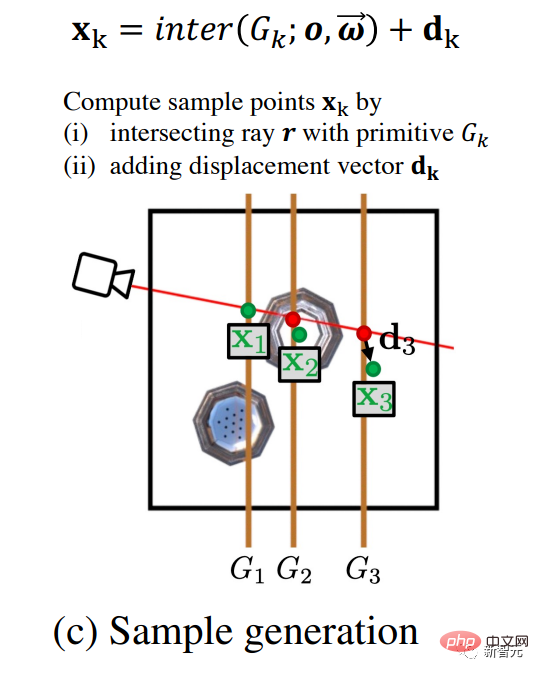

Seperti yang ditunjukkan dalam Rajah c, untuk menghasilkan titik sampel { } untuk pemaparan volum, penyelidik mengira persilangan asas sinar dan geometri titik antara unsur dan vektor anjakan ditambah pada hasil. Kelebihan meramalkan primitif geometri ialah isyarat sampel adalah lancar dan mudah untuk diinterpolasi.

} untuk pemaparan volum, penyelidik mengira persilangan asas sinar dan geometri titik antara unsur dan vektor anjakan ditambah pada hasil. Kelebihan meramalkan primitif geometri ialah isyarat sampel adalah lancar dan mudah untuk diinterpolasi.

Vektor anjakan memberikan fleksibiliti tambahan dalam titik pensampelan, membolehkan penangkapan yang lebih baik bagi penampilan bergantung kepada garis penglihatan yang kompleks.

Seperti yang ditunjukkan dalam Rajah d, akhirnya, penyelidik melakukan pemaparan volum melalui Formula 2 untuk menghasilkan warna piksel dan berdasarkan hasil pemerhatian yang sepadan , ia diselia dan dilatih.

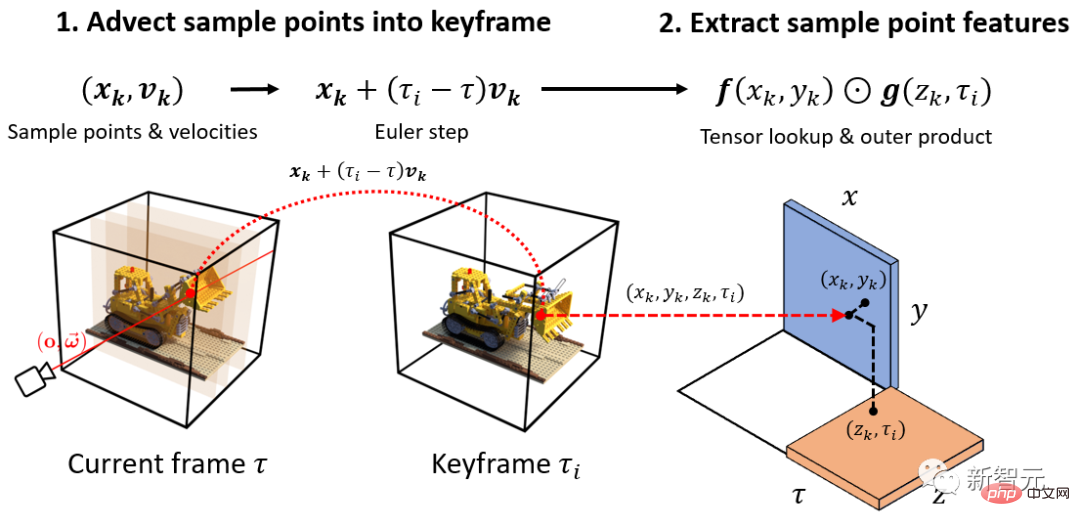

Volume dinamik berdasarkan bingkai kekunci

Melalui kaedah di atas, volum adegan 3D boleh diambil sampel dengan berkesan.

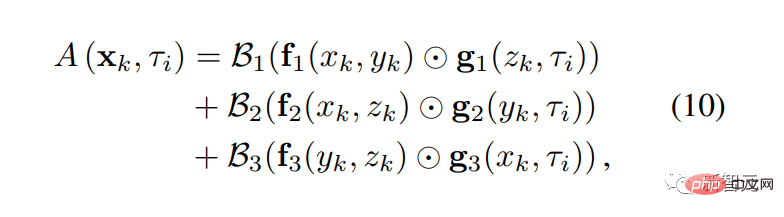

Bagaimana untuk mencirikan kelantangan? Dalam kes statik, penyelidik menggunakan kaedah medan sinaran tensor cekap ingatan (TensoRF) dalam kes dinamik, TensoRF telah diperluaskan kepada perwakilan volum dinamik berasaskan kerangka utama.

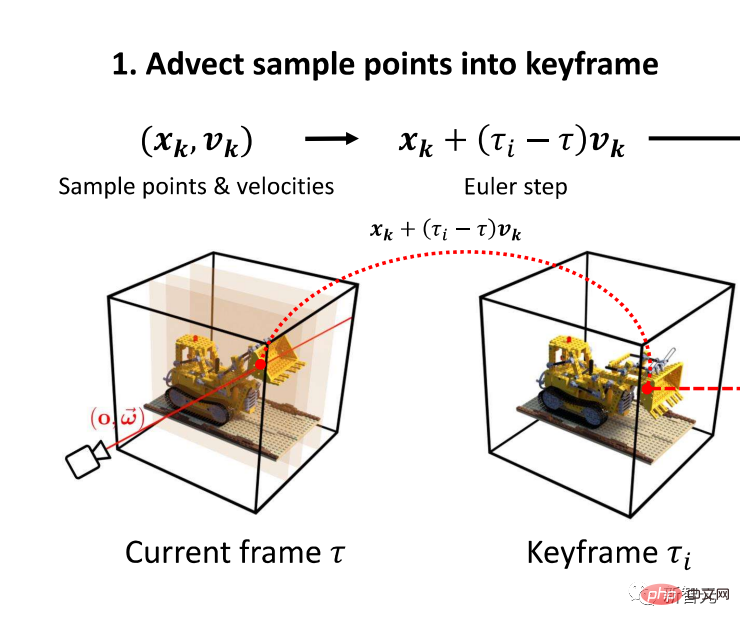

Rajah berikut menerangkan proses mengekstrak perwakilan titik sampel dinamik daripada perwakilan berasaskan kerangka utama.

Seperti yang ditunjukkan dalam Rajah 1, pertama, penyelidik menggunakan kelajuan meramalkan output rangkaian daripada sampel {}, terjemah titik sampel {} pada masa ke bingkai utama terdekat Sederhana.

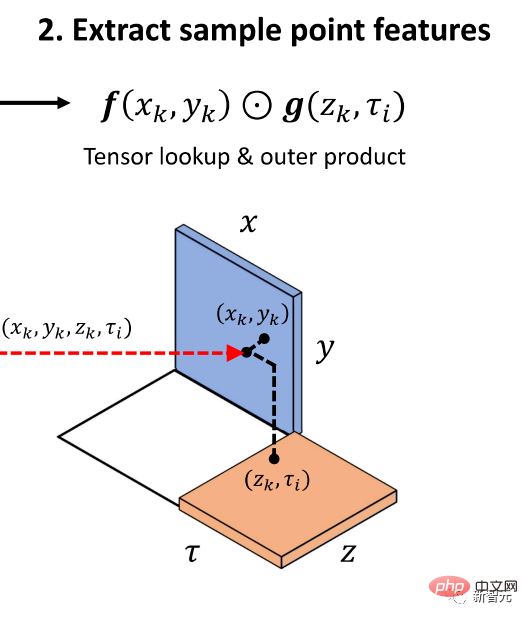

Kemudian, seperti yang ditunjukkan dalam Rajah 2, penyelidik menyoal produk luar tekstur spatiotemporal untuk menghasilkan ciri penampilan setiap titik sampel, dan kemudian Tukar ini kepada warna melalui Persamaan 10.

Melalui proses ini, penyelidik mengekstrak kelegapan setiap sampel.

Perbandingan hasil

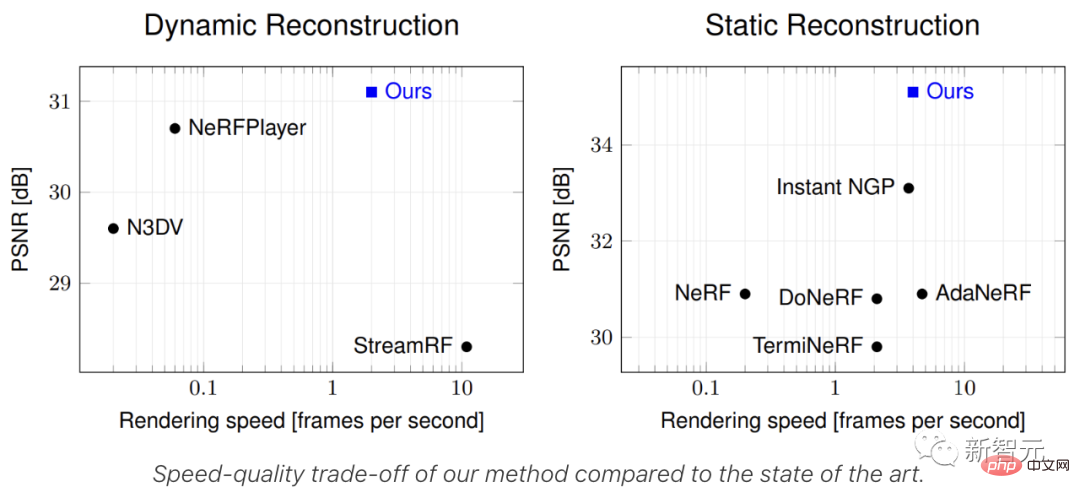

Perbandingan adegan statik

Di sini, pelajari penyelidik membandingkan HyperReel dengan kaedah sintesis paparan statik sedia ada, termasuk NeRF, InstantNGP dan tiga kaedah berasaskan rangkaian pensampelan.

- Dataset DoNeRF

Dataset DoNeRF mengandungi enam jujukan sintetik, imej Resolusi ialah 800×800 piksel.

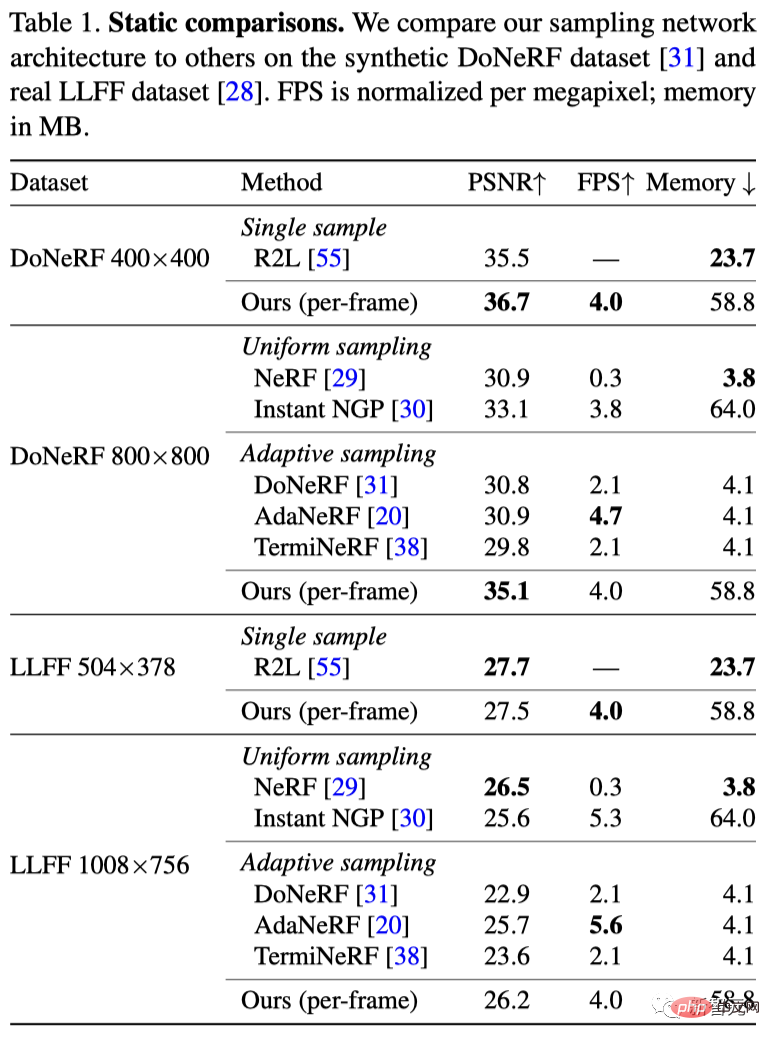

Seperti yang ditunjukkan dalam Jadual 1, kaedah HyperReel secara kualitatif mengatasi semua garis dasar dan meningkatkan prestasi skim rangkaian pensampelan lain pada tahap yang besar.

Sementara itu, HyperReel dilaksanakan dengan PyTorch vanila dan boleh menghasilkan imej 800×800 piksel pada 6.5 FPS pada satu RTX 3090 GPU (atau 29 FPS dengan pemaparan model Tiny).

Selain itu, berbanding dengan MLP dalam 88 lapisan, 256 unit tersembunyi R2L, rangkaian 6 lapisan, 256 unit tersembunyi yang dicadangkan oleh penyelidik ditambah dengan tulang belakang volumetrik TensoRF mempunyai kelajuan inferens lebih cepat Lebih cepat

- Dataset LLFF

Dataset LLFF mengandungi 8 jujukan dunia Nyata daripada imej 1008×756 piksel.

Seperti yang ditunjukkan dalam Jadual 1, kaedah HyperReel adalah lebih baik daripada DoNeRF, AdaNeRF, TermiNeRF dan InstantNGP, tetapi kualiti yang dicapai adalah lebih buruk sedikit daripada NeRF.

Disebabkan penentukuran kamera yang salah dan pandangan input yang jarang, set data ini merupakan cabaran besar untuk perwakilan volumetrik yang jelas.

Perbandingan adegan dinamik

- Dataset warna teknikal

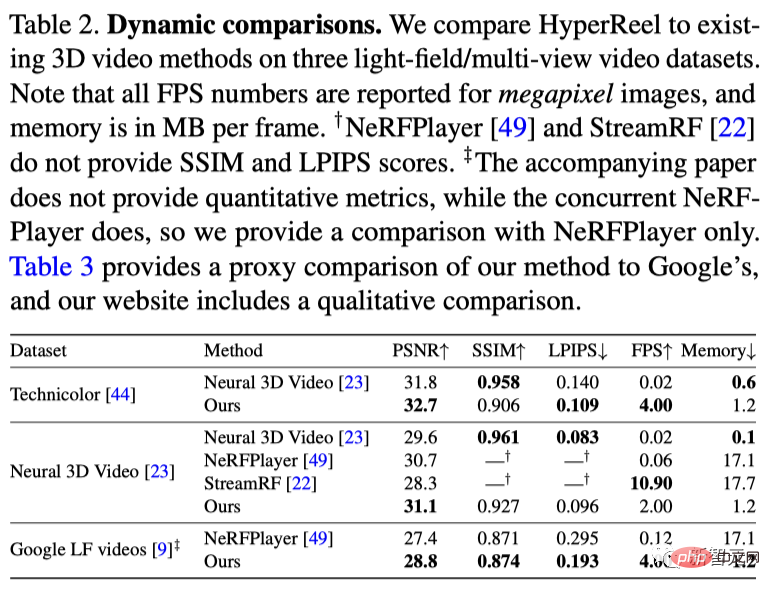

Penyelidik membandingkan HyperReel dan Video 3D Neural pada peleraian imej penuh untuk lima jujukan set data ini (Hari Lahir, Fabien, Pelukis, Teater, Kereta Api), setiap satu Urutan sepanjang 50 bingkai.

Seperti yang ditunjukkan dalam Jadual 2, kualiti HyperReel melebihi Video Neural 3D, manakala masa latihan bagi setiap urutan hanya 1.5 jam (bukan lebih daripada 1000 jam untuk Neural 3D) , dan menghasilkan lebih cepat.

Dataset Video 3D Neural

- Dataset Video 3D Neural mengandungi 6 Berbilang Dalaman lihat jujukan video, ditangkap oleh 20 kamera pada resolusi 2704 × 2028 piksel.

Seperti yang ditunjukkan dalam Jadual 2, HyperReel mengatasi semua kaedah garis dasar pada set data ini, termasuk kerja terbaharu seperti NeRFPlayer dan StreamRF.

Khususnya, HyperReel melebihi NeRFPlayer dalam kuantiti dan kira-kira 40 kali lebih pantas dalam pemaparan, ia melebihi StreamRF dalam kualiti, walaupun pendekatan berasaskan Plenoxels (menggunakan kernel CUDA tersuai untuk mempercepatkan inferens; ) dan render lebih cepat.

Selain itu, HyperReel menggunakan lebih sedikit memori setiap bingkai secara purata berbanding StreamRF dan NeRFPlayer.

Set Data Imersif Google

- Set Data Imersif Google mengandungi pelbagai jenis dalaman dan video medan cahaya persekitaran luar.

Seperti yang ditunjukkan dalam Jadual 2, HyperReel adalah 1 dB lebih baik daripada kualiti NeRFPlayer, dan kelajuan pemaparan juga lebih pantas.

Agak malangnya, HyperReel masih belum mencapai kelajuan pemaparan yang diperlukan untuk VR (sebaik-baiknya 72FPS, stereo).

Walau bagaimanapun, memandangkan kaedah ini dilaksanakan dalam PyTorch vanilla, prestasi boleh dioptimumkan lagi melalui kerja seperti kernel CUDA tersuai.

Pengenalan kepada pengarang

Benjamin Attal, pengarang pertama kertas kerja, sedang mengikuti pengajian PhD di Carnegie Mellon Robotics Institut. Minat penyelidikan termasuk realiti maya, dan pengimejan dan paparan pengiraan.

Benjamin Attal, pengarang pertama kertas kerja, sedang mengikuti pengajian PhD di Carnegie Mellon Robotics Institut. Minat penyelidikan termasuk realiti maya, dan pengimejan dan paparan pengiraan.

Atas ialah kandungan terperinci Meta dan CMU bekerjasama untuk melancarkan peningkatan VR epik! Model HyperReel terkini merealisasikan pemaparan video kebebasan 6 darjah kesetiaan tinggi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI