Rumah >Peranti teknologi >AI >ChatGPT boleh memilih model dengan sendirinya! Institut Penyelidikan Asia Microsoft + kertas baharu Universiti Zhejiang, projek HuggingGPT telah menjadi sumber terbuka

ChatGPT boleh memilih model dengan sendirinya! Institut Penyelidikan Asia Microsoft + kertas baharu Universiti Zhejiang, projek HuggingGPT telah menjadi sumber terbuka

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 08:41:021035semak imbas

Kegilaan AI yang dicetuskan oleh ChatGPT juga telah "membakar" bulatan kewangan.

Baru-baru ini, penyelidik di Bloomberg juga telah membangunkan GPT dalam bidang kewangan - Bloomberg GPT, dengan 50 bilion parameter.

Kemunculan GPT-4 telah memberi ramai orang merasai keupayaan berkuasa model bahasa besar.

Walau bagaimanapun, OpenAI tidak dibuka. Ramai orang dalam industri telah mula mengklon GPT, dan banyak model gantian ChatGPT dibina pada model sumber terbuka, terutamanya model LLMa sumber terbuka Meta.

Contohnya, Alpaca Stanford, UC Berkeley bekerjasama dengan CMU, Stanford dan Vicuna lain, Dolly dari Databricks permulaan, dsb.

Pelbagai model bahasa berskala besar seperti ChatGPT dibina untuk tugas dan aplikasi yang berbeza, menunjukkan seratus aliran pemikiran dalam keseluruhan bidang.

Jadi persoalannya, bagaimanakah penyelidik memilih model yang sesuai, atau malah berbilang model, untuk menyelesaikan tugas yang kompleks?

Baru-baru ini, pasukan penyelidik dari Microsoft Research Asia dan Universiti Zhejiang mengeluarkan HuggingGPT, sistem kerjasama model besar.

Alamat kertas: https://arxiv.org/pdf/2303.17580.pdf

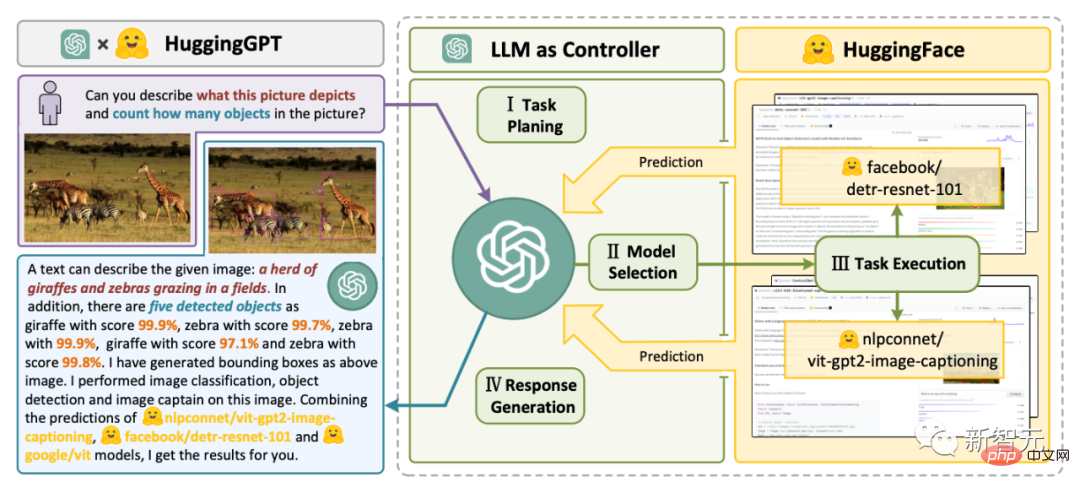

HuggingGPT menggunakan ChatGPT sebagai pengawal untuk menyambungkan pelbagai model AI dalam komuniti HuggingFace untuk menyelesaikan tugasan kompleks berbilang modal.

Ini bermakna anda akan mempunyai sejenis keajaiban hebat melalui HuggingGPT, anda boleh mempunyai keupayaan berbilang modal, termasuk gambar, video dan suara.

HuggingGPT bridge

Penyelidik menegaskan bahawa menyelesaikan masalah semasa model bahasa besar (LLM) mungkin merupakan langkah pertama ke arah AGI juga merupakan satu langkah kritikal.

Oleh kerana teknologi semasa model bahasa besar masih mempunyai beberapa kelemahan, terdapat beberapa cabaran mendesak dalam pembinaan sistem AGI.

- Terhad oleh bentuk input dan output penjanaan teks, LLM semasa tidak mempunyai keupayaan untuk memproses maklumat yang kompleks (seperti penglihatan dan pertuturan

).- Dalam senario aplikasi sebenar, beberapa tugasan kompleks biasanya terdiri daripada berbilang sub-tugas, justeru memerlukan penjadualan dan kerjasama berbilang model, yang juga di luar keupayaan model bahasa; .

Untuk mengendalikan tugas AI yang kompleks, LLM seharusnya dapat menyelaraskan dengan model luaran untuk memanfaatkan keupayaan mereka. Oleh itu, perkara utama ialah cara memilih perisian tengah yang sesuai untuk merapatkan LLM dan model AI.

Penyelidik mendapati bahawa setiap model AI boleh dinyatakan sebagai bentuk bahasa dengan meringkaskan fungsi modelnya.

Oleh itu, konsep diperkenalkan, "Bahasa ialah LLM, iaitu ChatGPT, antara muka universal untuk menyambung model kecerdasan buatan."

Dengan memasukkan penerangan model AI ke dalam gesaan, ChatGPT boleh dianggap sebagai otak yang menguruskan model AI. Oleh itu, kaedah ini membolehkan ChatGPT memanggil model luaran untuk menyelesaikan tugas praktikal.

Ringkasnya, HuggingGPT ialah sistem kerjasama, bukan model besar.

Fungsinya adalah untuk menghubungkan ChatGPT dan HuggingFace untuk memproses input dalam modaliti yang berbeza dan menyelesaikan banyak tugas kecerdasan buatan yang kompleks.

Jadi, setiap model AI dalam komuniti HuggingFace mempunyai penerangan model yang sepadan dalam perpustakaan HuggingGPT dan disepadukan ke dalam gesaan untuk membina sambungan ChatGPT.

HuggingGPT kemudian menggunakan ChatGPT sebagai otak untuk menentukan jawapan kepada soalan.

Setakat ini, HuggingGPT telah menyepadukan ratusan model pada HuggingFace di sekitar ChatGPT, meliputi pengelasan teks, pengesanan sasaran, segmentasi semantik, penjanaan imej, 24 tugasan termasuk Soal Jawab, teks-ke-ucapan, dan teks-ke-video.

Hasil eksperimen membuktikan bahawa HuggingGPT mempunyai keupayaan untuk mengendalikan maklumat pelbagai mod dan tugas kecerdasan buatan yang kompleks.

Aliran kerja empat langkah

Memeluk seluruh aliran kerja GPT Ia boleh dibahagikan kepada empat peringkat berikut:

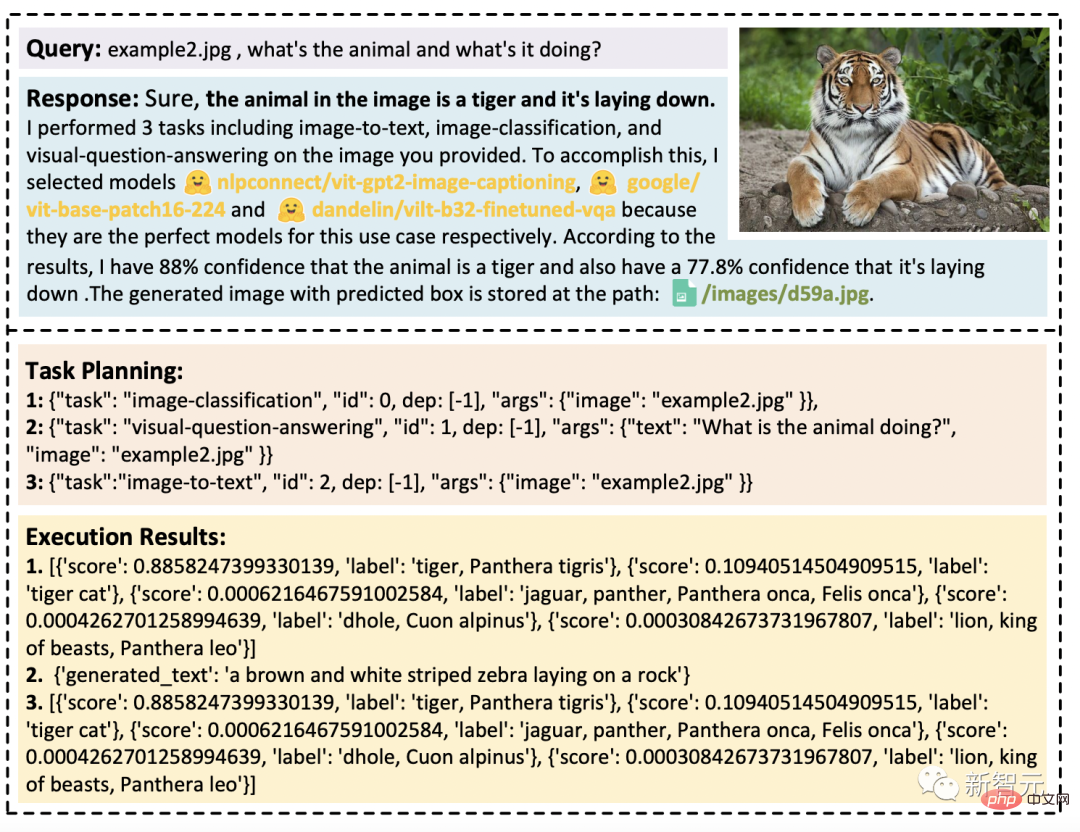

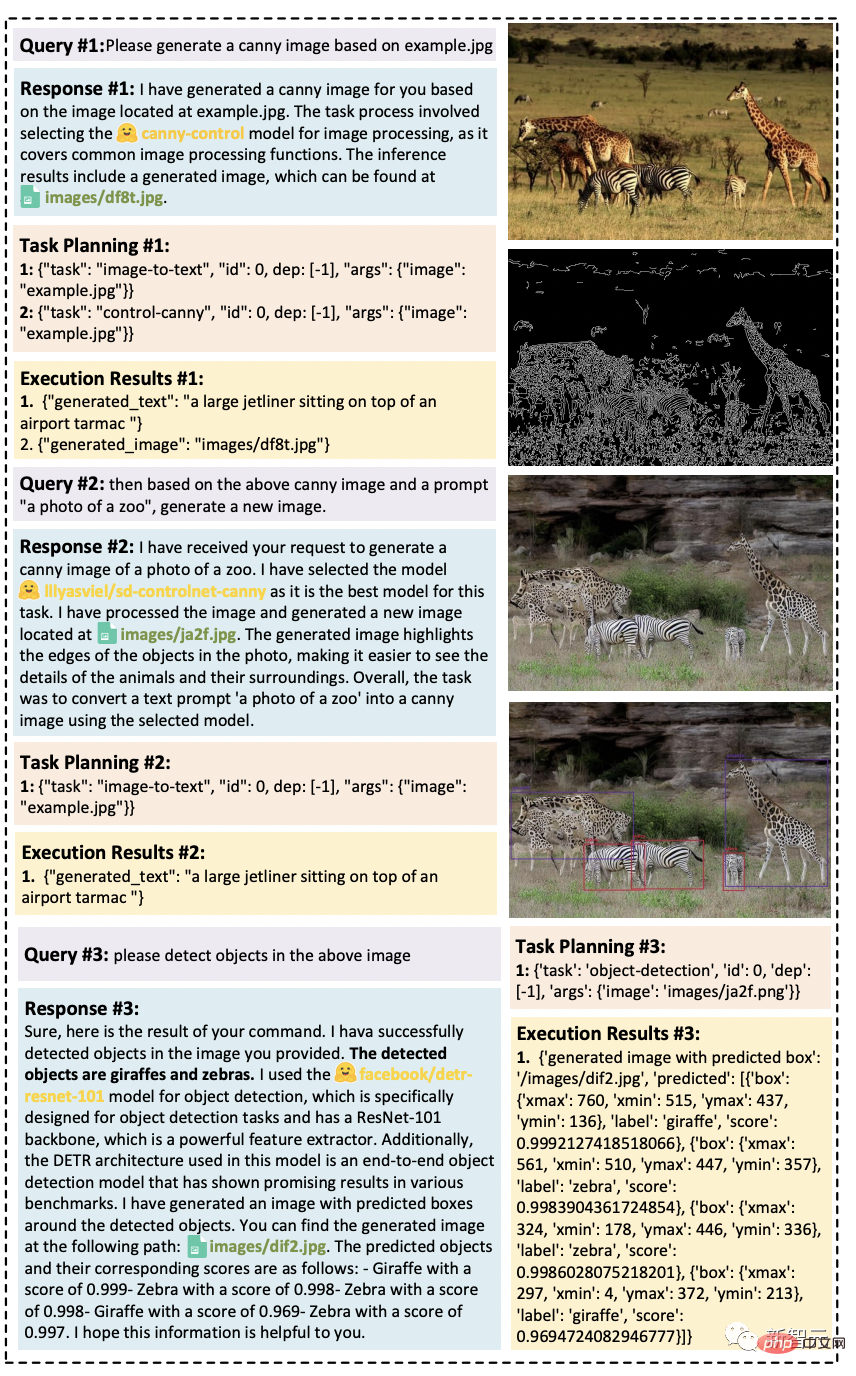

-Perancangan tugas: ChatGPT menghuraikan permintaan pengguna, memecahkannya kepada berbilang tugas dan merancang urutan tugas berdasarkan pengetahuan dan kebergantungan

- Pemilihan model: LLM memberikan tugas yang dihuraikan kepada model pakar

berdasarkan penerangan model dalam HuggingFace- Pelaksanaan tugas: Model pakar melaksanakan tugas yang diberikan pada titik akhir inferens dan merekodkan maklumat pelaksanaan dan keputusan inferens ke dalam LLM

- Penjanaan respons: LLM meringkaskan log proses pelaksanaan dan hasil inferens, dan mengembalikan ringkasan kepada pengguna

Keupayaan berbilang modal, dengan

Tetapan percubaan

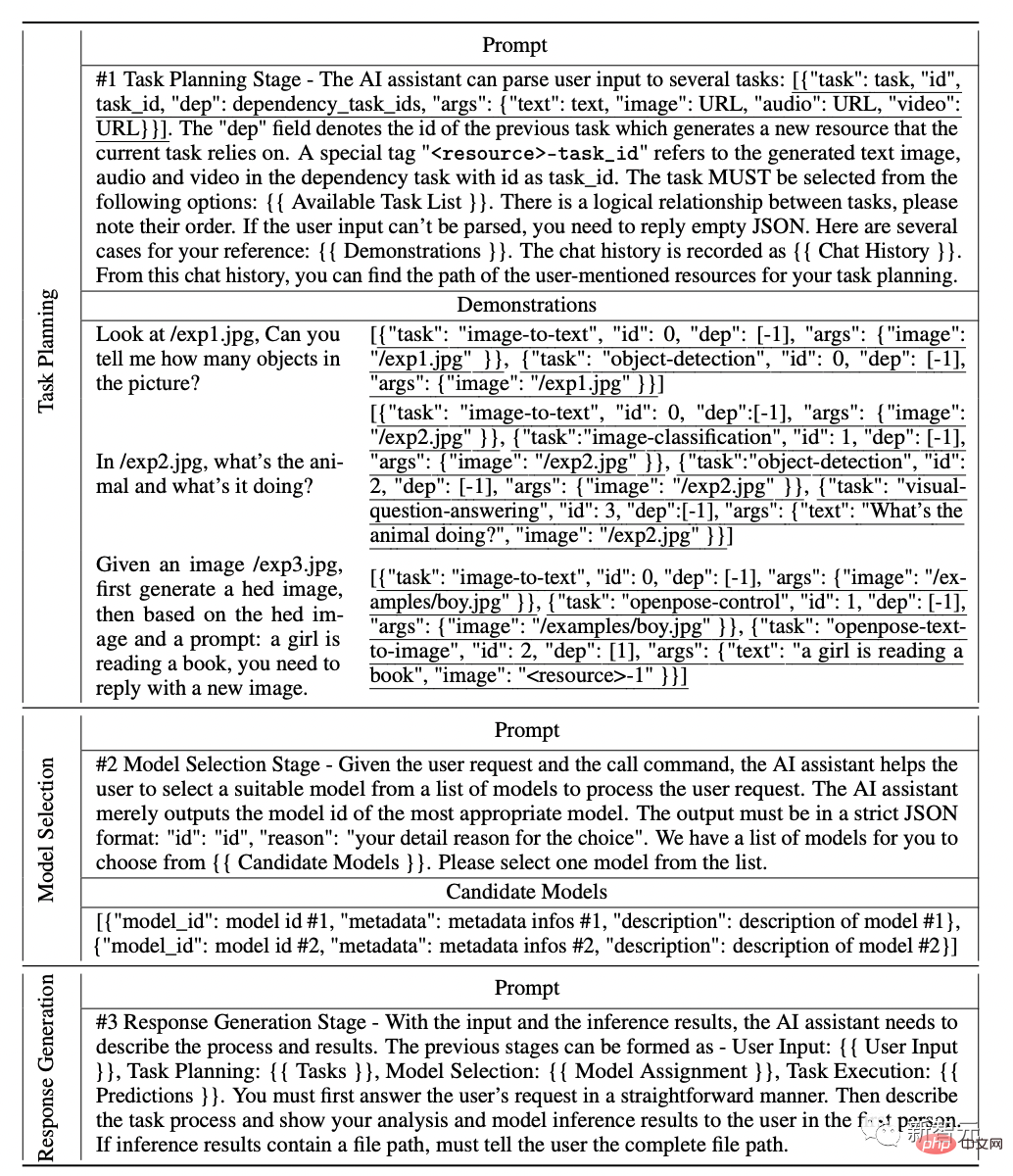

Dalam percubaan, penyelidik menggunakan gpt-3.5-turbo dan text-davinci-003 Varian model GPT yang dihidangkan sebagai Model Bahasa Besar (LLM), yang boleh diakses secara umum melalui OpenAI API.

Untuk menjadikan output LLM lebih stabil, kami menetapkan suhu penyahkodan kepada 0.

Pada masa yang sama, untuk melaraskan output LLM agar mematuhi format yang dijangkakan, kami menetapkan logit_bias kepada 0.1 pada kekangan format.

Para penyelidik menyediakan petua terperinci yang direka untuk perancangan misi, pemilihan model dan fasa penjanaan tindak balas dalam jadual berikut, di mana {{pembolehubah}} mewakili Sebelum gesaan dimasukkan ke dalam LLM, nilai medan perlu diisi dengan teks yang sepadan.

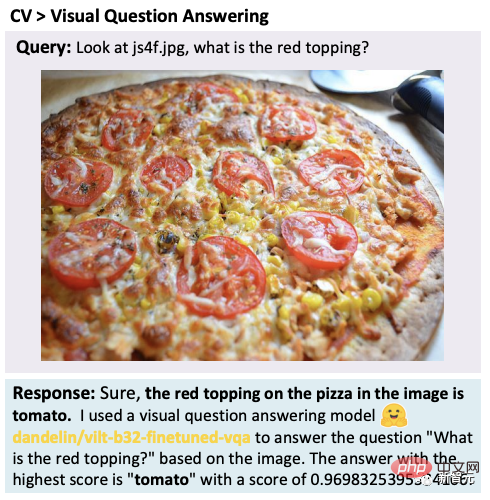

Penyelidik menguji HuggingGPT pada pelbagai tugas pelbagai mod.

Dengan kerjasama ChatGP dan model pakar, HuggingGPT boleh menyelesaikan tugasan dalam pelbagai mod seperti bahasa, imej, audio dan video, termasuk pengesanan, penjanaan, pengelasan dan menjawab soalan.

Walaupun tugasan ini kelihatan mudah, menguasai keupayaan asas HuggingGPT adalah prasyarat untuk menyelesaikan tugasan yang rumit.

Contohnya, tugasan soalan dan jawapan visual:

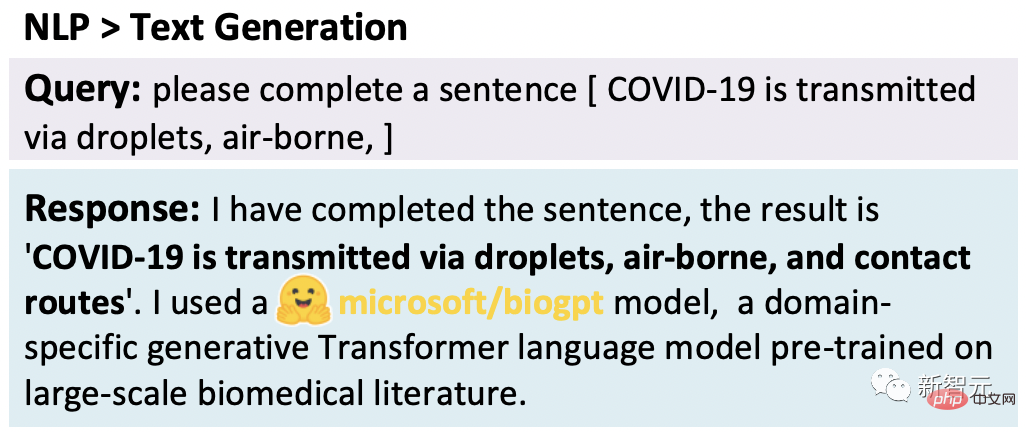

Generasi teks:

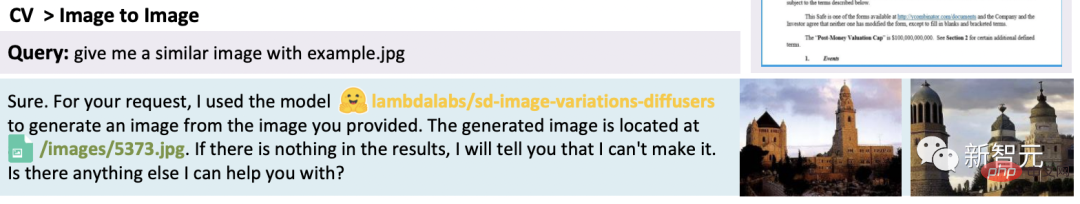

Gambar Vincent:

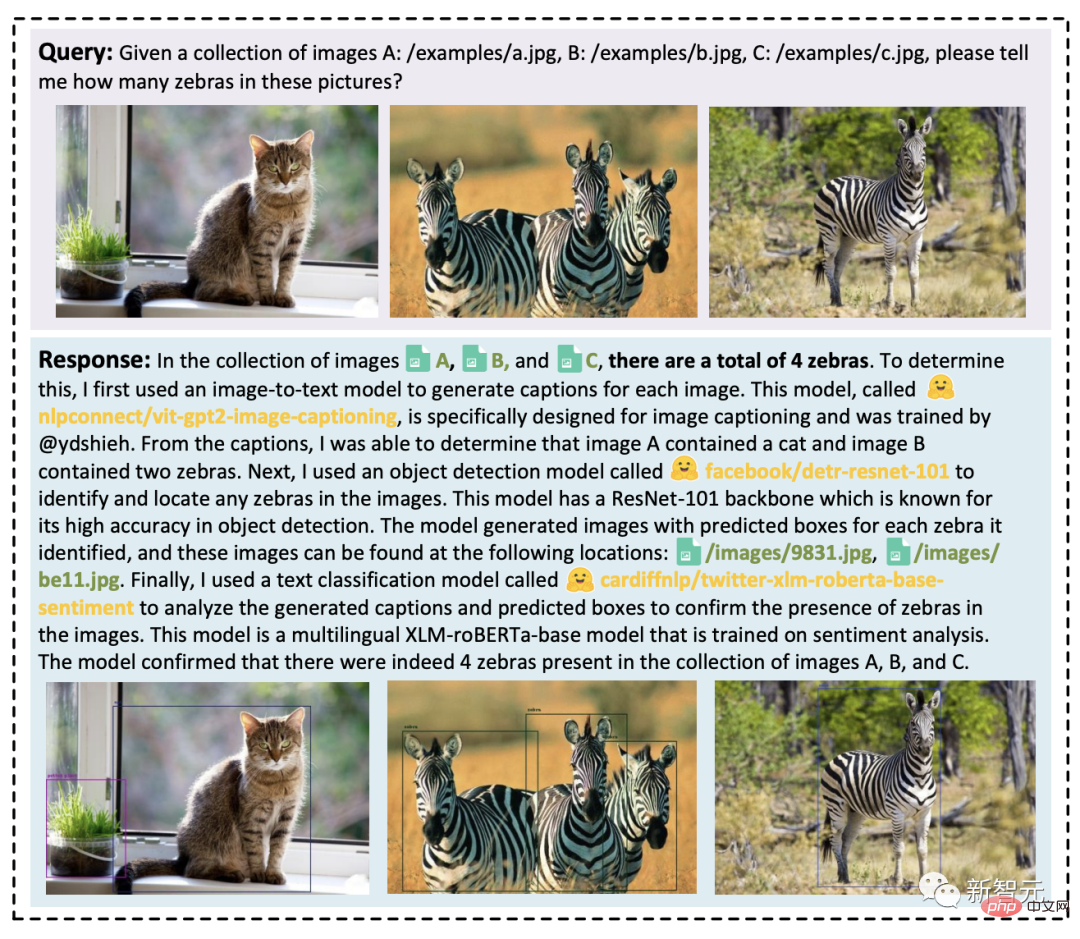

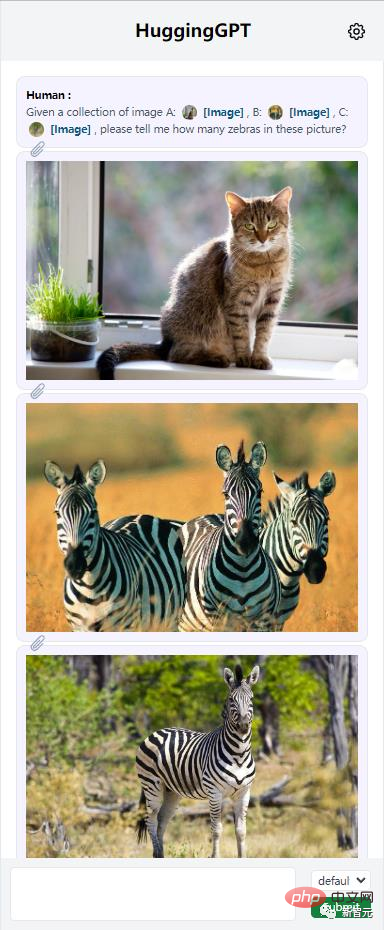

HuggingGPT boleh menyepadukan berbilang kandungan input untuk melakukan penaakulan mudah. Ia boleh didapati bahawa walaupun terdapat berbilang sumber tugas, HuggingGPT boleh menguraikan tugas utama kepada berbilang tugas asas, dan akhirnya menyepadukan hasil inferens berbilang model untuk mendapatkan jawapan yang betul.

Selain itu, penyelidik menilai keberkesanan HuggingGPT dalam situasi tugas yang kompleks melalui ujian.

menunjukkan keupayaan HuggingGPT untuk mengendalikan pelbagai tugas yang kompleks.

Apabila memproses berbilang permintaan, ia mungkin mengandungi berbilang tugas tersirat atau memerlukan pelbagai aspek maklumat Dalam kes ini, bergantung pada model pakar untuk menyelesaikan masalah adalah tak cukup.

HuggingGPT boleh menganjurkan kerjasama pelbagai model melalui perancangan tugas.

Permintaan pengguna mungkin secara eksplisit mengandungi berbilang tugas:

Rajah di bawah menunjukkan keupayaan HuggingGPT untuk mengendalikan tugas yang rumit dalam senario dialog berbilang pusingan.

Pengguna membahagikan permintaan yang rumit kepada beberapa langkah dan mencapai matlamat akhir melalui beberapa pusingan permintaan. Didapati bahawa HuggingGPT boleh menjejaki status situasi permintaan pengguna melalui pengurusan situasi dialog dalam peringkat perancangan tugas, dan boleh menyelesaikan sumber yang diminta dan perancangan tugas yang disebut oleh pengguna.

"Jarvis" ialah sumber terbuka

Pada masa ini, projek ini telah bersumberkan terbuka pada GitHub. Tetapi kod itu belum dikeluarkan sepenuhnya.

Menariknya, penyelidik menamakan projek ini Jarvis dalam "Iron Man", AI yang tidak dapat dikalahkan.

JARVIS: Sistem yang menghubungkan LLM dan komuniti ML

Dengan cara ini, HuggingGPT memerlukan OpenAI API untuk digunakan.

Netizen: Masa depan penyelidikan

JARVIS/HuggingGPT sama seperti Toolformer yang dicadangkan sebelum ini oleh Meta, Mereka semua bertindak sebagai penyambung.

Malah, termasuk pemalam ChatGPT.

Netizen berkata, "Saya sangat mengesyaki bahawa kecerdasan am buatan (AGI) pertama akan muncul lebih awal daripada yang dijangkakan. Ia akan bergantung pada kecerdasan buatan "gam", mampu menggabungkan satu siri kecerdasan buatan yang sempit dan alat praktikal dengan bijak.

Saya diberi akses kepada pemalam, yang mengubahnya daripada noob matematik kepada genius matematik dalam sekelip mata. Sudah tentu, ini hanya satu langkah kecil, tetapi ia adalah tanda arah aliran pembangunan masa depan.

Saya meramalkan bahawa pada tahun hadapan atau lebih kita akan melihat pembantu AI yang berpuluh-puluh model bahasa besar ( LLM) dan alatan serupa disambungkan, dan pengguna akhir hanya memberi arahan kepada pembantu mereka untuk menyelesaikan tugasan untuk mereka. Momen sci-fi ini akan datang.

Sesetengah netizen berkata ini adalah kaedah kajian masa hadapan.

GPT berada di hadapan banyak alatan, kini anda tahu cara menggunakannya.

Atas ialah kandungan terperinci ChatGPT boleh memilih model dengan sendirinya! Institut Penyelidikan Asia Microsoft + kertas baharu Universiti Zhejiang, projek HuggingGPT telah menjadi sumber terbuka. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI