Rumah >Peranti teknologi >AI >Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi

Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi

- 王林ke hadapan

- 2023-04-10 14:39:281599semak imbas

Gabungan terkuat HuggingFace+ChatGPT="Jarvis" kini dibuka untuk demo.

Beberapa masa lalu, Universiti Zhejiang dan Microsoft mengeluarkan HuggingGPT, sistem kerjasama model besar yang menjadi popular segera.

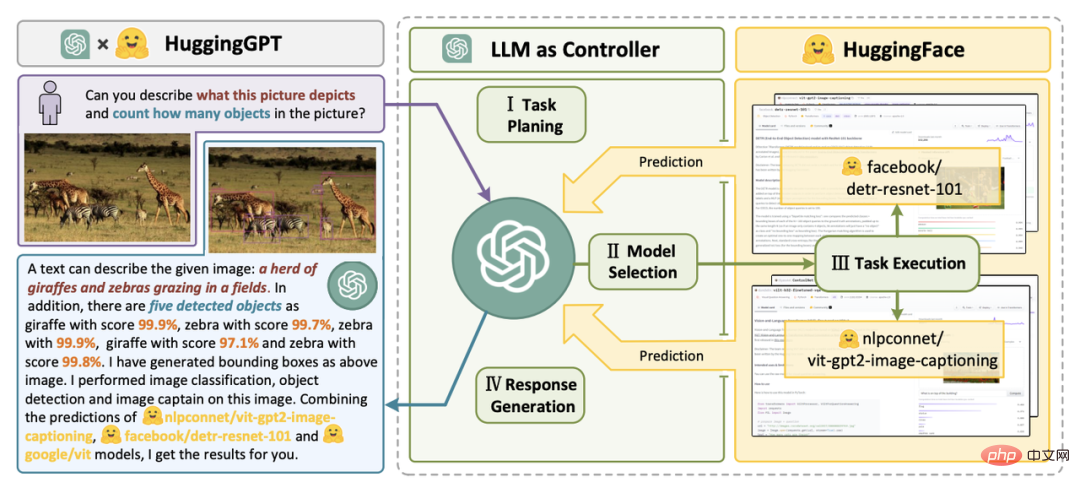

Para penyelidik mencadangkan menggunakan ChatGPT sebagai pengawal untuk menyambungkan pelbagai model AI dalam komuniti HuggingFace untuk menyelesaikan tugasan kompleks berbilang modal.

Dalam keseluruhan proses, semua yang anda perlu lakukan ialah: mengeluarkan keperluan anda dalam bahasa semula jadi.

Para saintis Nvidia berkata ini adalah kertas kerja paling menarik yang pernah saya baca minggu ini. Ideanya sangat dekat dengan "Apl Semuanya" yang saya nyatakan sebelum ini, iaitu, semuanya adalah Apl, dan maklumat itu dibaca terus oleh AI.

Pengalaman Bermula

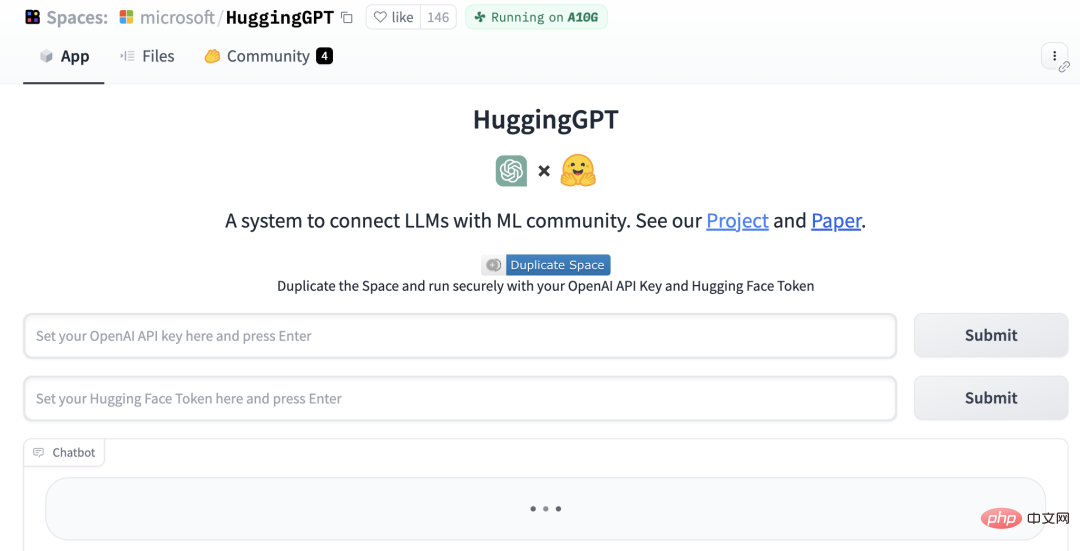

Kini, HuggingGPT telah menambah demo Gradio.

Alamat projek: https://github.com/microsoft/JARVIS

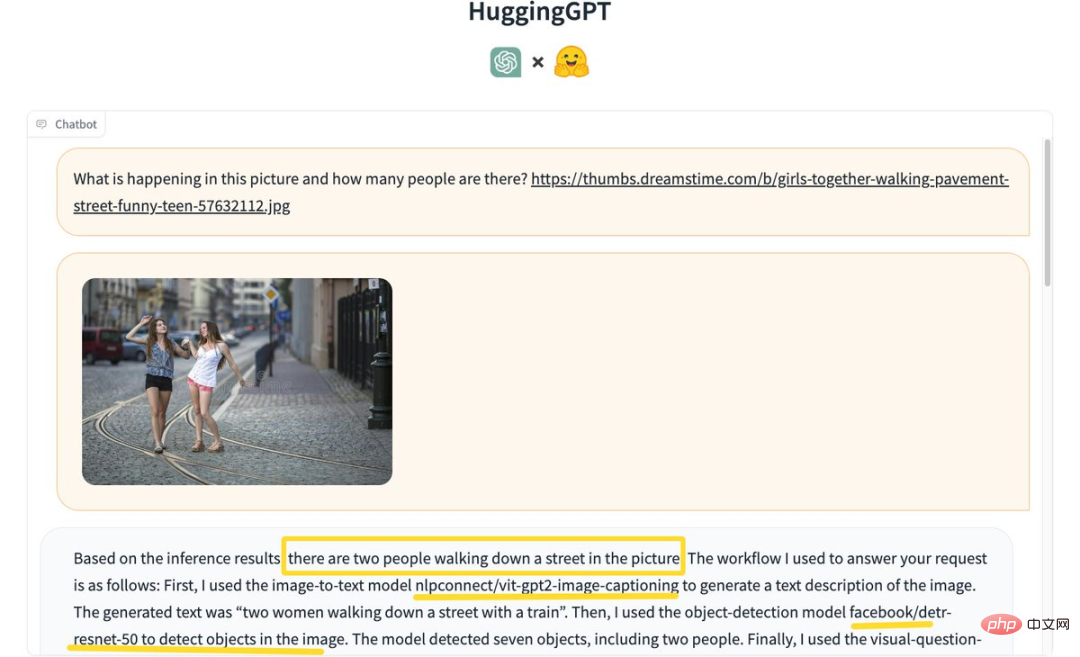

Sesetengah netizen mula mengalaminya, mula-mula mari kita "kenal pasti berapa ramai orang dalam gambar"?

MemelukGPT berdasarkan keputusan inferens, membuat kesimpulan bahawa terdapat 2 orang berjalan di jalan dalam gambar.

Proses khusus adalah seperti berikut:

Mula-mula gunakan imej untuk teks model nlpconnect/vit-gpt2-image-captioning untuk menerangkan imej dan jana teks "Dua wanita berjalan di jalan dengan kereta api."

Seterusnya, model pengesanan objek facebook/detresnet 50 digunakan untuk mengesan bilangan orang dalam gambar. Model itu mengesan 7 objek dan 2 orang.

Kemudian gunakan model menjawab soalan visual dandelin/vilt-b32-finetuned-vqa untuk mendapatkan keputusan. Akhir sekali, sistem menyediakan respons terperinci dan maklumat model untuk menjawab soalan.

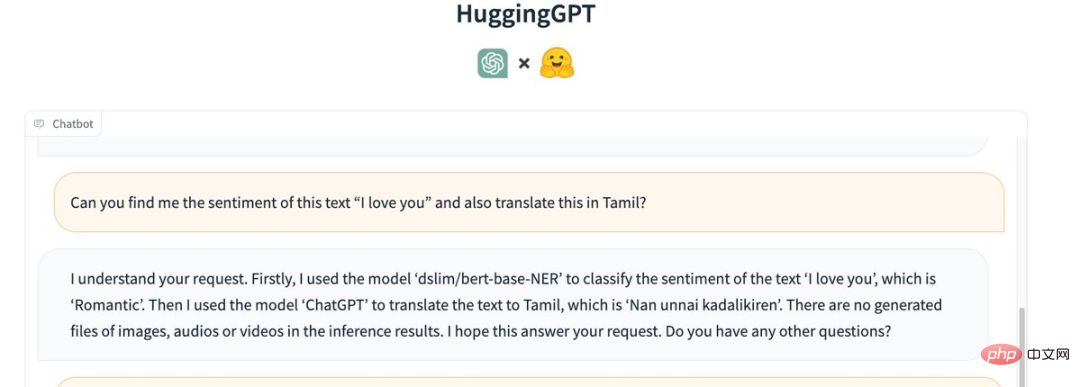

Selain itu, biarkan ia memahami emosi ayat "I love you" dan menterjemahkannya ke dalam bahasa Tamil (Tamiḻ).

HuggingGPT memanggil model berikut:

Pertama, model "dslim/bert-base-NER" digunakan untuk memadankan teks " Saya sayang awak "Pengkelasan emosi adalah "romantik".

Kemudian, gunakan "ChatGPT" untuk menterjemah teks ke dalam bahasa Tamil, iaitu "Nan unnai kadalikiren".

Tiada imej, fail audio atau video yang dijana dalam hasil inferens.

PelukanGPT gagal semasa menyalin fail MP3. Seorang netizen berkata, "Tidak pasti sama ada ini adalah masalah dengan fail input saya."

Masukkan imej "Kucing menari" dan tambahkan teks "I LOVE YOU" sebagai tindanan.

HuggingGPT mula-mula menggunakan model "runwayml/stable-diffusion-1-5" untuk menjana gambar "kucing menari" berdasarkan teks yang diberikan.

Kemudian, model yang sama digunakan untuk menjana imej "I LOVE YOU" berdasarkan teks yang diberikan.

Akhir sekali, gabungkan kedua-dua gambar dan keluarkan gambar berikut:

Jarvis menjadi kenyataan

Beberapa hari selepas projek itu diumumkan , Jarvis telah menerima 12.5k bintang di GitHub dan 811 garpu.

Penyelidik menegaskan bahawa menyelesaikan masalah semasa model bahasa besar (LLM) mungkin merupakan langkah pertama dan penting ke arah AGI.

Oleh kerana teknologi semasa model bahasa besar masih mempunyai beberapa kelemahan, terdapat beberapa cabaran mendesak dalam pembinaan sistem AGI.

Untuk mengendalikan tugas AI yang kompleks, LLM seharusnya dapat menyelaraskan dengan model luaran untuk memanfaatkan keupayaan mereka.

Oleh itu, perkara utama ialah cara memilih perisian tengah yang sesuai untuk merapatkan LLM dan model AI.

Dalam kertas penyelidikan ini, pengkaji mencadangkan bahasa ialah antara muka universal dalam HuggingGPT. Aliran kerjanya terbahagi terutamanya kepada empat langkah:

Alamat kertas: https://arxiv.org/pdf/2303.17580.pdf

Pertama ialah perancangan tugasan ChatGPT menghuraikan permintaan pengguna, memecahkannya kepada berbilang tugas dan merancang urutan dan kebergantungan tugas berdasarkan pengetahuannya.

Seterusnya, teruskan ke pemilihan model. LLM memberikan tugas yang dihuraikan kepada model pakar berdasarkan penerangan model dalam HuggingFace.

Kemudian laksanakan tugas itu. Model pakar melaksanakan tugasan yang diberikan pada titik akhir inferens dan merekodkan maklumat pelaksanaan dan keputusan inferens ke dalam LLM.

Akhir sekali ialah penjanaan tindak balas. LLM meringkaskan log proses pelaksanaan dan keputusan inferens, dan mengembalikan ringkasan kepada pengguna.

Jika permintaan sedemikian diberikan:

Sila hasilkan gambar seorang gadis sedang membaca buku , dia Posenya sama dengan budak lelaki dalam contoh.jpg. Kemudian gunakan suara anda untuk menerangkan imej baharu.

Anda boleh melihat cara HuggingGPT menguraikannya kepada 6 subtugasan dan memilih model untuk dilaksanakan masing-masing untuk mendapatkan hasil akhir.

Dengan memasukkan penerangan model AI ke dalam gesaan, ChatGPT boleh dianggap sebagai otak yang menguruskan model AI. Oleh itu, kaedah ini membolehkan ChatGPT memanggil model luaran untuk menyelesaikan tugas praktikal.

Ringkasnya, HuggingGPT ialah sistem kerjasama, bukan model besar.

Fungsinya adalah untuk menghubungkan ChatGPT dan HuggingFace untuk memproses input dalam modaliti yang berbeza dan menyelesaikan banyak tugas kecerdasan buatan yang kompleks.

Jadi, setiap model AI dalam komuniti HuggingFace mempunyai penerangan model yang sepadan dalam perpustakaan HuggingGPT, dan disepadukan ke dalam gesaan untuk mewujudkan sambungan dengan ChatGPT.

HuggingGPT kemudian menggunakan ChatGPT sebagai otak untuk menentukan jawapan kepada soalan tersebut.

Setakat ini, HuggingGPT telah menyepadukan ratusan model pada HuggingFace di sekitar ChatGPT, meliputi klasifikasi teks, pengesanan sasaran, segmentasi semantik, penjanaan imej, soal jawab, teks ke ucapan, 24 tugasan seperti sebagai teks kepada video.

Hasil eksperimen membuktikan bahawa HuggingGPT boleh menunjukkan prestasi yang baik dalam pelbagai bentuk tugasan yang kompleks.

Komen hangat daripada netizen

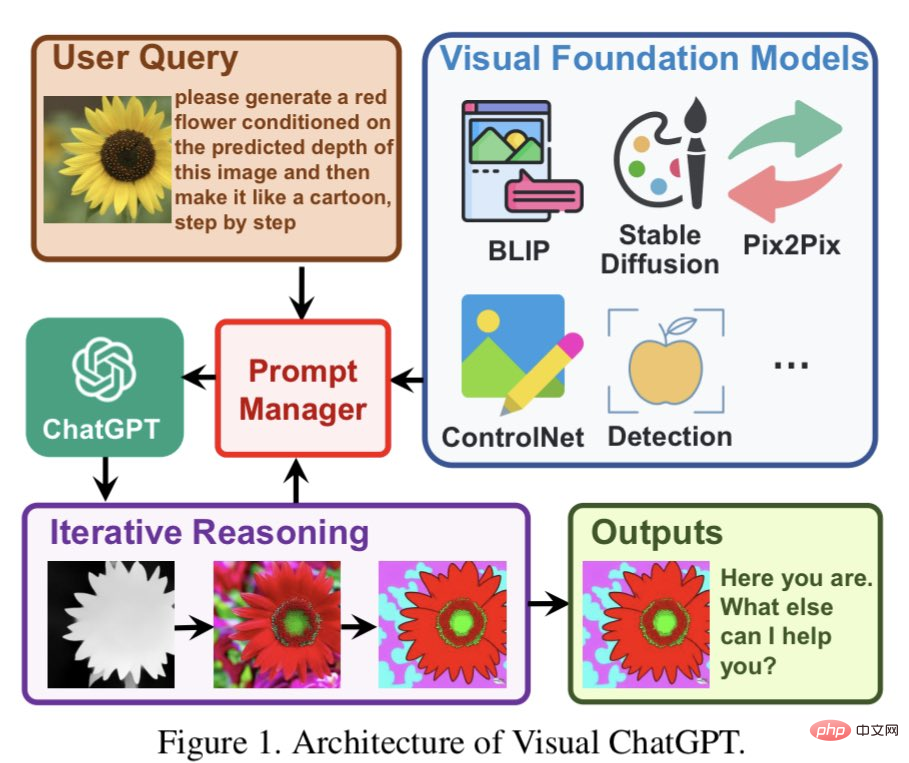

Sesetengah netizen berkata HuggingGPT serupa dengan Visual ChatGPT yang dicadangkan oleh Microsoft sebelum ini daripada model pra-latihan yang unggul.

Visual ChatGPT dibina terus pada ChatGPT dan menyuntik banyak model visual (VFM) ke dalamnya. Urus Prompt dicadangkan dalam artikel.

Dengan bantuan PM, ChatGPT boleh menggunakan VFM ini dan menerima maklum balas mereka secara berulang sehingga keperluan pengguna dipenuhi atau syarat tamat dicapai.

Sesetengah netizen percaya idea ini sememangnya hampir sama dengan ChatGPT. Menggunakan LLM sebagai pusat pemahaman semantik dan perancangan tugas boleh meningkatkan keupayaan LLM secara tidak terhingga. Dengan menggabungkan LLM dengan pakar fungsian atau domain lain, kami boleh mencipta sistem AI yang lebih berkuasa dan fleksibel yang boleh menyesuaikan diri dengan lebih baik kepada pelbagai tugas dan keperluan.

Inilah yang selalu saya fikirkan tentang model kecerdasan buatan boleh memahami tugas yang rumit dan kemudian memberikan tugasan yang lebih kecil kepada tugasan lain yang lebih khusus model.

Sama seperti otak, ia juga mempunyai bahagian yang berbeza untuk melaksanakan tugas tertentu, bunyinya sangat logik.

Atas ialah kandungan terperinci Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI