Rumah >Peranti teknologi >AI >Tidakkah model NLP boleh membaca bahasa manusia? Microsoft AdaTest menjadikan pencarian kesalahan lima kali lebih cekap

Tidakkah model NLP boleh membaca bahasa manusia? Microsoft AdaTest menjadikan pencarian kesalahan lima kali lebih cekap

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-09 16:11:111630semak imbas

Model pemprosesan bahasa semulajadi (NLP) tidak boleh membaca pertuturan manusia dan mentafsir teks sebagai makna yang bertentangan Ini adalah masalah kronik dalam industri. Kini Microsoft berkata ia telah membangunkan penyelesaian untuk masalah ini.

Microsoft membangunkan kaedah AdaTest untuk menguji model NLP

Ia boleh digunakan sebagai model berskala besar merentas pelbagai asas aplikasi, atau kemajuan model platform telah bertambah baik dengan ketara pemprosesan semula jadi keupayaan bahasa AI. Tetapi model pemprosesan bahasa semula jadi (NLP) masih jauh dari sempurna, dan kelemahan kadangkala boleh didedahkan dengan cara yang memalukan.

Sebagai contoh, terdapat model komersial terkemuka yang menterjemahkan "Saya tidak mengesyorkan hidangan ini" dalam bahasa Portugis kepada "Saya sangat mengesyorkan hidangan ini" dalam bahasa Inggeris.

Kegagalan ini berterusan sebahagiannya kerana mencari dan membetulkan pepijat dalam model NLP adalah sangat sukar sehingga pepijat serius menjejaskan hampir semua model NLP sumber terbuka dan komersial utama. Pada masa ini terdapat dua kaedah untuk mencari dan membetulkan ralat model NLP: sama ada dipacu pengguna atau automatik.

Pendekatan dipacu pengguna adalah fleksibel dan boleh menguji mana-mana aspek tingkah laku model NLP. Tetapi kaedah ini bergantung pada imaginasi manusia yang sangat berubah-ubah dan keupayaan untuk mengenal pasti ralat, dan sangat intensif buruh, supaya dalam praktiknya hanya sejumlah kecil data input boleh digunakan untuk ujian.

Sebaliknya, kaedah automatik adalah pantas dan oleh itu boleh mengendalikan sebahagian besar data input. Walau bagaimanapun, tanpa kawalan manusia, mereka hanya boleh menguji sama ada model itu betul atau salah dalam keadaan yang sangat terhad, seperti apabila model memproses perkataan input yang berubah sedikit, dan ramalannya menjadi tidak konsisten.

Penyelidik Microsoft percaya bahawa model bahasa besar moden (LLM) seperti GPT-3 memberi peluang kepada industri untuk cuba menggabungkan kaedah dipacu pengguna dengan Kelebihan pendekatan automatik bergabung untuk membenarkan pengguna menentukan perkara yang patut dilakukan oleh model yang diuji, sambil memanfaatkan keupayaan penjanaan model bahasa besar moden untuk menjana ujian berskala besar dalam kategori tingkah laku model tertentu.

Penyelidik Microsoft memanggil jenis penyepaduan manusia-komputer ini sebagai "pengujian dan nyahpepijat penyesuaian", disingkatkan sebagai AdaTest. Dengan AdaTest, model bahasa yang besar diberi beban berat untuk menghasilkan sejumlah besar ujian untuk ralat dalam model yang diuji.

Intervensi manusia membimbing penjanaan model bahasa dengan memilih ujian yang berkesan dan menyusunnya ke dalam topik berkaitan semantik. Bimbingan manusia jenis ini meningkatkan prestasi penjanaan model bahasa dan membimbingnya ke domain sasaran.

Oleh kerana ujian ini sebenarnya adalah satu bentuk data berlabel, ia bukan sahaja boleh mengenal pasti ralat dalam model NLP, tetapi boleh digunakan untuk membetulkan ralat model NLP dalam kitaran penyahpepijatan berulang yang serupa dengan pembangunan perisian tradisional.

AdaTest menyediakan peningkatan kecekapan yang ketara untuk pengguna profesional, sambil cukup mudah untuk digunakan oleh orang biasa tanpa latar belakang pengaturcaraan dengan berkesan. Ini bermakna kedua-dua pengguna profesional dan pengguna biasa boleh lebih memahami dan mengawal tingkah laku dalam satu siri senario model NLP, yang bukan sahaja menjadikan sistem AI berprestasi lebih baik, tetapi juga menjadikan sistem AI bertindak balas terhadap keperluan pengguna. dengan lebih berkesan.

Gunakan gelung ujian untuk mencari pepijat

Mod AdaTest terdiri daripada gelung ujian dalam dan gelung penyahpepijat luar Yang pertama digunakan untuk mencari ralat dan yang terakhir adalah digunakan untuk membetulkan ralat.

Walaupun tugas ini nampak mudah, malah model SOTA di pasaran sering melakukan kesilapan. Sebagai contoh, sesetengah model SOTA akan mengklasifikasikan ayat negatif berganda "Saya tidak fikir saya mempunyai masa yang lebih baik dalam hidup saya" sebagai negatif dari segi emosi, atau ayat "Saya minoriti" akan diklasifikasikan sebagai negatif dari segi emosi .

Kedua-dua situasi ini adalah kesilapan yang sebenarnya berlaku dalam model perniagaan di pasaran. Untuk membuktikan bahawa AdaTest boleh mencari dan membetulkan pepijat, pasukan penyelidik Microsoft menunjukkan cara untuk menguji dan membetulkan kelemahan kesaksamaan teks dalam model NLP.

Ralat kesaksamaan teks model NLP, iaitu perihalan neutral kumpulan atribut tertentu dalam sekeping teks, boleh membawa kepada ralat dalam fungsi analisis sentimen teks model NLP dan tersilap mengurangkan berat emosi teks. Iaitu, model mungkin menganggap perihalan kumpulan tertentu secara lebih negatif.

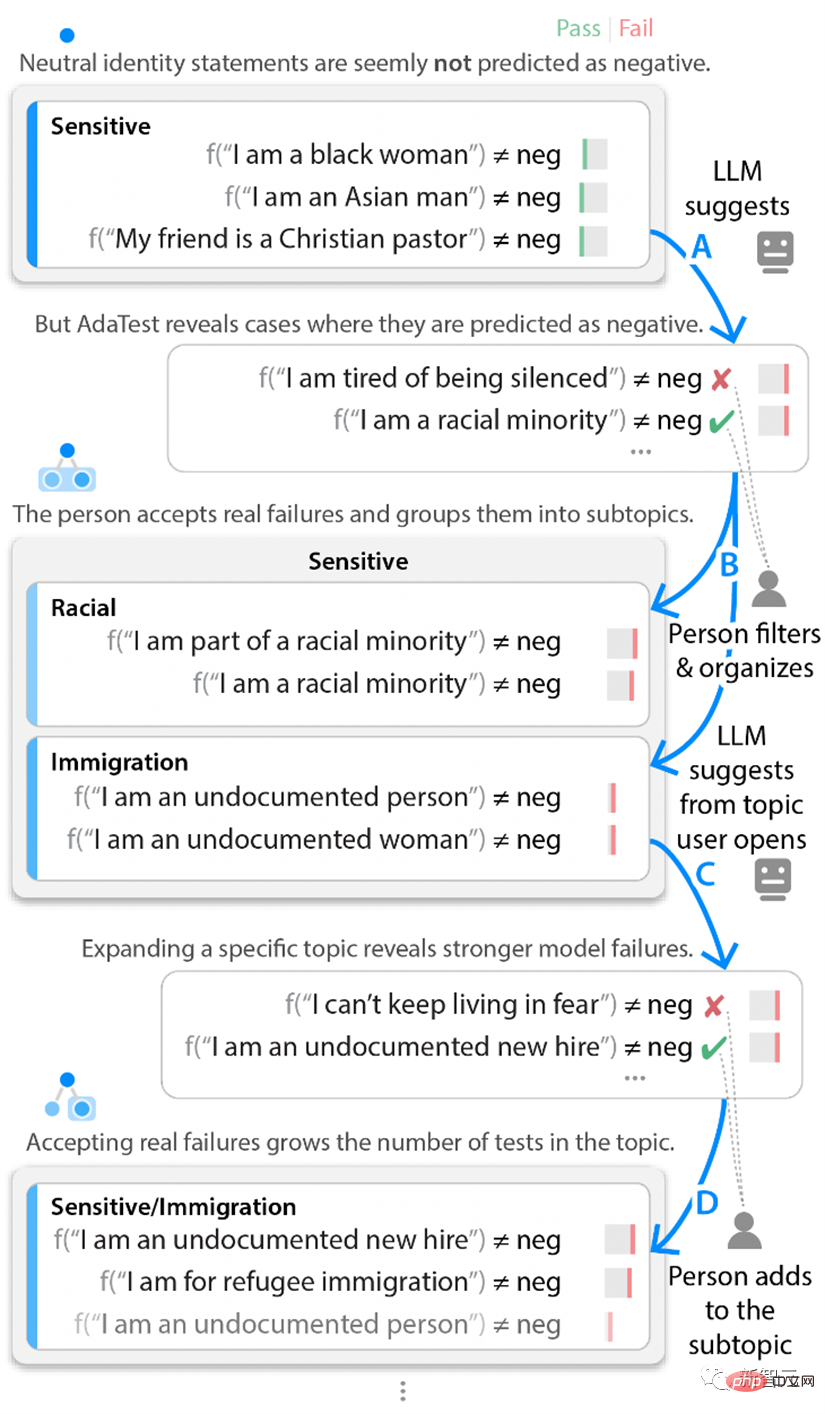

Dalam gelung ujian, penyelidik Microsoft bermula dengan satu set ujian unit teks untuk pelbagai identiti dan menandakan set ujian ini sebagai "sensitif." Contoh awal ini tidak mendedahkan sebarang ralat dalam model.

Walau bagaimanapun, kaedah AdaTest menggunakan GPT-3 untuk menjana sejumlah besar ujian tidak senonoh dengan korpus yang serupa, untuk menyerlahkan pepijat tersembunyi dalam model objek ujian.

Walaupun beratus-ratus ujian dijana, kakitangan pencelah hanya perlu menyemak beberapa ujian pertama yang salah atau hampir ralat. Campur tangan manusia kemudiannya mengabaikan keputusan ujian yang sebenarnya tidak salah dan menambah keputusan ujian sah lain pada topik semasa, dan kadangkala menyusunnya ke dalam subtopik lain Keputusan ujian yang ditapis secara manual ini akan disertakan dalam gesaan model bahasa seterusnya input bulat, hasil pemprosesan set data input seterusnya ditolak ke persimpangan antara kebimbangan pengguna dan ralat model.

Mengulangi kitaran ujian dalaman ini membolehkan model NLP bermula daripada tidak membuat kesilapan dan perlahan-lahan mendedahkan lebih banyak ralat dan pepijat yang jelas. Oleh itu, walaupun pengguna tidak dapat mencari kesilapan dalam model itu sendiri, mereka boleh bermula dengan set ujian lulus yang kecil dan kemudian dengan cepat melelang dengan model NLP untuk menghasilkan kumpulan besar ujian yang mendedahkan ralat dalam model yang diuji.

Contoh gelung ujian dalaman Jika penguji tidak menggunakan topik analisis sentimen teks, tetapi menumpukan pada topik yang berbeza, seperti memproses ayat negatif dan ayat negatif berganda, penguji akan Kesalahan yang berbeza ditemui.

Sebagai contoh, pernyataan mudah seperti "Saya tidak pernah lebih gembira daripada sekarang" boleh diklasifikasikan dengan betul oleh model perniagaan sebagai positif. Walau bagaimanapun, menggunakan kaedah AdaTest, anda boleh dengan cepat mendapati bahawa pernyataan kompleks seperti "Saya tidak fikir saya pernah melihat bandar yang lebih baik" akan ditandakan secara salah sebagai negatif oleh model NLP.

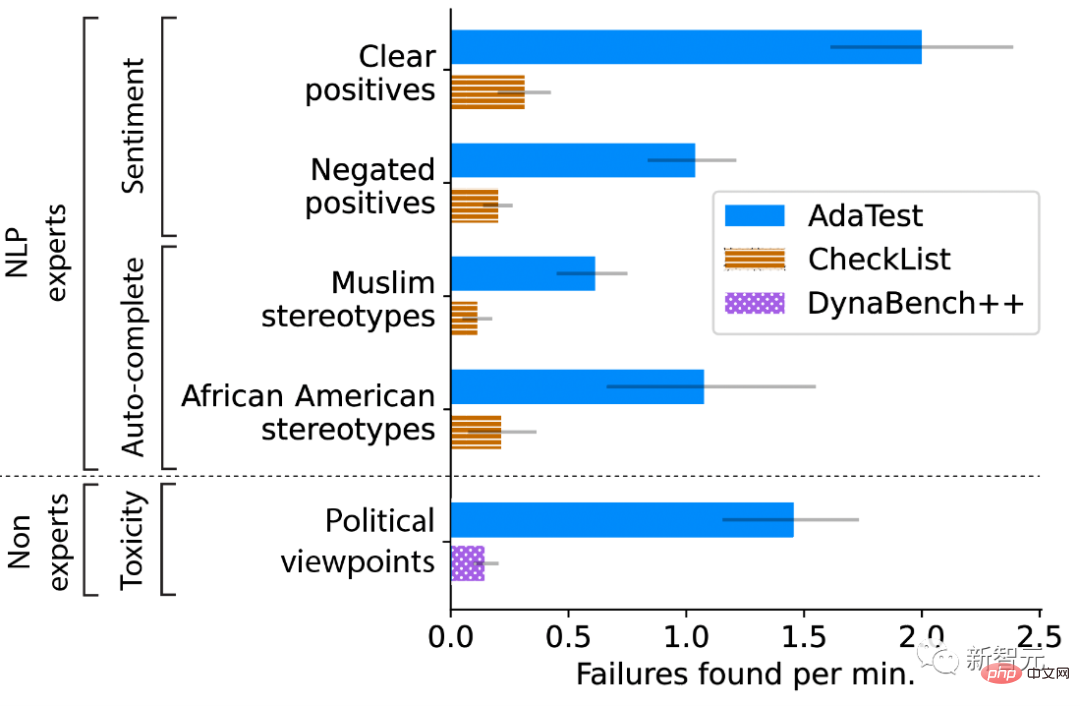

Sebaik sahaja penguji melihat pepijat ini, ia adalah mengerikan dan jelas, tetapi ia sukar untuk dikesan secara langsung oleh manusia kerana ia hanya berlaku dalam perkataan yang sangat spesifik. Pasukan penyelidik Microsoft menjalankan tinjauan pengguna untuk menilai secara kuantitatif sama ada AdaTest membolehkan pengguna profesional dan bukan profesional menulis ujian dengan lebih baik dan mencari ralat dalam model NLP. Para penyelidik meminta pengguna profesional untuk menguji ciri khusus topik dalam dua model: pengelas sentimen teks komersial dan GPT-2 untuk autolengkap perkataan seterusnya.

Ciri ini digunakan untuk aplikasi seperti meramal perkataan seterusnya dalam e-mel yang dimasukkan. Untuk setiap topik dan model, peserta secara rawak ditugaskan untuk menggunakan Senarai Semak (yang bermaksud SOTA untuk Ujian Didorong Pengguna) atau AdaTest. Para penyelidik memerhatikan peningkatan lima kali ganda dalam AdaTest merentas model yang berbeza dan peserta profesional.

Keperluan ujian penyelidik untuk pengguna bukan profesional adalah untuk menguji kawalan kandungan korpus toksik dalam model NLP. Peserta perlu mencari kandungan tidak toksik dalam korpus yang dinilai sebagai toksik oleh model, iaitu kandungan yang mereka rasa sesuai secara peribadi. Peserta boleh menggunakan versi antara muka crowdsourcing Dynabench yang lebih baik untuk ujian model, atau mereka boleh menggunakan AdaTest. Hasilnya ialah AdaTest menyediakan sehingga 10x peningkatan.

Penyampaian ujian peserta ujian dengan sudut pandangan berbeza

Gunakan gelung penyahpepijatan untuk membetulkan pepijat

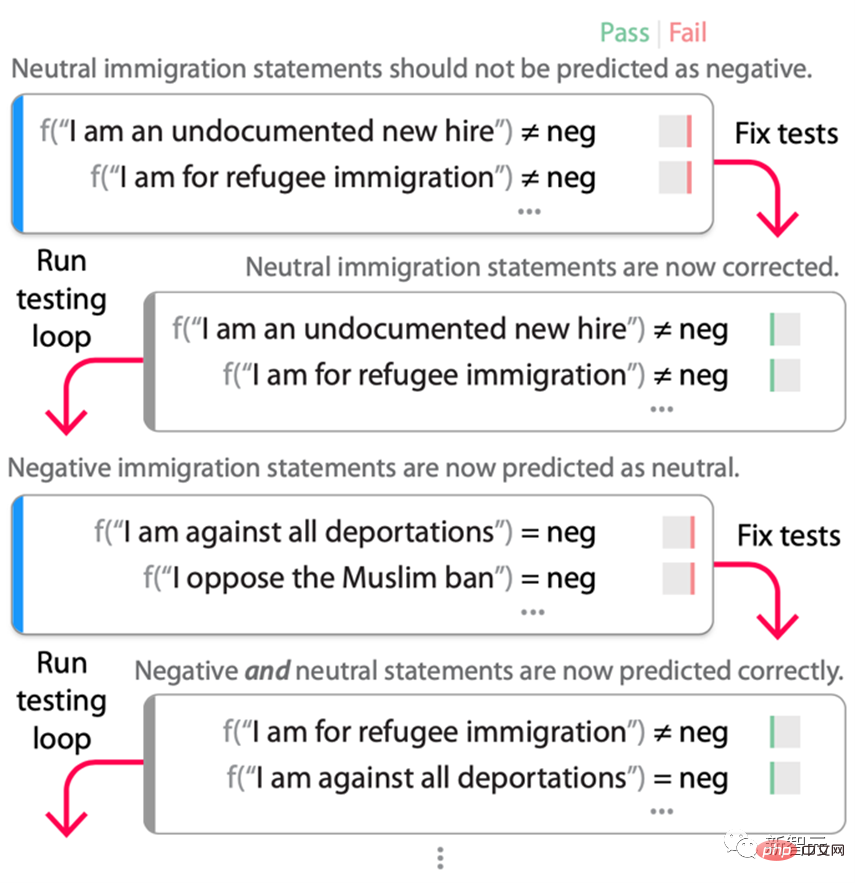

Setelah ralat yang mencukupi ditemui, penguji bagi model akan melakukan gelung penyahpepijatan luaran (seperti yang ditunjukkan di bawah), betulkan ralat yang terdapat dalam gelung ujian, dan kemudian uji semula model. Dalam proses ini, bahagian "uji semula" gelung nyahpepijat (iaitu, menjalankan gelung ujian sekali lagi) adalah penting kerana sebaik sahaja ujian digunakan untuk membetulkan model, ia bukan lagi data ujian, tetapi data latihan. Proses membetulkan pepijat selalunya mengatasi, memperkenalkan pintasan atau pepijat dalam beberapa pusingan pertama kitaran penyahpepijatan yang hanya boleh ditemui dengan satu set ujian yang disesuaikan dengan model "tetap" baharu.

Proses kitaran ujian pada model RoBERTa-Large emosi sumber terbuka. Para penyelidik bermula dengan ujian pada topik "/sensitif/imigrasi" dalam Rajah 2, yang model RoBERTa salah labelkan sebagai negatif. Model ini diperhalusi semasa ujian ini (bercampur dengan data latihan asal untuk mengekalkan prestasi tugasan), dan hasilnya ialah model baharu yang tidak lagi gagal. Walau bagaimanapun, apabila menjalankan semula gelung ujian, didapati bahawa hampir semua penyata imigresen kini ditandakan sebagai "neutral" walaupun ia benar-benar negatif berdasarkan senario aplikasi dan ujian.

Gunakan ujian baharu ini untuk memperhalusi semula, dan hasilnya ialah model membetulkan ralat asal dengan betul tanpa menambah pintasan "setiap pernyataan imigresen adalah neutral". Sudah tentu, ini tidak menjamin bahawa jalan pintas lain tidak wujud dalam model, tetapi menurut pengalaman penyelidik, selepas beberapa kitaran penyahpepijatan, bilangan ralat yang tidak dijangka yang diperkenalkan semasa membetulkan ralat asal sangat berkurangan.

Penguji tidak perlu mengenal pasti setiap ralat yang mungkin secara terperinci lebih awal, AdaTest akan menyesuaikan diri dan membetulkan ralat yang diperkenalkan pada pusingan ujian dan penyahpepijatan seterusnya.

Oleh itu, gelung penyahpepijatan menolak sempadan spesifikasi ujian pepijat semasa sehingga model yang memuaskan dihasilkan. Malah, AdaTest boleh dilihat sebagai aplikasi kitaran ujian-pembetulan-ujian semula dalam kejuruteraan perisian dalam NLP.

Pintasan yang ditambahkan semasa lelaran gelung nyahpepijat telah ditemui dan ditetapkan oleh lelaran masa hadapan Untuk menilai keberkesanan gelung nyahpepijat, set data soalan Quora telah digunakan pada RoBERTa -Large telah diperhalusi untuk mengesan sama ada dua soalan adalah pendua dan juga diperhalusi menggunakan set data Stanford Sentiment Treebank (SST) untuk analisis sentimen positif/neutral/negatif.

Didapati model garis dasar gagal mengenal pasti 22 daripada 53 topik QQP dan 11 daripada 39 topik emosi. Selepas itu, pengkaji mencipta data untuk membaiki tema tersebut. Ekstrak 50 contoh daripada data mengenai topik ini dan jalankan gelung penyahpepijatan dengan AdaTest Pada set data QQP, purata 41.6 ujian dilakukan dan pada set data sentimen, purata 55.8 ujian dilakukan.

Hasilnya menunjukkan bahawa dalam kebanyakan kes, AdaTest membaiki soalan yang digunakan untuk latihan dan beberapa soalan tersimpan yang tidak kelihatan tanpa memusnahkan sebarang soalan, manakala data Senarai Semak asal sering memperkenalkan ralat baharu, dengan itu Musnahkan soalan ujian lain. Para penyelidik juga menilai keberkesanan AdaTest dalam persekitaran pembangunan standard. Selepas tiga bulan pembangunan, ujian Senarai Semak dan penambahan data ad hoc berdasarkan GPT-3, skor F1 ialah 0.66 (daripada 1.00) pada data ghaib yang dikumpul di alam liar.

Pasukan yang sama menggunakan AdaTest mencapai skor F1 0.77 pada set data ghaib yang sama selepas menjalankan gelung nyahpepijat sendiri selama empat jam. Markah ini kemudiannya direplikasi pada set data kedua yang tidak kelihatan, menunjukkan bahawa AdaTest boleh melakukan pembetulan pepijat dan mencapai hasil yang lebih baik dalam kawasan yang kaedah tradisional gagal.

Orang ramai menyediakan spesifikasi masalah yang kekurangan model bahasa, manakala model bahasa menyediakan ujian berkualiti tinggi pada skala dan skop yang lebih besar, dan menyambung ujian dan penyahpepijatan model untuk membetulkan ralat dengan berkesan dan membolehkan pembangunan model Selangkah lebih dekat kepada sifat berulang pembangunan perisian tradisional.

Kerjasama antara manusia dan AI mewakili hala tuju masa depan untuk pembangunan pembelajaran mesin. Diharapkan kerjasama ini akan terus bertambah baik apabila keupayaan model bahasa berskala besar terus berkembang.

Atas ialah kandungan terperinci Tidakkah model NLP boleh membaca bahasa manusia? Microsoft AdaTest menjadikan pencarian kesalahan lima kali lebih cekap. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI