Rumah >Peranti teknologi >AI >Semakan sistematik pembelajaran peneguhan mendalam pra-latihan, penyelidikan dalam talian dan luar talian sudah memadai.

Semakan sistematik pembelajaran peneguhan mendalam pra-latihan, penyelidikan dalam talian dan luar talian sudah memadai.

- 王林ke hadapan

- 2023-04-09 11:31:031804semak imbas

Dalam beberapa tahun kebelakangan ini, pembelajaran pengukuhan (RL) telah berkembang pesat, didorong oleh pembelajaran mendalam Pelbagai kejayaan dalam bidang daripada permainan kepada robotik telah merangsang minat orang ramai dalam mereka bentuk algoritma dan sistem RL berskala besar. Walau bagaimanapun, penyelidikan RL sedia ada secara amnya membolehkan ejen belajar dari awal apabila berhadapan dengan tugasan baharu, menjadikannya sukar untuk menggunakan pengetahuan sedia ada yang telah diperoleh untuk membantu membuat keputusan, mengakibatkan overhed pengiraan yang tinggi.

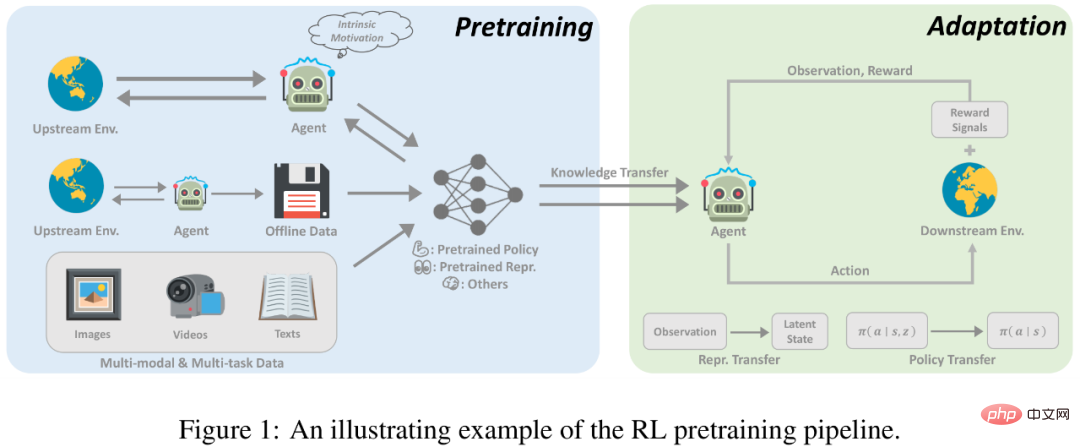

Dalam bidang pembelajaran yang diselia, paradigma pra-latihan telah disahkan sebagai cara yang berkesan untuk mendapatkan pengetahuan sedia ada yang boleh dipindahkan Dengan pra-latihan pada set data berskala besar, rangkaian model boleh menyesuaikan diri dengan pantas kepada tugas hiliran yang berbeza. Idea serupa juga telah dicuba dalam RL, terutamanya penyelidikan baru-baru ini mengenai ejen "generalis" [1, 2], yang membuatkan orang tertanya-tanya sama ada sesuatu seperti GPT-3 [3] juga boleh dilahirkan dalam bidang RL Universal pra-latihan model.

Walau bagaimanapun, penerapan pra-latihan dalam bidang RL menghadapi banyak cabaran, seperti perbezaan yang ketara antara tugas huluan dan hiliran, cara mendapatkan dan menggunakan data pra-latihan dengan cekap, dan cara menggunakan pengetahuan sedia ada Isu-isu seperti pemindahan yang berkesan menghalang kejayaan penerapan paradigma pra-latihan dalam RL. Pada masa yang sama, terdapat perbezaan besar dalam tetapan eksperimen dan kaedah yang dipertimbangkan dalam kajian terdahulu, yang menyukarkan penyelidik untuk mereka bentuk model pra-latihan yang sesuai dalam senario kehidupan sebenar.

Untuk menyelesaikan pembangunan pra-latihan dalam bidang RL dan kemungkinan arah pembangunan masa depan, Penyelidik dari Universiti Shanghai Jiao Tong dan Tencent menulis semak semula untuk membincangkan kaedah subbahagian Pra-latihan RL sedia ada di bawah tetapan dan masalah yang berbeza untuk diselesaikan .

Alamat kertas: https://arxiv.org/pdf/2211.03959.pdf

Pengenalan kepada pra-latihan RL

Pembelajaran pengukuhan (RL) menyediakan bentuk matematik umum untuk membuat keputusan berurutan. Melalui algoritma RL dan rangkaian neural dalam, ejen yang dipelajari dalam cara yang dipacu data dan mengoptimumkan fungsi ganjaran tertentu telah mencapai prestasi melebihi prestasi manusia dalam pelbagai aplikasi dalam bidang yang berbeza. Walau bagaimanapun, walaupun RL telah terbukti berkesan dalam menyelesaikan tugasan tertentu, kecekapan sampel dan kebolehan generalisasi masih menjadi dua halangan utama yang menghalang penggunaan RL dalam dunia nyata. Dalam penyelidikan RL, paradigma standard adalah untuk ejen belajar daripada pengalaman yang dikumpul sendiri atau orang lain, mengoptimumkan rangkaian saraf melalui pemulaan rawak untuk satu tugas. Sebaliknya, bagi manusia, pengetahuan terdahulu tentang dunia sangat membantu proses membuat keputusan. Sekiranya tugas itu berkaitan dengan tugasan yang dilihat sebelum ini, manusia cenderung menggunakan semula pengetahuan yang telah dipelajari untuk menyesuaikan diri dengan cepat dengan tugasan baharu tanpa belajar dari awal. Oleh itu, berbanding dengan manusia, ejen RL mengalami kecekapan data yang rendah dan terdedah kepada overfitting.

Walau bagaimanapun, kemajuan terkini dalam bidang pembelajaran mesin yang lain secara aktif menyokong memanfaatkan pengetahuan sedia ada yang dibina daripada pra-latihan berskala besar. Dengan melatih secara berskala pada julat data yang luas, model asas yang besar boleh disesuaikan dengan cepat kepada pelbagai tugas hiliran. Paradigma pralatihan-penalaan ini telah terbukti berkesan dalam bidang seperti penglihatan komputer dan pemprosesan bahasa semula jadi. Walau bagaimanapun, pra-latihan tidak memberi kesan yang ketara kepada bidang RL. Walaupun pendekatan ini menjanjikan, prinsip reka bentuk untuk pralatihan RL berskala besar menghadapi banyak cabaran. 1) Kepelbagaian domain dan tugas; 2) Sumber data yang terhad 3) Penyesuaian pantas terhadap kesukaran menyelesaikan tugasan hiliran. Faktor-faktor ini timbul daripada ciri-ciri yang wujud dalam RL dan memerlukan pertimbangan khusus oleh penyelidik.

Pra-latihan mempunyai potensi besar untuk RL, dan kajian ini boleh menjadi titik permulaan bagi mereka yang berminat ke arah ini. Dalam artikel ini, penyelidik cuba menjalankan semakan sistematik terhadap kerja pra-latihan sedia ada pada pembelajaran peneguhan mendalam.

Dalam beberapa tahun kebelakangan ini, pra-latihan pembelajaran peneguhan mendalam telah mengalami beberapa kejayaan. Pertama, pra-latihan berdasarkan demonstrasi pakar, yang menggunakan pembelajaran diselia untuk meramalkan tindakan yang diambil oleh pakar, telah digunakan pada AlphaGo. Dalam mengejar pra-latihan berskala besar yang kurang diawasi, bidang RL tanpa pengawasan telah berkembang dengan pesat, yang membolehkan ejen belajar daripada interaksi dengan persekitaran tanpa isyarat ganjaran. Di samping itu, perkembangan pesat pembelajaran pengukuhan luar talian (RL luar talian) telah mendorong penyelidik untuk mempertimbangkan lagi cara menggunakan data luar talian yang tidak berlabel dan sub-optimum untuk pra-latihan. Akhir sekali, kaedah latihan luar talian berdasarkan data berbilang tugas dan berbilang modal terus membuka jalan kepada paradigma pra-latihan umum.

Pralatihan dalam talian

Kejayaan RL sebelum ini dicapai dengan fungsi ganjaran yang padat dan direka dengan baik. Paradigma RL tradisional, yang telah mencapai kemajuan besar dalam banyak bidang, menghadapi dua cabaran utama apabila berskala kepada pra-latihan berskala besar. Pertama, ejen RL mudah dipasang, dan sukar bagi ejen yang telah dilatih dengan ganjaran tugas yang kompleks untuk mencapai prestasi yang baik pada tugas yang tidak pernah mereka lihat sebelum ini. Di samping itu, mereka bentuk fungsi ganjaran biasanya sangat mahal dan memerlukan banyak pengetahuan pakar, yang tidak diragukan lagi merupakan cabaran besar dalam amalan.

Pralatihan dalam talian tanpa isyarat ganjaran boleh menjadi penyelesaian yang tersedia untuk mempelajari pengetahuan sedia ada am dan isyarat diawasi tanpa penglibatan manusia. Pra-latihan dalam talian bertujuan untuk memperoleh pengetahuan sedia ada melalui interaksi dengan alam sekitar tanpa pengawasan manusia. Dalam fasa pra-latihan, ejen dibenarkan berinteraksi dengan persekitaran untuk jangka masa yang lama tetapi tidak boleh menerima ganjaran ekstrinsik. Penyelesaian ini, juga dikenali sebagai RL tanpa pengawasan, telah dikaji secara aktif oleh penyelidik dalam beberapa tahun kebelakangan ini.

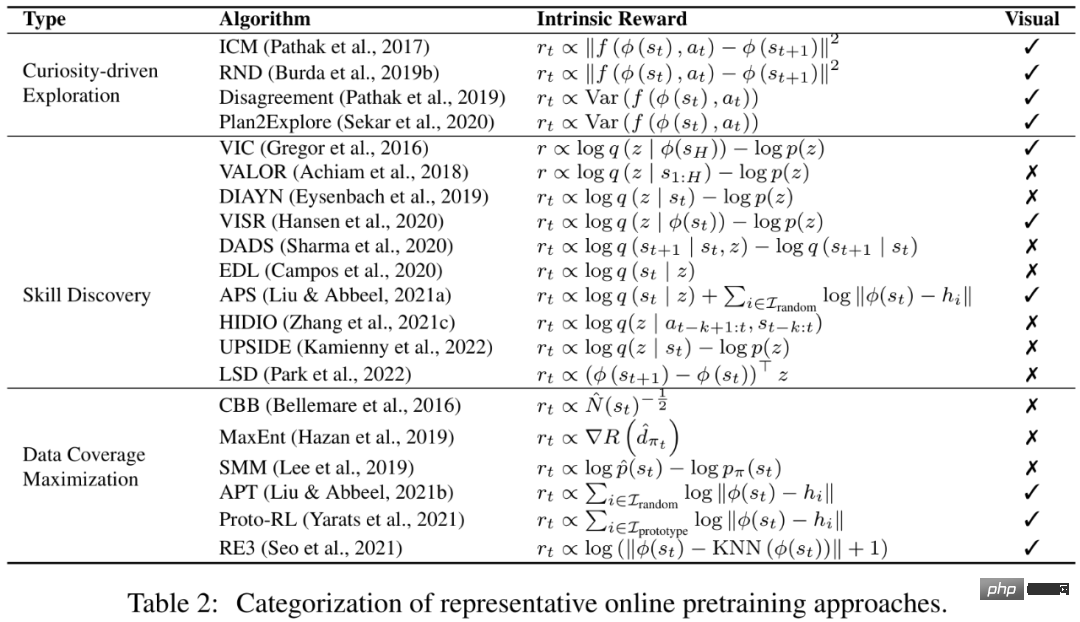

Untuk mendorong ejen memperoleh pengetahuan sedia ada daripada persekitaran tanpa sebarang isyarat penyeliaan, kaedah matang adalah untuk mereka bentuk ganjaran intrinsik untuk ejen untuk menggalakkan Ejen mereka bentuk mekanisme ganjaran sewajarnya dengan mengumpul pelbagai pengalaman atau menguasai kemahiran boleh dipindahkan. Penyelidikan terdahulu telah menunjukkan bahawa ejen boleh dengan cepat menyesuaikan diri dengan tugas hiliran melalui pralatihan dalam talian dengan ganjaran intrinsik dan algoritma RL standard.

Pra-latihan luar talian

Walaupun pra-latihan dalam talian boleh mencapai keputusan pra-latihan yang baik tanpa pengawasan manusia, Tetapi untuk besar -permohonan berskala, pra-latihan dalam talian masih terhad. Lagipun, interaksi dalam talian agak eksklusif antara satu sama lain dengan keperluan untuk melatih set data yang besar dan pelbagai. Untuk menyelesaikan masalah ini, orang ramai sering berharap untuk memisahkan pengumpulan data dan pautan pra-latihan dan terus menggunakan data sejarah yang dikumpul daripada ejen atau manusia lain untuk pra-latihan.

Penyelesaian yang mungkin adalah pembelajaran peneguhan luar talian. Tujuan pembelajaran peneguhan luar talian adalah untuk mendapatkan dasar RL memaksimumkan ganjaran daripada data luar talian. Cabaran asas ialah masalah anjakan pengedaran, iaitu perbezaan pengedaran antara data latihan dan data yang dilihat semasa ujian. Kaedah pembelajaran pengukuhan luar talian sedia ada memberi tumpuan kepada cara menyelesaikan cabaran ini apabila menggunakan anggaran fungsi. Sebagai contoh, kaedah kekangan dasar secara eksplisit memerlukan dasar yang dipelajari untuk mengelak daripada mengambil tindakan yang tidak dilihat dalam set data, dan kaedah penyelarasan nilai mengurangkan masalah anggaran berlebihan fungsi nilai dengan menyesuaikan fungsi nilai kepada beberapa bentuk sempadan bawah. Walau bagaimanapun, sama ada strategi yang dilatih di luar talian boleh digeneralisasikan kepada persekitaran baharu yang tidak dilihat dalam set data luar talian masih kurang diterokai.

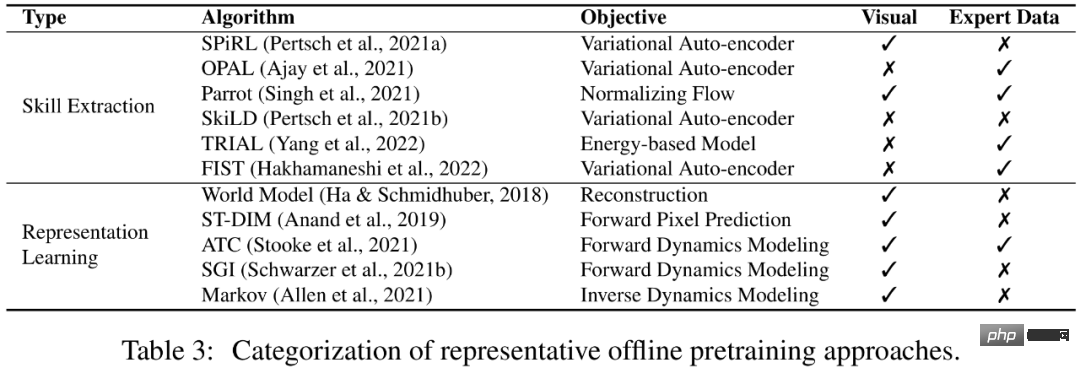

Mungkin, kita boleh mengelakkan pembelajaran dasar RL dan sebaliknya menggunakan data luar talian untuk mempelajari pengetahuan sedia ada yang bermanfaat kepada kelajuan penumpuan atau prestasi akhir tugasan hiliran. Lebih menarik lagi, jika model kami boleh memanfaatkan data luar talian tanpa pengawasan manusia, model itu berpotensi mendapat manfaat daripada jumlah data yang besar. Dalam makalah ini, penyelidik merujuk tetapan ini sebagai pra-latihan luar talian, dan ejen boleh mengekstrak maklumat penting (seperti perwakilan yang baik dan keutamaan tingkah laku) daripada data luar talian.

Ke arah ejen am

Kaedah pra-latihan dalam persekitaran tunggal dan modaliti tunggal terutamanya tertumpu pada pra Online yang disebutkan di atas -latihan dan tetapan pra-latihan luar talian, dan baru-baru ini, penyelidik dalam bidang itu semakin berminat untuk membina model membuat keputusan umum tunggal (cth., Gato [1] dan Multi-game DT [2]), menjadikan model yang sama model mampu mengendalikan tugasan modaliti yang berbeza dalam persekitaran yang berbeza. Untuk membolehkan ejen belajar daripada dan menyesuaikan diri dengan pelbagai tugas terbuka, penyelidikan berharap dapat memanfaatkan sejumlah besar pengetahuan sedia ada dalam bentuk yang berbeza, seperti persepsi visual dan pemahaman bahasa. Lebih penting lagi, jika penyelidik berjaya membina jambatan antara RL dan pembelajaran mesin dalam bidang lain, dan menggabungkan pengalaman kejayaan sebelumnya, mereka mungkin boleh membina model ejen am yang boleh menyelesaikan pelbagai tugas.

Atas ialah kandungan terperinci Semakan sistematik pembelajaran peneguhan mendalam pra-latihan, penyelidikan dalam talian dan luar talian sudah memadai.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI