Rumah >Peranti teknologi >AI >Mari kita bincangkan tentang pengecaman imej: Rangkaian Neural Berulang

Mari kita bincangkan tentang pengecaman imej: Rangkaian Neural Berulang

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-08 15:11:031734semak imbas

Artikel ini dicetak semula daripada akaun awam WeChat "Hidup dalam Era Maklumat" Pengarang hidup dalam era maklumat. Untuk mencetak semula artikel ini, sila hubungi akaun awam Living in the Information Age.

Rangkaian Neural Berulang (RNN) digunakan terutamanya untuk menyelesaikan masalah data jujukan. Sebab mengapa ia adalah rangkaian saraf berulang adalah bahawa output semasa jujukan juga berkaitan dengan output sebelumnya. Rangkaian RNN mengingati maklumat dari detik sebelumnya dan menggunakannya pada pengiraan keluaran semasa Tidak seperti rangkaian saraf konvolusi, neuron dalam lapisan tersembunyi rangkaian saraf berulang disambungkan antara satu sama lain ditentukan oleh input Output lapisan terdiri daripada output neuron tersembunyi pada saat sebelumnya. Walaupun rangkaian RNN telah mencapai beberapa keputusan yang luar biasa, ia mempunyai beberapa kekurangan dan batasan, seperti: kesukaran dalam latihan, ketepatan rendah, kecekapan rendah, masa yang lama, dll. Oleh itu, beberapa model rangkaian yang dipertingkatkan berdasarkan RNN telah dibangunkan secara beransur-ansur, seperti sebagai : Memori Jangka Pendek Panjang (LSTM), RNN dwiarah, LSTM dwiarah, GRU, dsb. Model RNN yang dipertingkatkan ini telah menunjukkan hasil yang cemerlang dalam bidang pengecaman imej dan digunakan secara meluas. Mengambil rangkaian LSTM sebagai contoh, kami akan memperkenalkan struktur rangkaian utamanya.

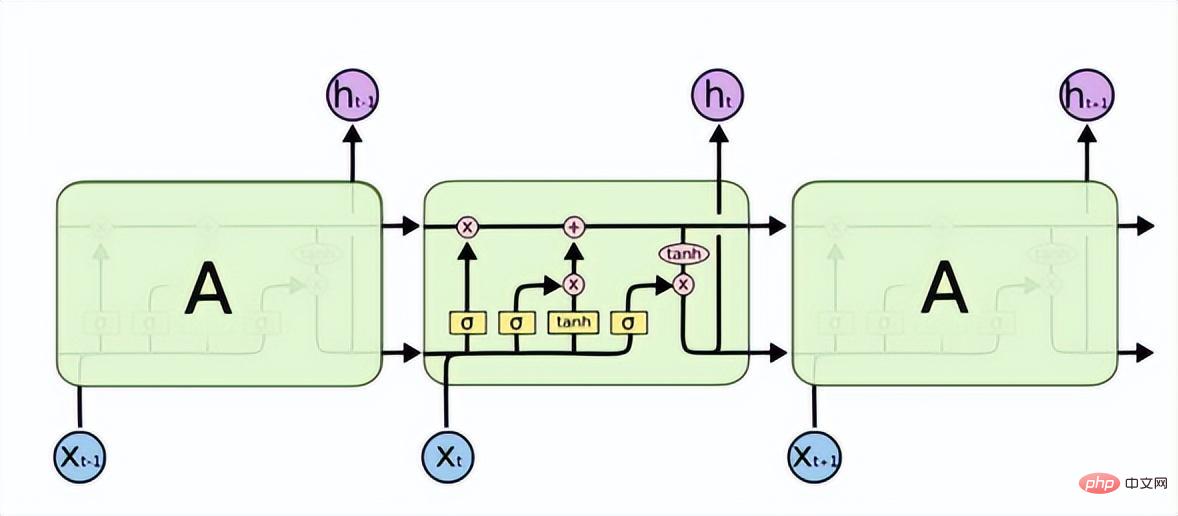

Memori Jangka Pendek Panjang (LSTM) menyelesaikan masalah kehilangan kecerunan atau letupan kecerunan dalam RNN dan boleh mempelajari masalah pergantungan jangka panjang. Strukturnya adalah seperti berikut.

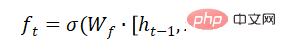

LSTM mempunyai tiga get untuk membolehkan maklumat melalui secara terpilih: get lupa, get input dan gate output. Gerbang lupa menentukan maklumat yang boleh melalui sel ini. Ia dilaksanakan melalui lapisan saraf sigmoid. Inputnya ialah, dan output ialah vektor dengan nilai antara (0, 1), mewakili bahagian setiap bahagian maklumat yang dibenarkan untuk dilalui. 0 bermaksud "jangan biarkan maklumat berlalu", 1 bermaksud "biar semua maklumat berlalu".

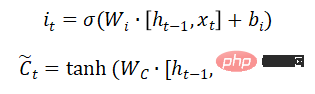

Gerbang input menentukan jumlah maklumat baharu yang ditambahkan pada keadaan sel Lapisan tanh menjana vektor, yang merupakan penggunaan alternatif untuk mengemas kini kandungan.

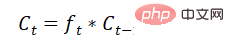

Kemas kini status sel:

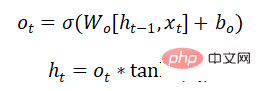

Ger keluar ialah sedang ditentukan Bahagian mana maklumat yang dikeluarkan:

Model rangkaian GRU juga menyelesaikan masalah kehilangan kecerunan atau letupan kecerunan dalam RNN, dan boleh belajar kebergantungan jangka panjang Hubungan ialah ubah bentuk LSTM Strukturnya lebih mudah daripada LSTM, mempunyai parameter yang lebih sedikit dan masa latihan lebih pendek daripada LSTM. Ia juga digunakan secara meluas dalam pengecaman pertuturan, penerangan imej, pemprosesan bahasa semula jadi dan senario lain.

Atas ialah kandungan terperinci Mari kita bincangkan tentang pengecaman imej: Rangkaian Neural Berulang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI