Rumah >Peranti teknologi >AI >Ahli bahasa telah kembali! Mula belajar dari 'sebutan': kali ini model AI perlu mengajar dirinya sendiri

Ahli bahasa telah kembali! Mula belajar dari 'sebutan': kali ini model AI perlu mengajar dirinya sendiri

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-08 12:44:25994semak imbas

Mencuba untuk menjadikan komputer memahami bahasa manusia sentiasa menjadi kesukaran yang tidak dapat diatasi dalam bidang kecerdasan buatan.

Model pemprosesan bahasa semula jadi awal biasanya menggunakan ciri reka bentuk buatan, memerlukan ahli bahasa khusus untuk menulis corak secara manual, bagaimanapun, hasil akhir tidak sesuai, malah penyelidikan AI jatuh ke musim sejuk.

Setiap kali saya memecat ahli bahasa, sistem pengecaman pertuturan menjadi lebih tepat.

Setiap kali saya memecat ahli bahasa, prestasi pengecam pertuturan meningkat.

——Frederick Jelinek

Dengan model statistik dan pra-skala besar latihan Selepas model dibina, pengekstrakan ciri tidak lagi diperlukan, tetapi anotasi data untuk tugasan tertentu masih diperlukan, dan masalah paling kritikal ialah: model terlatih masih tidak memahami bahasa manusia.

Jadi, patutkah kita bermula dari bentuk bahasa asal dan mengkaji semula: Bagaimanakah manusia memperoleh kebolehan berbahasa?

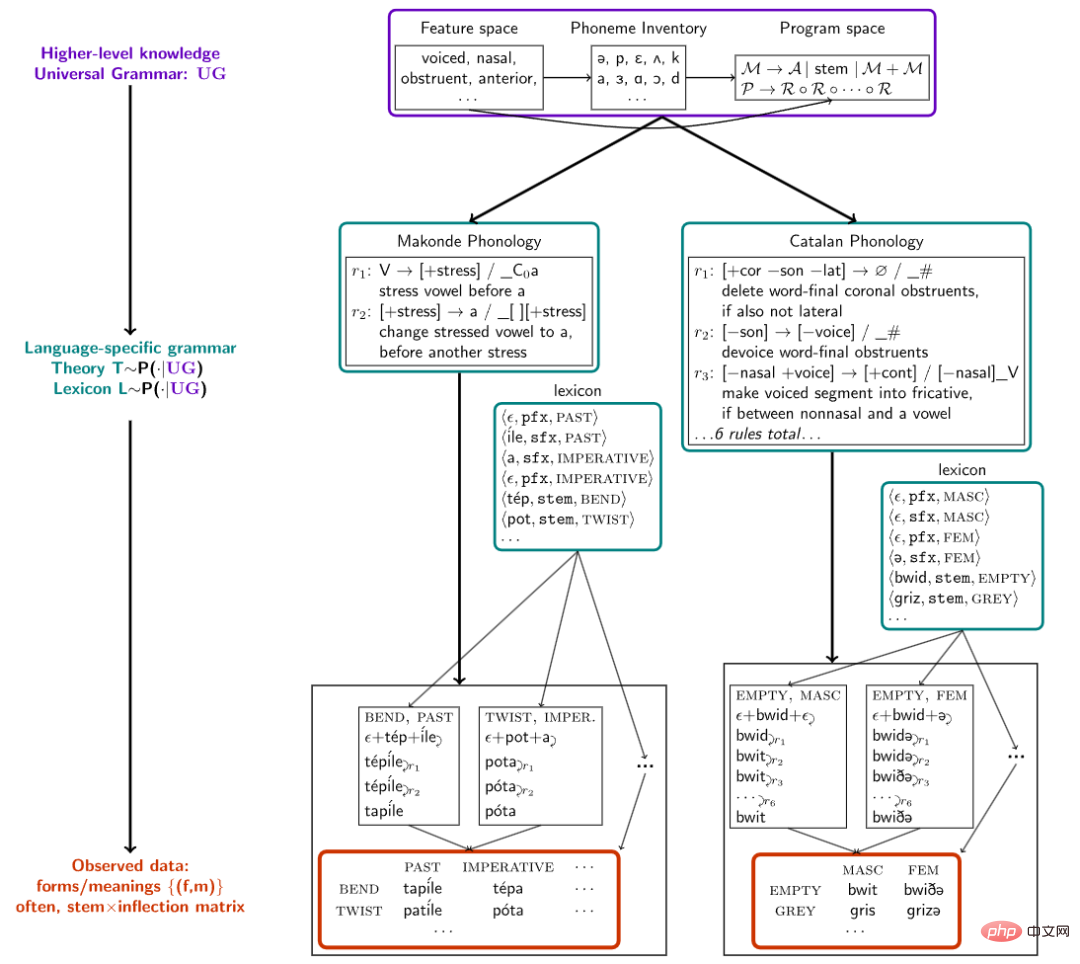

Baru-baru ini, penyelidik dari Universiti Cornell, MIT dan Universiti McGill menerbitkan kertas kerja dalam Nature Communications, mencadangkan rangka kerja untuk model sintesis algoritmik bahagian paling asas bahasa manusia Iaitu, morfo-fonologi mula mengajar AI untuk mempelajari bahasa dan membina morfologi bahasa secara langsung daripada bunyi.

Pautan kertas: https://www.nature.com/articles/s41467-022-32012-w

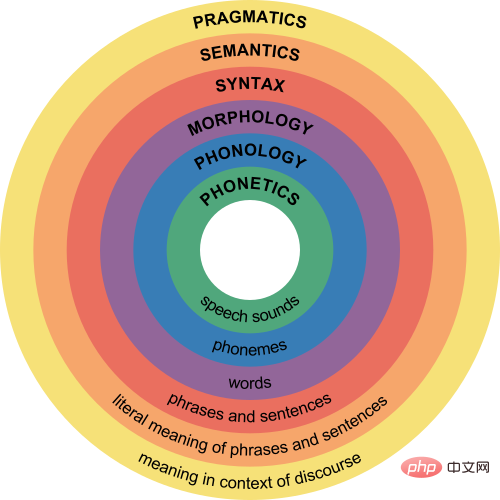

Morfologi dan fonologi ialah linguistik Salah satu cabang memberi tumpuan kepada perubahan bunyi yang berlaku apabila morfem (unit makna terkecil) digabungkan menjadi perkataan, dan cuba menyediakan satu siri peraturan untuk meramalkan perubahan bunyi biasa fonem dalam bahasa.

Sebagai contoh, morfem jamak dalam bahasa Inggeris ditulis sebagai -s atau -es, tetapi terdapat tiga sebutan [s], [z] dan [әz]. /, dan sebutan anjing ialah /dagz/, dan kuda disebut /hɔrsәz/.

Apabila manusia belajar untuk menukar sebutan jamak, mereka mula-mula menyedari bahawa akhiran jamak sebenarnya /z/ berdasarkan morfologi, kemudian berdasarkan fonologi, akhiran adalah berdasarkan fonologi dalam batang , seperti konsonan tidak bersuara, dsb. ditukar menjadi /s/ atau /әz/

Bahasa lain juga mempunyai peraturan fonemik dan morfologi yang sama daripada 58 bahasa 70 set data telah dikumpul, setiap satu mengandungi hanya berpuluh-puluh hingga ratusan perkataan dan hanya beberapa fenomena tatabahasa Percubaan menunjukkan bahawa kaedah mencari struktur tatabahasa dalam bahasa semula jadi juga boleh mensimulasikan proses pembelajaran bahasa bayi.

Dengan melakukan inferens Bayesian hierarki pada set data bahasa ini, penyelidik mendapati bahawa model itu boleh memperoleh peraturan morfofonemik baharu daripada hanya satu atau beberapa contoh, dan Dapat mengekstrak corak silang bahasa biasa dan menyatakannya dalam bentuk padat, bentuk yang boleh difahami manusia.

Biar model AI sebagai "ahli bahasa"

Kecerdasan manusia terutamanya dicerminkan dalam keupayaan untuk menubuhkan teori dunia kognitif Contohnya, selepas pembentukan bahasa semula jadi, ahli bahasa meringkaskan satu set peraturan untuk Membantu kanak-kanak mempelajari bahasa tertentu dengan lebih cepat, tetapi model AI semasa tidak boleh meringkaskan peraturan dan membentuk rangka kerja teori yang boleh difahami oleh orang lain.

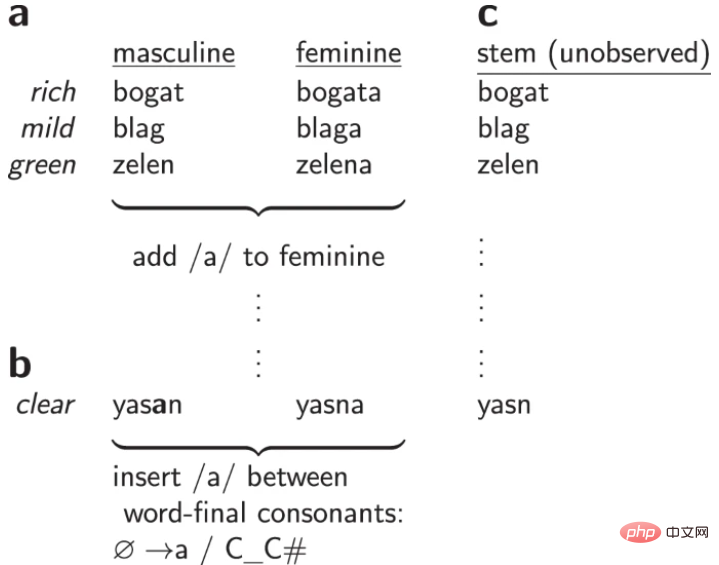

Sebelum membina model, kita perlu menyelesaikan masalah teras: "Bagaimana untuk menerangkan perkataan". perkataan.

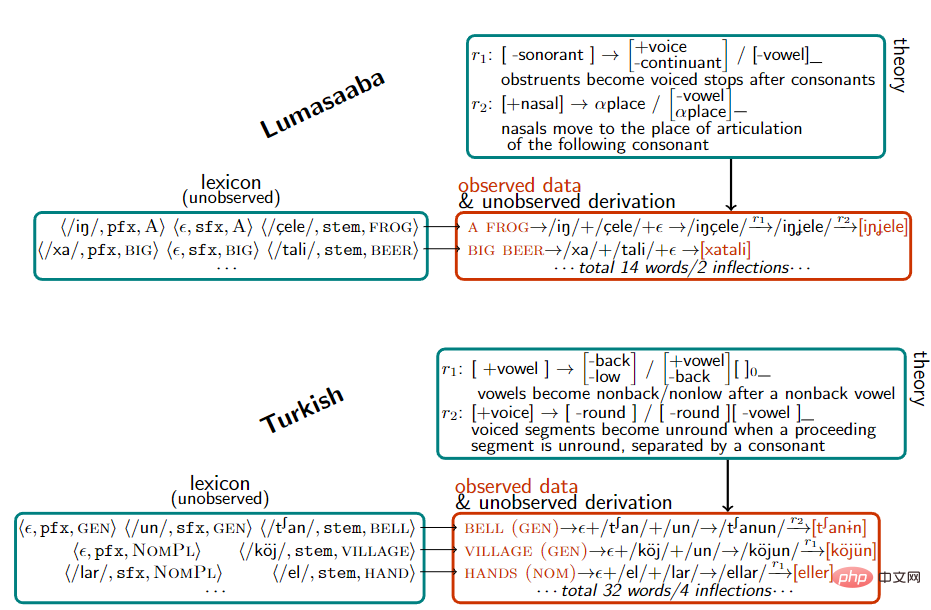

Apabila membina senarai perkataan, penyelidik menyatakan setiap perkataan sebagai pasangan , sebagai contoh, buka dinyatakan sebagai εn/, [stem: OPEN]>, kala lampau dinyatakan sebagai /, [tense: PAST]> dan gabungan buka dinyatakan sebagai εnd/, [stem: OPEN, [tense: PAST]]>

Selepas memiliki set data, penyelidik membina model untuk menerangkan penjanaan peraturan tatabahasa pada set set pasangan melalui inferens kebarangkalian posterior maksimum untuk menjelaskan perubahan perkataan.

Dalam perwakilan bunyi, fonem (bunyi atom) diwakili sebagai vektor ciri binari, seperti /m/, /n/, iaitu bunyi nasal, dan kemudian berdasarkan ruang ciri mentakrifkan peraturan pertuturan.

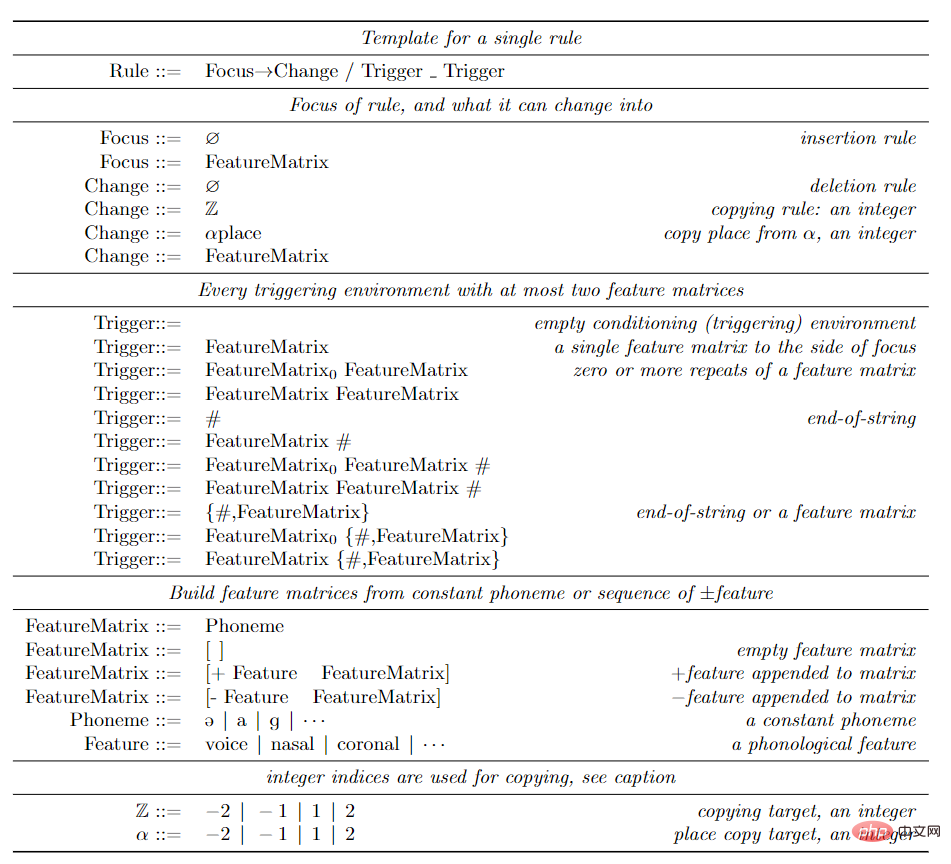

Penyelidik menggunakan kaedah ungkapan peraturan klasik, iaitu ingatan bergantung konteks, kadangkala juga dipanggil peraturan gaya SPE, yang digunakan secara meluas dalam perwakilan corak bunyi bahasa Inggeris.

Kaedah penulisan setiap peraturan ialah

(fokus)→(perubahan_struktur)/(left_trigger)_(right_trigger), yang bermaksud selagi persekitaran pencetus kiri/kanan hampir dengan kiri/kanan fokus, Fonem fokus akan ditukar mengikut perubahan struktur.

Persekitaran pencetus menentukan sambungan ciri (mewakili set fonem Contohnya, dalam bahasa Inggeris, asalkan fonem di sebelah kiri ialah [-sonorant]). , sebutan di hujung perkataan ialah Ia akan bertukar daripada /d/ kepada /t/, dan peraturan penulisan ialah [-sonorant] → [-voice]/[-voice -sonorant]_# Contohnya, selepas berjalan menggunakan peraturan ini, sebutan berubah daripada /wɔkd/ kepada /wɔkt/.

Apabila peraturan sedemikian dikekang untuk tidak digunakan secara kitaran pada keluaran mereka sendiri, peraturan dan leksikon sepadan dengan fungsi rasional 2 hala, yang seterusnya sepadan dengan penukar keadaan terhingga. Dihujahkan bahawa ruang penukar keadaan terhingga cukup ekspresif untuk merangkumi fenomena empirikal yang diketahui dalam morfofonetik dan mewakili had pada kuasa deskriptif penggunaan praktikal teori fonetik.

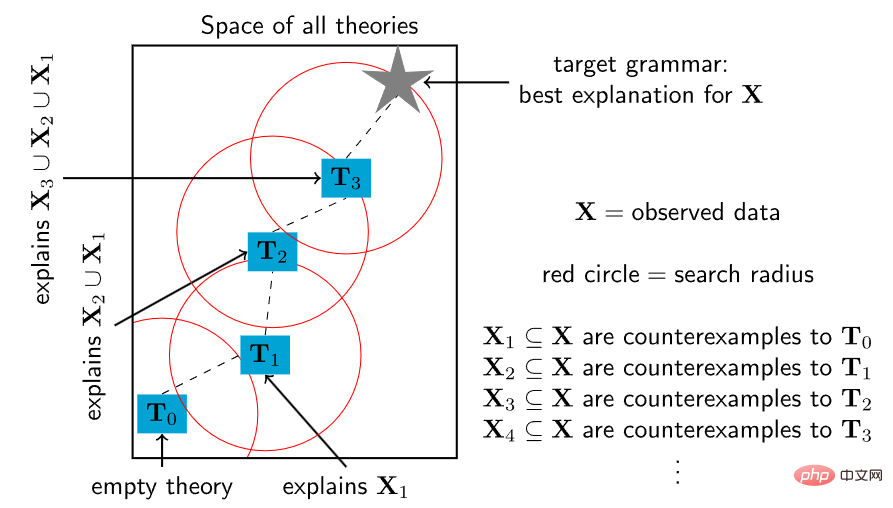

Untuk mempelajari tatabahasa ini, penyelidik menggunakan kaedah Pembelajaran Program Bayesian (BPL). Model setiap peraturan tatabahasa T sebagai program dalam bahasa pengaturcaraan yang menangkap kekangan khusus domain bagi ruang masalah. Struktur bahasa yang umum untuk semua bahasa dipanggil tatabahasa universal. Pendekatan ini boleh dilihat sebagai contoh moden pendekatan lama dalam linguistik dan menggunakan perwakilan generatif yang boleh difahami manusia untuk memformalkan tatabahasa universal.

Selepas mentakrifkan masalah yang perlu diselesaikan oleh BPL, ruang carian semua program adalah tidak terhingga, tiada panduan diberikan tentang cara menyelesaikan masalah ini, dan terdapat kekurangan. maklumat seperti Dalam kes pegun setempat yang dieksploitasi oleh algoritma pengoptimuman tempatan seperti keturunan kecerunan atau rantai Markov Monte Carlo, penyelidik menggunakan strategi sintesis program berasaskan kekangan untuk mengubah masalah pengoptimuman menjadi masalah kepuasan kekangan gabungan dan menggunakan kepuasan Boolean ( SAT) penyelesai untuk menyelesaikan.

Penyelesai ini melaksanakan carian yang menyeluruh tetapi agak cekap dan menjamin bahawa penyelesaian yang optimum akan ditemui dengan masa yang mencukupi. Tatabahasa terkecil yang konsisten dengan beberapa data boleh diselesaikan menggunakan pensintesis prosedur Lakaran, tetapi mesti mematuhi had atas saiz tatabahasa.

Tetapi dalam praktiknya, teknik carian menyeluruh yang digunakan oleh penyelesai SAT tidak boleh skala kepada sejumlah besar peraturan yang diperlukan untuk mentafsir korpora besar.

Untuk menskalakan penyelesai kepada teori yang besar dan kompleks, para penyelidik mengambil inspirasi daripada ciri asas kanak-kanak yang memperoleh bahasa dan saintis membina teori.

Kanak-kanak tidak belajar bahasa dalam sekelip mata, tetapi secara beransur-ansur memperkaya pemahaman mereka tentang tatabahasa dan perbendaharaan kata melalui peringkat pertengahan perkembangan bahasa. Begitu juga, teori saintifik yang kompleks boleh bermula dengan teras konsep yang mudah dan kemudian secara beransur-ansur berkembang untuk merangkumi peningkatan bilangan fenomena linguistik.

Berdasarkan idea di atas, penyelidik mereka bentuk algoritma sintesis program, bermula dari program kecil, dan kemudian berulang kali menggunakan penyelesai SAT untuk mencari titik pengubahsuaian kecil, supaya ia dapat menerangkan lebih banyak data . Secara khusus, cari contoh balas kepada teori semasa dan kemudian gunakan penyelesai untuk meneroka secara menyeluruh ruang semua pengubahsuaian kecil kepada teori yang boleh menampung contoh balas ini.

Tetapi kaedah heuristik ini tidak mempunyai jaminan integriti penyelesai SAT: walaupun ia berulang kali memanggil penyelesai SAT yang lengkap dan tepat, ia tidak menjamin untuk mencari penyelesaian yang optimum, tetapi setiap panggilan berulang adalah lebih baik daripada terus Mengoptimumkan keseluruhan data adalah banyak. lebih keras. Kerana mengekang setiap teori baharu untuk mendekati teori sebelumnya dalam ruang teori menghasilkan pengecutan polinomial masalah kepuasan kekangan, menjadikan masa carian secara eksponen lebih lama, dan penyelesai SAT secara eksponen lebih cepat dalam kes yang paling teruk.

Semasa fasa penilaian eksperimen, penyelidik mengumpul 70 soalan daripada buku teks linguistik, yang setiap satunya memerlukan analisis menyeluruh beberapa bentuk teori dalam bahasa semula jadi. Masalahnya berkisar dalam kesukaran dan merangkumi pelbagai jenis fenomena bahasa semula jadi.

Bahasa semula jadi juga pelbagai, termasuk bahasa tonal Contohnya, dalam Kerewe (bahasa Bantu di Tanzania), untuk mengira adalah /kubala/, tetapi untuk mengiranya adalah /kukíbála/, di mana tanda Stres. nada tinggi.

Terdapat juga bahasa dengan harmoni vokal Contohnya, Turki mempunyai /el/ dan /t∫an/, yang masing-masing mewakili tangan dan loceng, serta /el-ler/ dan /t∫. an-lar/ , masing-masing mewakili jamak tangan dan jam; terdapat banyak lagi fenomena linguistik, seperti bentuk asimilasi dan lanjutan.

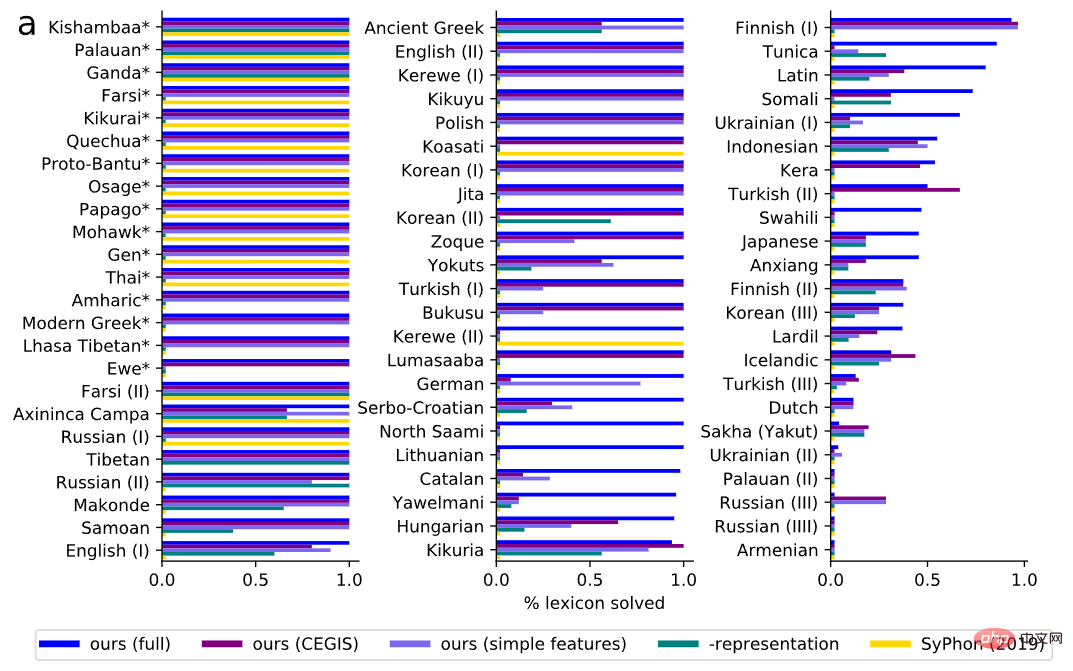

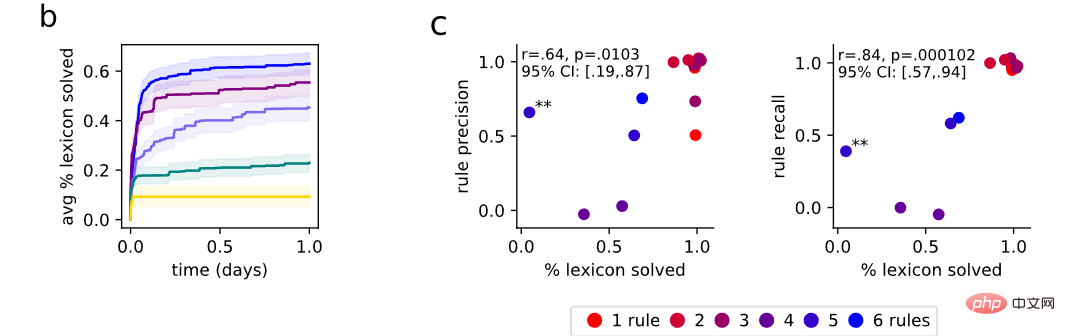

Dalam penilaian, kami terlebih dahulu mengukur keupayaan model untuk menemui perbendaharaan kata yang betul. Berbanding dengan perbendaharaan kata dasar-kebenaran, model mendapati tatabahasa yang sepadan dengan betul dengan keseluruhan perbendaharaan kata soalan dalam 60% penanda aras dan mentafsir dengan betul sebahagian besar perbendaharaan kata dalam 79% soalan.

Selalunya perbendaharaan kata yang betul untuk setiap soalan adalah lebih spesifik daripada peraturan yang betul, dan sebarang peraturan yang menghasilkan data lengkap daripada perbendaharaan kata yang betul mestilah konsisten dengan kemungkinan model untuk mencadangkan Mana-mana peraturan asas mempunyai kesetaraan pemerhatian. Oleh itu, konsistensi dengan leksikon kebenaran asas harus digunakan sebagai metrik untuk mengukur sama ada peraturan yang disegerakkan berkelakuan betul pada data, dan penilaian ini berkaitan dengan kualiti peraturan.

Untuk menguji hipotesis ini, penyelidik memilih 15 soalan secara rawak dan berunding dengan ahli bahasa profesional untuk menjaringkan peraturan yang ditemui. Ingat (perkadaran peraturan fonetik sebenar yang dipulihkan dengan betul) dan ketepatan (kadaran peraturan pulih yang benar-benar berlaku) diukur secara serentak. Di bawah penunjuk ketepatan dan ingat semula, boleh didapati bahawa ketepatan peraturan berkorelasi positif dengan ketepatan perbendaharaan kata.

Apabila sistem mendapat semua leksikon yang betul, ia jarang memperkenalkan peraturan yang tidak berkaitan (kepersisan tinggi) dan hampir selalu mendapat semua peraturan yang betul (Kadar ingatan tinggi).

Atas ialah kandungan terperinci Ahli bahasa telah kembali! Mula belajar dari 'sebutan': kali ini model AI perlu mengajar dirinya sendiri. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI