Peranti teknologi

Peranti teknologi AI

AI Buang 'clickbait', satu lagi karya sumber terbuka daripada pasukan Tsinghua!

Buang 'clickbait', satu lagi karya sumber terbuka daripada pasukan Tsinghua!Buang 'clickbait', satu lagi karya sumber terbuka daripada pasukan Tsinghua!

Sebagai seseorang yang menghadapi masalah menamakan, apa yang paling merisaukan saya tentang menulis esei di sekolah menengah ialah saya boleh menulis artikel yang bagus tetapi tidak tahu apa tajuknya Selepas saya mula membuat akaun awam, saya kalah banyak rambut setiap kali saya memikirkan tajuk.. ....

Baru-baru ini, saya akhirnya menemui cahaya "Name Waste" di GitHub, aplikasi menarik berskala besar dilancarkan oleh Universiti Tsinghua dan komuniti sumber terbuka OpenBMB: "Outsmart" "Tajuk", masukkan kandungan teks dan anda boleh menjana tajuk hangat dengan satu klik!

Ia berfungsi di luar kotak selepas mencubanya, apa yang boleh saya katakan ialah: baunya hebat!

Pengalaman dalam talian: https://live.openbmb.org/ant

GitHub: https://github.com/OpenBMB/CPM-Live

Mengenai artifak membuat tajuk ini, kita perlu bercakap tentangnya dahulu Mari kita bercakap tentang "ontologi" - model besar CPM-Ant.

CPM-Ant ialah model berpuluh bilion pertama di China yang dilatih secara langsung Latihan ini mengambil masa 68 hari dan telah selesai pada 5 Ogos 2022, dan dikeluarkan secara rasmi oleh OpenBMB!

- Lima Ciri Cemerlang

- Empat Terobosan Inovasi

- Proses latihan adalah kos rendah dan mesra alam!

- Perkara yang paling penting ialah - sumber terbuka sepenuhnya!

Sebagai model besar Cina latihan langsung yang pertama, CPM-Ant menyediakan penyelesaian yang boleh dilaksanakan dalam latihan model besar, penalaan halus, pemampatan, inferens, aplikasi dan lain-lain Pelan amali ini berharap dapat memberikan bantuan dan rujukan yang berbeza untuk pengikut yang berbeza.

Sekarang, mari kita lihat laporan kandungan hasil keluaran CPM-Ant!

Gambaran Keseluruhan Model

CPM-Ant ialah model bahasa pra-latihan Cina sumber terbuka dengan parameter 10B Ia juga merupakan pencapaian pertama dalam proses latihan langsung CPM-Live.

Keseluruhan proses latihan adalah kos rendah dan mesra alam Ia tidak memerlukan keperluan perkakasan yang tinggi dan kos operasi Ia berdasarkan kaedah penalaan delta dan telah mencapai keputusan yang cemerlang dalam penanda aras CUGE ujian.

Kod berkaitan CPM-Ant, fail log dan parameter model adalah sumber terbuka sepenuhnya di bawah perjanjian lesen terbuka. Sebagai tambahan kepada model penuh, OpenBMB juga menyediakan pelbagai versi termampat untuk disesuaikan dengan konfigurasi perkakasan yang berbeza.

Lima ciri cemerlang CPM-Ant:

(1) Kecekapan pengiraan

Dengan kit alat BMTrain[1], anda boleh menggunakan sepenuhnya keupayaan sumber pengkomputeran yang diedarkan untuk melatih model besar dengan cekap.

Latihan CPM-Ant berlangsung selama 68 hari dan menelan belanja 430,000 yuan, iaitu 1/20 daripada kira-kira AS$1.3 juta kos latihan model T5-11B oleh Google. Pelepasan gas rumah hijau latihan CPM-Ant adalah kira-kira 4872kg CO₂e, manakala pelepasan latihan T5-11B ialah 46.7t CO₂e[9].

(2) Prestasi cemerlang

Dengan alat OpenDelta[3], ia sangat mudah untuk melakukan incremental penalaan halus Sesuaikan CPM-Ant kepada tugas hiliran.

Percubaan menunjukkan bahawa CPM-Ant mencapai hasil terbaik pada 3/6 tugasan CUGE dengan hanya memperhalusi parameter 6.3M. Hasil ini mengatasi model lain yang diperhalusi sepenuhnya. Contohnya: bilangan parameter diperhalusi CPM-Ant hanyalah 0.06% daripada CPM2 (parameter 11B yang diperhalusi).

(3) Ekonomi penggunaan

Dengan bantuan kit alat BMCook[7] dan BInf[4], adalah mungkin untuk Memacu CPM-Ant di bawah sumber pengkomputeran terhad.

Berdasarkan BInf, ia boleh menggantikan kluster pengkomputeran untuk melaksanakan inferens model besar pada satu GPU (walaupun kad grafik gred pengguna seperti GTX 1060). Untuk menjadikan penggunaan CPM-Ant lebih menjimatkan, OpenBMB menggunakan BMCook untuk memampatkan lagi model 10B asal ke dalam versi yang berbeza. Model termampat (7B, 3B, 1B, 300M) boleh menyesuaikan diri dengan keperluan senario sumber rendah yang berbeza.

(4) Mudah digunakan

Sama ada model 10B asal atau versi termampat yang berkaitan, melalui beberapa baris kod Ia boleh dimuatkan dan dijalankan dengan mudah.

OpenBMB juga akan menambahkan CPM-Ant pada ModelCenter[8], menjadikan pembangunan model selanjutnya lebih mudah.

(5) Demokrasi Terbuka

Proses latihan CPM-Ant terbuka sepenuhnya.

OpenBMB menerbitkan semua kod, fail log dan arkib model sebagai akses terbuka. CPM-Ant juga mengguna pakai lesen terbuka yang membenarkan pengkomersilan.

Amalan latihan model besar yang lengkap

Untuk pengilang dan institusi penyelidikan yang mampu melakukan latihan model besar, proses latihan CPM-Ant menyediakan rekod Praktikal lengkap model besar Cina latihan.

OpenBMB mengeluarkan reka bentuk model, skema latihan, keperluan data dan kod pelaksanaan model siri CPM-Live. Berdasarkan seni bina model CPM-Live, adalah mungkin untuk mereka bentuk dan melaksanakan program latihan model besar dengan cepat dan mudah serta mengatur data perniagaan yang berkaitan untuk melengkapkan pra-penyelidikan model dan penyediaan data.

Tapak web rasmi merekodkan semua dinamik latihan semasa proses latihan, termasuk fungsi kehilangan, kadar pembelajaran, data yang dipelajari, daya pemprosesan, saiz kecerunan, keluk kos dan parameter dalaman model Min dan sisihan piawai dipaparkan dalam masa nyata Melalui dinamik latihan ini, pengguna boleh mendiagnosis dengan cepat sama ada terdapat masalah dalam proses latihan model.

Paparan masa nyata parameter dalaman latihan model

Selain itu, pelajar R&D OpenBMB mengemas kini ringkasan rekod latihan dalam masa nyata setiap hari Ringkasan termasuk nilai kehilangan, nilai kecerunan dan kemajuan keseluruhan Ia juga merekodkan beberapa masalah yang dihadapi dan pepijat semasa proses latihan, jadi bahawa pengguna boleh memahami proses latihan model terlebih dahulu pelbagai "pit" yang mungkin dihadapi.

Pada hari ketika latihan model "tenang", lelaki R&D itu juga akan mengeluarkan beberapa petikan terkenal, memperkenalkan beberapa kertas kerja terkini, dan juga melancarkan kuiz.

Aktiviti meneka dalam log

Selain itu, OpenBMB juga menyediakan penyelesaian latihan kos efektif Bagi perusahaan yang sebenarnya mempunyai keperluan latihan model yang besar, melalui teknologi pecutan latihan yang berkaitan, kos latihan telah dikurangkan ke tahap yang boleh diterima.

Menggunakan kit alat BMTrain[1], kos pengiraan untuk melatih berpuluh bilion model besar CPM-Ant hanyalah 430,000 yuan (kos semasa dikira berdasarkan harga awan awam , kos sebenar akan lebih rendah ), iaitu kira-kira 1/20 daripada anggaran luaran kos model besar 11B T5 sebanyak AS$1.3 juta!

Penyelesaian penalaan halus yang cekap yang telah berulang kali mencipta SOTA

Bagaimanakah CPM-Ant membantu kami menyesuaikan tugas hiliran?

Untuk penyelidik model besar, OpenBMB menyediakan penyelesaian penilaian prestasi model besar berdasarkan penalaan halus parameter yang cekap, yang memudahkan penyesuaian tugas hiliran pantas dan penilaian prestasi model.

Gunakan penalaan yang cekap parameter, yang dikenali sebagai penalaan delta, untuk menilai prestasi CPM-Ant pada enam tugasan hiliran. LoRA [2] digunakan dalam eksperimen, yang memasukkan dua matriks peringkat rendah boleh laras dalam setiap lapisan perhatian dan membekukan semua parameter model asal. Dengan menggunakan pendekatan ini, hanya 6.3M parameter diperhalusi setiap tugas, menyumbang hanya 0.067% daripada jumlah parameter.

Dengan bantuan OpenDelta[3], OpenBMB menjalankan semua percubaan tanpa mengubah suai kod model asal. Perlu diingat bahawa tiada kaedah penambahan data digunakan semasa menilai model CPM-Ant pada tugas hiliran. Keputusan percubaan ditunjukkan dalam jadual berikut:

Dapat dilihat bahawa dengan hanya memperhalusi beberapa parameter, model OpenBMB menunjukkan prestasi yang baik. pada tiga set data Prestasi telah melebihi CPM-2 dan Sumber 1.0.

Sesetengah tugasan (seperti LCSTS) mungkin sukar dipelajari apabila terdapat sangat sedikit parameter yang diperhalusi Proses latihan CPM-Live akan diteruskan dan prestasi pada setiap tugas juga akan terjejas lagi.

Pelajar yang berminat boleh melawati pautan GitHub di bawah untuk merasai pengalaman CPM-Ant dan OpenDelta terlebih dahulu, dan seterusnya meneroka keupayaan CPM-Ant pada tugasan lain!

https://github.com/OpenBMB/CPM-Live

Siri inferens mesra perkakasan kaedah

Prestasi model besar adalah menakjubkan, tetapi keperluan perkakasan yang tinggi dan kos operasi sentiasa menyusahkan ramai pengguna. Untuk pengguna model besar, OpenBMB menyediakan satu siri kaedah penggunaan mesra perkakasan, yang boleh menjalankan versi model yang berbeza dengan lebih mudah dalam persekitaran perkakasan yang berbeza.

Menggunakan kit alat BInf[4], CPM-Ant boleh dijalankan dalam persekitaran sumber yang rendah seperti satu kad 1060!

Selain itu, OpenBMB juga memampatkan CPM-Ant. Model mampat ini termasuk CPM-Ant-7B/3B/1B/0.3B. Kesemua saiz mampatan model ini boleh sepadan dengan saiz klasik model bahasa pra-latihan sumber terbuka sedia ada.

Memandangkan pengguna mungkin menjalankan pembangunan selanjutnya pada pusat pemeriksaan yang dikeluarkan, OpenBMB terutamanya menggunakan pemangkasan berstruktur bebas tugas untuk memampatkan CPM-Ant. Proses pemangkasan juga dilakukan secara beransur-ansur, iaitu dari 10B ke 7B, dari 7B ke 3B, dari 3B ke 1B, dan akhirnya dari 1B ke 0.3B.

Semasa proses pemangkasan khusus, OpenBMB akan melatih matriks topeng boleh dipelajari dinamik, dan kemudian menggunakan matriks topeng ini untuk memangkas parameter yang sepadan. Akhirnya, parameter dipangkas mengikut ambang matriks topeng, yang ditentukan berdasarkan sparsity sasaran. Untuk butiran lanjut mampatan, sila rujuk blog teknikal [5].

Jadual berikut menunjukkan keputusan pemampatan model:

Sekarang kandungan tegar sudah tamat , kemudian Bagaimanakah model besar boleh membantu kami "memilih tajuk"?

Aplikasi model besar yang menarik tanpa diduga

Berdasarkan CPM-Ant, semua pembangun dan peminat model besar boleh membangunkannya Aplikasi menyeronokkan teks yang menarik.

Untuk mengesahkan lagi keberkesanan model dan memberikan contoh, OpenBMB memperhalusi penjana tajuk hangat berdasarkan CPM-Ant untuk menunjukkan keupayaan model.

Anda hanya perlu menampal kandungan teks ke dalam kotak teks di bawah, klik untuk menjananya dan anda boleh mendapatkan tajuk menarik yang disediakan oleh model besar!

Tajuk artikel pertama laporan hasil CPM-Ant dijana oleh penjana

Demo ini akan terus digilap dan lebih banyak kesan khas akan ditambah pada masa hadapan untuk meningkatkan pengalaman pengguna

Pengguna yang berminat juga boleh menggunakan CPM-Ant untuk membina sendiri aplikasi paparan. Jika anda mempunyai sebarang idea aplikasi, memerlukan sokongan teknikal atau menghadapi sebarang masalah semasa menggunakan demo, anda boleh memulakan perbincangan di forum CPM-Live [6] pada bila-bila masa!

Pengeluaran CPM-Ant ialah pencapaian pertama CPM-Live, tetapi ia hanya fasa pertama latihan OpenBMB akan terus menjalankan satu siri latihan pada masa hadapan.

Perihal ringkas, sesi latihan seterusnya akan menambah ciri baharu seperti sokongan berbilang bahasa, input dan output berstruktur, dsb. Selamat datang semua untuk terus memberi perhatian!

Portal|Pautan projek

Alamat GitHub Projek:

https://github.com/OpenBMB/CPM - Langsung

Alamat pengalaman demo (akses PC sahaja):

https://live.openbmb.org/ant

Atas ialah kandungan terperinci Buang 'clickbait', satu lagi karya sumber terbuka daripada pasukan Tsinghua!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

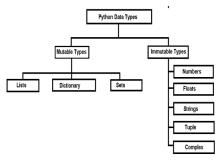

Mutable vs objek yang tidak berubah di Python - Analytics VidhyaApr 13, 2025 am 09:15 AM

Mutable vs objek yang tidak berubah di Python - Analytics VidhyaApr 13, 2025 am 09:15 AMPengenalan Python adalah bahasa pengaturcaraan berorientasikan objek (atau oops). Dalam artikel saya yang terdahulu, kami meneroka sifatnya yang serba boleh. Oleh kerana itu, Python menawarkan pelbagai jenis data, yang boleh diklasifikasikan secara meluas ke m

11 Saluran YouTube Untuk Belajar Tableau secara Percuma - Analytics VidhyaApr 13, 2025 am 09:14 AM

11 Saluran YouTube Untuk Belajar Tableau secara Percuma - Analytics VidhyaApr 13, 2025 am 09:14 AMPengenalan Tableau dianggap sebagai salah satu alat visualisasi data yang paling mantap yang sedang digunakan oleh syarikat dan individu di seluruh dunia untuk analisis dan pembentangan data yang cekap. Dengan antara muka mesra pengguna dan exten

10 Pelanjutan pengekodan AI generatif dalam kod vs yang mesti anda pelajariApr 13, 2025 am 01:14 AM

10 Pelanjutan pengekodan AI generatif dalam kod vs yang mesti anda pelajariApr 13, 2025 am 01:14 AMHei ada, pengekodan ninja! Apa tugas yang berkaitan dengan pengekodan yang anda telah merancang untuk hari itu? Sebelum anda menyelam lebih jauh ke dalam blog ini, saya ingin anda memikirkan semua kesengsaraan yang berkaitan dengan pengekodan anda-lebih jauh menyenaraikan mereka. Selesai? - Let ’

Memasak Inovasi: Bagaimana Kecerdasan Buatan Mengubah Perkhidmatan MakananApr 12, 2025 pm 12:09 PM

Memasak Inovasi: Bagaimana Kecerdasan Buatan Mengubah Perkhidmatan MakananApr 12, 2025 pm 12:09 PMAI Menambah Penyediaan Makanan Walaupun masih dalam penggunaan baru, sistem AI semakin digunakan dalam penyediaan makanan. Robot yang didorong oleh AI digunakan di dapur untuk mengautomasikan tugas penyediaan makanan, seperti membuang burger, membuat pizza, atau memasang SA

Panduan Komprehensif mengenai Python Namespaces & Variable ScopesApr 12, 2025 pm 12:00 PM

Panduan Komprehensif mengenai Python Namespaces & Variable ScopesApr 12, 2025 pm 12:00 PMPengenalan Memahami ruang nama, skop, dan tingkah laku pembolehubah dalam fungsi Python adalah penting untuk menulis dengan cekap dan mengelakkan kesilapan runtime atau pengecualian. Dalam artikel ini, kami akan menyelidiki pelbagai ASP

Panduan Komprehensif untuk Model Bahasa Visi (VLMS)Apr 12, 2025 am 11:58 AM

Panduan Komprehensif untuk Model Bahasa Visi (VLMS)Apr 12, 2025 am 11:58 AMPengenalan Bayangkan berjalan melalui galeri seni, dikelilingi oleh lukisan dan patung yang terang. Sekarang, bagaimana jika anda boleh bertanya setiap soalan dan mendapatkan jawapan yang bermakna? Anda mungkin bertanya, "Kisah apa yang anda ceritakan?

MediaTek meningkatkan barisan premium dengan Kompanio Ultra dan Dimensity 9400Apr 12, 2025 am 11:52 AM

MediaTek meningkatkan barisan premium dengan Kompanio Ultra dan Dimensity 9400Apr 12, 2025 am 11:52 AMMeneruskan irama produk, bulan ini MediaTek telah membuat satu siri pengumuman, termasuk Kompanio Ultra dan Dimensity 9400 yang baru. Produk ini mengisi bahagian perniagaan MediaTek yang lebih tradisional, termasuk cip untuk telefon pintar

Minggu ini di AI: Walmart menetapkan trend fesyen sebelum mereka pernah berlakuApr 12, 2025 am 11:51 AM

Minggu ini di AI: Walmart menetapkan trend fesyen sebelum mereka pernah berlakuApr 12, 2025 am 11:51 AM#1 Google melancarkan Agent2Agent Cerita: Ia Isnin pagi. Sebagai perekrut berkuasa AI, anda bekerja lebih pintar, tidak lebih sukar. Anda log masuk ke papan pemuka syarikat anda di telefon anda. Ia memberitahu anda tiga peranan kritikal telah diperolehi, dijadualkan, dan dijadualkan untuk

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

mPDF

mPDF ialah perpustakaan PHP yang boleh menjana fail PDF daripada HTML yang dikodkan UTF-8. Pengarang asal, Ian Back, menulis mPDF untuk mengeluarkan fail PDF "dengan cepat" dari tapak webnya dan mengendalikan bahasa yang berbeza. Ia lebih perlahan dan menghasilkan fail yang lebih besar apabila menggunakan fon Unicode daripada skrip asal seperti HTML2FPDF, tetapi menyokong gaya CSS dsb. dan mempunyai banyak peningkatan. Menyokong hampir semua bahasa, termasuk RTL (Arab dan Ibrani) dan CJK (Cina, Jepun dan Korea). Menyokong elemen peringkat blok bersarang (seperti P, DIV),

SecLists

SecLists ialah rakan penguji keselamatan muktamad. Ia ialah koleksi pelbagai jenis senarai yang kerap digunakan semasa penilaian keselamatan, semuanya di satu tempat. SecLists membantu menjadikan ujian keselamatan lebih cekap dan produktif dengan menyediakan semua senarai yang mungkin diperlukan oleh penguji keselamatan dengan mudah. Jenis senarai termasuk nama pengguna, kata laluan, URL, muatan kabur, corak data sensitif, cangkerang web dan banyak lagi. Penguji hanya boleh menarik repositori ini ke mesin ujian baharu dan dia akan mempunyai akses kepada setiap jenis senarai yang dia perlukan.

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

Dreamweaver Mac版

Alat pembangunan web visual