pembangunan bahagian belakang

pembangunan bahagian belakang Tutorial Python

Tutorial Python Rekod praktikal beberapa masalah dalam menyimpan dan memuatkan model pytorch

Rekod praktikal beberapa masalah dalam menyimpan dan memuatkan model pytorchRekod praktikal beberapa masalah dalam menyimpan dan memuatkan model pytorch

Artikel ini membawakan anda pengetahuan yang berkaitan tentang Python terutamanya memperkenalkan rekod praktikal tentang beberapa masalah dalam menyimpan dan memuatkan model pytorch. Saya harap ia dapat membantu semua orang. membantu.

[Cadangan berkaitan: Tutorial video Python3 ]

1. Cara menyimpan dan memuatkan model dalam obor

1. Simpan dan muatkan parameter model dan struktur model

torch.save(model,path) torch.load(path)

2. Hanya simpan dan muatkan parameter model - kaedah ini lebih selamat, tetapi lebih menyusahkan

torch.save(model.state_dict(),path) model_state_dic = torch.load(path) model.load_state_dic(model_state_dic)

2. Masalah dalam menyimpan dan memuatkan model dalam obor

1 Masalah dalam memuatkan struktur dan parameter model selepas menyimpannya dalam model kad tunggal

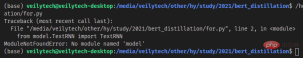

Struktur model akan ditakrifkan apabila model disimpan. laluan fail direkodkan, dan apabila memuatkan, ia akan dihuraikan mengikut laluan dan parameter akan dimuatkan selepas laluan fail definisi model diubah suai, ralat akan dilaporkan apabila menggunakan torch.load(path).

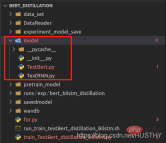

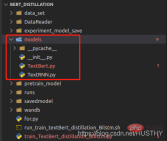

Selepas menukar folder model kepada model, ralat akan dilaporkan apabila memuatkan semula.

import torch from model.TextRNN import TextRNN load_model = torch.load('experiment_model_save/textRNN.bin') print('load_model',load_model)

Dengan cara ini untuk menyimpan struktur dan parameter model lengkap, pastikan anda tidak menukar laluan fail definisi model .

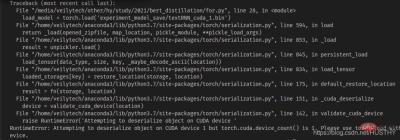

2. Selepas menyimpan model latihan kad tunggal pada mesin berbilang kad, ralat akan dilaporkan semasa memuatkannya pada mesin kad tunggal

Bermula dari 0 pada berbilang -mesin kad dengan berbilang kad grafik, model kini n>= Selepas menyimpan latihan kad grafik pada 1 dan memuatkan salinan pada mesin kad tunggal

import torch from model.TextRNN import TextRNN load_model = torch.load('experiment_model_save/textRNN_cuda_1.bin') print('load_model',load_model)

akan ada masalah ketidakpadanan peranti cuda - segmen kod modul yang anda simpan adalah kecil Jenis komponen menggunakan cuda1, jadi apabila ia dibuka menggunakan torch.load(), ia akan mencari cuda1 secara lalai, dan kemudian memuatkan model. kepada peranti. Pada masa ini, anda boleh terus menggunakan map_location untuk menyelesaikan masalah dan memuatkan model ke CPU.

load_model = torch.load('experiment_model_save/textRNN_cuda_1.bin',map_location=torch.device('cpu'))

3 Masalah yang berlaku selepas menyimpan struktur model dan parameter model latihan berbilang GPU dan kemudian memuatkannya

Apabila menggunakan berbilang GPU untuk melatih model pada masa yang sama. , sama ada struktur model dan parameter disimpan bersama atau Masalah akan berlaku jika anda menyimpan parameter model secara berasingan dan kemudian memuatkannya di bawah satu kad

a Simpan struktur model dan parameter bersama-sama dan kemudian memuatkan model

torch.distributed.init_process_group(backend='nccl')

Kaedah berbilang proses di atas digunakan semasa latihan, jadi anda mesti mengisytiharkannya semasa memuatkan, jika tidak ralat akan dilaporkan.

b. Menyimpan parameter model secara berasingan

model = Transformer(num_encoder_layers=6,num_decoder_layers=6) state_dict = torch.load('train_model/clip/experiment.pt') model.load_state_dict(state_dict)

juga akan menyebabkan masalah, tetapi masalahnya di sini ialah kunci kamus parameter berbeza daripada kunci yang ditakrifkan oleh model

Sebabnya di bawah latihan multi-GPU, apabila menggunakan latihan yang diedarkan, model tersebut akan dibungkus seperti berikut:

model = torch.load('train_model/clip/Vtransformers_bert_6_layers_encoder_clip.bin') print(model) model.cuda(args.local_rank) 。。。。。。 model = nn.parallel.DistributedDataParallel(model,device_ids=[args.local_rank],find_unused_parameters=True) print('model',model)

Struktur model sebelum pembungkusan:

Model berpakej

mempunyai DistributedDataParallel dan modul di lapisan luar, jadi berat model adalah dimuatkan dalam persekitaran kad tunggal Apabila kekunci berat tidak konsisten.

3. Kaedah menyimpan dan memuatkan model yang betul

if gpu_count > 1:

torch.save(model.module.state_dict(),save_path)

else:

torch.save(model.state_dict(),save_path)

model = Transformer(num_encoder_layers=6,num_decoder_layers=6)

state_dict = torch.load(save_path)

model.load_state_dict(state_dict)Ini adalah paradigma yang lebih baik, dan tidak akan ada ralat dalam memuatkan.

[Cadangan berkaitan: Tutorial video Python3]

Atas ialah kandungan terperinci Rekod praktikal beberapa masalah dalam menyimpan dan memuatkan model pytorch. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Python: Permainan, GUI, dan banyak lagiApr 13, 2025 am 12:14 AM

Python: Permainan, GUI, dan banyak lagiApr 13, 2025 am 12:14 AMPython cemerlang dalam permainan dan pembangunan GUI. 1) Pembangunan permainan menggunakan pygame, menyediakan lukisan, audio dan fungsi lain, yang sesuai untuk membuat permainan 2D. 2) Pembangunan GUI boleh memilih tkinter atau pyqt. TKInter adalah mudah dan mudah digunakan, PYQT mempunyai fungsi yang kaya dan sesuai untuk pembangunan profesional.

Python vs C: Aplikasi dan kes penggunaan dibandingkanApr 12, 2025 am 12:01 AM

Python vs C: Aplikasi dan kes penggunaan dibandingkanApr 12, 2025 am 12:01 AMPython sesuai untuk sains data, pembangunan web dan tugas automasi, manakala C sesuai untuk pengaturcaraan sistem, pembangunan permainan dan sistem tertanam. Python terkenal dengan kesederhanaan dan ekosistem yang kuat, manakala C dikenali dengan keupayaan kawalan dan keupayaan kawalan yang mendasari.

Rancangan Python 2 jam: Pendekatan yang realistikApr 11, 2025 am 12:04 AM

Rancangan Python 2 jam: Pendekatan yang realistikApr 11, 2025 am 12:04 AMAnda boleh mempelajari konsep pengaturcaraan asas dan kemahiran Python dalam masa 2 jam. 1. Belajar Pembolehubah dan Jenis Data, 2.

Python: meneroka aplikasi utamanyaApr 10, 2025 am 09:41 AM

Python: meneroka aplikasi utamanyaApr 10, 2025 am 09:41 AMPython digunakan secara meluas dalam bidang pembangunan web, sains data, pembelajaran mesin, automasi dan skrip. 1) Dalam pembangunan web, kerangka Django dan Flask memudahkan proses pembangunan. 2) Dalam bidang sains data dan pembelajaran mesin, numpy, panda, scikit-learn dan perpustakaan tensorflow memberikan sokongan yang kuat. 3) Dari segi automasi dan skrip, Python sesuai untuk tugas -tugas seperti ujian automatik dan pengurusan sistem.

Berapa banyak python yang boleh anda pelajari dalam 2 jam?Apr 09, 2025 pm 04:33 PM

Berapa banyak python yang boleh anda pelajari dalam 2 jam?Apr 09, 2025 pm 04:33 PMAnda boleh mempelajari asas -asas Python dalam masa dua jam. 1. Belajar pembolehubah dan jenis data, 2. Struktur kawalan induk seperti jika pernyataan dan gelung, 3 memahami definisi dan penggunaan fungsi. Ini akan membantu anda mula menulis program python mudah.

Bagaimana Mengajar Asas Pengaturcaraan Pemula Komputer Dalam Kaedah Projek dan Masalah Dikemukakan Dalam masa 10 Jam?Apr 02, 2025 am 07:18 AM

Bagaimana Mengajar Asas Pengaturcaraan Pemula Komputer Dalam Kaedah Projek dan Masalah Dikemukakan Dalam masa 10 Jam?Apr 02, 2025 am 07:18 AMBagaimana Mengajar Asas Pengaturcaraan Pemula Komputer Dalam masa 10 jam? Sekiranya anda hanya mempunyai 10 jam untuk mengajar pemula komputer beberapa pengetahuan pengaturcaraan, apa yang akan anda pilih untuk mengajar ...

Bagaimana untuk mengelakkan dikesan oleh penyemak imbas apabila menggunakan fiddler di mana-mana untuk membaca lelaki-dalam-tengah?Apr 02, 2025 am 07:15 AM

Bagaimana untuk mengelakkan dikesan oleh penyemak imbas apabila menggunakan fiddler di mana-mana untuk membaca lelaki-dalam-tengah?Apr 02, 2025 am 07:15 AMCara mengelakkan dikesan semasa menggunakan fiddlerevery di mana untuk bacaan lelaki-dalam-pertengahan apabila anda menggunakan fiddlerevery di mana ...

Apa yang perlu saya lakukan jika modul '__builtin__' tidak dijumpai apabila memuatkan fail acar di Python 3.6?Apr 02, 2025 am 07:12 AM

Apa yang perlu saya lakukan jika modul '__builtin__' tidak dijumpai apabila memuatkan fail acar di Python 3.6?Apr 02, 2025 am 07:12 AMMemuatkan Fail Pickle di Python 3.6 Kesalahan Laporan Alam Sekitar: ModulenotFoundError: Nomodulenamed ...

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

Dreamweaver CS6

Alat pembangunan web visual