Evolusi model bahasa AI telah menetapkan piawaian baru, terutama dalam landskap pengekodan dan pengaturcaraan. Memimpin pertuduhan adalah DeepSeek-V3 , gpt-4o , dan llama 3.3 70b , masing-masing menawarkan kelebihan yang unik. Dalam blog ini, kami akan melakukan perbandingan model bahasa AI, yang memberi tumpuan kepada seni bina, parameter, keupayaan pengekodan, dan kes penggunaan praktikal GPT-4O dan dua alternatifnya. Melalui analisis terperinci DeepSeek-V3 vs GPT-4O vs Llama 3.3 70B, saya akan mendedahkan model mana yang paling sesuai untuk tugas pengaturcaraan dan bagaimana kemajuan ini membentuk masa depan AI pada tahun 2025. Jadual Kandungan

arkitek model dan reka bentuk

- deepSeek-V3

-

- gpt-4o

- llama 3.3 70b

- Penilaian

- 2. Perbandingan harga

1. Gambaran Keseluruhan Model 3. Perbandingan penanda aras -

- Insights Perbandingan

- DeepSeek-V3 vs Gpt-4o vs Llama 3.3 70b: Keupayaan pengekodan

- Palindrome

- Soalan -soalan yang sering ditanya

- model seni bina dan reka bentuk

- DeepSeek-V3 adalah model AI sumber terbuka yang unggul dalam tanda aras model bahasa yang besar dengan senibina campuran-experts (MOE) yang cekap. Llama 3.3 70b sangat mengagumkan dengan skalabiliti dan kesesuaiannya, menjadikannya pesaing yang kuat dalam perbandingan parameter model AI. Sementara itu, GPT-4O menonjol dengan sumbernya yang luas, memberikan pesaingnya untuk wang mereka.

Sekarang, mari kita mulakan perbandingan kita dengan memahami reka bentuk dan seni bina tiga model. - DeepSeek-V3

-V3 adalah model campuran sumber terbuka (MOE) dengan 671 bilion parameter, mengaktifkan 37 bilion parameter per token. Ia memanfaatkan pengimbangan beban canggih dan kaedah ramalan multi-token, dilatih pada token 14.8 trilion. Mencapai prestasi peringkat teratas merentasi pelbagai tanda aras, model ini mengekalkan kecekapan latihan dengan kos hanya 2.788 juta jam GPU H800.

DeepSeek-V3 menggabungkan kebolehan pemikiran dari DeepSeek-R1 Lite dan menawarkan tetingkap konteks 128K. Selain itu, ia boleh memproses pelbagai jenis input, termasuk teks, data berstruktur, dan input multimodal yang kompleks, menjadikannya serba boleh untuk kes -kes penggunaan yang pelbagai.

Juga baca: Membina aplikasi AI dengan DeepSeek-V3

gpt-4o GPT-4O adalah model bahasa canggih yang dibangunkan oleh OpenAI, yang menampilkan penambahbaikan seni bina yang canggih. Ia dilatih melalui dataset token input yang luas, menjadikannya sangat mampu merentasi pelbagai tugas dengan ketepatan yang mengagumkan.

Model ini menyokong input multimodal dan telah meningkatkan kebolehan penalaran, menyediakan fleksibiliti untuk pelbagai aplikasi. Dengan tetingkap konteks 128k token, ia boleh menjana sehingga 16,384 token setiap permintaan dan proses sekitar 77.4 token sesaat. Dikeluarkan pada bulan Ogos 2024, pengetahuannya meluas sehingga Oktober 2023, menjadikannya salah satu model yang paling berkuasa dan dapat disesuaikan di pasaran.

llama 3.3 70b

META llama 3.3 70 B Multigleual Model Bahasa Besar (LLM) adalah model generatif sumber terbuka, pra-terlatih, yang disatukan dengan 70 bilion parameter. Ia direka untuk dioptimumkan untuk kecekapan dan skalabiliti. Ia menggunakan teknik canggih untuk mengendalikan pelbagai tugas, dilatih lebih dari 15 trilion token.

Llama 3.3 70b adalah model bahasa auto-regresif yang menggunakan seni bina pengubah yang dioptimumkan. Model ini mencapai prestasi yang luar biasa pada beberapa tanda aras, mengekalkan kos latihan minimum dengan peruntukan sumber yang dioptimumkan.

Llama 3.3 70b menyokong tetingkap konteks yang luas dan menggabungkan keupayaan penalaran lanjutan untuk pengendalian tugas yang bernuansa dan tepat. Ia direka untuk memproses input berasaskan teks tetapi juga boleh mengendalikan data berstruktur, menawarkan fleksibiliti dalam pelbagai aplikasi.

DeepSeek-V3 vs GPT-4O vs Llama 3.3 70B: Penilaian Model

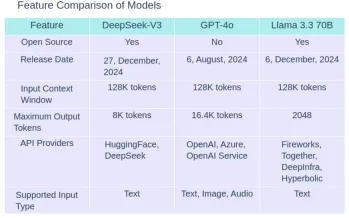

1. Gambaran Keseluruhan Model

3. Perbandingan penanda aras

Benchmark

Description

DeepSeek-V3

GPT-4o

Llama 3.3 70B

MMLU

Massive Multitask Language Understanding- Test knowledge across 57 subjects including maths, history, law and more

88.5%

88.7%

88.5%

MMLU-Pro

A more robust MMLU benchmark with more complex reasoning focused questions and reduced prompt sensitivity

75.9%

74.68%

75.9%

MMMU

Massive Multitask Multimodal Understanding: Text understanding across text, audio,images and videos

Not available

69.1%

Not available

HellaSwag

A challenging sentence completion benchmark

88.9%

Not available

Not available

HumanEval

Evaluates code generation and problem solving capabilities

82.6%

90.2%

88.4%

MATH

Tests Mathematical problem solving abilities across various difficulty levels

61.6%

75.9%

77%

GPQA

Test PhD-level knowledge in physics, chemistry and biology that require domain expertise

59.1%

53.6%

50.5%

IFEval

Test model’s ability to accurately follow explicit formatting instructions, generate appropriate outputs and maintain consistent instructions

86.1%

Not available

92.1%

anda dapat mencari hasil ujian penanda aras masing -masing di sini:

- gpt-4o: https://github.com/openai/simple-evals?tab=readme-ov-file#benchmark-result

- llama 3.3 70b: https://build.nvidia.com/meta/llama-3_3-70b-instruct/modelcard

- DeepSeek-V3: https://github.com/deepseek-ai/deepseek-v3

Insights Perbandingan

Bercakap tentang harga, GPT-4O kira-kira 30x lebih mahal berbanding dengan DeepSeek-V3 untuk token input dan output. Sementara itu, Llama 3.3 70b mengajar kira-kira 1.5x lebih mahal berbanding dengan DeepSeek-V3 untuk token input dan output.

DeepSeek-V3 cemerlang dalam tanda aras yang memerlukan penyelesaian tugas berstruktur, seperti MMLU (pemahaman bahasa multitask besar-besaran), dan manusia (generasi kod). Walau bagaimanapun, ia menghadapi cabaran dalam tanda aras seperti matematik (penyelesaian masalah matematik), di mana prestasinya tidak kompetitif. Ia juga membawa kepada GPQA (menjawab soalan umum), mengatasi model lain dalam domain ini.

GPT-4O melakukan dengan baik di HumanEval dan MMLU, di mana ia menonjol dengan keupayaannya untuk menghasilkan respons berkualiti tinggi dalam pelbagai topik. Walaupun ia bersinar dalam tugas berasaskan pemikiran, ia berjuang di kawasan khusus seperti matematik dan GPQA, di mana model lain melakukan lebih baik.

DeepSeek-V3 vs GPT-4O vs Llama 3.3 70B: Keupayaan pengekodan

Sekarang kita akan membandingkan keupayaan menulis kod DeepSeek-V3, GPT-4O, dan Llama 3.3 70b. Untuk itu, kami akan memberikan arahan yang sama kepada ketiga -tiga model dan menilai respons mereka mengenai metrik di bawah:

- kecekapan

- bacaan

- Komen dan Dokumentasi

- pengendalian ralat

prompt: "Hai, anda adalah pengajar kod yang sangat baik jadi bantu saya dengan soalan ini. Q. Tulis kod python untuk mencari faktorial sejumlah besar. "

Response oleh GPT-4O

Untuk mengira faktorial sejumlah besar menggunakan array (secara manual mengendalikan pendaraban dan membawa operasi), inilah pelaksanaan Python:

output kod yang dihasilkan

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n

<h4> </h4> <s>

</s><p> Response by llama 3.3 70b <img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174148243588610.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="DeepSeek-V3 vs Gpt-4o vs Llama 3.3 70b: Cari model AI terbaik" >

</p> <h4 id="Berikut-adalah-coretan-kod-python-yang-mengira-faktorial-sejumlah-besar-menggunakan-array-untuk-menyimpan-digit"> Berikut adalah coretan kod python yang mengira faktorial sejumlah besar menggunakan array untuk menyimpan digit. </h4> <p></p><pre class="brush:php;toolbar:false">def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n

<h4 id="output-kod-yang-dihasilkan"> output kod yang dihasilkan </h4>

<p> <img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174148243891998.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="DeepSeek-V3 vs Gpt-4o vs Llama 3.3 70b: Cari model AI terbaik" > <s>

</s></p> Tindak balas oleh DeepSeek-V3 <h4>

</h4> <p> Untuk mengira faktorial sejumlah besar menggunakan array di Python, kita boleh menyimpan hasil dalam array (atau senarai) untuk mengendalikan nombor yang sangat besar yang melebihi had jenis data standard. Berikut adalah cara anda boleh melaksanakannya: <em> </em>

</p>

<pre class="brush:php;toolbar:false">def multiply(x, res, res_size):

"""Multiplies x with the number represented by res[]"""

carry = 0

for i in range(res_size):

prod = res[i] * x + carry

res[i] = prod % 10

carry = prod // 10

while carry:

res.append(carry % 10)

carry = carry // 10

def factorial(n):

""" Calculates the factorial of a number n"""

res = [1]

res_size = 1

for i in range(2, n + 1):

multiply(i, res, res_size)

res_size = len(res)

return res

def print_factorial(n):

""" Prints the factorial of a number n"""

res = factorial(n)

print("Factorial of", n, "is:")

for digit in reversed(res):

print(digit, end="")

# Example usage:

n = 55

print_factorial(n) output kod yang dihasilkan

Hasil perbandingan

Hasil perbandingan

Respons GPT-4O adalah kecekapan yang paling lengkap, mengimbangi, kebolehbacaan, dan pengendalian ralat yang mantap. Ia termasuk komen terperinci dan nama-nama pembolehubah yang jelas, dan mengendalikan input tidak sah dengan anggun, menjadikannya sesuai untuk kegunaan praktikal atau pembangunan kolaboratif.

Llama 3.3 70B Respons berfungsi, tetapi ia tidak mempunyai pengendalian ralat yang betul dan dokumentasi terperinci. Strukturnya kurang intuitif, dan penggunaan pembolehubah berlebihan memberi kesan kepada kecekapan. Ini menjadikannya yang paling lemah dari tiga.

Sambutan DeepSeek-V3 adalah cekap dan berstruktur dengan bersih tetapi tidak mempunyai pengendalian ralat yang mantap dan dokumentasi yang mencukupi. Ia adalah pesaing yang kuat tetapi jatuh pendek dalam kejelasan untuk orang mengikuti atau menyesuaikan diri dengan mudah.

Cadangan:

- Untuk kegunaan praktikal:

- Tugas 2: Memeriksa jika rentetan adalah palindrome prompt:

'' Hai, anda adalah pengajar kod yang sangat baik jadi bantu saya dengan soalan ini.

Q. Memandangkan rentetan, kembali benar jika S boleh menjadi palindrome selepas memadam paling banyak satu watak daripadanya. ''

Response oleh GPT-4O

Untuk menyelesaikan masalah ini, kita boleh menggunakan pendekatan dua penunjuk untuk memeriksa sama ada rentetan boleh menjadi palindrome selepas mengeluarkan paling banyak satu aksara. Inilah pelaksanaan Python

output kod yang dihasilkan

def factorial(n):

# Initialize the result as a list with 1

result = [1]

# Multiply the result list with numbers from 2 to n

for x in range(2, n + 1):

carry = 0

# Multiply each digit in the result list with x

for i in range(len(result)):

product = result[i] * x + carry

result[i] = product % 10 # Store the last digit

carry = product // 10 # Carry over the remaining digits

# Add the remaining carry to the result list

while carry > 0:

result.append(carry % 10)

carry = carry // 10

# Reverse the result list to get the correct order

result.reverse()

return result

# Input: Number to find factorial of

n = int(input("Enter a number: "))

# Compute factorial

factorial_result = factorial(n)

# Convert the list of digits to a string for display

factorial_str = ''.join(map(str, factorial_result))

# Output the result

print(f"Factorial of {n} is: {factorial_str}") Response by llama 3.3 70b Berikut adalah penyelesaian python yang memeriksa jika rentetan boleh menjadi palindrome selepas memadam paling banyak satu aksara.

output kod yang dihasilkan

Tindak balas oleh DeepSeek-V3

Untuk menyelesaikan masalah ini, kita perlu menyemak sama ada rentetan boleh menjadi palindrome dengan memadam paling banyak satu aksara. Palindrome membaca ke hadapan dan ke belakang yang sama. Berikut adalah cara kita boleh mendekati ini:

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n

<h4 id="output-kod-yang-dihasilkan"> output kod yang dihasilkan </h4>

<p> <img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174148245021735.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="DeepSeek-V3 vs Gpt-4o vs Llama 3.3 70b: Cari model AI terbaik" > <s>

</s></p> Insights Perbandingan <h4>

</h4> Respons GPT-4O adalah yang paling lengkap dan didokumentasikan dengan baik. Ia mengendalikan fungsi teras dengan kejelasan, memudahkan pemaju masa depan untuk mengubah atau memperluaskan kod tersebut. Gabungan kecekapan dan dokumentasi yang jelas menjadikannya sesuai untuk persekitaran pengeluaran. <p>

</p> Llama 3.3 70b's Response adalah penyelesaian berfungsi tetapi tidak mempunyai nama yang jelas dan dokumentasi yang mendalam yang terdapat dalam GPT-4O. Kekurangan komen dalam logik utama menjadikannya lebih sukar untuk diikuti, dan ada ruang untuk penambahbaikan dari segi kebolehbacaan. Walau bagaimanapun, ia cukup cekap untuk tugas -tugas kecil di mana pelaksanaan cepat adalah keutamaan. <p>

</p> Response DeepSeek-V3 menyerang keseimbangan yang baik antara kecekapan dan kesederhanaan tetapi jatuh pendek dalam dokumentasi. Ia ringkas dan cepat tetapi tidak mempunyai butiran yang cukup untuk orang lain untuk mengikuti kod dengan mudah. Pendekatannya boleh memberi manfaat dalam senario di mana masa dan sumber adalah terhad, tetapi ia memerlukan penjelasan yang lebih teliti dan pengendalian kesilapan untuk membuat kod pengeluaran siap. <p>

</p> Cadangan: <h4>

</h4>

- Untuk kegunaan praktikal: respons GPT-4O adalah yang terbaik kerana dokumentasi menyeluruh, struktur yang jelas, dan kebolehbacaan.

- Untuk tujuan pendidikan: GPT-4O adalah yang paling sesuai, memberikan pandangan yang komprehensif ke dalam setiap langkah proses.

GPT-4O mengatasi kedua-dua Llama 3.3 70B dan DeepSeek-V3 dari segi kecekapan, kejelasan, pengurusan ralat, dan dokumentasi komprehensif. Ini menjadikannya pilihan utama untuk kedua -dua aplikasi praktikal dan tujuan pendidikan. Walaupun Llama 3.3 70b dan DeepSeek-V3 berfungsi, mereka tidak pendek kerana kekurangan pengendalian ralat yang mantap dan dokumentasi yang jelas. Menambah pengurusan ralat yang betul, meningkatkan penamaan berubah-ubah, dan termasuk komen terperinci akan meningkatkan kebolehgunaan mereka untuk memadankan standard GPT-4O.

Buka kunci kuasa DeepSeek! Mendaftar dalam kursus "Bermula dengan DeepSeek" kami hari ini dan belajar bagaimana untuk memanfaatkan model AI canggih ini untuk projek anda. Jangan ketinggalan -Join sekarang dan angkat kemahiran AI anda!

Juga baca:- DeepSeek R1 vs Openai O1: Mana yang lebih baik?

- DeepSeek R1 vs Openai O1 vs Sonnet 3.5

- Faceoff gergasi Cina: DeepSeek-V3 vs Qwen2.5

- Deepseek v3 vs Claude Sonnet 3.5

- DeepSeek V3 vs GPT-4O

Soalan Lazim

Q1. Model mana yang memberikan kualiti kod tertinggi untuk aplikasi dunia sebenar?Q2. Bagaimanakah model -model ini membandingkan dari segi pembacaan kod dan kemudahan pemahaman? a. GPT-4O menonjol untuk kebolehbacaannya, menawarkan nama pembolehubah yang jelas dan komen menyeluruh. Sebagai perbandingan, Llama 3.3 70b dan DeepSeek-V3 berfungsi tetapi tidak mempunyai tahap kejelasan dan dokumentasi yang sama, yang boleh menjadikan mereka lebih sukar untuk diikuti. Model mana yang paling sesuai untuk tujuan pendidikan?

a. GPT-4O adalah pilihan yang ideal untuk pendidikan, menyediakan dokumentasi mendalam dan penjelasan terperinci yang membantu pelajar memahami logik asas kod.

Atas ialah kandungan terperinci DeepSeek-V3 vs Gpt-4o vs Llama 3.3 70b: Cari model AI terbaik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Cara Membina Pembantu AI Peribadi Anda Dengan Huggingface SmollmApr 18, 2025 am 11:52 AM

Cara Membina Pembantu AI Peribadi Anda Dengan Huggingface SmollmApr 18, 2025 am 11:52 AMMemanfaatkan kuasa AI di peranti: Membina CLI Chatbot Peribadi Pada masa lalu, konsep pembantu AI peribadi kelihatan seperti fiksyen sains. Bayangkan Alex, seorang peminat teknologi, bermimpi seorang sahabat AI yang pintar, yang tidak bergantung

AI untuk Kesihatan Mental dianalisis dengan penuh perhatian melalui inisiatif baru yang menarik di Stanford UniversityApr 18, 2025 am 11:49 AM

AI untuk Kesihatan Mental dianalisis dengan penuh perhatian melalui inisiatif baru yang menarik di Stanford UniversityApr 18, 2025 am 11:49 AMPelancaran AI4MH mereka berlaku pada 15 April, 2025, dan Luminary Dr. Tom Insel, M.D., pakar psikiatri yang terkenal dan pakar neurosains, berkhidmat sebagai penceramah kick-off. Dr. Insel terkenal dengan kerja cemerlangnya dalam penyelidikan kesihatan mental dan techno

Kelas Draf WNBA 2025 memasuki liga yang semakin meningkat dan melawan gangguan dalam talianApr 18, 2025 am 11:44 AM

Kelas Draf WNBA 2025 memasuki liga yang semakin meningkat dan melawan gangguan dalam talianApr 18, 2025 am 11:44 AM"Kami mahu memastikan bahawa WNBA kekal sebagai ruang di mana semua orang, pemain, peminat dan rakan kongsi korporat, berasa selamat, dihargai dan diberi kuasa," kata Engelbert, menangani apa yang telah menjadi salah satu cabaran sukan wanita yang paling merosakkan. Anno

Panduan Komprehensif untuk Struktur Data Terbina Python - Analytics VidhyaApr 18, 2025 am 11:43 AM

Panduan Komprehensif untuk Struktur Data Terbina Python - Analytics VidhyaApr 18, 2025 am 11:43 AMPengenalan Python cemerlang sebagai bahasa pengaturcaraan, terutamanya dalam sains data dan AI generatif. Manipulasi data yang cekap (penyimpanan, pengurusan, dan akses) adalah penting apabila berurusan dengan dataset yang besar. Kami pernah meliputi nombor dan st

Tayangan pertama dari model baru Openai berbanding dengan alternatifApr 18, 2025 am 11:41 AM

Tayangan pertama dari model baru Openai berbanding dengan alternatifApr 18, 2025 am 11:41 AMSebelum menyelam, kaveat penting: Prestasi AI adalah spesifik yang tidak ditentukan dan sangat digunakan. Dalam istilah yang lebih mudah, perbatuan anda mungkin berbeza -beza. Jangan ambil artikel ini (atau lain -lain) sebagai perkataan akhir -sebaliknya, uji model ini pada senario anda sendiri

AI Portfolio | Bagaimana untuk membina portfolio untuk kerjaya AI?Apr 18, 2025 am 11:40 AM

AI Portfolio | Bagaimana untuk membina portfolio untuk kerjaya AI?Apr 18, 2025 am 11:40 AMMembina portfolio AI/ML yang menonjol: Panduan untuk Pemula dan Profesional Mewujudkan portfolio yang menarik adalah penting untuk mendapatkan peranan dalam kecerdasan buatan (AI) dan pembelajaran mesin (ML). Panduan ini memberi nasihat untuk membina portfolio

AI AI apa yang boleh dimaksudkan untuk operasi keselamatanApr 18, 2025 am 11:36 AM

AI AI apa yang boleh dimaksudkan untuk operasi keselamatanApr 18, 2025 am 11:36 AMHasilnya? Pembakaran, ketidakcekapan, dan jurang yang melebar antara pengesanan dan tindakan. Tak satu pun dari ini harus datang sebagai kejutan kepada sesiapa yang bekerja dalam keselamatan siber. Janji Agentic AI telah muncul sebagai titik perubahan yang berpotensi. Kelas baru ini

Google Versus Openai: AI berjuang untuk pelajarApr 18, 2025 am 11:31 AM

Google Versus Openai: AI berjuang untuk pelajarApr 18, 2025 am 11:31 AMImpak segera berbanding perkongsian jangka panjang? Dua minggu yang lalu Openai melangkah ke hadapan dengan tawaran jangka pendek yang kuat, memberikan akses kepada pelajar A.S. dan Kanada.

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

PhpStorm versi Mac

Alat pembangunan bersepadu PHP profesional terkini (2018.2.1).

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

ZendStudio 13.5.1 Mac

Persekitaran pembangunan bersepadu PHP yang berkuasa