Rumah >masalah biasa >MLOps: Cara Membina Kit Alat Untuk Meningkatkan Prestasi Projek AI

MLOps: Cara Membina Kit Alat Untuk Meningkatkan Prestasi Projek AI

- 百草asal

- 2024-09-04 13:35:57688semak imbas

Banyak projek AI yang dilancarkan dengan janji gagal untuk berlayar. Ini biasanya bukan kerana kualiti model pembelajaran mesin (ML). Pelaksanaan yang lemah dan integrasi sistem menyebabkan 90% projek. Organisasi boleh menyelamatkan usaha AI mereka. Mereka harus mengamalkan amalan MLOps yang mencukupi dan memilih set alat yang betul. Artikel ini membincangkan amalan dan alatan MLOps yang boleh menyelamatkan projek AI yang tenggelam dan meningkatkan projek yang mantap, yang berpotensi menggandakan kelajuan pelancaran projek.

Banyak projek AI yang dilancarkan dengan janji gagal belayar. Ini biasanya bukan kerana kualiti model pembelajaran mesin (ML). Pelaksanaan yang lemah dan penyepaduan sistem menyebabkan 90% projek. Organisasi boleh menyelamatkan usaha AI mereka. Mereka harus mengamalkan amalan MLOps yang mencukupi dan memilih set alat yang betul. Artikel ini membincangkan amalan dan alatan MLOps yang boleh menjimatkan projek AI yang tenggelam dan meningkatkan projek yang mantap, yang berpotensi menggandakan kelajuan pelancaran projek.

MLOps secara ringkas

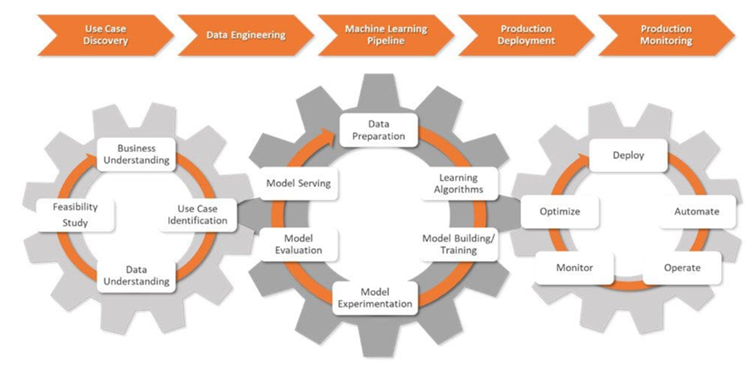

MLOps adalah gabungan pembangunan aplikasi pembelajaran mesin ( Dev) dan aktiviti operasi (Ops). Ia merupakan satu set amalan yang membantu mengautomasikan dan menyelaraskan penggunaan model ML. Akibatnya, keseluruhan kitaran hayat ML menjadi piawai.

MLOps adalah kompleks. Ia memerlukan keharmonian antara pengurusan data, pembangunan model dan operasi. Ia juga mungkin memerlukan anjakan dalam teknologi dan budaya dalam organisasi. Jika diterima pakai dengan lancar, MLOps membenarkan profesional mengautomasikan tugas yang membosankan, seperti pelabelan data, dan menjadikan proses penggunaan telus. Ia membantu memastikan data projek selamat dan mematuhi undang-undang privasi data.

Organisasi mempertingkat dan menskalakan sistem ML mereka melalui amalan MLOps. Ini menjadikan kerjasama antara saintis data dan jurutera lebih berkesan dan memupuk inovasi.

Tenun Projek AI Daripada Cabaran

Para profesional MLOps mengubah cabaran perniagaan mentah kepada matlamat pembelajaran mesin yang diperkemas dan boleh diukur. Mereka mereka bentuk dan mengurus saluran paip ML, memastikan ujian dan akauntabiliti menyeluruh sepanjang kitaran hayat projek AI.

Dalam fasa awal projek AI yang dipanggil penemuan kes guna, saintis data bekerjasama dengan perniagaan untuk menentukan masalah. Mereka menterjemahkannya ke dalam pernyataan masalah ML dan menetapkan objektif dan KPI yang jelas.

Seterusnya, saintis data bekerjasama dengan jurutera data. Mereka mengumpul data daripada pelbagai sumber, dan kemudian membersihkan, memproses dan mengesahkan data ini.

Apabila data sedia untuk pemodelan, saintis data mereka bentuk dan menggunakan saluran paip ML yang mantap, diintegrasikan dengan proses CI/CD. Saluran paip ini menyokong ujian dan percubaan serta membantu menjejak data, keturunan model dan KPI yang berkaitan merentas semua percubaan.

Dalam peringkat penggunaan pengeluaran , model ML digunakan dalam persekitaran yang dipilih: awan, di premis atau hibrid .

Saintis data memantau model dan infrastruktur, menggunakan metrik utama untuk mengesan perubahan dalam data atau prestasi model. Apabila mereka mengesan perubahan, mereka mengemas kini algoritma, data dan hiperparameter, mencipta versi baharu saluran paip ML. Mereka juga mengurus memori dan sumber pengkomputeran untuk memastikan model berskala dan berjalan dengan lancar.

Alat MLOps Meet AI Projects

Gambarkan seorang saintis data membangunkan aplikasi AI untuk meningkatkan proses reka bentuk produk pelanggan. Penyelesaian ini akan mempercepatkan fasa prototaip dengan menyediakan alternatif reka bentuk yang dijana AI berdasarkan parameter yang ditentukan.

Saintis data menavigasi melalui pelbagai tugas, daripada mereka bentuk rangka kerja kepada memantau model AI dalam masa nyata. Mereka memerlukan alat yang betul dan memahami cara menggunakannya pada setiap langkah.

Prestasi LLM yang Lebih Baik, Aplikasi AI yang Lebih Pintar

Inti kepada penyelesaian AI yang tepat dan boleh disesuaikan ialah pangkalan data vektor dan alatan utama ini untuk meningkatkan prestasi LLM:

Guardrails adalah pakej Python sumber terbuka yang membantu saintis data menambah struktur, jenis dan semakan kualiti pada output LLM. Ia secara automatik mengendalikan ralat dan mengambil tindakan, seperti menanya semula LLM, jika pengesahan gagal. Ia juga menguatkuasakan jaminan pada struktur dan jenis output, seperti JSON.

Saintis data memerlukan alat untuk pengindeksan, carian dan menganalisis set data yang besar. Di sinilah LlamaIndex melangkah masuk. Rangka kerja ini menyediakan keupayaan berkuasa untuk mengurus dan mengekstrak cerapan daripada repositori maklumat yang luas.

Rangka kerja DUST membolehkan aplikasi berkuasa LLM dibuat dan digunakan tanpa kod pelaksanaan . Ia membantu dengan introspeksi output model, menyokong penambahbaikan reka bentuk berulang dan menjejaki versi penyelesaian yang berbeza.

Jejaki Eksperimen dan Uruskan Metadata Model

Saintis data bereksperimen untuk lebih memahami dan menambah baik model ML dari semasa ke semasa. Mereka memerlukan alat untuk menyediakan sistem yang meningkatkan ketepatan dan kecekapan model berdasarkan hasil dunia sebenar.

MLflow ialah kuasa besar sumber terbuka, berguna untuk mengawasi keseluruhan kitaran hayat ML. Ia menyediakan ciri seperti penjejakan percubaan, versi model dan keupayaan penggunaan. Suite ini membolehkan saintis data log dan membandingkan percubaan, memantau metrik dan memastikan model dan artifak ML teratur.

Comet ML adalah platform untuk menjejak, membandingkan, menerangkan dan mengoptimumkan model ML dan eksperimen. Saintis data boleh menggunakan Comet ML dengan Scikit-learn, PyTorch, TensorFlow atau HuggingFace — ia akan memberikan cerapan untuk menambah baik model ML.

Amazon SageMaker merangkumi keseluruhan kitaran hayat pembelajaran mesin. Ia membantu melabel dan menyediakan data, serta membina, melatih dan menggunakan model ML yang kompleks. Menggunakan alat ini, saintis data menggunakan dan menskalakan model dengan pantas merentas pelbagai persekitaran.

Microsoft Azure ML ialah platform berasaskan awan yang membantu memperkemas aliran kerja pembelajaran mesin. Ia menyokong rangka kerja seperti TensorFlow dan PyTorch, dan ia juga boleh disepadukan dengan perkhidmatan Azure yang lain. Alat ini membantu saintis data dengan penjejakan percubaan, pengurusan model dan penggunaan.

DVC (kawalan versi data) adalah alat sumber terbuka yang bertujuan untuk mengendalikan set data yang besar dan eksperimen pembelajaran mesin. Alat ini menjadikan aliran kerja sains data lebih tangkas, boleh dihasilkan semula dan kolaboratif. DVC berfungsi dengan sistem kawalan versi sedia ada seperti Git, memudahkan cara saintis data menjejaki perubahan dan berkongsi kemajuan pada projek AI yang kompleks.

Optimumkan dan Urus Aliran Kerja ML

Saintis data perlukan aliran kerja yang dioptimumkan untuk mencapai proses yang lebih lancar dan lebih berkesan pada projek AI. Alat berikut boleh membantu:

Prefect ialah alat sumber terbuka moden yang digunakan oleh saintis data untuk memantau dan mengatur aliran kerja. Ringan dan fleksibel, ia mempunyai pilihan untuk mengurus saluran paip ML (Prefect Orion UI dan Prefect Cloud).

Metaflow ialah alat yang berkuasa untuk mengurus aliran kerja. Ia bertujuan untuk sains data dan pembelajaran mesin. Ia memudahkan tumpuan pada pembangunan model tanpa kerumitan kerumitan MLOps.

Kedro ialah alat berasaskan Python yang membantu saintis data memastikan projek boleh dihasilkan semula, modular dan mudah diselenggara. Ia menggunakan prinsip kejuruteraan perisian utama untuk pembelajaran mesin (modulariti, pengasingan kebimbangan dan versi). Ini membantu saintis data membina projek yang cekap dan berskala.

Urus Data dan Kawal Versi Saluran Paip

Aliran kerja ML memerlukan pengurusan data dan integriti saluran paip yang tepat. Dengan alatan yang betul, saintis data kekal di atas tugasan tersebut dan mengendalikan walaupun cabaran data yang paling kompleks dengan yakin.

Pachyderm membantu saintis data mengautomasikan transformasi data dan menawarkan ciri yang mantap untuk versi data, keturunan dan saluran paip hujung ke hujung. Ciri ini boleh berjalan dengan lancar pada Kubernetes. Pachyderm menyokong penyepaduan dengan pelbagai jenis data: imej, log, video, CSV dan berbilang bahasa (Python, R, SQL dan C/C ). Ia berskala untuk mengendalikan petabait data dan beribu-ribu kerja.

LakeFS ialah alat sumber terbuka yang direka untuk kebolehskalaan. Ia menambah kawalan versi seperti Git pada storan objek dan menyokong kawalan versi data pada skala exabait. Alat ini sesuai untuk mengendalikan tasik data yang luas. Saintis data menggunakan alat ini untuk mengurus tasik data dengan kemudahan yang sama seperti mereka mengendalikan kod.

Uji Model ML untuk Kualiti dan Kesaksamaan

Saintis data menumpukan pada pembangunan yang lebih dipercayai dan penyelesaian ML yang adil. Mereka menguji model untuk meminimumkan bias. Alat yang betul membantu mereka menilai metrik utama, seperti ketepatan dan AUC, menyokong analisis ralat dan perbandingan versi, proses dokumen dan disepadukan dengan lancar ke dalam saluran paip ML.

Deepchecks adalah pakej Python yang membantu dengan model ML dan pengesahan data. Ia juga memudahkan semakan prestasi model, integriti data dan ketidakpadanan pengedaran.

Truera adalah platform kecerdasan model moden yang membantu saintis data meningkatkan kepercayaan dan ketelusan dalam model ML. Menggunakan alat ini, mereka boleh memahami tingkah laku model, mengenal pasti isu dan mengurangkan berat sebelah. Truera menyediakan ciri untuk penyahpepijatan model, kebolehjelasan dan penilaian kesaksamaan.

Kolena adalah platform yang meningkatkan penjajaran dan kepercayaan pasukan melalui ujian dan penyahpepijatan yang ketat. Ia menyediakan persekitaran dalam talian untuk hasil log dan pandangan. Fokusnya adalah pada ujian dan pengesahan unit ML secara berskala, yang merupakan kunci kepada prestasi model yang konsisten merentas senario yang berbeza.

Hidupkan Model

Saintis data memerlukan alat yang boleh dipercayai untuk menggunakan model ML dengan cekap dan menyampaikan ramalan dengan pasti. Alat berikut membantu mereka mencapai operasi ML yang lancar dan berskala:

BentoML adalah platform terbuka yang membantu saintis data mengendalikan operasi ML dalam pengeluaran. Ia membantu menyelaraskan pembungkusan model dan mengoptimumkan beban kerja penyajian untuk kecekapan. Ia juga membantu dengan persediaan, penggunaan dan pemantauan perkhidmatan ramalan yang lebih pantas.

Kubeflow memudahkan penggunaan model ML pada Kubernetes (secara tempatan, di premis atau dalam awan). Dengan alat ini, keseluruhan proses menjadi mudah, mudah alih dan berskala. Ia menyokong segala-galanya daripada penyediaan data kepada penyajian ramalan.

Permudahkan Kitaran Hayat ML Dengan Platform MLOps End-To-End

Platform MLOps hujung-ke-hujung adalah penting untuk mengoptimumkan kitaran hayat pembelajaran mesin, menawarkan pendekatan yang diperkemas untuk membangunkan, menggunakan dan mengurus model ML dengan berkesan. Berikut ialah beberapa platform terkemuka dalam ruang ini:

Amazon SageMaker menawarkan antara muka komprehensif yang membantu saintis data mengendalikan keseluruhan kitaran hayat ML. Ia menyelaraskan prapemprosesan data, latihan model dan percubaan, meningkatkan kerjasama dalam kalangan saintis data. Dengan ciri seperti algoritma terbina dalam, penalaan model automatik dan penyepaduan yang ketat dengan perkhidmatan AWS, SageMaker ialah pilihan utama untuk membangunkan dan menggunakan penyelesaian pembelajaran mesin berskala.

Microsoft Azure ML Platform mencipta persekitaran kolaboratif yang menyokong pelbagai bahasa pengaturcaraan dan rangka kerja. Ia membolehkan saintis data menggunakan model pra-bina, mengautomasikan tugasan ML dan menyepadukan dengan lancar dengan perkhidmatan Azure yang lain, menjadikannya pilihan yang cekap dan berskala untuk projek ML berasaskan awan.

Google Cloud Vertex AI menyediakan persekitaran yang lancar untuk pembangunan model automatik dengan AutoML dan latihan model tersuai menggunakan rangka kerja yang popular. Alatan bersepadu dan akses mudah kepada perkhidmatan Google Cloud menjadikan Vertex AI sesuai untuk memudahkan proses ML, membantu pasukan sains data membina dan menggunakan model dengan mudah dan pada skala.

Mendaftar Mati

MLOps bukan sekadar gembar-gembur. Ia merupakan bidang penting yang membantu profesional melatih dan menganalisis jumlah data yang besar dengan lebih cepat, tepat dan mudah. Kita hanya boleh membayangkan bagaimana ini akan berkembang dalam tempoh sepuluh tahun akan datang, tetapi jelas bahawa AI, data besar dan automasi baru mula mendapat momentum.

Atas ialah kandungan terperinci MLOps: Cara Membina Kit Alat Untuk Meningkatkan Prestasi Projek AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!