Rumah >Peranti teknologi >AI >Pandangan alam semula jadi: Ujian kecerdasan buatan dalam perubatan berada dalam keadaan huru-hara Apa yang perlu dilakukan?

Pandangan alam semula jadi: Ujian kecerdasan buatan dalam perubatan berada dalam keadaan huru-hara Apa yang perlu dilakukan?

- PHPzasal

- 2024-08-22 16:37:32527semak imbas

Berdasarkan data klinikal yang terhad, beratus-ratus algoritma perubatan telah diluluskan. Para saintis sedang membahaskan siapa yang harus menguji alat dan cara terbaik untuk melakukannya.

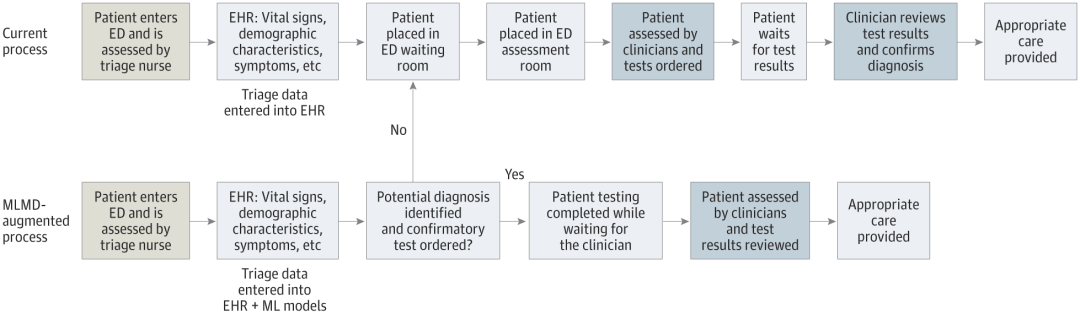

- Devin Singh menyaksikan seorang pesakit kanak-kanak mengalami serangan jantung di bilik kecemasan sementara menunggu rawatan untuk masa yang lama, yang mendorongnya untuk meneroka penggunaan AI untuk mengurangkan masa menunggu.

- Memanfaatkan data triage daripada bilik kecemasan SickKids, Singh dan rakan sekerja membina satu siri model AI untuk menyediakan potensi diagnosis dan mengesyorkan ujian.

- Satu kajian menunjukkan model ini boleh mempercepatkan lawatan doktor sebanyak 22.3%, mempercepatkan pemprosesan keputusan hampir 3 jam bagi setiap pesakit yang memerlukan ujian perubatan.

- Walau bagaimanapun, kejayaan algoritma AI dalam penyelidikan hanyalah langkah pertama dalam mengesahkan sama ada campur tangan tersebut akan membantu orang ramai dalam kehidupan sebenar.

Satu cara untuk memesan ujian secara autonomi di jabatan kecemasan (ED) menggunakan pesanan perubatan pembelajaran mesin (MLMD) (Sumber: jamanetwork.com)

Siapa yang menguji sistem AI perubatan?

Aplikasi perubatan berasaskan AI, seperti yang sedang dibangunkan oleh Singh, sering dianggap peranti perubatan oleh pengawal selia ubat, termasuk FDA AS dan Agensi Pengawalseliaan Ubat dan Penjagaan Kesihatan UK. Oleh itu, piawaian untuk semakan dan kebenaran penggunaan secara amnya kurang ketat daripada piawaian untuk farmaseutikal. Hanya subset kecil peranti—yang mungkin menimbulkan risiko tinggi kepada pesakit—memerlukan data percubaan klinikal untuk kelulusan.

Ramai orang berpendapat ambang terlalu rendah. Apabila Gary Weissman, seorang doktor penjagaan kritikal di University of Pennsylvania di Philadelphia, menyemak peranti AI yang diluluskan oleh FDA dalam bidangnya, dia mendapati bahawa daripada sepuluh peranti yang dikenal pastinya, hanya tiga yang memetik data yang diterbitkan dalam kebenaran mereka. Hanya empat menyebut penilaian keselamatan, dan tidak termasuk penilaian berat sebelah, yang menganalisis sama ada keputusan alat itu adil kepada kumpulan pesakit yang berbeza. "Kebimbangannya ialah peranti ini boleh dan memberi kesan kepada penjagaan di tepi katil," katanya "Kehidupan pesakit mungkin bergantung pada keputusan ini

Kekurangan data menyukarkan hospital dan sistem kesihatan untuk membuat keputusan sama ada untuk menggunakan ini." teknologi dalam keadaan yang sukar. Dalam sesetengah kes, insentif kewangan turut dimainkan. Di Amerika Syarikat, sebagai contoh, pelan insurans kesihatan sudah membayar balik hospital untuk penggunaan peranti AI perubatan tertentu, menjadikannya menarik dari segi kewangan. Institusi ini juga mungkin cenderung untuk menggunakan alat AI yang menjanjikan penjimatan kos, walaupun mereka tidak semestinya meningkatkan penjagaan pesakit.

Ouyang berkata insentif ini mungkin menghalang syarikat AI daripada melabur dalam ujian klinikal. "Untuk banyak perniagaan komersial, anda boleh bayangkan mereka akan bekerja lebih keras untuk memastikan alat AI mereka boleh dibayar balik," katanya.

Situasi mungkin berbeza di pasaran yang berbeza. Di United Kingdom, sebagai contoh, pelan kesihatan negara yang dibiayai oleh kerajaan mungkin menetapkan ambang bukti yang lebih tinggi sebelum pusat perubatan boleh membeli produk tertentu, kata Xiaoxuan Liu, seorang penyelidik klinikal di Universiti Birmingham yang mengkaji inovasi yang bertanggungjawab dalam kecerdasan buatan insentif untuk menjalankan ujian klinikal. "

Sebaik sahaja hospital membeli produk AI, mereka tidak perlu menjalankan ujian lanjut dan boleh menggunakannya serta-merta seperti perisian lain. Walau bagaimanapun, sesetengah agensi menyedari bahawa kelulusan kawal selia bukanlah jaminan bahawa peranti itu sebenarnya akan memberi manfaat. Jadi mereka memilih untuk mengujinya sendiri. Pada masa ini, banyak usaha ini dijalankan dan dibiayai oleh pusat perubatan akademik, kata Ouyang.

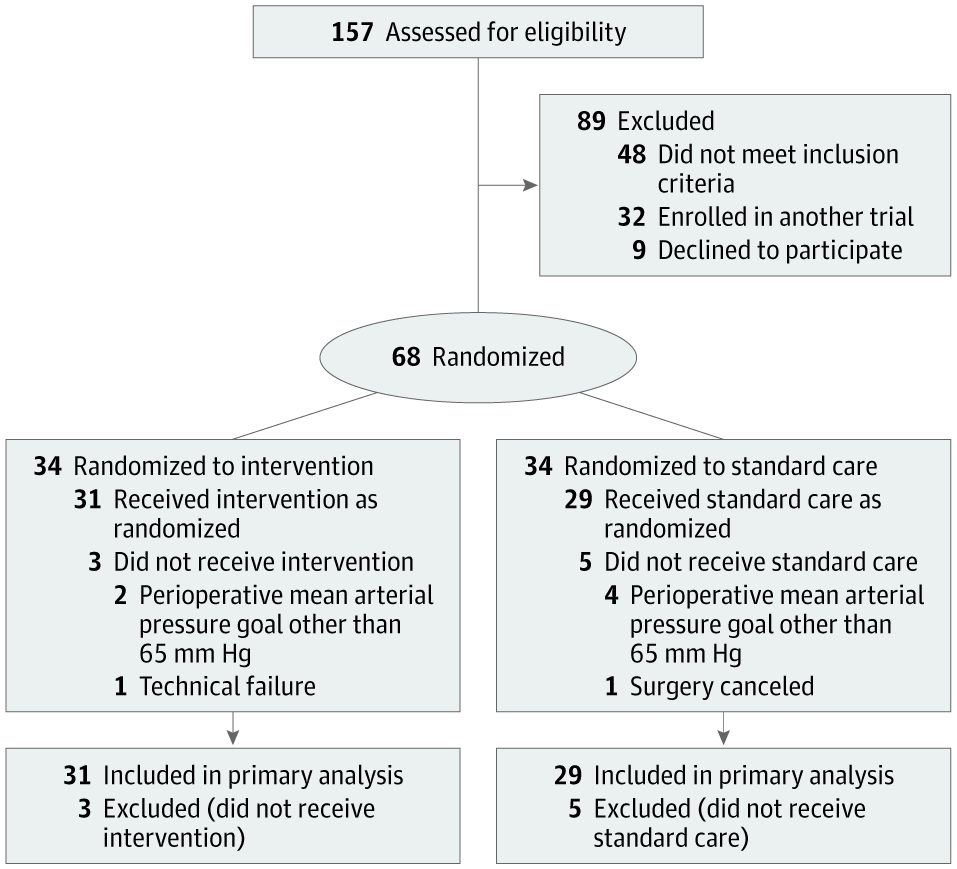

Alexander Vlaar, pengarah perubatan rawatan rapi di Pusat Perubatan Universiti Amsterdam, dan Denise Veelo, pakar bius di institusi yang sama, memulakan usaha sedemikian pada 2017. Matlamat mereka adalah untuk menguji algoritma yang direka untuk meramalkan berlakunya hipotensi semasa pembedahan. Keadaan ini, yang dikenali sebagai hipotensi intraoperatif, boleh membawa kepada komplikasi yang mengancam nyawa seperti kerosakan otot jantung, serangan jantung dan kegagalan buah pinggang akut, dan juga kematian.

Algoritma, dibangunkan oleh Edwards Lifesciences yang berpangkalan di California, menggunakan data bentuk gelombang arteri — garis merah dengan puncak dan palung dipaparkan pada monitor di jabatan kecemasan atau unit rawatan rapi. Kaedah ini boleh meramalkan hipotensi beberapa minit sebelum ia berlaku, membolehkan campur tangan awal.

Aliran peserta dalam percubaan Hypotension Prediction (HYPE). (Sumber: jamanetwork.com) Vlaar, Veelo dan rakan sekerja menjalankan percubaan klinikal rawak untuk menguji alat itu ke atas 60 pesakit yang menjalani pembedahan bukan jantung. Pesakit yang menggunakan peranti itu mengalami purata lapan minit hipotensi semasa pembedahan, manakala pesakit dalam kumpulan kawalan mengalami purata hampir 33 minit.

Pasukan menjalankan percubaan klinikal kedua, mengesahkan bahawa peranti itu juga berkesan dalam tetapan yang lebih kompleks, termasuk semasa pembedahan jantung dan dalam unit rawatan rapi, apabila digabungkan dengan rejimen rawatan yang jelas. Keputusan masih belum diumumkan.

Kejayaan bukan hanya disebabkan oleh ketepatan algoritma. Tindak balas pakar bius terhadap penggera juga penting. Jadi para penyelidik memastikan doktor bersedia dengan baik: "Kami mempunyai carta alir diagnostik yang menggariskan langkah-langkah yang perlu diambil apabila amaran diterima, " kata Veelo. Algoritma yang sama gagal menunjukkan manfaat dalam percubaan klinikal yang dijalankan oleh institusi lain. Dalam kes itu, "apabila penggera berbunyi, doktor sisi katil gagal mengikut arahan dan mengambil tindakan," kata Vlaar.

Manusia Terlibat Algoritma yang sangat baik mungkin gagal disebabkan oleh perubahan dalam tingkah laku manusia, sama ada profesional penjagaan kesihatan atau orang yang menerima rawatan.

Klinik Mayo di Rochester, Minnesota, sedang menguji algoritma yang dibangunkan secara dalaman untuk mengesan penyakit jantung dengan pecahan lenting yang rendah, dan Barbara Barry, seorang penyelidik interaksi manusia-komputer di pusat, bertanggungjawab untuk merapatkan pembangun dan pengguna jurang antara penyedia penjagaan primer.

Alat ini direka bentuk untuk menandakan individu yang mungkin berisiko tinggi menghidapi keadaan ini, yang boleh menjadi tanda kegagalan jantung dan boleh dirawat tetapi selalunya tidak didiagnosis. Percubaan klinikal menunjukkan bahawa algoritma itu meningkatkan kadar diagnosis. Walau bagaimanapun, dalam perbualan dengan pembekal, Barry mendapati bahawa mereka mahukan panduan lanjut tentang cara membincangkan keputusan algoritma dengan pesakit mereka. Ini membawa kepada cadangan bahawa apl itu, jika dilaksanakan secara meluas, harus memasukkan maklumat penting untuk berkomunikasi dengan pesakit supaya penyedia penjagaan kesihatan tidak perlu memikirkan cara mengadakan perbualan ini setiap kali. "Ini adalah contoh kita beralih daripada eksperimen pragmatik kepada strategi pelaksanaan," kata Barry.

Satu lagi isu yang mungkin mengehadkan kejayaan sesetengah peranti AI perubatan ialah "keletihan amaran"—apabila doktor terdedah kepada sejumlah besar amaran yang dijana AI, mereka mungkin menjadi tidak peka terhadapnya. Itu harus diambil kira semasa proses ujian, kata David Rushlow, ketua bahagian perubatan keluarga di Mayo Clinic.

“Kami menerima makluman berkali-kali setiap hari tentang penyakit yang mungkin berisiko kepada pesakit, bagi doktor barisan hadapan yang sibuk, ini sebenarnya merupakan tugas yang sangat sukar,” katanya mereka tidak diperkenalkan dengan tepat, lalainya adalah untuk terus melakukan perkara dengan cara yang sama kerana kami tidak mempunyai lebar jalur yang mencukupi untuk mempelajari perkara baharu." Rushlow menegaskan.

Pertimbangkan Bias

Satu lagi cabaran dalam menguji AI perubatan ialah keputusan percubaan klinikal sukar untuk digeneralisasikan merentas populasi yang berbeza. "Adalah diketahui umum bahawa algoritma kecerdasan buatan boleh menjadi sangat rapuh apabila ia digunakan pada data yang berbeza daripada data latihan, " kata Liu.

Dia menyatakan bahawa keputusan hanya boleh diekstrapolasi dengan selamat jika peserta ujian klinikal mewakili populasi yang alat itu akan digunakan.

Selain itu, algoritma yang dilatih mengenai data yang dikumpul di hospital yang kaya dengan sumber mungkin tidak berfungsi dengan baik apabila digunakan dalam tetapan yang tidak mempunyai sumber. Sebagai contoh, pasukan Kesihatan Google membangunkan algoritma untuk mengesan retinopati diabetik, keadaan yang menyebabkan kehilangan penglihatan pada penghidap diabetes, dengan ketepatan yang tinggi secara teori. Tetapi apabila alat itu digunakan di klinik di Thailand, prestasinya menurun dengan ketara.

Kajian pemerhatian menunjukkan bahawa keadaan pencahayaan di klinik Thai mengakibatkan kualiti imej mata yang lemah, mengurangkan keberkesanan alat.

Pada masa ini, kebanyakan alatan AI perubatan membantu profesional penjagaan kesihatan dengan pemeriksaan, diagnosis atau perancangan rawatan. Pesakit mungkin tidak menyedari bahawa teknologi ini sedang diuji atau digunakan secara rutin dalam penjagaan mereka, dan tiada negara pada masa ini memerlukan penyedia penjagaan kesihatan untuk mendedahkan perkara ini.

Perdebatan berterusan mengenai perkara yang perlu diberitahu kepada pesakit tentang teknologi kecerdasan buatan. Beberapa apl ini telah mendorong isu persetujuan pesakit menjadi perhatian pembangun. Begitulah halnya dengan peranti kecerdasan buatan yang sedang dibangunkan oleh pasukan Singh untuk menyelaraskan penjagaan kanak-kanak di bilik kecemasan SickKids.

Apa yang sangat berbeza tentang teknologi ini ialah ia menyingkirkan doktor daripada keseluruhan proses, membenarkan kanak-kanak (atau ibu bapa atau penjaga mereka) menjadi pengguna akhir.

“Apa yang dilakukan oleh alat ini ialah mengambil data percubaan kecemasan, membuat ramalan dan memberi kelulusan terus kepada ibu bapa — ya atau tidak — jika anak mereka boleh diuji,” kata Singh. Ini mengurangkan beban doktor dan mempercepatkan keseluruhan proses. Tetapi ia juga membawa banyak masalah yang tidak pernah berlaku sebelum ini. Siapa yang bertanggungjawab jika berlaku masalah kepada pesakit? Siapa yang membayar jika ujian yang tidak perlu dilakukan?

“Kami perlu mendapatkan persetujuan termaklum daripada keluarga secara automatik.” Singh berkata, dan persetujuan itu mestilah boleh dipercayai dan sahih. “Ini tidak seperti apabila anda mendaftar untuk media sosial dan mempunyai 20 halaman cetakan halus dan anda hanya klik terima

Sementara Singh dan rakan-rakannya menunggu dana untuk memulakan ujian ke atas pesakit, pasukan itu bekerja dengan undang-undang.” pakar dan Libatkan agensi kawal selia negara, Health Canada, dalam menyemak cadangannya dan mempertimbangkan implikasi kawal selia. Pada masa ini, "landskap kawal selia adalah sedikit seperti Wild West," kata Anna Goldenberg, seorang saintis komputer dan pengerusi bersama Inisiatif Kecerdasan Buatan Perubatan Kanak-kanak SickKids.

Institusi perubatan secara berhemat menggunakan alatan AI dan menjalankan ujian autonomi.

Faktor kos telah mendorong penyelidik dan institusi perubatan untuk meneroka alternatif.

Institusi perubatan yang besar mempunyai lebih sedikit kesukaran, manakala institusi kecil menghadapi cabaran yang lebih besar.

Mayo Clinic menguji alat AI untuk digunakan dalam tetapan penjagaan kesihatan komuniti.

The Health AI Alliance menubuhkan makmal jaminan untuk menilai model tersebut.

Universiti Duke mencadangkan keupayaan ujian dalaman untuk mengesahkan model AI secara tempatan.

Ahli radiologi Nina Kottler menekankan kepentingan pengesahan tempatan.

Faktor manusia perlu diberi perhatian untuk memastikan ketepatan kecerdasan buatan dan pengguna akhir.

Kandungan rujukan: https://www.nature.com/articles/d41586-024-02675-0

Atas ialah kandungan terperinci Pandangan alam semula jadi: Ujian kecerdasan buatan dalam perubatan berada dalam keadaan huru-hara Apa yang perlu dilakukan?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI