Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Wu Yi, penolong profesor di Institut Maklumat Antara Disiplin, Universiti Tsinghua, bekas penyelidik penyelidikan sepenuh masa di OpenAI, , penjajaran model besar, interaksi Komputer manusia, pembelajaran robot, dsb. Mendapat PhD dari University of California, Berkeley, pada 2019, belajar di bawah Profesor Stuart Russell lulus dari Institut Maklumat Antara Disiplin Universiti Tsinghua (Kelas Yao) pada 2014. Kerja-kerja wakilnya termasuk: Kertas kerja terbaik NIPS2016, Rangkaian Lelaran Nilai yang paling banyak dipetik dalam bidang pembelajaran tetulang dalam pelbagai ejen, algoritma MADDPG OpenAI, dsb. Bagaimana untuk menjadikan model besar lebih mematuhi arahan dan niat manusia? Bagaimana untuk menjadikan model besar mempunyai keupayaan penaakulan yang lebih baik? Bagaimana untuk mengelakkan halusinasi dalam model besar? Sama ada masalah ini boleh diselesaikan ialah cabaran teknikal yang paling kritikal untuk menjadikan model besar benar-benar tersedia secara meluas dan juga mencapai kecerdasan super. Cabaran paling sukar ini juga merupakan tumpuan penyelidikan jangka panjang pasukan Wu Yi, dan merupakan masalah yang perlu diatasi oleh teknologi penjajaran model besar (Penjajaran). Dalam teknologi penjajaran, rangka kerja algoritma yang paling penting ialah pembelajaran pengukuhan berdasarkan maklum balas manusia (RLHF, Pembelajaran Pengukuhan daripada Maklum Balas Manusia). RLHF mempelajari fungsi ganjaran (Model Ganjaran) berdasarkan maklum balas manusia berdasarkan maklum balas keutamaan manusia untuk output model besar, dan seterusnya melaksanakan latihan pembelajaran pengukuhan pada model besar, supaya model besar boleh belajar membezakan kualiti respons dalam lelaran berulang, dan mencapai keupayaan model yang Diperbaiki. Pada masa ini, model bahasa yang paling berkuasa di dunia, seperti model GPT OpenAI dan model Claude Anthropic, sangat menekankan kepentingan latihan RLHF. OpenAI dan Anthropic juga telah membangunkan sistem latihan RLHF secara dalaman berdasarkan algoritma PPO berskala besar untuk penjajaran model besar. Walau bagaimanapun, disebabkan proses kompleks algoritma PPO dan penggunaan kuasa pengkomputeran yang tinggi, sistem latihan RLHF berskala besar syarikat AI Amerika tidak pernah menjadi sumber terbuka, walaupun algoritma PPO sangat kuat, kerja penjajaran dalam akademia jarang menggunakan kaedah yang rumit Algoritma PPO digunakan untuk penyelidikan RLHF, dan algoritma penjajaran seperti SFT (penalaan halus diselia) atau DPO (Pengoptimuman Dasar Langsung) biasanya digunakan yang lebih mudah, lebih langsung. , dan mempunyai keperluan yang lebih rendah pada sistem latihan. Jadi, adakah algoritma penjajaran mudah pasti berfungsi dengan lebih baik? Kerja "Adakah DPO Unggul daripada PPO untuk Penjajaran LLM? Kajian Komprehensif" yang diterbitkan oleh pasukan Wu Yi di ICML 2024 dengan teliti membincangkan ciri-ciri algoritma DPO dan PPO dan menunjukkan perkara utama untuk meningkatkan kesan algoritma RLHF. Dalam kerja ini, berdasarkan sistem latihan RLHF berskala besar yang dibangunkan sendiri, pasukan Wu Yi menggunakan algoritma PPO dan model sumber terbuka dengan parameter yang lebih sedikit untuk kali pertama, mengatasi tugas penjanaan kod skala besar sumber tertutup CodeContest dalam cabaran paling sukar yang diiktiraf.

Keputusan yang berkaitan telah diterima sebagai Persembahan Lisan oleh ICML 2024, dan akan dilaporkan secara terbuka pada sesi Lisan pertama Penjajaran-1 ICML 2024 pada 23 Julai, bersama-sama dengan kerja institusi terkenal seperti OpenAI dan Antropik.

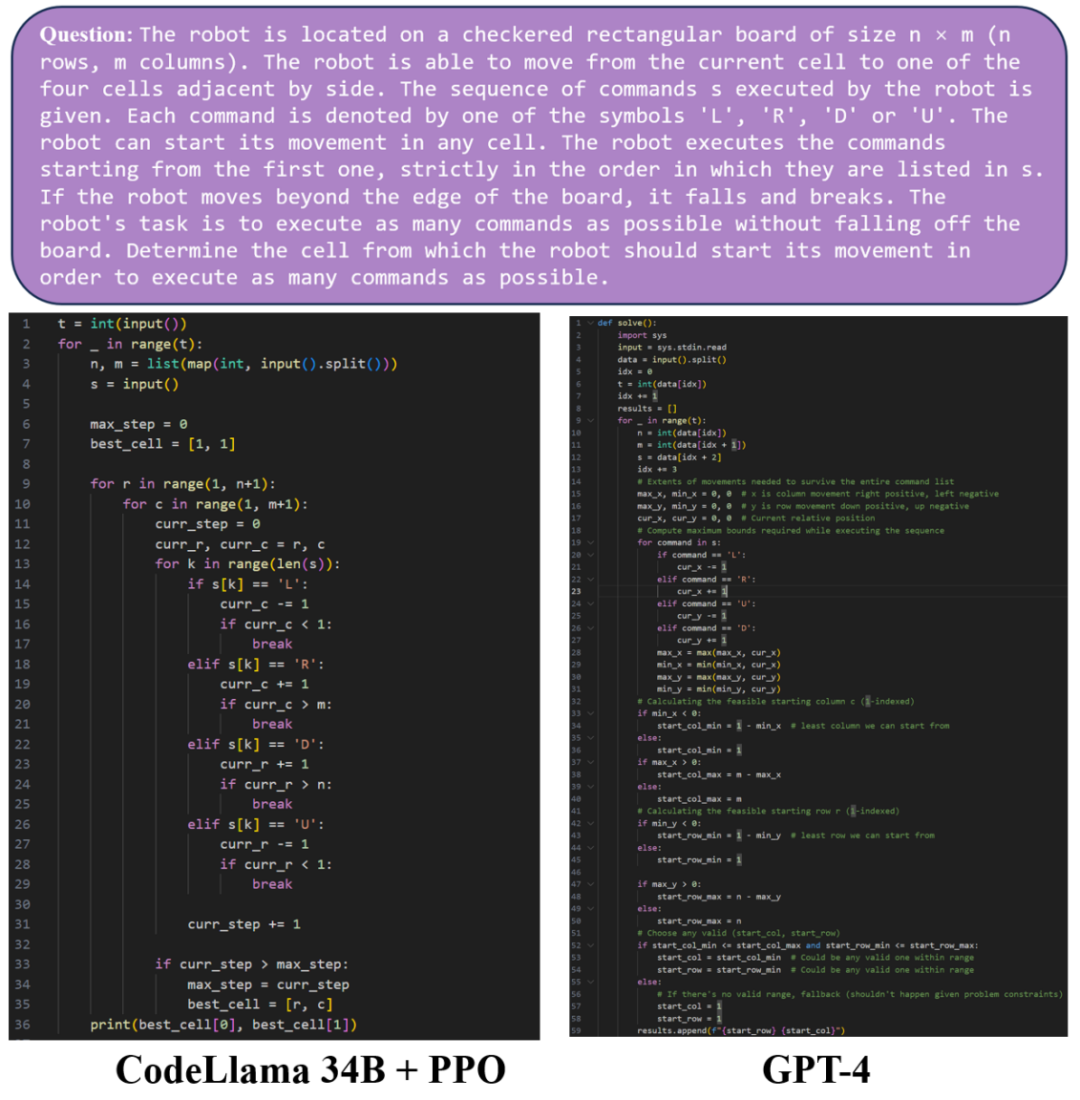

Seterusnya, mari kita bandingkan kesan penjanaan kod GPT-4 dan model CodeLlama 34B yang dilatih oleh algoritma PPO Dalam Contoh 1, model CodeLlama 34B yang dilatih oleh algoritma PPO dan model GPT-4 dijana. Kod kualiti setanding.

Dalam Contoh 2, anda dapat melihat bahawa kedua-dua model CodeLlama 34B dan model GPT-4 yang dilatih oleh algoritma PPO boleh menjana kod python yang lengkap dan boleh dijalankan. Walau bagaimanapun, dalam contoh ini, GPT-4 menghasilkan kod yang salah dan gagal untuk mengeluarkan dengan betul pada data ujian. Kod yang dijana oleh model CodeLlama 34B yang dilatih oleh algoritma PPO boleh lulus ujian.

Dans cet article de l'ICML 2024, l'équipe de recherche a discuté en détail des caractéristiques des algorithmes DPO et PPO et a souligné les points clés pour améliorer les capacités du DPO et du PPO.

-

Titre de l'article : Le DPO est-il supérieur au PPO pour l'alignement LLM ? Algorithme DPO Limites

Par rapport au PPO, DPO utilise des données hors ligne au lieu de données d'échantillonnage en ligne pour la formation. Après analyse, l'algorithme DPO amènera le modèle entraîné à privilégier les sorties en dehors de la distribution des données d'entraînement et, dans certains cas, produira des réponses imprévisibles.

Ainsi, afin d'améliorer les capacités de l'algorithme DPO, l'équipe de recherche a résumé deux technologies clés : Effectuer une formation SFT supplémentaire avant la formation RLHF et utiliser des données d'échantillonnage en ligne au lieu de données hors ligne.

Les expériences montrent que l'utilisation d'une formation SFT supplémentaire peut rendre le modèle de base et le modèle de référence plus biaisés en faveur de la distribution au sein de l'ensemble de données, améliorant considérablement l'effet de l'algorithme DPO, d'autre part, de l'algorithme DPO utilisant l'échantillonnage en ligne ; les données pour la formation itérative peuvent Il a été régulièrement amélioré et ses performances sont bien meilleures que l'algorithme DPO de base.

Les points clés de l'algorithme PPO

À l'exclusion du DPO, le document résume également trois points clés pour maximiser les capacités du PPO :

Utiliser un lot de grande taille (grand taille du lot)

et mettre à jour le modèle de référence en utilisant la moyenne mobile exponentielle (moyenne mobile exponentielle pour le modèle de référence).

- L'équipe de recherche a utilisé avec succès l'algorithme PPO pour obtenir des résultats SOTA sur les tâches de dialogue Safe-RLHF/HH-RLHF et la tâche de génération de code APPS/CodeContest.

-

Sur la tâche de dialogue, l'équipe de recherche a constaté que l'algorithme PPO qui combine trois points clés est nettement meilleur que l'algorithme DPO et l'algorithme DPO d'échantillonnage en ligne DPO-Iter.

Dans les tâches de génération de code APPS et CodeContest, basées sur le modèle open source Code Llama 34B, l'algorithme PPO a également atteint le niveau le plus élevé, dépassant le précédent SOTA, AlphaCode 41B dans CodeContest.

Pour obtenir un alignement de modèles à grande échelle avec de meilleurs résultats, un système de formation très efficace est indispensable. L'équipe de Wu Yi s'est accumulée à long terme dans la réalisation d'une formation d'apprentissage par renforcement à grande échelle et a construit depuis 2021 un cadre d'apprentissage par renforcement distribué exclusif. .

- NeurIPS 2022 Keberkesanan PPO yang Mengejutkan dalam Permainan Pelbagai Ejen Koperasi [1]: Mencadangkan dan sumber terbuka rangka kerja latihan selari pembelajaran pengukuhan MAPPO untuk pelbagai ejen untuk menyokong latihan pelbagai ejen dalam senario koperasi telah digunakan dalam sejumlah besar karya dalam bidang berbilang ejen, dan bilangan petikan semasa dalam kertas telah melebihi 1k.

- Pembelajaran Peneguhan Teragih ICLR 2024 kepada Lebih Sepuluh Ribu Teras [2]: Mencadangkan rangka kerja latihan teragih untuk pembelajaran pengukuhan, yang boleh dikembangkan dengan mudah kepada puluhan ribu teras, dan nisbah pecutan melebihi peneguhan skala besar OpenAI sistem pembelajaran Rapid .

- ReaLHF: Latihan RLHF Dioptimumkan untuk Model Bahasa Besar melalui Alokasi Semula Parameter [3]: Baru-baru ini, pasukan Wu Yi terus melaksanakan rangka kerja latihan RLHF yang diedarkan ReaLHF. Kertas Lisan ICML pasukan Wu Yi dihasilkan berdasarkan sistem ReaLHF. Sistem ReaLHF telah dibangunkan untuk masa yang lama dan telah melalui banyak penggilapan terperinci untuk mencapai prestasi optimum. Berbanding dengan kerja sumber terbuka sebelumnya, ReaLHF boleh mencapai skalabiliti hampir linear dalam RLHF, senario yang lebih kompleks daripada pra-latihan Ia juga mempunyai penggunaan sumber yang lebih tinggi dan boleh melaksanakan RLHF secara stabil dan pantas pada 128 A100 GPU, kerja berkaitan telah menjadi sumber terbuka: https://github.com/openpsi-project/ReaLHF

Selain meningkatkan keupayaan pengekodan model bahasa besar, pasukan Wu Yi juga menggunakan pelbagai algoritma pembelajaran pengukuhan dan besar. Gabungan model merealisasikan pelbagai Ejen LLM yang kompleks dan boleh menjalankan interaksi yang kompleks dengan manusia. Gunakan pembelajaran pengukuhan dalam MiniRTS untuk mencipta agen bahasa yang boleh mengikut arahan manusia dan membuat keputusan yang optimum [4].

Melatih strategi pembelajaran tetulang pelbagai strategi dalam Werewolf untuk meningkatkan keupayaan membuat keputusan model besar [5].

Dalam permainan Overcooked, model kecil dan model besar digabungkan untuk melaksanakan Agen Bahasa koperasi yang boleh memberikan maklum balas masa nyata [6].

Menggabungkan strategi kawalan robot yang dilatih oleh pembelajaran pengukuhan dan keupayaan penaakulan model bahasa besar membolehkan robot melakukan satu siri tugas yang kompleks [7].

Untuk membolehkan model besar benar-benar memasuki beribu-ribu isi rumah, teknologi penjajaran adalah penting Bagi ahli akademik dan pengamal model besar, kerja sumber terbuka dan kertas kerja yang baik sudah pasti akan mengurangkan kos percubaan dan Kesukaran pembangunan, kami juga menjangkakan bahawa dengan perkembangan teknologi, lebih banyak model besar yang berkhidmat kepada manusia akan muncul. [1] Yu, Chao, Akash Velu, Eugene Vinitsky, Jiaxuan Gao, Yu Wang, Alexandre Bayen dan Yi Wu "Keberkesanan ppo yang mengejutkan dalam permainan pelbagai ejen koperasi.". [2] Mei, Zhiyu, Wei Fu, Guangju Wang, Huanchen Zhang dan Yi Wu "SRL: Menskalakan Pembelajaran Peneguhan Teragih kepada Lebih Sepuluh Ribu Teras."[3] Mei, Zhi. Wei Fu, Kaiwei Li, Guangju Wang, Huanchen Zhang dan Yi Wu "ReaLHF: Latihan RLHF Dioptimumkan untuk Model Bahasa Besar melalui Alokasi Semula Parameter."[4] Xu, Shusheng, Huaijie Gao, Jiaxuan. Yutao Ouyang, Chao Yu dan Yi Wu "Generasi pergerakan dan kawalan robot yang realistik secara berpandukan bahasa."[5] Xu, Zelai, Chao Yu, Fei Fang, Yu Wang dan Yi Wu. "Ejen bahasa dengan pembelajaran pengukuhan untuk permainan strategik dalam permainan serigala jadian."[6] Liu, Jijia, Chao Yu, Jiaxuan Gao, Yuqing Xie, Qingmin Liao, Yi Wu, dan Yu Wang. agen bahasa hierarki yang dikuasakan untuk penyelarasan manusia-ai masa nyata."[7] Ouyang, Yutao, Jinhan Li, Yunfei Li, Zhongyu Li, Chao Yu, Koushil Sreenath dan Yi Wu. "Horizon panjang Pergerakan dan Manipulasi pada Robot Kuadrupedal dengan Model Bahasa Besar."Atas ialah kandungan terperinci ICML 2024 Oral |. Adakah DPO lebih sesuai untuk LLM daripada pendedahan terbaru pasukan Tsinghua Wuyi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Kenyataan:Kandungan artikel ini disumbangkan secara sukarela oleh netizen, dan hak cipta adalah milik pengarang asal. Laman web ini tidak memikul tanggungjawab undang-undang yang sepadan. Jika anda menemui sebarang kandungan yang disyaki plagiarisme atau pelanggaran, sila hubungi admin@php.cn