Rumah >Peranti teknologi >AI >KDD 2024|Pasukan Hong Kong Rhubarb Chao menganalisis dengan mendalam 'sempadan tidak diketahui' model besar dalam bidang pembelajaran mesin graf

KDD 2024|Pasukan Hong Kong Rhubarb Chao menganalisis dengan mendalam 'sempadan tidak diketahui' model besar dalam bidang pembelajaran mesin graf

- PHPzasal

- 2024-07-22 16:54:341176semak imbas

AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。送信メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

この記事の主な著者は香港大学のデータ インテリジェンス研究室の出身です。著者のうち、第1著者のRen Xubinと第2著者のTang Jiabinはともに香港大学データサイエンス学部の博士課程1年生で、指導教員はData Intelligence Lab@HKUのHuang Chao教授です。香港大学のデータ インテリジェンス研究室は、人工知能とデータ マイニングに関連する研究に特化しており、大規模言語モデル、グラフ ニューラル ネットワーク、情報検索、推奨システム、時空間データ マイニングなどの分野をカバーしています。これまでの研究には、一般的なグラフ大規模言語モデル GraphGPT、HiGPT、スマートシティ大規模言語モデル UrbanGPT、解釈可能な大規模言語モデル推奨アルゴリズム XRec などが含まれます。

今日の情報爆発の時代において、膨大なデータの海から深いつながりをどのように探索すればよいでしょうか?

これに関して、香港大学、ノートルダム大学、その他の機関の専門家や学者が、グラフ学習と大規模言語モデルの分野に関する最新のレビューで答えを明らかにしてくれました。

グラフは、現実世界のさまざまな関係を表す基本的なデータ構造として、その重要性は自明です。これまでの研究では、グラフ ニューラル ネットワークがグラフ関連のタスクで素晴らしい結果を達成したことが証明されています。しかし、グラフ データのアプリケーション シナリオが複雑になるにつれて、グラフ機械学習のボトルネック問題がますます顕著になってきています。近年、自然言語処理の分野では大規模言語モデルが注目を集めており、その優れた言語理解力と要約能力が注目を集めています。このため、大規模な言語モデルをグラフ学習テクノロジと統合して、グラフ学習タスクのパフォーマンスを向上させることが、業界で新たな研究のホットスポットとなっています。

このレビューでは、モデルの汎化能力、堅牢性、複雑なグラフデータを理解する能力など、グラフ学習の現在の分野における主要な技術的課題の詳細な分析を提供し、大規模モデルの将来のブレークスルーを期待しています。 「未知のフロンティア」という意味での可能性。

論文アドレス: https://arxiv.org/abs/2405.08011

プロジェクトアドレス: https://github.com/HKUDS/Awesome-LLM4Graph-Papers

HKU Data Intelligenceラボ: https://sites.google.com/view/chaoh/home

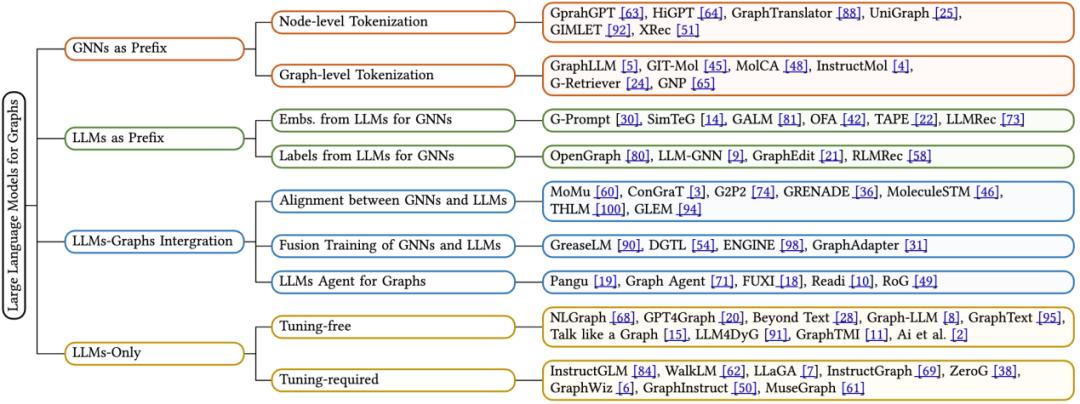

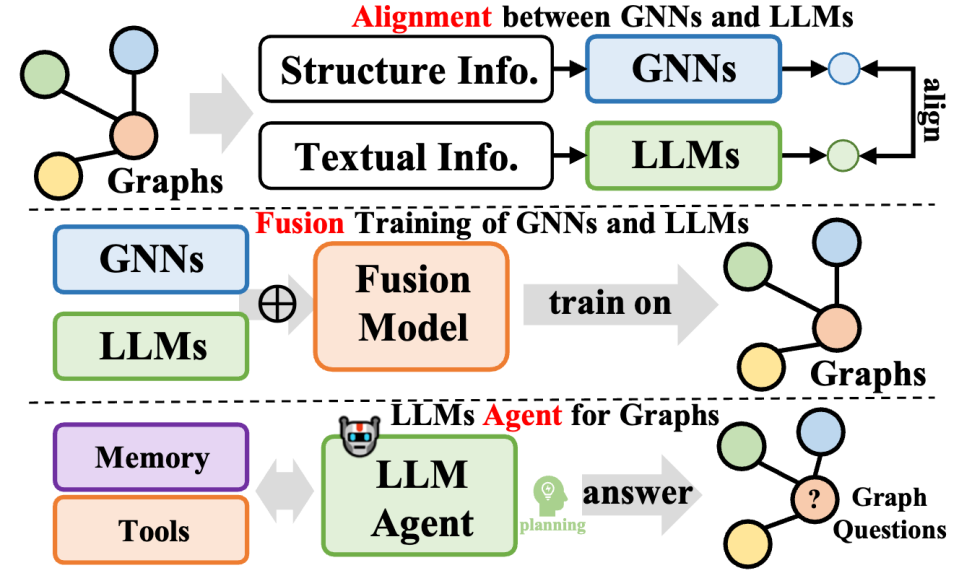

このレビューでは、グラフ学習に適用される最新の LLM を詳細にレビューし、フレームワーク設計に基づいた新しい分類方法を提案します。既存の技術を体系的に分類しています。これは 4 つの異なるアルゴリズム設計アイデアの詳細な分析を提供します。1 つはグラフ ニューラル ネットワークをプレフィックスとして使用し、2 つ目は大規模言語モデルをプレフィックスとして使用し、3 つ目は大規模言語モデルとグラフを統合するもので、4 つ目は大規模言語モデルのみを使用します。各カテゴリーについて、私たちは核となる技術的手法に焦点を当てています。さらに、このレビューはさまざまなフレームワークの長所とその限界についての洞察を提供し、将来の研究の潜在的な方向性を特定します。

香港大学データインテリジェンス研究所のHuang Chao教授率いる研究チームは、KDD 2024カンファレンスで、グラフ学習分野の大規模モデルが直面する「未知の境界」について徹底的に議論する予定です。

1 基礎知識

コンピュータサイエンスの分野において、グラフ(Graph)は重要な非線形データ構造であり、ノードセット(V)とエッジセット(E)から構成されます。各エッジはノードのペアを接続し、有向 (明確な始点と終点を持つ) または無向 (方向が指定されていない) の場合があります。特に注目すべき点は、テキスト属性グラフ (TAG) がグラフの特殊な形式として、文などのシリアル化されたテキスト機能を各ノードに割り当てることです。この機能は、大規模な言語モデルの時代には特に重要です。不可欠。テキスト属性グラフは、ノード セット V、エッジ セット E、およびテキスト特徴セット T から構成されるトリプレットとして正規に表すことができます。つまり、G * = (V, E, T) です。

グラフ ニューラル ネットワーク (GNN) は、グラフ構造データ用に設計された深層学習フレームワークです。隣接するノードからの情報を集約することにより、ノードの埋め込み表現を更新します。具体的には、GNN の各層は、現在のノードの埋め込みステータスと周囲のノードの埋め込み情報を包括的に考慮して次の層のノード埋め込みを生成する特定の関数を通じてノード埋め込み h を更新します。

Model Bahasa Besar (LLM) ialah model regresi yang berkuasa. Penyelidikan terkini telah menunjukkan bahawa model bahasa yang mengandungi berbilion parameter berfungsi dengan baik dalam menyelesaikan pelbagai tugas bahasa semula jadi, seperti terjemahan, penjanaan ringkasan dan pelaksanaan arahan, dan oleh itu dipanggil model bahasa besar. Pada masa ini, kebanyakan LLM termaju dibina berdasarkan blok Transformer menggunakan mekanisme query-key-value (QKV), yang menyepadukan maklumat dengan cekap dalam jujukan token. Mengikut arah aplikasi dan kaedah latihan perhatian, model bahasa boleh dibahagikan kepada dua jenis utama:

Pemodelan Bahasa Bertopeng (MLM) ialah sasaran pra-latihan yang popular untuk LLM. Ia melibatkan secara terpilih menutup token tertentu dalam urutan dan melatih model untuk meramalkan token bertopeng ini berdasarkan konteks sekeliling. Untuk mencapai ramalan yang tepat, model akan mempertimbangkan secara menyeluruh persekitaran kontekstual unsur-unsur perkataan bertopeng.

Pemodelan Bahasa Bersebab (CLM) ialah satu lagi objektif pra-latihan arus perdana untuk LLM. Ia memerlukan model untuk meramalkan token seterusnya berdasarkan token sebelumnya dalam jujukan. Dalam proses ini, model hanya bergantung pada konteks sebelum unsur perkataan semasa untuk membuat ramalan yang tepat.

2 Pembelajaran graf dan model bahasa besar

Dalam artikel ulasan ini, penulis bergantung pada proses inferens model - iaitu pemprosesan data graf, data teks dan model bahasa besar (LLMs) ) Kaedah interaktif, kaedah pengelasan baru dicadangkan. Secara khusus, kami meringkaskan empat jenis reka bentuk seni bina model utama, seperti berikut:

GNN sebagai Awalan: Dalam kategori ini, rangkaian saraf graf (GNN) berfungsi sebagai komponen utama, bertanggungjawab untuk memproses data dan menyediakan LLM teg kesedaran struktur (seperti teg tahap nod, tahap tepi atau tahap graf) untuk inferens seterusnya.

LLM sebagai Awalan: Dalam kategori ini, LLM memproses data graf pertama disertai dengan maklumat teks dan seterusnya menyediakan pembenaman nod atau label yang dijana untuk latihan rangkaian saraf graf.

LLMs-Graphs Integration (LLMs and Graphs Integration): Kaedah dalam kategori ini berusaha untuk mencapai penyepaduan yang lebih mendalam antara LLM dan data graf, seperti melalui latihan gabungan atau penjajaran dengan GNN. Selain itu, ejen berasaskan LLM telah dibina untuk berinteraksi dengan maklumat graf.

LLM-Sahaja (hanya menggunakan LLM): Kategori ini mereka bentuk pembayang dan teknik praktikal untuk membenamkan data berstruktur graf ke dalam jujukan token untuk memudahkan inferens oleh LLM. Pada masa yang sama, beberapa kaedah turut menggabungkan penanda berbilang modal untuk memperkayakan lagi keupayaan pemprosesan model.

2.1 GNN sebagai Awalan

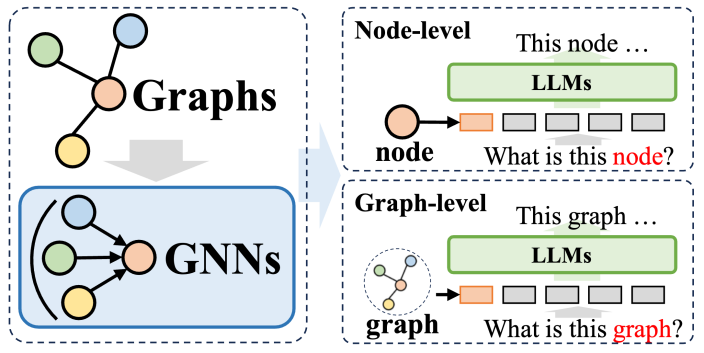

Dalam sistem kaedah di mana rangkaian neural graf (GNN) digunakan sebagai awalan, GNN memainkan peranan sebagai model pengekod bahasa struktur (LLM) dengan ketara meningkatkan prestasi pada struktur graf Keupayaan penghuraian data, dengan itu memanfaatkan pelbagai tugas hiliran. Dalam kaedah ini, GNN terutamanya berfungsi sebagai pengekod, yang bertanggungjawab untuk menukar data graf kompleks kepada jujukan token graf yang mengandungi maklumat struktur yang kaya, kemudiannya dimasukkan ke dalam LLM, yang konsisten dengan proses pemprosesan bahasa semula jadi.

Kaedah ini boleh dibahagikan secara kasar kepada dua kategori: Yang pertama ialah tokenisasi peringkat nod, iaitu, setiap nod dalam struktur graf dimasukkan secara individu ke dalam LLM. Tujuan pendekatan ini adalah untuk membolehkan LLM memahami dengan mendalam maklumat struktur peringkat nod dan mengenal pasti korelasi dan perbezaan antara nod yang berbeza dengan tepat. Yang kedua ialah tokenisasi peringkat graf, yang menggunakan teknologi pengumpulan khusus untuk memampatkan keseluruhan graf ke dalam urutan token panjang tetap, bertujuan untuk menangkap keseluruhan semantik peringkat tinggi struktur graf.

Untuk tokenisasi peringkat nod, ia amat sesuai untuk tugas pembelajaran graf yang memerlukan pemodelan maklumat struktur halus peringkat nod, seperti pengelasan nod dan ramalan pautan. Dalam tugasan ini, model perlu dapat membezakan perbezaan semantik halus antara nod yang berbeza. Rangkaian saraf graf tradisional menjana perwakilan unik untuk setiap nod berdasarkan maklumat nod jiran, dan kemudian melakukan pengelasan atau ramalan hiliran berdasarkan ini. Kaedah tokenisasi peringkat nod boleh mengekalkan ciri-ciri struktur unik setiap nod pada tahap yang paling besar, yang memberi manfaat besar kepada pelaksanaan tugas hiliran.

Sebaliknya, tokenisasi peringkat graf adalah untuk menyesuaikan diri dengan tugasan peringkat graf yang memerlukan pengekstrakan maklumat global daripada data nod. Di bawah rangka kerja GNN sebagai awalan, melalui pelbagai operasi pengumpulan, tokenisasi peringkat graf boleh mensintesis banyak perwakilan nod ke dalam perwakilan graf bersatu, yang bukan sahaja menangkap semantik global graf, tetapi juga meningkatkan lagi prestasi pelbagai tugas hiliran Kesan pelaksanaan.

2.2 LLM sebagai Awalan

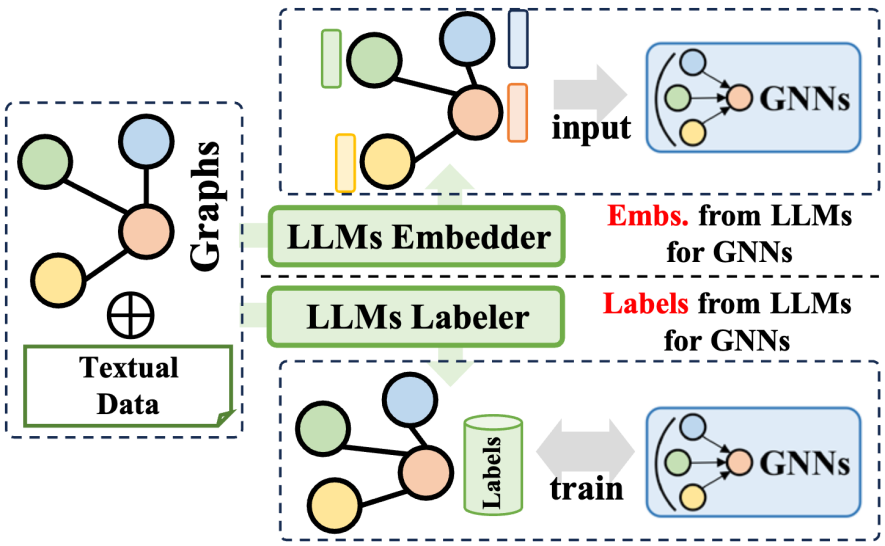

大規模言語モデル (LLM) プレフィックス メソッドは、大規模言語モデルによって生成された豊富な情報を利用して、グラフ ニューラル ネットワーク (GNN) のトレーニング プロセスを最適化します。この情報には、LLM によって生成されたテキスト コンテンツ、タグ、埋め込みなどのさまざまなデータが含まれます。この情報がどのように適用されるかに応じて、関連テクノロジーは 2 つの主要なカテゴリに分類できます。1 つは LLM によって生成された埋め込みを使用して GNN のトレーニングを支援するもので、もう 1 つは LLM によって生成されたラベルを GNN のトレーニング プロセスに統合するものです。 。

LLM エンベディングの利用 に関して、GNN の推論プロセスにはノード エンベディングの転送と集約が含まれます。ただし、初期ノードの埋め込みの品質と多様性は、レコメンダー システムの ID ベースの埋め込みや引用ネットワークのバッグ オブ ワード モデルの埋め込みなど、ドメインによって大きく異なり、明瞭さと豊富さに欠ける可能性があります。この埋め込み品質の欠如により、GNN のパフォーマンスが制限されることがあります。さらに、ユニバーサル ノード埋め込み設計の欠如は、さまざまなノード セットを扱うときの GNN の汎化能力にも影響します。幸いなことに、言語の要約とモデリングにおいて大規模言語モデルの優れた機能を活用することで、GNN に意味のある効果的な埋め込みを生成することができ、それによってトレーニング パフォーマンスを向上させることができます。

LLM ラベルの統合 に関して、別の戦略は、これらのラベルを監視信号として使用して、GNN のトレーニング効果を高めることです。ここでの教師ありラベルには従来の分類ラベルに限定されず、埋め込み、グラフ、その他の形式も含まれることに注意してください。 LLM によって生成された情報は、GNN の入力データとして直接使用されませんが、より洗練された最適化監視信号を構成するため、GNN がさまざまなグラフ関連タスクでより良いパフォーマンスを達成できるようになります。

2.3 LLMとグラフの統合

このタイプの方法は、大規模な言語モデルとグラフデータをさらに統合し、多様な方法論をカバーし、グラフ処理タスクにおける大規模言語モデル(LLM)の機能を向上させるだけでなく、同時に、グラフ ニューラル ネットワーク (GNN) のパラメーター学習も最適化されます。これらの方法は 3 つのタイプに要約できます。1 つは GNN と LLM の融合であり、モデル間の深い統合と共同トレーニングを実現することを目的としています。もう 1 つは、2 つのモデルの表現またはタスク レベルに焦点を当てた GNN と LLM 間の調整です。 3 つ目は、LLM に基づいて自律エージェントを構築し、グラフ関連のタスクを計画および実行することです。

GNN と LLM の融合に関しては、通常、GNN は構造化データの処理に重点を置き、LLM はテキスト データの処理に優れており、その結果、2 つは異なる特徴空間を持つことになります。この問題に対処し、GNN と LLM の学習における両方のデータ モダリティの共通の利益を促進するために、一部の方法では、対照学習や期待値最大化 (EM) 反復トレーニングなどの手法を採用して、2 つのモデルの特徴空間を調整します。このアプローチにより、グラフとテキスト情報のモデリングの精度が向上し、さまざまなタスクのパフォーマンスが向上します。

GNN と LLM の調整に関しては、表現の調整により両方のモデルの共同最適化と埋め込みレベルの調整が実現されますが、推論段階では依然として独立しています。 LLM と GNN の間のより緊密な統合を実現するために、一部の研究では、LLM のトランスフォーマー層と GNN のグラフ ニューラル層を組み合わせるなど、より深いモジュール アーキテクチャの融合の設計に焦点を当てています。 GNN と LLM を共同でトレーニングすることにより、グラフ タスクの両方のモジュールに双方向のゲインをもたらすことが可能になります。

最後に、LLM ベースのグラフ エージェント に関して、命令の理解と問題解決のための自己計画における LLM の優れた能力の助けを借りて、新しい研究の方向性は、処理または研究するための LLM に基づいた自律エージェントを構築することです。 -関連のタスク。通常、このようなエージェントには、記憶、知覚、および行動の 3 つのモジュールが含まれており、特定のタスクを解決するための観察、記憶の想起、および行動のサイクルを形成します。グラフ理論の分野では、LLM に基づくエージェントはグラフ データと直接対話し、ノード分類やリンク予測などのタスクを実行できます。

2.4 LLMのみ

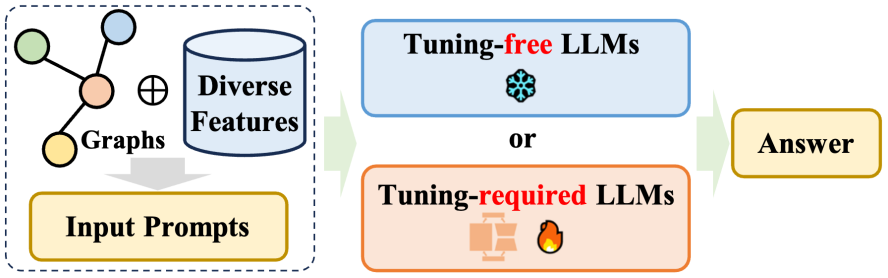

このレビューでは、LLMのみ、いわゆる「のみ」LLMに関する章で、さまざまなグラフ指向タスクへの大規模言語モデル(LLM)の直接適用について詳しく説明します。カテゴリー。これらのメソッドの目的は、LLM がグラフ構造情報を直接受け入れて理解し、この情報を組み合わせてさまざまな下流タスクについて推論できるようにすることです。これらの方法は主に 2 つのカテゴリに分類できます。i) LLM が理解できるキューを設計することを目的とした微調整を必要とせず、事前トレーニングされた LLM にグラフ指向のタスクの実行を直接促す方法。ii) 微調整を必要とする方法。 -チューニング、に焦点を当てる グラフは特定の方法でシーケンスに変換され、グラフのトークンのシーケンスと自然言語のトークンのシーケンスは微調整方法によって調整されます。

Pendekatan tanpa penalaan halus: Memandangkan ciri struktur unik data graf, dua cabaran utama timbul: pertama, untuk membina graf secara berkesan dalam format bahasa semula jadi kedua, untuk menentukan sama ada model bahasa besar (LLM) boleh memahami dengan tepat bentuk bahasa mewakili struktur graf. Untuk menangani isu ini, sekumpulan penyelidik membangunkan kaedah bebas penalaan untuk memodelkan dan menaakul tentang graf dalam ruang teks tulen, dengan itu meneroka potensi LLM yang telah terlatih dalam meningkatkan pemahaman struktur.

Kaedah yang memerlukan penalaan halus: Disebabkan oleh had penggunaan teks biasa untuk menyatakan maklumat struktur graf, kaedah arus perdana terkini ialah menggunakan graf sebagai urutan token nod dan urutan token bahasa semula jadi apabila memasukkan graf ke dalam model bahasa besar (LLMs). Berbeza daripada GNN yang disebut di atas sebagai kaedah awalan, satu-satunya kaedah LLM yang perlu dilaraskan meninggalkan pengekod graf dan sebaliknya menggunakan perihalan teks khusus untuk menggambarkan struktur graf dan gesaan direka dengan teliti dalam gesaan, yang berkaitan dengan pelbagai hiliran graf prestasi yang menjanjikan telah dicapai dalam misi.

3 Hala tuju penyelidikan masa depan

Semakan ini juga membincangkan beberapa isu terbuka dan hala tuju penyelidikan masa depan yang berpotensi untuk model bahasa besar dalam bidang graf:

Gabungan graf berbilang modal dan model bahasa besar (LLM). Penyelidikan terkini menunjukkan bahawa model bahasa yang besar telah menunjukkan keupayaan luar biasa dalam memproses dan memahami data berbilang modal seperti imej dan video. Kemajuan ini menyediakan peluang baharu untuk menggabungkan LLM dengan data peta pelbagai mod yang mengandungi berbilang ciri modal. Membangunkan LLM multimodal yang mampu memproses data graf sedemikian akan membolehkan kami menjalankan inferens yang lebih tepat dan komprehensif pada struktur graf berdasarkan pertimbangan komprehensif berbilang jenis data seperti teks, penglihatan dan pendengaran.

Meningkatkan kecekapan dan mengurangkan kos pengkomputeran. Pada masa ini, kos pengiraan yang tinggi yang terlibat dalam fasa latihan dan inferens LLM telah menjadi halangan utama dalam pembangunan mereka, menyekat keupayaan mereka untuk memproses data graf berskala besar yang mengandungi berjuta-juta nod. Apabila cuba menggabungkan LLM dengan rangkaian neural graf (GNN), cabaran ini menjadi lebih teruk disebabkan gabungan dua model berkuasa. Oleh itu, terdapat keperluan mendesak untuk menemui dan melaksanakan strategi yang berkesan untuk mengurangkan kos pengiraan latihan LLM dan GNN Ini bukan sahaja akan membantu mengurangkan had semasa, tetapi juga akan memperluaskan lagi skop aplikasi LLM dalam tugas berkaitan graf. dengan itu meningkatkan peranan mereka dalam sains data dan pengaruh dalam bidang.

Mengatasi tugasan graf yang pelbagai. Kaedah penyelidikan semasa tertumpu terutamanya pada tugas berkaitan graf tradisional, seperti ramalan pautan dan klasifikasi nod. Walau bagaimanapun, dengan mengambil kira keupayaan berkuasa LLM, adalah perlu untuk meneroka potensi mereka dalam memproses tugasan yang lebih kompleks dan generatif, seperti penjanaan graf, pemahaman graf dan jawapan soalan berasaskan graf. Dengan memperluaskan kaedah berasaskan LLM untuk menampung tugas yang kompleks ini, kami akan membuka banyak peluang baharu untuk aplikasi LLM dalam bidang yang berbeza. Sebagai contoh, dalam bidang penemuan dadah, LLM boleh memudahkan penjanaan struktur molekul baru dalam bidang analisis rangkaian sosial, mereka boleh memberikan pandangan yang mendalam tentang corak hubungan yang kompleks dalam bidang pembinaan graf pengetahuan, LLM boleh membantu mencipta; asas pengetahuan yang lebih komprehensif dan tepat mengikut konteks.

Bina ejen graf yang mesra pengguna. Pada masa ini, kebanyakan ejen berasaskan LLM yang direka untuk tugas berkaitan graf disesuaikan untuk satu tugasan. Ejen ini biasanya beroperasi dalam mod satu pukulan dan direka bentuk untuk menyelesaikan masalah sekali gus. Walau bagaimanapun, ejen berasaskan LLM yang ideal harus mesra pengguna dan berupaya mencari jawapan secara dinamik dalam data graf sebagai tindak balas kepada pelbagai soalan terbuka yang dikemukakan oleh pengguna. Untuk mencapai matlamat ini, kita perlu membangunkan ejen yang fleksibel dan teguh, mampu berinteraksi berulang dengan pengguna dan mahir mengendalikan kerumitan data graf untuk memberikan jawapan yang tepat dan relevan. Ini memerlukan ejen bukan sahaja untuk menyesuaikan diri, tetapi juga untuk menunjukkan keteguhan yang kuat.

4 Ringkasan

Semakan ini menjalankan perbincangan mendalam tentang model bahasa berskala besar (LLM) yang disesuaikan untuk data graf, dan mencadangkan kaedah pengelasan berdasarkan rangka kerja inferens berasaskan model, membahagikan model berbeza kepada empat jenis dengan teliti Reka bentuk bingkai yang unik. Setiap reka bentuk membentangkan kekuatan dan batasan uniknya sendiri. Bukan itu sahaja, semakan ini juga menyediakan perbincangan menyeluruh tentang ciri-ciri ini, meneroka potensi dan cabaran setiap rangka kerja secara mendalam apabila menangani tugas pemprosesan data graf. Kerja penyelidikan ini bertujuan untuk menyediakan sumber rujukan kepada penyelidik yang berminat untuk meneroka dan menggunakan model bahasa berskala besar untuk menyelesaikan masalah berkaitan graf, dan diharapkan akhirnya melalui kerja ini, ia akan menggalakkan pemahaman yang lebih mendalam tentang aplikasi LLM dan data graf, dan seterusnya Menghasilkan inovasi dan penemuan teknologi dalam bidang ini.

Atas ialah kandungan terperinci KDD 2024|Pasukan Hong Kong Rhubarb Chao menganalisis dengan mendalam 'sempadan tidak diketahui' model besar dalam bidang pembelajaran mesin graf. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI