Rumah >Peranti teknologi >AI >Tindakan pertama Ilya selepas meninggalkan kerjanya: Suka kertas ini, dan netizen bergegas membacanya

Tindakan pertama Ilya selepas meninggalkan kerjanya: Suka kertas ini, dan netizen bergegas membacanya

- PHPzasal

- 2024-06-12 11:22:14749semak imbas

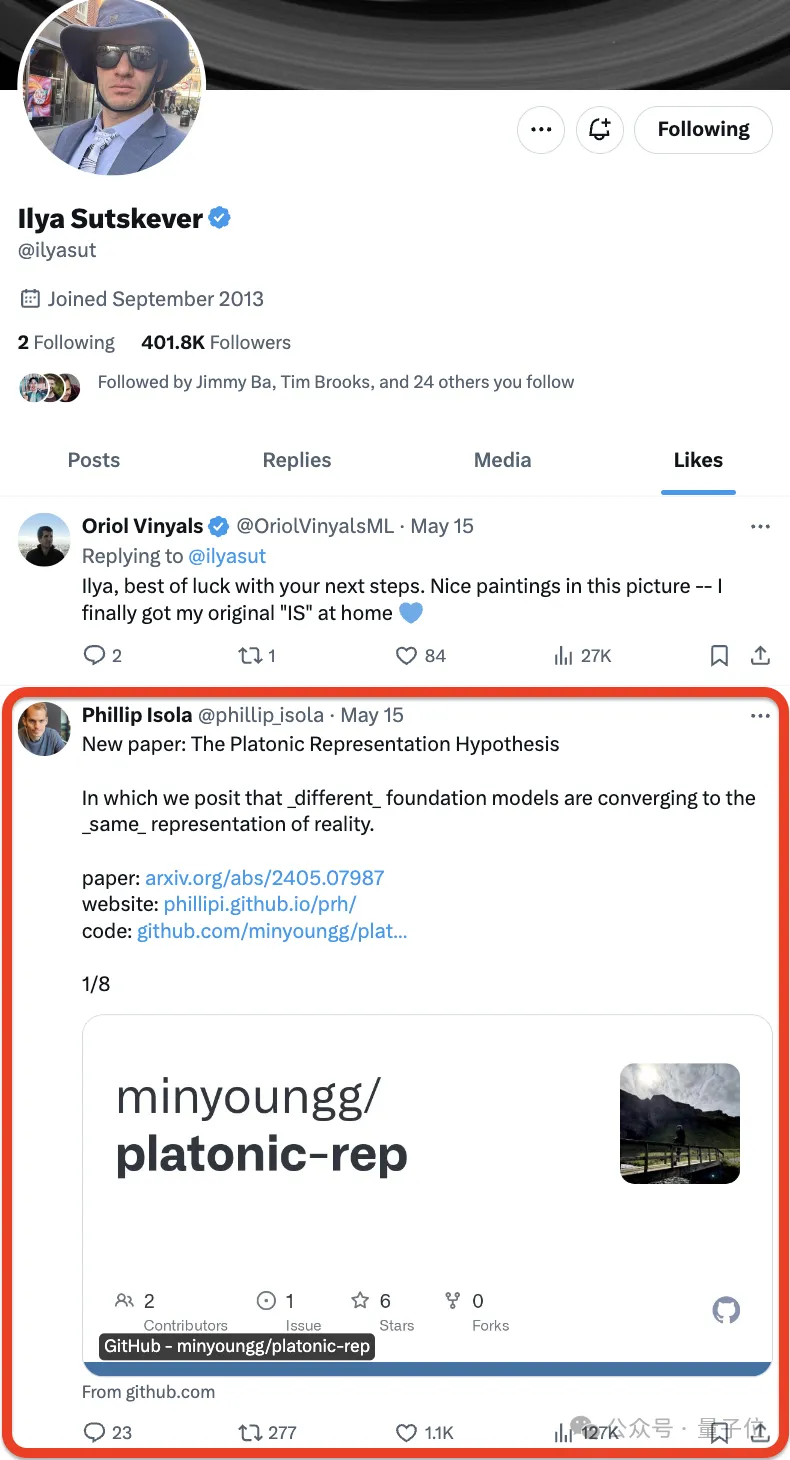

Sejak Ilya Sutskever secara rasmi mengumumkan peletakan jawatannya daripada OpenAI, langkah seterusnya telah menjadi tumpuan semua orang.

Ada juga yang memerhatikan setiap gerak-gerinya. . boleh diringkaskan dalam satu ayat seperti ini:

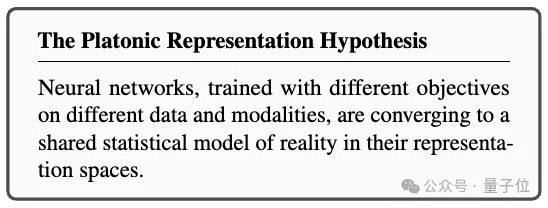

Rangkaian saraf dilatih dengan matlamat yang berbeza pada data dan modaliti yang berbeza, dan cenderung membentuk ruang perwakilan yang dikongsi dalam model statistik dunia sebenar .

Hipotesis Perwakilan Platonik

, merujuk kepada Alegori Gua Plato dan ideanya tentang sifat realiti ideal. Pemilihan Ilya masih dijamin. ringkaskan, ayat pembukaan "Karenina": Semua model bahasa gembira adalah serupa, dan setiap model bahasa yang malang mempunyai nasib malangnya sendiri.

Representational ConvergenceKami juga melihat, dan kandungan umum ialah:

Pengarang menganalisis

(Representational Convergence)

(Representational Convergence)

Apakah yang mendorong penumpuan ini? Adakah trend ini akan berterusan? Di manakah destinasi terakhirnya?

Selepas beberapa siri analisis dan eksperimen, para penyelidik membuat spekulasi bahawa penumpuan ini mempunyai titik akhir dan prinsip pemacu:Model yang berbeza berusaha untuk mencapai gambaran realiti yang tepat .

.

Sebuah gambar untuk diterangkan:

di mana imej

(X) dan teks  (Y)

(Y)

(Z)

. Para penyelidik membuat spekulasi bahawa algoritma pembelajaran perwakilan akan menumpu kepada perwakilan bersatu Z, dan peningkatan dalam saiz model serta kepelbagaian data dan tugasan adalah faktor utama yang mendorong penumpuan ini. Saya cuma boleh katakan itu memang soalan yang Ilya minat. Terlalu mendalam dan kami tak faham sangat Jom minta AI tolong tafsirkan dan kongsikan dengan semua orang~

Saya cuma boleh katakan itu memang soalan yang Ilya minat. Terlalu mendalam dan kami tak faham sangat Jom minta AI tolong tafsirkan dan kongsikan dengan semua orang~

. Bukti yang mewakili penumpuanPertama sekali, penulis saya menganalisis sejumlah besar kajian berkaitan terdahulu, dan juga menjalankan eksperimen sendiri, dan menghasilkan satu siri bukti penumpuan, menunjukkan penumpuan, skala dan prestasi, dan penumpuan silang mod daripada model yang berbeza.

Ps: Penyelidikan ini memfokuskan kepada perwakilan pembenaman vektor, iaitu, data ditukar kepada bentuk vektor, dan persamaan atau jarak antara titik data diterangkan oleh fungsi kernel. Konsep "penjajaran perwakilan" dalam artikel ini bermakna jika dua kaedah perwakilan yang berbeza mendedahkan struktur data yang serupa, maka kedua-dua perwakilan itu dianggap sebagai diselaraskan.

1. Konvergensi model yang berbeza dengan seni bina dan matlamat yang berbeza cenderung konsisten dalam perwakilan asasnya.

Bilangan sistem yang dibina berdasarkan model asas pra-latihan semakin meningkat secara beransur-ansur, dan beberapa model menjadi seni bina teras standard untuk berbilang tugas. Kebolehgunaan luas ini dalam pelbagai aplikasi mencerminkan fleksibiliti tertentu mereka dalam kaedah perwakilan data.

Walaupun trend ini menunjukkan bahawa sistem AI sedang menumpu ke arah set model asas yang lebih kecil, ia tidak membuktikan bahawa model asas yang berbeza akan membentuk perwakilan yang sama.

Walau bagaimanapun, beberapa penyelidikan terkini berkaitan jahitan model(jahitan model) mendapati bahawa perwakilan lapisan tengah model pengelasan imej boleh diselaraskan dengan baik walaupun dilatih pada set data yang berbeza.

Sebagai contoh, beberapa penyelidikan mendapati bahawa lapisan awal rangkaian konvolusi yang dilatih pada set data ImageNet dan Places365 boleh ditukar ganti, menunjukkan bahawa mereka mempelajari perwakilan visual awal yang serupa. Terdapat juga kajian yang telah menemui sejumlah besar "Rosetta Neurons", iaitu neuron dengan corak pengaktifan yang sangat serupa dalam model visual yang berbeza...

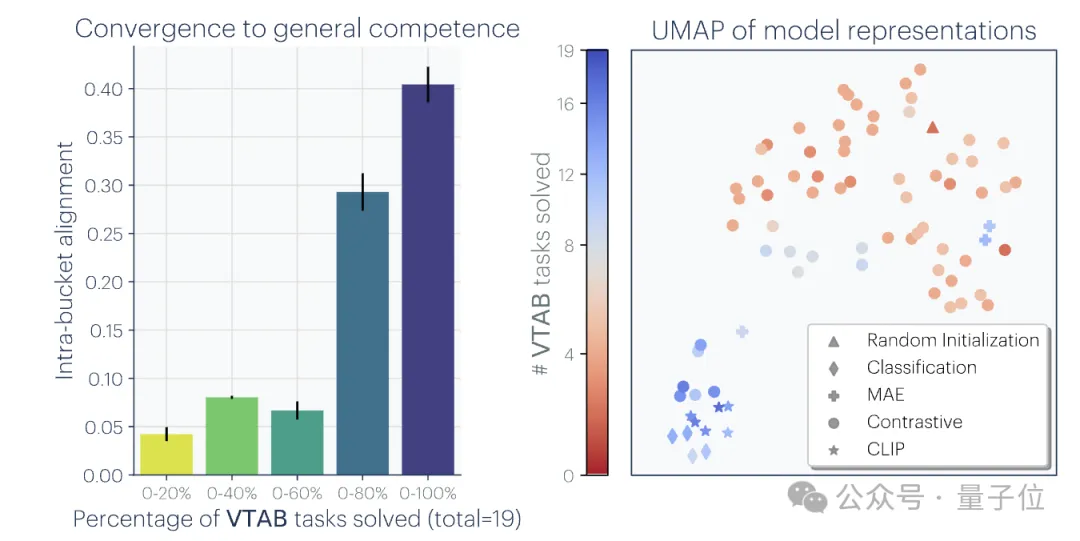

2 Lebih besar saiz dan prestasi model, lebih baik representasinya Semakin tinggi penjajaran.

Para penyelidik mengukur penjajaran 78 modelmenggunakan kaedah jiran terdekat bersama pada dataset Places-365 dan menilai prestasi tugas hiliran mereka pada penanda aras penyesuaian tugas visi VTAB.

3. Penumpuan perwakilan model dalam mod yang berbeza.

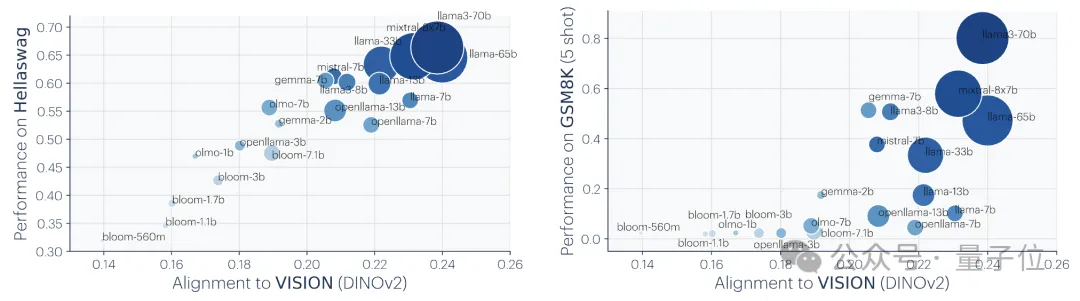

Penyelidik menggunakan kaedah jiran terdekat bersama untuk mengukur penjajaran pada dataset imej Wikipedia WIT. Hasilnya mendedahkan hubungan linear antara penjajaran visual bahasa dan skor pemodelan bahasa, dengan trend umum ialah model bahasa yang lebih berkebolehan diselaraskan dengan lebih baik dengan model visual yang lebih berkebolehan.

4. Model dan perwakilan otak juga menunjukkan tahap ketekalan tertentu, mungkin disebabkan oleh data dan kekangan tugas yang serupa.

Pada tahun 2014, satu kajian mendapati bahawa pengaktifan lapisan tengah rangkaian saraf sangat berkorelasi dengan corak pengaktifan kawasan visual otak, mungkin kerana menghadapi tugas visual dan kekangan data yang serupa. Sejak itu, kajian selanjutnya mendapati bahawa menggunakan data latihan yang berbeza akan menjejaskan penjajaran perwakilan otak dan model. Penyelidikan psikologi juga mendapati bahawa cara manusia melihat persamaan visual sangat konsisten dengan model rangkaian saraf.5. Tahap penjajaran perwakilan model berkorelasi positif dengan prestasi tugas hiliran.

Para penyelidik menggunakan dua tugas hiliran untuk menilai prestasi model: Hellaswag(penaakulan akal) dan GSM8K (matematik) . Dan gunakan model DINOv2 sebagai rujukan untuk mengukur penjajaran model bahasa lain dengan model visual.

Hasil eksperimen menunjukkan bahawa model bahasa yang lebih sejajar dengan model visual juga berprestasi lebih baik pada tugas Hellaswag dan GSM8K. Hasil visualisasi menunjukkan bahawa terdapat korelasi positif yang jelas antara tahap penjajaran dan prestasi tugas hiliran.

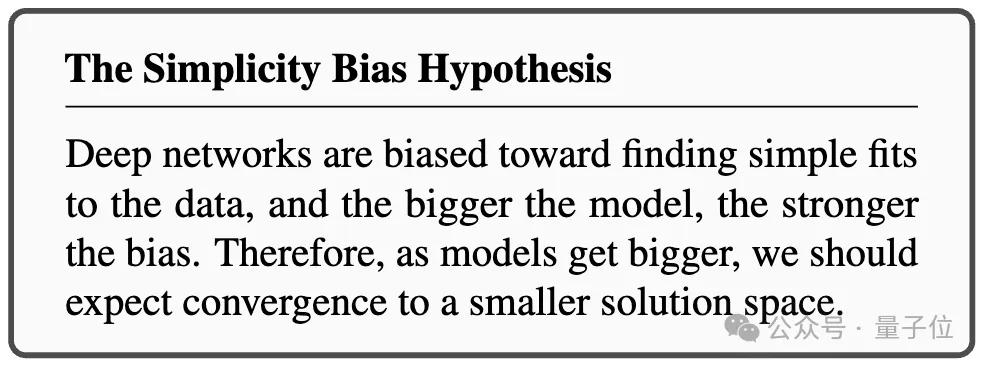

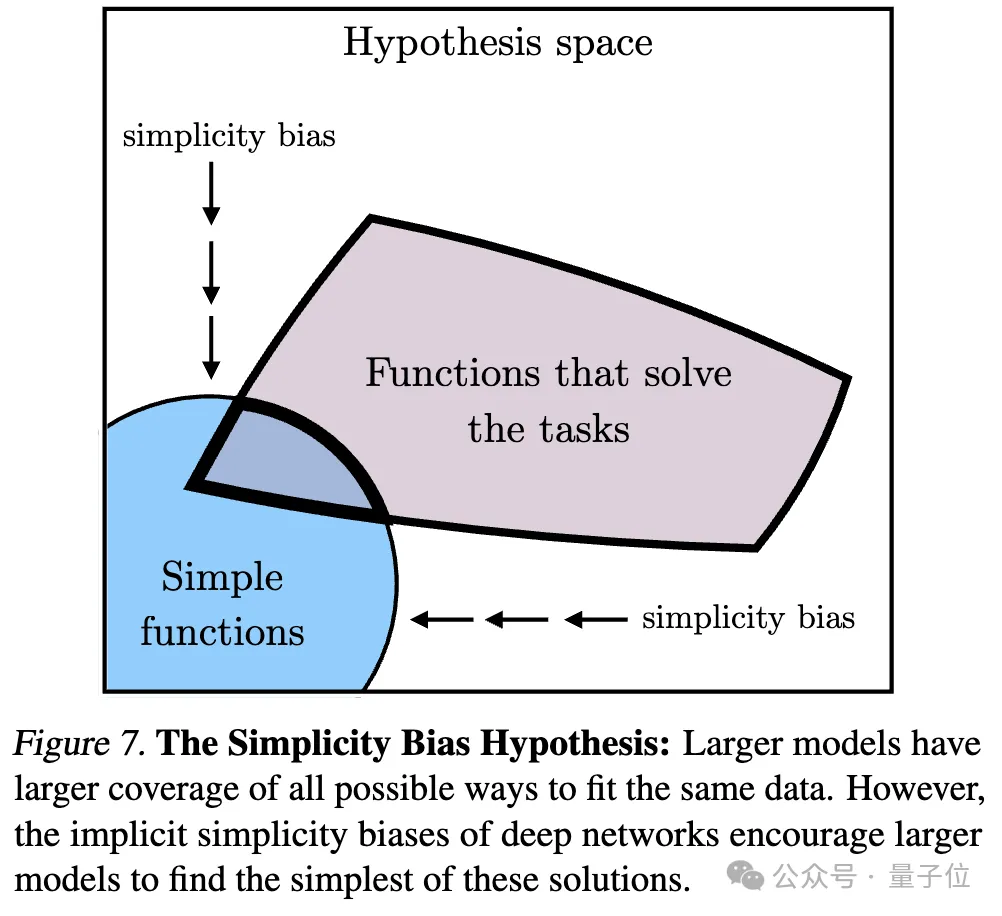

1. Convergence via Task Generality (Convergence via Task Generality)

Memandangkan model dilatih untuk menyelesaikan lebih banyak tugas, mereka perlu mencari perwakilan yang boleh memenuhi keperluan semua tugasan🜎 Bilangan perwakilan untuk tugasan N adalah kurang daripada bilangan perwakilan yang mampu untuk tugasan M (M . Oleh itu, apabila kesukaran tugasan meningkat, perwakilan model cenderung untuk menumpu kepada penyelesaian yang lebih baik dan lebih sedikit.

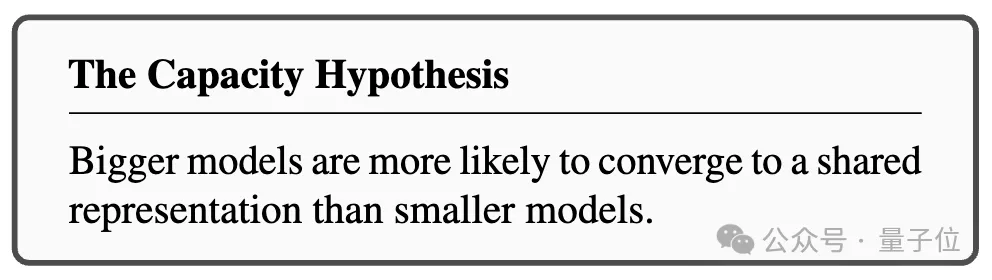

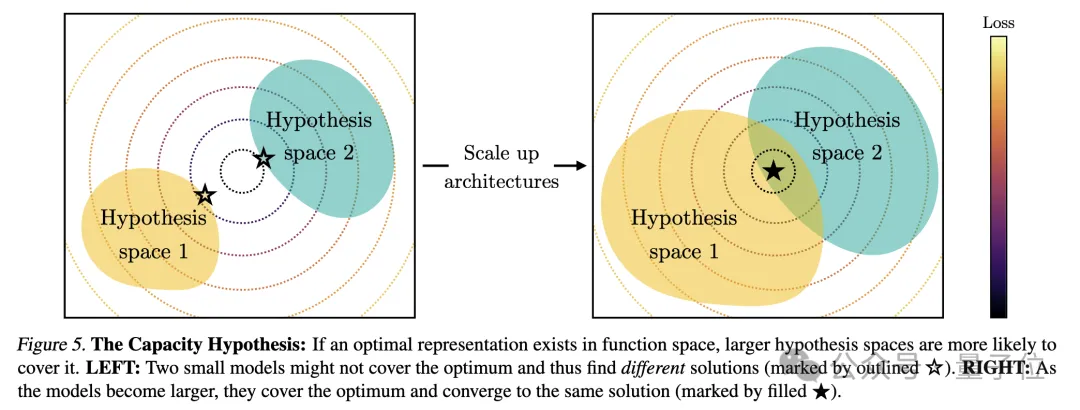

Iaitu, model yang lebih besar mempunyai liputan yang lebih luas dan dapat memuatkan data yang sama dalam semua cara yang mungkin. Walau bagaimanapun, keutamaan kesederhanaan tersirat rangkaian dalam menggalakkan model yang lebih besar untuk mencari penyelesaian yang paling mudah ini. .

Iaitu, model AI yang berbeza, walaupun dilatih pada data dan sasaran yang berbeza, ruang perwakilan mereka menumpu pada model statistik biasa yang mewakili dunia sebenar yang menjana data yang kami perhatikan.

Mereka mula-mula membina model dunia acara diskret yang ideal. Dunia mengandungi siri peristiwa diskret Z, setiap peristiwa diambil sampel daripada taburan P(Z) yang tidak diketahui. Setiap peristiwa boleh diperhatikan dengan cara yang berbeza melalui fungsi pemerhatian obs, seperti piksel, bunyi, teks, dsb.

Mereka mula-mula membina model dunia acara diskret yang ideal. Dunia mengandungi siri peristiwa diskret Z, setiap peristiwa diambil sampel daripada taburan P(Z) yang tidak diketahui. Setiap peristiwa boleh diperhatikan dengan cara yang berbeza melalui fungsi pemerhatian obs, seperti piksel, bunyi, teks, dsb.

Seterusnya, pengarang mempertimbangkan kelas algoritma pembelajaran kontrastif yang cuba mempelajari perwakilan fX supaya hasil darab dalam fX(xa) dan fX(xb) menghampiri xa dan ) nisbah kemungkinan log

kepada log kemungkinan menjadi pasangan sampel negatif (diambil secara rawak)  .

.

Selepas derivasi matematik, penulis mendapati bahawa jika data cukup lancar, algoritma jenis ini akan menumpu kepada fungsi kernel iaitu titik maklumat bersama (PMI) xa dan xb

Perwakilan kernel fX.

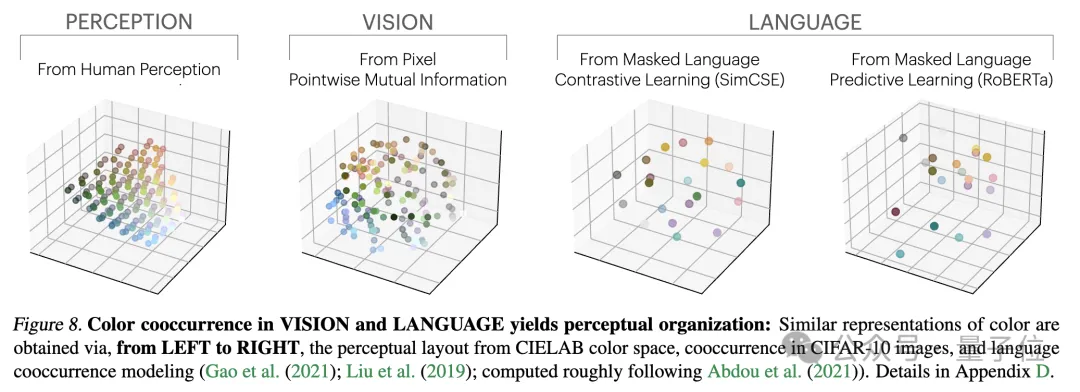

Pengkaji menguji teori ini melalui kajian empirikal tentang warna. Sama ada perwakilan warna dipelajari daripada statistik kejadian bersama piksel bagi imej atau statistik kejadian bersama perkataan bagi teks, jarak warna yang terhasil adalah serupa dengan persepsi manusia, dan apabila saiz model bertambah, persamaan ini menjadi lebih tinggi dan lebih tinggi.

Ini selaras dengan analisis teori, iaitu keupayaan model yang lebih besar boleh memodelkan statistik data pemerhatian dengan lebih tepat, dengan itu memperoleh kernel PMI yang lebih dekat dengan perwakilan acara yang ideal.

Beberapa pemikiran akhir

Di penghujung kertas kerja, penulis merumuskan potensi kesan penumpuan perwakilan pada bidang AI dan hala tuju penyelidikan masa depan, serta potensi had dan pengecualian kepada andaian perwakilan Platonik.

Mereka menegaskan bahawa apabila saiz model meningkat, kemungkinan kesan penumpuan perwakilan termasuk tetapi tidak terhad kepada:

- Walaupun hanya menskalakan boleh meningkatkan prestasi, kaedah yang berbeza mempunyai perbezaan dalam kecekapan penskalaan.

- Jika terdapat perwakilan Platonik yang bebas modaliti, maka data daripada modaliti yang berbeza harus dilatih bersama untuk mencari perwakilan bersama ini. Ini menjelaskan mengapa adalah berfaedah untuk menambah data visual pada latihan model bahasa dan sebaliknya.

- Penukaran antara perwakilan sejajar hendaklah agak mudah, yang mungkin menjelaskan: penjanaan bersyarat lebih mudah daripada penjanaan tanpa syarat, dan penukaran merentas mod juga boleh dicapai tanpa data berpasangan.

- Pertambahan saiz model mungkin mengurangkan kecenderungan model bahasa untuk mengada-adakan kandungan dan beberapa biasnya, menjadikannya lebih tepat mencerminkan bias dalam data latihan dan bukannya memburukkan lagi.

Pengarang menekankan bahawa premis impak di atas ialah data latihan model masa hadapan mestilah cukup pelbagai dan tidak rugi untuk benar-benar menumpu kepada perwakilan yang mencerminkan undang-undang statistik dunia sebenar.

Pada masa yang sama, penulis juga menyatakan bahawa data modaliti berbeza mungkin mengandungi maklumat unik, yang mungkin menyukarkan untuk mencapai penumpuan perwakilan lengkap walaupun saiz model meningkat. Di samping itu, tidak semua perwakilan sedang menumpu Sebagai contoh, tiada cara piawai untuk mewakili negeri dalam bidang robotik. Penyelidik dan keutamaan komuniti boleh membawa model untuk menumpu ke arah perwakilan manusia, dengan itu mengabaikan bentuk kecerdasan lain yang mungkin.

Dan sistem pintar yang direka khusus untuk tugasan tertentu mungkin tidak menumpu kepada perwakilan yang sama seperti kecerdasan am.

Pengarang juga menekankan bahawa kaedah mengukur penjajaran perwakilan adalah kontroversi dan kaedah pengukuran yang berbeza mungkin membawa kepada kesimpulan yang berbeza. Walaupun perwakilan model berbeza adalah serupa, jurang masih perlu dijelaskan, dan pada masa ini mustahil untuk menentukan sama ada jurang ini penting.

Untuk butiran lanjut dan kaedah penghujahan, saya akan siarkan kertas kerja di sini~

Pautan kertas: https://arxiv.org/abs/2405.07987

Atas ialah kandungan terperinci Tindakan pertama Ilya selepas meninggalkan kerjanya: Suka kertas ini, dan netizen bergegas membacanya. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- 怎么删除数据透视表

- Google juga melakukannya? Bard didedahkan menggunakan data ChatGPT untuk latihan Model besar itu benar-benar ketinggalan langkah demi langkah.

- Pengumuman rasmi Pusat Pengkomputeran Super Haimo: model besar dengan 100 bilion parameter, skala data 1 juta klip dan pengurangan 200 kali ganda dalam kos latihan

- Kajian semula kerajaan pertama bagi ChatGPT mungkin datang daripada Suruhanjaya Perdagangan Persekutuan AS, OpenAI: belum terlatih GPT5