Rumah >Peranti teknologi >AI >YOLOv10 ada di sini! Pengesanan sasaran hujung ke hujung masa nyata sebenar

YOLOv10 ada di sini! Pengesanan sasaran hujung ke hujung masa nyata sebenar

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBasal

- 2024-06-09 17:29:311185semak imbas

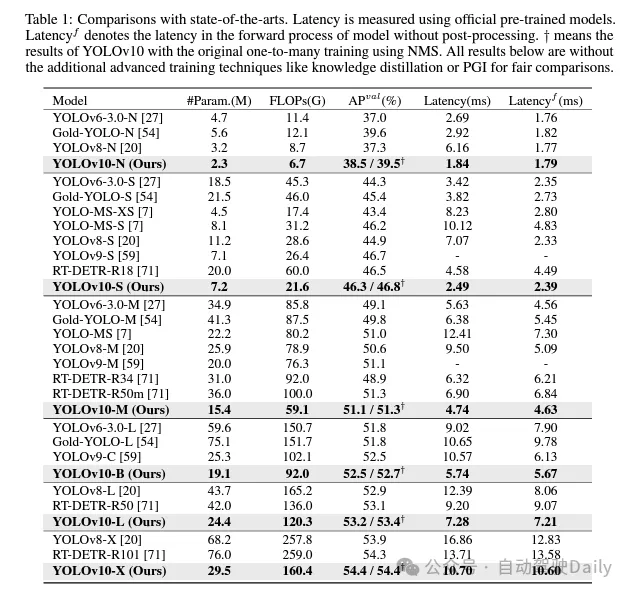

Dalam beberapa tahun kebelakangan ini, YOLO telah menjadi paradigma arus perdana dalam bidang pengesanan objek masa nyata kerana keseimbangannya yang berkesan antara kos pengiraan dan prestasi pengesanan. Penyelidik telah menjalankan penerokaan mendalam tentang reka bentuk struktur, matlamat pengoptimuman, strategi peningkatan data, dsb. YOLO dan telah mencapai kemajuan yang ketara. Walau bagaimanapun, pergantungan pasca pemprosesan pada penindasan bukan maksimum (NMS) menghalang penggunaan YOLO hujung ke hujung dan memberi kesan negatif kependaman inferens. Tambahan pula, reka bentuk pelbagai komponen dalam YOLO tidak mempunyai semakan yang komprehensif dan menyeluruh, mengakibatkan redundansi pengiraan yang ketara dan mengehadkan prestasi model. Ini menghasilkan kecekapan yang tidak optimum, dan potensi besar untuk peningkatan prestasi. Dalam kerja ini, kami berhasrat untuk memajukan lagi sempadan kecekapan prestasi YOLO daripada kedua-dua pasca pemprosesan dan seni bina model. Untuk tujuan ini, kami mula-mula mencadangkan peruntukan dwi yang berterusan untuk latihan YOLO tanpa NMS, yang pada masa yang sama membawa prestasi kompetitif dan kependaman inferens yang rendah. Tambahan pula, kami memperkenalkan strategi reka bentuk model yang didorong oleh ketepatan kecekapan yang komprehensif untuk YOLO. Kami telah mengoptimumkan secara menyeluruh setiap komponen YOLO dari perspektif kecekapan dan ketepatan, yang sangat mengurangkan overhed pengiraan dan meningkatkan keupayaan model. Hasil daripada usaha kami ialah generasi baharu siri YOLO yang direka untuk pengesanan objek hujung ke hujung masa nyata, yang dipanggil YOLOv10. Eksperimen yang meluas menunjukkan bahawa YOLOv10 mencapai prestasi dan kecekapan terkini pada pelbagai skala model. Sebagai contoh, pada set data COCO, YOLOv10-S kami adalah 1.8 kali lebih pantas daripada RT-DETR-R18 di bawah AP yang serupa, sambil mengurangkan parameter dan operasi titik terapung (FLOP) sebanyak 2.8 kali. Berbanding dengan YOLOv9-C, YOLOv10-B mengurangkan kependaman sebanyak 46% dan mengurangkan parameter sebanyak 25% di bawah prestasi yang sama. Pautan kod: https://github.com/THU-MIG/yolov10.

Apakah penambahbaikan yang terdapat dalam YOLOv10?

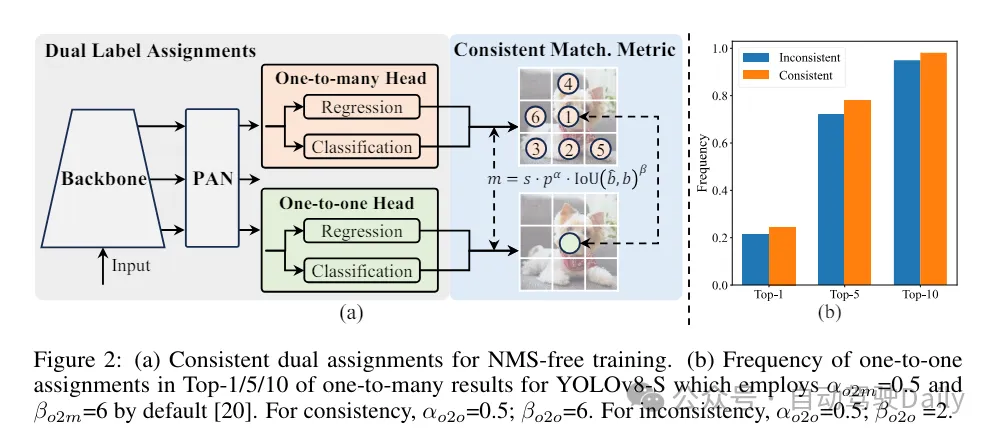

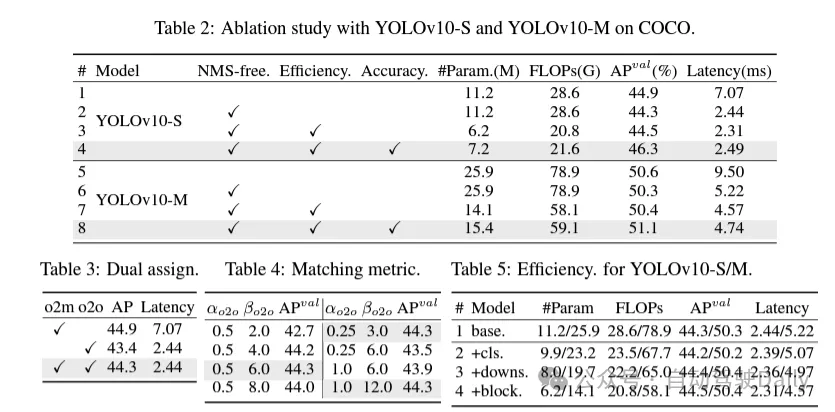

Pertama-tama selesaikan masalah ramalan yang berlebihan dalam pasca pemprosesan dengan mencadangkan strategi dua peruntukan yang berterusan untuk YOLO tanpa NMS. Strategi ini termasuk tugasan dwi label dan metrik padanan yang konsisten. Ini membolehkan model memperoleh penyeliaan yang kaya dan harmoni semasa latihan sambil menghapuskan keperluan untuk NMS semasa inferens, mencapai prestasi kompetitif sambil mengekalkan kecekapan tinggi.

Kali ini, strategi reka bentuk model dipacu kecekapan-ketepatan yang komprehensif dicadangkan untuk seni bina model, dan setiap komponen dalam YOLO diperiksa secara menyeluruh. Dari segi kecekapan, kepala pengelasan ringan, pensampelan bawah gandingan saluran ruang dan reka bentuk blok berpandukan pangkat dicadangkan untuk mengurangkan lebihan pengiraan yang jelas dan mencapai seni bina yang lebih cekap.

Dari segi ketepatan, konvolusi kernel yang besar diterokai dan modul separa perhatian diri yang berkesan dicadangkan untuk meningkatkan keupayaan model dan memanfaatkan potensi peningkatan prestasi pada kos yang rendah.

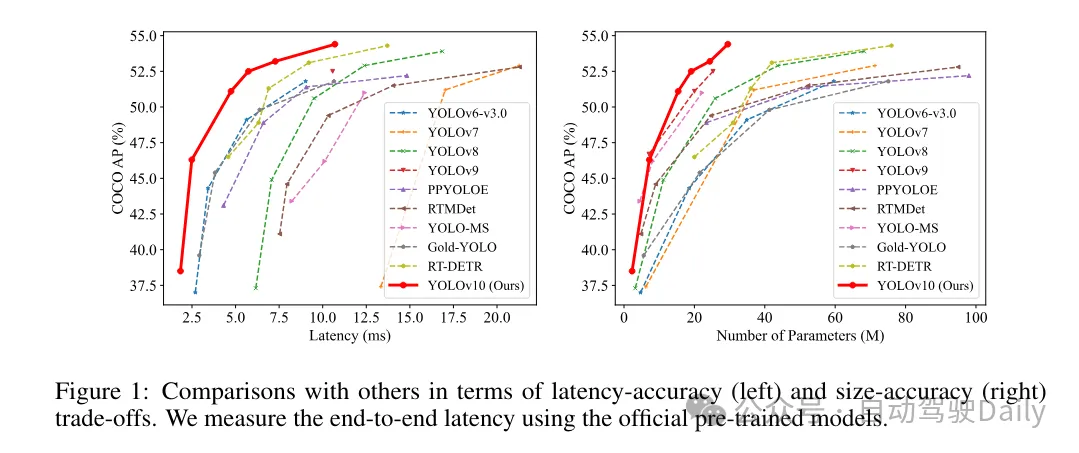

Berdasarkan kaedah ini, penulis berjaya melaksanakan satu siri pengesan hujung ke hujung masa nyata dengan saiz model yang berbeza, iaitu YOLOv10-N/S/M/B/L/X. Eksperimen yang meluas pada penanda aras pengesanan objek standard menunjukkan bahawa YOLOv10 menunjukkan keupayaan untuk mengatasi prestasi model terkini dari segi pertukaran ketepatan pengiraan pada pelbagai saiz model. Seperti yang ditunjukkan dalam Rajah 1, di bawah prestasi yang sama, YOLOv10-S/X masing-masing adalah 1.8 kali/1.3 kali lebih pantas daripada RT-DETR R18/R101. Berbanding dengan YOLOv9-C, YOLOv10-B mencapai 46% pengurangan kependaman di bawah prestasi yang sama. Di samping itu, YOLOv10 menunjukkan kecekapan penggunaan parameter yang sangat tinggi. YOLOv10-L/X ialah 0.3 AP dan 0.5 AP lebih tinggi daripada YOLOv8-L/X dengan bilangan parameter dikurangkan masing-masing sebanyak 1.8 kali dan 2.3 kali. YOLOv10-M mencapai AP yang serupa dengan YOLOv9-M/YOLO-MS sambil mengurangkan bilangan parameter masing-masing sebanyak 23% dan 31%.

Semasa proses latihan, YOLO biasanya menggunakan TAL (Pembelajaran Tugasan Tugasan) untuk memberikan berbilang sampel kepada setiap kejadian. Mengguna pakai kaedah peruntukan satu kepada banyak menjana isyarat penyeliaan yang kaya, yang membantu mengoptimumkan dan mencapai prestasi yang lebih kukuh. Walau bagaimanapun, ini juga menjadikan YOLO mesti bergantung pada NMS (penindasan bukan maksimum) pasca pemprosesan, yang menghasilkan kecekapan inferens suboptimum pada masa penggunaan. Walaupun kerja-kerja terdahulu telah meneroka pendekatan padanan satu-dengan-satu untuk menyekat ramalan berlebihan, mereka sering menambah overhed inferens tambahan atau menghasilkan prestasi suboptimum. Dalam kerja ini, kami mencadangkan strategi latihan bebas NMS yang menggunakan tugasan dwi label dan metrik padanan yang konsisten, mencapai kecekapan tinggi dan prestasi daya saing. Melalui strategi ini, YOLO kami tidak lagi memerlukan NMS dalam latihan, mencapai kecekapan tinggi dan prestasi kompetitif.

Reka bentuk model dipacu kecekapan. Komponen dalam YOLO termasuk batang, lapisan pensampelan bawah, peringkat dengan blok binaan asas, dan kepala. Kos pengiraan bahagian tulang belakang adalah sangat rendah, jadi kami melaksanakan reka bentuk model dipacu kecekapan untuk tiga bahagian yang lain.

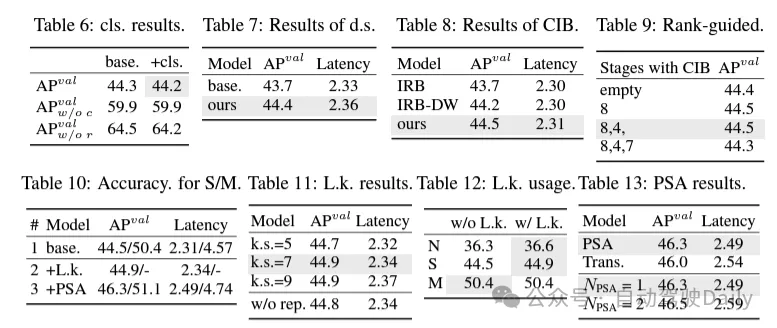

(1) Pengepala pengelasan ringan. Dalam YOLO, kepala klasifikasi dan kepala regresi biasanya mempunyai seni bina yang sama. Walau bagaimanapun, mereka mempunyai perbezaan yang ketara dalam overhed pengiraan. Sebagai contoh, dalam YOLOv8-S, bilangan FLOP dan parameter kepala pengelasan (5.95G/1.51M FLOP dan parameter) dan kepala regresi (2.34G/0.64M) ialah 2.5 kali dan 2.4 kali ganda daripada regresi kepala masing-masing. Walau bagaimanapun, dengan menganalisis kesan ralat klasifikasi dan ralat regresi (lihat Jadual 6), kami mendapati bahawa kepala regresi adalah lebih penting kepada prestasi YOLO. Oleh itu, kita boleh mengurangkan overhed pengepala pengelasan tanpa perlu risau tentang kemudaratan prestasi. Oleh itu, kami hanya mengguna pakai seni bina kepala pengelasan ringan, yang terdiri daripada dua konvolusi yang boleh dipisahkan secara mendalam dengan saiz kernel 3 × 3, diikuti dengan kernel 1 × 1. Melalui penambahbaikan di atas, kita boleh memudahkan seni bina kepala pengelasan ringan, yang terdiri daripada dua konvolusi boleh dipisahkan dalam dengan saiz kernel lilitan 3 × 3, diikuti dengan kernel lilitan 1 × 1. Seni bina yang dipermudahkan ini boleh mencapai fungsi klasifikasi dengan overhed pengiraan yang lebih kecil dan bilangan parameter.

(2) Pensampelan nyahgandingan saluran ruang. YOLO biasanya menggunakan lilitan piawai 3×3 biasa dengan langkah 2, sambil melaksanakan pensampelan bawah spatial (dari H × W ke H/2 × W/2) dan transformasi saluran (dari C ke 2C). Ini memperkenalkan kos pengiraan dan kiraan parameter yang tidak boleh diabaikan. Sebaliknya, kami mencadangkan untuk memisahkan pengurangan ruang dan operasi pembesaran saluran untuk mencapai pensampelan turun yang lebih cekap. Khususnya, lilitan arah mata digunakan untuk memodulasi dimensi saluran, dan kemudian lilitan mendalam digunakan untuk pensampelan spatial. Ini mengurangkan kos pengiraan dan pengiraan parameter kepada . Pada masa yang sama, ia memaksimumkan pengekalan maklumat semasa pensampelan turun, dengan itu mengurangkan kependaman sambil mengekalkan prestasi kompetitif.

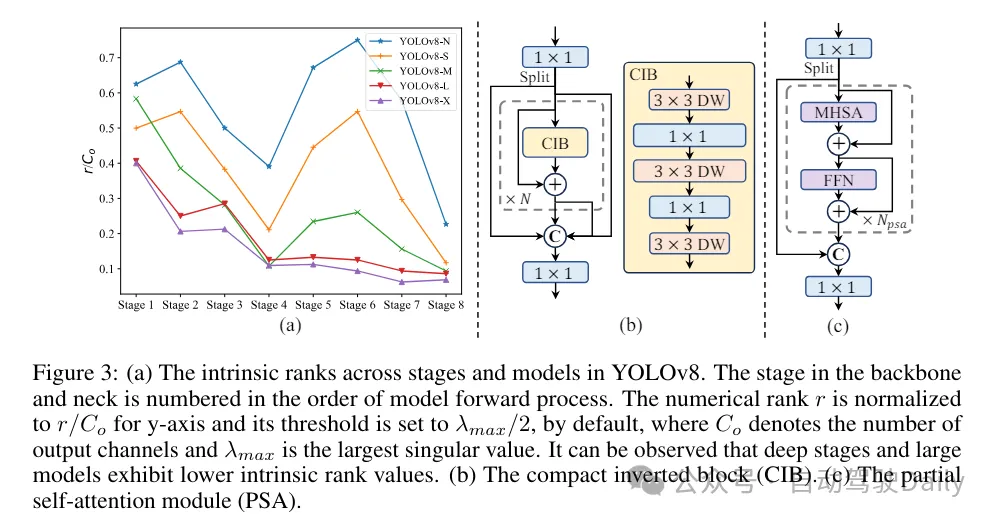

(3) Reka bentuk modul berdasarkan bimbingan pangkat. YOLO biasanya menggunakan blok binaan asas yang sama untuk semua peringkat, seperti blok kesesakan dalam YOLOv8. Untuk mengkaji secara menyeluruh reka bentuk isomorfik YOLO ini, kami menggunakan kedudukan intrinsik untuk menganalisis lebihan setiap peringkat. Secara khusus, kedudukan berangka bagi lilitan terakhir dalam blok asas terakhir dalam setiap peringkat dikira, yang mengira bilangan nilai tunggal yang lebih besar daripada ambang. Rajah 3(a) menunjukkan keputusan YOLOv8, menunjukkan bahawa peringkat dalam dan model besar lebih berkemungkinan menunjukkan lebihan redundansi. Pemerhatian ini menunjukkan bahawa hanya menggunakan reka bentuk blok yang sama pada semua peringkat adalah suboptimum untuk mencapai pertukaran kecekapan kapasiti terbaik. Untuk menyelesaikan masalah ini, skim reka bentuk modul berasaskan pangkat dicadangkan, yang bertujuan untuk mengurangkan kerumitan peringkat yang terbukti berlebihan melalui reka bentuk seni bina yang padat.

Kami mula-mula memperkenalkan struktur bongkah terbalik padat (CIB) yang menggunakan lilitan kedalaman yang murah untuk pencampuran ruang dan lilitan arah yang kos efektif untuk pencampuran saluran, seperti yang ditunjukkan dalam Rajah 3(b). Ia boleh berfungsi sebagai blok binaan asas yang berkesan, contohnya tertanam dalam struktur ELAN (Rajah 3(b)). Kemudian, strategi peruntukan modul berasaskan pangkat digalakkan untuk mencapai kecekapan optimum sambil mengekalkan kuasa daya saing. Khususnya, berdasarkan model, susun semua peringkat mengikut susunan menaik pangkat intrinsiknya. Periksa lebih lanjut perubahan prestasi selepas menggantikan blok asas peringkat utama dengan CIB. Jika tiada kemerosotan prestasi berbanding model yang diberikan, kami terus menggantikan peringkat seterusnya, jika tidak, hentikan proses tersebut. Hasilnya, kami boleh melaksanakan reka bentuk blok padat suai pada peringkat dan saiz model yang berbeza, mencapai kecekapan yang lebih tinggi tanpa menjejaskan prestasi.

Berdasarkan reka bentuk model berorientasikan ketepatan. Makalah ini meneroka lebih lanjut mekanisme konvolusi kernel besar dan perhatian kendiri untuk mencapai reka bentuk berasaskan ketepatan, bertujuan untuk meningkatkan prestasi pada kos yang minimum.

(1) Konvolusi isirong besar. Mengguna pakai lilitan dalam kernel besar ialah cara yang berkesan untuk mengembangkan medan penerimaan dan meningkatkan keupayaan model. Walau bagaimanapun, hanya mengeksploitasinya dalam semua peringkat boleh menyebabkan pencemaran dalam ciri cetek yang digunakan untuk mengesan objek kecil, sementara juga memperkenalkan overhed I/O yang ketara dan kependaman dalam peringkat resolusi tinggi. Oleh itu, penulis mencadangkan untuk menggunakan lilitan dalam kernel besar dalam blok maklumat antara peringkat (CIB) peringkat dalam. Di sini saiz kernel lilitan 3×3 mendalam kedua dalam CIB dinaikkan kepada 7×7. Selain itu, teknologi penyusunan semula struktur diguna pakai untuk memperkenalkan satu lagi cawangan konvolusi kedalaman 3×3 untuk mengurangkan masalah pengoptimuman tanpa meningkatkan overhed inferens. Tambahan pula, apabila saiz model bertambah, medan penerimaannya mengembang secara semula jadi, dan faedah menggunakan belitan kernel besar secara beransur-ansur berkurangan. Oleh itu, lilitan kernel besar hanya digunakan pada skala model kecil.

(2) Separa Perhatian Diri (PSA). Mekanisme perhatian diri digunakan secara meluas dalam pelbagai tugas visual kerana keupayaan pemodelan globalnya yang sangat baik. Walau bagaimanapun, ia mempamerkan kerumitan pengiraan yang tinggi dan jejak ingatan. Untuk menyelesaikan masalah ini, memandangkan redundansi kepala perhatian yang ada di mana-mana, penulis mencadangkan reka bentuk modul perhatian kendiri separa (PSA) yang cekap, seperti ditunjukkan dalam Rajah 3.(c). Secara khusus, ciri dibahagikan sama rata kepada dua bahagian mengikut saluran selepas lilitan 1×1. Hanya sebahagian daripada ciri dimasukkan ke dalam blok NPSA yang terdiri daripada modul perhatian diri berbilang kepala (MHSA) dan rangkaian suapan ke hadapan (FFN). Kemudian, kedua-dua bahagian ciri disambung dan dicantumkan melalui lilitan 1×1. Selain itu, tetapkan dimensi pertanyaan dan kunci dalam MHSA kepada separuh daripada nilai dan gantikan LayerNorm dengan BatchNorm untuk inferens pantas. PSA hanya diletakkan selepas peringkat 4 dengan resolusi terendah untuk mengelakkan overhed berlebihan yang disebabkan oleh kerumitan pengiraan kuadratik perhatian diri. Dengan cara ini, keupayaan pembelajaran perwakilan global boleh digabungkan ke dalam YOLO pada kos pengiraan yang rendah, sekali gus meningkatkan keupayaan model dan meningkatkan prestasi.

Perbandingan eksperimen

Saya tidak akan memperkenalkan terlalu banyak di sini, hanya hasilnya! ! ! Latensi dikurangkan dan prestasi terus meningkat.

Atas ialah kandungan terperinci YOLOv10 ada di sini! Pengesanan sasaran hujung ke hujung masa nyata sebenar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Bagaimana untuk menggunakan C++ untuk penjejakan imej berprestasi tinggi dan pengesanan sasaran?

- Robot Tesla berkembang sepenuhnya! Keupayaan persepsi, otak dan kawalan motor dinaik taraf, dan penyelesaian hujung ke hujung menunjukkan hasil awal.

- Penjajaran ciri yang tepat untuk meningkatkan pengesanan objek 3D multimodal: Aplikasi GraphAlign

- Menggunakan algoritma pengurangan dimensi untuk mencapai pengesanan sasaran: petua dan langkah

- Anotasi kotak sempadan berlebihan berbilang grid untuk pengesanan objek yang tepat