LLM 성과가 최대 60% 향상되었습니다! Google ICLR 2024 걸작: 대규모 언어 모델이 '그래프 언어'를 학습하게 하세요

- 王林앞으로

- 2024-03-27 20:46:33788검색

컴퓨터 과학 분야에서 그래프 구조는 노드(엔티티를 나타냄)와 에지(엔티티 간의 관계를 나타냄)로 구성됩니다.

사진은 어디에나 있습니다.

인터넷은 거대한 네트워크로 간주될 수 있으며 검색 엔진은 그래픽 방법을 사용하여 정보를 구성하고 표시합니다.

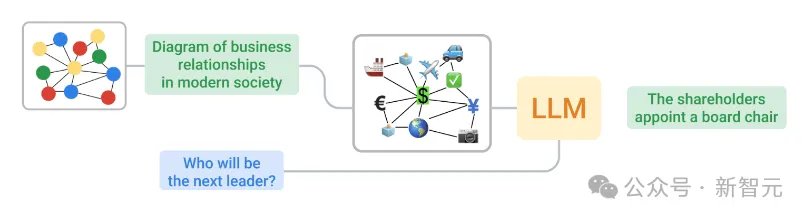

LLM은 주로 일반 텍스트에 대해 학습하므로 그래프 구조가 텍스트와 근본적으로 다르기 때문에 그래프를 LLM이 이해할 수 있는 텍스트로 변환하는 것은 어려운 작업입니다.

ICLR 2024에서 Google 팀은 그래프 데이터를 LLM이 이해하기에 적합한 형식으로 변환하는 방법을 탐구했습니다.

논문 주소: https://openreview.net/pdf?id=IuXR1CCrSi

두 가지 방법을 사용하여 그래픽을 텍스트로 인코딩하고 텍스트와 질문을 LLM에 다시 제공합니다. 그 과정에서

그들은 또한 GraphQA라는 벤치마크를 개발하여 다양한 그래프 추론 문제를 해결하는 접근 방식을 탐색하고 LLM이 그래프 관련 문제를 해결하는 데 유용한 방식으로 이러한 문제를 표현하는 방법을 보여주었습니다.

올바른 방법을 사용하면 LLM은 그래픽 작업 성능을 최대 60%까지 향상시킬 수 있습니다.

GraphOA: LLM을 위한 "시험"

먼저 Google 팀은 특정 그래프 문제를 해결하는 LLM의 능력을 평가하기 위해 고안된 시험으로 볼 수 있는 GraphQA 벤치마크를 설계했습니다.

GraphOA는 여러 유형의 그래프를 사용하여 그래프를 처리할 때 LLM에서 가능한 편차를 찾아 연결 폭과 수의 다양성을 보장하고 전체 프로세스를 LLM이 실제 응용 프로그램에서 접할 수 있는 조건에 더 가깝게 만듭니다.

GraphIQA를 사용하여 LLM으로 추론하기 위한 프레임워크

에지 존재 여부 확인, 노드 또는 에지 수 계산 등과 같은 작업은 간단하지만 이러한 작업을 수행하려면 LLM이 다음을 이해해야 합니다. 노드와 가장자리 사이의 관계는 보다 복잡한 그래픽 추론에 중요합니다.

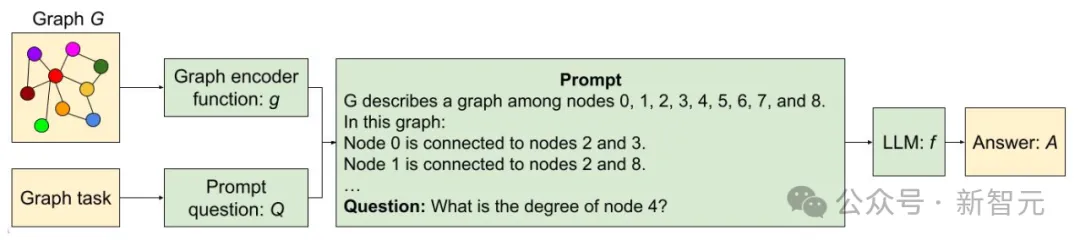

동시에 팀은 다음 두 가지 주요 문제를 해결하는 등 그래프를 LLM이 처리할 수 있는 텍스트로 변환하는 방법도 모색했습니다.

노드 인코딩: 단일 노드를 어떻게 표현합니까? 노드에는 간단한 정수, 일반 이름(사람, 문자) 및 문자가 포함될 수 있습니다.

에지 코딩: 노드 간의 관계를 어떻게 설명합니까? 메서드에는 괄호, 문구(예: "친구입니다") 및 기호 표현(예: 화살표)이 포함될 수 있습니다.

궁극적으로 연구원들은 다양한 노드와 에지 인코딩 방법을 체계적으로 결합하여 아래 그림과 같은 기능을 생성했습니다.

그래프 인코딩 기능의 예

LLM은 어떻게 작동하나요?

연구팀은 GraphOA에 대해 세 가지 주요 실험을 수행했습니다.

- 그래픽 작업을 처리하는 LLM의 능력 테스트

- LLM 크기가 성능에 미치는 영향 테스트

- 다양한 작업의 영향 테스트 그래프 모양이 성능에 미치는 영향

첫 번째 실험에서 LLM은 평범하게 수행되었으며 대부분의 기본 작업에서 LLM은 무작위 추측보다 나을 것이 없었습니다.

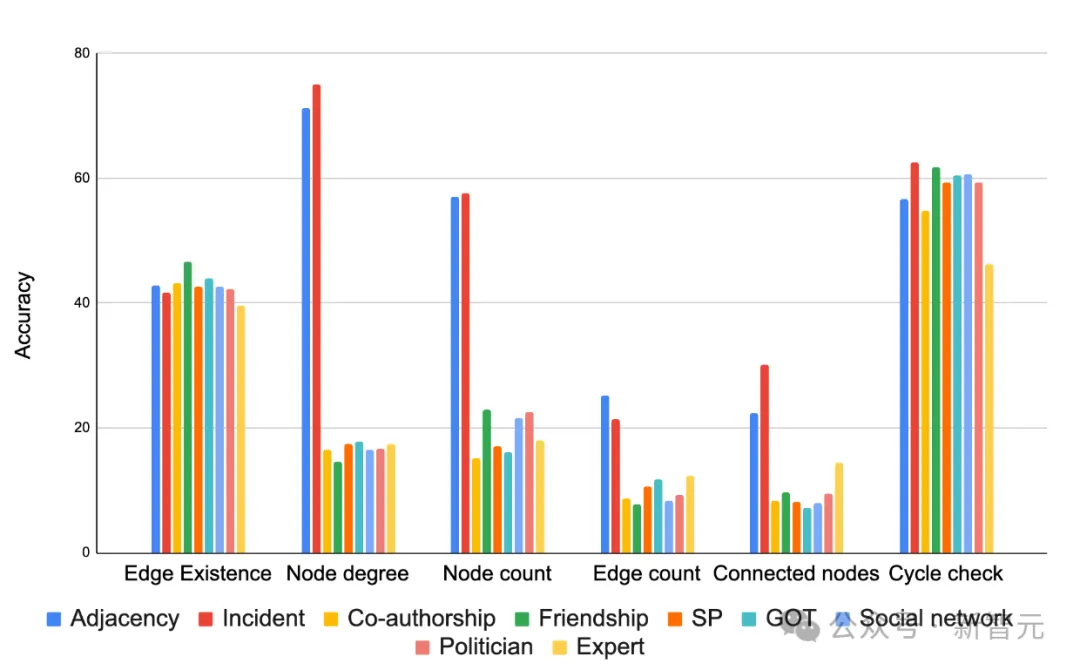

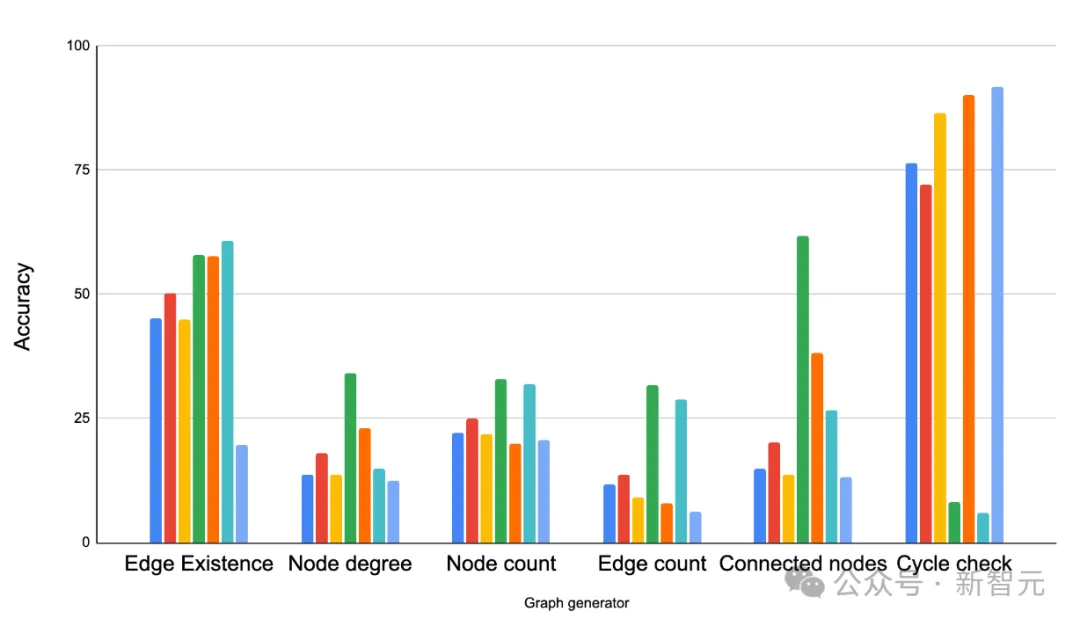

그러나 아래 그림과 같이 인코딩 방법이 결과에 큰 영향을 미치며, 대부분의 경우 "incident" 인코딩이 대부분의 작업에서 잘 수행됩니다. 적절한 인코딩 기능을 선택하면 작업의 정확성이 크게 향상될 수 있습니다.

다양한 작업 정확도에 따른 다양한 그래프 인코더 기능 비교

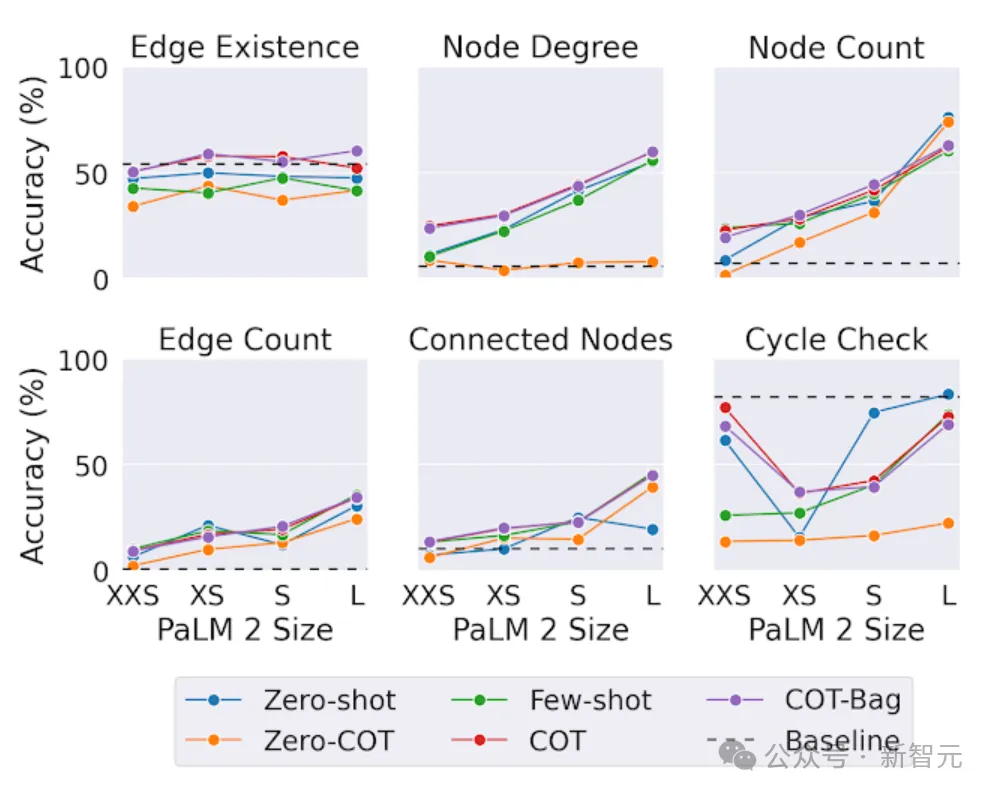

두 번째 테스트에서 연구원들은 다양한 크기의 모델에서 동일한 그래프 작업을 테스트했습니다.

결론적으로 그래프 추론 작업에서는 더 큰 모델이 더 좋은 성능을 보였습니다.

흥미롭게도 "edge 존재" 작업(그래프에서 두 노드가 연결되어 있는지 확인)에서는 크기가 다른 작업만큼 중요하지 않습니다.

가장 큰 LLM이라도 주기 확인 문제(그래프에 주기가 존재하는지 확인)에 대한 간단한 기본 솔루션을 항상 이길 수는 없습니다. 이는 LLM이 특정 그래프 작업에 대해 여전히 개선의 여지가 있음을 보여줍니다.

PaLM 2-XXS의 그래프 추론 작업에 대한 모델 용량의 영향, 사람들은 GraphOA를 사용하여 분석을 위한 다양한 구조의 그래프를 생성합니다.

GraphQA의 다양한 그래프 생성기로 생성된 그래프의 예. ER, BA, SBM 및 SFN은 각각 Erdös-Rényi, Barabási-Albert, 확률적 블록 모델 및 규모 없는 네트워크입니다.

결과는 그래프의 구조가 LLM의 성과에 큰 영향을 미치는 것으로 나타났습니다.

예를 들어, 루프가 존재하는지 묻는 작업에서 LLM은 밀접하게 연결된 그래프(루프가 일반적인 경우)에서는 잘 수행되지만 경로 그래프(루프가 발생하지 않는 경우)에서는 성능이 좋지 않습니다.

그러나 동시에 일부 혼합 샘플을 제공하면 LLM이 적응하는 데 도움이 됩니다. 예를 들어 주기 감지 작업에서 연구원은 주기를 포함하는 몇 가지 예와 주기를 포함하지 않는 몇 가지 예를 프롬프트에 추가했습니다. 이 방법을 통해 LLM의 성능이 향상됩니다.

다양한 그래프 작업에서 다양한 그래프 생성기를 비교해 보세요. 주요 관찰은 그래프 구조가 LLM 성능에 중요한 영향을 미친다는 것입니다. ER, BA, SBM 및 SFN은 각각 Erdös-Rényi, Barabási-Albert, 확률적 블록 모델 및 규모 없는 네트워크를 나타냅니다.

이것은 LLM이 그래프를 이해할 수 있도록 하는 시작에 불과합니다

문서에서 Google 팀은 처음에 LLM이 이해할 수 있도록 그래프를 텍스트로 가장 잘 표현하는 방법을 탐색했습니다.

올바른 코딩 기술의 도움으로 그래프 문제에 대한 LLM의 정확도가 크게 향상됩니다(약 5%에서 60% 이상 향상).

또한 그래픽을 텍스트로 변환하는 인코딩 방법, 다양한 그래픽의 작업 유형, 그래픽의 밀도 구조라는 세 가지 주요 영향 요인을 확인했습니다.

이것은 LLM이 그래프를 이해하는 시작일 뿐입니다. 새로운 벤치마크 GraphQA의 도움으로 우리는 LLM의 더 많은 가능성을 탐구하기 위한 추가 연구를 기대합니다.

위 내용은 LLM 성과가 최대 60% 향상되었습니다! Google ICLR 2024 걸작: 대규모 언어 모델이 '그래프 언어'를 학습하게 하세요의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!