DualBEV: BEVFormer 및 BEVDet4D를 크게 능가하는 책을 펼치세요!

- PHPz앞으로

- 2024-03-21 17:21:09538검색

본 논문에서는 자율 주행에서 다양한 시야각(원근 및 조감도 등)에서 물체를 정확하게 감지하는 문제, 특히 투시도(PV)에서 조감도(BEV) 공간으로 효과적으로 이동하는 방법을 탐구합니다. 변환 기능, 이 변환은 VT(Visual Transformation) 모듈을 통해 구현됩니다. 기존 방법은 크게 2D에서 3D로, 3D에서 2D로 변환하는 두 가지 전략으로 나뉩니다. 2D에서 3D로의 방법은 깊이 확률을 예측하여 조밀한 2D 특징을 개선하지만, 특히 먼 영역에서는 깊이 예측의 본질적인 불확실성으로 인해 부정확성이 발생할 수 있습니다. 3D에서 2D로의 방법은 일반적으로 3D 쿼리를 사용하여 2D 기능을 샘플링하고 Transformer를 통해 3D와 2D 기능 간의 대응에 대한 주의 가중치를 학습하므로 계산 및 배포의 복잡성이 증가합니다.

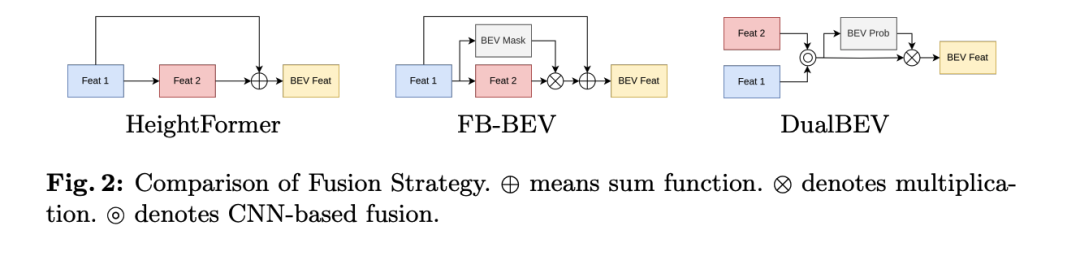

HeightFormer 및 FB-BEV와 같은 기존 방법은 이 두 가지 VT 전략을 결합하려고 시도하지만 이러한 방법은 일반적으로 듀얼 VT의 서로 다른 기능 변환으로 인해 2단계 전략을 채택한다는 점을 지적합니다. 이는 초기 기능 성능으로 인해 듀얼 VT 간의 원활한 통합을 방해합니다. 게다가 이러한 방법은 자율 주행의 실시간 배포를 달성하는 데 여전히 어려움에 직면해 있습니다.

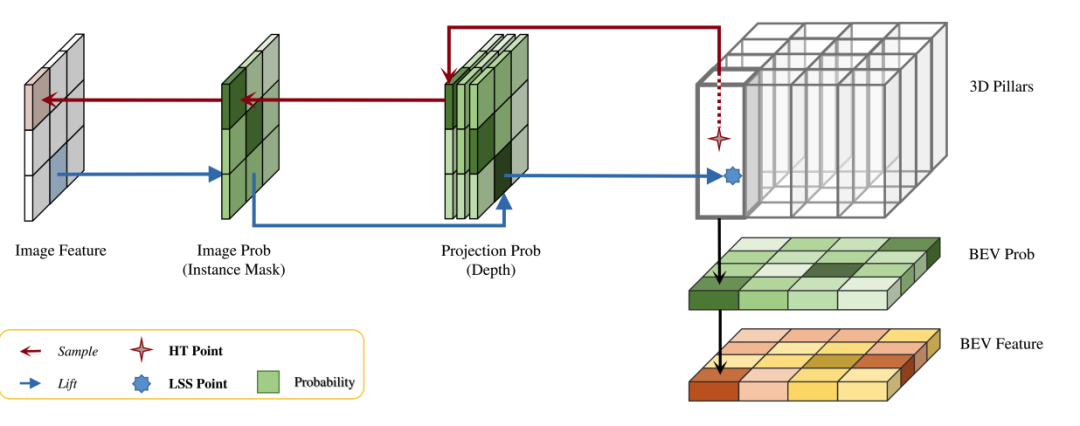

이러한 문제에 대응하여 본 논문에서는 2D에서 3D로, 3D에서 2D로의 시각적 변환에 적합한 통합 특징 변환 방법을 제안하고, BEV 확률, 투영 확률, 이미지의 세 가지 확률 측정을 통해 3D와 2D 특징 간의 일치성을 평가합니다. 개연성. 이 새로운 방법은 BEV 그리드의 빈 영역이 특징 구성에 미치는 영향을 완화하고, 다중 대응을 구별하고, 특징 변환 프로세스 중에 배경 특징을 제외하는 것을 목표로 합니다.

이 통합 특징 변환을 적용하여 논문에서는 CNN(컨벌루션 신경망)을 사용하여 3D에서 2D로 시각적 변환하는 새로운 방법을 탐색하고 HeightTrans라는 방법을 소개합니다. 뛰어난 성능을 입증하는 것 외에도 사전 계산을 통한 가속 가능성도 보여 실시간 자율주행 애플리케이션에 적합합니다. 동시에 이러한 기능 변환을 통합함으로써 기존 LSS 프로세스가 향상되어 전류 검출기에 대한 보편성을 입증합니다.

HeightTrans와 Prob-LSS를 결합하여 이 논문에서는 BEV와 투시도의 대응성을 한 단계에서 고려하고 융합하여 초기 기능에 대한 의존성을 제거하는 혁신적인 방법인 DualBEV를 소개합니다. 또한 채널 주의 모듈과 공간 주의 모듈을 활용하여 BEV 확률 예측을 더욱 구체화하는 데 도움이 되는 DFF(Dual Feature Fusion) 모듈이라고 하는 강력한 BEV 특성 융합 모듈이 제안되었습니다. DualBEV는 "광범위한 입력, 엄격한 출력"의 원칙을 따르며 정확한 듀얼 뷰 확률 대응을 활용하여 장면의 확률 분포를 이해하고 표현합니다.

논문의 주요 기여는 다음과 같습니다.

- 3D에서 2D로, 2D에서 3D로의 시각적 변환 사이의 본질적인 유사성을 밝히고, BEV와 투시도 모두에서 정확한 통일된 특징 변환 방법을 제안합니다. 대응 관계 구축 두 전략 간의 격차가 크게 줄어듭니다.

- 확률 샘플링 및 룩업 테이블의 사전 계산을 통해 정확한 3D-2D 대응을 효과적이고 효율적으로 설정하는 새로운 CNN 기반의 3D에서 2D 시각적 변환 방법인 HeightTrans를 제안했습니다.

- DFF는 듀얼 뷰 기능 융합을 위해 도입되었습니다. 이 융합 전략은 근거리 및 원거리 영역의 정보를 한 단계에서 캡처하여 포괄적인 BEV 기능을 생성합니다.

- 효율적인 프레임워크인 DualBEV는 Transformer를 사용하지 않고도 nuScenes 테스트 세트에서 55.2% mAP 및 63.4% NDS를 달성하여 뷰 변환을 위한 정확한 듀얼 뷰 대응 캡처의 중요성을 강조합니다.

본 논문에서는 이러한 혁신을 통해 기존 방법의 한계를 극복하고 자율주행과 같은 실시간 응용 시나리오에서 보다 효율적이고 정확한 객체 감지를 달성하기 위한 새로운 전략을 제안합니다.

DualBEV에 대한 자세한 설명

본 논문에서 제안하는 방법은 통합된 특징 변환 프레임워크인 DualBEV를 통해 자율주행에서 BEV(bird's eye view) 객체 검출 문제를 해결하는 것을 목표로 합니다. 다음은 다양한 하위 섹션과 주요 혁신을 간략하게 설명하는 방법 섹션의 주요 내용입니다.

DualBEV 개요

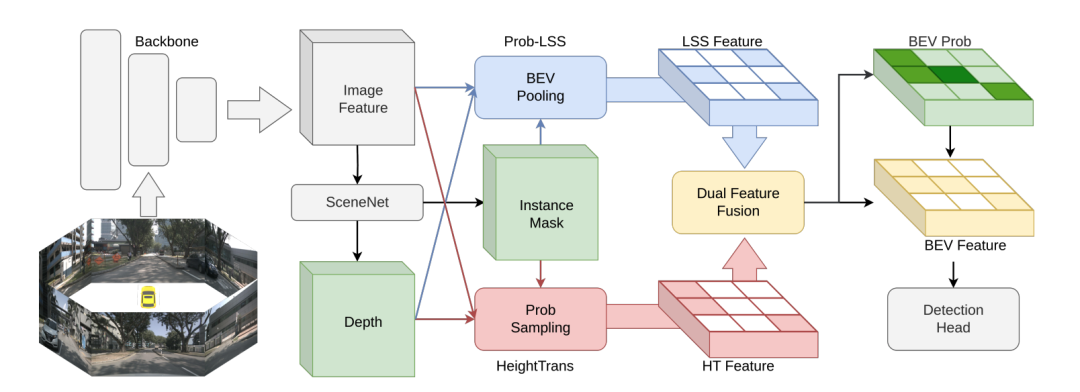

DualBEV의 처리 흐름은 여러 카메라에서 얻은 이미지 특징 에서 시작하여 SceneNet을 사용하여 인스턴스 마스크 및 깊이 맵 을 생성합니다. 다음으로 HeightTrans 모듈과 Prob을 통해 추출합니다. -LSS 파이프라인과 변환 기능, 그리고 마지막으로 이러한 기능을 융합하여 BEV 공간의 확률 분포 를 예측하여 후속 작업에 대한 최종 BEV 기능 을 얻는 데 사용됩니다.

HeightTrans

HeightTrans는 3D 위치를 선택하고 이를 이미지 공간에 투영하고 이러한 3D-2D 대응을 평가하는 3D에서 2D 시각적 변환 원리를 기반으로 합니다. 이 방법은 먼저 사전 정의된 BEV 지도에서 3D 점 세트를 샘플링한 다음 이러한 대응 관계를 신중하게 고려하고 필터링하여 BEV 기능을 생성합니다. HeightTrans는 다중 해상도 샘플링 전략과 확률 샘플링 방법을 채택하여 작은 물체에 대한 주의력을 높이고 배경 픽셀로 인한 오해의 소지가 있는 문제를 해결합니다. 또한 BEV 확률 을 도입하여 빈 BEV 그리드 문제를 해결합니다. HeightTrans 모듈은 논문에서 제안한 핵심 기술 중 하나로, 3D에서 2D로의 시각적 변환(VT)을 통해 기능을 처리하고 변환하는 데 중점을 둡니다. 사전 정의된 BEV(조감도) 지도에서 3D 위치를 선택하고 이러한 위치를 이미지 공간에 투영하여 3D와 2D 간의 일치성을 평가하는 방식입니다. 다음은 HeightTrans의 작동 방식에 대한 자세한 소개입니다.

BEV Height

HeightTrans 방법은 높이를 처리할 때 전체 높이 범위(-5미터에서 3미터까지)를 포괄하는 다중 해상도 샘플링 전략을 채택합니다. 관심 영역 ROI 내의 해상도(-2미터 ~ 2미터로 정의됨)는 0.5미터이고, 이 범위 밖의 해상도는 1.0미터입니다. 이 전략은 낮은 해상도 샘플링에서 놓칠 수 있는 작은 물체에 대한 초점을 높이는 데 도움이 됩니다.

Prob-Sampling

HeightTrans는 확률적 샘플링에서 다음 단계를 채택합니다.

- 3D 샘플링 지점 정의: 3D 샘플링 지점 집합을 미리 정의, 각 지점은 3D 공간에서의 위치에 따라 결정됩니다 정의.

- 2D 공간에 투영: 카메라의 외부 매개변수 행렬 및 내부 매개변수 행렬 을 사용하여 3D 점을 2D 이미지 공간 의 한 점에 투영합니다. 여기서 는 점의 깊이를 나타냅니다.

- Feature sampling: 이중선형 그리드 샘플러를 사용합니다. 투영 위치에서 이미지 특징을 샘플링합니다. :

- 인스턴스 마스크 활용 : 투영 위치가 배경 픽셀에 떨어지는 것을 방지하려면 SceneNet을 사용합니다. 인스턴스 마스크를 생성하기 위해 이미지 확률을 표현하기 위해 이를 이미지 특징에 적용하여 오해의 소지가 있는 정보의 영향을 줄입니다.

- 다중 대응 처리 : 깊이 맵에서 삼선형 그리드 샘플러를 사용하기 여러 3D 점이 동일한 2D 위치에 매핑되는 상황, 즉 투영 확률 :

- BEV 확률 소개: BEV 그리드의 빈 셀이 유용한 정보를 제공하지 못하는 문제를 해결하기 위해 BEV 확률 이 도입됩니다. BEV 그리드의 점유 확률을 나타냅니다. 여기서 는 BEV 공간의 위치입니다.

BEV 공간의 3D 포인트 인덱스를 미리 계산하고 이미지 특징 인덱스를 고정하여

가속합니다추론 중 깊이 맵 인덱스와 HeightTrans를 사용하면 시각적 변환 프로세스의 속도를 높일 수 있습니다. 최종 HeightTrans 기능은 각 BEV 메시에 대해 사전 정의된

Prob-LSSProb-LSS를 사용하여 각 픽셀의 깊이 확률을 예측함으로써 기존 LSS(Lift, Splat, Shoot) 파이프라인을 확장합니다. 이 방법은 BEV 확률을 추가로 통합하여 다음 공식을 통해 LSS 기능을 구축합니다. 이렇게 하면 깊이 추정의 불확실성을 더 잘 처리하여 BEV 공간의 중복 정보를 줄일 수 있습니다.

DFF(Dual Feature Fusion)DFF 모듈은 HeightTrans와 Prob-LSS의 기능을 융합하고 BEV 확률을 효과적으로 예측하도록 설계되었습니다. 채널 주의 모듈과 공간 주의 강화 ProbNet을 결합함으로써 DFF는 특징 선택과 BEV 확률 예측을 최적화하여 가깝고 먼 물체의 표현을 향상시킬 수 있습니다. 이 융합 전략은 두 스트림의 기능 보완성을 고려하는 동시에 로컬 및 글로벌 관심을 계산하여 BEV 확률의 정확성을 향상시킵니다.

간단히 말하면, 본 논문에서 제안하는 DualBEV 프레임워크는 HeightTrans와 Prob-LSS뿐 아니라 혁신적인 이중 기능 융합 모듈을 결합하여 3D와 2D 기능 간의 대응성을 효율적으로 평가하고 변환합니다. 이는 2D에서 3D로, 3D에서 2D로의 변환 전략 간의 격차를 해소할 뿐만 아니라 사전 계산 및 확률 측정을 통해 특징 변환 프로세스를 가속화하여 실시간 자율 주행 애플리케이션에 적합합니다. 이 방법의 핵심은 다양한 시야각의 특징을 정확하게 대응하고 효율적으로 융합하여 BEV 객체 감지에서 뛰어난 성능을 달성한다는 것입니다.

실험

실험

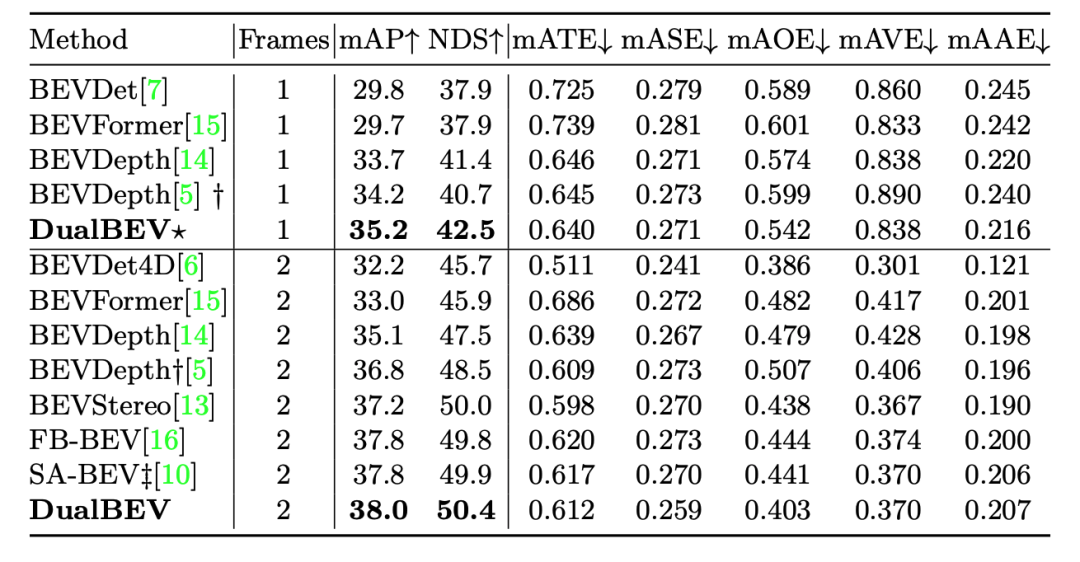

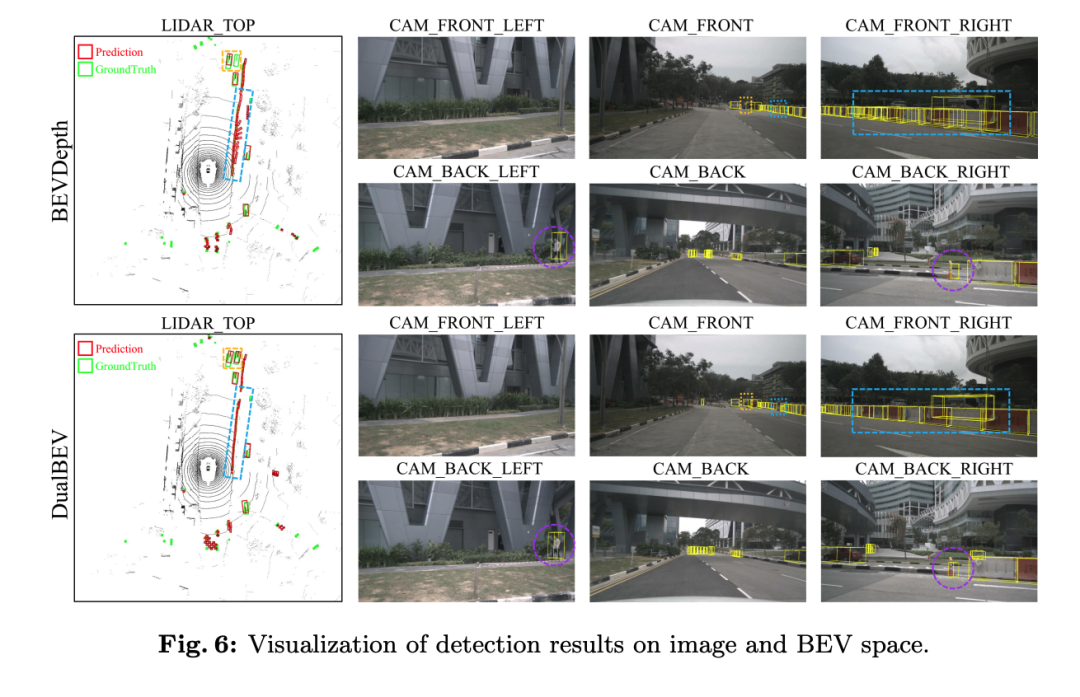

입력 프레임 수가 2개 프레임으로 증가하면 DualBEV의 성능이 더욱 향상되어 mAP가 38.0%에 도달하고 NDS가 50.4%에 도달합니다. 이는 나열된 모든 방법 중 가장 높은 NDS로, 처리 시 DualBEV가 더 포괄적임을 나타냅니다. 더 복잡한 입력을 통해 장면을 이해합니다. 다중 프레임 방법 중 mATE, mASE, mAAE에서도 강력한 성능을 보여주며, 특히 mAOE에서 상당한 개선을 보여 객체 방향 추정에 장점을 보여줍니다.

이러한 결과를 통해 DualBEV와 그 변형이 여러 중요한 성능 지표, 특히 다중 프레임 설정에서 좋은 성능을 발휘한다는 것을 분석할 수 있으며 이는 BEV 객체 감지 작업에 대한 정확성과 정확성이 우수함을 나타냅니다. 또한 이러한 결과는 모델의 전체 성능과 추정 정확도를 향상시키기 위해 다중 프레임 데이터를 사용하는 것의 중요성을 강조합니다.

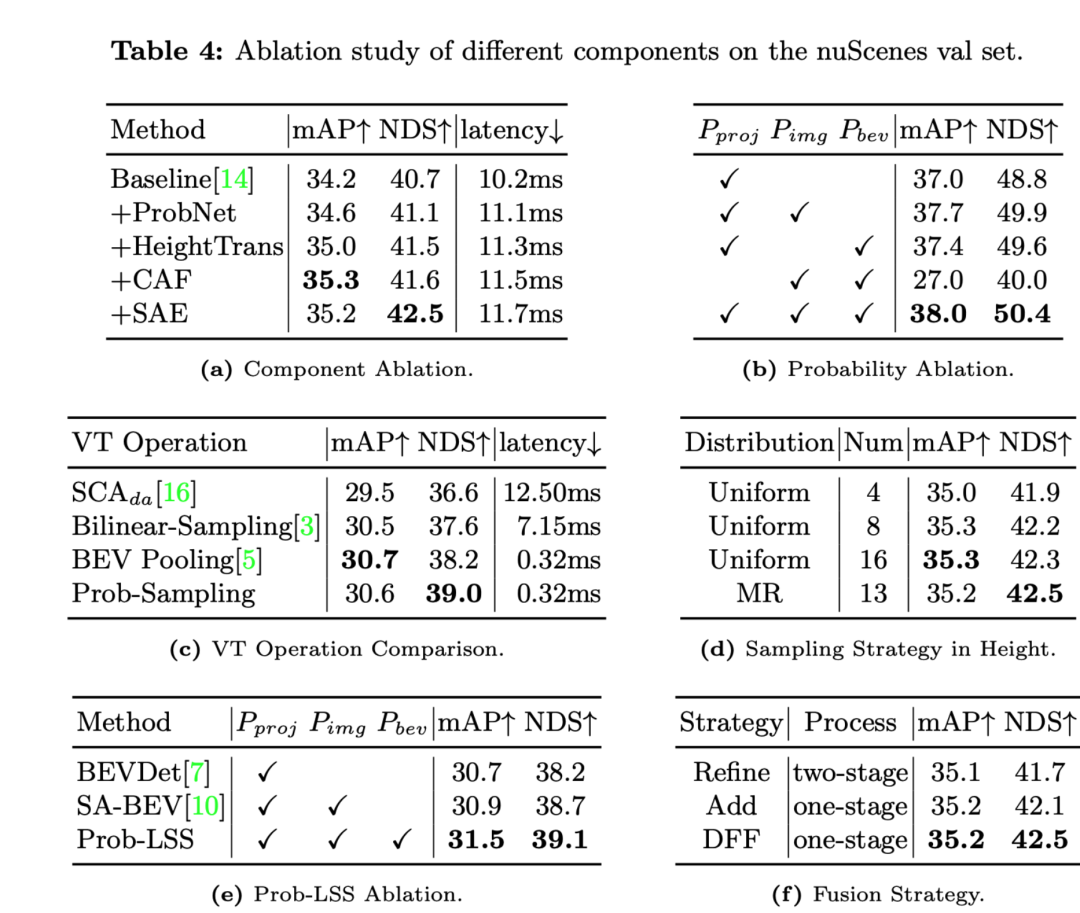

다음은 각 절제 실험 결과를 분석한 것입니다.

- ProbNet, HeightTrans, CAF(Channel Attention Fusion), SAE(Spatial Attention Enhanced) 등의 구성 요소를 추가하면서 점차 성능이 향상되었습니다. 기준선의.

- HeightTrans의 추가로 mAP와 NDS가 크게 향상되었으며, 이는 높이 정보를 시각적 변환에 도입하는 것이 효과적임을 보여줍니다.

- CAF는 mAP를 더욱 향상시키지만 대기 시간은 약간 늘어납니다.

- SAE의 도입으로 NDS가 최대 42.5%까지 증가하고 mAP도 향상되어 공간 주의 메커니즘이 모델 성능을 효과적으로 향상시켰음을 나타냅니다.

- 다양한 확률 측정값(투영 확률 , 이미지 확률 , BEV 확률 )이 점차적으로 비교 실험에 추가됩니다.

- 모델은 세 가지 확률을 모두 동시에 사용했을 때 가장 높은 mAP와 NDS를 달성했는데, 이는 이러한 확률의 조합이 모델 성능에 중요하다는 것을 나타냅니다.

- Prob-Sampling은 유사한 지연(0.32ms)에서 다른 VT 작업보다 높은 NDS(39.0%)를 가지며, 이는 확률적 샘플링의 성능 우수성을 강조합니다.

- 다중 해상도(MR) 샘플링 전략은 동일한 수의 샘플링 포인트를 사용할 때 균일 샘플링 전략과 유사하거나 더 나은 성능을 얻을 수 있습니다.

- LSS 프로세스에 투영 확률, 이미지 확률 및 BEV 확률을 추가함으로써 Prob-LSS는 다른 LSS 변형보다 성능이 뛰어나 mAP 및 NDS를 개선하고 이러한 확률 결합의 효율성을 보여줍니다.

- 다단계 Refine 전략과 비교하여 단일 단계 Add 전략과 DFF 모듈 모두 더 높은 NDS를 달성할 수 있으며 DFF도 mAP가 약간 향상되어 DFF가 단일 단계 융합 전략임을 보여줍니다. 효율성과 성능면에서 유리합니다.

Ablation 실험은 HeightTrans, 확률적 측정, Prob-Sampling 및 DFF와 같은 구성 요소와 전략이 모델 성능을 향상시키는 데 중요하다는 것을 보여줍니다. 또한 높이 정보에 대한 다중 해상도 샘플링 전략을 사용하는 것도 그 효율성을 입증합니다. 이러한 결과는 방법 섹션에 제시된 각 기술이 모델 성능에 긍정적으로 기여한다는 저자의 주장을 뒷받침합니다.

Discussion

이 논문은 일련의 절제 실험을 통해 해당 방법의 성능을 보여줍니다. 논문에서 제안한 DualBEV 프레임워크와 그 다양한 구성 요소가 조감도(BEV) 객체 감지 정확도를 향상시키는 데 긍정적인 영향을 미친다는 것을 실험 결과에서 확인할 수 있습니다.

논문의 방법은 ProbNet, HeightTrans, CAF(Channel Attention Fusion) 및 SAE(Spatial Attention Enhanced) 모듈을 기본 모델에 점진적으로 도입하여 mAP 및 NDS 지표 모두에서 상당한 개선을 보여줍니다. 전체 아키텍처에서 중요한 역할을 합니다. 특히 SAE 도입 후 NDS 점수는 42.5%로 최고점까지 상승한 반면 지연은 소폭 증가하는 데 그쳐 정확도와 지연의 균형이 잘 맞는 방식임을 알 수 있다.

확률적 절제 실험 결과는 감지 성능 향상에 있어 투영 확률, 이미지 확률 및 BEV 확률의 중요성을 더욱 확인시켜 줍니다. 이러한 확률이 하나씩 도입되면 시스템의 mAP 및 NDS 점수가 꾸준히 향상되어 이러한 확률적 측정을 BEV 객체 감지 작업에 통합하는 것이 중요함을 보여줍니다.

Visual Transformation(VT) 연산 비교에서, 논문에서 제안하는 Prob-Sampling 방식은 SCAda, Bilinear-Sampling 등의 다른 연산에 비해 지연 시간이 낮고 NDS 점수가 높아 효율성과 성능 장점을 강조합니다. . 또한 다양한 높이 샘플링 전략의 경우 균일한 샘플링 대신 다중 해상도(MR) 전략을 채택하면 NDS 점수를 더욱 향상시킬 수 있습니다. 이는 감지 성능을 향상시키기 위해 장면의 다양한 높이에서 정보를 고려하는 것이 중요함을 보여줍니다.

또한 다양한 기능 융합 전략의 경우 이 논문에서는 DFF 방법이 모델을 단순화하면서 여전히 높은 NDS 점수를 유지할 수 있음을 보여줍니다. 이는 1단계 처리 흐름에서 듀얼 스트림 기능을 융합하는 것이 효과적이라는 것을 의미합니다.

그러나 논문에서 제안한 방법은 여러 측면에서 잘 작동하지만 모든 개선은 시스템 복잡성과 계산 비용의 증가로 이어집니다. 예를 들어, 새로운 구성 요소(예: ProbNet, HeightTrans 등)가 도입될 때마다 시스템의 대기 시간이 증가합니다. 비록 대기 시간의 증가는 미미하지만 실시간 또는 낮은 대기 시간 요구 사항이 있는 애플리케이션에서는 이렇게 됩니다. 고려사항이 될 수 있습니다. 또한 확률적 측정은 성능 향상에 기여하지만 이러한 확률을 추정하기 위해 추가 컴퓨팅 리소스가 필요하므로 잠재적으로 리소스 소비가 높아집니다.

논문에서 제안된 DualBEV 방법은 특히 최신 딥 러닝 기술과 시각적 변환 기술을 결합하여 BEV 객체 감지의 정확성과 포괄적인 성능을 향상시키는 데 있어 놀라운 결과를 얻었습니다. 그러나 이러한 발전은 계산 대기 시간과 리소스 소비가 약간 증가하는 대가로 이루어지며 실제 애플리케이션에서는 사례별로 이러한 요소를 평가해야 합니다.

결론

이 방법은 BEV 객체 감지 작업에서 잘 수행되어 정확도와 전반적인 성능이 크게 향상됩니다. 확률적 샘플링, 높이 변환, 주의 메커니즘 및 공간 주의 강화 네트워크를 도입함으로써 DualBEV는 특히 조감도(BEV) 정확도 및 장면 이해에서 여러 핵심 성과 지표를 성공적으로 향상시킵니다. 실험 결과에 따르면 이 논문의 방법은 다양한 관점에서 복잡한 장면과 데이터를 처리하는 데 특히 효과적이며 이는 자율 주행 및 기타 실시간 모니터링 애플리케이션에 매우 중요합니다.

위 내용은 DualBEV: BEVFormer 및 BEVDet4D를 크게 능가하는 책을 펼치세요!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!