CVPR 2024 전체 점수 논문: Zhejiang University는 변형 가능한 3차원 가우스를 기반으로 한 고품질 단안 동적 재구성의 새로운 방법을 제안합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-03-05 15:58:19439검색

단안 동적 장면이란 단안 카메라를 사용하여 관찰하고 분석한 동적 환경을 말하며, 장면 내에서 물체가 자유롭게 움직일 수 있습니다. 단안의 동적 장면 재구성은 환경의 동적 변화 이해, 객체 모션 궤적 예측, 동적 디지털 자산 생성과 같은 작업에서 매우 중요합니다. 단안 비전 기술을 사용하면 동적 장면의 3차원 재구성 및 모델 추정이 가능해 동적 환경에서 다양한 상황을 더 잘 이해하고 처리할 수 있습니다. 이 기술은 컴퓨터 비전 분야뿐만 아니라 자율주행, 증강현실, 가상현실 등 분야에서도 중요한 역할을 할 수 있다. 단안의 동적 장면 재구성을 통해 환경 내 물체의 움직임을 보다 정확하게 포착할 수 있습니다

NeRF(Neural Radiance Field)로 대표되는 신경 렌더링의 등장으로 숨겨진 동적 장면의 3차원 재구성을 사용하는 작업이 점점 더 많아지고 있습니다. 암시적 표현을 사용합니다. D-NeRF, Nerfies, K-planes 등과 같은 NeRF를 기반으로 한 일부 대표 작품은 만족스러운 렌더링 품질을 달성했지만 여전히 진정한 실사 렌더링과는 거리가 멀습니다.

절강대학교 연구팀과 ByteDance는 레이 캐스팅을 기반으로 한 NeRF 파이프라인이 역방향 흐름을 통해 관찰 공간을 표준 공간에 매핑하므로 정확성과 명확성 문제가 발생한다는 것이 위 문제의 핵심이라고 지적했습니다. 역 매핑은 학습된 구조의 수렴에 이상적이지 않으므로 현재 방법은 D-NeRF 데이터 세트에서 30개 이상의 레벨의 PSNR 렌더링 표시기만 달성합니다.

이 과제를 해결하기 위해 연구팀은 래스터화 기반의 단안 동적 장면 모델링 프로세스를 제안했습니다. 그들은 처음으로 변형 필드를 3D 가우스와 결합하여 고품질 재구성과 새로운 원근 렌더링을 가능하게 하는 새로운 방법을 만들었습니다. 본 연구 논문 "고충실도 단안 동적 장면 재구성을 위한 변형 가능한 3D 가우스"는 컴퓨터 비전 분야 최고의 국제 학술 컨퍼런스인 CVPR 2024에 게재되었습니다. 이 작업의 독특한 점은 변형장을 3D 가우시안에 적용하여 단안의 동적 장면으로 확장한 최초의 연구라는 것입니다.

프로젝트 홈페이지: https://ingra14m.github.io/Deformable-Gaussians/

논문 링크: https://arxiv.org/abs/2309.13101

코드: https: //github.com/ingra14m/Deformable-3D-Gaussians

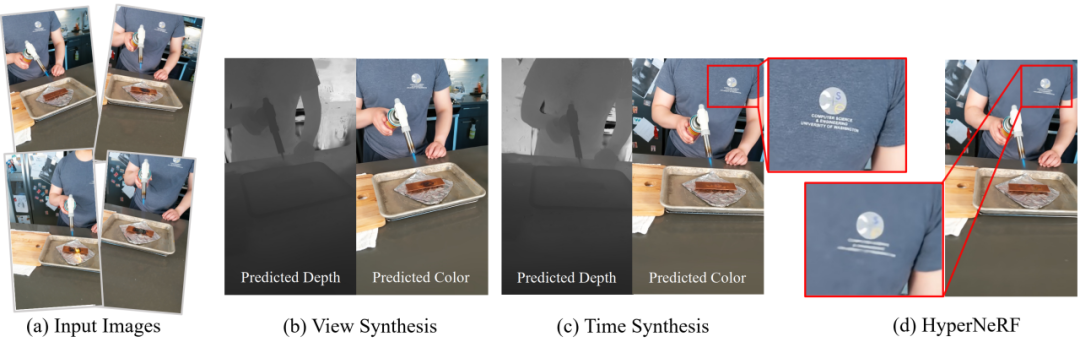

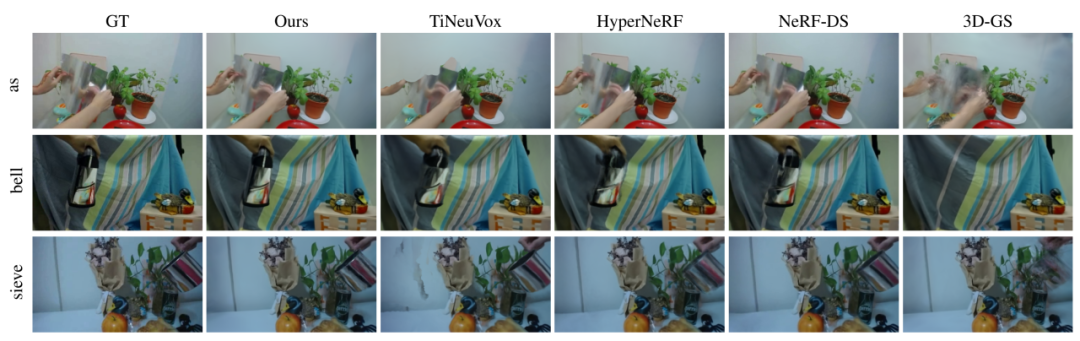

실험 결과는 변형 가능한 필드가 정규 공간의 3D 가우스 순방향 매핑을 관찰 공간에 정확하게 효과적으로 매핑할 수 있음을 보여줍니다. D-NeRF 데이터 세트에서는 PSNR이 10% 이상 향상되었습니다. 또한 실제 장면에서는 카메라 포즈가 정확하지 않더라도 렌더링 디테일을 높일 수 있습니다. N 그림 1 하이퍼너프 실제 장면의 실험 결과.

관련 작업동적인 장면 재구성은 3D 재구성에서 항상 뜨거운 이슈였습니다. NeRF로 대표되는 신경 렌더링이 고품질 렌더링을 달성함에 따라 동적 재구성 분야에서도 암시적 표현을 기반으로 한 일련의 작업이 등장했습니다. D-NeRF와 Nerfies는 강력한 동적 장면 재구성을 달성하기 위해 NeRF 레이캐스팅 파이프라인을 기반으로 변형 필드를 도입합니다. TiNeuVox, K-Planes 및 Hexplanes는 이를 기반으로 그리드 구조를 도입하여 모델 훈련 프로세스를 크게 가속화하고 렌더링 속도를 향상시킵니다. 그러나 이러한 방법은 모두 역 매핑을 기반으로 하며 게이지 공간과 변형 필드의 고품질 분리를 실제로 달성할 수 없습니다.

3D Gaussian Splash는 래스터화를 기반으로 하는 포인트 클라우드 렌더링 파이프라인입니다. CUDA 맞춤형 미분 가능 가우스 래스터화 파이프라인과 혁신적인 치밀화를 통해 3D 가우스는 SOTA 렌더링 품질을 달성할 뿐만 아니라 실시간 렌더링도 달성할 수 있습니다. 동적 3D 가우스는 먼저 정적 3D 가우스를 동적 필드로 확장합니다. 그러나 다중 뷰 장면만 처리할 수 있는 능력은 휴대폰 촬영과 같은 단일 뷰 장면과 같은 보다 일반적인 상황에서의 적용을 심각하게 제한합니다.연구 아이디어

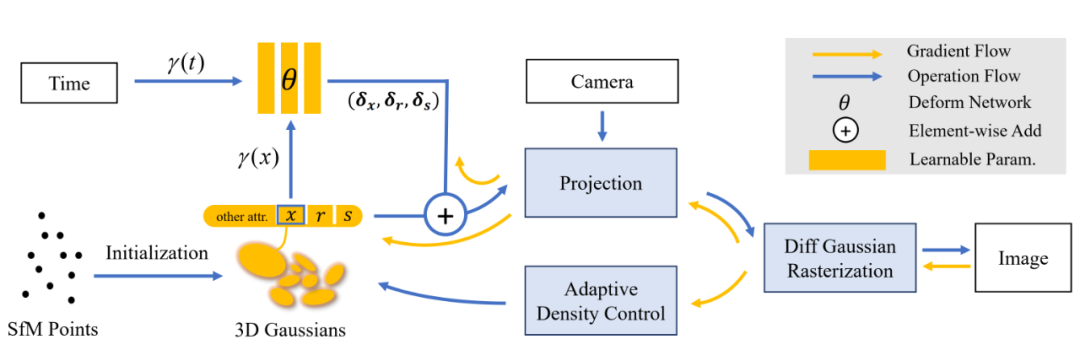

Deformable-GS의 핵심은 정적 3D 가우스를 단안의 동적 장면으로 확장하는 것입니다. 각 3D 가우스는 이미지 수준 렌더링을 위한 위치, 회전, 크기, 불투명도 및 SH 계수를 전달합니다. 3D 가우스 알파 블렌드의 공식에 따르면, 시간에 따른 위치뿐만 아니라 가우스 형태를 제어하는 회전 및 스케일링이 동적 3D 가우스를 결정하는 결정적인 매개변수임을 찾는 것은 어렵지 않습니다. 하지만 기존의 포인트 클라우드 기반 렌더링 방식과 달리 3D 가우시안이 초기화된 후에는 위치, 투명도 등의 매개변수가 지속적으로 최적화되어 업데이트됩니다. 이는 동적 가우스 학습에 어려움을 더합니다.본 연구에서는 변형 필드와 3D 가우시안을 공동으로 최적화하는 동적 장면 렌더링 프레임워크를 혁신적으로 제안합니다. 구체적으로 본 연구에서는 COLMAP 또는 임의의 포인트 클라우드로 초기화된 3차원 가우스를 표준 공간으로 취급한 후 변형 필드를 사용하여 표준 공간의 3차원 가우스 좌표 정보를 입력으로 사용하여 각 3차원 가우스의 위치와 모양을 예측합니다. 시간이 지남에 따라. 변형 필드를 사용하여 이 연구는 3D 가우스를 표준 공간에서 래스터화된 렌더링을 위한 관찰 공간으로 변환할 수 있습니다. 이 전략은 3D 가우시안의 미분 래스터화 파이프라인에 영향을 미치지 않으며, 이를 통해 계산된 기울기는 표준 공간 3D 가우시안의 매개변수를 업데이트하는 데 사용될 수 있습니다.

또한 변형 필드를 도입하면 동작 범위가 더 넓은 부품의 가우스 치밀화에 도움이 됩니다. 이는 이동 진폭이 더 큰 영역에서 변형 장의 기울기가 상대적으로 높아 치밀화 과정에서 해당 영역이 보다 세밀하게 조절되도록 안내하기 때문입니다. 표준 공간 3D 가우시안의 수와 위치 매개변수가 초기 단계에서 지속적으로 업데이트되지만 실험 결과는 이 공동 최적화 전략이 결국 강력한 수렴 결과를 달성할 수 있음을 보여줍니다. 약 20,000번의 반복 후에는 표준 공간에서 3D 가우스의 위치 매개변수가 더 이상 변하지 않습니다.

연구팀은 실제 장면에서 카메라 포즈가 정확하지 않은 경우가 많고, 역동적인 장면이 이 문제를 악화시킨다는 사실을 발견했습니다. 신경방사선장은 다층퍼셉트론(MLP)을 기반으로 하고 매우 매끄러운 구조이기 때문에 이는 신경방사선장을 기반으로 한 구조에는 큰 영향을 미치지 않을 것이다. 그러나 3D 가우시안은 포인트 클라우드의 명시적인 구조를 기반으로 하기 때문에 약간 부정확한 카메라 포즈는 가우시안 스플래싱을 통해 강력하게 수정하기 어렵습니다.

이러한 문제를 완화하기 위해 본 연구에서는 AST(Annealing Smooth Training)를 혁신적으로 도입했습니다. 이 훈련 메커니즘은 초기 단계에서 3D 가우시안 학습을 원활하게 하고 후반 단계에서 렌더링의 세부 사항을 높이기 위해 설계되었습니다. 이 메커니즘을 도입하면 렌더링 품질이 향상될 뿐만 아니라 시간 보간 작업의 안정성과 부드러움도 크게 향상됩니다.

그림 2는 이 연구의 파이프라인을 보여줍니다. 자세한 내용은 원본 논문을 참조하세요. 그림 2 본 연구의 파이프라인.

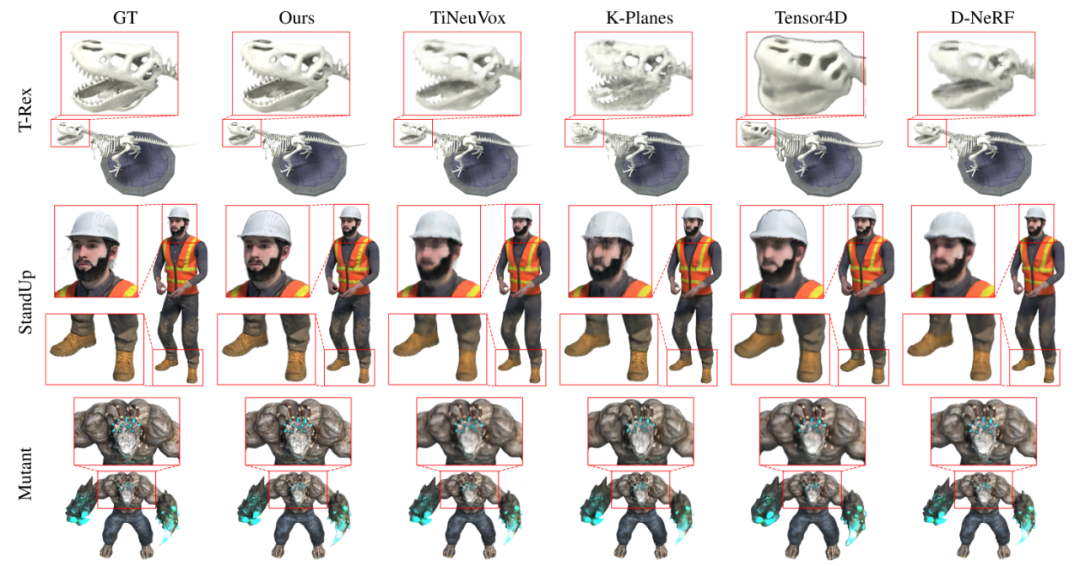

결과 표시본 연구에서는 먼저 동적 재구성 분야에서 널리 사용되는 D-NeRF 데이터 세트에 대한 합성 데이터 세트에 대한 실험을 수행했습니다. 그림 3의 시각화 결과를 보면 Deformable-GS가 이전 방법에 비해 렌더링 품질이 크게 향상되었음을 쉽게 알 수 있습니다. 그림 3 D-NeRF 데이터 세트에 대한 본 연구의 정성적 실험 비교 결과.

본 연구에서 제안된 방법은 시각 효과에서 상당한 개선을 달성했을 뿐만 아니라 렌더링의 정량적 지표에서도 그에 상응하는 개선을 가져왔습니다. 연구팀이 D-NeRF 데이터세트의 레고 장면에서 오류를 발견했다는 점은 주목할 만하다. 즉, 훈련 세트와 테스트 세트의 장면 사이에 약간의 차이가 있다는 점이다. 이는 레고 모델 삽의 일관되지 않은 뒤집기 각도에서 나타납니다. 이는 레고 씬에서 기존 방식의 지표가 개선될 수 없는 근본적인 이유이기도 하다. 의미 있는 비교를 가능하게 하기 위해 이 연구에서는 레고의 검증 세트를 미터법 측정의 기준으로 사용했습니다. 그림 4 합성 데이터 세트의 정량적 비교.

그림 4에서 볼 수 있듯이 이 연구에서는 CVPR 2020의 D-NeRF, Sig Asia 2022의 TiNeuVox 및 CVPR2023의 Tensor4D, K-planes를 포함하여 전체 해상도(800x800)에서 SOTA 방법을 비교했습니다. 본 연구에서 제안한 방법은 다양한 렌더링 지표(PSNR, SSIM, LPIPS)와 다양한 시나리오에서 상당한 개선을 이루었습니다. 본 연구에서 제안한 방법은 합성 장면에만 적용할 수 있는 것이 아니라 카메라 포즈가 정확하지 않은 실제 장면에서도 SOTA 결과를 얻습니다. 그림 5에서 볼 수 있듯이, 이 연구는 NeRF-DS 데이터 세트에 대한 SOTA 방법과 비교됩니다. 실험 결과에 따르면, 본 연구에서 제안한 방법은 고광 반사 표면을 특수 처리하지 않고도 고광 반사 장면을 위해 특별히 설계된 NeRF-DS를 능가하고 최고의 렌더링 효과를 얻을 수 있음을 보여줍니다.

본 연구에서 제안한 방법은 합성 장면에만 적용할 수 있는 것이 아니라 카메라 포즈가 정확하지 않은 실제 장면에서도 SOTA 결과를 얻습니다. 그림 5에서 볼 수 있듯이, 이 연구는 NeRF-DS 데이터 세트에 대한 SOTA 방법과 비교됩니다. 실험 결과에 따르면, 본 연구에서 제안한 방법은 고광 반사 표면을 특수 처리하지 않고도 고광 반사 장면을 위해 특별히 설계된 NeRF-DS를 능가하고 최고의 렌더링 효과를 얻을 수 있음을 보여줍니다.

MLP를 도입하면 렌더링 오버헤드가 증가하지만 3D Gaussian의 매우 효율적인 CUDA 구현과 컴팩트한 MLP 구조 덕분에 여전히 실시간 렌더링을 달성할 수 있습니다. 3090에서 D-NeRF 데이터 세트의 평균 FPS는 85(400x400), 68(800x800)에 도달할 수 있습니다.

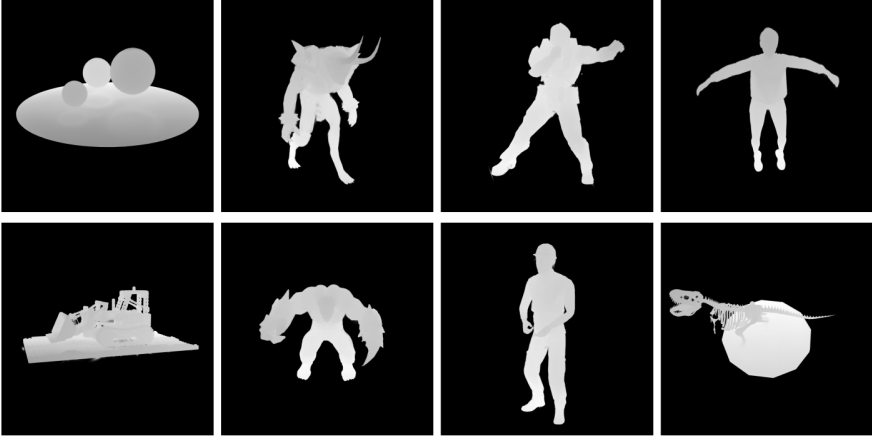

또한 이 연구에서는 처음으로 순방향 및 역방향 깊이 전파가 가능한 미분 가능한 가우스 래스터화 파이프라인을 적용했습니다. 그림 6에서 볼 수 있듯이 이 깊이는 Deformable-GS가 견고한 기하학적 표현을 얻을 수도 있음을 증명합니다. 심층 역전파는 역렌더링(Inverse Rendering), SLAM, 자율주행 등 미래에 심층 감독이 필요한 많은 작업을 촉진할 수 있습니다. 그림 6 깊이 시각화.논문의 제1저자: 절강대학교 석사 2년차 Yang Ziyi 그의 주요 연구 방향은 3차원 가우스, 신경 방사선 분야, 실시간 렌더링, 등.

논문의 다른 저자: Zhejiang University의 석사 3학년 학생인 Gao Xinyu의 주요 연구 방향은 신경 방사선장과 암시적 장면 조합입니다.

Zhang Yuqing: 절강대학교 석사과정 2년차 학생입니다. 그녀의 주요 연구 방향은 3D 생성 및 역방향 렌더링입니다.논문의 교신저자는 저장대학교 컴퓨터과학기술대학원의 Jin Xiaogang 교수입니다.

이메일: jin@cad.zju.edu.cn위 내용은 CVPR 2024 전체 점수 논문: Zhejiang University는 변형 가능한 3차원 가우스를 기반으로 한 고품질 단안 동적 재구성의 새로운 방법을 제안합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!