Transformer 모델은 챌린지 비디오 생성에서 20억 개의 데이터 포인트를 사용하여 물리적 세계를 성공적으로 학습합니다.

- 王林앞으로

- 2024-01-29 09:09:261308검색

비디오를 만들 수 있는 월드 모델 구축도 Transformer를 통해 가능합니다!

Tsinghua University와 Jiji Technology의 연구원들이 힘을 합쳐 비디오 생성을 위한 새로운 보편적인 세계 모델인 WorldDreamer를 출시했습니다.

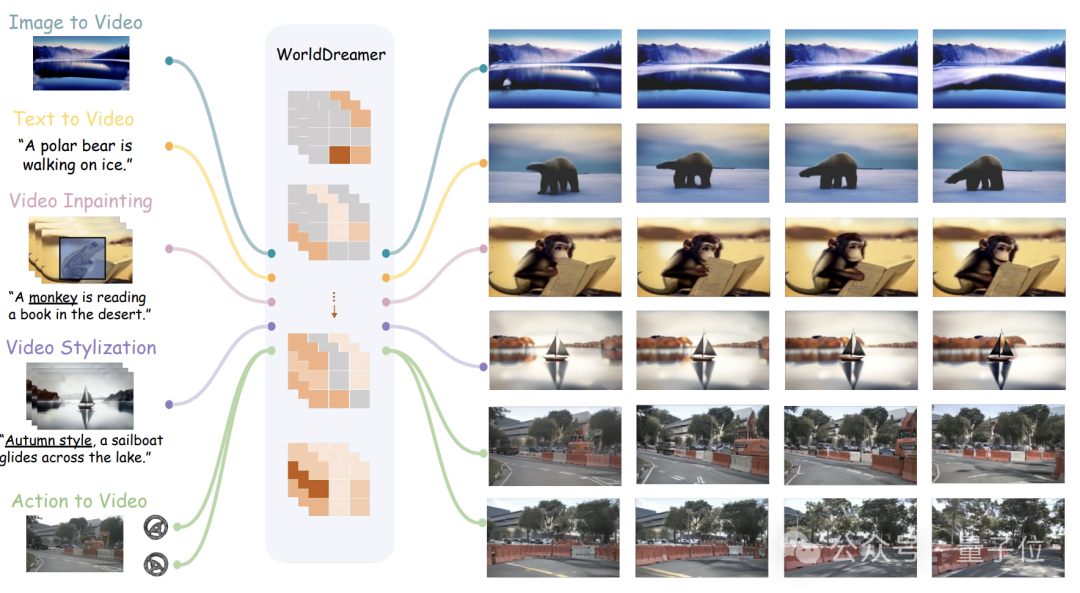

빈센트 영상, 사진 영상, 영상 편집, 액션 시퀀스 영상 등 자연 장면, 자율 주행 장면 등 다양한 영상 생성 작업을 완료할 수 있습니다.

팀에 따르면 WorldDreamer는 업계 최초로 토큰을 예측하여 보편적인 시나리오 세계 모델을 구축했습니다.

비디오 생성을 시퀀스 예측 작업으로 변환하여 물리적 세계의 변화와 모션 패턴을 완전히 학습할 수 있습니다.

시각화 실험을 통해 WorldDreamer가 일반 세계의 역동적인 변화를 깊이 이해하고 있음이 입증되었습니다.

그렇다면 어떤 비디오 작업을 완료할 수 있으며 얼마나 효과적일까요?

여러 비디오 작업 지원

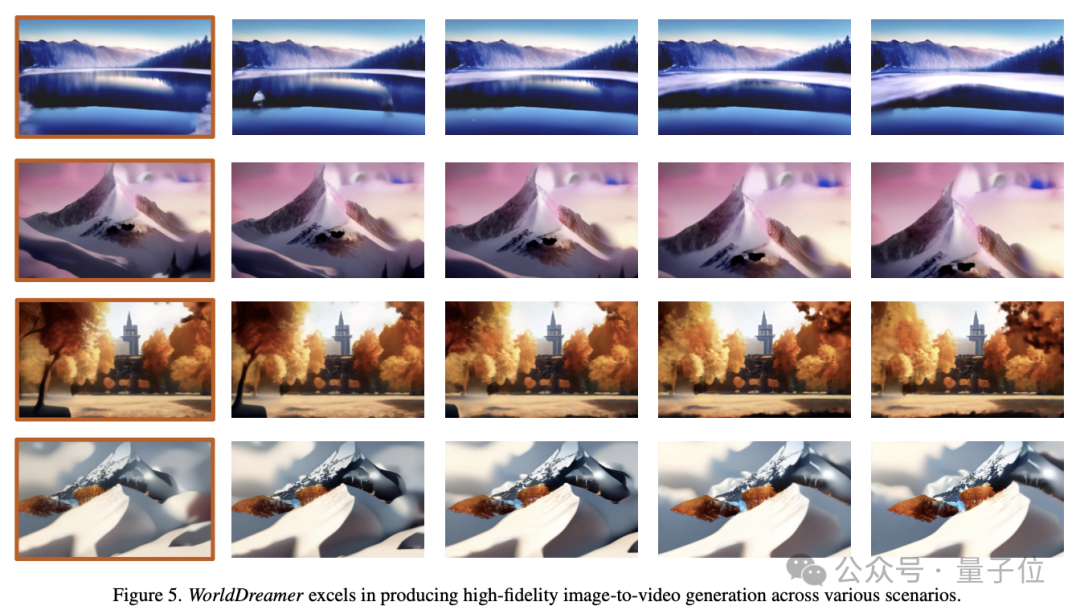

Image to Video(이미지 대 비디오)

WorldDreamer는 단일 이미지를 기반으로 미래 프레임을 예측할 수 있습니다.

첫 번째 이미지만 입력되면 WorldDreamer는 나머지 비디오 프레임을 마스크된 시각적 토큰으로 처리하고 이러한 토큰을 예측합니다.

아래 그림과 같이 WorldDreamer는 영화 수준의 고화질 영상을 생성하는 기능을 가지고 있습니다.

결과 비디오는 실제 영화에서 부드러운 카메라 움직임과 유사한 원활한 프레임별 모션을 보여줍니다.

게다가 이 비디오는 원본 이미지의 제약을 엄격하게 준수하여 프레임 구성의 놀라운 일관성을 보장합니다.

텍스트를 비디오로

WorldDreamer는 텍스트를 기반으로 비디오를 생성할 수도 있습니다.

언어 텍스트 입력이 있을 경우에만 WorldDreamer는 모든 비디오 프레임을 마스크된 시각적 토큰으로 간주하고 이러한 토큰을 예측합니다.

아래 이미지는 다양한 스타일 패러다임의 텍스트에서 비디오를 생성하는 WorldDreamer의 능력을 보여줍니다.

생성된 비디오는 입력 언어와 완벽하게 어울리며, 사용자가 입력한 언어가 비디오 콘텐츠, 스타일 및 카메라 움직임을 형성할 수 있습니다.

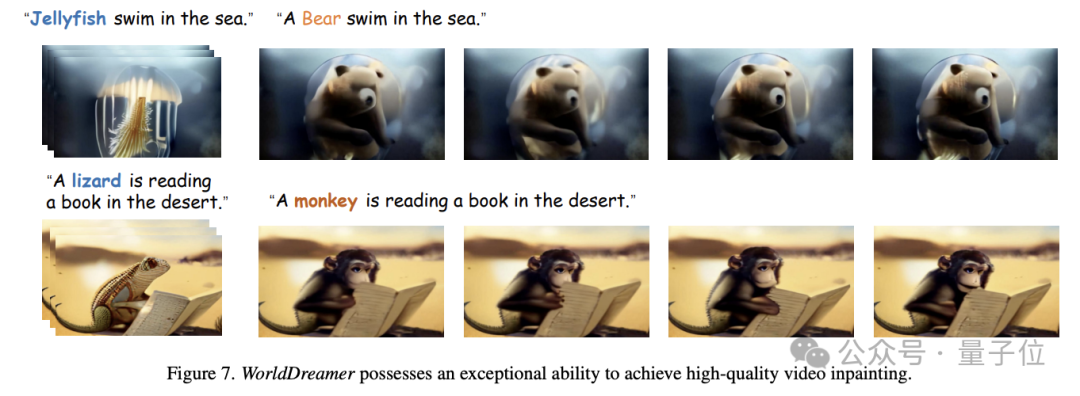

비디오 인페인팅

WorldDreamer는 비디오 인페인팅 작업을 추가로 구현할 수 있습니다.

구체적으로는 영상에 대해 사용자가 마스크 영역을 지정할 수 있으며, 언어 입력에 따라 마스크 영역의 영상 내용이 변경될 수 있습니다.

아래 그림과 같이 WorldDreamer는 해파리를 곰으로, 도마뱀을 원숭이로 대체할 수 있으며, 대체된 영상은 사용자의 언어 설명과 매우 일치합니다.

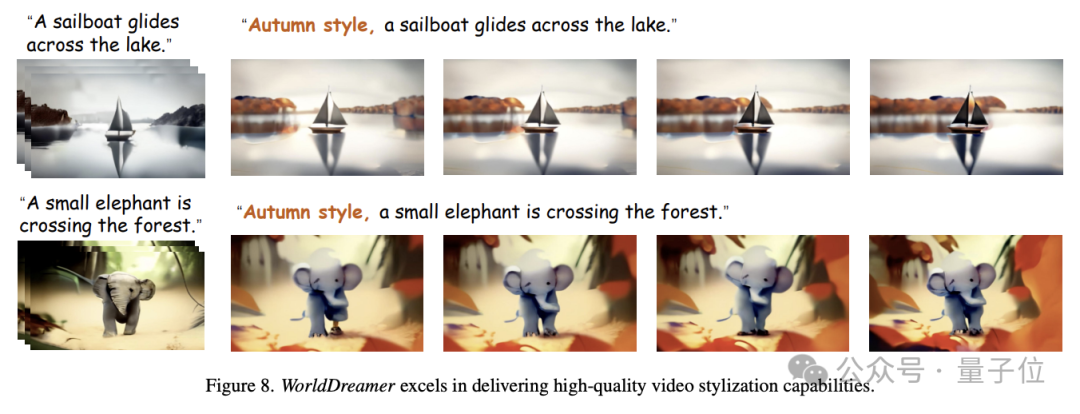

동영상 스타일화

또한 WorldDreamer는 동영상을 스타일화할 수도 있습니다.

아래 그림과 같이 특정 픽셀이 랜덤하게 마스크된 영상 세그먼트를 입력하면, WorldDreamer에서는 입력된 언어에 따라 가을 테마 효과를 생성하는 등 영상의 스타일을 변경할 수 있습니다.

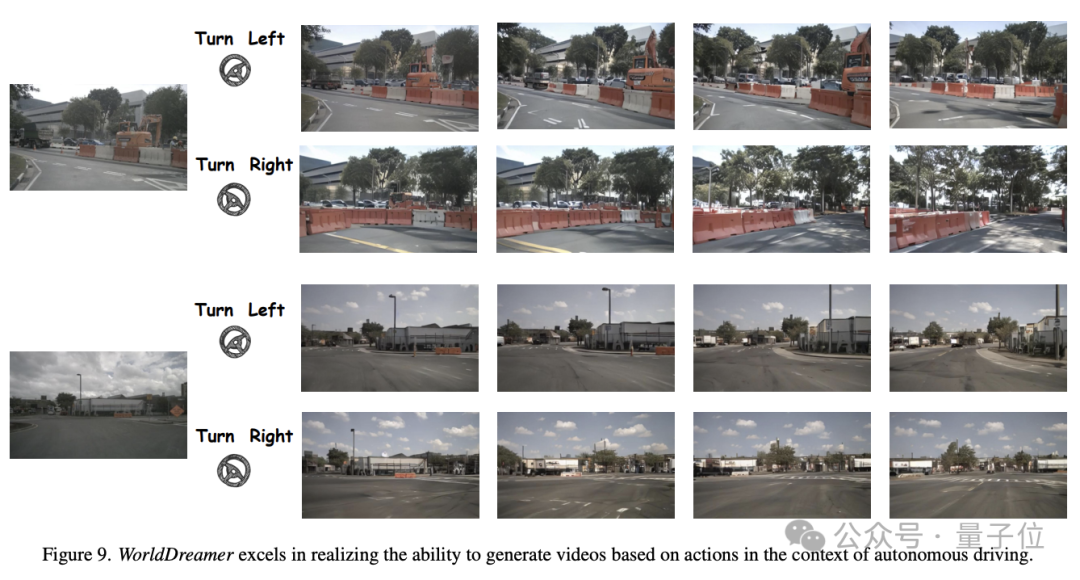

액션 합성 영상(Action to Video)을 기반으로

WorldDreamer는 자율 주행 시나리오에서 주행 액션을 영상으로 생성할 수도 있습니다.

아래 그림과 같이, 동일한 초기 프레임과 다양한 주행 전략(예: 좌회전, 우회전)이 주어지면 WorldDreamer는 첫 번째 프레임 제약 조건과 주행 전략을 잘 준수하는 동영상을 생성할 수 있습니다.

그렇다면 WorldDreamer는 어떻게 이러한 기능을 구현하나요?

Transformer를 사용하여 세계 모델 구축

연구원들은 가장 진보된 비디오 생성 방법은 주로 Transformer 기반 방법과 확산 모델 기반 방법의 두 가지 범주로 나뉜다고 믿습니다.

Transformer를 사용하여 토큰 예측을 하면 비디오 신호의 동적 정보를 효율적으로 학습하고 대규모 언어 모델 커뮤니티의 경험을 재사용할 수 있으므로 Transformer 기반 솔루션은 일반적인 세계 모델을 학습하는 효과적인 방법입니다.

확산 모델 기반 방법은 단일 모델 내에서 여러 모드를 통합하기 어렵고 더 큰 매개변수로 확장하기 어렵기 때문에 일반적인 세계의 변화와 운동 법칙을 배우기가 어렵습니다.

현재 세계 모델 연구는 주로 게임, 로봇, 자율주행 분야에 집중되어 있어 일반적인 세계 변화와 모션 패턴을 종합적으로 포착하는 능력이 부족합니다.

그래서 연구팀은 일반적인 세계의 변화와 움직임 패턴에 대한 학습과 이해를 높여 영상 생성 능력을 크게 향상시키기 위해 WorldDreamer를 제안했습니다.

대규모 언어 모델의 성공적인 경험을 바탕으로 WorldDreamer는 Transformer 아키텍처를 채택하여 세계 모델 모델링 프레임워크를 비지도 시각적 토큰 예측 문제로 변환합니다.

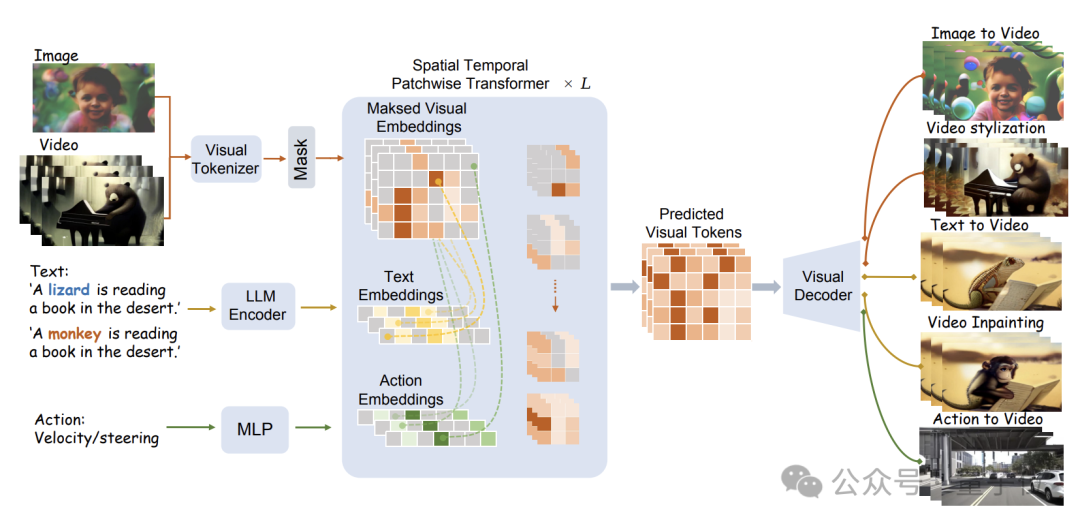

특정 모델 구조는 아래 그림에 나와 있습니다.

WorldDreamer는 먼저 시각적 토크나이저를 사용하여 시각적 신호(이미지 및 비디오)를 개별 토큰으로 인코딩합니다.

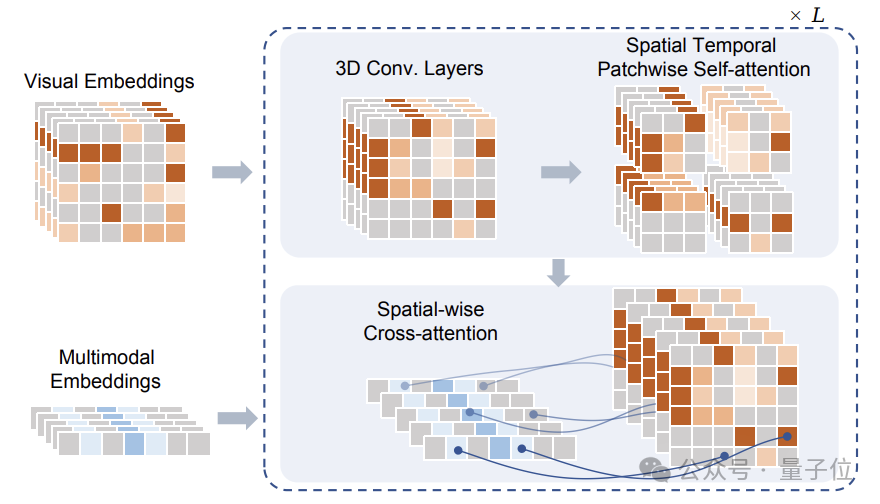

마스킹 후 이러한 토큰은 연구팀이 제안한 STPT(Sptial Temporal Patchwuse Transformer) 모듈에 입력됩니다.

동시에 텍스트 및 동작 신호는 각각 해당 특징 벡터로 인코딩되고 다중 모달 특징으로 STPT에 입력됩니다.

STPT는 내부적으로 시각적, 언어, 동작 및 기타 기능을 완전히 대화식으로 학습하고 마스크된 부분의 시각적 토큰을 예측할 수 있습니다.

궁극적으로 이러한 예측된 시각적 토큰은 다양한 비디오 생성 및 비디오 편집 작업을 완료하는 데 사용될 수 있습니다.

WorldDreamer를 훈련할 때 연구팀은 세 개의 시각적-텍스트-액션(시각적-텍스트-액션) 데이터도 구축했으며, 훈련 중 손실 함수에는 마스크된 비전 토큰을 예측하는 것만 포함된다는 점에 주목할 가치가 있습니다. 추가적인 감시 신호가 없습니다.

팀이 제안한 데이터 삼중항에서는 시각적 정보만 필요하므로 텍스트나 동작 데이터가 없어도 WorldDreamer 훈련을 수행할 수 있습니다.

이 모드는 데이터 수집의 어려움을 줄일 뿐만 아니라 WorldDreamer가 알려지지 않거나 단일 조건 없이 비디오 생성 작업 완료를 지원할 수 있도록 합니다.

연구팀은 WorldDreamer를 훈련하기 위해 20억 개의 정리된 이미지 데이터, 1천만 개의 일반적인 장면 동영상, 50만 개의 고품질 언어 주석 동영상, 약 1천 개의 자율주행 장면 동영상 등 많은 양의 데이터를 사용했습니다.

팀은 10억 개 수준의 학습 가능한 매개변수에 대해 수백만 번의 반복 교육을 수행했습니다. 융합 후 WorldDreamer는 물리적 세계의 변화와 움직임 패턴을 점차적으로 이해했으며 다양한 비디오 생성 및 비디오 편집 기능을 보유하게 되었습니다.

논문 주소: https://arxiv.org/abs/2401.09985

프로젝트 홈페이지: https://world-dreamer.github.io/

위 내용은 Transformer 모델은 챌린지 비디오 생성에서 20억 개의 데이터 포인트를 사용하여 물리적 세계를 성공적으로 학습합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!