Transformer의 위치 인코딩 적용: 길이 외삽의 무한한 가능성 탐구

- 王林앞으로

- 2024-01-16 18:42:281245검색

자연어 처리 분야에서 Transformer 모델은 뛰어난 시퀀스 모델링 성능으로 많은 주목을 받아왔습니다. 그러나 훈련 중 컨텍스트 길이가 제한되어 있기 때문에 이 길이 제한을 초과하는 시퀀스를 효과적으로 처리할 수 없습니다. 이를 "유효 길이 외삽" 기능이 부족하다고 합니다. 이로 인해 긴 텍스트를 처리할 때 대규모 언어 모델의 성능이 저하되거나 심지어 처리할 수 없게 됩니다. 이러한 문제를 해결하기 위해 연구자들은 절단(truncation) 방법, 분할(segmented) 방법, 계층적(hierarchical) 방법 등 일련의 방법을 제안해 왔다. 이러한 방법은 몇 가지 트릭을 통해 모델의 유효 길이 외삽 기능을 향상시켜 매우 긴 시퀀스를 더 잘 처리할 수 있도록 하는 것을 목표로 합니다. 이러한 방법은 이 문제를 어느 정도 완화하지만 실제 적용 시나리오의 요구 사항에 더 잘 적응하기 위해 모델의 유효 길이 외삽 기능을 더욱 향상시키기 위해서는 더 많은 연구가 여전히 필요합니다.

텍스트 연속성과 언어 확장은 인간 언어 능력의 중요한 측면 중 하나입니다. 대형 모델 시대에 길이 외삽은 모델의 성능을 긴 시퀀스 데이터에 효과적으로 적용하기 위해 중요한 방법이 되었습니다. 이 문제에 대한 연구는 이론적, 실무적 가치가 있어 관련 연구가 계속해서 나오고 있다. 동시에 이 분야에 대한 개요를 제공하고 언어 모델의 경계를 지속적으로 확장하기 위한 체계적인 검토도 필요합니다.

하얼빈 공과 대학의 연구원들은 위치 인코딩의 관점에서 길이 외삽에 따른 Transformer 모델의 연구 진행 상황을 체계적으로 검토했습니다. 연구자들은 Transformer 모델의 길이 외삽 능력을 향상시키기 위해 주로 외삽 가능한 위치 코드와 이러한 코드를 기반으로 한 확장 방법에 중점을 두고 있습니다.

문서 링크: https://arxiv.org/abs/2312.17044

외삽 가능한 위치 인코딩

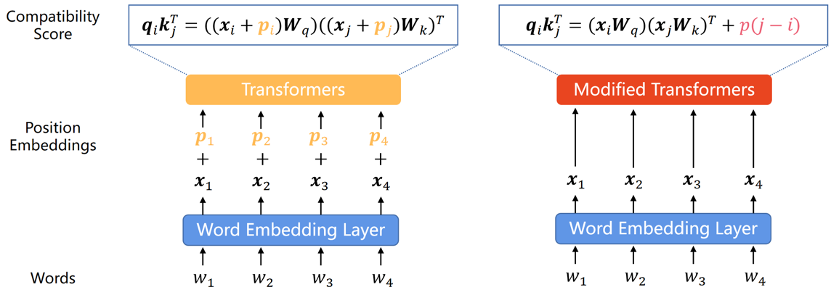

Transformer 모델 자체는 시퀀스에 있는 각 단어의 위치 정보를 캡처할 수 없으므로, 따라서 위치 인코딩은 일반적인 추가 기능이 되었습니다. 위치 인코딩은 절대 위치 인코딩과 상대 위치 인코딩의 두 가지 유형으로 나눌 수 있습니다. 절대 위치 인코딩은 입력 시퀀스의 각 단어에 위치 벡터를 추가하여 시퀀스에 있는 단어의 절대 위치 정보를 나타냅니다. 상대 위치 인코딩은 서로 다른 위치에 있는 각 단어 쌍 사이의 상대적 거리를 인코딩합니다. 두 인코딩 방법 모두 시퀀스의 요소 순서 정보를 Transformer 모델에 통합하여 모델의 성능을 향상시킬 수 있습니다.

기존 연구에서 이 분류가 모델의 외삽 능력에 매우 중요하다는 점을 고려하여 이 분류에 따라 이 섹션을 나누겠습니다.

절대 위치 인코딩

원래 Transformer 논문에서는 위치 인코딩이 사인 및 코사인 함수에 의해 생성되었습니다. 이 방법은 잘 외삽되지는 않았지만 최초의 Transformer A PE인 sine APE로 사용되었습니다. 후속 PE에 큰 영향을 미쳤습니다.

Transformer 모델의 외삽 기능을 향상시키기 위해 연구자들은 무작위 변위를 통해 변위 불변성을 정현파 APE에 통합하거나 위치에 따라 원활하게 변하는 위치 임베딩을 생성하고 모델이 이 다양한 기능을 추론하는 방법을 학습할 것으로 기대합니다. 이러한 아이디어를 기반으로 한 방법은 정현파 APE보다 강력한 외삽 기능을 나타내지만 여전히 RPE 수준에 도달할 수는 없습니다. 한 가지 이유는 APE가 서로 다른 위치를 서로 다른 위치 임베딩에 매핑하고 외삽법을 통해 모델이 보이지 않는 위치 임베딩을 추론해야 한다는 것입니다. 그러나 이는 모델에게는 어려운 작업입니다. 특히 LLM의 경우 광범위한 사전 훈련 중에 반복되는 위치 임베딩 수가 제한되어 있기 때문에 모델이 이러한 위치 인코딩에 과적합되는 경향이 있습니다.

상대 위치 인코딩

APE의 길이 외삽 성능이 만족스럽지 않기 때문에 RPE는 당연히 변위 불변성으로 인해 더 나은 외삽 기능을 가지며 일반적으로 문맥에서는 단어의 상대적 순서가 더 중요하다고 믿어집니다. . 최근 몇 년 동안 RPE는 위치 정보를 인코딩하는 데 지배적인 방법이 되었습니다.

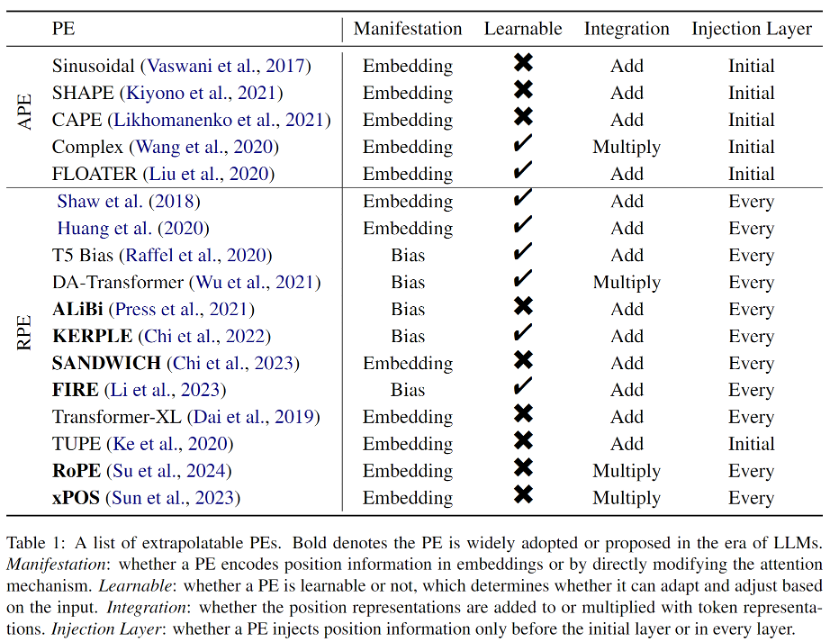

초기 RPE는 정현파 위치 인코딩에 대한 간단한 수정에서 비롯되었으며, 종종 외삽에 유익한 것으로 간주되는 배포 외 위치 임베딩을 피하기 위해 가지치기 또는 비닝 전략과 결합되었습니다. 또한 RPE는 위치와 위치 표현 간의 일대일 대응을 분리하므로 어텐션 공식에 바이어스 항을 직접 추가하는 것이 위치 정보를 Transformer에 통합하는 실현 가능하거나 더 나은 방법이 됩니다. 이 접근 방식은 훨씬 간단하며 값 벡터와 위치 정보를 자연스럽게 분리합니다. 그러나 이러한 바이어스 방법은 강력한 외삽 특성을 갖고 있지만 RoPE(Rotary Position Embedding)처럼 복잡한 거리 함수를 표현할 수는 없습니다. 따라서 RoPE는 외삽법이 좋지 않지만 뛰어난 종합 성능으로 인해 최근 LLM의 가장 주류 위치 인코딩이 되었습니다. 논문에 소개된 모든 추정 가능한 PE는 표 1에 나와 있습니다.

대형 모델 시대의 외삽법

LLM의 길이 외삽 능력을 높이기 위해 연구자들은 기존 위치 코딩을 기반으로 다양한 방법을 제안해왔는데, 주로 위치 보간(Position Interpolation)(Position Interpolation)으로 나뉜다. 보간) )과 무작위 위치 인코딩(Randomized Position Encoding) 두 가지 범주가 있습니다.

위치 보간 방법

위치 보간 방법은 추론 중에 위치 코드를 스케일링하여 원래 모델 훈련 길이를 초과하는 위치 코드가 보간 후 훈련된 위치 간격에 들어가도록 합니다. 위치 보간 방법은 뛰어난 외삽 성능과 매우 낮은 오버헤드로 인해 연구 커뮤니티에서 광범위한 관심을 끌었습니다. 또한 위치 보간법은 다른 외삽법과 달리 Code Llama, Qwen-7B, Llama2 등의 오픈 소스 모델에서 널리 사용되고 있습니다. 그러나 현재 보간 방법은 RoPE에만 초점을 맞추고 있으며 다른 PE를 사용하여 LLM이 보간을 통해 더 나은 외삽 기능을 갖도록 만드는 방법은 여전히 탐색되어야합니다.

Randomized Positional Encoding

간단히 말해서, Randomized PE는 훈련 중에 임의의 위치를 도입하여 사전 훈련된 컨텍스트 창을 더 긴 추론 길이에서 분리하여 장기적 성능을 향상시킵니다. 컨텍스트 창. 무작위 PE의 개념은 위치 보간 방법과 매우 다르다는 점에 주목할 필요가 있습니다. 전자는 훈련 중에 모델이 가능한 모든 위치를 관찰하도록 하는 반면, 후자는 추론 중에 위치를 보간하여 다음 위치에 속하도록 시도합니다. 미리 정해진 위치. 같은 이유로 위치 보간 방법은 대부분 플러그 앤 플레이 방식인 반면, 무작위 PE에는 추가 미세 조정이 필요한 경우가 많아 위치 보간이 더 매력적입니다. 그러나 이 두 가지 범주의 방법은 상호 배타적이지 않으므로 결합하여 모델의 외삽 기능을 더욱 향상시킬 수 있습니다.

도전과 향후 방향

평가 및 벤치마크 데이터 세트: 초기 연구에서 Transformer의 외삽 기능 평가는 기계 번역의 BLEU와 같은 다양한 다운스트림 작업의 성능 평가 지표에서 나왔습니다. T5, GPT2 등의 언어 모델이 점차 자연어 처리 작업을 일원화함에 따라 언어 모델링에 사용되는 난해함은 외삽을 위한 평가 지표가 되었습니다. 그러나 최신 연구에 따르면 복잡성은 다운스트림 작업의 성능을 드러낼 수 없으므로 길이 외삽 분야의 추가 개발을 촉진하기 위해 전용 벤치마크 데이터 세트와 평가 지표가 시급히 필요합니다.

이론적 설명: 길이 외삽과 관련된 현재 작업은 대부분 경험적입니다. 비록 모델의 성공적인 외삽을 설명하려는 몇 가지 예비적인 시도가 있지만 어떤 요인이 영향을 미치는지는 아직 확립되지 않았습니다. 그리고 길이 추정 성능이 어떻게 영향을 받는지는 여전히 미해결 문제입니다.

기타 방법: 이 글에서 언급한 것처럼 기존의 길이 외삽 작업은 대부분 위치 인코딩 관점에 초점을 맞추고 있지만, 길이 외삽에는 체계적인 설계가 필요하다는 점을 이해하는 것은 어렵지 않습니다. 위치 인코딩은 핵심 구성 요소이지만 결코 유일한 구성 요소는 아니며 더 넓은 관점에서 문제를 더욱 자극할 것입니다.

위 내용은 Transformer의 위치 인코딩 적용: 길이 외삽의 무한한 가능성 탐구의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!