감지 기능을 효율적으로 향상: 200미터 이상의 작은 표적 감지를 돌파합니다.

- PHPz앞으로

- 2024-01-15 19:51:291122검색

본 글은 자율주행하트 공개 계정의 승인을 받아 재인쇄되었습니다.

LiDAR 포인트 클라우드를 기반으로 한 3D 객체 감지는 항상 학계와 업계 모두 정확성, 속도 및 견고성을 향상하기 위해 다양한 모델을 제안해 왔습니다. 그러나 복잡한 실외 환경으로 인해 실외 포인트 클라우드에 대한 객체 감지 성능은 그리 좋지 않습니다. Lidar 포인트 클라우드는 본질적으로 희박합니다. 이 문제를 목표 방식으로 해결하는 방법은 무엇입니까? 이 논문은 시계열 정보의 집합을 기반으로 정보를 추출한다는 자체 답변을 제공합니다.

1. 논문 정보

2. 소개

이 백서에서는 주변 환경을 3차원으로 정확하게 표현하는 자율 주행의 핵심 과제에 대해 설명합니다. 이는 자율주행차의 신뢰성과 안전성을 위해 중요하다. 특히, 자율주행자동차는 차량, 보행자 등 주변 사물을 인식하고 그 위치, 크기, 방향을 정확하게 판단할 수 있어야 합니다. 일반적으로 사람들은 심층 신경망을 사용하여 LiDAR 데이터를 처리하여 이 작업을 수행합니다.

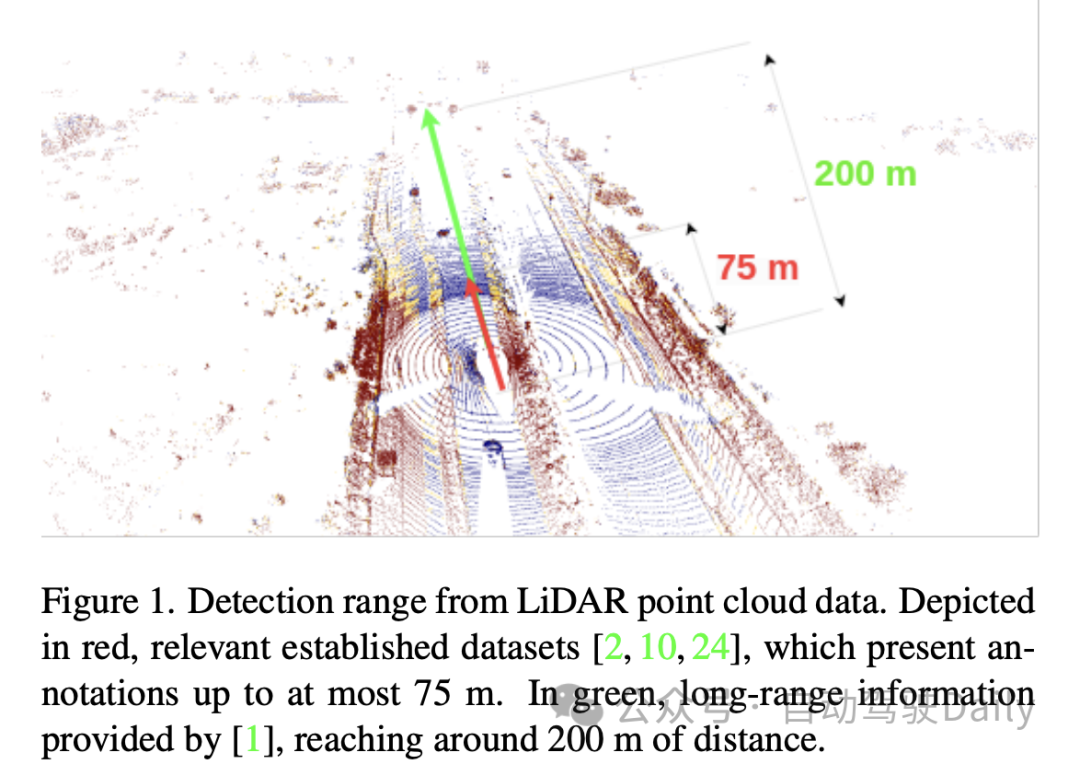

대부분의 기존 문헌은 단일 프레임 방법, 즉 한 번에 하나의 센서로 스캔한 데이터를 사용하는 데 중점을 둡니다. 이 접근 방식은 최대 75미터 거리에 있는 물체를 대상으로 한 기존 벤치마크에서 잘 수행됩니다. 그러나 LiDAR 포인트 클라우드는 본질적으로 특히 장거리에서 희박합니다. 따라서 논문에서는 장거리 감지(예: 최대 200미터)를 위해 단일 스캔만 사용하는 것만으로는 충분하지 않다고 명시합니다. 이는 포인트 클라우드 밀도를 높이고 거리 측정의 정확도를 향상시키기 위해서는 다중 프레임 융합 방법이 필요하다는 것을 의미합니다. 여러 시간 단계의 스캔 데이터를 등록하고 융합함으로써 보다 완전하고 정확한 장면 재구성 및 거리 측정 결과를 얻을 수 있습니다. 이러한 방법은 장거리 표적 탐지 및 장애물 회피와 같은 작업에서 더 높은 신뢰성과 견고성을 갖습니다. 따라서 본 논문의 공헌은 다중 프레임 융합 기반 방법을 제안하는 것입니다

이 문제를 해결하기 위한 한 가지 방법은 포인트 클라우드 집계를 통해 LiDAR 스캔 데이터를 지속적으로 획득하여 밀도가 높은 입력을 얻는 것입니다. 그러나 이 접근 방식은 계산 비용이 많이 들고 네트워크 내 집계를 최대한 활용하지 못합니다. 따라서 분명한 대안은 정보를 점진적으로 축적하여 이 문제를 해결하기 위한 재귀적 접근 방식을 채택하는 것입니다. 재귀적 방법은 시간이 지남에 따라 지속적으로 정보를 업데이트하여 보다 정확하고 포괄적인 결과를 제공합니다. 재귀적 방법을 사용하면 많은 양의 입력 데이터를 효율적으로 처리할 수 있으며 계산 측면에서도 더 효율적입니다. 이런 방식으로 문제를 해결하는 동시에 컴퓨팅 리소스를 절약할 수 있습니다.

이 기사에서는 희소 컨볼루션, 주의 모듈, 3D 컨볼루션 등 감지 범위를 늘리는 다른 기술도 언급했습니다. 그러나 이러한 방법은 대상 하드웨어의 호환성 문제를 무시하는 경우가 많습니다. 신경망을 배포하고 훈련할 때 사용되는 하드웨어는 지원되는 작업 및 대기 시간에 따라 크게 달라질 수 있습니다. 예를 들어 Nvidia Orin DLA와 같은 대상 하드웨어는 Sparse Convolution 또는 Attention과 같은 작업을 지원하지 않는 경우가 많습니다. 또한 실시간 대기 시간 요구 사항으로 인해 3D 컨볼루션과 같은 레이어를 사용하는 것이 불가능할 수도 있습니다. 따라서 2D 컨볼루션과 같은 간단한 연산을 사용하는 것이 더욱 필요해집니다.

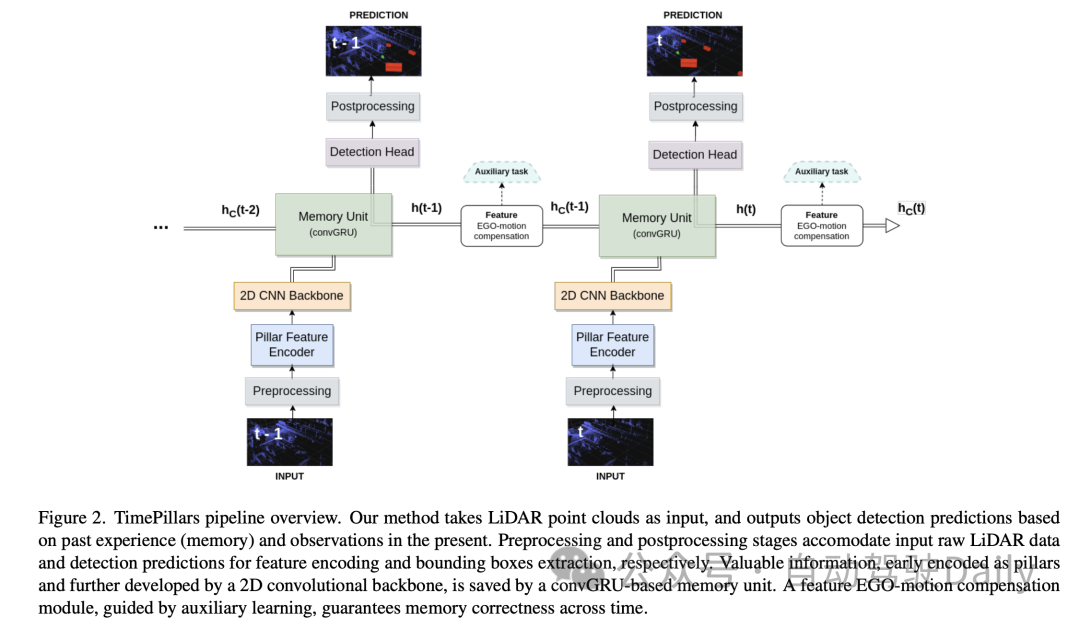

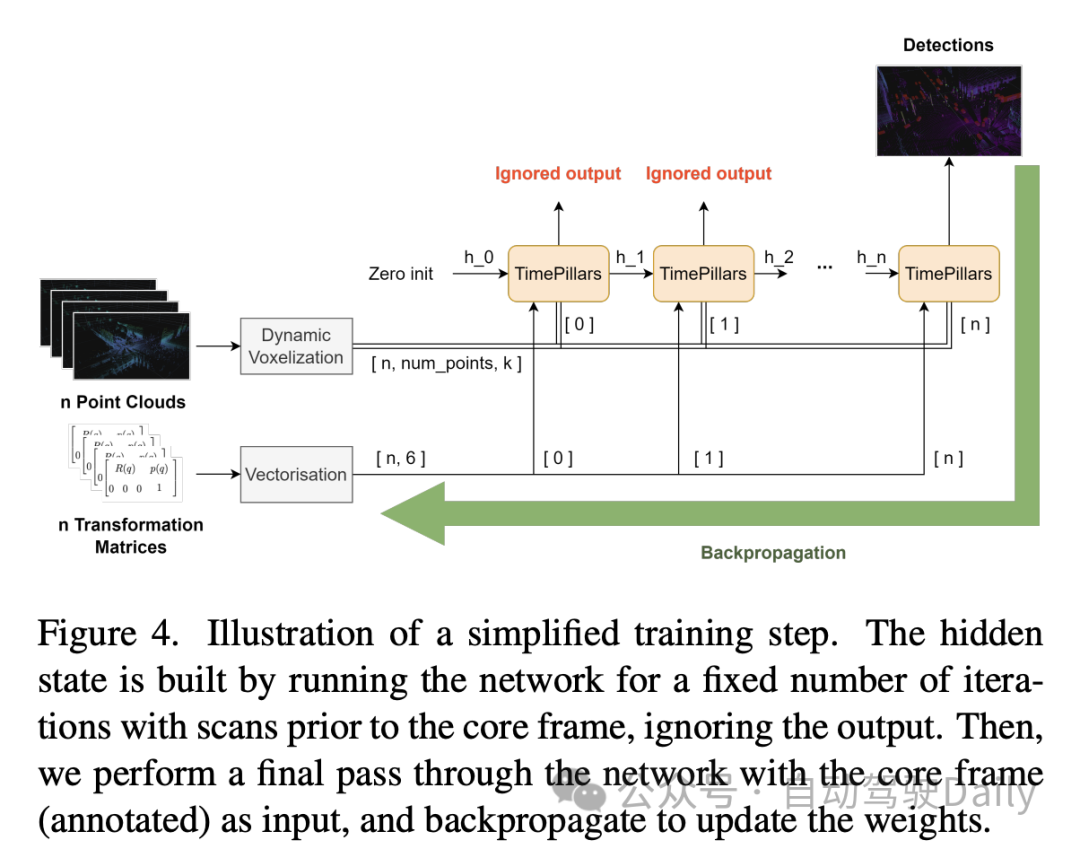

이 논문에서는 공통 대상 하드웨어에서 지원되는 작업 집합을 존중하고 2D 컨볼루션에 의존하며 포인트 필러(Pillar) 입력 표현과 컨볼루셔널 재귀 단위를 기반으로 하는 새로운 시간 재귀 모델인 TimePillars를 제안합니다. Self-Motion Compensation은 단일 컨볼루션과 보조 학습을 통해 반복 유닛의 숨겨진 상태에 적용됩니다. 이 조작의 정확성을 보장하기 위해 보조 작업을 사용하는 것이 절제 연구를 통해 적절하다는 것이 입증되었습니다. 또한 이 논문에서는 파이프라인에서 재귀 모듈의 최적 배치를 조사하고 이를 네트워크 백본과 감지 헤드 사이에 배치하면 최상의 성능을 얻을 수 있음을 명확하게 보여줍니다. 새로 출시된 ZOD(Zenseact Open Dataset)에서 이 논문은 TimePillars 방법의 효율성을 보여줍니다. 단일 프레임 및 다중 프레임 포인트 앤 필러 기준선과 비교하여 TimePillars는 특히 중요한 자전거 타는 사람 및 보행자 범주의 장거리(최대 200미터) 감지에서 상당한 평가 성능 향상을 달성합니다. 마지막으로 TimePillar는 다중 프레임 포인트 기둥보다 지연 시간이 훨씬 낮아 실시간 시스템에 적합합니다.

본 논문에서는 3D LiDAR 객체 감지 작업을 해결하기 위해 TimePillars라는 새로운 시간 재귀 모델을 제안합니다. 단일 프레임 및 다중 프레임 포인트 필러 기준과 비교하여 TimePillars는 장거리 감지에서 훨씬 더 나은 성능을 보여주고 공통 대상 하드웨어에서 지원하는 일련의 작업을 존중합니다. 또한 이 논문은 처음으로 새로운 Zenseact 공개 데이터 세트에서 3D LiDAR 객체 감지 모델을 벤치마킹했습니다. 그러나 이 논문의 한계는 다른 센서 입력을 포괄적으로 고려하지 않고 LiDAR 데이터만 고려하며 접근 방식이 단일 최첨단 기준을 기반으로 한다는 것입니다. 그럼에도 불구하고 저자는 그들의 프레임워크가 일반적이며 기준선에 대한 향후 개선이 전반적인 성능 향상으로 이어질 것이라고 믿습니다.

3. 방법

3.1 입력 전처리

본 논문의 "입력 전처리" 부분에서 저자는 "Pillarisation" 기술을 사용하여 입력 포인트 클라우드 데이터를 처리합니다. 이 방법은 수직 방향(z축)의 고정된 높이를 유지하면서 수평 방향(x, y축)으로만 포인트 클라우드를 수직 기둥 구조로 분할하는 기존의 복셀화와 다릅니다. 이렇게 하면 네트워크 입력 크기가 일관되게 유지되고 2D 컨볼루션을 사용하여 효율적인 처리가 가능해집니다.

그러나 Pillarisation의 한 가지 문제점은 빈 열이 많이 생성되어 데이터가 매우 희박하다는 것입니다. 이러한 문제를 해결하기 위해 본 논문에서는 동적 복셀화 기술의 활용을 제안한다. 이 기술을 사용하면 각 열에 미리 정의된 포인트 수를 가질 필요가 없으므로 각 열에서 자르기 또는 채우기 작업이 필요하지 않습니다. 대신 전체 포인트 클라우드 데이터가 전체적으로 처리되어 필요한 총 포인트 수(여기서는 200,000 포인트로 설정)와 일치합니다. 이 전처리 방법의 이점은 정보 손실을 최소화하고 생성된 데이터 표현을 보다 안정적이고 일관되게 만든다는 것입니다.

3.2 모델 아키텍처

그 다음 모델 아키텍처에 대해 저자는 Pillar Feature Encoder, 2D CNN(Convolutional Neural Network) 백본 및 탐지 헤드로 구성된 신경망 아키텍처를 자세히 소개했습니다.

- Pillar Feature Encoder: 이 부분은 전처리된 입력 텐서를 BEV(조감도) 의사 이미지로 매핑합니다. 동적 복셀화를 사용한 후 단순화된 PointNet이 그에 따라 조정됩니다. 입력은 1D 컨볼루션, 배치 정규화 및 ReLU 활성화 함수로 처리되어 모양의 텐서가 생성됩니다. 여기서 는 채널 수를 나타냅니다. 최종 산란 최대 레이어 이전에 최대 풀링이 채널에 적용되어 모양의 잠재 공간 을 형성합니다. 초기 텐서는 로 인코딩되어 이전 레이어 이후 가 되므로 max pooling 연산이 제거됩니다.

- Backbone: 뛰어난 깊이 효율성으로 인해 원래 칼럼 논문에서 제안된 2D CNN 백본 아키텍처를 사용합니다. 3개의 다운샘플링 블록(Conv2D-BN-ReLU)을 사용하여 잠재 공간을 줄이고 3개의 업샘플링 블록과 전치된 컨볼루션을 사용하여 의 출력 형태로 복원합니다.

- Memory Unit: 특히 Gated Recurrent Unit의 컨볼루션 버전인 컨볼루셔널 GRU(convGRU)를 사용하여 시스템의 메모리를 순환 신경망(RNN)으로 모델링합니다. Convolutional GRU의 장점은 Vanishing Gradient 문제를 피하고 공간 데이터 특성을 유지하면서 효율성을 향상시킨다는 것입니다. LSTM과 같은 다른 옵션에 비해 GRU는 게이트 수가 적기 때문에 훈련 가능한 매개 변수가 적고 메모리 정규화 기술(숨겨진 상태의 복잡성 감소)로 간주될 수 있습니다. 유사한 성격의 작업을 병합하면 필요한 컨벌루션 레이어 수가 줄어들어 단위가 더 효율적이 됩니다.

- 감지 헤드: SSD(Single Shot MultiBox Detector)에 대한 간단한 수정입니다. SSD의 핵심 개념, 즉 지역 제안이 없는 단일 패스는 유지되지만 앵커 박스의 사용은 제거됩니다. 셀 다중 객체 감지 기능이 손실되더라도 그리드의 각 셀에 대한 예측을 직접 출력하면 지루하고 종종 부정확한 앵커 상자 매개변수 조정을 피하고 추론 프로세스가 단순화됩니다. 선형 레이어는 분류 및 지역화(위치, 크기 및 각도) 회귀의 각 출력을 처리합니다. 크기만 음수 값을 취하는 것을 방지하기 위해 활성화 함수(ReLU)를 사용합니다. 또한, 본 논문에서는 관련 문헌과 달리 차량의 주행 방향에 대한 사인 성분과 코사인 성분을 독립적으로 예측하고, 이로부터 각도를 추출함으로써 직접 각도 회귀 문제를 피한다.

3.3 Feature Ego-Motion Compensation

이 부분에서 저자는 이전 프레임의 좌표계로 표현되는 Convolutional GRU에서 출력된 Hidden State Feature를 처리하는 방법에 대해 논의합니다. 직접 저장하여 다음 예측을 계산하는 데 사용하면 자아 움직임으로 인해 공간 불일치가 발생합니다.

변환에는 다양한 기술을 적용할 수 있습니다. 이상적으로는 수정된 데이터가 네트워크 내에서 변환되지 않고 네트워크에 공급됩니다. 그러나 이는 추론 과정의 각 단계에서 숨겨진 상태를 재설정하고, 이전 포인트 클라우드를 변환하고, 이를 네트워크 전체에 전파해야 하기 때문에 논문에서 제안한 방법이 아닙니다. 이는 비효율적일 뿐만 아니라 RNN 사용 목적에도 맞지 않습니다. 따라서 루프 컨텍스트에서는 기능 수준에서 보상을 수행해야 합니다. 이는 가상 솔루션을 더욱 효율적으로 만들지만 문제를 더욱 복잡하게 만듭니다. 변환된 좌표계에서 특징을 얻기 위해 전통적인 보간 방법을 사용할 수 있습니다.

반면, Chen 외 연구진의 연구에서 영감을 받은 이 논문에서는 컨볼루션 연산과 보조 작업을 사용하여 변환을 수행할 것을 제안합니다. 본 논문에서는 앞서 언급한 작업의 제한된 세부 사항을 고려하여 이 문제에 대한 맞춤형 솔루션을 제안합니다.

논문에서 취한 접근 방식은 추가 컨볼루셔널 레이어를 통해 특징 변환을 수행하는 데 필요한 정보를 네트워크에 제공하는 것입니다. 두 개의 연속 프레임 사이의 상대 변환 행렬, 즉 기능을 성공적으로 변환하는 데 필요한 작업이 먼저 계산됩니다. 그런 다음 2D 정보(회전 및 변환 부분)가 추출됩니다.

이 단순화는 주요 행렬 상수를 피하고 2D(의사 이미지) 도메인에서 작동하여 16개 값을 줄입니다. 6. 그런 다음 매트릭스는 보상할 숨겨진 특징의 모양과 일치하도록 편평화되고 확장됩니다. 첫 번째 차원은 변환해야 하는 프레임 수를 나타냅니다. 이 표현은 숨겨진 기능의 채널 차원에서 각 잠재적인 기둥을 연결하는 데 적합합니다.

마지막으로 숨겨진 상태 기능은 변환 프로세스에 맞게 조정된 2D 컨볼루셔널 레이어에 공급됩니다. 주목해야 할 핵심 측면은 컨볼루션을 수행한다고 해서 변환이 발생한다는 것을 보장하지 않는다는 것입니다. 채널 연결은 단순히 변환이 수행되는 방법에 대한 추가 정보를 네트워크에 제공합니다. 이 경우 보조 학습을 사용하는 것이 적절합니다. 훈련 중에 추가 학습 목표(좌표 변환)가 기본 목표(객체 감지)와 병행하여 추가됩니다. 보조 작업은 보상의 정확성을 보장하기 위해 감독 하에 변환 프로세스를 통해 네트워크를 안내하는 것이 목적으로 설계되었습니다. 네트워크가 기능을 올바르게 변환하는 방법을 학습하면 적용성이 상실됩니다. 따라서 이 작업은 추론 중에 고려되지 않습니다. 다음 섹션에서는 영향을 비교하기 위해 추가 실험을 수행합니다.

4. 실험

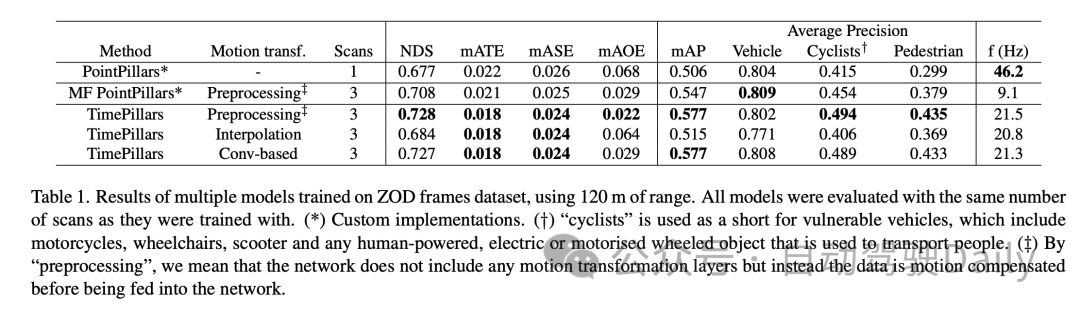

TimePillars 모델은 ZOD(Zenseact Open Dataset) 프레임 데이터세트를 처리할 때, 특히 최대 120미터 범위에서 처리할 때 성능이 우수한 것으로 나타났습니다. 이 결과는 다양한 모션 변환 방법에서 TimePillars의 성능 차이를 강조하고 다른 방법과 비교합니다.

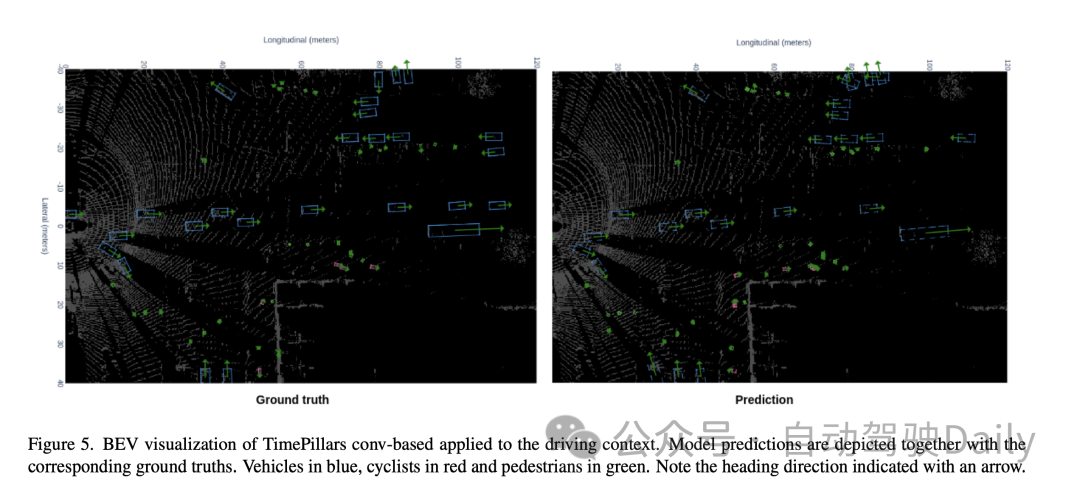

기본 모델인 PointPillars와 다중 프레임(MF) PointPillars를 비교한 결과 TimePillars가 여러 핵심 성과 지표에서 상당한 개선을 달성했음을 알 수 있습니다. 특히 NuScenes 탐지 점수(NDS)에서는 TimePillars가 더 높은 전체 점수를 보여 탐지 성능과 위치 정확도에 대한 장점을 반영했습니다. 또한 TimePillars는 평균 변환 오류(mATE), 평균 스케일 오류(mASE) 및 평균 방향 오류(mAOE)에서도 더 낮은 값을 달성하여 위치 정확도 및 방향 추정이 더 정확함을 나타냅니다. 특히 주목할 점은 모션 변환 측면에서 TimePillars의 다양한 구현이 성능에 상당한 영향을 미친다는 것입니다. 컨볼루션 기반 모션 변환(Conv 기반)을 사용할 때 TimePillars는 NDS, mATE, mASE 및 mAOE에서 특히 뛰어난 성능을 발휘하여 모션 보상에서 이 방법의 효율성을 입증하고 감지 정확도를 향상시킵니다. 반면, 보간법을 사용한 TimePillars 역시 기준 모델보다 성능이 뛰어나지만 일부 지표에서는 컨볼루션 방법보다 열등합니다. 평균 정밀도(mAP) 결과는 TimePillars가 차량, 자전거 타는 사람 및 보행자를 감지하는 데 탁월한 성능을 발휘한다는 것을 보여줍니다. 특히 자전거 타는 사람 및 보행자와 같이 보다 까다로운 범주를 처리할 때 성능 향상이 더욱 두드러집니다. 처리 주파수(f(Hz)) 측면에서 TimePillar는 단일 프레임 PointPillar만큼 빠르지는 않지만 높은 감지 성능을 유지하면서 다중 프레임 PointPillar보다 빠릅니다. 이는 TimePillars가 실시간 처리를 유지하면서 장거리 감지 및 모션 보상을 효과적으로 수행할 수 있음을 보여줍니다. 즉, TimePillars 모델은 특히 다중 프레임 데이터 처리 및 컨볼루션 기반 모션 변환 기술을 사용할 때 장거리 감지, 모션 보상 및 처리 속도에서 상당한 이점을 나타냅니다. 이러한 결과는 자율주행차용 3D LiDAR 객체 감지 분야에서 TimePillars의 적용 가능성을 강조합니다.

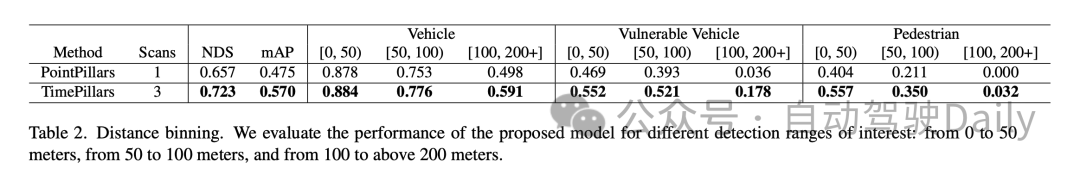

위의 실험 결과는 TimePillars 모델이 특히 벤치마크 모델인 PointPillars와 비교하여 다양한 거리 범위에서 객체 감지 성능이 탁월하다는 것을 보여줍니다. 이러한 결과는 0~50m, 50~100m, 100m 이상 등 세 가지 주요 감지 범위로 나뉩니다.

먼저 NuScenes 탐지 점수(NDS)와 평균 정밀도(mAP)가 전반적인 성능 지표입니다. TimePillars는 두 지표 모두에서 PointPillars보다 성능이 뛰어나며 전반적으로 더 높은 감지 기능과 포지셔닝 정확도를 보여줍니다. 특히 TimePillars의 NDS는 0.723으로 mAP 측면에서 PointPillars의 0.657보다 훨씬 높습니다. 또한 TimePillars는 0.570으로 PointPillars의 0.475를 훨씬 능가합니다.

다양한 거리 범위 내의 성능 비교에서 TimePillars가 각 범위에서 더 나은 성능을 발휘하는 것을 볼 수 있습니다. 차량 카테고리의 경우 0~50미터, 50~100미터, 100미터 이상 범위에서 TimePillars의 감지 정확도는 각각 0.884, 0.776, 0.591로 동일한 범위의 PointPillars 성능보다 모두 높습니다. 이는 TimePillars가 근거리 및 원거리 모두에서 차량 감지 정확도가 더 높다는 것을 보여줍니다. TimePillars는 또한 취약한 차량(예: 오토바이, 휠체어, 전기 스쿠터 등)을 처리할 때 더 나은 감지 성능을 보여주었습니다. 특히 100m 이상의 범위에서 TimePillars의 감지 정확도는 0.178인 반면 PointPillars는 0.036에 불과해 장거리 감지에 상당한 이점을 보여줍니다. 보행자 감지의 경우 TimePillars는 특히 50~100m 범위에서 0.350의 감지 정확도로 더 나은 성능을 보인 반면 PointPillars는 0.211에 불과했습니다. 더 먼 거리(100미터 이상)에서도 TimePillars는 특정 수준의 감지(정확도 0.032)를 달성하는 반면 PointPillars는 이 범위에서 0을 수행합니다.

이 실험 결과는 다양한 거리 범위에서 물체 감지 작업을 처리하는 데 있어 TimePillars의 탁월한 성능을 강조합니다. 근거리에서든 장거리에서든 TimePillars는 자율주행 차량의 안전과 효율성에 중요한 보다 정확하고 신뢰할 수 있는 감지 결과를 제공합니다.

5. 토론

우선, TimePillars 모델의 가장 큰 장점은 장거리 물체 감지에 대한 효율성입니다. 동적 복셀화 및 컨볼루셔널 GRU 구조를 사용함으로써 모델은 특히 장거리 객체 감지에서 희소 LiDAR 데이터를 더 잘 처리할 수 있습니다. 이는 복잡하고 변화하는 도로 환경에서 자율주행차의 안전한 작동에 매우 중요합니다. 또한, 실시간 응용에 필수적인 처리 속도 측면에서도 좋은 성능을 보여준다. 반면 TimePillars는 모션 보상을 위해 컨볼루션 기반 방법을 채택했는데, 이는 기존 방법에 비해 크게 개선되었습니다. 이 접근 방식은 훈련 중 보조 작업을 통해 변환의 정확성을 보장하여 움직이는 객체를 처리할 때 모델의 정확성을 향상시킵니다.

그러나 본 논문의 연구에도 몇 가지 한계가 있습니다. 첫째, TimePillars는 멀리 있는 물체 감지를 처리하는 데 탁월한 성능을 발휘하지만 이러한 성능 향상에는 일부 처리 속도가 저하될 수 있습니다. 모델의 속도는 여전히 실시간 애플리케이션에 적합하지만 단일 프레임 방법에 비해 여전히 감소합니다. 또한 이 백서에서는 주로 LiDAR 데이터에 중점을 두고 카메라나 레이더와 같은 다른 센서 입력을 고려하지 않습니다. 이로 인해 보다 복잡한 다중 센서 환경에서 모델 적용이 제한될 수 있습니다.

즉, TimePillars는 자율주행차용 3D LiDAR 물체 감지, 특히 장거리 감지 및 동작 보상 분야에서 상당한 이점을 보여주었습니다. 다중 센서 데이터 처리의 처리 속도와 한계에 대한 약간의 절충에도 불구하고 TimePillars는 여전히 이 분야에서 중요한 발전을 나타냅니다.

6. 결론

이 연구는 과거의 센서 데이터를 고려하는 것이 현재 정보만을 활용하는 것보다 우수하다는 것을 보여줍니다. 이전 주행 환경 정보에 접근하면 LiDAR 포인트 클라우드의 희박한 특성에 대처하고 보다 정확한 예측을 할 수 있습니다. 우리는 순환 네트워크가 후자를 달성하기 위한 수단으로 적합하다는 것을 보여줍니다. 시스템 메모리를 제공하면 광범위한 처리를 통해 더 조밀한 데이터 표현을 생성하는 포인트 클라우드 집계 방법에 비해 더 강력한 솔루션이 됩니다. 우리가 제안한 방법인 TimePillars는 재귀 문제를 해결하는 방법을 구현합니다. 추론 프로세스에 3개의 추가 컨볼루셔널 레이어를 간단히 추가함으로써 기본 네트워크 구성 요소가 중요한 결과를 달성하고 기존 효율성 및 하드웨어 통합 사양을 충족하는 데 충분하다는 것을 보여줍니다. 우리가 아는 한, 이 작업은 새로 도입된 Zenseact 공개 데이터 세트에 대한 3D 객체 감지 작업에 대한 첫 번째 벤치마크 결과를 제공합니다. 우리의 작업이 미래에 더욱 안전하고 지속 가능한 도로를 만드는데 기여할 수 있기를 바랍니다.

원본 링크: https://mp.weixin.qq.com/s/94JQcvGXFWfjlDCT77gjlA

위 내용은 감지 기능을 효율적으로 향상: 200미터 이상의 작은 표적 감지를 돌파합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!